19 अक्टू॰ 2025·8 मिनट

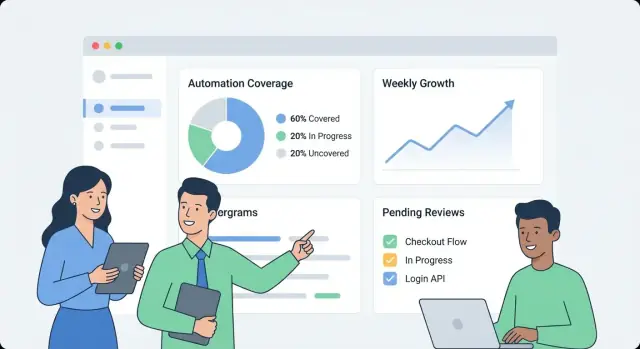

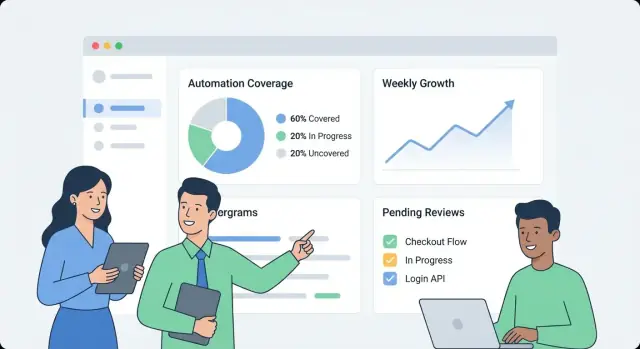

आंतरिक ऑटोमेशन कवरेज की निगरानी के लिए वेब ऐप कैसे बनाएं

सीखें कि आंतरिक ऑटोमेशन कवरेज ट्रैक करने वाला वेब ऐप कैसे डिज़ाइन और बनाएं: मेट्रिक्स, डेटा मॉडल, इंटीग्रेशन, डैशबोर्ड UX, और अलर्ट।

सीखें कि आंतरिक ऑटोमेशन कवरेज ट्रैक करने वाला वेब ऐप कैसे डिज़ाइन और बनाएं: मेट्रिक्स, डेटा मॉडल, इंटीग्रेशन, डैशबोर्ड UX, और अलर्ट।

कुछ भी बनाने से पहले यह लिख लें कि आपकी संगठन के अंदर “ऑटोमेशन कवरेज” से क्या मतलब है। वरना डैशबोर्ड एक बेकार संख्या-पेटी बन सकता है जिसे अलग-अलग टीमें अलग तरीके से इंटरप्रेट करेंगी।

सबसे पहले उन यूनिट्स को चुनें जिन्हें आप माप रहे हैं। सामान्य विकल्प:

v1 के लिए एक प्राथमिक परिभाषा चुनें, और उन सेकेंडरी प्रकारों को नोट करें जिन्हें आप बाद में जोड़ सकते हैं। एज केस—जैसे “आंशिक रूप से ऑटोमेटेड” जो अभी भी अनुमोदन मांगते हैं—पर स्पष्ट रहें।

विभिन्न दर्शक अलग सवाल पूछते हैं:

5–10 “टॉप प्रश्न” लिखें और उन्हें प्रोडक्ट आवश्यकताओं की तरह ट्रीट करें।

प्राथमिक परिणाम परिभाषित करें: visibility (क्या मौजूद है), prioritization (अगला क्या ऑटोमेट करें), accountability (कौन उसका मालिक है), और trend tracking (क्या यह सुधर रहा है)।

v1 के लिए स्पष्ट सीमाएँ सेट करें। उदाहरण: “हम अभी गुणवत्ता स्कोर नहीं करेंगे,” “हम समय-बचत नहीं मापेंगे,” या “हम सिर्फ CI-बेस्ड टेस्ट शामिल करेंगे, लोकल स्क्रिप्ट्स नहीं।”

अंततः सफलता का मतलब तय करें: लगातार अपनाने (साप्ताहिक सक्रिय उपयोगकर्ता), उच्च डेटा ताज़गी (उदा., 24 घंटे के भीतर अपडेट), कम blind spots (सभी क्रिटिकल सिस्टम्स के लिए कवरेज मैप्ड), और मापने योग्य फॉलो-थ्रू (मालिक असाइन हुए और गैप महीने-दर-महीने घट रहे)।

ऑटोमेशन कवरेज मापने से पहले आपको यह जानना होगा कि "ऑटोमेशन साक्ष्य" वास्तव में कहाँ रहता है। अधिकांश संगठनों में ऑटोमेशन अलग-अलग टूल्स में बिखरी होती है जो अलग समय पर अपनाई गई थीं।

व्यवहारिक इन्वेंटरी से शुरू करें जो यह जवाब दे: कौन से सिग्नल बताते हैं कि कोई गतिविधि ऑटोमेटेड है, और उन्हें कहाँ से हम प्राप्त कर सकते हैं?

टिपिकल सोर्सेज़ में CI पाइपलाइन्स (बिल्ड/टेस्ट जॉब्स), टेस्ट फ्रेमवर्क (unit/integration/E2E रिजल्ट्स), वर्कफ़्लो टूल्स (approvals, deployments, ticket transitions), रनबुक्स (स्क्रिप्ट्स और डॉक्युमेंटेड प्रक्रियाएँ), और RPA प्लेटफ़ॉर्म आते हैं। हर स्रोत के लिए वह पहचानकर्ता पकड़ें जिस पर आप बाद में जोइन कर सकें (repo, सर्विस नाम, environment, टीम) और वह “प्रूफ” जो आप स्टोर करेंगे (जॉब रन, टेस्ट सूट रिपोर्ट, ऑटोमेशन नियम, स्क्रिप्ट एक्सिक्यूशन)।

फिर वे सिस्टम सूचीबद्ध करें जो परिभाषित करते हैं कि "क्या होना चाहिए": रेपो होस्टिंग, इश्यू ट्रैकर, और CMDB/सर्विस कैटलॉग। ये स्रोत सामान्यतः सर्विसेस, मालिकों, और क्रिटिकलिटी की अधिकृत सूची प्रदान करते हैं—जो सिर्फ गतिविधि गिनने के बजाय कवरेज गणना के लिए आवश्यक है।

प्रति स्रोत सबसे कम भंगुर इंगेशन मेथड मैच करें:

रेट लिमिट्स, ऑथेंटिकेशन मेथड (PAT, OAuth, सर्विस अकाउंट्स), रिटेंशन विंडोज़, और ज्ञात डेटा क्वालिटी इश्यूज़ (रिनेम्ड सर्विसेस, असंगत नामकरण, मिसिंग ओनर्स) रिकॉर्ड करें।

अंत में, प्रत्येक कनेक्टर के लिए एक सोर्स रिलायबिलिटी स्कोर (और वैकल्पिक रूप से प्रति मैट्रिक) प्लान करें ताकि उपयोगकर्ता देख सकें कि कोई नंबर "हाई कॉन्फिडेंस" है या "बेस्ट-एफ़र्ट"। इससे झूठी सटीकता रोकी जा सकती है और बाद में कनेक्टर सुधारों को प्राथमिकता देने में मदद मिलती है।

एक उपयोगी कवरेज डैशबोर्ड वह डेटा मॉडल से शुरू होता है जो यह अलग करता है कि आप क्या इच्छा करते हैं ऑटोमेटेड हो और वास्तव में क्या हाल ही में चला है। यदि आप इन्हें मिला देते हैं तो आपके नंबर अच्छे दिख सकते हैं लेकिन ऑटोमेशन stale हो सकती है।

इन बिल्डिंग ब्लॉक्स से शुरू करें:

एक प्राथमिक रिपोर्टिंग लेवल चुनें और उस पर टिकें:

आप बाद में कई व्यूज़ सपोर्ट कर सकते हैं, पर आपकी पहली वर्जन में एक “source of truth” लेवल होना चाहिए।

ऐसे IDs इस्तेमाल करें जो refactor सहन कर सकें:

डिस्प्ले नाम को एडिटेबल मानें, पहचानकर्ता के रूप में नहीं।

एक व्यावहारिक पैटर्न:

यह आपको यह पूछने देता है: “किसे कवर्ड होना चाहिए?”, “कौन क्या कवर्ड करने का दावा करता है?”, और “असल में क्या चला?”

इनको कैप्चर करें:

last_seen_at (asset अभी भी मौजूद है)last_run_at, last_failure_atlast_reviewed_at (किसी ने दावा अभी भी मान्य बताया)Freshness फ़ील्ड्स "कवर्ड पर परन्तु stale" आइटम्स को बिना बहस हाइलाइट करने में मदद करते हैं।

यदि आपका कवरेज मैट्रिक अस्पष्ट है, तो हर चार्ट बहस बन जाता है। एक एकल प्राथमिक मैट्रिक चुनकर शुरू करें (एक्जीक्यूटिव समरी के लिए), फिर टीमों के लिये सहायक ब्रेकडाउन जोड़ें।

अधिकांश संगठन इनमें से एक चुनते हैं:

आप तीनों दिखा सकते हैं, पर स्पष्ट करें कौन सा "हेडलाइन्" नंबर है।

स्पष्ट नियम लिखें ताकि टीमें सामान रूप से स्कोर कर सकें:

नियमों को मापनीय रखें। अगर दो लोग एक ही आइटम को अलग तरह स्कोर करते हैं तो परिभाषा सुधारें।

इनपुट्स जैसे risk, business impact, run frequency, और time saved के लिए छोटे integer स्केल (1–5) का उपयोग करें। उदाहरण: weight = risk + impact + frequency।

जब तक आइटम के पास साक्ष्य न हो, उसे “ऑटोमेटेड” न गिनें, जैसे:

यह कवरेज को सेल्फ-रिपोर्टेड क्लेम से ऑब्ज़रवेबल सिग्नल बनाता है।

स्कोरिंग नियम और उदाहरण एक साझा पेज पर रखें (डैशबोर्ड से लिंक करें)। लगातार व्याख्या वही है जो ट्रेंड्स को भरोसेमंद बनाती है।

एक आंतरिक ऑटोमेशन कवरेज ऐप "सबसे अच्छे अर्थों में बोअरिंग" होना चाहिए: ऑपरेट करने में आसान, बदलने में आसान, और यह स्पष्ट कि नंबर कहाँ से आते हैं। एक सरल "API + डेटाबेस + डैशबोर्ड" आकार आमतौर पर तब तक बेहतर रहता है जब तक आपको वास्तव में डिस्ट्रिब्यूटेड सिस्टम की ज़रूरत न पड़े।

अपनी टीम जिस स्टैक को पहले से सपोर्ट करती है वही चुनें। सामान्य बेसलाइन:

यदि आप पहले इंटरनल वर्जन पर तेजी से जाना चाहते हैं तो एक vibe-coding अप्रोच काम कर सकती है: उदाहरण के लिए, Koder.ai एक स्ट्रक्चर्ड स्पेसिफिकेशन से React डैशबोर्ड और Go + PostgreSQL बैकएंड जनरेट करने में मदद कर सकता है, फिर आपकी टीम चैट के माध्यम से इटेरेट कर सकती है जबकि पूरा सोर्स-कोड एक्सपोर्ट भी उपलब्ध रहता है।

एक "सिम्पल" सिस्टम में भी जिम्मेदारियाँ अलग रखें:

कैनोनिकल एंटिटीज़ (टीम्स, सर्विसेज़, ऑटोमेशन्स, साक्ष्य, ओनर्स) के लिए रिलेशनल टेबल्स का प्रयोग करें। ट्रेंड्स (रन ओवर टाइम, कवरेज सप्ताह दर सप्ताह) के लिए या तो:

यदि कई टीमें ऐप साझा कर रही हैं, तो पहले से org_id/team_id फ़ील्ड जोड़ें। इससे permissions और भविष्य में "सेगमेंटेड डैशबोर्ड" की मांग आसान हो जाएगी।

dev/staging/prod चलाएँ और तय करें कि डेटा कैसे मूव होगा:

UI को नेविगेट करने पर अधिक जानकारी के लिए देखें /blog/design-dashboard-ux.

कवरेज डैशबोर्ड जल्दी ही सत्य का स्रोत बन जाता है, इसलिए एक्सेस कंट्रोल और डेटा हैंडलिंग चार्ट्स जितनी महत्वपूर्ण हैं उतनी ही। सरल से शुरू करें, पर ऐसा डिज़ाइन करें कि सिक्योरिटी बिना बड़े रीराइट्स के सख्त की जा सके।

यदि आपकी कंपनी के पास SSO है तो दिन एक से इंटीग्रेट करें (OIDC अक्सर आसान है; बड़े ऑर्ग्स में SAML सामान्य)। अगर तेज़ लांच चाहिए तो शुरू में एक internal auth proxy के पीछे चलाएँ जो identity headers इंजेक्ट करे, और बाद में native SSO में स्विच करें।

पहचान को एक स्थिर user key पर नॉर्मलाइज़ करें (ईमेल बदल सकता है)। एक न्यूनतम यूजर प्रोफ़ाइल स्टोर करें और समूह/टीम मेंबरशिप मांग पर लाएँ।

एक छोटा रोल सेट परिभाषित करें और UI व API में अनुमति को सुसंगत रखें:

स्कोप-आधारित परमिशन (टीम/सर्विस द्वारा) "सुपर यूज़र्स" की तुलना में बेहतर हैं—यह जोखिम कम करता है और बोतलनेक्स टालता है।

कवरेज प्रमाण अक्सर CI लॉग्स, इनसिडेंट टिकट, या अंदरूनी डॉक्स के लिंक शामिल करते हैं। उन URLs और किसी भी रॉ लॉग्स तक पहुँच सीमित करें। सत्यापन के लिए केवल जो ज़रूरी हो वही स्टोर करें (उदा., एक बिल्ड ID, timestamp, और एक छोटा status सारांश) बजाय पूरे लॉग को DB में कॉपी करने के।

कवरेज दावों या मेटाडेटा पर कोई भी मैन्युअल संपादन एक ऑडिट रिकॉर्ड बनाए: किसने क्या बदला, कब, और क्यों (free-text कारण)। अंत में, रन हिस्ट्री और साक्ष्य के लिए रिटेंशन नीति सेट करें—यह परिभाषित करें कि कितनी देर तक रखना है, और सुरक्षित पर्ज़िंग लागू करें ताकि पुराने रिकॉर्ड हटाये जा सकें बिना वर्तमान कवरेज गणनाओं को तोड़े।

एक कवरेज डैशबोर्ड सफल तब होता है जब कोई व्यक्ति एक मिनट के अंदर तीन प्रश्नों का उत्तर दे सके: हम कैसे कर रहे हैं? क्या बदल रहा है? अगला क्या ठीक किया जाना चाहिए? UX को उन निर्णयों के इर्द-गिर्द डिज़ाइन करें, न कि डेटा स्रोतों के।

पहली स्क्रीन को सरल ओवरव्यू बनाएं:

लेबल साधारण भाषा में रखें (“Automated recently” बेहतर है बनाम “Evidence recency”), और पाठकों को तकनीकी स्टेटस interpret करने के लिए मजबूर न करें।

किसी भी ओवरव्यू मैट्रिक से यूज़र को एक सर्विस/प्रोसेस पेज पर क्लिक करने दें जो “क्या” और “किस द्वारा” का जवाब दे:

प्रत्येक रो/कार्ड में “नंबर के पीछे क्यों” दिखाएँ: साक्ष्य लिंक, owner, last run status, और एक स्पष्ट next action (“Re-run job”, “Assign owner”, “Add missing evidence”)।

ऐसे फ़िल्टर्स ऑफर करें जो संगठन के काम करने के तरीके के अनुरूप हों:

फ़िल्टर स्टेट को दृश्यमान और शेयरएबल रखें (URL पैरामीटर्स), ताकि कोई stakeholder लिंक भेज सके जैसे “Prod + Tier-1 + last 14 days”।

इनलाइन डेफिनिशन उपयोग करें, न कि लंबी डॉक्यूमेंटेशन:

इंटीग्रेशन्स वही जगह हैं जहाँ आपका कवरेज ऐप असली बनता है। लक्ष्य हर CI या टेस्ट टूल की हर फ़ीचर को मिरर करना नहीं है—बल्कि एक सुसंगत तथ्य सेट निकालना है: क्या चला, कब चला, किसे कवर्ड किया, और किसका मालिक है।

उन सिस्टम्स से शुरुआत करें जो पहले से ऑटोमेशन सिग्नल पैदा करते हैं: CI (GitHub Actions, GitLab CI, Jenkins), टेस्ट रनर्स (JUnit, pytest), और गुणवत्ता टूल्स (coverage reports, linters, security scans)।

एक कनेक्टर को न्यूनतम वायबल पे लोड लाना चाहिए:

कनेक्टर्स idempotent रखें: दोहराये गए pulls से डुप्लिकेट्स नहीं बनने चाहिए।

कुछ कवरेज गैप जानबूझकर होते हैं (legacy systems, तृतीय-पक्ष बाधाएँ, paused initiatives)। एक हल्का “exception” रिकॉर्ड दें जिसमें अनिवार्य हो:

यह स्थायी blind spots रोकता है और लीडरशिप व्यूज़ को ईमानदार रखता है।

विभिन्न स्रोत कभी सहमत नहीं होते: एक सिस्टम कहता है “payments-service”, दूसरा कहता है “payments”, और तीसरा रेपो स्लग उपयोग करता है।

नॉर्मलाइज़ेशन नियम बनाएं:

इसे जल्दी करें; हर डाउनस्ट्रीम मैट्रिक इस पर निर्भर करेगा।

service_aliases, repo_aliases जैसी alias तालिकाएँ रखें जो कई बाहरी नामों को एक canonical एंटिटी से मैप करें। नई डाटा आने पर पहले canonical IDs के खिलाफ मैच करें, फिर aliases के साथ।

अगर नया नाम मैच नहीं करता है, तो merge सुझाव जेनरेट करें (उदा., “payments-api” दिखता है जैसे “payments-service”) जिसे एक एडमिन अप्रूव कर सके।

एक recurring job शेड्यूल करें जो स्रोत के अनुसार लेटेस्ट रन timestamp चेक करे और कुछ स्टेल (उदा., 7 दिनों में कोई CI रन नहीं) को फ़्लैग करे। इसे UI में दिखाएँ ताकि low coverage को missing data से कन्फ्यूज़ न किया जाए।

डैशबोर्ड उपयोगी है, पर अलर्ट्स और हल्के वर्कफ़्लो वही हैं जो दिलचस्प डेटा को निरंतर सुधार में बदलते हैं। लक्ष्य सरल है: सही लोगों को समय पर सूचित करें, पर्याप्त संदर्भ के साथ ताकि वे कार्रवाई कर सकें।

छोटे सेट से शुरू करें जो हाई-सिग्नल देते हों:

हर अलर्ट सीधे संबंधित ड्रिल-डाउन व्यू से लिंक होना चाहिए (उदा., /services/payments?tab=coverage या /teams/platform?tab=owners) ताकि लोगों को खोजने की ज़रूरत न पड़े।

वन-साइज़-फिट-ऑल थ्रेशहोल्ड्स से बचें। टीमें ऐसे नियम सेट कर सकें:

यह सिग्नल्स को मायने रखता बनाता है और अलर्ट थकान घटाता है।

अलर्ट्स मौजूदा चैनलों (ईमेल और Slack) पर भेजें, और शामिल करें: क्या बदला, क्यों मायने रखता है, और मालिक कौन है। रियल-टाइम अलर्ट्स के साथ, एक साप्ताहिक सारांश भी दें:

अलर्ट्स को टास्क की तरह ट्रीट करें: acknowledgement, assignment, और status (open/triaged/resolved) दें। एक छोटा comment trail (“fixed in PR #1234”) रिपोर्टिंग को विश्वसनीय बनाता है और एक ही समस्या के बार-बार चुपचाप वापस आने को रोकता है।

एक मॉनिटरिंग डैशबोर्ड तब तेज़ महसूस होता है जब API उन प्रश्नों का जवाब दे जो UI वास्तव में पूछता है—बिना ब्राउज़र को दर्जनों कॉल्स जोड़ने के लिए मजबूर किए। पहले एक न्यूनतम, डैशबोर्ड-फर्स्ट API सतह से शुरू करें, फिर महंगे कैलकुलेशन्स को प्रीकॉम्प्यूट करने के लिए बैकग्राउंड जॉब्स जोड़ें।

पहली वर्जन को कोर स्क्रीन पर फोकस रखें:

GET /api/services (filters जैसे team, language, tier)GET /api/services/{id}/coverage (ओवरऑल स्कोर + की ब्रेकडाउन)GET /api/services/{id}/evidence?status=passed&since=...PATCH /api/services/{id}रिस्पॉन्सेस इस तरह डिजाइन करें कि डैशबोर्ड तुरंत रेंडर कर सके: एक पेलोड में सर्विस नाम, owner, last evidence time, और current score शामिल करें बजाय अलग- अलग लुकअप के।

लिस्ट्स और ड्रिल-डाउन टेबल्स हमेशा paginated हों (limit + cursor)। अक्सर हिट होने वाले एंडपॉइंट्स पर API लेयर पर कैशिंग जोड़ें (या साझा कैश) जो फ़िल्टर्स और कॉलर की एक्सेस स्कोप द्वारा की—key करें।

किसी भी चीज़ के लिए जो बहुत सारा साक्ष्य स्कैन करती है (उदा., “team द्वारा कवरेज”), रात्रीकालीन जॉब में rollups प्रीकॉम्प्यूट करें। Rollups को अलग टेबल (या materialized view) में रखें ताकि पढ़ना सरल और अनुमाननीय हो।

ट्रेंड्स तब आसान होते हैं जब आप दैनिक स्नैपशॉट्स स्टोर करते हैं:

GET /api/services/{id}/trend?days=90।स्नैपशॉट्स इतिहासिक मैट्रिक्स को हर पेज लोड पर फिर से नहीं निकालने देते और “freshness” को चार्ट करना आसान बनाते हैं।

बुल्क ऑनबोर्डिंग को सुगम करने के लिए:

POST /api/import/services (CSV अपलोड)GET /api/export/services.csvअंत में, write टाइम पर वैलिडेशन नियम लागू करें: required owner, allowed status values, और sensible timestamps (कोई “future” evidence न हो)। खराब डेटा को जल्दी reject करना बाद के धीमे और जटिल फिक्सेस को रोकता है—खासकर जब rollups उन इनपुट्स पर निर्भर हों।

एक कवरेज डैशबोर्ड तभी उपयोगी रहता है जब लोग उस पर भरोसा कर सकें। डेपLOYमेंट और ऑपरेशंस को उत्पाद का हिस्सा मानें: अनुमानित रिलीज़, स्पष्ट हेल्थ सिग्नल, और कुछ भी टूटे तो आसान recovery।

एक आंतरिक ऐप के लिए low overhead और त्वरित इटरेशन पर ऑप्टिमाइज़ करें।

यदि आप Koder.ai जैसे प्लेटफ़ॉर्म का प्रयोग कर रहे हैं तो सोर्स-कोड एक्सपोर्ट और डिप्लॉयमेंट/होस्टिंग वर्कफ़्लो का जल्दी लाभ उठाएँ ताकि आपका इंटरनल ऐप मानक प्रमोशन, रिव्य्ू, और रोलबैक प्रैक्टिस फ़ॉलो करे।

आपको विश्वसनीय संकेतों के लिए जटिल स्टैक की ज़रूरत नहीं है।

ऑटोमेटेड DB बैकअप और रिटेंशन पॉलिसी सेट करें:

रनबुक्स डॉक्यूमेंट करें:

थोड़ी सी ऑपरेशनल डिसिप्लिन "कवरेज" को अंदाज़-ए-गोेस से बचाती है।

एक मॉनिटरिंग ऐप तभी मदद करता है जब टीमें उस पर भरोसा करें और उपयोग करें। रोलआउट को एक उत्पाद लॉन्च की तरह ट्रीट करें: छोटे से शुरू करें, स्पष्ट ownership तय करें, और अपडेट्स के लिए एक पूर्वानुमेय तालमेल बनाएं।

ऑनबोर्डिंग को हल्का और दोहराने योग्य रखें:

एक अच्छा लक्ष्य है "पहले डैशबोर्ड व्यू में 30 मिनट" न कि एक सप्ताह लंबा कॉन्फिगरेशन प्रोजेक्ट।

दो रिदम स्थापित करें:

जब नियम अनपेक्षित रूप से बदलते हैं तो कवरेज राजनीतिक हो सकता है। एक छोटा गवर्नेंस समूह (अक्सर Eng Productivity + Security/Quality) परिभाषित करें जो कर सके:

परिवर्तनों को एक सरल चेंजलॉग पेज पर प्रकाशित करें जैसे /docs/scoring-changelog।

कुछ सरल मैट्रिक्स से अपनाने पर नज़र रखें: active users, services tracked, और freshness compliance (कितनी सर्विसेज़ के पास up-to-date साक्ष्य है)। इनको इस्तेमाल कर के इटरेशन का मार्ग तय करें: बेहतर वेटिंग, समृद्ध साक्ष्य प्रकार, और अतिरिक्त कनेक्टर्स—हमेशा उन सुधारों को प्राथमिकता दें जो टीमों का मैनुअल काम घटाते हैं।

यदि आप अपने आंतरिक learnings सार्वजनिक करने का निर्णय लेते हैं, तो अपने बिल्ड नोट्स और टेम्पलेट्स को स्टैण्डर्ड करने पर विचार करें: Koder.ai का उपयोग करने वाली टीमें अपना डेवलपमेंट वर्कफ़्लो के बारे में कंटेंट बनाकर क्रेडिट कमा सकती हैं या रेफ़रल लिंक के जरिये अन्य उपयोगकर्ताओं को रेफ़र कर सकती हैं, जो आंतरिक टूलिंग पर आगे के इटरेशन को फंड करने में मदद कर सकता है।

ऑटोमेशन कवरेज वह है जिसे आपकी संगठन अंदर यह तय करता है कि "कौन सा काम स्वचालित रूप से हो रहा है" बनाम मैनुअल। भ्रम से बचने के लिए v1 के लिए एक प्राथमिक यूनिट चुनें (उदाहरण: प्रक्रियाएँ, आवश्यकताएँ/नियंत्रण, टेस्ट सूट, या रनबुक) और स्पष्ट नियम लिखें जैसे "आंशिक रूप से ऑटोमेटेड" कदम जिनके लिए अभी भी अनुमोदन चाहिए।

एक अच्छा परिभाषा वह है जहां दो लोग एक ही आइटम को एक जैसा स्कोर करें।

5–10 “टॉप प्रश्न” लिखकर शुरू करें जिन्हें आपके उपयोगकर्ताओं को उत्तर चाहिए, और इन्हें उत्पाद आवश्यकताओं की तरह ट्रीट करें। सामान्य उदाहरण:

विभिन्न दर्शक (QA, Ops, लीडरशिप) अलग-अलग दृश्य चाहते हैं, इसलिए तय करें कि v1 किसकी ज़रूरतों के लिए अनुकूल होगा।

यहां उन जगहों की इन्वेंटरी बनाएं जहाँ “ऑटोमेशन का प्रमाण” रहता है और जिन स्रोतों से आप सत्यापन ले सकते हैं:

रिकार्ड सिस्टम के बिना आप सिर्फ गतिविधि गिन सकते हैं, पर पैठ (coverage) भरोसेमंद नहीं निकाल सकते क्योंकि लक्ष्यों की संपूर्ण सूची आपके पास नहीं होगी।

हर स्रोत के लिए सबसे कम-भंगुर (least-fragile) तरीका चुनें:

साथ ही कनेक्टर की सीमाएँ (rate limits, auth, retention) दस्तावेज़ करें ताकि उपयोगकर्ता डेटा ताज़गी और विश्वास समझ सकें।

इच्छा (intent), दावे (claims), और प्रमाण (proof) को अलग रखें ताकि मैट्रिक्स हरे दिखें पर असल में ऑटोमेशन stale न हो।

व्यावहारिक मॉडल:

“पेपर कवरेज” रोकने के लिए freshness timestamps और प्रमाण नियम लागू करें।

सामान्य फ़ील्ड:

last_seen_at (asset अभी मौजूद है)last_run_at, last_failure_atlast_reviewed_at (किसी ने दावा मान्य किया)फिर एक नियम लागू करें जैसे “पिछले 30 दिनों में N सफल रन होने पर ही आइटम को ऑटोमेटेड माना जाएगा।” यह "मौजूद है" को "अभी काम कर रहा है" से अलग कर देता है।

एक हेडलाइन मैट्रिक चुनें और स्कोरिंग नियम स्पष्ट लिखें।

आम हेडलाइन विकल्प:

वेट्स को साधारण रखें (उदा., 1–5) और यह दस्तावेज़ करें कि “automated / partially automated / manual” का क्या अर्थ है, ठोस उदाहरणों के साथ।

पहले ही पहचान और normalize करें और rename/duplicates को स्पष्ट रूप से संभालें।

व्यावहारिक कदम:

service_aliases, repo_aliases) का प्रयोग करें जो बाहरी नामों को एक canonical ID से मैप करें।यह duplicates रोकता है और टीमों के reorganize/rename होने पर historical ट्रेंड्स सुरक्षित रखता है।

अगर उपलब्ध हो तो SSO (OIDC/SAML) से शुरुआत करें, नहीं तो अस्थायी रूप से internal auth proxy का उपयोग कर सकते हैं जो identity headers इंजेक्ट करे। एक छोटा रोल सेट परिभाषित रखें और UI व API में अनुमति समान रखें:

संवेदनशील साक्ष्यों को सावधानी से रखें: पूरी लॉग्स की नकल करने के बजाय build IDs, timestamps और छोटे सारांश स्टोर करें। मैन्युअल एडिट्स को audit रिकॉर्ड करें (किसने/क्या/कब/क्यों) और रन हिस्ट्री के लिए retention नीति तय करें।

अलर्ट को actionable बनाएं और ग्लोबल शोर से बचें।

उच्च-सिग्नल अलर्ट प्रकार:

टीम/सर्विस के हिसाब से thresholds अनुमति दें (विभिन्न "stale windows" और paging नियम)। अलर्ट में ड्रिल-डाउन लिंक शामिल करें (उदा., /services/payments?tab=coverage) और acknowledge/assign/status सपोर्ट करें ताकि मुद्दे साफ़ तौर पर बंद हो सकें।

इसके साथ ownership और स्थिर identifiers जोड़ें ताकि rename से इतिहास न टूटे।