03 मई 2025·8 मिनट

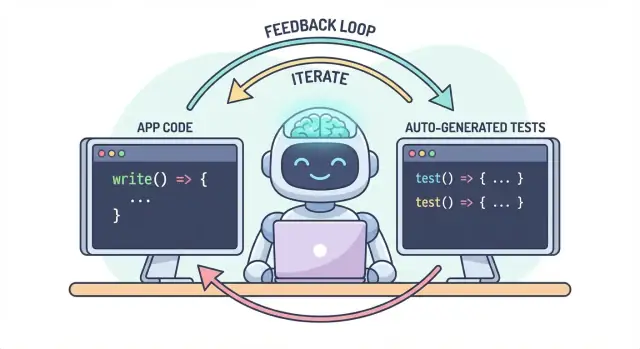

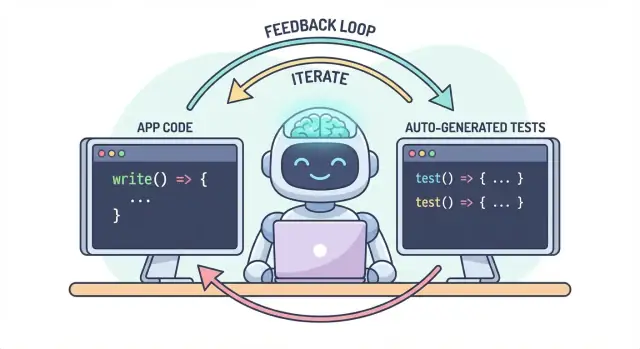

स्वचालित परीक्षण जनरेशन AI-लिखित लॉजिक को कैसे पूरक बनाता है

जानिए क्यों ऑटो-जनरेटेड टेस्ट AI-लिखित ऐप लॉजिक के साथ स्वाभाविक रूप से मेल खाते हैं और कैसे ऐसा वर्कफ़्लो बनाएं जहाँ कोड, टेस्ट और CI चेक एक साथ बेहतर हों।

जानिए क्यों ऑटो-जनरेटेड टेस्ट AI-लिखित ऐप लॉजिक के साथ स्वाभाविक रूप से मेल खाते हैं और कैसे ऐसा वर्कफ़्लो बनाएं जहाँ कोड, टेस्ट और CI चेक एक साथ बेहतर हों।

AI-लिखित एप्लिकेशन लॉजिक का मतलब है कि आपके कोडबेस के “काम करने वाले” हिस्से सहायक की मदद से ड्राफ्ट किए जाते हैं: नई फ़ंक्शन, छोटे फीचर, रीफ़ैक्टर, एज-क़ेस हैंडलिंग, और यहां तक कि मौजूदा मॉड्यूल के राइट-राइट्स। आप अभी भी तय करते हैं क्या बनाना है, लेकिन इम्प्लीमेंटेशन का पहला वर्शन तेज़ी से आता है—और कभी-कभी ऐसे अनुमानों के साथ जो आप बाद में ही नोटिस करते हैं।

ऑटोमेटेड टेस्ट जनरेशन वेरिफिकेशन पक्ष पर मिलती-जुलती क्षमता है। हर टेस्ट हाथ से लिखने की बजाय, टूल्स आपके कोड, किसी स्पेक, या पिछले बग्स से सीखे पैटर्न के आधार पर टेस्ट केस और assertions प्रस्तावित कर सकते हैं। व्यवहार में यह कुछ इस तरह दिखता है:

एक जनरेटेड टेस्ट भ्रामक हो सकता है: यह वर्तमान व्यवहार को असर्ट कर सकता है भले ही व्यवहार गलत हो, या यह उन प्रोडक्ट नियमों को मिस कर सकता है जो लोगों के सिर में और टिकट कमेंट्स में रहते हैं। इसलिए इंसानी समीक्षा मायने रखती है। किसी को पुष्टि करनी चाहिए कि टेस्ट का नाम, सेटअप और assertions असल इरादे को दर्शाते हैं—सिर्फ़ वही नहीं जो आज कोड कर रहा है।

मूल विचार सरल है: कोड और टेस्ट को एक ही वर्कफ़्लो के रूप में एक साथ विकसित होना चाहिए। अगर AI आपको लॉजिक बदलने में मदद करता है, तो ऑटोमेटेड टेस्ट जनरेशन इच्छित व्यवहार को उतनी ही तेजी से लॉक करने में मदद करता है—ताकि अगला परिवर्तन (मानव या AI) के लिए स्पष्टीकृत, executable परिभाषा मौजूद हो कि "अब भी सही है"।

व्यवहार में यह “पेर्ड आउटपुट” तरीका तब बेहतर मैनेज होता है जब आपका डेवलप फ़्लो पहले से ही चैट-चालित हो। उदाहरण के लिए, Koder.ai जैसे प्लेटफ़ॉर्म में (वेब, बैकएंड, और मोबाइल ऐप चैट के ज़रिए बनाने के लिए), "फीचर + टेस्ट" को एक ही डिलीवरबल मानना सहज है: आप व्यवहार वर्णित करते हैं, इम्प्लीमेंटेशन जनरेट करते हैं, फिर उसी बातचीत में टेस्ट जनरेट और रिव्यू करते हैं before deploying।

AI-लिखित कोड एक सुपरपावर जैसा महसूस कर सकता है: फीचर जल्दी आते हैं, बायलरप्लेट गायब हो जाता है, और वे रीफ़ैक्टर जो कभी घंटों लेते थे अब कॉफ़ी ठंडी होने से पहले हो सकते हैं। कैच यह है कि गति जोखिम की प्रकृति बदल देती है। जब कोड बनाना आसान होता है, तो गलतियाँ शिप करना भी आसान होता है—कभी-कभी सूक्ष्म।

AI सहायक “तर्कसंगत” इम्प्लीमेंटेशन जनरेट करने में अच्छे होते हैं, परन्तु तर्कसंगत आपके विशिष्ट डोमेन के लिए सही नहीं होता।

एज केस सबसे पहले प्रभावित होते हैं। AI-जनरेटेड लॉजिक अक्सर हैप्पी पाथ को ठीक हैंडल करता है, पर बाउंडरी कंडीशंस पर ठोकर खाता है: खाली इनपुट, टाइमज़ोन क्यूर्क्स, राउंडिंग, null मान, retry व्यवहार, या "यह कभी नहीं होना चाहिए" जैसे स्टेट जो प्रोडक्शन में हो जाते हैं।

गलत अनुमान एक और आम समस्या है। सहायक कुछ आवश्यकताओं का अनुमान लगा सकता है जो कही गई नहीं थीं ("यूज़र्स हमेशा authenticated हैं", "IDs numeric हैं", "यह फ़ील्ड हमेशा मौजूद है"), या वह कोई परिचित पैटर्न लागू कर सकता है जो आपके सिस्टम के नियमों से मेल नहीं खाता।

छुपे हुए रिग्रेशन अक्सर सबसे महंगे होते हैं। आप छोटे परिवर्तन के लिए कहते हैं, सहायक लॉजिक का एक हिस्सा फिर से लिख देता है, और कुछ असंबंधित टूट जाता है—बिना स्पष्ट एरर के। कोड अभी भी कंपाइल होता है, UI लोड होता है, पर कोई प्राइसिंग नियम, permission चेक, या डेटा कन्वर्ज़न थोड़ी सी गलत हो सकती है।

जब कोड बदलाव तेज़ हो जाते हैं, मैन्युअल टेस्टिंग बाधा बन जाती है और सट्टा बन जाती है। या तो आप ज़्यादा समय क्लिकिंग में खर्च करते हैं (डिलीवरी धीमी होती है), या आप कम टेस्ट करते हैं (escape बढ़ता है)। यहां तक कि अनुशासित QA टीमें भी हर वैरिएंट मैन्युअली कवर नहीं कर सकतीं जब बदलाव बार-बार और व्यापक हों।

बुरा यह है कि मैन्युअल चेक्स को दोहराना कठिन है। वे किसी की स्मृति या चेकलिस्ट में रहते हैं, और डेडलाइन्स कड़े होने पर उन्हें छोड़ना आसान है—बिल्कुल वही समय जब रिस्क सबसे अधिक होता है।

ऑटोमेटेड टेस्ट्स एक स्थायी सुरक्षा जाल बनाते हैं: वे अपेक्षाओं को executable बनाते हैं। एक अच्छा टेस्ट कहता है, "इन इनपुट्स और इस संदर्भ में, यह वह आउटपुट है जिस पर हम निर्भर करते हैं।" यह सिर्फ़ वेरिफिकेशन नहीं है; यह भविष्य के आप, टीममेट्स, और यहां तक कि AI सहायक के लिए संचार है।

जब टेस्ट मौजूद होते हैं, तो परिवर्तन कम डरावने लगते हैं क्योंकि फ़ीडबैक तत्काल होता है। कोड रिव्यू, स्टेजिंग, या ग्राहकों से समस्या खोजने के बजाय आप मिनटों में समस्याएँ पाते हैं।

किसी बग को जितना पहले पकड़ा जाता है, उसे ठीक करना उतना सस्ता होता है। टेस्ट फ़ीडबैक लूप को छोटा करते हैं: वे mismatched assumptions और छूटी हुई एज केस्स को तब surfaced करते हैं जब इरादा ताज़ा हो। इससे रीवर्क घटता है, “fix-forward” पैच्स बचते हैं, और AI गति को AI-चालित churn में बदलने से रोका जा सकता है।

AI-लिखित कोड तब सबसे तेज़ है जब आप उसे एक एक बातचीत की तरह ट्रीट करते हैं, ना कि एक बार का डिलीवरबल। टेस्ट वही चीज़ हैं जो उस बातचीत को मापनीय बनाते हैं।

स्पेक: आप बताते हैं क्या होना चाहिए (इनपुट, आउटपुट, एज केस)।

कोड: AI इम्प्लीमेंटेशन लिखता है जो उस विवरण से मेल करने का दावा करता है।

टेस्ट्स: आप (या AI) चेक्स जनरेट करते हैं जो साबित करते हैं कि व्यवहार वास्तव में सच है।

इस लूप को दोहराएँ और आप सिर्फ़ ज़्यादा कोड नहीं बना रहे होते—आप लगातार "डन" की परिभाषा को कस रहे होते हैं।

"invalid users को gracefully हैंडल करो" जैसा अस्पष्ट requirement कोड में आसानी से अनदेखा हो सकता है। एक टेस्ट अस्पष्ट नहीं हो सकता। यह स्पेसिफिस करता है:

जैसे ही आप उन विवरणों को टेस्ट में व्यक्त करने की कोशिश करते हैं, अस्पष्ट हिस्से तुरंत surfaced होते हैं। वह स्पष्टता AI को दिया गया प्रॉम्प्ट बेहतर बनाती है और अक्सर सरल, स्थिर इंटरफेस की ओर ले जाती है।

AI कोड सही दिख सकता है परंतु अनुमान छिपा सकता है। जनरेटेड टेस्ट्स उन दावों को सत्यापित करने का व्यावहारिक तरीका हैं जिनका कोड दावा कर रहा है:

लक्ष्य यह नहीं है कि जनरेटेड टेस्ट्स पर अंधविश्वास किया जाए—बल्कि उन्हें तेज़, संरचित संशय के रूप में उपयोग करना है।

एक फेलिंग टेस्ट कार्रवाई योग्य फ़ीडबैक है: यह स्पेस और इम्प्लीमेंटेशन के बीच विशिष्ट mismatch की ओर इशारा करता है। AI से कहने की बजाय "इसे ठीक करो", आप फेलियर पेस्ट कर सकते हैं और कह सकते हैं: “कोड अपडेट करें ताकि यह टेस्ट बिना public API बदले पास हो।” यह debugging को एक फोकस्ड iteration बनाता है बजाए अटकलों के खेल के।

ऑटोमेटेड टेस्ट जनरेशन तब सबसे उपयोगी है जब यह आपके मौजूदा टेस्ट रणनीति का समर्थन करता है—खासकर क्लासिक "टेस्ट पिरामिड"। पिरामिड अपने आप में नियम नहीं है; यह फ़ीडबैक को तेज और भरोसेमंद रखने का तरीका है जबकि वास्तविक दुनिया की विफलताओं को पकड़ता है।

AI हर लेयर पर टेस्ट जनरेट करने में मदद कर सकता है, पर सबसे अच्छे परिणाम तब मिलते हैं जब आप सस्ते टेस्ट्स (पिरामिड के निचले भाग) ज़्यादा जनरेट करें और महँगे टेस्ट्स (ऊपर) कम—यह संतुलन आपके CI पाइपलाइन को तेज़ रखता है और यूज़र अनुभव की रक्षा करता है।

यूनिट टेस्ट छोटे चेक होते हैं व्यक्तिगत फ़ंक्शन्स, मेथड्स, या मॉड्यूल्स के लिए। वे तेज़ चलते हैं, बाहरी सिस्टम की ज़रूरत नहीं होती, और एज केस कवर करने के लिए AI-जनरेटेड कवरेज के लिए आदर्श हैं।

ऑटोमेटेड टेस्ट जनरेशन का अच्छा उपयोग यहाँ है:

यूनिट टेस्ट संकीर्ण रूप से स्कोप्ड होने के कारण, उन्हें रिव्यू करना आसान है और वे कम flaky होते हैं।

इंटीग्रेशन टेस्ट यह जाँचते हैं कि हिस्से कैसे साथ काम करते हैं: आपका API DB के साथ, एक सेवा दूसरी सेवा को कॉल कर रही है, queue processing, authentication, आदि।

AI-जनरेटेड इंटीग्रेशन टेस्ट्स मूल्यवान हो सकते हैं, पर इनके लिए अधिक अनुशासन चाहिए:

इन्हें "कॉन्ट्रैक्ट चेक्स" समझें जो साबित करते हैं कि कॉम्पोनेंट्स के बीच सीमाएँ अब भी बनी हुई हैं।

E2E टेस्ट्स महत्वपूर्ण यूज़र फ्लो को वैलिडेट करते हैं। वे सबसे महंगे भी होते हैं: चलने में धीमे, ज्यादा brittle, और डिबग करने में कठिन।

ऑटोमेटेड टेस्ट जनरेशन E2E पर परिदृश्य ड्राफ्ट करने में मदद कर सकता है, लेकिन आपको इन्हें कठोरता से क्यूरेट करना चाहिए। कुछ क्रिटिकल पाथ्स रखें (signup, checkout, core workflow) और हर फीचर के लिए E2E जनरेट करने से बचें।

सब कुछ जनरेट करने का लक्ष्य न रखें। इसके बजाय:

यह दृष्टिकोण पिरामिड को बरकरार रखता है—और ऑटोमेटेड टेस्ट जनरेशन को एक बल-गुणा बनाता है बजाय शोर के स्रोत के।

ऑटोमेटेड टेस्ट जनरेशन सिर्फ़ "इस फ़ंक्शन के लिए यूनिट टेस्ट लिखो" तक सीमित नहीं है। सबसे उपयोगी जनरेटर्स तीन स्रोतों से खींचते हैं: आपके पास मौजूद कोड, उसके पीछे का इरादा, और उन फेलियर्स जो आपने पहले देखे हैं।

किसी फ़ंक्शन या मॉड्यूल को देखकर टूल्स इनपुट/आउटपुट, ब्रांचेस, और exception paths से टेस्ट केस infer कर सकते हैं। आमतौर पर इसका मतलब:

यह स्टाइल AI-लिखित लॉजिक के चारों तरफ ऐसे चेक जल्दी से बनाकर यह सुनिश्चित करने के लिए बढ़िया है कि आज यह क्या कर रहा है।

अगर आपके पास acceptance criteria, user stories, या example tables हैं, जनरेटर उन्हें ऐसे टेस्ट्स में बदल सकते हैं जो स्पेक की तरह पढ़े जाते हैं। यह अक्सर कोड-आधारित टेस्ट्स से अधिक मूल्यवान होता है क्योंकि यह "क्या होना चाहिए" को लॉक करता है, न कि "अभी क्या हो रहा है"।

एक व्यावहारिक पैटर्न: कुछ ठोस उदाहरण (इनपुट + अपेक्षित आउटपुट) दें और जनरेटर से कहें कि उन नियमों के अनुरूप एज केस जोड़ें।

बग-आधारित जनरेशन अर्थपूर्ण रिग्रेशन सूट बनाने का तेज़ तरीका है। steps to reproduce (या logs और एक minimal payload) दें और जनरेट करें:

Snapshot (golden) टेस्ट्स स्थिर आउटपुट्स (रेंडर्ड UI, serialized responses) के लिए कुशल हो सकते हैं। इन्हें सावधानी से उपयोग करें: बड़े स्नैपशॉट्स सूक्ष्म गलतियों को “approve” कर सकते हैं। छोटे, फोकस्ड स्नैपशॉट्स पसंद करें और प्रमुख फ़ील्ड्स पर assertions जोड़ें जो निश्चित रूप से सही होने चाहिए।

ऑटोमेटेड टेस्ट जनरेशन तब सबसे प्रभावी है जब आप इसे स्पष्ट प्राथमिकताएँ देते हैं। पूरे कोडबेस पर "सभी टेस्ट बनाओ" कहेंगे तो शोर मिलेगा: कम-मूल्य वाले चेक्स, डुप्लिकेट कवरेज, और नाज़ुक टेस्ट्स जो डिलीवरी धीमी कर देंगे।

उन फ्लोज़ से शुरुआत करें जिन्हें टूटने पर सबसे महंगा लगेगा—या तो वित्तीय, कानूनी, या प्रतिष्ठा के हिसाब से। जोखिम-आधारित फ़िल्टर स्कोप को व्यावहारिक रखता है और क्विक क्वालिटी इम्प्रूवमेंट देता है।

पहले ध्यान दें:

प्रत्येक चुने गए फ्लो के लिए, लेयर्स में टेस्ट जनरेट करें: जटिल लॉजिक के लिए कुछ तेज़ यूनिट टेस्ट्स, और फिर वह पूरा पाथ काम कर रहा है यह सुनिश्चित करने के लिए एक-दो इंटीग्रेशन टेस्ट्स।

वास्तविक विफलताओं के अनुरूप कवरेज मांगें, न कि सैद्धांतिक permutations। एक अच्छा प्रारंभिक सेट है:

बाद में बग्स, incident reports, या यूज़र फीडबैक के आधार पर विस्तार कर सकते हैं।

नियम स्पष्ट करें: एक फीचर तब पूरा नहीं माना जाएगा जब तक टेस्ट न हों। यह डिफ़िनिशन AI-लिखित कोड के साथ और भी महत्वपूर्ण है, क्योंकि यह रोकता है कि "तेज़ शिपिंग" चुपचाप "तेज़ रिग्रेशन" न बन जाए।

अगर आप चाहते हैं कि यह अठन्न रहे, तो इसे अपने वर्कफ़्लो में जोड़ें (उदा., merge से पहले संबंधित टेस्ट ज़रूर हों CI में) और टीम दस्तावेज़ में लिंक करें (उदा., /engineering/definition-of-done)।

AI तेज़ी से टेस्ट जनरेट कर सकता है, पर गुणवत्ता काफी हद तक आप कैसे पूछते हैं उस पर निर्भर करती है। लक्ष्य मॉडल को ऐसे टेस्ट्स की ओर निर्देशित करना है जो व्यवहार की रक्षा करें—न कि ऐसे टेस्ट्स जो सिर्फ़ कोड को execute करें।

शुरूआत में टेस्ट्स का "आकार" पिन करें ताकि आउटपुट आपके रेपो से मेल खाए।

शामिल करें:

should_<behavior>_when_<condition>)src/ और tests/, या __tests__/)यह मॉडल को आपकी टीम द्वारा उपयोग किए न जाने वाले पैटर्न बनाने से रोकेगा।

एक मौजूदा टेस्ट फ़ाइल (या एक छोटा excerpt) पेस्ट करें और स्पष्ट कहें: “इस स्टाइल को मैच करें।” यह निर्णयों को एंकर करता है जैसे टेस्ट डेटा कैसे व्यवस्थित किया जाए, वेरिएबल्स का नामकरण, और क्या आप table-driven टेस्ट पसंद करते हैं।

अगर आपके प्रोजेक्ट में helpers हैं (उदा., buildUser() या makeRequest()), उन स्निपेट्स को भी शामिल करें ताकि जनरेटेड टेस्ट्स उन्हें पुन: उपयोग करें बजाय फिर से इम्प्लीमेंट करने के।

"अच्छा" क्या दिखता है इस बारे में स्पष्ट रहें:

एक उपयोगी प्रॉम्प्ट लाइन: “प्रत्येक टेस्ट में कम से कम एक assertion होना चाहिए जो बिजनेस व्यवहार की जाँच करे (केवल ‘कोई exception नहीं’ नहीं)।”

अधिकांश AI-जनरेटेड सूट्स हैप्पी पाथ की ओर झुकते हैं। इसे संतुलित करने के लिए आग्रह करें:

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

(ऊपर मौजूद कोड ब्लॉक को अनुवादित न करें।)

AI तेज़ी से बहुत सारे टेस्ट ड्राफ्ट कर सकता है, पर यह फैसला नहीं कर सकता कि वे टेस्ट आपकी मंशा का प्रतिनिधित्व करते हैं या नहीं। एक इंसानी पास उन्हें "टेस्ट जो रन होते हैं" से "टेस्ट जो हमें बचाते हैं" में बदल देता है। लक्ष्य शैली पर न फोकस कर के यह पुष्टि करना है कि टेस्ट सूट अर्थपूर्ण रिग्रेशन्स पकड़ेगा बिना मेंटेनेंस टैक्स बनकर रह जाने के।

दो प्रश्न पूछकर शुरू करें:

जनरेटेड टेस्ट कभी-कभी आकस्मिक व्यवहार (वर्तमान implementation details) को लॉक कर देते हैं बजाए इच्छित नियम के। अगर कोई टेस्ट कोड की प्रति जैसा पढ़ता है बजाय अपेक्षित परिणाम के विवरण के, तो उसे उच्च-स्तरीय assertions की ओर धकेलें।

आम स्रोतों में ओवर-मॉकिंग, हार्ड-कोडेड टाइमस्टैम्प, और रैंडम वैल्यूज़ हैं। निर्धारक इनपुट और स्थिर assertions पसंद करें (उदा., कच्चे Date.now() स्ट्रिंग के बजाय पार्स की गई तारीख या रेंज पर assertion)। यदि कोई टेस्ट पास होने के लिए अत्यधिक mocking मांगता है, तो संभव है वह wiring टेस्ट कर रहा है न कि व्यवहार।

एक "पास" टेस्ट तब भी बेकार हो सकता है अगर वह फेल होने पर भी फीचर टूटने पर पास हो जाए (false positive)। कमजोर assertions जैसे “does not throw” या सिर्फ यह जाँचना कि कोई फ़ंक्शन कॉल हुआ—इस तरह के परीक्षणों को मजबूत करके आउटपुट, स्टेट चेंज, रिटर्न किए गए एरर्स, या persist किए गए डेटा पर assertion करें।

एक सरल चेकलिस्ट समीक्षाओं को सुसंगत रखता है:

जनरेटेड टेस्ट्स को किसी भी अन्य कोड की तरह ट्रीट करें: वही मर्ज करें जो आप छह महीने में भी रखने के लिए तैयार हों।

AI आपकी मदद से कोड जल्दी लिखवा सकता है, पर असली जीत यह है कि वह कोड समय के साथ सही रहे। सबसे सरल तरीका है कि हर बदलाव पर टेस्ट और चेक्स स्वतः चलें—ताकि रिग्रेशन शिप होने से पहले पकड़ में आ जाएँ।

कई टीमें जो वज़नदार नहीं हैं, वे यह फ्लो अपनाती हैं:

अंतिम कदम मायने रखता है: AI-लिखित लॉजिक बिना संबंधित टेस्ट के धीरे-धीरे drift कर जाता है। टेस्ट के साथ आप इरादे रिकॉर्ड कर रहे हैं जिसे CI लागू कर सकता है।

अपने CI पाइपलाइन को हर pull request पर (और आदर्श रूप से main पर merge पर) चलाने के लिए कॉन्फ़िगर करें। न्यूनतम रूप से, इसे करना चाहिए:

यह “मेरी मशीन पर हुआ” आश्वासन को रोकता है और पकड़ता है जब कोई teammate (या बाद का AI प्रॉम्प्ट) कहीं और कोड बदलता है।

टेस्ट्स जरूरी हैं, पर वे सब कुछ पकड़ते नहीं। कुछ छोटे, तेज़ गेट्स जोड़ें जो टेस्ट जनरेशन की पूरक हों:

इन चेक्स को तेज़ रखें—अगर CI धीमा या noisy लगेगा तो लोग इसे बायपास करने के तरीके ढूँढ लेंगे।

अगर आप और टेस्ट जनरेट करने से CI रन बढ़ा रहे हैं, तो सुनिश्चित करें आपकी बजट नई cadence के अनुरूप हो। अगर आप CI मिनट्स ट्रैक करते हैं, तो सीमाएँ और विकल्प समीक्षा करने लायक हैं (देखें /pricing)।

AI-लिखित कोड के साथ काम करने का एक प्रभावी तरीका यह है कि फेल होते हुए टेस्ट्स को अपने “अगले प्रॉम्प्ट” की तरह ट्रीट करें। फीचर को व्यापक रूप से “सुधारने” के बजाय, आप AI को एक ठोस failure देते हैं और वह failure परिवर्तन को सीमित कर देता है।

इसके बजाय:

उपयोग करें:

shouldRejectExpiredToken. यहाँ failure output और संबंधित कोड है। Implementation अपडेट करें ताकि यह टेस्ट बिना unrelated व्यवहार बदले पास हो। अगर ज़रूरत हो, एक रिग्रेशन टेस्ट जोड़ें जो बग को कैप्चर करे।”फेलिंग टेस्ट अटकलों को खत्म कर देते हैं। वे executable रूप में परिभाषित करते हैं कि "सही" क्या है, इसलिए आप चैट में requirements पर बहस नहीं कर रहे। आप बढ़ते edits से भी बचते हैं: हर प्रॉम्प्ट एक मापनीय परिणाम के लिए स्कोप्ड होता है, जिससे मानव समीक्षा तेज़ होती है और यह देखना आसान होता है कि AI ने symptom ठीक किया पर कहीं और तो नहीं तोड़ा।

यहाँ पर agent-style वर्कफ़्लो भी लाभ दे सकता है: एक एजेंट न्यूनतम कोड चेंज पर ध्यान दे, दूसरा सबसे छोटा टेस्ट समायोजन सुझाए, और आप diff रिव्यू करें। Koder.ai जैसे प्लेटफ़ॉर्म इस तरह के iterative, चैट-फर्स्ट डेवलपमेंट फ़्लो के आसपास बने हैं—जो “टेस्ट्स को अगले प्रॉम्प्ट के रूप में” को डिफ़ॉल्ट मोड की तरह बनाते हैं।

ऑटोमेटेड टेस्ट जनरेशन आपकी टेस्ट सूट को रातोंरात बड़ा कर सकता है—पर "बड़ा" मतलब "बेहतर" नहीं होता। लक्ष्य आत्मविश्वास है: रिग्रेशन्स जल्दी पकड़ना, प्रोडक्शन दोष घटाना, और टीम को चलते रखना।

उत्पादन-नक्शे संकेतों से शुरू करें:

कवरेज उपयोगी स्मोक अलार्म हो सकता है—खासकर अनटेस्टेड क्रिटिकल पाथ्स ढूँढने में—पर इसे गेम करना आसान है। जनरेटेड टेस्ट्स कवरेज को फुल कर सकते हैं जबकि assertions बहुत कमजोर हों। पसंद रखें:

अगर आप सिर्फ टेस्ट काउंट या कवरेज ट्रैक करते हैं, तो आप वॉल्यूम के लिए optimize करेंगे। ट्रैक करें रिलीज़ से पहले पकड़े गए दोष: CI, QA, या स्टेजिंग में पाए गए बग जो उपयोगकर्ताओं तक नहीं पहुंचे। जब ऑटोमेटेड टेस्ट जनरेशन काम कर रहा हो, तो यह संख्या बढ़ेगी जबकि प्रोडक्शन incidents घटेंगे।

जनरेटेड सूट्स में मेंटेनेंस की आवश्यकता होती है। कैलेंडर पर नियमित कार्य रखें:

सफलता एक शांत CI, तेज़ फ़ीडबैक, और कम सरप्राइज़ है—न कि सिर्फ़ एक प्रभावशाली डैशबोर्ड।

ऑटोमेटेड टेस्ट जनरेशन क्वालिटी तेज़ी से बढ़ा सकता है—पर केवल तब जब आप इसे एक सहायक मानें, न कि अधिकार। सबसे बड़े विफलताएँ अक्सर सभी टीमों में एक जैसी दिखती हैं, और वे टाला जा सकते हैं।

ओवर-रिलायंस क्लासिक जाल है: जनरेटेड टेस्ट्स सुरक्षा की ilusio दे सकते हैं जबकि वे असली जोखिमों को मिस कर रहे हैं। अगर लोग सोच न छोड़ दें (“टूल ने टेस्ट लिखे, तो हम कवर हैं”), तो आप और तेज़ी से बग शिप करेंगे—बस ज़्यादा ग्रीन चेकमार्क्स के साथ।

एक और आम समस्या है implementation details का टेस्ट करना न कि व्यवहार का। AI टूल्स अक्सर मौजूदा method names, internal helpers, या exact error messages पर अटक जाते हैं। वे टेस्ट्स brittle बन जाते हैं: रिफैक्टर से टूट जाते हैं भले ही फीचर काम कर रहा हो। ऐसे टेस्ट्स से बचें जो क्या होना चाहिए की जगह कैसे हो रहा है पर निर्भर हों।

टेस्ट जनरेशन अक्सर कोड, स्टैक ट्रेस, लॉग्स, या स्पेक्स को प्रॉम्प्ट में कॉपी करने की मांग कर सकता है। इससे secrets (API keys), कस्टमर डेटा, या मालिकाना लॉजिक लीक हो सकता है।

प्रॉम्प्ट्स और टेस्ट फिक्स्चर संवेदनशील जानकारी से मुक्त रखें:

अगर आप किसी होस्टेड AI dev प्लेटफ़ॉर्म का उपयोग करते हैं, तो वही अनुशासन लागू करें। प्लेटफ़ॉर्म आधुनिक होस्टिंग और क्षेत्र-आधारित ऑप्शंस क्यों न दे, आपके प्रॉम्प्ट्स और फिक्स्चर अभी भी आपकी सुरक्षा पॉलिसी का हिस्सा हैं।

छोटे शुरू करें और इसे रूटीन बनाएं:

लक्ष्य अधिकतम टेस्ट नहीं है—बल्कि भरोसेमंद फ़ीडबैक है जो AI-लिखित लॉजिक को ईमानदार रखता है।

क्योंकि AI परिवर्तन को तेज कर सकता है, यह गलत अनुमानों और सूक्ष्म रिग्रेशन की दर भी बढ़ा देता है। जनरेटेड टेस्ट्स इच्छित व्यवहार को तेजी से, executable रूप में लॉक करने का तरीका हैं ताकि भविष्य के परिवर्तन (मनुष्य या AI द्वारा) मिलने पर तुरंत फ़ीडबैक मिले।

नहीं। एक जनरेटेड टेस्ट मौजूदा व्यवहार को ही ‘स्वीकृत’ कर सकता है भले ही वह व्यवहार गलत हो, या वह उन व्यापारिक नियमों को छोड़ सकता है जो कोड में स्पष्ट नहीं हैं। जनरेटेड टेस्ट्स को ड्राफ्ट मानें: नाम, सेटअप और assertion यह सुनिश्चित करने के लिए इंसानी समीक्षा ज़रूरी है कि वे उत्पाद के इरादे को दर्शाते हैं।

जब आपको नए या बदले हुए लॉजिक के चारों ओर तेज़, संरचित कवरेज चाहिए—खासकर AI-सहायता प्राप्त रीफ़ैक्टरिंग के बाद। यह विशेष रूप से उपयोगी है:

पहले सबसे कम-लागत, उच्च-सिग्नल लेयर: यूनिट टेस्ट्स।

व्यवहार-केंद्रित टेस्ट जिन्हें “सही वजह” से फेल होना चाहिए। कमजोर चेक्स को मजबूत करें:

अधिकतर ब्रेकीनेस के स्रोत: ओवर-मॉकिंग, हार्ड-कोडेड टाइमस्टैम्प, रैंडम डेटा, और आंतरिक method calls पर assertions। निर्धारक इनपुट और स्थिर assertions पसंद करें, और सार्वजनिक व्यवहार का परीक्षण करें ताकि हल्के-फैक्टर रिफैक्टर से सूट टूटी न जाए।

एक तंग लूप का उपयोग करें:

यह सुनिश्चित करता है कि “डन” executable अपेक्षाओं से जुड़ा रहे, सिर्फ़ मैन्युअल चेक से नहीं।

सीमाएँ और असली रेपो संदर्भ शामिल करें:

यह मॉडल को अनचाहे पैटर्न बनाने से रोकता है और समीक्षा योग्य आउटपुट देता है।

प्रॉम्प्ट में कोड, स्टैक ट्रेस या लॉग्स पेस्ट करने से संवेदनशील जानकारी लीक हो सकती है। निम्न बातों से बचें:

सिंथेटिक फिक्स्चर उपयोग करें, आक्रामक रूप से redact करें, और साझा संदर्भ को केवल जरूरी तक सीमित रखें।

वॉल्यूम की जगह परिणामों पर ध्यान दें:

कवरेज को संकेत के रूप में देखें, न कि लक्ष्य के रूप में, और समय-समय पर कचरा/दोहराव हटाएँ ताकि सूट में मान रखा जा सके।