23 अक्टू॰ 2025·8 मिनट

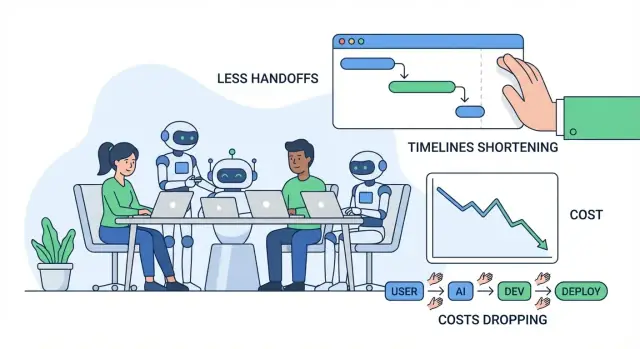

AI टूल कैसे सॉफ़्टवेयर बिल्ड्स में लागत, समय और घर्षण घटाते हैं

AI टूल कहाँ-कहाँ सॉफ़्टवेयर की लागत, समय, और घर्षण घटाते हैं — प्लानिंग, कोडिंग, टेस्टिंग, रिलीज़ और सपोर्ट में व्यावहारिक वर्कफ़्लो के साथ।

सॉफ़्टवेयर काम में “लागत, समय, और घर्षण” का क्या मतलब है

जब लोग सॉफ़्टवेयर डिलीवरी सुधारने की बात करते हैं, तो वे आमतौर पर तीन चीज़ें कहते हैं: लागत, समय, और घर्षण। ये निकट से जुड़े हैं, पर एक जैसे नहीं—और AI की बात करने से पहले इन्हें साधारण शब्दों में परिभाषित करना मददगार है।

लागत: आप परिणामों के लिए क्या चुकाते हैं

लागत उस कुल खर्च को कहता है जो किसी फीचर को भेजने और बनाए रखने में लगता है: सैलेरी और ठेकेदार के घंटे, क्लाउड बिल, टूलिंग, और बैठकों, समन्वय, और गलतियों को ठीक करने के "छिपे" खर्च। एक फीचर जो दो अतिरिक्त हफ्ते लेता है, सिर्फ़ इंजीनियरिंग समय ही महंगा नहीं बनाता—यह राजस्व को भी देर से लाता है, सपोर्ट बोझ बढ़ाता है, या आपको पुराने सिस्टम अधिक समय तक चलाने के लिए मजबूर कर सकता है।

समय: विचार से शिप होने तक कितना समय लगता है

समय वह कैलेंडर समय है “हमें यह बनाना चाहिए” से लेकर “ग्राहक इसे भरोसेमंद तरीके से इस्तेमाल कर सकते हैं” तक। इसमें विकास के साथ-साथ निर्णय, अनुमोदन, समीक्षा का इंतज़ार, एनवायरनमेंट का इंतज़ार, QA परिणामों का इंतज़ार, और सही संदर्भ वाले किसी व्यक्ति के उत्तर के इंतज़ार भी शामिल है।

घर्षण: घर्षण, भ्रम और व्यवधानों में खोया प्रयास

घर्षण वह रोज़मर्रा का घर्षण है जो काम को धीमा महसूस कराता है: अस्पष्ट आवश्यकताएँ, लगातार स्पष्टीकरण की मांग, संदर्भ बदलना, दूहराया गया काम, या भूमिकाओं/टीमों के बीच लंबी हैंडऑफ़्स।

अधिकांश बर्बादी सॉफ़्टवेयर परियोजनाओं में हैंडऑफ़्स, रीवर्क, और इंतज़ार के रूप में दिखती है। एक छोटी सी गलतफहमी शुरू में बाद में redesign, बग खोज, या बार-बार मीटिंग्स में बदल सकती है। धीमी रिव्यू कतार या गायब दस्तावेज़ीकरण तब भी प्रगति को रोक सकता है जब हर कोई "व्यस्त" हो।

“AI टूल” से क्या मतलब है (और क्या नहीं)

इस लेख में, AI टूल में कोडिंग copilots, रिसर्च और व्याख्याओं के लिए चैट असिस्टेंट, आवश्यकताओं और टिकटों के लिए स्वचालित विश्लेषण, टेस्ट जनरेशन हेल्पर्स, और QA/DevOps में वर्कफ़्लो ऑटोमेशन शामिल हैं।

AI प्रयास और चक्रों को कम कर सकता है—पर यह ज़िम्मेदारी नहीं हटाता। टीमों को अभी भी स्पष्ट मालिकाना, अच्छा निर्णय, सुरक्षा नियंत्रण, और जो शिप होता है उस पर मानव अनुमोदन की आवश्यकता है।

सॉफ़्टवेयर परियोजनाएँ सामान्यतः कहाँ समय और पैसा खो देती हैं

अधिकांश सॉफ़्टवेयर ओवररन्स "कठिन कोडिंग" से नहीं आते। वे रोज़मर्रा की बाधाओं से आते हैं जो एकत्रित हो जाती हैं: अस्पष्ट आवश्यकताएँ, लगातार संदर्भ-स्विचिंग, धीमी रिव्यू लूप, और बहुत देर से होने वाला मैनुअल परीक्षण।

सामान्य बाधाएँ (और वे महंगी क्यों हैं)

अस्पष्ट आवश्यकताएँ सबसे बड़ा डाउनस्ट्रीम खर्च पैदा करती हैं। एक छोटी गलतफहमी शुरू में बाद में एक हफ्ते के रीवर्क में बदल सकती है—विशेषकर जब अलग-अलग लोग उसी फीचर को अलग तरीके से समझते हैं।

संदर्भ-स्विचिंग उत्पादकता का मौन घातक है। इंजीनियर टिकटों, चैट प्रश्नों, मीटिंग्स, और प्रोडक्शन समस्याओं के बीच उछलते हैं। हर स्विच की एक रिस्टार्ट लागत होती है: कोडबेस, निर्णय इतिहास, और "क्यों" को फिर से लोड करना।

धीमी रिव्यूज़ सिर्फ मर्ज को देर से नहीं करते—वे सीखने को भी देर से करते हैं। यदि फ़ीडबैक दिनों बाद आता है, तो लेखक पहले ही किसी अन्य काम पर चला गया होता है, और फिक्स अधिक समय लेता है।

मैनुअल परीक्षण और देर से QA अक्सर इसका मतलब होता है कि समस्याएँ तब पाई जाती हैं जब उन्हें ठीक करना सबसे महंगा होता है: कई फीचर्स के बाद या ठीक रिलीज़ से पहले।

लोग जिन छिपे हुए खर्चों का बजट नहीं बनाते

स्पष्ट खर्च सैलेरी और वेंडर बिल हैं। छिपे हुए खर्च आमतौर पर अधिक दुःख देते हैं:\n\n- रीवर्क: कोड फिर से लिखना और फ्लोज़ को री-डिज़ाइन करना क्योंकि आवश्यकताएँ बदल गईं या गलत समझी गईं।\n- विलंब: निर्णयों, अनुमोदनों, टेस्ट एनवायरनमेंट्स, या "एक प्रमुख व्यक्ति" के उत्तर का इंतज़ार।\n- समन्वय ओवरहेड: उत्पाद, डिज़ाइन, इंजीनियरिंग, QA, सुरक्षा, और स्टेकहोल्डर्स के बीच सिंक करना।

एक सरल विचार → रिलीज़ वर्कफ़्लो (दर्द बिंदुओं के साथ)

Idea → requirements → design → build → review → test → release → monitor

आम दर्द बिंदु: requirements (अस्पष्टता), build (विचलन), review (कतार समय), test (मैनुअल प्रयास), release (हैंडऑफ़्स), monitor (धीमी ट्रबलशूटिंग)।

त्वरित निदान: घर्षण मैपिंग

एक 30-मिनट सेशन में "घर्षण मानचित्र" आज़माएँ: प्रत्येक चरण सूचीबद्ध करें, फिर (1) जहाँ काम रुका है, (2) जहाँ निर्णय अटके हैं, और (3) जहाँ रीवर्क होता है, चिह्नित करें। वे चिह्नित क्षेत्र वे हैं जहाँ AI टूल अक्सर सबसे तेज़ बचत पैदा करते हैं—गलतफहमियों को कम करके, फ़ीडबैक तेज़ करके, और दोहराव वाले मैनुअल काम को काटकर।

AI-समर्थित डिस्कवरी और आवश्यकताएँ: कम गलतफहमियाँ

डिस्कवरी वह जगह है जहाँ कई परियोजनाएँ चुपचाप रास्ता भटक जाती हैं: नोट्स बिखरे होते हैं, फ़ीडबैक विरोधाभासी होता है, और निर्णय लोगों के सिर में रहते हैं। AI उपयोगकर्ताओं से बात करने की जगह नहीं ले सकता, पर यह बातचीत, दस्तावेज़, और जो इंजीनियर वास्तव में बनाते हैं उनके बीच का "अनुवाद घाटा" कम कर सकता है।

गंदे इनपुट्स को उपयोगी आवश्यकताओं में बदलना

टीमें अक्सर शोध नोट्स का ढेर इकट्ठा करती हैं—इंटरव्यू ट्रांसक्रिप्ट, सपोर्ट टिकट, सेल्स कॉल स्निपेट, सर्वे उत्तर—और फिर पैटर्न तुरंत निकालने में संघर्ष करती हैं। AI टूल इस चरण को तेज़ कर सकते हैं:\n\n- लंबी शोध नोट्स को संगत निष्कर्षों (दर्द-बिंदु, लक्ष्य, आपत्तियाँ) में संक्षेपित करना\n- फ़ीडबैक को थीम्स में क्लस्टर करना (जैसे ऑनबोर्डिंग भ्रम बनाम गायब इंटीग्रेशन)\n- कच्चे इनपुट से प्रारंभिक यूज़र स्टोरीज़ और jobs-to-be-done बयान ड्राफ्ट करना\n\nयह स्वतः सत्य नहीं बनाता, पर यह एक स्पष्ट शुरुआती बिंदु बनाता है जिसे आलोचना, परिष्करण, और संरेखित करना आसान होता है।

पहले ही स्कोप और स्वीकृति मानदंड परिभाषित करना

गलतफहमियाँ आमतौर पर बाद में "वह वही नहीं था जो मैंने चाहा" के रूप में दिखती हैं। AI तेज़ी से पहले ड्राफ्ट बना कर मदद करता है:\n\n- स्कोप बॉउंड्रीज़ (इस रिलीज़ के लिए क्या अंदर है व बाहर है)\n- समान पैटर्न के आधार पर एज केस और "क्या होगा अगर..." परिदृश्य\n- परीक्षण योग्य acceptance criteria जो पर्याप्त विशिष्ट हों\n\nउदाहरण के लिए, अगर आवश्यकता कहती है "यूज़र रिपोर्ट्स एक्सपोर्ट कर सकते हैं," तो AI टीम को स्पष्ट करने के लिए प्रॉम्प्ट कर सकता है: फ़ॉर्मैट (CSV/PDF), परमिशन, डेट रेंज, टाइमज़ोन व्यवहार, और क्या एक्सपोर्ट ईमेल किए जाएँ या डाउनलोड हों। इन उत्तरों को पहले पाना विकास और QA के दौरान होने वाले झंझट को घटाता है।

सुसंगत दस्तावेज़ीकरण जो वास्तव में उपयोग होता है

जब आवश्यकताएँ दस्तावेज़ों, चैट थ्रेड्स, और टिकट्स में बिखरी हों, तो टीमें निरंतर "संदर्भ-स्विचिंग टैक्स" का भुगतान करती हैं। AI एक पढ़ने योग्य एकल नैरेटिव रखने में मदद कर सकता है:

- निर्णयो और खुले प्रश्नों के साथ मीटिंग सारांश\n- सुसंगत टेम्पलेट में आवश्यकता दस्तावेज़ और टिकट विवरण\n- डोमेन शब्दों के लिए शब्दावलियाँ (ताकि "account", "workspace", और "org" उलझ न जाएँ)\n लाभ यह है कि "हमने क्या निर्णय लिया था?" जैसी बार-बार की बाधाएँ कम होती हैं और उत्पाद, डिज़ाइन, इंजीनियरिंग, और QA के बीच हैंडऑफ़्स स्मूद होते हैं।

गार्डरिल्स: धारणाओं का सत्यापन करें, उन्हें आउटसोर्स न करें

AI आउटपुट को परिकल्पनाएँ माना जाना चाहिए, न कि आवश्यकताएँ। सरल गार्डरिल्स का उपयोग करें:\n\n- सारांशों की मूल स्रोतों के खिलाफ हमेशा समीक्षा करें (खासकर उद्धरण और संख्याओं के लिए)\n- अनिश्चित आइटम्स को प्रश्न के रूप में चिह्नित करें, फिर उपयोगकर्ताओं और स्टेकहोल्डर्स के साथ पुष्टि करें\n- निर्णय की मालिकाना टीम के पास रखें: AI ड्राफ्ट करे, इंसान अनुमोदित करें\n\nइस तरीके से उपयोग करने पर, AI-समर्थित डिस्कवरी गलतफहमियों को घटाता है बिना जवाबदेही कमजोर किए—यह कोड की पहली पंक्ति लिखे जाने से पहले लागत, समय, और घर्षण कम कर देता है।

AI से तेज़ प्रोटोटाइपिंग और डिज़ाइन इटरेशन

प्रोटोटाइपिंग वह जगह है जहाँ कई टीमें या तो सप्ताह बचाती हैं—या उन्हें जला देती हैं। AI विचारों को जल्दी से सस्ते तरीके से खोजने में मदद करता है, ताकि आप इंजीनियरिंग समय को पूर्ण बिल्ड के लिए प्रतिबद्ध करने से पहले वास्तविक उपयोगकर्ताओं से वैधता प्राप्त कर सकें।

स्क्रीन और फ्लोज़ के लिए त्वरित “पहले ड्राफ्ट”\n

खाली पन्ने से शुरुआत करने की बजाय, आप AI से जेनरेट करवा सकते हैं:\n\n- बटन, त्रुटि संदेश, ऑनबोर्डिंग स्टेप्स, और खाली स्टेट्स के लिए UI कॉपी (टोन विकल्प जैसे “मित्रवत” बनाम “औपचारिक”)\n- सरल स्क्रीन विवरण के रूप में वायरफ़्रेम विचार (पेज पर क्या है, प्राथमिक बनाम गौण क्या है)\n- नमूना यूज़र जर्नी: “नया यूज़र साइन अप करता है → डाटा इम्पोर्ट करता है → लक्ष्य सेट करता है → रिमाइंडर प्राप्त करता है”\n\nये ड्राफ्ट अंतिम डिज़ाइन कार्य नहीं हैं, पर ये आपकी टीम को प्रतिक्रिया देने के लिए कुछ ठोस देते हैं। इससे ऐसे बैक-एंड-फ़र्थ कम होते हैं जैसे "मुझे लगा आप X का मतलब थे" या "हम अभी भी फ्लो पर संरेखित नहीं हैं"।

त्वरित डेमो ऐप्स और POC

कई उत्पाद निर्णयों हेतु आपको प्रोडक्शन-गुणवत्ता कोड की ज़रूरत नहीं होती। AI एक बेसिक डेमो ऐप या प्रूफ-ऑफ़-कॉन्सेप्ट बनाने में मदद कर सकता है जो दिखाता है:\n\n- मुख्य इंटरैक्शन (यूज़र क्या क्लिक करता है, उसे अगली स्क्रीन क्या दिखती है)\n- उदाहरण डेटा और वास्तविक एज केस\n- सरल "हैप्पी पाथ" जो आंतरिक समीक्षा या उपयोगकर्ता इंटरव्यू के लिए अच्छा है\n\nयदि आप इसे स्थैतिक मॉकअप से आगे ले जाना चाहते हैं, तो vibe-coding प्लेटफ़ॉर्म जैसे Koder.ai तेज़ इटरेशनों के लिए उपयोगी हो सकते हैं: आप चैट इंटरफ़ेस में फीचर का वर्णन करते हैं, एक काम करने वाला वेब या मोबाइल ऐप ड्राफ्ट जनरेट करते हैं (आमतौर पर वेब पर React और मोबाइल पर Flutter), और फिर पूर्ण इंजीनियरिंग चक्र के लिए प्रतिबद्ध होने से पहले स्टेकहोल्डर्स के साथ उसे परिष्कृत करते हैं।

असली समय की बचत कहाँ से आती है

सबसे बड़ी बचत आमतौर पर "डिज़ाइन समय" में नहीं होती। वह गलत चीज़ का पूरा बिल्ड टालने से आती है। जब एक प्रोटोटाइप भ्रम, गायब कदम, या अस्पष्ट मूल्य दिखाता है, तो आप दिशा समायोजित कर सकते हैं जबकि बदलाव अभी सस्ते हैं।

एक महत्वपूर्ण चेतावनी: प्रोटोटाइप को गलती से शिप न करें

AI-जनित प्रोटोटाइप अक्सर महत्वपूर्ण क्लींनअप स्किप करते हैं: सुरक्षा जांच, पहुँचनीयता, प्रदर्शन, उचित त्रुटि हेंडलिंग, और मेंटनेबल संरचना। प्रोटोटाइप को तब तक डिस्पोजेबल मानें जब तक आप जानबूझकर उसे हार्डन न करें—अन्यथा आप एक तेज़ प्रयोग को दीर्घकालिक रीवर्क में बदलने का जोखिम लेते हैं।

यदि आप प्रोटोटाइप को वास्तविक फीचर में बदलते हैं, तो उन वर्कफ़्लोज़ की तलाश करें जो वह संक्रमण स्पष्ट बनाते हैं (उदाहरण: planning mode, snapshots, और rollback)। इससे टीमें तेज़ी से काम कर सकती हैं बिना ट्रेसबिलिटी खोए।

AI असिस्टेंट्स के साथ तेज़ कोडिंग (और वे कहाँ सबसे ज़्यादा मदद करते हैं)

AI कोडिंग असिस्टेंट्स सबसे अधिक मूल्यवान होते हैं उन उबाऊ हिस्सों में: "कुछ नहीं" से एक काम करने योग्य शुरुआती बिंदु तक पहुँचना, और दोहराव वाले काम को साफ़ करना जो टीमों को धीमा करता है। वे इंजीनियरिंग निर्णय की जगह नहीं लेते—पर वे विचार से reviewable PR तक का समय छोटा कर सकते हैं।

वे "ब्लैंक पेज" समय कैसे कम करते हैं

जब आप नया endpoint, job, या UI फ्लो शुरू करते हैं, पहला घंटा अक्सर वायरिंग, नामकरण, और पुराने कोड से पैटर्न कॉपी करने में जाता है। असिस्टेंट्स वह शुरुआती स्ट्रक्चर तेज़ी से ड्राफ्ट कर सकते हैं: फ़ोल्डर्स, बेसिक फ़ंक्शन, एरर हैंडलिंग, लॉगिंग, और प्लेसहोल्डर टेस्ट। इसका मतलब है कि इंजीनियर उत्पाद लॉजिक और एज केस पर अधिक समय बिताते हैं, और बोटरप्लेट पर कम।

उन टीमों के लिए जो "एडिटर के अंदर असिस्ट" से आगे जाना चाहते हैं, प्लेटफ़ॉर्म जैसे Koder.ai इसे एक पूरा वर्कफ़्लो के रूप में पैकेज करते हैं: चैट में स्पेक से एक runnable ऐप तक (अक्सर Go + PostgreSQL बैकएंड पीस), साथ में सोर्स कोड एक्सपोर्ट और डिप्लॉय/होस्टिंग विकल्प। व्यावहारिक लाभ यह है कि "देखने लायक किसी चीज़ तक पहुँचने" की समन्वय लागत कम होती है।

बेहतरीन-फ़िट कार्य (जहाँ वे सबसे ज़्यादा मदद करते हैं)

ये आमतौर पर सीमित, पैटर्न-आधारित काम पर अच्छा प्रदर्शन करते हैं, विशेषकर जब आपके कोडबेस में पहले से स्पष्ट कन्वेंशन्स हों:\n\n- Scaffolding: नए routes/controllers, CRUD स्क्रीन, CLI कमांड, बैकग्राउंड जॉब्स, SDK रैपर्स।\n- Refactors: मॉड्यूल्स का नाम बदलना और पुनर्गठित करना, फ़ंक्शन निकालऩा, सुसंगत एरर हैंडलिंग लागू करना, deprecated APIs अपडेट करना।\n- Translations: छोटे कॉम्पोनेंट्स को भाषाओं/फ्रेमवर्क्स के बीच पोर्ट करना (जैसे Python से TypeScript) और व्यवहार की पुष्टि करने वाले टेस्ट।\n- Small features: अच्छी तरह से परिभाषित जोड़ जैसे फ़िल्टर, एक्सपोर्ट, webhook हैंडलर, या वैलिडेशन नियम।\n- Internal tools: एडमिन पेजेज, स्क्रिप्ट्स, डेटा फिक्सेस, रिपोर्ट जनरेटर—उच्च मूल्य, निम्न UX पालिश।

उपयोगी कोड उत्पादन के लिए प्रॉम्प्ट पैटर्न

अच्छे प्रॉम्प्ट ऐसे होते हैं जो “फीचर X लिखो” से कम और एक मिनी स्पेक की तरह ज्यादा दिखते हैं। शामिल करें:\n\n- Context: मॉड्यूल क्या करता है, कहां रहता है, और आस-पास के APIs।\n- Constraints: लाइब्रेरीज़, स्टाइल नियम, प्रदर्शन/सुरक्षा आवश्यकताएँ।\n- Examples: मौजूदा समान फ़ाइलें या इनपुट/आउटपुट सैंपल।\n- Acceptance tests: एज केस और “किया हुआ माना जाएगा…” चेक (भले ही साधारण अंग्रेज़ी में)।

Add a /v1/invoices/export endpoint.

Context: Node/Express, uses InvoiceService.list(), auth middleware already exists.

Constraints: stream CSV, max 50k rows, no PII fields, follow existing error format.

Example: match style of routes/v1/customers/export.ts.

Acceptance: returns 401 if unauthenticated; CSV has headers A,B,C; handles empty results.

समीक्षा अनिवार्य है

AI-जनित कोड को अभी भी वही मानक चाहिए: कोड रिव्यू, सुरक्षा समीक्षा, और टेस्ट। डेवलपर्स अभी भी सहीपन, डेटा हैंडलिंग, और अनुपालन के लिए आवास्यक होते हैं—सहायक को एक तेज़ ड्राफ्ट मानें, प्राधिकरण नहीं।

समीक्षा चक्र और रीवर्क कम करना AI से

कुछ मिनटों में बैकएंड शुरू करें

Go और PostgreSQL का एक स्टार्टिंग प्वाइंट तैयार करें जिसे आप प्रोडक्शन कोड में परिष्कृत कर सकें.

कोड रिव्यू वह जगह है जहाँ बहुत सा "छिपा हुआ खर्च" जमा होता है: फ़ीडबैक के इंतज़ार में, इरादे को फिर से समझाने में, और एक ही श्रेणी के मुद्दों को बार-बार ठीक करने में। AI समीक्षक के निर्णय की जगह नहीं ले सकता, पर यह यांत्रिक जांचों और गलतफहमियों में लगने वाला समय घटा सकता है।

कोड रिव्यू में AI कैसे मदद करता है

एक अच्छा AI वर्कफ़्लो समीक्षकों का समर्थन तब कर सकता है जब वे PR खोलने भी नहीं जाते:\n\n- परिवर्तनों का सारांश: PR क्या करता है, कौन सी फाइलें बदलीं, और क्या व्यवहार अपेक्षित है—यह सादा-इंग्लिश सार बनाकर समीक्षा को तेज़ी से केंद्रित करने में मदद करता है।\n- जोखिम वाले पैटर्न फ़्लैग करना: सामान्य बग-जनक पैटर्न—मिसिंग नल चेक, अनसुर स्ट्रिंग पार्सिंग, फ्लेकी टाइम-आधारित लॉजिक, अनहैंडल्ड एरर्स, या संदिग्ध परमिशन परिवर्तन—को चिन्हित करे।\n- टेस्ट सुझाएँ: डिफ़ के आधार पर विशिष्ट टेस्ट केस प्रस्तावित करें ("अमान्य इनपुट के लिए टेस्ट जोड़ें", "रोल X के लिए एक्सेस कंट्रोल जांचें", "पैगिनेशन के नए एज केस को कवर करें").

कम बैक-एंड-फ़र्थ लूप

AI स्पष्टता और सुसंगतता भी बढ़ा सकता है, जो सामान्यतः रिव्यू पिंग-पाँग को जन्म देती है:\n\n- बेहतर PR विवरण ड्राफ्ट करना (मोटिवेशन, दृष्टिकोण, ट्रेड़-ऑफ)\n- नामकरण और फॉर्मेटिंग सुसंगतता लागू कर के विषयगत बहसों को टालना\n- छोटे रिफ़ैक्टर सुझाना जो कोड को पढ़ने में आसान बनाते हैं, ताकि रिव्यूअर बाद में बड़े पुनर्लेखन की मांग न करें\n\n### सुरक्षित रखने वाले व्यावहारिक नियम

AI की मदद से रिव्यू तेज़ करें पर मानक न घटाएँ:\n\n- हर PR के लिए मानव अनुमोदन अनिवार्य हो।\n- AI सुझावों को अपने स्टाइल गाइड और लिंट नियमों के साथ संरेखित रखें।\n- PRs को छोटा और केंद्रित रखें ताकि इंसान और AI दोनों उसको समझ सकें। \n### कहाँ AI अभी कमजोर है

AI सबसे कमजोर है डोमेन लॉजिक और आर्किटेक्चर में: व्यापार नियम, वास्तविक उपयोगकर्ताओं से जुड़े एज केस, और सिस्टम-व्यापी ट्रेड-ऑफ अभी भी अनुभवयुक्त निर्णय की माँग करते हैं। AI को एक समीक्षक के सहायक के रूप में देखें—समीक्षक के रूप में नहीं।

परीक्षण और QA में AI: कम मैनुअल काम के साथ जल्दी मुद्दे पकड़ना

परीक्षण वह जगह है जहाँ छोटी गलतफहमियाँ महंगे आश्चर्यों में बदल जाती हैं। AI गुणवत्ता की गारंटी नहीं दे सकता, पर यह काफी दोहराव वाला काम हटा सकता है—ताकि इंसान उन पेचिदा मामलों पर समय लगाएँ जो वास्तव में उत्पाद तोड़ते हैं।

स्वचालित टेस्ट जनरेशन: वास्तविक कोड पाथ्स से शुरुआत

AI टूल मौजूदा कोड पढ़कर यूनिट टेस्ट प्रस्तावित कर सकते हैं और सामान्य निष्पादन पाथ ("हैप्पी पाथ") के साथ उन शाखाओं को भी पहचान सकते हैं जिन्हें भूल जाना आसान है (एरर हैंडलिंग, null/empty इनपुट, retries, timeouts)। जब आप छोटा स्पेक या acceptance criteria भी प्रदान करते हैं, AI आवश्यक एज केस सीधे सुझाव दे सकता है — उदाहरण के लिए, सीमा मान, अमान्य फ़ॉर्मैट, परमिशन चेक, और "अगर upstream सर्विस डाउन है तो क्या होगा" परिदृश्य।

यहाँ सर्वोत्तम उपयोग तेज़ी है: आप जल्दी से टेस्ट का पहला ड्राफ्ट पाते हैं, फिर इंजीनियर assertions को असली व्यापार नियमों के अनुरूप समायोजित करते हैं।

तेज़ टेस्ट डेटा, मॉक्स, और फिक्स्चर

QA में एक आश्चर्यजनक समय-खपत प्रतिनिधि टेस्ट डेटा बनाना और मॉक्स जोड़ना है। AI इसमें मदद कर सकता है:\n\n- प्रतिनिधि नमूना रिकॉर्ड जेनरेट करना (साथ ही "अजीब" मामलों सहित) जो वैलिडेशन नियमों से मेल खाते हों\n- बाहरी सेवाओं के लिए predictable responses वाले मॉक/स्टब लिखना\n- पुन:उपयोग योग्य फिक्स्चर बनाना जो टेस्ट को छोटा और पढ़ने में आसान बनाते हैं\n\nयह डेवलपर-लिखित यूनिट टेस्ट और इंटीग्रेशन टेस्ट दोनों को तेज़ करता है, खासकर जब कई APIs शामिल हों।

बेहतर बग रिपोर्ट्स: स्पष्ट, तेज़ फिक्सेस

जब मुद्दे QA या प्रोडक्शन में पहुँचते हैं, AI गंदे नोट्स को संरचित रिप्रो स्टेप्स में बदलकर और अपेक्षित बनाम वास्तविक व्यवहार को स्पष्ट करके बग रिपोर्ट्स को बेहतर कर सकता है। लॉग्स या कंसोल आउटपुट दिए जाने पर, यह पैटर्न का सार दे सकता है (पहले क्या फेल हुआ, क्या दोहराया, विफलता से क्या सहसंबंधित है) ताकि इंजीनियर पहले घंटे में सिर्फ़ रिपोर्ट समझने में न बिताएँ।

गुणवत्ता नियंत्रण (अनिवार्य)

AI-जनित टेस्ट अभी भी होने चाहिए:\n\n- अर्थपूर्ण: वास्तविक आवश्यकताओं से जुड़े assertions, न कि केवल "यह बिना क्रैश हुए चलता है"\n- नियतात्मक: कोई flaky timing, रैंडम सीड, या अस्थिर बाहरी निर्भरताएँ नहीं\n- पालित: प्रोडक्शन कोड की तरह समीक्षा की जाएँ, नामकरण अच्छा हो, और व्यवहार बदलने पर अपडेट हों \nइस तरह उपयोग करने पर, AI मैनुअल प्रयास घटाता है और टीमें समस्याओं को पहले पकड़ने में सक्षम होती हैं—जब फिक्स सस्ते होते हैं।

रिलीज़ और संचालन: कम इंतज़ार, तेज़ ट्रबलशूटिंग

आरंभिक आवश्यकताएँ स्पष्ट करें

प्लानिंग मोड में स्कोप और स्वीकृति मानदंड का ड्राफ्ट बनाएं जिसे आपकी टीम समीक्षा कर सके.

रिलीज़ वर्क वह जगह है जहाँ "छोटे विलंब" बिगड़कर बड़े असर डालते हैं: एक फ्लेकी पाइपलाइन, अस्पष्ट त्रुटि, गायब कॉन्फ़िग मूल्य, या dev और ops के बीच धीमा हैंडऑफ़। AI टूल "कुछ टूट गया" और "अब हम क्या करें" के बीच का समय घटाकर मदद करते हैं।

CI/CD और DevOps के लिए AI

आधुनिक CI/CD सिस्टम बहुत सारे संकेत उत्पन्न करते हैं (बिल्ड लॉग्स, टेस्ट आउटपुट, डिप्लॉय इवेंट)। AI उस शोर को एक छोटे, कार्रवाई योग्य दृश्य में संक्षेप कर सकता है: क्या फेल हुआ, कहाँ पहली बार दिखा, और हाल ही में क्या बदला।

यह संदर्भ में संभावित फिक्स भी सुझा सकता है—जैसे Docker इमेज में वर्शन मिसमैच, वर्कफ़्लो में गलत क्रम, या गायब वातावरण वेरिएबल—बिना सैकड़ों लाइनों को मैन्युअल रूप से स्कैन किए।

यदि आप Koder.ai जैसे एंड-टू-एंड प्लेटफ़ॉर्म का उपयोग कर रहे हैं, तो ऑपरेशनल फीचर्स जैसे स्नैपशॉट और रोलबैक भी रिलीज़ जोखिम घटा सकते हैं: टीमें टेस्ट कर सकती हैं, डिप्लॉय कर सकती हैं, और जब वास्तविकता योजना से अलग हो तो जल्दी वापस ले सकती हैं।

इंसिडेंट समर्थन: तेज़ हाइपोथेसिस और चेकलिस्ट

इंसिडेंट्स के दौरान, शुरुआती 15–30 मिनट में गति सबसे महत्वपूर्ण होती है। AI कर सकता है:\n\n- लॉग्स, अलर्ट, और हाल की डिप्लॉयमेंट के आधार पर रूट-कॉज़ हाइपोथेसिस ड्राफ्ट करना\n- एक remediation चेकलिस्ट बनाना (rollback, feature-flag off, scale up, queue साफ़ करना, DB कनेक्शन validate करना)\n- प्रत्येक हाइपोथेसिस की पुष्टि/खारिज करने के लिए लक्षित कमांड और क्वेरीज सुझाना\n\nयह ऑन-कॉल लोड को तेज़ triage करके घटाता है—न कि उन इंसानों की जगह लेता जो सर्विस के मालिक हैं।

सुरक्षा नोट (इन्हें मत छोड़ें)

AI तभी उपयोगी है जब इसे सुरक्षित रूप से इस्तेमाल किया जाए:\n\n- प्रॉम्प्ट में सीक्रेट्स (API कीज़, टोकन, ग्राहक डेटा) न चिपकाएँ—रेडक्शन और न्यूनतम-प्रिविलेज एक्सेस का उपयोग करें।\n- AI आउटपुट को सुझाव मानें, बदलाव न मानें। कोड रिव्यू, अनुमोदन, और चेंज मैनेजमेंट अभी भी लागू होते हैं।\n- ऐसे टूल पसंद करें जो sanitized logs के खिलाफ काम कर सकें और अनुपालन के लिए ऑडिट ट्रेल्स रखें।

दस्तावेज़ीकरण और ज्ञान साझा करना: कम व्यवधान और हैंडऑफ़

अच्छा दस्तावेज़ीकरण इंजीनियरिंग घर्षण घटाने के सबसे सस्ते तरीकों में से एक है—फिर भी यह अक्सर समय-सारिणी में पहला चीज़ होता है जो छूट जाती है। AI टूल रोज़मर्रा के काम का हिस्सा बनाकर दस्तावेज़ीकरण को हल्का और दोहराव-योग्य बना देते हैं।

AI क्या तेज़ कर सकता है (मालिकाना बने रहने के बिना)

टीमें आमतौर पर तेज़ जीत देखती हैं उन दस्तावेज़ों में जो स्पष्ट पैटर्न का पालन करते हैं:\n\n- API docs: मौजूदा स्पेक्स या कोड टिप्पणियों से endpoint विवरण, request/response उदাহारण, और error तालिकाएँ जेनरेट करें।\n- Runbooks: पिछले टिकट और पोस्टमॉर्टम से चरण-दर-चरण इंसिडेंट प्लेबुक ड्राफ्ट करें ("यदि X alert चलता है, तो Y चेक करें, फिर Z करें")।\n- Changelogs और release notes: मर्ज किए गए PRs को ग्राहक-और-आंतरिक संस्करणों में संक्षेपित करें।\n- Onboarding guides: "पहले सप्ताह" चेकलिस्ट, सर्विस ओवरव्यू, और शब्दकोश पेजेस repo संरचना और मौजूदा docs से बनवाएँ। \nकुंजी यह है कि AI एक मजबूत पहला ड्राफ्ट देता है; इंसान सत्यापित करते हैं कि क्या सच है, क्या साझा करना सुरक्षित है, और क्या महत्वपूर्ण है।

कम व्यवधान, कम बाधाएँ

जब docs खोजने योग्य और अद्यतन हों, तो टीम बार-बार पूछे जाने वाले प्रश्नों का उत्तर देने में कम समय खर्च करती है—जिससे संदर्भ-स्विचिंग कम होती है, फोकस समय सुरक्षित रहता है, और ज्ञान किसी एक "गो-टू" व्यक्ति पर अटका नहीं रहता।

अच्छी तरह बनाए दस्तावेज़ नई टीम के सदस्यों, QA, सपोर्ट, और गैर-तकनीकी स्टेकहोल्डर्स को स्व-सर्व करने में सक्षम बनाते हैं बजाय इंजीनियर का इंतज़ार करने के।

लागू रहने वाला व्यावहारिक वर्कफ़्लो

कई टीमों के लिए एक सरल पैटर्न काम करता है:\n\n1. PRs से doc अपडेट जेनरेट करें (सार + क्या बदला + कैसे टेस्ट करें)\n2. मानव संपादित और सत्यापित करें (सटीकता, सुरक्षा, ऑडियंस फिट)\n3. कोड के साथ repo में डॉक्स को वर्जन करें, ताकि परिवर्तन की समीक्षा और शिपिंग साथ-साथ हो

गैर-तकनीकी पाठकों के लिए सुलभता

AI घने नोट्स को साफ़ भाषा में फिर से लिख सकता है, समान शीर्षक जोड़ सकता है, और पन्नों में संरचना मानकीकृत कर सकता है। इससे दस्तावेज़ीकरण इंजीनियरिंग के बाहर भी उपयोगी बन जाता है—बिना इंजीनियरों से प्रोफेशनल लेखक बनाए जाने की मांग के।

ROI मापना: अंदाज़े के बिना बचत को मात्रात्मक बनाना

ROI तब धुंधला हो जाता है जब आप केवल पूछते हैं, "क्या हमने तेज़ शिप किया?" एक साफ़ तरीका यह है कि उन विशिष्ट लागत-ड्राइवरों की कीमत लगाएँ जिन पर AI असर डालता है, फिर उसी वर्कफ़्लो के लिए बेसलाइन और "AI के साथ" रन की तुलना करें।

अपने वास्तविक लागत-ड्राइवर मैप करें

शुरू करें उन बकेट्स की लिस्ट से जो आपकी टीम के लिए वाकई मायने रखते हैं:\n\n- इंजीनियरिंग घंटे: बिल्ड, रिव्यू, टेस्ट, फिक्स, रीवर्क\n- क्लाउड खर्च: चल रहे एनवायरनमेंट्स, धीमी पाइपलाइन, बार-बार टेस्ट रन\n- टूल सब्स्क्रिप्शन: AI सीट्स, टेस्टिंग टूल्स, मॉनिटरिंग, डिज़ाइन टूलिंग\n- सपोर्ट बोझ: इंसिडेंट रिस्पॉन्स, बग ट्रायेज़, ग्राहक टिकट्स\n- डिले कॉस्ट: स्थगित राजस्व, संविदात्मक दंड, अवसर लागत

एक सरल बेसलाइन बनाम with-AI अनुमान

एक फीचर या स्प्रिंट चुनें और समय चरणों में बाँट दें। फिर हर चरण के लिए दो नंबर नापें: औसत घंटे बिना AI बनाम AI के साथ, साथ में कोई नया टूल कॉस्ट।

एक हल्का फार्मूला:\n\n\nSavings = (Hours_saved × Blended_hourly_rate) + Cloud_savings + Support_savings − Tool_cost\nROI % = Savings / Tool_cost × 100\n\n\nआपको परफेक्ट ट्रैकिंग की ज़रूरत नहीं—टाइम लॉग्स, PR साइकिल टाइम, रिव्यू राउंड की संख्या, टेस्ट फ्लेक रेट, और लीड टाइम टु डिप्लॉय को प्रॉक्सी के रूप में उपयोग करें।

"रिस्क कॉस्ट" को नज़रअंदाज़ न करें

AI अनियंत्रित होने पर लागत भी जोड़ सकता है: सुरक्षा एक्सपोज़र, लाइसेंस/आईपी मुद्दे, अनुपालन गैप्स, या घटिया कोड क्वालिटी। इन्हें अपेक्षित लागत के रूप में प्राइस करें:\n\n- Risk cost = Probability × Impact (उदा., सुरक्षा फाइंडिंग के बाद रीवर्क, ऑडिट सुधार का समय)

छोटे से शुरू करें, फिर स्केल करें

एक वर्कफ़्लो से शुरू करें (उदाहरण: टेस्ट जनरेशन या आवश्यकताओं की स्पष्टता)। इसे 2–4 हफ्ते चलाएँ, पहले/बाद के मैट्रिक्स रिकॉर्ड करें, और तभी अन्य टीमों पर बढ़ाएँ। यह AI अपनाने को प्रयोगात्मक से रिपीटेबल प्रैक्टिस में बदल देता है।

जोखिम और गार्डरिल्स: सुरक्षा, गुणवत्ता, और अनुपालन

बनाने से पहले प्रोटोटाइप करें

इंजीनियरिंग समय लगाने से पहले वेब या मोबाइल प्रोटोटाइप से फ्लो टेस्ट करें.

AI बहुत सारा काम घटा सकता है, पर यह नए फेल्योर मोड भी लाता है। AI आउटपुट को एक मजबूत ऑटोकम्प्लीट समझें: गति के लिए उपयोगी, न कि सत्य का स्रोत।

योजना करने योग्य प्रमुख जोखिम

पहला, गलत या अपूर्ण आउटपुट। मॉडल सही लग सकता है पर एज केस मिस कर सकता है, APIs बना सकता है, या ऐसा कोड दे सकता है जो हैप्पी-पाथ टेस्ट तो पास कर ले पर प्रोडक्शन में फेल हो।

दूसरा, सुरक्षा लीक। अनधिकृत टूल्स में सीक्रेट्स, ग्राहक डेटा, इंसिडेंट लॉग्स, या प्रोप्राइटरी कोड पेस्ट करना अनजाने में एक्सपोज़र बना सकता है। साथ ही ऐसा कोड जेनरेट होना भी जोखिम है (कमज़ोर auth, unsafe deserialization, injection-prone queries)।

तीसरा, लाइसेंसिंग/IP चिंताएँ। जनरेट किए गए कोड का मिलान कॉपीराइटेड स्निपेट्स से हो सकता है या डेवलपर्स यदि बेधड़क कॉपी करते हैं तो अनुकूल लाइसेंस वाले निर्भरताएँ आ सकती हैं।

चौथा, पक्षपाती या असंगत निर्णय। AI प्राथमिकता, शब्दावली, या मूल्यांकन को ऐसी दिशा में धकेल सकता है जो अनायास ही उपयोगकर्ताओं को बाहर करे या आंतरिक नीतियों का उल्लंघन करे।

व्यावहारिक सुरक्षा जो वेग बनाए रखती है

AI-जनित परिवर्तनों के लिए मानव समीक्षा एक नियम बनाएं: कोड-रिव्यू आवश्यक हो, और रिव्यूअर से सुरक्षा, एरर हैंडलिंग, और टेस्ट चेक कराने को कहें—सिर्फ़ स्टाइल नहीं।

हल्के पॉलिसी और एक्सेस कंट्रोल लागू करें: केवल स्वीकृत टूल, SSO, भूमिका-आधारित अनुमतियाँ, और क्या डेटा साझा किया जा सकता है इसकी स्पष्ट नियमावली।

ऑडिट ट्रेल्स रखें: सुझाए गए प्रॉम्प्ट और आउटपुट को अनुमोदित वातावरण में लॉग करें, और रिकॉर्ड करें कि कब और कहाँ AI का उपयोग हुआ।

डेटा हैंडलिंग बुनियादी बातें

संवेदी डेटा (PII, credentials, प्रोडक्शन लॉग्स, ग्राहक संविदाएँ) को सामान्य-उद्देश्य AI टूल्स में भेजने से बचें। अनुमोदित परिवेश, रेडैक्शन, और सिंथेटिक उदाहरणों को प्राथमिकता दें।

निचोड़

AI आउटपुट सुझाव हैं, गारंटी नहीं। रिव्यू, नीति, एक्सेस कंट्रोल, और ट्रेसबिलिटी जैसी गार्डरिल्स के साथ आप गति के लाभ उठा सकते हैं बिना सुरक्षा, गुणवत्ता, या अनुपालन को छोड़ने के।

किसी भी आकार की टीम के लिए व्यावहारिक अपनाने का रोडमैप

AI टूल अपनाना तब सबसे अच्छा होता है जब आप इसे किसी अन्य प्रक्रिया परिवर्तन की तरह लें: छोटे से शुरू करें, जो काम करे उसे मानकीकृत करें, और स्पष्ट गार्डरिल्स के साथ बढ़ाएँ। लक्ष्य "सब जगह AI उपयोग करना" नहीं है—बल्कि टाल-मटोल, रीवर्क, और इंतज़ार घटाना है।

चरण 1: पायलट (1–2 सप्ताह)

एक टीम और एक वर्कफ़्लो चुनें जहाँ गलतियाँ कम-जोखिम हों पर समय बचत स्पष्ट हो (उदा., यूज़र स्टोरीज़ लिखना, टेस्ट केस जेनरेट करना, छोटे मॉड्यूल का रिफैक्टर)। दायरा संकुचित रखें और अपनी सामान्य बेसलाइन से तुलना करें।

चरण 2: मानक (हल्के, बोझिल नहीं)

लिखें कि आपकी टीम के लिए "अच्छा AI उपयोग" कैसा दिखेगा।\n\n- प्रॉम्प्ट टेम्पलेट्स: सामान्य कार्यों के लिए छोटे, पुन:उपयोग योग्य प्रॉम्प्ट (requirements स्पष्ट करना, कोड रिव्यू नोट, टेस्ट प्लान ड्राफ्ट)।\n- रिव्यू चेकलिस्ट: इंसान क्या सत्यापित करेंगे (सहीपन, सुरक्षा, एज केस, आवश्यकताओं के अनुरूपता)।\n- करें/न करें सूची:\n - करें: संदर्भ, प्रतिबंध, acceptance criteria, और उदाहरण दें।\n - न करें: सीक्रेट्स, प्रोडक्शन क्रेडेंशियल, या साझा करने के लिए अनुमति नहीं है ऐसा प्रोप्राइटरी डेटा पेस्ट न करें।

चरण 3: प्रशिक्षण (2–4 छोटे सेशन्स)

लोगों को बेहतर प्रश्न पूछना और आउटपुट सत्यापित करना सिखाएँ। व्यावहारिक परिदृश्यों पर ध्यान दें: "एक अस्पष्ट आवश्यकता को परीक्षण योग्य acceptance criteria में बदलना" या "एक migration plan जनरेट करें, फिर जोखिम चेक करें।"

चरण 4: ऑटोमेशन (जहाँ दोहराव नुकसान पहुँचाता है)

जब टीम वर्कफ़्लो पर भरोसा कर लें, तब दोहराव वाले हिस्सों को ऑटोमेट करें: PR विवरण ड्राफ्ट, टेस्ट स्कैफोल्डिंग, रिलीज़ नोट्स, और टिकट ट्रायएज। कुछ भी शिप करने से पहले मानव अनुमोदन कदम रखें।

यदि आप प्लेटफ़ॉर्मों का मूल्यांकन कर रहे हैं, तो देखें क्या वे सुरक्षित इटरेशन फीचर्स सपोर्ट करते हैं (उदा.: planning mode, snapshots, और rollback) और व्यवहारिक अपनाने के विकल्प (जैसे सोर्स कोड एक्सपोर्ट)। यह एक ऐसा क्षेत्र है जहाँ Koder.ai मौजूदा इंजीनियरिंग अपेक्षाओं में फिट होने के लिए डिज़ाइन किया गया है: तेज़ी से बढ़ें, पर नियंत्रण रखें।

चरण 5: निरंतर सुधार

टेम्पलेट्स और नियमों की मासिक समीक्षा करें। उन प्रॉम्प्ट्स को हटाएँ जो मदद नहीं करते, और मानक तभी बढ़ाएँ जब आप आवर्ती फेल्योर मोड देखें।

ट्रैक करने के लिए मैट्रिक्स (ताकि ROI अटकल न बने)

कुछ संकेतक नियमित रूप से ट्रैक करें:\n\n- Cycle time (विचार → डिप्लॉय)\n- Review time (PR खुला → मर्ज)\n- Defect rate (सीधे प्रोडक्शन में आए बग + QA में मिले बग)\n- Rework % (टिकट फिर खोले गए, चर्न, पुनरावृत्त परिवर्तन)\n- टीम सन्तोष (छोटा पल्स सर्वे)

अपने अगले प्रोजेक्ट पर यह चेकलिस्ट इस्तेमाल करें

- एक पायलट वर्कफ़्लो चुनें और "सफलता" पहले से परिभाषित करें\n- [ ] 3–5 प्रॉम्प्ट टेम्पलेट बनाएँ जो आपकी टीम वास्तव में पुन: उपयोग करेगी\n- [ ] AI-जनित आउटपुट के लिए एक सरल रिव्यू चेकलिस्ट जोड़ें\n- [ ] डेटा-हैंडलिंग नियम सेट करें (क्या साझा किया जा सकता है/नहीं)\n- [ ] 2–4 हफ्तों के लिए साइकिल टाइम, दोष, रीवर्क, और रिव्यू टाइम मापें\n- [ ] मैनुअल वर्शन लगातार विश्वसनीय होने के बाद ही ऑटोमेट करें\n- [ ] मानकों और प्रशिक्षण को सुधारने के लिए मासिक रेट्रो रखें

यदि आप अपने पायलट के learnings प्रकाशित करते हैं, तो इसे आंतरिक मार्गदर्शक या सार्वजनिक लेख के रूप में औपचारिक बनाना भी फायदेमंद हो सकता है—कई टीमें पाती हैं कि "पहले/बाद" मैट्रिक्स दस्तावेज़ करने से AI अपनाना प्रयोग से दोहरिने योग्य अभ्यास में बदल जाता है। (कुछ प्लेटफ़ॉर्म, जिनमें Koder.ai भी शामिल है, ऐसे प्रोग्राम चलाते हैं जहाँ टीमें व्यावहारिक सामग्री साझा करने या अन्य उपयोगकर्ताओं को रेफर करने पर क्रेडिट कमा सकती हैं, जो प्रारंभिक परीक्षण के दौरान टूल लागत को कम कर सकता है।)

अक्सर पूछे जाने वाले प्रश्न

What’s the difference between cost, time, and friction in software delivery?

Cost कुल खर्च है जो किसी फीचर को भेजने और मेंटेन करने में लगता है (लोगों का समय, क्लाउड, टूल्स, साथ ही समन्वय और रीवर्क के छिपे हुए खर्च)। Time वह कैलेंडर समय है जो विचार से लेकर भरोसेमंद ग्राहक-योग्यता तक लगता है (समीक्षाओं, QA, वातावरण, निर्णयों के इंतज़ार सहित)। Friction रोज़मर्रा का वह घर्षण है (भ्रम, हैंडऑफ़्स, व्यवधान, दोहराया काम) जो लागत और समय दोनों को बढ़ाता है।

Where do software projects usually lose the most time and money?

अधिकांश ओवररन्स हैंडऑफ़्स, रीवर्क और इंतज़ार से आते हैं — न कि सिर्फ़ “कठिन कोडिंग” से। आम गर्म स्थानों में अस्पष्ट आवश्यकताएँ (जो डाउनस्ट्रीम रीवर्क बनाती हैं), संदर्भ-स्विचिंग (रिस्टार्ट कॉस्ट), धीमी रिव्यू कतारें (सीखने में देरी), और मैनुअल/देर से होने वाला परीक्षण (जब फिक्स सबसे महंगा होता है) शामिल हैं।

How do you do a quick “friction map” to find AI opportunities?

30 मिनट का सेशन करें और अपना वर्कफ़्लो मैप करें (idea → requirements → design → build → review → test → release → monitor)। प्रत्येक चरण में चिन्हित करें:

- कहाँ काम रुकता है (कतारें, अनुमोदन, पर्यावरण पहुँच)

- कहाँ निर्णय अटकते हैं (मालिक नहीं, संदर्भ गायब)

- कहाँ रीवर्क होता है (requirements churn, बग, redesign)

ऊपर के 1–2 चिन्हित क्षेत्रों से शुरू करें; अक्सर यहीं AI सबसे तेज़ बचत देता है।

How can AI reduce misunderstandings during discovery and requirements?

AI का उपयोग गंदे इनपुट्स (इंटरव्यू, टिकट, कॉल नोट्स) को समीक्षा-योग्य प्रारूप में बदलने के लिए करें:

- प्रमुख दर्द-बिंदु/लक्ष्य/आपत्तियों के सारांश

- फीडबैक को थीम्स में क्लस्टर करना

- कच्चे इनपुट से प्रारंभिक यूज़र स्टोरीज़ और jobs-to-be-done ड्राफ्ट

फिर आउटपुट को परिकल्पनाएँ मानें: स्रोतों से सत्यापित करें, अनिश्चितताओं को सवाल के रूप में चिह्नित करें, और अंतिम निर्णय टीम के पास रखें।

How do AI tools help define scope and acceptance criteria earlier?

AI से शीघ्र रूप में स्कोप और स्वीकृति मानदंड (acceptance criteria) प्रस्तावित कराएँ ताकि निर्माण/QA से पहले अस्पष्टताएँ हल हो सकें:

- रिलीज के लिए “इन बनाम आउट”

- किनारे के मामले ("what about...") और गायब प्रतिबंध

- परीक्षण करने योग्य acceptance criteria

उदाहरण के रूप में: फ़ॉर्मैट्स, अनुमतियाँ, टाइमज़ोन नियम, डिलीवरी तरीका (डाउनलोड बनाम ईमेल), सीमाएँ (पंक्तियों की गिनती), और विफलता व्यवहार स्पष्ट करने के लिए प्रॉम्प्ट दें।

What prompt structure produces usable AI-generated code?

AI सबसे उपयोगी तब होता है जब आप एक मिनी-स्पेक देते हैं, न कि अस्पष्ट अनुरोध। इसमें शामिल करें:

- Context (मॉड्यूल कहाँ है, आसपास के API)

- Constraints (लाइब्रेरीज़, प्रदर्शन, सुरक्षा, स्टाइल नियम)

- Examples (समान फ़ाइलें, इनपुट/आउटपुट सैंपल)

- Acceptance checks (एज केस, “किया हुआ माना जाएगा…”)

यह ऐसा कोड उत्पन्न करता है जिसे review करना आसान होता है और गायब धारणाओं से होने वाला रीवर्क कम होता है।

How can AI shorten code review cycles without lowering standards?

AI का प्रयोग मैकेनिकल प्रयास और भ्रम को कम करने के लिए करें, न कि निर्णयों को बदलने के लिए:

- PR का सादा-इंग्लिश सार बनवाएँ (क्या बदला, क्यों, कहाँ)

- सामान्य जोखिम वाले पैटर्न फ़्लैग कराएँ (null हैंडलिंग, परमिशन, error paths)

- डिफ़ के आधार पर गायब टेस्ट सुझाएँ

मानक बनाए रखें: मानव अनुमोदन आवश्यक, लिंट/स्टाइल नियमों का पालन, और PRs छोटे रखें ताकि इंसान और टूल दोनों उन्हें समझ सकें।

What’s a practical way to use AI in testing and QA?

AI का उपयोग टेस्ट निर्माण और बग स्पष्टता को तेज़ करने के लिए करें, फिर इंसान सख्ती से ठीक करें:

- वास्तविक कोड पाथ्स + acceptance criteria से यूनिट टेस्ट ड्राफ्ट करें

- "सामान्य" और "अजीब" मामलों के साथ फिक्स्चर/मॉक्स जनरेट करें

- गंदे QA नोट्स/logs को स्पष्ट रिप्रो स्टेप्स (उम्मीद बनाम वास्तविक) में बदलें

गुणवत्ता गार्डरिल्स लागू करें: अर्थपूर्ण Assertions, deterministic tests (कोई flaky timing नहीं), और लंबे समय तक रखरखाव को प्रोडक्शन कोड की तरह ट्रीट करें।

How does AI help in CI/CD, release work, and incident response?

AI CI/CD संकेतों को संक्षेप में बदल सकता है: क्या फेल हुआ, कहाँ पहली बार दिखा, और हाल में क्या बदला। यह संदर्भ में संभावित सुधार भी सुझा सकता है—जैसे Docker इमेज का वर्शन मिसमैच, वर्कफ़्लो में गलत क्रम, या गायब एनवायरनमेंट वेरिएबल।

इंसिडेंट्स में AI:

- लॉग्स, अलर्ट, हाल की डिप्लॉयमेंट के आधार पर रूट-कॉज़ हाइपोथेसिस ड्राफ्ट कर सकता है

- रिमेडिएशन चेकलिस्ट बना सकता है (rollback, feature-flag off, scale up, queue साफ़ करना, DB कनेक्शन validate करना)

- प्रत्येक हाइपोथेसिस की पुष्टि/खारिज़ करने के लिए लक्षित कमांड और क्वेरीज सुझा सकता है

सुरक्षा नियम: सीक्रेट्स/PII को प्रॉम्प्ट में न डालें, आउटपुट को सुझाव मानें, और अनुमोदन/चेंज मैनेजमेंट लागू रखें।

How can we quantify ROI from AI tools without guesswork?

AI द्वारा बदले जाने वाले विशिष्ट ड्राइवरों की कीमत लगाकर ROI मापें, बेसलाइन की तुलना with-AI रन से करें:

- चरणों के अनुसार घंटे ट्रैक करें (build/review/test/rework)

- क्लाउड/सपोर्ट बचत जोड़ें

- टूल कॉस्ट घटाएँ

सरल मॉडल:

Savings = (Hours_saved × Blended_hourly_rate) + Cloud_savings + Support_savings − Tool_cost

ROI % = Savings / Tool_cost × 100

साथ ही “रिस्क कॉस्ट” (Probability × Impact) को भी जोड़ें—for security/compliance या गलत उपयोग से होने वाले रीवर्क के लिए।