17 जून 2025·8 मिनट

AI डेवलपर्स का काम क्या बदलता है (और क्या नहीं)

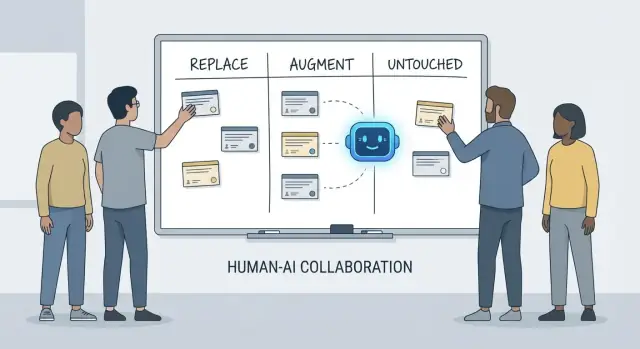

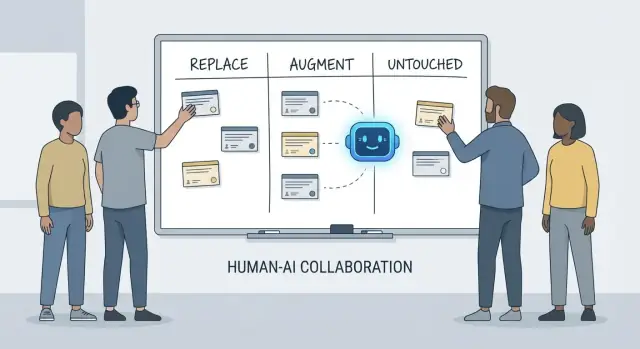

एक व्यावहारिक विभाजन—कहां AI डेवलपर जिम्मेदारियाँ बदल सकता है, कहां वह इंसानों को बढ़ाता है, और किन कार्यों के लिये असली टीम‑मालिकाना अभी भी ज़रूरी है।

एक व्यावहारिक विभाजन—कहां AI डेवलपर जिम्मेदारियाँ बदल सकता है, कहां वह इंसानों को बढ़ाता है, और किन कार्यों के लिये असली टीम‑मालिकाना अभी भी ज़रूरी है।

"AI डेवलपर्स के लिये क्या करेगा" पर बातचीत जल्दी उलझ जाती है क्योंकि हम अक्सर टूल्स और ज़िम्मेदारियों को मिला देते हैं। एक टूल कोड जेनरेट कर सकता है, टिकट का सार दे सकता है, या टेस्ट सुझा सकता है। एक ज़िम्मेदारी वह है जिसके लिये टीम तब भी जवाबदेह रहती है जब सुझाव गलत हो।

यह लेख एक सरल फ्रेमवर्क—replace, augment, untouched—का उपयोग करता है ताकि वास्तविक टीमों के दिन‑प्रतिदिन के काम को समझाया जा सके जिनके पास डेडलाइन, लेगेसी कोड, प्रोडक्शन इनसिडेंट और स्टेकहोल्डर होते हैं जो भरोसेमंद परिणाम चाहते हैं।

Replace का मतलब है कि AI अधिकांश समय स्पष्ट गार्डरेल्स के साथ टास्क को end-to-end पूरा कर सकता है, और मानव भूमिका निगरानी और spot-checks की ओर खिसक जाती है।

उदाहरण अक्सर बाउंडेड काम होते हैं: बॉयलरप्लेट जेनरेट करना, भाषाओं के बीच कोड ट्रांसलेट करना, रेपीटिटिव टेस्ट केस ड्राफ्ट करना, या पहली बार का डॉक्युमेंटेशन तैयार करना।

Replace का अर्थ यह नहीं है कि "कोई मानव जवाबदेही नहीं।" अगर आउटपुट प्रोडक्शन तोड़ देता है, डेटा लीक करता है, या मानकों का उल्लंघन करता है, तो टीम इसके लिये ज़िम्मेदार रहेगी।

Augment का मतलब है कि AI डेवलपर को तेज़ या अधिक पूरी तरह बनाता है, पर यह भरोसेमंद तरीके से काम पूरा नहीं करता बिना मानव निर्णय के।

यह पेशेवर इंजीनियरिंग में आम होता है: आपको उपयोगी ड्राफ्ट, वैकल्पिक दृष्टिकोण, त्वरित व्याख्याएँ, या संभावित बग्स की शॉर्टलिस्ट मिलती है—पर डेवलपर ही तय करता है कि क्या सही, सुरक्षित और उत्पाद के लिये उपयुक्त है।

Untouched का अर्थ है कि मूल जिम्मेदारी मानव-नेतृत्व वाली रहती है क्योंकि इसमें संदर्भ, ट्रेड-ऑफ, और जवाबदेही होती है जो प्रॉम्प्ट में समाहित नहीं होती।

सोचें: आवश्यकताओं का नेगोशिएशन, सिस्टम‑लेवल सीमाओं का चुनाव, इनसिडेंट हैंडलिंग, गुणवत्ता मानदंड तय करना, और उन कॉल्स का निर्णय जहाँ कोई एक "सही" उत्तर नहीं है।

टूल जल्दी बदलते हैं। जिम्मेदारियाँ धीरे‑धीरे बदलती हैं।

इसलिए सवाल पूछने के बजाय "क्या AI यह कोड लिख सकता है?", पूछें "परिणाम किसका है?" यह फ्रेमिंग सटीकता, विश्वसनीयता और जवाबदेही पर अपेक्षाएँ बनाए रखती है—वे चीज़ें जो प्रभावशाली डेमो से ज़्यादा मायने रखती हैं।

जब लोग पूछते हैं कि AI डेवलपमेंट में क्या "बदल देगा", वे अक्सर टास्क का मतलब रखते हैं: फ़ंक्शन लिखें, टेस्ट जनरेट करें, डॉक्यूमेंट ड्राफ्ट करें। टीमें हालांकि टास्क नहीं शिप करती—वे परिणाम शिप करती हैं। इसलिए डेवलपर जिम्मेदारियाँ मायने रखती हैं।

एक डेवलपर का काम आमतौर पर सिर्फ कोडिंग से अधिक फैला होता है:

ये जिम्मेदारियाँ पूरे लाइफसाइकल पर बैठती हैं—"हमें क्या बनाना चाहिए?" से लेकर "क्या यह सुरक्षित है?" और "3 बजे सुबह टूटने पर क्या होता है?" तक।

हर जिम्मेदारी वास्तव में बहुत सारी छोटी निर्णय‑बिंदुओं का समूह है: कौन से एज‑केस मायने रखते हैं, कौन से मीट्रिक्स स्वास्थ्य दिखाते हैं, कब स्कोप काटना है, क्या फिक्स सुरक्षित रूप से भेजना चाहिए, स्टेकहोल्डर्स को ट्रेड‑ऑफ कैसे समझाना है। AI इन कामों के टुकड़ों को निष्पादित करने में मदद कर सकता है (कोड ड्राफ्ट करना, टेस्ट सुझाव देना, लॉग संक्षेप करना), पर जिम्मेदारी परिणाम को अपनाने के बारे में है।

ब्रेकडाउन अक्सर हैंडऑफ सीमाओं पर होते हैं:

जब मालिकाना स्पष्ट नहीं होता, काम गैप में गिर जाता है।

जिम्मेदारियों की बात करने का एक उपयोगी तरीका है निर्णय अधिकार:

AI निष्पादन को तेज कर सकता है। निर्णय अधिकार—और परिणामों के लिये जवाबदेही—के लिये अभी भी किसी मानव का नाम होना चाहिए।

AI कोडिंग असिस्टेंट्स असल में तब उपयोगी होते हैं जब काम predictable, low‑stakes और सत्यापनीय हो। इन्हें तेज़ जूनियर टीम‑मेट समझें: पहली पास देने में तेज़ पर फिर भी स्पष्ट निर्देश और सावधानीपूर्वक जांच चाहिए।

प्रैक्टिकली, कुछ टीमें "vibe‑coding" प्लेटफ़ॉर्म (जैसे Koder.ai) का उपयोग इन replaceable हिस्सों को तेज़ करने के लिये कर रही हैं: स्कैफ़ोल्ड्स जेनरेट करना, CRUD फ्लोज़ वायर करना, और चैट से UI/बैकएंड का प्रारंभिक ड्राफ्ट बनाना। कुंजी वही रहती है: गार्डरेल्स, समीक्षा, और स्पष्ट ओनरशिप।

अनेक डेवलपर समय प्रोजेक्ट स्कैफ़ोल्ड और लेयर्स को जोड़ने में जाता है। AI अक्सर जेनरेट कर सकता है:

गार्डरेल यहाँ कंसिस्टेंसी है: सुनिश्चित करें कि यह आपकी मौजूदा कन्वेंशन्स से मेल खाता है और नए पैटर्न या निर्भरताएँ न बना दे।

जब परिवर्तन ज्यादातर मैकेनिकल हो—कोडबेस में सिम्बल का नाम बदलना, रीफ़ॉर्मैट करना, या सीधी API उपयोग अपडेट करना—AI बासी काम तेज़ कर सकता है।

फिर भी, इसे एक बड़े एडिट की तरह ट्रीट करें: पूरा टेस्ट सूट चलाएँ, डिफ़्स स्कैन करें कि कहीं अनचाही व्यवहार परिवर्तन तो नहीं आये, और इसे अनुरोधित रिफैक्टर से आगे "सुधार" करने न दें।

AI README, इनलाइन कमेंट और चेंजलॉग एंट्रियों का ड्राफ्ट कर सकता है कोड और कमिट नोट्स के आधार पर। इससे स्पष्टता तेज़ होती है, पर यह आत्मविश्वासी‑लगने वाली गलतियाँ भी बना सकता है।

सर्वोत्तम अभ्यास: AI को संरचना और वाक्यांश देने के लिये उपयोग करें, फिर हर दावे—खासकर सेटअप स्टेप्स, कॉन्फ़िग डिफ़ॉल्ट्स, और एज‑केस—की जाँच करें।

अच्छी तरह परिभाषित, शुद्ध फ़ंक्शन्स के लिये AI‑जनरेटेड यूनिट टेस्ट प्रारंभिक कवरेज दे सकते हैं और एज‑केस की याद दिला सकते हैं। गार्डरेल: आप अभी भी तय करते हैं कि क्या मायने रखता है, उपयुक्त असेर्शन जोड़ते हैं, और सुनिश्चित करते हैं कि टेस्ट सही कारणों से फेल हों।

लंबे स्लैक थ्रेड्स, टिकट्स, या इनसिडेंट लॉग्स को संक्षेप में ACTION ITEMS में बदलने में AI मदद कर सकता है। इसे पूरा संदर्भ देकर जमीनी हकीकत में रखें और साझाकरण से पहले प्रमुख तथ्यों, टाइमस्टैम्प और निर्णयों का सत्यापन करें।

AI कोडिंग असिस्टेंट्स सर्वाधिक तब बेहतरीन होते हैं जब आपको पहले ही पता हो कि आप क्या चाहते हैं और आपको बस तेजी से आगे बढ़ना है। वे "टाइपिंग काम" समय घटाते हैं और सहायक संदर्भ सामने लाते हैं, पर ओनरशिप, वेरिफिकेशन और निर्णयन की ज़रूरत नहीं हटती।

स्पष्ट स्पेक दिए जाने पर—इन्पुट, आउटपुट, एज‑केस, और सीमाएँ—AI एक उपयुक्त शुरुआती इम्प्लीमेंटेशन ड्राफ्ट कर सकता है: बॉयलरप्लेट, डेटा मैपिंग, API हैंडलर्स, माइग्रेशन्स, या सरल रिफैक्टर। जीत गति है: आपको कुछ Runnable जल्दी मिलता है।

कैच यह है कि पहली पास अक्सर सूक्ष्म आवश्यकताओं (एरर सेमान्टिक्स, परफ़ॉर्मेंस बाधाएँ, बैकवर्ड कम्पैटिबिलिटी) को मिस कर देती है। इसे इंटरन का ड्राफ्ट समझें: उपयोगी, पर अधिकारिक नहीं।

जब आप विकल्पों (जैसे कैशिंग बनाम बैचिंग, optimistic बनाम pessimistic locking) के बीच चुन रहे हों, AI विकल्प और ट्रेड‑ऑफ सूचीबद्ध कर सकता है। यह ब्रेनस्टॉर्मिंग के लिये मूल्यवान है, पर ट्रेड‑ऑफ को आपकी सिस्टम वास्तविकताओं—ट्रैफ़िक शप, डेटा कंसिस्टेंसी ज़रूरतें, ऑपरेशनल सीमाएँ, और टीम कन्वेंशन्स—के खिलाफ जांचना होगा।

AI अपरिचित कोड समझाने, पैटर्न बताने, और "यह क्या कर रहा है?" को सादे शब्दों में अनुवाद करने में भी मजबूत है। सर्च टूल्स के साथ मिलकर यह जवाब दे सकता है "X कहाँ उपयोग हो रहा है?" और संभावित कॉल साइट्स, कॉन्फ़िग्स, और टेस्ट की प्रभाव सूची बना सकता है।

प्रैक्टिकल सुधार की उम्मीद रखें: स्पष्ट त्रुटि संदेश, छोटे उदाहरण, और रेडी‑टू‑पेस्ट स्निपेट। ये घर्षण कम करते हैं, पर वे सावधानीपूर्ण समीक्षा, लोकल रन, और लक्षित टेस्ट को प्रतिस्थापित नहीं करते—खासतौर पर उन बदलावों के लिये जो उपयोगकर्ताओं या प्रोडक्शन सिस्टम को प्रभावित करते हैं।

AI आवश्यकताएँ लिखने और परिमार्जन करने में मदद कर सकता है, पर यह भरोसेमंद रूप से निर्धारित नहीं कर सकता कि हमें क्या बनाना चाहिए या क्यों यह मायने रखता है। उत्पाद की समझ संदर्भ में जड़ित है: व्यापार लक्ष्य, उपयोगकर्ता दर्द, संगठनात्मक सीमाएँ, एज‑केस, और गलत होने की लागत। ये इनपुट संवादों, इतिहास, और जवाबदेही में रहते हैं—ऐसी चीज़ें जिन्हें मॉडल सारांशित कर सकता है, पर असली मालिक नहीं बन सकता।

प्रारंभिक अनुरोध अक्सर इस तरह होते हैं: “ऑनबोर्डिंग को अधिक सहज बनाओ” या “सपोर्ट टिकट घटाओ।” डेवलपर का काम इसे स्पष्ट आवश्यकताओं और स्वीकृति मानदंडों में ट्रांसलेट करना है।

यह अनुवाद ज़्यादातर मानव कार्य है क्योंकि इसमें probing प्रश्न और निर्णय‑बुद्धि शामिल है:

AI संभावित मीट्रिक्स या स्वीकृति मानदंड सुझा सकता है, पर यह नहीं जानता कि कौन‑सी सीमाएँ वास्तविक हैं जब तक कोई उन्हें न बताए—और यह तब भी विरोध नहीं करेगा जब कोई अनुरोध स्व‑विरोधी हो।

आवश्यकताओं का काम वह जगह है जहाँ असुविधाजनक ट्रेड‑ऑफ सामने आते हैं: समय बनाम गुणवत्ता, गति बनाम मेंटेनबिलिटी, नई फीचर बनाम स्थिरता। टीम को एक व्यक्ति चाहिए जो जोखिम स्पष्ट करे, विकल्प प्रस्तावित करे, और स्टेकहोल्डर्स को परिणामों पर संरेखित करे।

एक अच्छा स्पेक सिर्फ़ टेक्स्ट नहीं है; यह एक निर्णय रिकॉर्ड है। इसे टेस्टेबल और इम्प्लीमेंटेबल होना चाहिए, स्पष्ट परिभाषाओं के साथ (इनपुट, आउटपुट, एज‑केस, और फेलियर मोड)। AI दस्तावेज़ संरचित कर सकता है, पर सहीपन का और "यह अस्पष्ट है—हमें निर्णय चाहिए" कहने की जिम्मेदारी इंसानों पर रहती है।

सिस्टम डिज़ाइन वह जगह है जहाँ "हमें क्या बनाना चाहिए?" बदलकर "हमें इसे किस पर बनाना चाहिए, और जब चीज़ें गलत हों तो यह कैसा व्यवहार करेगा?" बन जाता है। AI विकल्पों को एक्सप्लोर करने में मदद कर सकता है, पर परिणामों का मालिक नहीं बन सकता।

मोनोलिथ, मॉड्यूलर मोनोलिथ, माइक्रोसर्विसेज, सर्वरलेस, या मैनेज्ड प्लेटफ़ॉर्म्स के बीच चुनाव कोई क्विज़ नहीं है। यह एक फिट‑समस्या है: अपेक्षित स्केल, बजट सीमाएँ, समय‑टू‑मार्केट, और टीम की कौशलें।

सहायक पैटर्न और संदर्भ वास्तुकलाएँ सुझा सकता है, पर यह नहीं जानता कि आपकी टीम साप्ताहिक ऑन‑कॉल करती है, हायरिंग धीमी है, या आपका डेटाबेस वेंडर कॉन्ट्रैक्ट अगले तिमाही में रिन्यू होता है। ऐसे विवरण अक्सर तय करते हैं कि आर्किटेक्चर सफल होगा या नहीं।

अच्छी आर्किटेक्चर ज्यादातर ट्रेड‑ऑफ हैं: सादगी बनाम लचीलापन, परफ़ॉर्मेंस बनाम लागत, आज की गति बनाम भविष्य की मेंटेनबिलिटी। AI जल्दी pros/cons सूची दे सकता है, जो निर्णय दस्तावेज़ीकरण के लिये उपयोगी है।

पर यह प्राथमिकताएँ तय नहीं कर सकता जब ट्रेड‑ऑफ चोट पहुँचाते हों। उदाहरण: “हम सिस्टम को सरल रखने के लिये थोड़ी धीमी प्रतिक्रियाएँ स्वीकार करते हैं” एक व्यावसायिक निर्णय है, तकनीकी नहीं।

सर्विस सीमाएँ परिभाषित करना, कौन‑सा डेटा किसका है, और आंशिक आउटेज के दौरान क्या होता है—इनमें गहरी उत्पाद और ऑपरेशनल संदर्भ चाहिए। AI फेलियर मोड्स का ब्रेनस्टॉर्म कर सकता है (“यदि पेमेंट प्रदाता डाउन है तो क्या होगा?”), पर आपको तय करना होगा कि अपेक्षित व्यवहार क्या है, ग्राहक संदेश क्या होगा, और रोलबैक योजना क्या है।

API डिज़ाइन एक कॉन्ट्रैक्ट बनाना है। AI उदाहरण जेनरेट और विसंगतियाँ पकड़ सकता है, पर आपको तय करना होगा वर्ज़निंग, बैकवर्ड कम्पैटिबिलिटी, और लंबी अवधि तक किसे समर्थन देने को तैयार हैं।

शायद सबसे वास्तुशिल्पीय निर्णय कहना है "ना"—या किसी फीचर को हटाना। AI अवसर लागत या राजनीतिक जोखिम नाप नहीं सकता। टीमें कर सकती हैं, और करनी चाहिए।

डिबगिंग वह जगह है जहाँ AI अक्सर प्रभावशाली दिखता है—और जहाँ यह चुपके से सबसे अधिक समय बर्बाद करवा सकता है। सहायक लॉग्स स्कैन कर सकता है, संदिग्ध कोड पाथ दिखा सकता है, या एक ऐसा फिक्स सुझा सकता है जो "सही लगे"। पर रूट‑कारण विश्लेषण सिर्फ़ व्याख्याएँ जेनरेट करना नहीं है; यह उन्हें साबित करना है।

AI आउटपुट को हाइपोथीसिस मानें, निष्कर्ष नहीं। कई बग्स के कई संभावित कारण होते हैं, और AI खासकर उस साफ‑सुथरी कहानी को चुनने में प्रवृत्त है जो आपने पेस्ट किया हुआ कोड स्निपेट मिलती‑जुलती हो, न कि रनिंग सिस्टम की वास्तविकता से मेल खाती हो।

व्यावहारिक वर्कफ़्लो:

भरोसेमंद पुनरुत्पादन एक डिबगिंग सुपरपावर है क्योंकि यह रहस्य को टेस्ट में बदल देता है। AI मिनिमल रिप्रो लिखने, डायग्नोस्टिक स्क्रिप्ट ड्राफ्ट करने, या अतिरिक्त लॉगिंग की सलाह देने में मदद कर सकता है, पर आप तय करें कि कौन‑से संकेत मायने रखते हैं: रिक्वेस्ट IDs, टाइमिंग, एनवायरनमेंट अंतर, फीचर फ्लैग्स, डेटा शेप, या concurrency।

जब यूज़र्स लक्षण रिपोर्ट करते हैं ("ऐप फ्रीज़ हो गया"), तब भी आपको उसे सिस्टम व्यवहार में ट्रांसलेट करना होगा: कौन‑सा एन्डपॉइंट रुका, कौन‑से टाइमआउट ट्रिगर हुए, कौन‑से error‑budget संकेत बदले। इसके लिये संदर्भ चाहिए: उत्पाद कैसे उपयोग होता है और क्या "नॉर्मल" दिखता है।

यदि किसी सुझाव का सत्यापन नहीं हो सकता, तो उसे गलत मानें जब तक कि परीक्षणीय भविष्यवाणी न करे (उदा., "यह केवल बड़े payloads पर होगा" या "केवल cache warm‑up के बाद")।

कारण पाये जाने के बाद भी, कठिन निर्णय बना रहता है। AI ट्रेड‑ऑफ बता सकता है, पर मानव चुनते हैं:

रूट‑कारण विश्लेषण अंततः जवाबदेही है: स्पष्टीकरण, फिक्स, और यह आत्मविश्वास कि यह फिर नहीं लौटेगा—इन सबको अपनाना।

कोड रिव्यू सिर्फ़ स्टाइल‑चेकलिस्ट नहीं है। यह वह क्षण है जब टीम तय करती है कि वह किसे मेंटेन, सपोर्ट, और जवाबदेह मानती है। AI आपको "ज़्यादा देखने" में मदद कर सकता है, पर यह तय नहीं कर सकता कि क्या मायने रखता है, क्या आपके उत्पाद इरादे के अनुरूप है, या आपकी टीम कौन से ट्रेड‑ऑफ स्वीकार करती है।

AI असिस्टेंट्स एक थकान न होने वाले दूसरे जोड़े आंख की तरह काम कर सकते हैं। वे जल्दी से कर सकते हैं:

इस तरह उपयोग करने पर AI PR खोलने और जोखिम नोटिस करने के बीच का समय कम कर देता है।

सहीपन की समीक्षा सिर्फ यह देखने की बात नहीं है कि कोड कम्पाइल होता है। इंसान बदलावों को वास्तविक उपयोगकर्ता व्यवहार, प्रोडक्शन सीमाओं, और दीर्घकालिक मेंटेनबिलिटी से जोड़ते हैं।

एक रिव्युअर को अभी भी तय करना होता है:

AI को अंतिम अप्रूवर नहीं, बल्कि दूसरे रिव्युअर के रूप में ट्रीट करें। इसे लक्षित पास माँगें (सिक्योरिटी चेक, एज‑केस, बैकवर्ड कम्पैटिबिलिटी), फिर मानव निर्णय लें कि स्कोप, प्रायोरिटी, और क्या बदलाव टीम मानकों और उत्पाद इरादे के अनुरूप है।

AI असिस्टेंट्स टेस्ट जल्दी जेनरेट कर सकते हैं, पर वे गुणवत्ता के मालिक नहीं हैं। एक टेस्ट सूट उन शर्तों पर दांव है जो आप मानते हैं कि टूट सकता है, क्या कभी न टूटने देना चाहिए, और किन चीज़ों को बिना हर एज‑केस साबित किए शिप किया जा सकता है। वे दांव उत्पाद और इंजीनियरी निर्णय हैं—अब भी इंसानों द्वारा किये जाते हैं।

सहायक यूनिट टेस्ट scaffolding, मॉकिंग, और इम्प्लिमेंटेशन से "हैप्पी पाथ" कवरेज बनाने में अच्छे हैं। पर वे भरोसेमंद रूप से यह तय नहीं करते कि कौन‑सा कवरेज मायने रखता है।

इंसान तय करते हैं:

अधिकांश टीमों को "ज़्यादा टेस्ट" नहीं बल्कि परतदार रणनीति चाहिए। AI कई तरह के टेस्ट लिखने में मदद कर सकता है, पर चयन और सीमाएँ मानव‑नेतृत्व वाली होंगी:

AI‑जनरेटेड टेस्ट अक्सर कोड के बहुत करीब होते हैं, नाज़ुक असेर्शन बनाते हैं या ओवर‑मॉक्ड सेटअप करते हैं जो असली व्यवहार फेल होने पर भी पास हो सकते हैं। डेवलपर्स इसे रोकते हैं:

एक अच्छी रणनीति आपके शिपिंग तरीके से मेल खाती है। तेज़ रिलीज़ में मजबूत ऑटोमेटेड चेक्स और स्पष्ट रोलबैक पाथ चाहिए; धीमे रिलीज़ में प्री‑मर्ज वैलिडेशन भारी हो सकती है। गुणवत्ता का मालिक टीम है, टूल नहीं।

कवरेज प्रतिशत गुणवत्ता नहीं है। ट्रैक करें कि क्या टेस्टिंग बेहतर परिणाम दे रही है: कम प्रोडक्शन इनसिडेंट्स, तेज़ रिस्कवरी, और सुरक्षित बदलाव (छोटे रोलबैक, तेज़ भरोसेमंद डिप्लॉय)। AI काम को तेज़ कर सकता है, पर जवाबदेही डेवलपर्स की रहती है।

सिक्योरिटी काम कोड जेनरेट करने से अधिक है—यह वास्तविक सीमाओं के अधीन ट्रेड‑ऑफ करने के बारे में है। AI चेकलिस्ट और आम गलतियों को उभार सकता है, पर जोखिम निर्णय टीम के साथ रहते हैं।

थ्रेट मॉडलिंग generic व्यायाम नहीं है—क्या मायने रखता है यह आपके व्यापार, उपयोगकर्ताओं, और फेलियर मोड्स पर निर्भर करता है। सहायक Tips दे सकता है (इंजेक्शन, ब्रोकन ऑथ, अनसेक्योर डिफ़ॉल्ट्स), पर यह भरोसेमंद रूप से नहीं जान पाएगा कि आपके उत्पाद के लिये क्या असल में महंगा है: अकाउंट टेकओवर बनाम डेटा लीक बनाम सर्विस डिस्टर्पशन, या कौन‑सा एसेट कानूनी रूप से संवेदनशील है।

AI ज्ञात एंटी‑पैटर्न पहचानने में अच्छा है, पर कई इंसिडेंट्स ऐप‑विशिष्ट विवरणों से आते हैं: एक परमिशंस एज‑केस, एक "टेम्पररी" एडमिन एंडपॉइंट, या ऐसा वर्कफ़्लो जो अनजाने में अप्रूवल्स को बायपास कर दे। ये जोखिम सिस्टम के इरादे पढ़ने माँगते हैं, सिर्फ़ कोड नहीं।

टूल्स आपको याद दिला सकते हैं कि कीज़ हार्ड‑कोड न करें, पर वे पूरी पॉलिसी का मालिक नहीं बनते:

AI पुराने लाइब्रेरीज़ को फ़्लैग कर सकता है, पर टीमें अभी भी प्रथाएँ चाहिए: वर्ज़न पिनिंग, प्रोवनेंस सत्यापन, ट्रांज़िटिव डिपेंडेंसी की समीक्षा, और तय करना कब जोखिम स्वीकार करें बनाम मेंडिटेशन में निवेश करें।

कम्प्लायंस केवल "एन्क्रिप्शन जोड़ो" नहीं है। यह कंट्रोल्स, दस्तावेज़ और जवाबदेही है: एक्सेस लॉग्स, अप्रूवल ट्रेल्स, इनसिडेंट प्रक्रियाएँ, और प्रमाण कि आपने उन्हें फॉलो किया—इन्हें AI टेम्पलेट ड्राफ्ट कर सकता है, पर इंसान प्रमाण सत्यापित और साइन‑ऑफ करेंगे—क्योंकि ऑडिटर (और ग्राहक) अंततः उन्हीं पर भरोसा करते हैं।

AI ऑप्स काम को तेज़ कर सकता है, पर यह मालिक नहीं लेता। विश्वसनीयता अनिश्चितता के तहत निर्णयों की चेन है, और गलत कॉल की लागत अक्सर धीमे होने की लागत से ज़्यादा होती है।

AI रनबुक, चेकलिस्ट और "यदि X तो Y करें" प्लेबुक्स ड्राफ्ट करने में उपयोगी है। यह लॉग्स संक्षेप कर सकता है, समान अलर्ट्स क्लस्टर कर सकता है, और पहले‑पास हाइपोथीसिस प्रस्तावित कर सकता है।

इसका परिणाम:

ये अच्छे एक्सेलेरेटर हैं, पर वे वास्तविक काम नहीं हैं।

इनसिडेंट्स अक्सर स्क्रिप्ट के अनुसार नहीं चलते। ऑन‑कॉल इंजीनियर्स अस्पष्ट संकेतों, आंशिक विफलताओं, और घर्षण‑भरे ट्रेड‑ऑफ्स के साथ निपटते हैं जब घड़ी चल रही होती है। AI संभावित कारण सुझा सकता है, पर यह भरोसेमंद रूप से तय नहीं कर सकता कि किसी और टीम को पेज करें, किसी फीचर को डिसेबल करें, या डेटा इंटीग्रिटी बचाने के लिये अल्पकालिक ग्राहक प्रभाव स्वीकार करें।

डिप्लॉयमेंट सुरक्षा भी मानव जिम्मेदारी है। टूल्स रोलबैक, फीचर फ्लैग्स, या स्टेज्ड रिलीज़ सुझा सकते हैं, पर टीमें अभी भी यह चुनती हैं कि दिए गए बिज़नेस संदर्भ और ब्लास्ट‑रेडियस को देखते हुए सबसे सुरक्षित पथ कौन‑सा है।

AI टाइमलाइन ड्राफ्ट कर सकता है और चैट, टिकट्स, और मॉनिटरिंग से मुख्य घटनाएँ खींच सकता है। इंसान अभी भी महत्वपूर्ण काम करते हैं: यह तय करना कि "अच्छा" क्या दिखता है, फिक्सेस को प्राथमिकता देना, और ऐसे परिवर्तन करना जो दोहराव रोकें (सिर्फ़ वही लक्षण ठीक न करें)।

यदि आप AI को ऑप्स कागज़‑कमी और पैटर्न‑फाइंडिंग के सह‑पायलट के रूप मेंTreat करते हैं—ना कि इनसिडेंट कमांडर के रूप में—तो आपको स्पीड मिलेगी बिना जवाबदेही छोड़ने के।

AI कई अवधारणाएँ स्पष्ट और तत्क्षण समझा सकता है: "CQRS क्या है?", "यह deadlock क्यों होता है?", "इस PR का सार बताओ।" इससे टीम तेज़ी से आगे बढ़ती है। पर काम में संचार केवल जानकारी हस्तांतरण नहीं है—यह भरोसा बनाना, साझा आदतें स्थापित करना, और वादों का निभाना है जिन पर लोग भरोसा कर सकें।

नए डेवलपर्स को सिर्फ़ उत्तर नहीं चाहिए; उन्हें संदर्भ और रिश्ते चाहिए। AI मॉड्यूल्स का सार, पढ़ने के मार्ग सुझाने, और जार्गन का अनुवाद करके मदद कर सकता है। फिर भी इंसान यह सिखाते हैं कि "यहाँ क्या मायने रखता है": टीम कौनसे ट्रेड‑ऑफ पसंद करती है, इस कोडबेस में "अच्छा" क्या है, और जब कुछ अजीब लगे तो किससे बात करनी चाहिए।

अधिकांश प्रोजेक्ट टकराव भूमिकाओं के बीच दिखते हैं: प्रोडक्ट, डिज़ाइन, QA, सिक्योरिटी, सपोर्ट। AI बैठक नोट्स ड्राफ्ट कर सकता है, स्वीकृति मानदंड प्रस्तावित कर सकता है, या फीडबैक को अधिक तटस्थ भाषा में पुनःप्रस्तुत कर सकता है। फिर भी लोगों को प्राथमिकताओं पर नेगोशिएट करना, अस्पष्टता हल करना, और यह नोटिस करना होता है जब कोई स्टेकहोल्डर "मंज़ूरी" दे रहा हो पर असल में सहमत न हो।

टीम तब विफल होती है जब जिम्मेदारी अस्पष्ट होती है। AI चेकलिस्ट जेनरेट कर सकता है, पर इसे लागू नहीं कर सकता। इंसानों को परिभाषित करना होगा कि "डन" का क्या मतलब है (टेस्ट? डॉक्यूमेंट? रोलआउट प्लान? मॉनिटरिंग?), और मर्ज के बाद किसका क्या मालिकाना है—खासतौर पर जब AI‑जनरेटेड कोड जटिलता छिपाता है।

यह उपकरणों (टास्क को पूरा करने वाली चीज़ें) और जिम्मेदारियों (नतीजों के लिये टीम की जवाबदेही) को अलग करता है।

क्योंकि टीमें "टास्क" नहीं बल्कि परिणाम भेजती हैं।

भले ही सहायक कोड या टेस्ट ड्राफ्ट करे, आपकी टीम अभी भी ज़िम्मेदार है:

“Replace” का मतलब है बाउंडेड, सत्यापनीय, और कम-जोखिम वाला काम जहाँ गलतियाँ पकड़ना आसान हो।

अच्छे उम्मीदवार:

ऐसे गार्डरेल्स जो त्रुटियों को स्पष्ट और सस्ते बनाते हैं:

क्योंकि "augment" वाले काम में अक्सर ऐसे छिपे हुए प्रतिबंध होते हैं जिन्हें मॉडल भरोसेमंद तरीके से नहीं समझ पाएगा:

AI आउटपुट को एक ड्राफ्ट मानें जिसे आप अपनी प्रणाली के हिसाब से अनुकूलित करते हैं, अंतिम समाधान नहीं।

इसे हाइपोथीसिस के रूप में उपयोग करें, निष्कर्ष के रूप में नहीं।

व्यावहारिक लूप:

यदि आप किसी सुझाव को सत्यापित नहीं कर सकते, तो उसे गलत मान लें जब तक कि साबित न हो।

AI आपकी मदद करके मुद्दे जल्दी दिखा सकता है, पर इंसान तय करते हैं कि क्या शिप करना है।

उपयोगी AI रिव्यू प्रॉम्प्ट:

फिर मानव पास करें कि यह इंटेंट, मेंटेनबिलिटी, और रिलीज रिस्क के साथ मेल खाता है—क्या रिलीज-प्रतिकार्य है और क्या बाद में फॉलो-अप होगा।

AI बहुत सारे टेस्ट ड्राफ्ट कर सकता है, पर यह तय नहीं करता कि किस कवरेज की वास्तविक जरूरत है।

मानव ज़िम्मेदारियाँ:

AI का उपयोग scaffolding और एज-केस ब्रेनस्टॉर्मिंग के लिए करें, न कि गुणवत्ता का पूरा मालिक बनने के लिए।

कभी भी प्रॉम्प्ट में सीक्रेट्स या संवेदनशील ग्राहक/इनसिडेंट डेटा पेस्ट न करें।

व्यवहारिक नियम: