10 जून 2025·8 मिनट

कैशिंग परतें लोड घटाती हैं — पर छिपी हुई जटिलता जोड़ती हैं

कैशिंग लेयर्स लेटेंसी और बैकएंड लोड घटाती हैं, पर वे विफलता मोड और ऑपरेशनल ओवरहेड भी जोड़ती हैं। सामान्य लेयर्स, जोखिम और जटिलता का प्रबंधन करने के तरीके सीखें।

कैशिंग लेयर्स लेटेंसी और बैकएंड लोड घटाती हैं, पर वे विफलता मोड और ऑपरेशनल ओवरहेड भी जोड़ती हैं। सामान्य लेयर्स, जोखिम और जटिलता का प्रबंधन करने के तरीके सीखें।

कैशिंग उस डेटा की एक कॉपी नज़दीक रखती है जहाँ उसकी ज़रूरत होती है, ताकि अनुरोध तेज़ी से सर्व किए जा सकें और कोर सिस्टम्स को बार-बार हिट न किया जाए। लाभ आम तौर पर स्पीड (कम लेटेंसी), लागत (कम महँगे DB रीड या अपस्ट्रीम कॉल), और स्थिरता (ओरिजिन सर्विसेस ट्रैफिक स्पाइक्स सहन कर पाती हैं) का मिश्रण होता है।

जब कैश अनुरोध का जवाब दे देता है, तो आपका “ओरिजिन” (एप सर्वर, डेटाबेस, थर्ड-पार्टी एपीआई) कम काम करता है। यह कमी नाटकीय हो सकती है: कम क्वेरीज, कम CPU साइकिल, कम नेटवर्क हॉप, और कम टाइमआउट संभावनाएँ।

कैशिंग बर्स्ट्स को भी स्मूथ करती है—जिससे औसत लोड के लिए आकार दिए गए सिस्टम पीक मोमेंट्स को बिना तुंरत स्केल किए हैंडल कर लेते हैं।

कैशिंग काम हटाती नहीं है; यह काम को डिज़ाइन और ऑपरेशन्स की दिशा में स्थानांतरित कर देती है। आपके पास अब नए प्रश्न होंगे:

हर कैशिंग लेयर नई कॉन्फ़िगरेशन, मॉनिटरिंग और एज केस जोड़ती है। एक कैश जो 99% अनुरोधों को तेज़ बनाता है, फिर भी 1% मामलों में दर्दनाक incidents का कारण बन सकता है: समकालिक एक्सपायरी, असंगत उपयोगकर्ता अनुभव, या ओरिजिन पर अचानक फ्लड।

एक एकल कैश एक स्टोर होता है (उदा., एप्लिकेशन के पास इन-मेमोरी कैश)। एक कैशिंग लेयर अनुरोध पथ में एक अलग चेकपॉइंट है—CDN, ब्राउज़र कैश, एप्लिकेशन कैश, डेटाबेस कैश—और हर एक की अपनी ताज़गी, इनवैलिडेशन और विफलता विधियाँ होती हैं।

यह पोस्ट उन व्यावहारिक जटिलताओं पर फोकस करती है जो कई परतें लाती हैं: correctness, invalidation, और operations (न कि लो-लेवल कैश अल्गोरिद्म या वेंडर-विशेष ट्यूनिंग)।

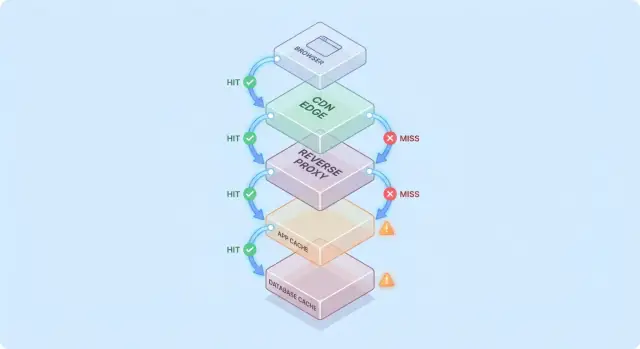

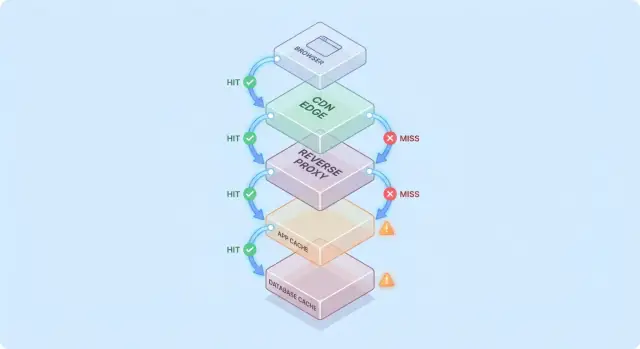

जब आप एक अनुरोध को कई "शायद मेरे पास पहले से है" चेकपॉइंट्स के स्टैक से गुजरते हुए कल्पना करते हैं, तो कैशिंग को समझना आसान हो जाता है।

एक आम पथ इस तरह दिखता है:

हर हॉप पर सिस्टम या तो कैश्ड रिस्पॉन्स दे सकता है (hit) या अगले लेयर पर फ़ॉरवर्ड कर सकता है (miss)। जितनी पहले हिट होती है (उदा., एज पर), उतना ही गहराई में लोड बचता है।

हिट्स डैशबोर्ड को अच्छा दिखाते हैं। मिस वही जगह हैं जहाँ जटिलता आती है: वे असल काम (एप लॉजिक, DB क्वेरीज) को ट्रिगर करते हैं और ओवरहेड जोड़ते हैं (कैश लुकअप, सिरियलाइज़ेशन, कैश राइट)।

एक उपयोगी मानसिक मॉडल यह है: हर मिस दो बार कैश के लिए भुगतान कराती है—आप अभी भी मूल काम करते हैं, साथ ही उसके इर्द-गिर्द का कैशिंग काम भी होता है।

एक कैश लेयर जोड़ना आम तौर पर बॉटलनेक्स को खत्म नहीं करता; यह अक्सर उन्हें स्थानांतरित कर देता है:

मान लें आपकी प्रोडक्ट पेज CDN पर 5 मिनट के लिए कैश है, और ऐप भी प्रोडक्ट डिटेल्स को Redis में 30 मिनट के लिए कैश करता है।

यदि प्राइस बदलती है, तो CDN तुरंत रिफ्रेश कर सकता है जबकि Redis पुराने प्राइस को सर्व करता रहे। अब "सत्य" इस बात पर निर्भर करेगा कि किस लेयर ने अनुरोध का जवाब दिया—यह एक छोटा सा उदाहरण है कि कैशिंग परतें लोड तो घटाती हैं पर सिस्टम जटिलता बढ़ाती हैं।

कैशिंग कोई एक फीचर नहीं है—यह डेटा को सेव और रीयूज़ करने के कई स्थानों का स्टैक है। हर लेयर लोड घटा सकती है, पर हर एक की ताज़गी, इनवैलिडेशन और दृश्यता के अलग नियम होते हैं।

ब्राउज़र्स HTTP हेडर (जैसे Cache-Control और ETag) के आधार पर इमेज, स्क्रिप्ट, CSS और कभी-कभी API रिस्पॉन्स भी कैश कर लेते हैं। इससे रिपीट डाउनलोड्स पूरी तरह से खत्म हो सकते हैं—प्रदर्शन और CDN/ओरिजिन ट्रैफ़िक दोनों के लिए अच्छा।

सावधानी: एक बार क्लाइंट-साइड कैश हो जाने पर आप रिवैलिडेशन टाइमिंग को पूरी तरह नियंत्रित नहीं कर पाते। कुछ उपयोगकर्ता पुराने एसेट लंबे समय तक रख सकते हैं (या कैश अनपेक्षित रूप से क्लियर कर दें), इसलिए वर्ज़न्ड URLs (उदा., app.3f2c.js) एक सामान्य सुरक्षा जाल होते हैं।

CDN कंटेंट को उपयोगकर्ताओं के नज़दीक कैश करता है। यह स्थैतिक फाइलों, पब्लिक पेजों और "मोहतरमा स्थिर" प्रतिक्रियाओं जैसे प्रोडक्ट इमेज, डॉक्यूमेंटेशन, या रेट-लिमिटेड API एंडपॉइंट्स के लिए शानदार है।

CDNs अर्ध-स्थिर HTML भी कैश कर सकती हैं जब आप cookies, headers, geo, device जैसी वेरिएशन के साथ सावधान हों। गलत कॉन्फ़िगर की गई variation rules अक्सर गलत उपयोगकर्ता को गलत कंटेंट सर्व करने का स्रोत बनती हैं।

रिवर्स प्रॉक्सी (जैसे NGINX या Varnish) आपके एप के सामने बैठती हैं और पूरे रिस्पॉन्स को कैश कर सकती हैं। यह तब उपयोगी है जब आप केंद्रीकृत नियंत्रण, पूर्वानुमेय eviction और ट्रैफ़िक स्पाइक्स के दौरान ओरिजिन सर्वरों की तेज़ सुरक्षा चाहते हैं।

यह सामान्यतः CDN जितना ग्लोबली वितरित नहीं होता, पर आपके ऐप के रूट्स और हेडर्स के लिए अनुकूलित करना आसान होता है।

यह कैश ऑब्जेक्ट्स, कम्प्यूटेड रिज़ल्ट और महँगी कॉल्स (उदा., “user profile by id” या “region के लिए प्राइसिंग नियम”) को लक्षित करता है। यह लचीला है और बिजनेस लॉजिक के बारे में अवेयर बनाया जा सकता है।

पर यह और भी निर्णय बिंदु जोड़ता है: की डिज़ाइन, TTL विकल्प, इनवैलिडेशन लॉजिक, और साइजिंग/फेलओवर जैसे ऑपरेशनल ज़रूरतें।

अधिकांश डेटाबेस पेजेज़, इंडेक्स और क्वेरी प्लान स्वतः कैश करते हैं; कुछ रिज़ल्ट कैशिंग भी सपोर्ट करते हैं। यह बार-बार आने वाली क्वेरीज को बिना एप को बदले तेज़ कर सकता है।

इसे बोनस के रूप में देखें, गारंटी के रूप में नहीं: डेटाबेस कैश विविध क्वेरी पैटर्न के तहत कम अनुमाननीय होते हैं, और वे राइट्स, लॉक या कंटेंशन की लागत को नहीं हटाते जैसा अपस्ट्रीम कैश कर पाते हैं।

कैशिंग तब सबसे ज़्यादा लाभ देती है जब यह बार-बार होने वाले महँगे बैकेंड ऑपरेशंस को सस्ती लुकअप में बदल दे। चाल यह है कि कैश को उन वर्कलोड्स से मिलाएँ जहाँ रिक्वेस्ट काफी हद तक समान हों—और पर्याप्त स्थिर हों—ताकि रीयूज़ अधिक हो।

यदि आपकी प्रणाली पढ़नों में बहुत अधिक है बनाम लिखने में, तो कैशिंग डेटाबेस और एप्लिकेशन के बहुत हिस्से का काम हटा सकती है। प्रोडक्ट पेज, पब्लिक प्रोफाइल, सहायता केंद्र के लेख, और भारी-भरकम सर्च/फिल्टर परिणाम अक्सर बार-बार वही पैरामीटर लेकर अनुरोध होते हैं।

कैशिंग उन "महँगी" प्रक्रियाओं में भी मदद करती है जो सख्ती से DB-बाउंड नहीं हैं: PDF जनरेशन, इमेज रीसाइज़िंग, टेम्पलेट रेंडरिंग, या एग्रीगेट्स का कम्प्यूटेशन। यहाँ तक कि थोड़ी अवधि का कैश (सेकंड से मिनट) भी व्यस्त समय में दोहराए जा रहे कम्प्यूटेशन को समेकित कर सकता है।

जब ट्रैफ़िक असमान हो, तब कैशिंग विशेष रूप से प्रभावी होती है। अगर एक मार्केटिंग ईमेल, न्यूज़ में उल्लेख, या सोशल पोस्ट एक ही कुछ URLs पर यूज़र्स का बर्स्ट भेजे, तो CDN या एज कैश उस surge का अधिकांश हिस्सा सोख सकता है।

यह सिर्फ़ तेज़ जवाब देने से अधिक लोड घटाता है: यह ऑटोस्केल थ्रैश को रोक सकता है, डेटाबेस कनेक्शन exhaustion से बचा सकता है, और रेट लिमिट्स/बैकप्रेशर को काम करने के लिए समय खरीद सकता है।

यदि आपका बैकएंड उपयोगकर्ताओं से दूर है—भौतिक रूप से (क्रॉस-रीजन) या तार्किक रूप से (धीमा निर्भरता)—तो कैशिंग लोड और प्रतीत होने वाली सुस्ती दोनों घटा सकती है। CDN से यूज़र के नज़दीक सर्विंग लंबी दूरी के ट्रिप्स को रोकता है।

इंटर्नल कैशिंग भी उपयोगी है जब बॉटलनेक उच्च-लेटेंसी स्टोर (रिमोट DB, थर्ड-पार्टी API, या साझा सेवा) है। कॉल्स की संख्या घटाने से concurrency दबाव और टेल लेटेंसी में सुधार होता है।

जब प्रतिक्रियाएँ बहुत अधिक व्यक्तिगत हों (प्रति-उपयोगकर्ता डेटा, संवेदनशील अकाउंट डिटेल्स) या जब मूल डेटा लगातार बदलता रहे (लाइव डैशबोर्ड, तेज़ी से बदलती इन्वेंटरी), तब कैशिंग का लाभ कम होता है। ऐसे मामलों में हिट रेट कम, इनवैलिडेशन लागत अधिक और बचा हुआ बैकेंड काम सीमित हो सकता है।

एक व्यावहारिक नियम: कैशिंग तब सबसे ज़्यादा मूल्यवान है जब कई उपयोगकर्ता एक ही चीज़ एक खिड़की के भीतर मांगते हैं और वह चीज़ वैध रहती है। यदि वह ओवरलैप मौजूद नहीं है, तो एक और कैशिंग लेयर जटिलता बढ़ा सकता है बिना लोड घटाए।

जब डेटा नहीं बदलता तो कैशिंग सरल है। जैसे ही वह बदलता है, आप सबसे कठिन हिस्सा विरासत में पाते हैं: तय करना कि कब कैश किया हुआ डेटा भरोसेमंद नहीं रहा और हर कैश लेयर कैसे जाने कि वह बदल गया।

TTL आकर्षक है क्योंकि यह एक संख्या है और किसी समन्वय की ज़रूरत नहीं। समस्या यह है कि "सही" TTL इस बात पर निर्भर करता है कि डेटा कैसे उपयोग होता है।

यदि आप किसी प्रोडक्ट प्राइस पर 5-मिनट TTL सेट करते हैं, तो कुछ उपयोगकर्ता बदलाव के बाद पुराना प्राइस देखेंगे—संभावित रूप से कानूनी या सपोर्ट समस्या। अगर आप 5-सेकंड सेट करते हैं तो शायद आप लोड बहुत कम नहीं करेंगे। और भी बदतर, एक ही रिस्पॉन्स के अलग फील्ड्स अलग दर पर बदलते हैं (इन्वेंटरी बनाम डिस्क्रिप्शन), तो एकल TTL समझौता बनाता है।

इवेंट-ड्रिवन इनवैलिडेशन कहता है: जब स्रोत-ऑफ-ट्रूथ बदलता है, तो एक इवेंट प्रकाशित करें और प्रभावित कैश कीज़ को purge/update करें। यह बहुत सटीक हो सकता है, पर यह नया काम बनाता है:

यही मैप वह जगह है जहाँ "दो कठिन चीजें: नामकरण और इनवैलिडेशन" व्यावहारिक रूप से दर्दनाक हो जाती हैं। अगर आप /users/123 कैश करते हैं और "टॉप कंट्रीब्यूटर्स" लिस्ट भी कैश करते हैं, तो एक यूज़रनेम परिवर्तन कई कीज़ को प्रभावित कर सकता है। अगर आप रिश्तों को ट्रैक नहीं करते, तो मिश्रित वास्तविकता सर्व की जाएगी।

Cache-aside (एप DB पढ़ता/लिखता, कैश को पॉपुलेट करता) सामान्य है, पर इनवैलिडेशन आपकी ज़िम्मेदारी है।

Write-through (कैश और DB दोनों में साथ-ही-लिखें) स्टालेनेस जोखिम घटाता है, पर latency और फेल्योर-हैंडलिंग जटिलता बढ़ाता है।

Write-back (पहले कैश में लिखें, बाद में फ्लश करें) स्पीड बढ़ाता है, पर correctness और रिकवरी बहुत मुश्किल बना देता है।

Stale-while-revalidate थोड़ा पुराना डेटा सर्व करता है जबकि बैकग्राउंड में उसे रिफ्रेश करता है। यह स्पाइक्स को स्मूद करता है और ओरिजिन की रक्षा करता है, पर यह भी एक प्रोडक्ट निर्णय है: आप स्पष्ट रूप से "तेज़ और ज्यादातर वर्तमान" को चुन रहे हैं बनाम "हमेशा नवीनतम"।

कैशिंग यह बदल देती है कि "सही" का क्या अर्थ है। बिना कैश के उपयोगकर्ता ज्यादातर नवीनतम कमिटेड डेटा देखते हैं (सामान्य DB व्यवहार के अधीन)। कैशों के साथ, उपयोगकर्ता थोड़ा पीछे का या स्क्रीन-टू-स्क्रीन असंगत डेटा देख सकते हैं—कभी-कभी बिना किसी स्पष्ट त्रुटि संदेश के।

मजबूत सुसंगति "रीड-आफ्टर-राइट" का लक्ष्य रखती है: अगर यूज़र अपना शिपिंग पता अपडेट करता है, अगली पेज लोड पर नया पता हर जगह दिखना चाहिए। यह सहज लगता है, पर महँगा हो सकता है अगर हर राइट तुरंत कई कैशेस को purge/refresh करे।

इवेंटुअल सुसंगति थोड़ी स्टेलनेस की अनुमति देती है: अपडेट जल्द दिखेगा पर तुरंत नहीं। उपयोगकर्ता कम-जोखिम कंटेंट (जैसे view counts) के लिए इसे सहन करते हैं, पर पैसे, परमिशन या ऐसे किसी भी चीज के लिए नहीं जो उनके अगले कदम को प्रभावित करे।

एक आम समस्या वह है जब राइट और कैश रिपॉपुलेशन एक साथ हो:

अब कैश अपने पूरे TTL के लिए पुराना डेटा रख सकता है, हालांकि DB सही है।

कई कैशिंग लेयर होने पर सिस्टम के अलग हिस्से असहमत हो सकते हैं:

उपयोगकर्ता इसे "सिस्टम टूटा हुआ है" के रूप में लेते हैं, न कि "सिस्टम अंततः सुसंगत है"।

वर्ज़निंग अस्पष्टता को कम करती है:

user:123:v7) सुरक्षित रूप से आगे बढ़ने देती हैं: एक राइट वर्ज़न बढ़ा देता है, और रीड्स नया की स्वाभाविक रूप से इस्तेमाल करने लगते हैं बिना परफेक्ट-टाइम किया हटाने के।मुख्य निर्णय यह नहीं है "क्या स्टेल डेटा बुरा है?" बल्कि कहाँ यह बुरा है।

हर फीचर के लिए स्पष्ट स्टेलनेस बजट (सेकंड/मिनट/घंटे) सेट करें और उन्हें उपयोगकर्ता अपेक्षाओं के अनुरूप रखें। सर्च रिज़ल्ट एक मिनट तक लैग कर सकते हैं; अकाउंट बैलेंस और एक्सेस कंट्रोल तुरंत दिखना चाहिए। यह "कैश correctness" को एक प्रोडक्ट रिक्वायरमेंट बनाता है जिसे आप टेस्ट और मॉनिटर कर सकते हैं।

कैशिंग अक्सर उन तरीकों से फेल होती है जो दिखते हैं कि "सब कुछ ठीक था, फिर अचानक सब कुछ टूट गया"। यह विफलताएँ यह नहीं दर्शातीं कि कैशिंग खराब है—बल्कि कि कैश ट्रैफ़िक पैटर्न को केन्द्रित कर देती है, इसलिए छोटे परिवर्तन बड़े प्रभाव ला सकते हैं।

डिप्लॉय, ऑटोस्केल इवेंट, या कैश फ़्लश के बाद आपका कैश अधिकांशतः खाली हो सकता है। अगले ट्रैफ़िक बर्स्ट में कई अनुरोध DB या अपस्ट्रीम APIs पर सीधे पहुंचते हैं।

यह विशेष रूप से तब दर्दनाक होता है जब ट्रैफ़िक तेजी से बढ़े, क्योंकि कैश में लोकप्रिय आइटम्स को गर्म होने का समय नहीं मिला होता। अगर डिप्लॉय पीक के साथ मेल खाता है, तो आप आकस्मिक रूप से अपना खुद का लोड टेस्ट बना सकते हैं।

स्टैंपेड तब होता है जब कई उपयोगकर्ता एक ही आइटम के लिए उसी समय एक्सपायर होने पर रिक्वेस्ट करते हैं। इसके बजाय कि एक अनुरोध वैल्यू को recompute करे, सैकड़ों/हज़ारों करते हैं—ओरिजिन को ओवरवाइल्म कर देते हैं।

सामान्य रोकथामों में:

यदि correctness अनुमति दे, तो stale-while-revalidate भी peaks को स्मूद कर सकता है।

कुछ कीज़ अत्यधिक लोकप्रिय हो जाती हैं (होमपेज पेलोड, ट्रेंडिंग प्रोडक्ट, वैश्विक कॉन्फ़िग्रेशन)। हॉट कीज़ असमान लोड पैदा करती हैं: एक कैश नोड या एक बैकएंड पाथ पेहले से ही हिट हो जाता है जबकि बाकी निडल रहते हैं।

राहत में छोटे "ग्लोबल" कीज़ को छोटे टुकड़ों में विभाजित करना, शार्डिंग/पार्टिशनिंग जोड़ना, या कैश को किसी अलग लेयर पर मूव करना (उदा., सचमुच पब्लिक कंटेंट को CDN के पास ले जाना) शामिल है।

कैश आउटेज नो-कैश से भी बदतर हो सकते हैं, क्योंकि एप्लिकेशन उन पर निर्भर होने के लिए लिखी जा सकती हैं। पहले से तय करें:

जो भी आप चुनें, रेट लिमिट्स और सर्किट ब्रेकर्स मदद करते हैं ताकि एक कैश फेल्योर ओरिजिन आउटेज न बन जाए।

कैशिंग आपके ओरिजिन सिस्टम्स पर लोड घटा सकती है, पर यह रोज़ाना चलने वाली सेवाओं की संख्या बढ़ा देती है। यहाँ तक कि "मैनेज्ड" कैशेस को भी योजना, ट्यूनिंग, और इन्सिडेंट रिस्पॉन्स की ज़रूरत होती है।

एक नई कैशिंग लेयर अक्सर एक नया क्लस्टर (या कम से कम नया टियर) होती है जिसकी अपनी क्षमता सीमाएँ होती हैं। टीमें मेमोरी साइजिंग, eviction पॉलिसी, और दबाव में क्या होगा तय करती हैं। यदि कैश undersized है, तो वह churn करेगा: हिट रेट घटेगा, लेटेंसी बढ़ेगी, और अंततः ओरिजिन पर दबाव फिर से बढ़ेगा।

कैशिंग शायद ही कभी एक ही जगह रहती है। आपके पास CDN कैश, एप्लिकेशन कैश, और डेटाबेस कैश हो सकते हैं—सभी नियमों की अलग व्याख्या करते हुए।

छोटी-मोटी असमानताएँ मिलकर बड़ी समस्याएँ बना देती हैं:

समय के साथ, "यह अनुरोध क्यों कैश्ड है?" एक पुरातत्व परियोजना बन जाता है।

कैशेस दोहराव वाला काम पैदा करते हैं: डिप्लॉय के बाद महत्वपूर्ण कीज़ वार्म करना, डेटा बदलने पर purge/रिवैलिडेट करना, नोड्स जोड़/हटाने पर रेशार्ड करना, और फुल फ्लश के बाद क्या होता है इसका rehearsal करना।

जब उपयोगकर्ता स्टेल डेटा या अचानक स्लोनेस रिपोर्ट करते हैं, तो रिस्पॉन्डर्स के पास अब कई शक़ी होते हैं: CDN, कैश क्लस्टर, ऐप का कैश क्लाइंट, और ओरिजिन। डिबगिंग अक्सर हिट रेट, eviction स्पाइक्स, और टाइमआउट्स की जाँच करना होता है—फिर तय करना होता है कि बाईपास करें, purge करें, या स्केल करें।

कैशिंग तभी जीत है जब वह बैकेंड काम घटाए और उपयोगकर्ता-देखा हुआ स्पीड सुधारे। क्योंकि अनुरोध कई लेयर्स (edge/CDN, ऐप कैश, DB कैश) द्वारा सर्व हो सकता है, आपको ऐसा ऑब्ज़र्वेबिलिटी चाहिए जो बताए:

एक उच्च हिट रेशियो अच्छा लगता है, पर यह समस्याएँ छिपा सकता है (जैसे धीमे कैश रीड्स या लगातार churn)। प्रत्येक लेयर के लिए एक छोटा सेट ट्रैक करें:

अगर हिट रेशियो बढ़े पर कुल लेटेंसी नहीं सुधरी, तो कैश धीमा है, अत्यधिक serialized है, या oversized payloads लौटा रहा है।

डिस्ट्रिब्यूटेड ट्रेसिंग यह दिखानी चाहिए कि क्या अनुरोध एज पर, ऐप कैश से, या DB से सर्व हुआ। एकसमान टैग्स जोड़ें जैसे cache.layer=cdn|app|db और cache.result=hit|miss|stale ताकि आप ट्रेसेज़ फ़िल्टर कर सकें और हिट-पाथ बनाम मिस-पाथ का समय तुलना कर सकें।

कैश कीज़ को लॉग करते समय सावधान रहें: कच्चे यूज़र आइडेंटिफ़ायर, ईमेल, टोकन, या क्वेरी स्ट्रिंग्स के साथ फुल URLs से बचें। नॉर्मलाइज़्ड या हैश की हुई कीज़ पसंद करें और केवल छोटा प्रिफ़िक्स लॉग करें।

अलर्ट करें जब असामान्य मिस-रेट स्पाइक्स, मिसेज पर अचानक लेटेंसी उछाल, और स्टैम्पेड संकेत (एक ही पैटर्न के लिए कई समवर्ती मिसेज) दिखें। डैशबोर्ड को अलग रखें: एज, एप, और डेटाबेस के व्यूज़, और एक एंड-टू-एंड पैनल जो उन्हें जोड़ता हो।

कैशिंग तेज जवाब देने में मदद करती है—पर यह गलत जवाब भी गलत व्यक्ति को दोहरा सकती है। कैशिंग-संबंधी सुरक्षा घटनाएँ अक्सर साइलेंट होती हैं: सब कुछ तेज़ और स्वस्थ दिखता है जबकि डेटा लीक हो रहा होता है।

एक आम त्रुटि व्यक्तिगत या गोपनीय कंटेंट (अकाउंट विवरण, इनवॉइस, सपोर्ट टिकट, एडमिन पेज) को कैश कर देना है। यह किसी भी लेयर पर हो सकता है—CDN, रिवर्स प्रॉक्सी, या एप्लिकेशन कैश—खासकर जब "सभी कुछ कैश करें" जैसे व्यापक नियम हों।

एक और सूक्ष्म लीक: ऐसे रिस्पॉन्स को कैश करना जिनमें session state शामिल है (Set-Cookie), और बाद में वह कैश्ड रिस्पॉन्स दूसरों को सर्व होना।

एक क्लासिक बग यह है कि यूज़र A के लिए लौटाई गई HTML/JSON को बाद में यूज़र B को सर्व कर दिया जाए क्योंकि कैश की में यूज़र कॉन्टेक्स्ट शामिल नहीं था। मल्टी-टेनेंट सिस्टम्स में, टेनेंट आइडेंटिटी को की का हिस्सा होना चाहिए।

नियम: यदि रिस्पॉन्स authentication, roles, geography, pricing tier, feature flags, या tenant पर निर्भर है, तो आपकी कैश की (या बाइपास लॉजिक) को उस निर्भरता को दर्शाना चाहिए।

HTTP कैशिंग व्यवहार बड़े पैमाने पर हेडर्स से नियंत्रित होता है:

Cache-Control: गलत तरीके से स्टोरेज से रोकने के लिए private / no-store का उपयोग करें जहाँ ज़रूरी होVary: यह सुनिश्चित करें कि कैश रिस्पॉन्स को प्रासंगिक रिक्वेस्ट हेडर्स के अनुसार अलग करे (उदा., Authorization, Accept-Language)Set-Cookie: अक्सर यह संकेत देता है कि रिस्पॉन्स को सार्वजनिक रूप से कैश नहीं करना चाहिएयदि अनुपालन या जोखिम उच्च है—PII, स्वास्थ्य/वित्तीय डेटा, कानूनी दस्तावेज—तो Cache-Control: no-store पसंद करें और सर्वर-साइड ऑप्टिमाइज़ेशन पर ध्यान दें। मिश्रित पेजों के लिए, केवल गैर-संवेदनशील फ्रैगमेंट या स्टैटिक एसेट्स कैश करें, और व्यक्तिगत डेटा साझा कैशेस से बाहर रखें।

कैशिंग लेयर्स ओरिजिन लोड घटा सकते हैं, पर यह आम तौर पर "मुफ़्त प्रदर्शन" नहीं होता। हर नए कैश को एक निवेश समझें: आप कम लेटेंसी और कम बैकएंड काम के बदले पैसा, इंजीनियरिंग समय, और बड़ी correctness सतह खरीद रहे हैं।

अतिरिक्त इंफ्रास्ट्रक्चर लागत बनाम घटे हुए ओरिजिन खर्च। CDN से egress और DB रीड घट सकते हैं, पर आप CDN रिक्वेस्ट, कैश स्टोरेज, और कभी-कभी invalidation कॉल्स के लिए भुगतान करेंगे। एप्लिकेशन कैश (Redis/Memcached) क्लस्टर लागत, अपग्रेड, और ऑन-कॉल भार बढ़ाता है। बचत DB रेप्लिकास घटाने, छोटे instance types, या स्केलिंग को स्थगित करने के रूप में दिख सकती है।

लेटेंसी लाभ बनाम ताज़गी लागत। हर कैश यह प्रश्न लाता है "कितना स्टेल स्वीकार्य है?" सख्त ताज़गी अधिक इनवैलिडेशन प्लम्बिंग माँगती है (अधिक मिसेज)। सहन की गई स्टेलनेस कंप्यूटिंग बचाती है पर उपयोगकर्ता ट्रस्ट की कीमत पर—खासकर प्राइस, उपलब्धता, या परमिशन के मामलों में।

इंजीनियरिंग समय: फीचर वेलॉसिटी बनाम विश्वसनीयता पर काम। एक नई लेयर अक्सर अतिरिक्त कोड पाथ, अधिक टेस्टिंग, और अधिक इन्सिडेंट क्लासेस जोड़ती है जिन्हें रोकना होगा (स्टैम्पेड्स, हॉट कीज़, आंशिक इनवैलिडेशन)। जारी रखरखाव के लिए बजट रखें, सिर्फ़ आरंभिक इम्प्लीमेंटेशन नहीं।

व्यापक रोलआउट से पहले सीमित ट्रायल चलाएँ:

नई कैशिंग लेयर तभी जोड़ें जब:

कैशिंग सबसे तेज़ लाभ तब देती है जब आप इसे एक प्रोडक्ट फीचर की तरह ट्रीट करते हैं: इसे एक ओनर, स्पष्ट नियम, और इसे बंद करने का सुरक्षित तरीका चाहिए।

एक समय में एक कैशिंग लेयर जोड़ें (उदा., CDN या ऐप्लिकेशन कैश पहले), और एक सीधे जिम्मेदार टीम/व्यक्ति असाइन करें।

परिभाषित करें hvem owns:

ज़्यादातर कैश बग वास्तव में “की बग” होते हैं। एक दस्तावेजीकृत कन्वेंशन उपयोग करें जिसमें उन इनपुट्स को शामिल करें जो रिस्पॉन्स बदलते हैं: tenant/user स्कोप, locale, device क्लास, और प्रासंगिक फीचर फ्लैग्स।

स्पष्ट की वर्ज़निंग जोड़ें (उदा., product:v3:...) ताकि आप मिलियनों एंट्रीज़ हटाने की कोशिश करने के बजाय वर्ज़न बढ़ा कर सुरक्षित इनवैलिडेशन कर सकें।

हर चीज़ को बिल्कुल ताज़ा रखने की कोशिश हर राइट पाथ में जटिलता डाल देती है।

बदले में, तय करें कि हर एंडपॉइंट के लिए "स्वीकार्य स्टेल" क्या है (सेकंड, मिनट, या "अगले रिफ्रेश तक") और इसे इनकोड करें:

मालूम मानिए कैश धीमा, गलत, या डाउन रहेगा।

टाइमआउट्स और सर्किट ब्रेकर्स लगाएँ ताकि कैश कॉल्स आपकी रिक्वेस्ट पाथ को डाउन न कर सकें। ग्रेसफुल डिग्रेडेशन को स्पष्ट करें: अगर कैश फेल करे तो ओरिजिन पर फॉल बैक करें पर रेट-लिमिट्स के साथ, या एक न्यूनतम जवाब दें।

कैशिंग को कैनरी या प्रतिशत रोलआउट के पीछे शिप करें, और एक बाइपास स्विच रखें (प्रति रूट या हेडर के लिए) तेज़ ट्रबलशूटिंग के लिए।

रनबुक डॉक्यूमेंट करें: कैसे purge करना है, कैसे की वर्ज़न बढ़ानी है, कैसे अस्थायी रूप से कैश डिसेबल करना है, और मेट्रिक्स कहाँ देखें। ऑन-कॉल से जुड़े इंटरनल रुनबुक पेज पर लिंक डालें ताकि टीम जल्दी कार्रवाई कर सके।

कई बार कैशिंग का काम अटक जाता है क्योंकि बदलाव कई लेयर्स को छूते हैं (हेडर्स, ऐप लॉजिक, डेटा मॉडल, रोलबैक प्लान)। iteration लागत घटाने का एक तरीका है पूरा रिक्वेस्ट पाथ नियंत्रित वातावरण में प्रोटोटाइप करना।

यदि आप Koder.ai जैसे प्लेटफ़ॉर्म का उपयोग करते हैं, तो टीमें वास्तविक ऐप स्टैक (React वेब, Go बैकएंड्स with PostgreSQL, और Flutter मोबाइल क्लाइंट) तेज़ी से चैट-ड्रिवन वर्कफ़्लो से स्पिन कर सकती हैं और फिर TTL, की डिज़ाइन, stale-while-revalidate जैसे कैशिंग निर्णय E2E टेस्ट कर सकती हैं। planning mode जैसी विशेषताएँ इम्प्लीमेंटेशन से पहले इच्छित कैशिंग व्यवहार दस्तावेज़ करने में मदद करती हैं, और snapshots/rollback कैश कॉन्फ़िगरेशन या इनवैलिडेशन लॉजिक के साथ प्रयोग करना सुरक्षित बनाती हैं। जब आप तैयार हों, तो आप source code export या custom domains पर deploy/host भी कर सकते हैं—यह परफॉर्मेंस ट्रायल्स के लिए उपयोगी है जिन्हें प्रोडक्शन ट्रैफ़िक पैटर्न की नकल करनी हो।

यदि आप ऐसा प्लेटफ़ॉर्म इस्तेमाल करते हैं, तो इसे प्रोडक्शन-ग्रेड ऑब्ज़र्वेबिलिटी का पूरक मानें: लक्ष्य तेज़ी से कैशिंग डिज़ाइन पर iteration करना होना चाहिए, जबकि correctness आवश्यकताओं और रोलबैक प्रक्रियाओं को स्पष्ट रखना चाहिए।

कैशिंग बार-बार आने वाले अनुरोधों का जवाब देकर ओरिजिन (एप सर्वर, डेटाबेस, थर्ड-पार्टी API) तक पहुंचने की आवश्यकता घटा देती है। सबसे बड़े लाभ आम तौर पर इन परिस्थितियों में दिखते हैं:

जितनी पहले रिक्वेस्ट पाथ में कैश हिट होगा (ब्राउज़र/CDN बनाम ऐप), उतना ही अधिक ओरिजिन का काम बचता है।

एक अकेला कैश एक स्टोर है (उदाहरण: एप के पास इन-मेमोरी कैश)। एक "कैशिंग लेयर" अनुरोध पाथ में एक चेकपॉइंट है (ब्राउज़र कैश, CDN, रिवर्स प्रॉक्सी, ऐप कैश, डेटाबेस कैश)।

कई परतें लोड को व्यापक रूप से घटा सकती हैं, लेकिन वे साथ ही अधिक नियम, अधिक फेल्योर मोड और असंगत डेटा सर्व करने के और तरीके भी जोड़ती हैं।

मिसेस असल काम को ट्रिगर करते हैं और उसके ऊपर कैशिंग के ओवरहेड को जोड़ते हैं। मिस पर आप आम तौर पर भुगतते हैं:

इसलिए एक मिस बिना कैश के मुकाबले धीमी हो सकती है जब तक कैश सही तरह से डिज़ाइन और हाई-हिट रेट न दे रहा हो।

TTL (Time-to-Live) सरल है क्योंकि यह समन्वय नहीं माँगता, पर अक्सर "सही" नहीं होता। TTL बहुत लंबा होने पर आप पुराना डेटा दिखाएंगे; बहुत छोटा होने पर लोड घटेगा ही नहीं।

व्यवहारिक तरीका यह है कि फीचर के आधार पर TTL सेट करें (उदाहरण: डॉक्स पेज के लिए मिनट, बैलेंस/प्राइसिंग के लिए सेकंड या नो-कैश) और रियल-विश्व हिट/मिस तथा इनसिडेंट डेटा के साथ इन्हें समय-समय पर दोबारा जाँचें।

इवेंट-ड्रिवन इनवैलिडेशन का प्रयोग तब करें जब स्टेलनेस महँगी हो और आप भरोसेमंद तरीके से राइट्स को प्रभावित होने वाले कीज़ से जोड़ सकें। यह तब सबसे अच्छा काम करता है जब:

यदि आप ये गारंटी नहीं दे सकते, तो पूरी तरह सही इनवैलिडेशन के बजाय bounded staleness (TTL + revalidation) को प्राथमिकता दें।

मिसाल के तौर पर: कई परतें यह कर सकती हैं कि सिस्टम के अलग-अलग हिस्से अलग जवाब दें—CDN पुराना HTML दे रहा है जबकि ऐप कैश नया JSON। इससे UI मिश्रित हो सकता है।

इसे कम करने के लिए:

product:v3:...) का प्रयोग करें ताकि reads स्वाभाविक रूप से नई चाबी पर चले जाएँVary/हेडर को उन चीज़ों के अनुरूप रखें जो वास्तव में प्रतिक्रिया बदलती हैंएक स्टैंपेड तब होता है जब बहुत से अनुरोध एक ही आइटम के लिए उसी समय पुनर्निर्माण करते हैं (अक्सर expiry के तुरंत बाद), जिससे ओरिजिन पर भारी दबाव पड़ता है।

आम mitigations:

पहले तय कर लें कि बैकअप व्यवहार क्या होगा:

साथ ही टाइमआउट्स, सर्किट ब्रेकर्स और रेट लिमिट्स लगाएँ ताकि कैश आउटेज एक कैश फेल्योर से ओरिजिन आउटेज में न बढ़े।

परिणामों को समझाने वाले मेट्रिक्स पर ध्यान दें, केवल हिट रेशियो पर नहीं:

ट्रेसिंग/लॉग में अनुरोधों को cache.layer और टैग करें ताकि आप “हिट पाथ” बनाम “मिस पाथ” की तुलना कर सकें।

सबसे आम जोखिम यह है कि व्यक्तिगत या संवेदनशील प्रतिक्रिया साझा लेयर्स (CDN/रिवर्स प्रॉक्सी) में कैश हो जाएँ क्योंकि की वैरिएशन नहीं हुई या हेडर गलत हैं।

सुरक्षा उपाय:

cache.resultCache-Control: no-store या private का उपयोग करेंVary सेट करें (उदा., Authorization, Accept-Language)Set-Cookie वाले रिस्पॉन्स को सार्वजनिक कैशिंग से बचाएँ