06 अक्टू॰ 2025·8 मिनट

MongoDB बनाम PostgreSQL: 2026 में सही डेटाबेस कैसे चुनें

डेटा मॉडलिंग, क्वेरी, इंडेक्सिंग, स्केलिंग, ट्रांज़ैक्शन्स और ऑपरेशन्स के आधार पर MongoDB और PostgreSQL की तुलना कर के 2026 में आपके ऐप के लिए सर्वश्रेष्ठ डेटाबेस चुनें।

डेटा मॉडलिंग, क्वेरी, इंडेक्सिंग, स्केलिंग, ट्रांज़ैक्शन्स और ऑपरेशन्स के आधार पर MongoDB और PostgreSQL की तुलना कर के 2026 में आपके ऐप के लिए सर्वश्रेष्ठ डेटाबेस चुनें।

प्रश्न यह नहीं हो कि “कौन सा सबसे अच्छा है?”—बल्कि यह कि “कौन‑सी प्रणाली इस वर्कलोड और टीम के लिए सबसे उपयुक्त है?” MongoDB और PostgreSQL दोनों परिपक्व और व्यापक रूप से अपनाए गए डेटाबेस हैं, लेकिन उनकी डिफ़ॉल्ट प्राथमिकताएँ अलग हैं: MongoDB लचीले दस्तावेज़‑आकृत डेटा और तेज़ iteration के लिए, PostgreSQL रिलेशनल मॉडलिंग, SQL की अभिव्यक्ति, और मजबूत इंटीग्रिटी गारंटी के लिए।

चयन तब सबसे अधिक मायने रखता है जब आपका वर्कलोड एक स्पष्ट दिशा की ओर झुका हो:

एक उपयोगी मानसिक मॉडल: अगर आपका डेटा स्वाभाविक रूप से रिलेशनशिप वाले एंटिटीज़ का सेट है, तो PostgreSQL अक्सर सरल फिट होता है। अगर आपका डेटा स्वाभाविक रूप से स्वतंत्र रिकॉर्डों का संग्रह है जो आकार बदलते रहते हैं, तो MongoDB शुरुआती चरण में घर्षण कम कर सकता है।

इस तुलना को व्यावहारिक रखने के लिए, दोनों विकल्पों का मूल्यांकन एक ही प्रश्नों के सामने करें:

कई टीमें polyglot persistence उपयोग करती हैं: PostgreSQL को system‑of‑record के लिए और MongoDB को कंटेंट, कैश‑सदृश read मोडलों, या इवेंट‑भारी फीचर्स के लिए। लक्ष्य उन सिस्टम हिस्सों में कम समझौते है जो सबसे ज़्यादा मायने रखते हैं—न कि वैचारिक पवित्रता।

अगर आप नई सर्विसेज़ जल्दी बना रहे हैं, तो ऐसा प्लेटफ़ॉर्म और आर्किटेक्चर चुनना सहायक हो सकता है जो आपको जल्दी लॉक‑इन न करे। उदाहरण के लिए, Koder.ai (एक वाइब‑कोडिंग प्लेटफ़ॉर्म जो चैट से फुल‑स्टैक ऐप जनरेट करता है) React + Go + PostgreSQL स्टैक को डिफ़ॉल्ट करता है—यह transactional सिस्टम के लिए अच्छा “safe default” हो सकता है, जबकि आवश्यकता बदलने पर JSONB जैसी अर्ध‑संरचित फ़ील्ड्स की अनुमति भी देता है।

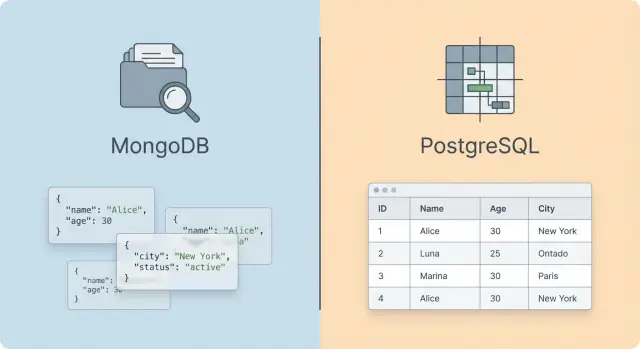

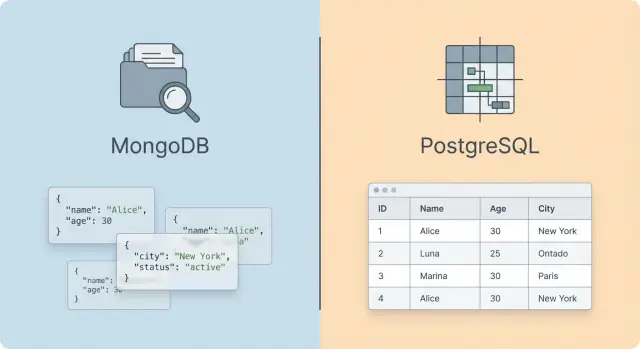

डाटा‑मॉडल स्तर पर, MongoDB और PostgreSQL आपके एप्लिकेशन की “शेप” के बारे में अलग तरीके अपनाने को प्रोत्साहित करते हैं। MongoDB एक डॉक्यूमेंट डेटाबेस है: आप संग्रहों में self‑contained JSON‑जैसे दस्तावेज़ स्टोर करते हैं। PostgreSQL एक रिलेशनल डेटाबेस है: आप टेबल्स में पंक्तियाँ स्टोर करते हैं, उन्हें keys के माध्यम से संबंधित करते हैं, और उन रिश्तों पर क्वेरी करते हैं।

MongoDB में, एक सामान्य रिकॉर्ड संबंधित डेटा को सीधे एम्बेड कर सकता है:

orders collection

यह hierarchical या “aggregate” डेटा के साथ अच्छा मेल खाता है जहाँ आप आमतौर पर पूरा ऑब्जेक्ट एक बार में फेच करते हैं।

PostgreSQL में, आप आमतौर पर इसे कई तालिकाओं में सामान्यीकृत करेंगे:

orders (प्रत्येक order के लिए एक पंक्ति)order_items (प्रत्येक order के लिए कई पंक्तियाँ)addresses (वैकल्पिक अलग तालिका)यह संरचना तब उत्कृष्ट होती है जब आपको ग्राहकों, उत्पादों और ऑर्डर्स पर रिपोर्टिंग जैसी लगातार रिश्तों की ज़रूरत हो।

MongoDB डिफ़ॉल्ट रूप से लचीला है: एक ही संग्रह के दस्तावेज़ों में अलग‑अलग फ़ील्ड हो सकती हैं। इससे iteration तेज़ होता है, पर बिना validation नियमों और अनुशासन के inconsistent आकार आना आसान हो जाता है।

PostgreSQL कॉलम प्रकार, constraints, और foreign keys से संरचना लागू करता है। बदलावों के लिए migrations की ज़रूरत होती है, पर आप डेटा इंटीग्रिटी के लिए मजबूत गार्डरेल्स पाते हैं।

एक मध्य मार्ग भी मौजूद है: PostgreSQL का JSONB आपको रिलेशनल टेबल के अंदर अर्ध‑संरचित डेटा स्टोर करने देता है। कई टीमें स्थिर फ़ील्ड्स (IDs, timestamps, status) के लिए कॉलम और विकसित होने वाले attributes के लिए JSONB का उपयोग करती हैं—रिलेशनल इंटीग्रिटी बनाए रखते हुए परिवर्तन को सहनशील बनाते हुए।

MongoDB अक्सर नेस्टेड ऑब्जेक्ट्स, इवेंट पेलोड्स, और कंटेंट‑प्रकार डेटा के लिए सहज लगता है जिसे आप पूरी तरह पढ़ते हैं। PostgreSQL तब उत्कृष्ट होता है जब रिश्ते पहली‑कक्षा हों, joins आम हों, और consistency नियम मॉडल का हिस्सा हों—न कि सिर्फ़ application कोड।

क्वेरी करना वह जगह है जहाँ MongoDB बनाम PostgreSQL का दैनिक अनुभव सबसे स्पष्ट होता है: PostgreSQL सेट‑आधारित ऑपरेशनों को टेबल्स पर optimize करता है, जबकि MongoDB application‑आकृति दस्तावेज़ों के साथ काम करने को प्राथमिकता देता है।

PostgreSQL का SQL declarative और composable है: आप परिणाम सेट का वर्णन करते हैं, और प्लानर यह तय करता है कि उसे कैसे प्राप्त करना है। यह जटिल filtering, grouping, window functions, CTEs, और multi‑step ट्रांसफॉर्मेशन्स को सहज बनाता है—खासकर जब आवश्यकताएँ बीच में बदलती हैं।

MongoDB आमतौर पर सीधी retrieval के लिए “find” क्वेरियों और ट्रांसफ़ॉर्मेशन के लिए Aggregation Pipeline का उपयोग करता है (filter → project → group → sort, आदि)। पाइपलाइन अभिव्यंजक हो सकती है, पर यह अधिक procedural है—क्रम मायने रखता है—और बहुत जटिल पाइपलाइन्स को समझना एकल SQL स्टेटमेंट की तुलना में कठिन हो सकता है।

PostgreSQL joins को पहली‑कक्षा टूल के रूप में देखता है। आप डेटा को सामान्यीकृत कर सकते हैं और तालिकाओं के पार join कर सकते हैं बिना यह बदले कि आप कैसे क्वेरी करते हैं; ट्रेड‑ऑफ यह है कि आपको join cardinality, इंडेक्सेस, और कभी‑कभी query tuning के बारे में सोचना होगा।

MongoDB आमतौर पर संबंधित डेटा को एम्बेड करने का सुझाव देता है जब वह सामान्यतः साथ पढ़ा जाता है (उदा., एक order में line items)। इससे पढ़ना सरल हो सकता है और joins की ज़रूरत खत्म हो जाती है। नकारात्मक पक्ष है duplication और अपडेट्स का जटिल होना।

जब आपको cross‑collection रिश्ते चाहिए होते हैं, MongoDB aggregations में $lookup प्रदान करता है। यह काम करता है, पर आम तौर पर यह उतना ergonomic नहीं होता—या अच्छी तरह से scale होने पर रिलेशनल joins जितना लगातार performant नहीं रहता—और यह आपको बड़े, अधिक जटिल aggregation पाइपलाइन्स की ओर धकेल सकता है।

PostgreSQL BI‑शैली के वर्कलोड्स में जीतता है: ad‑hoc क्वेरियाँ, exploratory joins, और कई एंटिटीज़ में रिपोर्टिंग सहज है, और अधिकांश analytics टूल्स SQL को नेटिव रूप से सपोर्ट करते हैं।

MongoDB रिपोर्टिंग का समर्थन कर सकता है, खासकर यदि आपकी रिपोर्ट्स दस्तावेज़ सीमाओं के अनुरूप हों, पर ad‑hoc multi‑entity विश्लेषण अक्सर अधिक पाइपलाइन‑काम (या कॉलम‑स्टोर/वेयरहाउस में ETL) मांगता है।

दोनों के पास परिपक्व ड्राइवर हैं, पर उनका “फील” अलग होता है। PostgreSQL बड़े SQL इकोसिस्टम, ORMs, और query analyzers से लाभ उठाता है। MongoDB तब अधिक प्राकृतिक लग सकता है जब आपके डोमेन ऑब्जेक्ट्स पहले से ही JSON‑सदृश हों—जब तक कि रिश्ते और रिपोर्टिंग की ज़रूरतें बढ़ न जाएँ।

स्कीमा डिज़ाइन वह जगह है जहाँ MongoDB और PostgreSQL दैनिक जीवन में सबसे अलग महसूस करते हैं: MongoDB एप्लिकेशन ऑब्जेक्ट्स की तरह डेटा आकार देने के लिए अनुकूल है, जबकि PostgreSQL तथ्यों के सेट की तरह डेटा आकार देने के लिए अनुकूल है।

PostgreSQL में सामान्यीकरण default है: आप एंटिटीज़ को तालिकाओं में विभाजित करते हैं और उन्हें foreign keys से जोड़ते हैं। इससे नकल कम होती है और cross‑entity अपडेट सुरक्षित बनते हैं (ग्राहक का नाम एक बार बदलें)।

MongoDB में एम्बेडिंग आम है: आप संबंधित डेटा को एक दस्तावेज़ में स्टोर करते हैं ताकि आप एक round trip में इसे पढ़ सकें। उदाहरण के लिए, एक order दस्तावेज़ उसके line items एम्बेड कर सकता है।

ट्रेड‑ऑफ़ अपडेट और consistency लागत है। एम्बेडिंग reference डेटा की नकल कर सकती है (product title, price snapshot), जबकि अधिक सामान्यीकरण कई joins और जटिल क्वेरियों की ओर ले जा सकता है।

जब आवश्यकताएँ बदलती हैं—जैसे कि कई शिपिंग पतों को जोड़ना, वैकल्पिक tax फ़ील्ड्स जोड़ना, या नए उत्पाद attributes का समर्थन—MongoDB का लचीला दस्तावेज़ कम upfront migration के साथ नए फ़ील्ड्स को अवशोषित कर सकता है।

PostgreSQL भी सुचारू रूप से विकसित हो सकता है, पर बदलाव स्पष्ट होते हैं: ALTER TABLE, बैकफिलिंग, और समय के साथ constraints कड़ाई। कई टीमें “पहले nullable, बाद में constrain” दृष्टिकोण अपनाती हैं ताकि तेज़ी से शिप किया जा सके बिना दीर्घकालिक अखंडता खोए।

PostgreSQL के बिल्ट‑इन गार्डरेल्स (foreign keys, CHECK constraints, unique constraints) बुरे राज्यों को डेटाबेस में प्रवेश करने से रोकते हैं।

MongoDB अक्सर अधिक application validation पर निर्भर करता है, हालाँकि JSON Schema validation मौजूद है। मुख्य अंतर सांस्कृतिक है: PostgreSQL केंद्रीय रूप से invariants लागू करने को बढ़ावा देता है; MongoDB टीमें अक्सर इन्हें कोड पाथ्स और परीक्षणों में लागू करती हैं।

अत्यधिक एम्बेडिंग बहुत बड़े दस्तावेज़ों, हॉट स्पॉट्स (कई writes एक दस्तावेज़ पर), और जटिल आंशिक अपडेट्स तक ले जाती है। अत्यधिक सामान्यीकरण अत्यधिक joins, चैटी APIs, और प्रदर्शन आश्चर्यों तक ले जा सकता है।

एक व्यावहारिक नियम: वह डेटा एम्बेड करें जो साथ बदलता है; वह डेटा reference करें जो स्वतंत्र रूप से बदलता है।

इंडेक्सेस वह जगह है जहाँ MongoDB बनाम PostgreSQL बहस अक्सर व्यावहारिक हो जाती है: "सबसे अच्छा" डेटाबेस अक्सर वही होता है जो आपकी सबसे सामान्य क्वेरियों को प्रत्याशित latency के साथ जवाब दे सके।

PostgreSQL सामान्यतः B‑tree इंडेक्सेस देता है, जो कई वर्कलोड्स (equality, ranges, ordering) को कवर करते हैं। जब access पैटर्न बदलते हैं, तो आपको विशिष्ट विकल्प भी मिलते हैं: GIN (arrays और full‑text search तथा JSONB के साथ उपयोगी), GiST/SP‑GiST (geospatial और कुछ कस्टम प्रकार), और BRIN (बड़े, प्राकृतिक रूप से ordered तालिकाओं जैसे time‑series)।

MongoDB भी सामान्य lookups और sorting के लिए B‑tree‑style इंडेक्सेस पर निर्भर करता है, साथ ही आप जल्दी मिलेंगे: multikey इंडेक्सेस (arrays के लिए), 2dsphere (geospatial), और text इंडेक्सेस (बुनियादी full‑text search)।

डॉक्यूमेंट डेटाबेस बनाम रिलेशनल डेटाबेस के चुनाव के संदर्भ में व्यावहारिक फ्रेम: PostgreSQL के पास विभिन्न डेटा प्रकारों और ऑपरेटरों के लिए अधिक “इंडेक्स प्रिमिटिव्स” हैं, जबकि MongoDB nested फ़ील्ड्स के लिए फ्लेक्सिबल एक्सेस पैटर्न और मजबूत इंडेक्सिंग सपोर्ट पर जोर देता है।

दोनों सिस्टम्स heavily compound indexes पर निर्भर करते हैं। मूल विचार समान है: उन फ़ील्ड्स को एक साथ इंडेक्स करें जिन पर आप फ़िल्टर करते हैं ताकि इंजन जल्दी से परिणाम संकुचित कर सके।

WHERE status = 'active')।दोनों डेटाबेस बिल्ट‑इन full‑text क्षमताएँ प्रदान करते हैं, पर इन्हें "ठीक‑ठाक" एक्सपीरियंस के रूप में देखें:

यदि सर्च प्रमुख उत्पाद फ़ीचर है (जटिल relevance, autocomplete, भारी faceting), तो अक्सर एक समर्पित सर्च इंजन का उपयोग करना साफ़ होता है—बजाय इसके कि किसी भी डेटाबेस को उसकी comfort zone से परे खींचें।

प्रदर्शन विचारों के लिए, अपनी इंडेक्सिंग रणनीतियों को वास्तविक query plans के साथ सत्यापित करें।

EXPLAIN (ANALYZE, BUFFERS) का उपयोग करें और sequential scans, misestimated row counts, और महँगे sorts पर ध्यान दें।explain() का उपयोग करें और stage output देखें (index usage, docs examined vs returned)।यहीं "SQL बनाम MongoDB क्वेरी भाषा" बहस शांत होती है: विजयी इंडेक्स वह होता है जो आपके एप्लिकेशन के असली पाथ पर काम को घटा दे।

ट्रांज़ैक्शन्स केवल एक चेकबॉक्स नहीं हैं—वे यह परिभाषित करते हैं कि आपकी एप्लिकेशन कौन‑सी विफलताओं को सह सकती है बिना डेटा को भ्रष्ट किए। ACID आमतौर पर मतलब होता है: लिखाई सब‑या‑कुछ‑नहीं (Atomicity), डेटा वैध बना रहता है (Consistency), समवर्ती अनुरोध अधूरा काम नहीं देखते (Isolation), और कमिट करने पर डेटा क्रैश के बाद भी टिकता है (Durability)।

PostgreSQL multi‑statement, multi‑table ट्रांज़ैक्शन्स के चारों ओर बना है। आप वर्कफ़्लोज़ जैसे “create order → reserve inventory → charge payment → write ledger entry” को एक इकाई के रूप में मॉडल कर सकते हैं, मजबूत गारंटियों और परिपक्व सुविधाओं (constraints, foreign keys, triggers) पर भरोसा करते हुए।

Concurrency के लिए PostgreSQL MVCC का उपयोग करता है: readers writers को ब्लॉक नहीं करते और isolation levels (Read Committed, Repeatable Read, Serializable) आपको यह चुनने देते हैं कि आप कितनी anomalies रोकना चाहते हैं। यह write‑heavy सिस्टम्स में महत्वपूर्ण है जहाँ जटिल बिज़नेस नियम हैं।

MongoDB डिफ़ॉल्ट रूप से single‑document level पर atomicity प्रदान करता है, जो तब आदर्श है जब आप संबंधित डेटा एम्बेड करते हैं और अपडेट्स एक दस्तावेज़ में रख सकते हैं। यह multi‑document ट्रांज़ैक्शन्स भी सपोर्ट करता है (replica sets और sharded clusters में), जिससे अधिक रिलेशनल‑स्टाइल वर्कफ़्लो संभव हैं—पर इसके साथ अधिक ओवरहेड और व्यावहारिक बाधाएँ आती हैं (ट्रांज़ैक्शन साइज/समय सीमाएँ, बढ़े हुए lock/coordination काम)।

MongoDB में consistency को read concern और write concern के माध्यम से कॉन्फ़िगर किया जा सकता है। कई एप्स "majority" writes और उपयुक्त reads का उपयोग करते हैं ताकि failover के बाद rollbacks से बचा जा सके।

Multi‑entity ऑपरेशन्स वह जगह हैं जहाँ अंतर स्पष्ट होते हैं:

यदि आपके मूल वर्कफ़्लोज़ सख्त, कई रिकॉर्ड्स पर फैले invariants पर निर्भर करते हैं, तो PostgreSQL अक्सर सरल लगता है। यदि आप महत्वपूर्ण अपडेट्स एक दस्तावेज़ के अंदर रख सकते हैं (या eventual reconciliation सह सकते हैं), तो MongoDB साफ़ फिट हो सकता है।

MongoDB और PostgreSQL के बीच प्रदर्शन का अंतर आम तौर पर ‘‘इंजन की गति’’ से कम और इस बात से ज़्यादा जुड़ा होता है कि आपका डेटा आपके access पैटर्न से कितना मेल खाता है—और प्रति अनुरोध डेटाबेस को कितना काम करना पड़ता है।

Read‑heavy सिस्टम्स उन डिज़ाइनों को इनाम देते हैं जो round trips और महँगा सर्वर‑साइड काम कम करते हैं। यदि एक अनुरोध एक ही दस्तावेज़ फ़ेच में मैप हो जाता है (और दस्तावेज़ ओवरसाइज़्ड नहीं है), तो MongoDB बहुत तेज़ हो सकता है।

Write‑heavy सिस्टम्स अक्सर इंडेक्स रखरखाव, write amplification, और durability सेटिंग्स पर bottleneck करते हैं। PostgreSQL narrow rows, सावधानीपूर्वक चुने गए इंडेक्स, और batch writes के साथ बेहद अच्छा प्रदर्शन कर सकता है; MongoDB भी append‑like पैटर्न में उत्कृष्ट हो सकता है, पर बड़े दस्तावेज़ों के बार‑बार in‑place updates महँगे पड़ सकते हैं।

मिश्रित वर्कलोड्स contention उजागर करते हैं: hot indexes, lock pressure, और cache churn। यहां दोनों डेटाबेस को “प्रति अनुरोध अतिरिक्त काम” कम करने का फायदा होता है (अनावश्यक इंडेक्स, wide projections, बहुत चैटी क्वेरियाँ)।

कम p99 लेटेंसी आमतौर पर सबसे धीमी क्वेरी द्वारा निर्धारित होती है, न कि औसत द्वारा। थ्रूपुट यह दर्शाता है कि डेटाबेस concurrency में CPU, memory, और I/O को कितनी कुशलता से उपयोग करता है।

निष्पक्ष बेंचमार्क के लिए रखें:

Joins बनाम document fetches: PostgreSQL joins शक्तिशाली हैं पर scale पर महँगी हो सकती हैं बिना अच्छे join keys और selective predicates के। MongoDB एम्बेडिंग से joins टालता है, पर बड़े दस्तावेज़ और नकल का भार उठाना पड़ सकता है।

Document/row size: जब दस्तावेज़ बड़े हो जाते हैं और अधिकांश क्वेरियाँ केवल कुछ फ़ील्ड्स चाहिए होती हैं, तो MongoDB प्रदर्शन गिर सकता है। PostgreSQL में भी wide rows और बड़े JSONB blobs I/O और मेमोरी दबाव बढ़ा सकते हैं।

इंडेक्स रखरखाव: अधिक इंडेक्स पढ़ने अच्छा करते हैं—जब तक वे लिखने को पस्त न कर दें। दोनों सिस्टम प्रति‑write हर इंडेक्स अपडेट करने की लागत उठाते हैं, इसलिए इंडेक्सेस को वास्तविक क्वेरी पैटर्न से बांध कर रखें।

एक छोटा हार्नेस बनाएं जो आपके टॉप 5–10 endpoints या क्वेरियों को वास्तविक concurrency और डेटा वितरण के साथ रीप्ले करे। बेसलाइन के साथ शुरू करें, फिर एक‑एक करके एक चीज़ बदलें (इंडेक्स सेट, दस्तावेज़ एम्बेडिंग, JSONB बनाम सामान्यीकृत टेबल्स)। चेकलिस्ट को एक repo में रखें और पुनरावृत्ति करें—synthetic single‑query बेंचमार्क पर निर्भर न रहें।

HA और स्केलिंग केवल "repl इनेबल करो" नहीं हैं—वे डिज़ाइन विकल्प हैं जो स्कीमा, क्वेरी पैटर्न, और संचालनात्मक कार्यभार को प्रभावित करते हैं। तेज़ वृद्धि का सबसे तेज़ मार्ग यह है कि आप स्केलिंग मैकेनिक्स को अपने प्रमुख access पैटर्न (read‑heavy, write‑heavy, time‑series, multi‑tenant, आदि) के साथ संरेखित करें।

MongoDB आमतौर पर replica sets उपयोग करता है: एक primary writes स्वीकार करता है, secondaries oplog replicate करते हैं, और failure पर चुनाव से नया primary प्रमोट होता है। इस मॉडल के लिए योजना बनानी चाहिए:

PostgreSQL सामान्यतः streaming replication (physical) पर निर्भर करता है, अक्सर एक primary और एक या अधिक standbys के साथ। failover आमतौर पर टूलिंग (managed services, Patroni, आदि) द्वारा orchestration करता है, और trade‑offs में शामिल हैं:

MongoDB sharding बिल्ट‑इन है और reads और writes दोनों को shards में वितरित कर सकता है। पकड़ यह है ऑपरेशनल जटिलता: shard key चुनना, hotspots से बचना, chunk migrations संभालना, और cross‑shard query लागतें समझना।

PostgreSQL "ऊपर" (scale up) बहुत अच्छा करता है, और "बाहर" (scale out) अधिक चयनात्मक रूप से करता है। सामान्य पैटर्न हैं read scaling replicas के माध्यम से और write scaling के लिए:

कमीट करने से पहले, अपने भविष्य के क्वेरियों का मॉडल बनाएं: कौन‑से फ़ील्ड सबसे अधिक फ़िल्टर करते हैं, कौन‑से sorts आवश्यक हैं, और क्या transactional होना चाहिए। आज फिट बैठने वाला डिज़ाइन जो cross‑shard fan‑out, hot partitions, या अत्यधिक synchronous replication को मजबूर करता है, अपेक्षा से पहले ही bottleneck बना देगा।

ऑपरेशनल काम वह जगह है जहाँ “MongoDB बनाम PostgreSQL” सुविधाओं की बात से हटकर आदतों की बात बन जाती है: आप कैसे बैकअप लेते हैं, कितनी जल्दी restore कर सकते हैं, और आप कितनी आत्मविश्वास के साथ संस्करण बदल सकते हैं।

PostgreSQL आमतौर पर logical और physical बैकअप का मिश्रण उपयोग करता है:

pg_dump/pg_restore लचीले होते हैं (टेबल‑स्तर रिस्टोर्स, पोर्टेबिलिटी) पर बड़े datasets पर धीमे हो सकते हैं।pg_basebackup) प्लस WAL archiving point‑in‑time recovery सक्षम करते हैं। यह आम तौर पर कम RPO (मिनटों या उससे कम) और अनुमानित RTO के लिए उपयोगी है।MongoDB इसको टूलिंग और स्नैपशॉट रणनीतियों के माध्यम से संभालता है:

mongodump/mongorestore सरल हैं पर बड़े पैमाने या तंग RTO पर चुनौतीपूर्ण हो सकते हैं।दोनों प्रणालियों के लिए, RPO/RTO स्पष्ट रूप से परिभाषित करें और नियमित रूप से restores का परीक्षण करें। एक “बैकअप” जिसे व्यावहारिक रूप में restore नहीं किया गया, सिर्फ़ संग्रहीत डेटा है।

उन्हीं लक्षणों की निगरानी करें जो उपयोगकर्ता‑दर्द से मजबूत रूप से जुड़े होते हैं:

pg_stat_statements, auto_explain, और slow query logs; MongoDB profiler और slow query logs।इसके अलावा storage health ट्रैक करें: PostgreSQL vacuum progress और bloat; MongoDB cache eviction, page faults, और index build प्रभाव।

PostgreSQL के मेजर अपग्रेड अक्सर pg_upgrade या logical replication cutovers को शामिल करते हैं; एक्सटेंशन्स कंपैटिबिलिटी और डाउनटाइम विंडो प्लान करें। MongoDB अपग्रेड आमतौर पर rolling प्रक्रियाओं का उपयोग करते हैं, Feature Compatibility Version (FCV), index builds, और (यदि sharded हो) chunk balancing पर ध्यान रखते हुए।

वास्तव में, टीमें managed services (जैसे Atlas या cloud Postgres) या Terraform/Ansible और Kubernetes operators के माध्यम से ऑटोमेशन पर निर्भर करती हैं। मुख्य प्रश्न यह नहीं है कि "क्या इसे ऑटोमेट किया जा सकता है?"—बल्कि यह है कि क्या आपकी टीम runbooks, on‑call संकेतों, और restore drills संभालने के लिए तैयार है।

यदि आप तेज़ी से सर्विसेज़ जनरेट कर रहे हैं (उदा., Koder.ai का उपयोग करके कई वातावरण स्पिन‑अप करना), तो जल्द operational defaults मानकीकृत करना सार्थक है—बैकअप रणनीति, माइग्रेशन वर्कफ़्लो, और rollback दृष्टिकोण—ताकि गति fragility पर न आए।

सुरक्षा केवल "auth चालू करें और काम खत्म" नहीं है। दोनों MongoDB और PostgreSQL के लिए व्यावहारिक प्रश्न यह है कि आप कितनी आसानी से least‑privilege एक्सेस लागू कर सकते हैं, credentials घुमाने/रोटेट कर सकते हैं, और (खुद को या ऑडिटर को) साबित कर सकते हैं कि किसने कब किस डेटा को एक्सेस/बदला।

दोनों डेटाबेस मजबूत प्रमाणीकरण और role‑based access control (RBAC) सपोर्ट करते हैं, पर व्यवहार में ये अलग तरह से महसूस होते हैं।

PostgreSQL का मॉडल users/roles, schemas/tables/views पर grants, और predictable SQL privileges के चारों ओर बना है। यह अक्सर ऐप्स (write paths) बनाम analysts (read paths) के लिए अलग रोल्स मैप करने में सहज रहता है, अक्सर dedicated read replicas के माध्यम से।

MongoDB का RBAC भी परिपक्व है, privileges को databases और collections तक scope करने के साथ, और deployment के आधार पर और भी finer‑grained विकल्प मिलते हैं। यह तब अच्छा बैठता है जब टीमें पहले से ही "service X collection Y पढ़/लिख सकता है" की धारणा में काम करती हों।

दोनों में उपयोगी least‑privilege पैटर्न:

ट्रांज़िट में एन्क्रिप्शन के लिए TLS को अनिवार्य मानें। इसे ड्राइवर स्तर और सर्वर स्तर पर लागू करें, और पुराने प्रोटोकॉल वर्ज़न्स अक्षम करें।

एट‑रेस्ट एन्क्रिप्शन की क्षमताएँ deployment मॉडल पर निर्भर करती हैं:

यदि आपके पास कंप्लायंस आवश्यकताएँ हैं (SOC 2, ISO 27001, HIPAA, PCI), तो आपको auditing और retention के लिए स्पष्ट कहानी चाहिए: connection logs, DDL परिवर्तन, privilege परिवर्तन, और संवेदनशील तालिकाओं/कलेक्शनों तक पहुँच। शासन में डेटा वर्गीकरण (PII क्या है?), retention नीतियाँ, और incident response के दस्तावेज़ीकृत प्रक्रियाएँ भी शामिल हैं।

व्यावहारिक तरीका यह है कि पहले तय करें कौन‑से इवेंट्स कैप्चर करने चाहिए (auth, admin actions, विशिष्ट datasets तक पहुँच) और लॉग्स को अपने SIEM में केंद्रीकृत करें।

अधिकांश वास्तविक दुनिया के भंगियाँ credentials और connectivity के इर्द‑गिर्द होती हैं, न कि क्वेरी सिंटैक्स के आसपास।

अच्छी तरह किया जाए तो दोनों MongoDB और PostgreSQL कड़े सुरक्षा और शासन आवश्यकताओं को पूरा कर सकते हैं—भेद यह है कि कौन‑सा मॉडल आपकी संगठनात्मक एक्सेस पैटर्न और ऑडिट अपेक्षाओं से बेहतर मेल खाता है।

लागत आमतौर पर केवल “डेटाबेस” नहीं होती। MongoDB बनाम PostgreSQL के लिए कुल स्वामित्व आमतौर पर resource खपत, durability ओवरहेड, और चीज़ों को स्वस्थ रखने के लिए जरूरी लोग‑घंटों में विभाजित होता है।

Compute अक्सर सबसे बड़ा परिवर्तनीय होता है। joins, जटिल रिपोर्टिंग, या सख्त consistency वाली वर्कलोड्स CPU और memory को अलग तरह से धकेल सकती हैं बनाम डॉक्यूमेंट‑सेंट्रिक पढ़/लिख। Storage लागत केवल कच्चे डेटा आकार पर निर्भर नहीं करती, बल्कि इंडेक्स फुटप्रिंट और denormalization से उत्पन्न किसी भी नकल पर भी निर्भर करती है।

IOPS और लेटेंसी तब लाइन‑आइटम बन जाते हैं जब आपका वर्किंग सेट memory में नहीं फिट बैठता या आपके इंडेक्स बड़े हैं। उच्च write दरें भी backup ओवरहेड को बढ़ाती हैं (स्नैपशॉट आवृत्ति, WAL/oplog प्रतिधारण, और रिस्टोर परीक्षण)। अंत में, replicas लागत को गुणा करते हैं: तीन‑नोड HA सेटअप बुनियादी compute+storage को लगभग तिगुना कर देता है, और क्रॉस‑रीजन रिप्लिकास नेटवर्क और उच्च‑स्तरीय स्टोरेज लागत जोड़ते हैं।

PostgreSQL सामान्यतः ओपन‑सोर्स लाइसेंसिंग के तहत उपयोग होता है, जबकि MongoDB deployments community builds और वाणिज्यिक ऑफ़रिंग्स के बीच भिन्न होते हैं। किसी भी के लिए managed services स्टाफ‑टाइम को उच्च यूनिट प्राइसिंग में बदल सकती हैं। पेड सपोर्ट incident response और performance tuning के लिए उपयोगी हो सकता है, पर ROI आपकी टीम के अनुभव और जोखिम सहिष्णुता पर निर्भर करता है।

ऑपरेशनल प्रयास वेतन और अवसर लागत के रूप में दिखता है: स्कीमा माइग्रेशन्स, इंडेक्स ट्यूनिंग, क्वेरी regressions, क्षमता योजना, on‑call थकान, और अनुपालन कार्य। यदि आपका संगठन पहले से मजबूत PostgreSQL टूलिंग, मानक, और प्रशिक्षित इंजीनियरों वाला है, तो इंजन बदलना अधोसंरचना बिल से अधिक महँगा पड़ सकता है (और उल्टा भी)।

डॉक्यूमेंट डेटाबेस बनाम रिलेशनल डेटाबेस का चुनाव आम तौर पर कच्ची गति से कम और इस बात से ज़्यादा जुड़ा होता है कि आपका डेटा परिवर्तन के तहत कैसे व्यवहार करता है, आपको कितनी इंटीग्रिटी लागू करनी है, और आपकी टीम कैसे क्वेरी करना चाहती है।

MongoDB उन डॉक्यूमेंट‑केंद्रित डोमेन्स में चमकता है जहाँ जो आप स्टोर करते हैं वह स्वाभाविक रूप से नेस्टेड JSON ऑब्जेक्ट जैसा दिखता है और अक्सर बदलता रहता है:

PostgreSQL आम तौर पर सुरक्षित विकल्प है जब relational integrity और expressive SQL मुख्य आवश्यकताएँ हों:

JSONB के माध्यम से अर्ध‑संरचित डेटा के साथ coexist कर सकते हैंएक व्यावहारिक विभाजन यह है: authoritative, constraint‑heavy एंटिटीज़ को PostgreSQL में रखें, और लचीले “interaction” या “content” दस्तावेज़ों को MongoDB में स्टोर करें।

उदाहरण: orders/payments Postgres में; product descriptions, personalization blobs, clickstream events, या cached projections MongoDB में। immutable IDs और event/outbox पैटर्न का उपयोग करके बदलाओं को सिंक करें, और प्रति एंटिटी एक सिस्टम को स्रोत‑ऑफ‑ट्रुथ मानें।

| जरूरत | MongoDB पसंद करें | PostgreSQL पसंद करें |

|---|---|---|

| डेटा आकार अक्सर बदलता है | ✅ | ➖ |

| जटिल joins और SQL रिपोर्टिंग | ➖ | ✅ |

| सख्त रिलेशनल इंटीग्रिटी | ➖ | ✅ |

| नेस्टेड दस्तावेज़ सीधे स्टोर करना | ✅ | ✅ (JSONB) |

| टीम/टूलिंग SQL पर आधारित | ➖ | ✅ |

अगर आप निर्णय‑चै churn कम रखना चाहते हैं जबकि तेज़ी से शिप कर रहे हैं, तो एक मजबूत default चुनें और एक exit ramp रखें: कोर एंटिटीज़ के लिए Postgres से शुरू करें, स्पष्ट डॉक्यूमेंट‑आकृति डोमेन के लिए MongoDB सुरक्षित रखें, और असली क्वेरी योजनाओं के साथ सत्यापित करें।

प्लानिंग के लिए स्विच (या दूसरा स्टोर जोड़ने) की जरूरत हो, तो /blog/database-migration-checklist देखें।

काम और टीम के अनुसार डेटाबेस मिलान कर के निर्णय लें:

अगर सिस्टम के अलग-अलग हिस्सों की अलग जरूरतें हैं, तो हाइब्रिड विकल्प मान्य मानें।

एक सामान्य नियम:

फिर अपने असली शीर्ष क्वेरीज और अपडेट पैटर्न से सत्यापित करें।

MongoDB नेस्टेड ऑब्जेक्ट्स को स्वाभाविक रूप से स्टोर करता है, इसलिए एक ही read अक्सर पूरे एग्रीगेट (उदाहरण: लाइन आइटम्स सहित एक order) वापस कर देता है। इससे round trips कम होती हैं और शुरुआती iteration सरल हो जाती है。

ट्रेड‑ऑफ: नकल (duplication) और अपडेट जटिलताएँ—खासकर जब वही एम्बेडेड जानकारी कई दस्तावेज़ों में अपडेट करनी हो।

PostgreSQL डेटाबेस में correctness को लागू करता है:

CHECK और UNIQUE constraintsयह सुनिश्चित करता है कि inconsistent डेटा गलती से डेटाबेस में न घुसे और concurrency-heavy बिज़नेस रूल्स लंबे समय में समझना आसान बने।

हाँ—JSONB अक्सर मध्य मार्ग होता है। सामान्य पैटर्न:

JSONB कॉलम में रखेंJSONB के अंदर query करने के लिए GIN इंडेक्स का उपयोग करेंयह relational integrity बनाए रखता है और फिर भी लचीले attributes की अनुमति देता है।

PostgreSQL joins को पहले-कक्षा का टूल मानता है और multi-entity querying व ad-hoc analysis के लिए आम तौर पर अधिक सुविधाजनक है।

MongoDB अक्सर embedding को बढ़ावा देता है ताकि joins टाले जा सकें। जब cross-collection relationships जरूरी हों, तो $lookup काम करता है, पर जटिल pipelines कठिन बन सकते हैं और बड़े पैमाने पर रिलेशनल joins जितने प्रत्याशित प्रदर्शन नहीं दे सकते।

अगर BI-शैली की रिपोर्टिंग और exploratory querying प्राथमिक आवश्यकताएँ हैं, तो PostgreSQL आम तौर पर बेहतर है क्योंकि:

MongoDB रिपोर्टिंग ठीक कर सकता है जब रिपोर्ट्स दस्तावेज़ सीमाओं के अनुरूप हों; पर multi-entity विश्लेषण के लिए अक्सर अधिक pipeline काम या ETL की ज़रूरत पड़ती है।

PostgreSQL "transactions first" मॉडल है और multi-statement, multi-table ACID वर्कफ़्लो में उत्कृष्ट है (उदा., order + inventory + ledger अपडेट)।

MongoDB डिफ़ॉल्ट रूप से single-document पर atomicity देता है (जब आप embed करते हैं तो बेहतरीन), और आवश्यकता पर multi-document transactions भी सपोर्ट करता है—पर आम तौर पर अधिक ओवरहेड और व्यावहारिक सीमाओं के साथ। अगर आपके मूल इनवारिएंट्स कई रिकॉर्ड्स पर concurrency में फैलते हैं, तो PostgreSQL ज़्यादा सरल महसूस होता है।

अपने असली क्वेरीज का उपयोग करें और query plans की जाँच करें:

EXPLAIN (ANALYZE, BUFFERS) का उपयोग करें ताकि sequential scans, misestimated row counts, और महँगे sorts पकड़े जा सकें।explain() का उपयोग करें और देखा जाये कि कितने docs एक्सामिन किए गए बनाम रिटर्न हुए।दोनों प्रणालियों में compound indexes और selectivity मायने रखते हैं, और अत्यधिक इंडेक्सेस लिखने पर भारी पड़ सकते हैं।

हाँ, और यह सामान्य भी है। एक व्यावहारिक विभाजन:

इसे संभाले रखने के लिए: प्रत्येक एंटिटी के लिए एक सिंगल सोर्स‑ऑफ‑ट्रुथ पर कार्य करें, immutable IDs का उपयोग करें, और outbox/events जैसे पैटर्न से सिंक रखें। बदलावों की योजना बनाते समय मदद के लिए /blog/database-migration-checklist देखें।