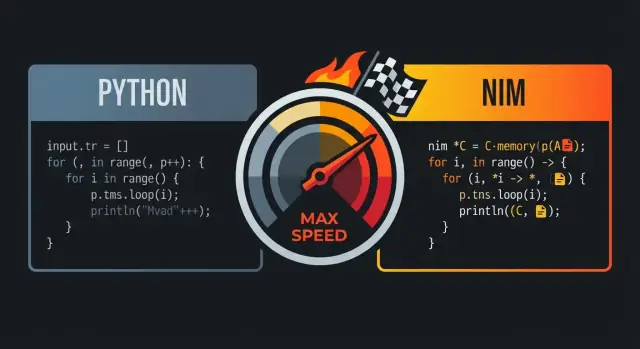

क्यों लोग Nim की तुलना Python और C से करते हैं

Nim की तुलना अक्सर Python और C से इसलिए की जाती है क्योंकि यह उन दोनों के बीच का मध्यम बिंदु खोजता है: ऐसा कोड जो पढ़ने में उच्च-स्तरीय स्क्रिप्टिंग भाषा जैसा लगे, लेकिन तेज़ नेटिव एक्जिक्यूटेबल में संकलित हो।

मूल वादा: पठनीयता के साथ गति

पहली नज़र में Nim अक्सर “Python जैसा” महसूस होता है: साफ़ इंडेंटेशन, सरल कंट्रोल फ्लो, और अभिव्यंजक स्टैन्डर्ड लाइब्रेरी फीचर जो स्पष्ट और कॉम्पैक्ट कोड को बढ़ावा देते हैं। मुख्य फर्क वह है जो आप लिखने के बाद होता है—Nim को कुशल मशीन-कोड में संकलित होने के लिए डिज़ाइन किया गया है बजाय भारी रनटाइम पर चलने के।

कई टीमों के लिए यही संयोजन मायने रखता है: आप ऐसा कोड लिख सकते हैं जो Python में प्रोटोटाइप जैसा दिखे, फिर भी उसे एक अकेले नेटिव बाइनरी के रूप में डिलिवर कर सकते हैं।

किसके लिए यह महत्वपूर्ण है

यह तुलना खासकर इन लोगों को प्रभावित करती है:

- Python डेवलपर्स जिन्हें प्रदर्शन सीमा (CPU-गहन कार्य, घनी लूप्स, डेटा प्रोसेसिंग) में बाधा मिलती है

- प्रोडक्ट टीमें जो तेज़ इटरेशन चाहती हैं बिना धीमे रनटाइम के

- वे इंजीनियर जिन्हें C की गति चाहिए पर रोज़मर्रा के कोड के लिए निचले-स्तर की रस्में नहीं करनीं

व्यवहार में “C-स्तरीय प्रदर्शन” का क्या अर्थ है

“C-स्तरीय प्रदर्शन” का मतलब यह नहीं कि हर Nim प्रोग्राम स्वचालित रूप से हाथ से ट्यून किए हुए C के बराबर होगा। बल्कि इसका मतलब है कि Nim काफ़ी वर्कलोड्स के लिए C के साथ प्रतिस्पर्धी कोड जेनरेट कर सकता है—खासकर जहाँ ओवरहेड मायने रखता है: संख्यात्मक लूप्स, पार्सिंग, एल्गोरिद्म, और ऐसे सर्विसेज जिन्हें पूर्वानुमेय लेटेंसी चाहिए।

आप आम तौर पर सबसे बड़े लाभ तब देखेंगे जब आप इंटरप्रेटर ओवरहेड हटाते हैं, आवंटनों को कम करते हैं, और हॉट कोड पाथ्स को सरल रखते हैं।

अपेक्षाएँ: गति अभी भी आपके चुनावों पर निर्भर है

Nim किसी भी गैर-कुशल एल्गोरिद्म को नहीं सुधारेगा, और आप फिर भी धीमा कोड लिख सकते हैं अगर आप अत्यधिक आवंटन करते हैं, बड़े डेटा ढांचे कॉपी करते हैं, या प्रोफ़ाइलिंग की अनदेखी करते हैं। वादा यह है कि भाषा आपको पठनीय कोड से तेज़ कोड तक का एक रास्ता देती है बिना पूरी तरह अलग पारिस्थितिकी में फिर से लिखने के।

नतीजा: एक ऐसी भाषा जो Python जैसी दोस्ताना लगती है, पर जब प्रदर्शन वास्तव में मायने रखता है तो यह “मेटल के करीब” होने को तैयार रहती है।

Python-जैसा सिंटैक्स: ओवरहेड के बिना पठनीय कोड

Nim को अक्सर “Python-जैसा” कहा जाता है क्योंकि कोड दिखने और बहने में परिचित लगता है: इंडेंटेशन-आधारित ब्लॉक्स, न्यूनतम विराम-चिन्ह, और पठनीय उच्च-स्तरीय कन्स्ट्रक्ट्स की प्राथमिकता। अंतर यह है कि Nim एक स्थिर-टाइप, 컴्बाइल्ड भाषा बनी रहती है—इसलिए आपको वह साफ़ सतह मिलती है बिना किसी रनटाइम “टैक्स” के।

इंडेंटेशन-आधारित ब्लॉक्स और साफ़ संरचना

Python की तरह, Nim भी ब्लॉक्स को परिभाषित करने के लिए इंडेंटेशन का उपयोग करता है, जिससे कंट्रोल फ्लो रिव्यू और डिफ़्स में स्कैन करना आसान होता है। आपको हर जगह ब्रेसेस की जरूरत नहीं पड़ती, और सामान्यतः केवल तभी पैरेंथेसिस चाहिए होते हैं जब वे स्पष्टता बढ़ाते हैं।

let limit = 10

for i in 0..<limit:

if i mod 2 == 0:

echo i

यह दृश्य सरलता मायने रखती है जब आप प्रदर्शन-संवेदी कोड लिख रहे हों: आप सिंटैक्स से लड़ने में कम समय बिताते हैं और अपना इरादा व्यक्त करने में अधिक।

परिचित बिल्डिंग ब्लॉक्स: लूप्स, स्लाइसेस, स्ट्रिंग्स

कई रोज़मर्रा के कन्स्ट्रक्ट्स Python उपयोगकर्ताओं की अपेक्षा के अनुसार नज़दीकी रूप से मैप होते हैं.

- लूप्स: रेंज और कलेक्शन्स पर

for लूप्स सहज लगते हैं।

- स्लाइस: सीक्वेंस और स्ट्रिंग्स स्लाइस-स्टाइल ऑपरेशंस का समर्थन करते हैं।

- स्ट्रिंग्स: स्ट्रिंग हैंडलिंग सरल है, और स्टैन्डर्ड लाइब्रेरी व्यावहारिक काम के लिए डिज़ाइन की गई है।

let nums = @[10, 20, 30, 40, 50]

let middle = nums[1..3] # slice: @[20, 30, 40]

let s = "hello nim"

echo s[0..4] # "hello"

मुश्किल बात यह है कि इन कन्स्ट्रक्ट्स के नीचे क्या होता है: ये इंटरप्रेटर द्वारा चलने की बजाय कुशल नेटिव कोड में संकलित होते हैं।

स्टैटिक टाइपिंग जो रास्ते में बाधा नहीं बनती

Nim मजबूत रूप से स्टैटिकली टाइप्ड है, पर यह भारी रूप से टाइप इन्फरेंस पर निर्भर करता है, इसलिए आपको सिर्फ़ काम करने के लिएVerbose टाइप एनोटेशन नहीं लिखने पड़ते।

var total = 0 # inferred as int

let name = "Nim" # inferred as string

जब आप स्पष्ट টাইप्स चाहते हैं (पब्लिक API, स्पष्टता, या प्रदर्शन-संवेदी सीमाओं के लिए), Nim उसे साफ़ तरीके से सपोर्ट करता है—बिना हर जगह मजबूर किए बिना।

सहायक कंपाइलर एरर और वार्निंग्स

“पठनीय कोड” का बड़ा हिस्सा इसे सुरक्षित रूप से मेंटेन करने की क्षमता है। Nim का कंपाइलर उपयोगी तरीकों से सख्त है: यह टाइप मिसमैच, अनयूज़्ड वेरिएबल्स, और संदेहजनक कन्वर्ज़न पहले ही दिखा देता है, अक्सर कार्य करने योग्य संदेशों के साथ। यह फीडबैक लूप आपको Python-सहजता बनाए रखते हुए कंपाइल-टाइम करेक्टनेस चेक का लाभ देता है।

यदि आप Python की पठनीयता पसंद करते हैं, Nim का सिंटैक्स घर जैसा लगेगा। फर्क यह है कि Nim का कंपाइलर आपकी धारणा को मान्य कर सकता है और फिर तेज़, पूर्वानुमेय नेटिव बाइनरी उत्पन्न कर सकता है—बिना आपके कोड को बोइलरप्लेट में बदलने के।

Nim कैसे कंपाइल करता है: स्रोत से नेटिव बाइनरी तक

Nim एक कंपाइल्ड भाषा है: आप .nim फाइलें लिखते हैं, और कंपाइलर उन्हें उस मशीन पर सीधे चलने योग्य नेटिव executable में बदल देता है। सबसे आम मार्ग Nim के C बैकएंड के माध्यम से है (यह C++, Objective-C को भी लक्षित कर सकता है), जहाँ Nim कोड बैकएंड स्रोत कोड में अनुवादित होता है और फिर सिस्टम कंपाइलर (GCC/Clang) द्वारा कंपाइल किया जाता है।

“नेटिव बाइनरी” का असली मतलब

एक नेटिव बाइनरी किसी भाषा वर्चुअल मशीन के बिना और किसी इंटरप्रेटर के बिना चलती है। यही Nim को हाई-लेवल महसूस कराते हुए कई रनटाइम लागतों से बचने का एक बड़ा कारण है: स्टार्टअप समय आमतौर पर तेज़ होता है, फ़ंक्शन कॉल सीधे होते हैं, और हॉट लूप्स हार्डवेयर के करीब निष्पादित हो सकते हैं।

पूरे-प्रोग्राम ऑप्टिमाइज़ेशन के अवसर

क्योंकि Nim AOT (ahead-of-time) कंपाइल करता है, टूलचेन आपके प्रोग्राम पर समग्र रूप से ऑप्टिमाइज़ कर सकता है। व्यवहार में यह बेहतर इनलाइनिंग, डेड-कोड एलिमिनेशन, और लिंक-टाइम ऑप्टिमाइज़ेशन (फ्लैग्स और आपके C/C++ कंपाइलर पर निर्भर) को सक्षम कर सकता है। नतीजा अक्सर छोटे, तेज़ executable होते हैं—खासकर तुलना में जब आपको एक रनटाइम और सोर्स दोनों शिप करने पड़ते हैं।

सामान्य वर्कफ़्लो: कंपाइल, रन, शिप

डेवेलपमेंट के दौरान आप आम तौर पर nim c -r yourfile.nim जैसे कमांड से इटरेट करेंगे (कंपाइल और रन) या डिबग बनाम रिलीज़ के लिए अलग-बिल्ड मोड का उपयोग करेंगे। जब शिप करने का समय आएगा, आप उत्पादित executable (और यदि आवश्यक तो डायनामिक लाइब्रेरीज़) वितरित करेंगे। इंटरप्रेटर को डिप्लॉय करने का कोई अलग कदम नहीं है—आपका आउटपुट पहले से ही एक ऐसा प्रोग्राम है जिसे OS चला सकता है।

कम्पाइल-टाइम पावर: प्रोग्राम रन होने से पहले काम करना

Nim के सबसे बड़े गति लाभों में से एक यह है कि यह कुछ काम कम्पाइल-टाइम पर कर सकता है (CTFE)। साधारण शब्दों में: रनटाइम पर हर बार कुछ गणना करने की बजाय, आप कंपाइलर से कह सकते हैं कि वह बिल्ड के दौरान एक बार गणना करे और परिणाम को फाइनल बाइनरी में bake कर दे।

कम्पाइल-टाइम काम क्यों मायने रखता है

रनटाइम प्रदर्शन अक्सर “सेटअप लागत” द्वारा खाया जाता है: टेबल बनाना, ज्ञात फॉर्मैट पार्स करना, इनवेरिएन्ट चेक करना, या ऐसे मान जो कभी नहीं बदलते। यदि ये रिज़ल्ट कॉन्स्टैंट्स से अनुमानित हैं, तो Nim वह प्रयास बिल्ड के दौरान स्थानांतरित कर सकता है।

इसका मतलब:

- कम स्टार्टअप समय (कोई “वार्म-अप” नहीं)

- निष्पादन के दौरान कम आवंटन और ब्रांचेज़

- सरल रनटाइम कोड पाथ्स (अक्सर कंपाइलर के लिए ऑप्टिमाइज़ करना आसान)

व्यावहारिक उदाहरण

लुकअप टेबल्स जनरेट करना। यदि आपको फास्ट मैपिंग के लिए टेबल चाहिए (जैसे ASCII कैरेक्टर क्लासेस या ज्ञात स्ट्रिंग्स का छोटा हैश मैप), आप उसे कम्पाइल-टाइम पर जेनरेट कर के एक कॉन्स्ट ऐरे के रूप में स्टोर कर सकते हैं। प्रोग्राम तब O(1) लुकअप करता है बिना किसी सेटअप के।

कॉन्स्टैंट्स को जल्दी वैलिडेट करना। यदि कोई कॉन्स्टैंट रेंज से बाहर है (पोर्ट नंबर, फिक्स्ड बफ़र साइज, प्रोटोकॉल वर्शन), आप बिल्ड को फेल कर सकते हैं बजाय ऐसी बाइनरी शिप करने के जो बाद में समस्या पाए।

व्युत्पन्न कॉन्स्टैंट्स प्रीकम्प्यूट करना। मास्क, बिट पैटर्न या नॉर्मलाइज़्ड कॉन्फ़िग डिफॉल्ट्स एक बार कम्प्यूट कर के बार-बार उपयोग किए जा सकते हैं।

सावधानी का टिप: पठनीयता रखें

कम्पाइल-टाइम लॉजिक शक्तिशाली है, पर यह फिर भी ऐसा कोड है जिसे किसी को समझना होगा। छोटे, अच्छे नाम वाले हेल्पर्स पसंद करें; टिप्पणी में बताएं कि "क्यों अब" (कम्पाइल टाइम) बनाम "क्यों बाद में" (रनटाइम)। और कम्पाइल-टाइम हेल्पर्स को उसी तरह टेस्ट करें जैसे आप सामान्य फ़ंक्शन्स की टेस्टिंग करते हैं—ताकि ऑप्टिमाइज़ेशन बिल्ड-समस्या में बदल न जाएं।

मैक्रो और मेटाप्रोग्रामिंग बिना पठनीयता खोएं

Nim के मैक्रो कम्पाइलेशन के दौरान "कोड जो कोड लिखता है" के रूप में काम करते हैं। रनटाइम पर रिफ्लेक्टिव लॉजिक चलाने और हर बार उसके लिए भुगतान करने की बजाय, आप विशेषीकृत, टाइप-अवेयर Nim कोड एक बार जेनरेट कर सकते हैं और फिर तेज़ बाइनरी शिप कर सकते हैं।

बायलरप्लेट हटाना (और रनटाइम चेक्स हटाना)

एक सामान्य उपयोग रिपीटेटिव पैटर्न को बदलना है जो अन्यथा कोडबेस बढ़ा देता या प्रति-कॉल ओवरहेड जोड़ता। उदाहरण के लिए आप:

- किसी टाइप के लिए सीरियलाइज़/डिसिरियलाइज़ फ़ंक्शन जेनरेट कर सकते हैं

- संक्षिप्त स्कीमा के आधार पर इनपुट वेलिडेशन कोड बना सकते हैं

- ऑप्टिमाइज़्ड डिस्पैच को रनटाइम लुकअप टेबल के बिना उत्पन्न कर सकते हैं

क्योंकि मैक्रो सामान्य Nim कोड में विस्तृत होता है, कंपाइलर अभी भी इनलाइन, ऑप्टिमाइज़ और डेड ब्रांचेज़ हटाने में सक्षम रहता है—इसलिए "एबस्ट्रक्शन" अक्सर अंतिम executable में गायब हो जाती है।

डोमेन-विशिष्ट सिंटैक्स (बिना कस्टम कंपाइलर के)

मैक्रो हल्के-फुल्के डोमेन-विशिष्ट सिंटैक्स की अनुमति देते हैं। टीमें इसे स्पष्ट इरादा व्यक्त करने के लिए उपयोग करती हैं:

- तेज़ पार्सर्स: डिक्लेरेटिव ग्रामर-नुमा विवरण लिखें, मैक्रो कठोर पार्सिंग कोड निकाल दे

- सीरियलाइज़र्स: फील्ड टैग/फॉर्मैट नियम निर्दिष्ट करें, पैक/अनपैक कोड जेनरेट करें

- राउटिंग, SQL-बिल्डिंग, या कॉन्फ़िग मैपिंग के लिए मिनी-DSLs

अच्छा किया गया, कॉल साइट Python जैसा साफ़ और डायरेक्ट पढ़ेगा, जबकि यह कुशल लूप्स और पॉइंटर-सेफ ऑपरेशंस में संकलित होगा।

मैक्रो को मेंटेनेबल रखना

मेटाप्रोग्रामिंग गड़बड़ तब बन सकती है जब यह आपके प्रोजेक्ट के अंदर एक छिपी प्रोग्रामिंग भाषा बन जाए। कुछ गाइडरैल्स मदद करते हैं:

- जो कोड मैक्रो जनरेट करता है उसे डॉक्यूमेंट करें और एक छोटा उदाहरण दिखाएँ

- मैक्रो को संकुचित रखें: एक स्पष्ट समस्या हल करें

- जहाँ काम दे तो सामान्य जनरिक्स/टेम्पलेट्स का प्रयोग करें; AST-स्तर परिवर्तन तभी करें जब ज़रूरी हो

मेमोरी मैनेजमेंट: ARC/ORC और पूर्वानुमेय प्रदर्शन

प्रोफाइलिंग दिखाएँ

समय के साथ प्रदर्शन परिवर्तनों को ट्रैक करने के लिए एक आंतरिक बेंचमार्क रनर UI बनाएं।

Nim का डिफ़ॉल्ट मेमोरी मैनेजमेंट एक बड़ा कारण है कि यह “Python-जैसा” महसूस कर सकता है जबकि सिस्टम-लेवल बिहेवियर रखता है। क्लासिक ट्रेसिंग गार्बेज कलेक्टर की बजाय Nim आमतौर पर ARC या ORC उपयोग करता है।

ARC/ORC बनाम ट्रेसिंग GC (उच्च स्तर)

एक ट्रेसिंग GC बर्स्ट में काम करती है: यह सामान्य काम को रोकर ऑब्जेक्ट्स के माध्यम से चलती है और तय करती है क्या फ्री करना है। यह मॉडल डेवलपर एर्गोनॉमिक्स के लिए अच्छा हो सकता है, पर पॉज़ भविष्यवाणी करना कठिन कर सकती हैं।

ARC/ORC के साथ, अधिकांश मेमोरी उस समय मुक्त हो जाती है जब आखिरी रेफ़रेंस चला जाता है। व्यवहार में यह अधिक सुसंगत लेटेंसी और संसाधन रिलीज़ के समय को समझना आसान बनाता है (मेमोरी, फ़ाइल हैंडल, सॉकेट)।

क्यों पूर्वानुमेयता प्रदर्शन में मदद करती है

पूर्वानुमेय मेमोरी व्यवहार “अचानक” धीमे होने को कम करता है। यदि आवंटन और फ्री स्थानीय और लगातार होते हैं—बजाय कभी-कभार वैश्विक क्लीनअप साइकिल के—तो आपके प्रोग्राम का समय नियंत्रित करना आसान होता है। यह गेम्स, सर्वर्स, CLI टूल्स और किसी भी चीज़ के लिए महत्वपूर्ण है जिसे जवाबदेह रहना है।

यह कंपाइलर को भी ऑप्टिमाइज़ करने में मदद करता है: जब लाइफटाइम स्पष्ट होते हैं, तो कंपाइलर कभी-कभी डेटा को रजिस्टर या स्टैक में रख सकता है और अतिरिक्त पुस्त-खातों से बच सकता है।

स्टैक बनाम हीप, लाइफटाइम्स, और कॉपीिंग बनाम मूविंग

सरलीकरण के रूप में:

- स्टैक वैल्यूज़ अल्पकालिक और बनाने में सस्ते होते हैं; वे स्कोप खत्म होते ही गायब हो जाते हैं।

- हीप वैल्यूज़ लंबे समय तक रहती हैं और स्कोप्स के पार साझा हो सकती हैं, पर उनका अलोकेशन महँगा होता है।

Nim आपको उच्च-स्तरीय कोड लिखने देते हुए लाइफटाइम का ध्यान रखने की स्वतंत्रता देते हैं। ध्यान दें कि क्या आप बड़े स्ट्रक्चर्स कॉपी कर रहे हैं (डेटा डुप्लिकेट) या उन्हें मूव कर रहे हैं (बिना डुप्लिकेट किए स्वामित्व हस्तांतरित)। टाइट लूप्स में अकस्मात कॉपियों से बचें।

अनावश्यक आवंटनों से बचने के व्यावहारिक सुझाव

अगर आप “C-जैसी गति” चाहते हैं, तो सबसे तेज़ आवंटन वह है जो आप नहीं करते:

- बफ़र्स (स्ट्रिंग्स, सीक्वेंसेज़, IO) को री-यूज़ करें बजाय उन्हें बार-बार फिर से बनाने के

- हॉट पाथ्स में in-place अपडेट्स पसंद करें

- जब संभव हो तो प्रीएलोकेट क्षमता के साथ डेटा बनाएं

ये आदतें ARC/ORC के साथ अच्छी तरह मेल खाती हैं: कम हीप ऑब्जेक्ट्स का मतलब कम रेफ़रेंस-काउंट ट्रैफ़िक और अपने असली काम पर अधिक समय।

डेटा संरचनाएँ और लेआउट: सादगी से गति प्राप्त करना

Nim उच्च-स्तरीय महसूस कर सकता है, पर इसका प्रदर्शन अक्सर निम्न-स्तरीय विवरण पर निर्भर करता है: क्या अलोकेट होता है, कहाँ रहता है, और मेमोरी में उसकी लेआउट कैसी है। सही आकृतियों का चुनाव करने पर आपको बिना पठनीयता खोए गति मुफ्त में मिल सकती है।

वैल्यू टाइप्स बनाम ref: कहाँ अलोकेशन होती है

अधिकांश Nim प्रकार डिफ़ॉल्ट रूप से वैल्यू टाइप्स होते हैं: int, float, bool, enum, और साधारण object वैल्यूज़। वैल्यू टाइप्स सामान्यतः इनलाइन रहते हैं (अक्सर स्टैक पर या अन्य संरचनाओं में एम्बेड), जो मेमोरी एक्सेस को तंग और पूर्वानुमेय बनाता है।

जब आप ref का उपयोग करते हैं (उदाहरण: ref object), तो आप एक अतिरिक्त इंडाइरेक्शन माँगते हैं: वैल्यू आमतौर पर हीप पर रहती है और आप उसके एक पॉइंटर को हैंडल करते हैं। यह साझा, लंबे समय तक रहने वाले या वैकल्पिक डेटा के लिए उपयोगी हो सकता है, पर हॉट लूप्स में CPU को पॉइंटर फॉलो करना पड़ता है जिससे ओवरहेड बढ़ सकता है।

नियम: प्रदर्शन-संवेदी डेटा के लिए साधारण object वैल्यूज़ प्राथमिक रखें; जब आपको वाकई रेफ़रेंस सेमॉन्टिक्स चाहिए तभी ref का प्रयोग करें।

seq और string: सुविधाजनक, पर लागत जानें

seq[T] और string डायनामिक, रिसाइज़ेबल कंटेनर्स हैं। वे रोज़मर्रा के प्रोग्रामिंग के लिए बढ़िया हैं, पर बढ़ने पर वे अलोकेट/रीअलोकेट कर सकते हैं। लागत पैटर्न पर ध्यान दें:

- अपेंड करते समय कभी-कभी रीसाइज़ ट्रिगर हो सकता है (मौजूदा एलिमेंट्स की कॉपी)

- कई छोटे

seqs या स्ट्रिंग्स कई अलग-अलग हीप ब्लॉक्स बना सकते हैं

यदि आपको आकार पहले से पता है तो प्री-आकार दें (newSeq, setLen) और चर्न घटाने के लिए बफ़र री-यूज़ करें।

लेआउट क्यों मायने रखता है: एक सरल CPU कैश मानसिक मॉडल

CPU तब सबसे तेज़ होता है जब वह सतत मेमोरी पढ़ सकता है। एक seq[MyObj] जहाँ MyObj एक साधारण वैल्यू ऑब्जेक्ट है आमतौर पर कैश-फ्रेंडली होता है: एलिमेंट्स एक दूसरे के बगल में बैठते हैं।

पर एक seq[ref MyObj] पॉइंटर्स की सूची है जो हीप पर बिखरे होते हैं; इसे iterate करना मेमोरी में कूदने का कारण बनता है, जो धीमा होता है।

हॉट पाथ्स के लिए व्यावहारिक सलाह

कठोर लूप्स और प्रदर्शन-संवेदी कोड के लिए:

- निश्चित आकार के लिए

array या वैल्यू ऑब्जेक्ट्स वाले seq को प्राथमिक रखें

- बार-बार उपयोग होने वाले फ़ील्ड्स को एक ही

object में पास रखो

- अनावश्यक “पॉइंटर चेन” (

ref के अंदर ref) से बचें, जब तक कि जरूरी न हो

ये चुनाव डेटा को कॉम्पैक्ट और स्थानीय रखते हैं—ठीक वही जो आधुनिक CPU पसंद करते हैं।

ऐसे एब्स्ट्रैक्शन जो कम्पाइल होकर गायब हो जाते हैं

विचार से स्कैफोल्ड तक

चैट में वर्कफ़्लो बताएं और एक काम करने वाला वेब, सर्वर या मोबाइल स्कैफोल्ड पाएं।

एक कारण कि Nim उच्च-स्तरीय महसूस कर सकता है बिना बड़े रनटाइम टैक्स के वह यह है कि कई भाषा फीचर ऐसे डिज़ाइन किए गए हैं कि वे सीधा मशीन कोड में बदले जाएँ। आप अभिव्यंजक कोड लिखते हैं; कंपाइलर उसे तंग लूप्स और डाइरेक्ट कॉल्स में लोअर कर देता है।

Nim में “ज़ीरो-कॉस्ट एब्स्ट्रैक्शन” का क्या अर्थ है

ज़ीरो-कॉस्ट एब्स्ट्रैक्शन वह फीचर है जो कोड पढ़ना या reuse करना आसान बनाती है, पर रनटाइम पर हाथ से लिखे निचले-स्तर वाले संस्करण की तुलना में अतिरिक्त काम नहीं जोड़ती।

एक सहज उदाहरण: इटरेटर-शैली API का उपयोग करके मान फ़िल्टर करना, जबकि अंतिम बाइनरी में एक साधारण लूप मिलना।

proc sumPositives(a: openArray[int]): int =

for x in a:

if x > 0:

result += x

यद्यपि openArray फ्लेक्सिबल और “उच्च-स्तरीय” दिखता है, यह आमतौर पर मेमोरी पर एक बुनियादी इंडेक्स्ड वॉक में कंपाइल होता है (कोई Python-शैली ऑब्जेक्ट ओवरहेड नहीं)। API सुखद है, पर उत्पन्न कोड स्पष्ट C लूप के करीब होता है।

इनलाइनिंग, जनरिक्स, और स्पेशलाइज़ेशन (साधारण-भाषा)

Nim छोटे प्रोसिज़र को जरूरी होने पर इनलाइन करता है, मतलब कॉल गायब हो सकती है और उसकी बॉडी कॉलर में चिपक सकती है।

जनरिक्स के साथ आप एक फ़ंक्शन लिखते हैं जो कई प्रकारों के लिए काम करता है। कंपाइलर फिर इसे स्पेशलाइज़ करता है: यह प्रत्येक ठोस प्रकार के लिए उपयुक्त संस्करण बनाता है। इससे अक्सर हाथ से लिखे टाइप-विशिष्ट फ़ंक्शन्स जितना कुशल कोड मिलता है—बिना लॉजिक दोहराए।

"अच्छी APIs" जो फिर भी तंग लूप बनती हैं

mapIt, filterIt-शैली उपयोगिताएँ, distinct प्रकार, और रेंज चेक जैसे पैटर्न ऑप्टिमाइज़ हो सकते हैं जब कंपाइलर उन पर से देख सके। अंतिम नतीजा एकल लूप हो सकता है जिसमें न्यूनतम ब्रांचिंग हो।

एक बड़ा चेतावनी: ऐसे एब्स्ट्रैक्शन जो अलोकेशन मजबूर करते हैं

एब्स्ट्रैक्शन्स “मुफ्त” नहीं रहते जब वे हीप अलोकेशन्स या छिपी कॉपीिंग बनाते हैं। बार-बार नई sequences लौटाना, आंतरिक लूप्स में अस्थायी स्ट्रिंग्स बनाना, या बड़े क्लोज़र्स कैप्चर करना ओवरहेड पैदा कर सकता है।

नियम: यदि कोई एब्स्ट्रैक्शन प्रति-इटरेशन अलोकेट करता है, तो वह रनटाइम पर हावी हो सकता है। स्टैक-फ्रेंडली डेटा पसंद करें, बफ़र री-यूज़ करें, और उन APIs पर नज़र रखें जो हॉट पाथ में निहित अस्थायी seq/string बनाते हैं।

C के साथ इंटरऑपरेबिलिटी: गति और इकोसिस्टम का पुन:उपयोग

एक व्यावहारिक कारण कि Nim उच्च-स्तरीय महसूस कर सकता है जबकि तेज़ भी रहता है वह यह है कि यह सीधे C को कॉल कर सकता है। सिद्ध C लाइब्रेरी को Nim में फिर से लिखने के बजाय आप उसके हेडर डेफिनिशन्स आयात कर सकते हैं, कंपाइल्ड लाइब्रेरी लिंक कर सकते हैं, और फ़ंक्शन्स को लगभग नेटिव Nim प्रोसिज़र की तरह कॉल कर सकते हैं।

Nim का C FFI (उच्च स्तर)

Nim का FFI उन C फ़ंक्शन्स और प्रकारों का वर्णन करने पर आधारित है जिन्हें आप उपयोग करना चाहते हैं। कई मामलों में आप या तो:

- Nim में C सिम्बल्स

importc के साथ घोषित करते हैं (ठीक C नाम दिखाते हुए), या

- C हेडर्स से Nim डिक्लेरेशन्स जनरेट करने के लिए सहायक टूलिंग का उपयोग करते हैं।

उसके बाद, Nim कंपाइलर सब कुछ एक ही नेटिव बाइनरी में लिंक करता है, इसलिए कॉल ओवरहेड न्यूनतम होता है।

क्यों यह मायने रखता है: बिना री-राइट किए पुन:उपयोग

यह आपको परिपक्व इकोसिस्टम तक तुरंत पहुंच देता है: compression (zlib), क्रिप्टो प्रिमिटिव्स, इमेज/ऑडियो कोडेक्स, डेटाबेस क्लाइंट्स, OS APIs, और प्रदर्शन-संवेदी यूटिलिटीज़। आप Nim की पठनीय, Python-जैसी संरचना को एप्लिकेशन लॉजिक के लिए रख सकते हैं और भारी काम के लिए सिद्ध C पर भरोसा कर सकते हैं।

सावधानियाँ: ओनरशिप और कन्वर्ज़न

FFI बग आमतौर पर गलत अपेक्षाओं से आते हैं:

- ओनरशिप नियम: किसने अलोकेट किया और किसे फ्री करना है? यदि C फ़ंक्शन पॉइंटर लौटाता है जिसे आपको फ्री करना है, तो Nim में उसके लिए स्पष्ट फ्री पाथ चाहिए। यदि C ने आपके पास भेजी मेमोरी का पॉइंटर रखा है, तो आपको यह सुनिश्चित करना होगा कि मेमोरी जीवित रहे।

- स्ट्रिंग्स और बफ़र्स: Nim strings C strings नहीं होते।

cstring में कन्वर्ट करना आसान है, पर नल-टर्मिनेशन और लाइफटाइम सुनिश्चित करना आप पर निर्भर है। बाइनरी डेटा के लिए स्पष्ट ptr uint8/लंबाई पेयर्स पसंद करें।

C APIs को सुरक्षित रूप से रैप करें (और टेस्टेबल बनाएं)

एक अच्छा पैटर्न छोटा Nim रैपर लिखना है जो:

- आइडियोमैटिक Nim प्रोसिज़र और प्रकार एक्सपोज़ करे,

- कन्वर्ज़न और एरर-हैंडलिंग केंद्रीकृत करे,

- जहाँ उपयुक्त हो कच्चे पॉइंटर्स को RAII-लाइक हेल्पर्स (

defer, डेस्ट्रक्टर) के पीछे छिपाए।

यह यूनिट टेस्टिंग आसान बनाता है और निम्न-स्तरीय विवरणों के लीक होने के चांस घटाता है।

प्रदर्शन टूलकिट: बिल्ड मोड्स, फ्लैग्स, और प्रोफ़ाइलिंग

Nim पहले से ही तेज़ महसूस कर सकता है, पर आख़िरी 20–50% अक्सर इस पर निर्भर करता है कि आप कैसे बिल्ड करते हैं और कैसे मापते हैं। अच्छी खबर: Nim का कंपाइलर प्रदर्शन नियंत्रण ऐसे तरीके से एक्सपोज़ करता है जो सिस्टम विशेषज्ञ न होने पर भी सुलभ है।

मायने रखने वाले बिल्ड मोड्स

असली प्रदर्शन नंबरों के लिए डिबग बिल्ड्स से दूरी बनाएँ। प्रदर्शन माप के लिए रिलीज़ बिल्ड से शुरू करें और केवल बग खोजते समय अतिरिक्त चेक जोड़ें।

nim c -d:release --opt:speed myapp.nim

nim c -d:danger --opt:speed myapp.nim

nim c -d:release --opt:speed --passC:-march=native myapp.nim

एक सरल नियम: बेंचमार्क और प्रोडक्शन के लिए -d:release का प्रयोग करें, और -d:danger का प्रयोग केवल तब करें जब आपने परीक्षण के साथ भरोसा बना लिया हो।

प्रोफ़ाइलिंग वर्कफ़्लो: पहले मापें, फिर अनुकूलित करें

एक व्यावहारिक फ्लो इस तरह दिखता है:

- पहले एन्ड-टू-एन्ड मापें (वॉल-क्लॉक टाइम, मेमोरी, थ्रूपुट)।

hyperfine या साधारण time अक्सर पर्याप्त होते हैं।

- फिर हॉटस्पॉट खोजیں। Nim बिल्ट-इन प्रोफ़ाइलिंग (

--profiler:on) समर्थन करता है और मौजूदा प्रोफ़ाइलर्स (Linux perf, macOS Instruments, Windows टूलिंग) के साथ भी अच्छा खेलता है क्योंकि आप नेटिव बाइनरी बना रहे हैं।

- सबसे गर्म 1–2 फ़ंक्शन्स अनुकूलित करें, फिर फिर से मापें। यदि हॉटस्पॉट बदलता है तो यह प्रगति है।

बाहरी प्रोफ़ाइलर्स का उपयोग करते समय पठनीय स्टैक ट्रेस और सिम्बल्स के लिए डिबग इन्फो के साथ कंपाइल करें:

nim c -d:release --opt:speed --debuginfo myapp.nim

छोटे-छोटे ऑप्टिमाइज़ेशन जिन्हें टालें

छोटी-छोटी चीज़ों (मैन्युअल लूप अनरोलिंग, अभिव्यक्ति पुनर्विन्यास, “चतुर” ट्रिक्स) को डेटा के बिना बदलने का प्रलोभन होता है। Nim में बड़े फायदे आमतौर पर इनसे आते हैं:

- बेहतर एल्गोरिद्म चुनना,

- आवंटन और कॉपीइंग को घटाना,

- डेटा लेआउट में सुधार (जब संभव हो लगातार सीक्वेंसेज़ का उपयोग),

- महत्वपूर्ण लूप्स में ओवरहेड कम करना।

CI-फ्रेंडली बेंचमार्क और रिग्रेशन चेक

प्रदर्शन रिग्रेशन उस समय पकड़ना आसान होता है जब वे जल्दी पकड़े जाएं। एक हल्का दृष्टिकोण एक छोटा बेंचमार्क सूट जोड़ना है (अक्सर Nimble टास्क जैसे nimble bench) और इसे CI पर स्थिर रनर पर चलाना। बेसलाइन्स स्टोर करें (यहाँ तक कि साधारण JSON आउटपुट के रूप में) और महत्वपूर्ण मीट्रिक्स अनुमत सीमा से अधिक विचलन पर बिल्ड फेल करें। इससे "आज तेज़" का मतलब "अगले महीने धीमा" नहीं बनता।

जहाँ Nim चमकता है (और जहाँ यह शायद उपयुक्त न हो)

एक त्वरित पायलट चलाएँ

बड़े प्रोजेक्ट पर भरोसा करने से पहले एक छोटे Nim-संबंधित प्रोजेक्ट पर Koder.ai को टेस्ट करें।

Nim उस समय अच्छा मेल खाता है जब आप ऐसा कोड चाहते हैं जो उच्च-स्तरीय भाषा जैसा पढ़े पर एक तेज़, सिंगल executable के रूप में शिप हो। यह उन टीमों को इनाम देता है जो प्रदर्शन, डिप्लॉयमेंट सादगी, और डिपेंडेंसीज़ को नियंत्रित रखने पर ध्यान देती हैं।

बढ़िया फ़िट्स

कई टीमों के लिए Nim “प्रोडक्ट-नुमा” सॉफ़्टवेयर में खूब चमकता है—ऐसी चीज़ें जिन्हें आप कंपाइल, टेस्ट, और वितरित करते हैं।

- CLIs और डेवलपर टूल्स: एक नेटिव बाइनरी शिप करें, तेज़ स्टार्टअप रखें, ओवरहेड कम रखें।

- नेटवर्किंग टूल्स और सर्विसेज: अच्छा थ्रूपुट और पूर्वानुमेय लेटेंसी, साथ ही पठनीय कोड।

- गेम टूलिंग और पाइपलाइंस: असेट कनवर्टर्स, बिल्ड टूल्स, एडिटर्स—जहाँ गति चाहिए पर C/C++ जटिलता नहीं चाहिए।

सावधानी बरतने वाले मामले

Nim कम उपयुक्त हो सकता है जब आपकी सफलता रनटाइम डायनेमिकिटी पर निर्भर हो ना कि कंपाइल्ड प्रदर्शन पर।

- भारी डायनेमिक प्लगइन सिस्टम्स: यदि आप उम्मीद करते हैं कि आप बहुत सारे थर्ड-पार्टी एक्सटेंशन्स रनटाइम पर लोड/अनलोड करेंगे, Nim का कंपाइल्ड मॉडल कुछ घर्षण जोड़ सकता है।

- त्वरित एक-बारगी स्क्रिप्ट्स: अगर आपका वर्कफ़्लो “एडिट, तुरंत रन, फेंक दो” जैसा है, तो छोटे कार्यों के लिए Python (या शैल) तेज़ हो सकता है।

टीम विचार

Nim सुलभ है, पर फिर भी इसकी सीखने की एक घुमावदार सीमा है।

- स्टाइल कन्वेंशंस पर जल्दी सहमति बनाएं (मॉड्यूल लेआउट, एरर हैंडलिंग, नामकरण) ताकि “हर कोई अलग तरह से Nim लिखे” की समस्या न हो।

- ऑनबोर्डिंग की योजना बनाएं: पेयरिंग और एक छोटा आंतरिक गाइड लंबे डॉक्यूमेंट्स से अधिक मददगार होते हैं।

- इकोसिस्टम गैप्स के बारे में वास्तविक रहें: कुछ लाइब्रेरी मौजूद हैं, पर आपको Python की तरह हर चीज़ के लिए पैकेज नहीं मिलेगा।

पायलट प्रोजेक्ट का तरीका

एक छोटा, मापनीय प्रोजेक्ट चुनें—जैसे किसी धीमे CLI स्टेप या नेटवर्क यूटिलिटी का पुनर्लेखन। सफलता मीट्रिक्स परिभाषित करें (रनटाइम, मेमोरी, बिल्ड समय, डिप्लॉय साइज़), एक छोटे आंतरिक दर्शक को शिप करें, और नतीजों के आधार पर निर्णय लें न कि प्रचार के आधार पर।

यदि आपके Nim काम को किसी आसपास के उत्पाद सतह की जरूरत है—एक एडमिन डैशबोर्ड, बेंचमार्क रनर UI, या API गेटवे—Koder.ai जैसी टूल्स आपको वे टुकड़े तेजी से स्कैफोल्ड करने में मदद कर सकती हैं। आप त्वरित-कोड React फ्रंटएंड और Go + PostgreSQL बैकएंड बना सकते हैं, और फिर अपने Nim बाइनरी को HTTP के माध्यम से एक सर्विस के रूप में एकीकृत कर सकते हैं—प्रदर्शन-संवेदी कोर Nim में रखते हुए बाकी तेज़ी से विकसित करें।

एक व्यावहारिक चेकलिस्ट: Python-जैसा कोड C गति पर पाने के लिए

Nim अपनी “Python-जैसी पर तेज़” प्रतिष्ठा इस संयोजन से कमाता है: पठनीय सिंटैक्स, एक ऑप्टिमाइज़िंग नेटिव कंपाइलर, पूर्वानुमेय मेमोरी मैनेजमेंट (ARC/ORC), और डेटा लेआउट व आवंटन पर ध्यान देने की संस्कृति। यदि आप गति लाभ बिना कोडबेस को लो-लेवल स्पेगेटी में बदलने के चाहते हैं, तो इस चेकलिस्ट को एक दोहराने योग्य वर्कफ़्लो के रूप में उपयोग करें।

गति-प्रथम चेकलिस्ट (पठनीयता त्यागे बिना)

- कम्पाइल ऐसे करें जैसे आप गंभीर हैं: वास्तविक माप के लिए रिलीज़ बिल्ड का उपयोग करें।

-d:release और विचार करें --opt:speed का।- जहां उपयुक्त हो लिंक-टाइम ऑप्टिमाइज़ेशन सक्षम करें (

--passC:-flto --passL:-flto)।

- डेटा स्ट्रक्चर्स जानबूझकर चुनें: सरल, contiguous प्रतिनिधित्व प्राथमिक रखें।

seq[T] बढ़िया है, पर टाइट लूप्स अक्सर array, openArray, और फालतू resizing से बचने से लाभान्वित होते हैं।- हॉट डेटा को छोटा और पास रखें; कम प्वाइंटर्स आमतौर पर कम कैश मिस करते हैं।

- अवंटेशनों के प्रति जागरूक रहें: ARC/ORC मदद करता है, पर यह आपके बनाए गए काम को हटा नहीं सकता।

- बफ़र्स री-यूज़ करें,

newSeqOfCap से प्रीएलोकेट करें, और लूप्स में अस्थायी स्ट्रिंग्स बनाने से बचें।

- स्लाइसिंग या कंकैटिनेशन में छिपी कॉपियों पर नज़र रखें।

- एब्स्ट्रैक्शन्स को कम्पाइल होकर गायब होने दें: साफ़ कोड लिखें, फिर सत्यापित करें।

- अभिव्यंजकता के लिए इटरेटर्स/टेम्पलेट्स पसंद करें, पर रिलीज़ बिल्ड्स में सुनिश्चित करें कि वे इनलाइन हो रहे हैं।

- “ऑप्टिमाइज़” करने से पहले मापें: प्रोफ़ाइल कर के असली हॉटस्पॉट खोजें।

- अगर आप प्रोफ़ाइलिंग में नए हैं, तो देखें /blog/performance-profiling-basics।

अगले कदम: अपने मशीन पर साबित करें

- एक छोटा बेंचमार्क आजमाएँ: parsing, filtering, math जैसे वास्तविक काम करने वाली फ़ंक्शन चुनें और डिबग बनाम रिलीज़ बिल्ड की तुलना करें।

- एक वास्तविक फीचर शिप करें: एक छोटा मॉड्यूल end-to-end लागू करें, फिर केवल हॉट पाथ को टाइट करें (पूरा कोडबेस नहीं)।

यदि आप अभी भी भाषाओं के बीच निर्णय कर रहे हैं, तो /blog/nim-vs-python व्यापार-ऑफ को फ्रेम करने में मदद कर सकता है। टूलिंग या समर्थन विकल्पों का मूल्यांकन कर रहे टीमों के लिए, आप /pricing भी देख सकते हैं।