खोसला के कहने का तात्पर्य: “एआई डॉक्टरों की जगह लेगा”\n\nजब विनोद खोसला कहते हैं “एआई डॉक्टरों की जगह लेगा,” तो वे आमतौर पर किसी साइ-फाई अस्पताल की बात नहीं कर रहे जहाँ इंसान बिल्कुल न हों। वे एक अधिक सटीक, संचालन संबंधी दावे के बारे में बोलते हैं: कई ऐसे कार्य जो आज चिकित्सक का समय लेते हैं — खासकर सूचना‑भारी काम — सॉफ़्टवेयर द्वारा किए जा सकते हैं जो तेज़, सस्ता और लगातार बेहतर होता जा रहा है।\n\n### दायरा: कार्यों का प्रतिस्थापन, करुणा का नहीं\n\nखोसला के प्रस्तुतिकरण में “बदलना” अक्सर इसका मतलब होता है दिन‑प्रतिदिन डॉक्टर जो बहुत कुछ करते हैं उसका बड़ा हिस्सा सॉफ़्टवेयर बदल दे—ना कि पूरी पेशा मिटा दे। रूटीन के उन हिस्सों के बारे में सोचें: लक्षण इकट्ठा करना, दिशानिर्देश जांचना, संभावित निदानों को क्रमबद्ध करना, अगले परीक्षण सुझाना, क्रॉनिक कंडीशंस की निगरानी और जोखिम को जल्दी फ़्लैग करना।\n\nइसीलिए विचार ज़्यादा “प्रो‑ऑटोमेशन” जैसा है न कि “एंटी‑डॉक्टर।” मूल दांव यह है कि स्वास्थ्य सेवा पैटर्न से भरी है—और पैटर्न‑रिकग्निशन बड़े पैमाने पर वही जगह है जहाँ एआई अच्छा होता है।\n\n### इस लेख के लिए अपेक्षाएँ निर्धारित करना\n\nयह लेख इस कथन को एक परखने योग्य परिकल्पना के रूप में लेता है, न कि शोर‑शराबा वाली नारा। हम उसके पीछे का तर्क देखेंगे, किन प्रकार के हेल्थकेयर उत्पाद इससे मेल खाते हैं, और वास्तविक बाधाएँ: नियमन, सुरक्षा, दायित्व और चिकित्सा का मानवीय पहलू।\n\n### हम जिन प्रमुख शब्दों का उपयोग करेंगे\n\n- बदलना: एआई एक कार्य को एंड‑टू‑एंड न्यूनतम क्लिनिशियन भागीदारी के साथ करता है।\n- सहायता करना: एआई मदद करता है, पर निर्णय लेने वाला क्लिनिशियन बना रहता है।\n- क्लिनिशियन: एक लाइसेंसधारी पेशेवर (डॉक्टर, नर्स प्रैक्टिशनर, फिज़िशियन असिस्टेंट) जो रोगी देखभाल देता है।\n- निदान: केवल बीमारी का नाम नहीं, बल्कि संभावना‑वज़नी व्याख्या बनाना और अगले कदम (परीक्षण, उपचार, फॉलो‑अप) चुनना।\n\n## विनोद खोसला कौन हैं, और उनकी राय क्यों मायने रखती है\n\n### एक संक्षिप्त तथ्यात्मक पृष्ठभूमि\n\nविनोद खोसला सिलिकॉन वैली के उद्यमी और निवेशक हैं, जिन्हें 1980s में Sun Microsystems के सह‑संस्थापक के रूप में और बाद में वेंचर कैपिटल में उनके लंबे करियर के लिए जाना जाता है। Kleiner Perkins में समय बिताने के बाद उन्होंने 2004 में Khosla Ventures की स्थापना की।\n\nऑपरेटर अनुभव और दशकों के निवेश का यह मिश्रण समझाने में मदद करता है कि उनके AI‑और‑हेल्थकेयर के बारे में दावे टेक सर्किल से परे क्यों दोहराए जाते हैं।\n\n### Khosla Ventures की “स्टाइल” सरल शब्दों में\n\nKhosla Ventures की प्रसिद्धि है कि वे बड़े, उच्च‑विश्वास दांव लगाते हैं जो शुरुआत में अवास्तविक लग सकते हैं। फर्म अक्सर झुकती है:\n\n- विपरीत मत वाले थीसिस की ओर (ऐसे विचार जो कई विशेषज्ञ पहले खारिज कर दें)\n- प्लेटफ़ॉर्म शिफ्ट्स की ओर (तकनीकें जो कई उद्योग बदल दें)\n- लंबी समय‑सीमाएँ (नियमन, अपनाने या इंफ्रास्ट्रक्चर के लिए इंतज़ार करने की इच्छा)\n\nयह इसलिए महत्वपूर्ण है क्योंकि “एआई डॉक्टरों की जगह लेगा” जैसे भविष्यवाणियाँ सिर्फ भाषण नहीं—ये तय करते हैं कि कौन‑सी स्टार्टअप्स को फंड मिलता है, कौन‑से उत्पाद बनते हैं, और बोर्ड/एग्जीक्यूटिव किस उद्देश्य को गंभीरता से लेते हैं।\n\n### हेल्थकेयर AI दांव क्यों बड़ा लक्षय बन गया\n\nहेल्थकेयर अर्थव्यवस्था का एक बड़ा, महँगा हिस्सा है, और यह संकेतों (इमेज, लैब, नोट्स, सेंसर डेटा, आउटकम्स) से भरा हुआ है जिनसे एआई सीख सकता है। सटीकता, गति या लागत में मामूली सुधार भी महत्वपूर्ण बचत और पहुंच के लाभ दे सकते हैं।\n\nखोसला और उनकी फर्म बार‑बार तर्क देती हैं कि मेडिसिन सॉफ़्टवेयर‑ड्रिवन बदलाव के लिए तैयार है—खासकर ट्रायेज, निदान समर्थन और वर्कफ़्लो ऑटोमेशन जैसे क्षेत्रों में। भले ही आप “बदलाव” फ्रेमिंग से सहमत न हों, उनका योगदान इस बात को दर्शाता है कि वेंचर कैपिटल मेडिसिन के भविष्य का कैसे मूल्यांकन करता है—और अगली पूंजी कहाँ जाएगी।\n\n## भविष्यवाणी के पीछे की तर्क‑रचना\n\nखोसला की भविष्यवाणी एक सरल दावे पर टिकी है: मेडिसिन का एक बड़ा हिस्सा—खासकर प्राइमरी केयर और शुरुआती ट्रायेज—अनिश्चितता के तहत पैटर्न‑रिकग्निशन है। अगर निदान और उपचार चयन कई मामलों में “इस प्रस्तुति को सबसे संभावित से मिलाना” है, तो वह सॉफ़्टवेयर जो लाखों उदाहरणों से सीख सकता है, किसी एक क्लिनिशियन से बेहतर प्रदर्शन कर सकता है जो केवल हजारों मामलों से सीखता है।\n\n### स्केल पर पैटर्न रिकग्निशन\n\nमानव पैटर्न पहचान में बेहतर होते हैं, पर हमारी स्मृति, ध्यान और अनुभव सीमित होता है। एक एआई सिस्टम किसी एक डॉक्टर से कहीं अधिक केस, गाइडलाइंस और आउटकम्स निगल सकता है, फिर उस सीखे हुए पैटर्न‑मैचिंग को लगातार लागू कर सकता है। खोसला के फ्रेम में, जब सिस्टम की error‑rate औसत क्लिनिशियन से नीचे गिरती है, तो रोगी और पेयर्स के लिए तार्किक विकल्प रूटीन निर्णय मशीन के माध्यम से भेजना होता है।\n\n### लागत, पहुँच और एकरूपता\n\nआर्थिकता दूसरी मजबूरक शक्ति है। प्राइमरी केयर समय, भौगोलिकता और स्टाफिंग की कमी से बंधी है; विज़िट महँगी, संक्षिप्त और गुणवत्ता में भिन्न हो सकती हैं। एक एआई सेवा 24/7 उपलब्ध हो सकती है, सेवा‑विहीन इलाक़ों तक स्केल कर सकती है, और अधिक एकसमान निर्णय दे सकती है—जिससे “किसको दिखा था” वाला फर्क कम हो सकता है।\n\n### यह व्यवहार्य क्यों हुआ\n\nपहले के एक्सपर्ट सिस्टम हैंड‑कोडेड नियमों और संकीर्ण डाटासेट पर निर्भर थे। व्यवहार्यता तब सुधरी जब मेडिकल डेटा डिजिटाइज़ हुआ (EHRs, इमेजिंग, लैब, वेरेबल्स) और कंप्यूटिंग इतनी सस्ती हुई कि बड़े कॉर्पस पर मॉडल ट्रेन करना और लगातार अपडेट करना संभव हुआ।\n\n### ऑटोमेशन बनाम मानवीय देखभाल\n\nइस लॉजिक के भीतर भी, “बदलाव” की रेखा आम तौर पर रूटीन निदान और प्रोटोकॉल‑नियंत्रित प्रबंधन के आसपास खिंची जाती है—न कि भरोसे, जटिल ट्रेड‑ऑफ और जीवन‑परिवर्तनशील निर्णयों के साथ जुड़ी चिकित्सा के हिस्सों के लिए।\n\n## प्रमुख तर्क और कोट्स (सही संदर्भ के साथ)\n\nखोसला की “एआई डॉक्टरों की जगह लेगा” लाइन आमतौर पर एक उत्तेजक भविष्यवाणी के रूप में दी जाती है, न कि यह वादा कि अस्पतालों में डॉक्टर बिल्कुल ही नहीं होंगे। उनके भाषणों और इंटरव्यू में बार‑बार विषय यही होता है कि चिकित्सा का बहुत सारा काम—खासकर निदान और रूटीन उपचार निर्णय—ऐसे पैटर्न का पालन करता है जिसे सॉफ़्टवेयर सीख, माप और सुधार सकता है।\n\n### तर्क 1: पैटर्न पहचान मानवीय प्रशिक्षण से तेज़ी से स्केल करती है\n\nवे अक्सर क्लीनिकल रीजनिंग को लक्षणों, इतिहासों, इमेजेस, लैब्स और आउटकम्स के बीच पैटर्न मैचिंग के रूप में पेश करते हैं। मुख्य दावा यह है कि जब कोई एआई मॉडल एक निश्चित गुणवत्ता‑मानक तक पहुँचता है, तो उसे व्यापक रूप से तैनात किया जा सकता है और लगातार अपडेट किया जा सकता है—जबकि क्लिनिशियन का प्रशिक्षण धीमा, महँगा और क्षेत्रवार अनसमान रहता है।\n\n### तर्क 2: बेहतर औसत प्रदर्शन, कम “बुरे दिन”\n\nउनकी फ़्रेमिंग में एक प्रमुख सूक्ष्मता है—वैरिएबिलिटी: क्लिनिशियन उत्कृष्ट हो सकते हैं पर थकान, कार्यभार या विरले मामलों के कारण असंगत भी हो सकते हैं। एआई, यदि ठीक से परखा, मॉनिटर और रीट्रेन किया जाए, तो स्थिर प्रदर्शन दे सकता है और संभवतः त्रुटि दर घटा सकता है।\n\n### तर्क 3: सेकंड ओपिनियन डिफ़ॉल्ट बन सकता है\n\nएआई को एक निर्णायक “डॉक्टर प्रतिस्थापन” की तरह कल्पना करने के बजाय, उनकी मजबूत व्याख्या यह है: अधिकांश मरीज पहले किसी एआई से परामर्श करेंगे, और मानव क्लिनिशियन जटिल मामलों, एज‑शर्तों और उच्च‑जोखिम निर्णयों के लिए समीक्षा करने वालों के रूप में अधिक कार्य करेंगे।\n\n### महत्वपूर्ण संदर्भ: यह बहस योग्य भविष्यवाणी है, स्थिर तथ्य नहीं\n\nसमर्थक उनके रुख को नाप‑जोख और पहुँच की ओर धकेलने के रूप में देखते हैं। आलोचक कहते हैं कि वास्तविक दुनिया की चिकित्सा में अस्पष्टता, नैतिकता और जवाबदेही शामिल है—और “बदलाव” मॉडल की सटीकता के साथ‑साथ नियमन, वर्कफ़्लो और भरोसे पर भी निर्भर करता है।\n\n## उन हेल्थकेयर दांवों का सार जो इस थिसिस से मेल खाते हैं\n\nखोसला का “एआई डॉक्टरों की जगह लेगा” दावा उन प्रकार की हेल्थकेयर स्टार्टअप्स के साथ सहजता से जुड़ता है जिनमें VCs निवेश करना पसंद करते हैं: कंपनियाँ जो तेज़ी से स्केल कर सकें, गंदे क्लिनिकल काम को स्टैंडर्डाइज़ कर सकें, और विशेषज्ञ निर्णय को सॉफ़्टवेयर में बदल सकें।\n\n### मुख्य निवेश श्रेणियाँ\n\nइस थिसिस से मेल खाने वाले दांव कई दोहराए जाने वाले विषयों में केन्द्रित हैं:\n\n- डायग्नोस्टिक्स और प्रारंभिक पहचान: ऐसे टूल जो नियमित देखभाल से पहले ही बीमारी को पहचान लें, अक्सर लैब, लक्षण, इतिहास और पिछले रिकॉर्ड को एक जोखिम स्कोर में मिलाकर।\n- ट्रायेज और रूटिंग: एआई “फ्रंट डोअर” जो तय करे कि किसे आपातकालीन देखभाल चाहिए, किसे स्वयं‑उपचार संभव है, और किसे किस विशेषज्ञ के पास भेजना चाहिए।\n- इमेजिंग और सिग्नल व्याख्या: रेडियोलॉजी, पैथोलॉजी, डर्मैटोलॉजी फ़ोटो, ECG—वे क्षेत्र जहाँ पैटर्न रिकग्निशन केंद्रीय है और प्रदर्शन आसानी से मापा जा सकता है।\n- वर्कफ़्लो ऑटोमेशन: चार्ट सारांश, डॉक्यूमेंटेशन, प्रायर‑ऑथ सपोर्ट, कोडिंग, और इनबॉक्स प्रबंधन—कम सुर्खियों में आने वाला, पर क्लिनिशियन के समय से सीधे जुड़ा हुआ।\n\n### ये दांव VC के प्रोत्साहनों से कैसे मेल खाते हैं\n\nडॉक्टरों की ज़रूरत को घटाना (या सिकोड़ना) एक बड़ा इनाम है: हेल्थकेयर खर्च विशाल है, और श्रम एक प्रमुख लागत केंद्र है। इसलिए टाइमलाइन को बोल्डली फ्रेम करना आकर्षक है—क्योंकि फंडरेज़िंग एक स्पष्ट, उच्च‑अपसाइड कहानी को इनाम देती है, भले ही क्लिनिकल अपनाना और नियमन सॉफ़्टवेयर से धीमे हों।\n\n### मेडिकल AI में “प्लेटफ़ॉर्म” बनाम “पॉइंट सॉल्यूशन”\n\nएक पॉइंट सॉल्यूशन एक काम बखूबी करता है (उदा., छाती के एक्स‑रे पढ़ना)। एक प्लेटफ़ॉर्म कई वर्कफ़्लोज़ पर बैठने का लक्ष्य रखता है—ट्रायेज, निदान समर्थन, फॉलो‑अप, बिलिंग—साझा डेटा पाइपलाइनों और मॉडलों का उपयोग करते हुए।\n\n“डॉक्टरों को बदलने” वाली कथा प्लेटफ़ॉर्म पर अधिक निर्भर है: यदि एआई केवल एक संकीर्ण काम में जीतता है, डॉक्टर अनुकूलन कर लेते हैं; अगर यह कई कार्यों को एंड‑टू‑एंड समन्वित करता है, तो क्लिनिशियन की भूमिका निरीक्षण, अपवादों और जवाबदेही की ओर बदल सकती है।\n\nस्टार्टर‑फाउंडर्स के लिए जो इन प्लेटफ़ॉर्म विचारों का पता लगा रहे हैं, शुरुआती गति मायने रखती है: अक्सर आपको इंटेक फ्लोज़, क्लिनिशियन डैशबोर्ड और ऑडिट ट्रेल के कामकाजी प्रोटोटाइप चाहिए होते हैं ताकि आप वर्कफ़्लो की परख कर सकें। Koder.ai जैसे टूल्स टीमों को चैट इंटरफ़ेस से आंतरिक वेब ऐप (आम तौर पर React फ्रंटएंड, Go + PostgreSQL बैकएंड) बनाने, सोर्स कोड एक्सपोर्ट करने और जल्दी इटरेट करने में मदद कर सकते हैं। किसी भी चीज़ जो क्लिनिकल निर्णयों को छूती है, उसके लिए उचित मान्यता, सुरक्षा समीक्षा और नियामक रणनीति की ज़रूरत होगी—पर तेज़ प्रोटोटायपिंग रियलिस्टिक पायलट तक रास्ता छोटा कर सकती है।\n\n## वे क्षेत्र जहाँ एआई यथार्थवादी रूप से क्लिनिशियनों से मेल या उनसे बेहतर कर सकता है\n\nएआई पहले से ही कुछ संकुचित क्लिनिकल कार्यों में मनुष्यों से बेहतर है—खासकर जहाँ काम पैटर्न‑रिकग्निशन, गति और एकरूपता पर आधारित है। इसका मतलब यह नहीं कि “एआई डॉक्टर” पूरी तरह से मौजूद है; इसका मतलब है कि एआई देखभाल का एक बहुत मजबूत घटक बन सकता है।\n\n### वे कार्य जिनमें एआई वास्तव में मज़बूत है\n\nएआई उन जगहों पर चमकता है जहाँ बहुत सारा दोहरावदार सूचना और स्पष्ट फ़ीडबैक लूप होता है:\n\n- सारांश: लंबे चार्ट को साफ़ टाइमलाइन में बदलना (दवाएँ, लैब, पिछले निदान), या ट्रांस्क्रिप्ट से विज़िट नोट ड्राफ्ट करना।\n- ट्रायेज: उच्च‑वॉल्यूम सेटिंग्स में लक्षण और जोखिम फैक्टर को प्राथमिकता बाल्टियों में बांटना (सेल्फ‑केयर बनाम उसी‑दिन विज़िट बनाम ER)।\n- पैटर्न डिटेक्शन: इमेजेस और वेवफॉर्म में सूक्ष्म संकेत पकड़ना (रेडियोलॉजी, डर्मैटोलॉजी, ECG), और लैब ट्रेंड्स के संयोजनों को नोटिस करना जो थके या व्यस्त इंसान मिस कर देता है।\n\nइन क्षेत्रों में “बेहतर” का मतलब अक्सर कम मिस्ड फाइंडिंग, अधिक स्टैन्डर्ड निर्णय और तेज़ टर्नअराउंड है।\n\n### क्लिनिकल डिसीजन सपोर्ट बनाम स्वायत्त निदान\n\nआज के वास्तविक‑दुनिया के जीतें ज़्यादातर क्लिनिकल डिसीजन सपोर्ट (CDS) से आती हैं: एआई संभावित स्थितियाँ सुझाता है, खतरनाक विकल्प फ़्लैग करता है, अगले परीक्षण सुझाता है, या गाइडलाइन अनुपालन चेक करता है—जबकि क्लिनिशियन जिम्मेदारी बना रहता है।\n\nस्वायत्त निदान (एआई अंत‑से‑अंत फैसला करता है) सीमित, अच्छी तरह परिभाषित संदर्भों में व्यवहार्य है—जैसे स्क्रीनिंग वर्कफ़्लो जिनमें कड़े प्रोटोकॉल हैं—पर यह जटिल, बहु‑रोगी मरीजों के लिए सामान्य नहीं है।\n\n### पकड़: डेटा गुणवत्ता और प्रतिनिधित्व

\nएआई की सटीकता बहुत हद तक प्रशिक्षण डेटा पर निर्भर करती है जो मरीजों की जनसंख्या और केयर सेटिंग से मेल खाए। मॉडल तब डिफ्ट कर सकते हैं जब:\n\n- अस्पताल अलग उपकरण या डॉक्यूमेंटेशन शैलियाँ इस्तेमाल करे,\n- मरीजों का मिश्रण अलग हो (आयु, जातीयता, सह‑रोग), या\n- “ग्राउंड‑ट्रुथ” लेबल असंगत हों।\n\n### क्यों मानवीय निरीक्षण अभी भी ज़रूरी है\n\nउच्च‑जोखिम सेटिंग्स में निरीक्षण वैकल्पिक नहीं है—यह एज‑केस, असामान्य प्रेजेंटेशन और वैल्यू‑आधारित निर्णय (मरीज क्या करना, सहन करना या प्राथमिकता दे रहा है) के लिए सुरक्षा परत है। एआई देखना बहुत अच्छा कर सकता है, पर क्लिनिशियन को तय करना होता है कि आज यह व्यक्ति के लिए क्या मायने रखता है।\n\n## वे क्षेत्र जहाँ एआई अभी भी कमजोर है\n\nएआई पैटर्न‑मैचिंग, रिकॉर्ड सारांश और संभावित निदानों का सुझाव देने में प्रभावशाली हो सकता है। पर मेडिसिन केवल भविष्यवाणी का काम नहीं है। सबसे कठिन हिस्से तब आते हैं जब “सही” उत्तर अस्पष्ट हो, मरीज के लक्ष्य दिशानिर्देशों से टकराते हों, या केयर सिस्टम जटिल हो।\n\n### भरोसा, बिस्तर‑पर व्यवहार और साझा निर्णय

\nलोग केवल परिणाम नहीं चाहते—वे सुने जाना, विश्वास किया जाना और सुरक्षित महसूस करना चाहते हैं। एक क्लिनिशियन डर, शर्म, भ्रम या घरेलू जोखिम नोट कर सकता है और फिर बातचीत व योजना उसी के अनुसार समायोजित कर सकता है। साझा निर्णय‑प्रक्रिया में साइड‑इफेक्ट्स, लागत, जीवनशैली और पारिवारिक समर्थन जैसे ट्रेड‑ऑफ पर बातचीत शामिल होती है जो समय के साथ भरोसा बनाती है।\n\n### अस्पष्टता, मल्टी‑मॉर्बिडिटी और दुर्लभ मामले

\nवास्तविक मरीज अक्सर कई स्थितियों के साथ आते हैं, अधूरा इतिहास रखते हैं, और ऐसे लक्षण दिखाते हैं जो साफ़ टेम्पलेट में नहीं बैठते। दुर्लभ बीमारियाँ और अस्पष्ट प्रेजेंटेशन आम समस्याओं जैसा दिख सकते हैं—जब तक कि वे न हों। एआई सम्भवतः आशाजनक सुझाव देगा, पर “आशाजनक” का अर्थ नैदानिक रूप से सिद्ध नहीं होता, खासकर जब सूक्ष्म संदर्भ महत्वपूर्ण हो (हाल का यात्रा इतिहास, नई दवाएँ, सामाजिक कारक, “कुछ अजीब लग रहा है”)।\n\n### जब एआई गलत हो: जवाबदेही का सवाल

\nएक अत्यंत सटीक मॉडल भी कभी‑कभी फेल करेगा। कठिन सवाल यह है कि जिम्मेदारी किसकी होगी: वह क्लिनिशियन जिसने टूल का पालन किया, अस्पताल जिसने इसे तैनात किया, या वह विक्रेता जिसने इसे बनाया? स्पष्ट जवाबदेही यह तय करती है कि टीमों को कितना सावधान होना चाहिए—और मरीज कहां सहारा माँग सकते हैं।\n\n### संचालन‑वास्तविकता: क्लिनिक्स और EHRs में फिट होना

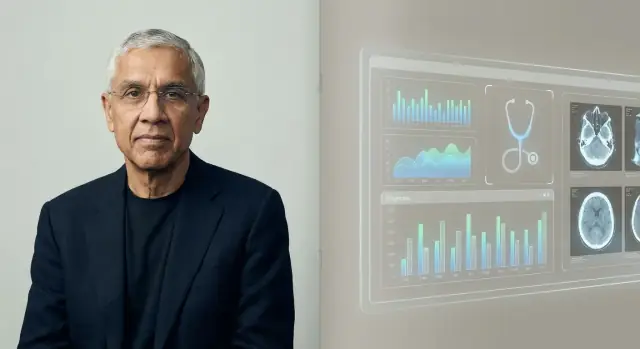

\nदेखभाल वर्कफ़्लो के भीतर होती है। अगर कोई एआई टूल EHRs, ऑर्डरिंग सिस्टम, डॉक्यूमेंटेशन और बिलिंग के साथ साफ़ तरीके से एकीकृत नहीं होता—या अगर वह अतिरिक्त क्लिक और अनिश्चितता जोड़ता है—तो व्यस्त टीमें उस पर भरोसा नहीं करेंगी, चाहे वह डेमो में कितना भी अच्छा दिखे।\n\n## मेडिकल एआई में नियमन, नैतिकता और सुरक्षा\n\nमेडिकल एआई सिर्फ इंजीनियरिंग प्रॉब्लम नहीं है—यह सुरक्षा का मुद्दा है। जब सॉफ़्टवेयर निदान या उपचार को प्रभावित करता है, तो नियमदाता इसे सामान्य ऐप जैसा नहीं देखते, बल्कि मेडिकल डिवाइस जैसा मानते हैं।\n\n### FDA और CE ओवरसाइट: मूल बातें\n\nयू.एस. में FDA कई “Software as a Medical Device” टूल्स को नियंत्रित करता है, खासकर वे जो निदान करते हैं, उपचार सिफारिश करते हैं, या सीधे केयर निर्णयों को प्रभावित करते हैं। EU में CE मार्किंग (MDR के तहत) समान भूमिका निभाती है।\n\nइन फ्रेमवर्क्स में सुरक्षा‑प्रभावशीलता के साक्ष्य, इच्छित उपयोग की स्पष्टता, और तैनाती के बाद निरंतर मॉनिटरिंग की आवश्यकता होती है। नियम मायने रखते हैं क्योंकि डेमो में प्रभावशाली दिखने वाला मॉडल असली क्लिनिक्स में फेल हो सकता है—मरीजों के साथ।\n\n### बायस और असमान प्रदर्शन

\nएक बड़ा नैतिक जोखिम है प्रदर्शन का विभाजन (उदा., उम्र‑समूह, त्वचा‑टोन, भाषाएँ, सह‑रोग)। अगर प्रशिक्षण डेटा कुछ समूहों का पर्याप्त प्रतिनिधित्व नहीं करता तो सिस्टम उन समूहों में निदान मिस कर सकता है या अनावश्यक हस्तक्षेप सुझा सकता है। फेयरनेस‑टेस्टिंग, सब‑ग्रुप रिपोर्टिंग और सावधान डेटा डिज़ाइन अनिवार्य हैं—ये सिर्फ़ ऐड‑ऑन नहीं बल्कि बुनियादी सुरक्षा हैं।\n\n### गोपनीयता, सहमति और रोगी डेटा

\nमॉडल ट्रेन करने और सुधारने के लिए अक्सर बहुत सारा संवेदनशील स्वास्थ्य डेटा चाहिए होता है। इससे सहमति, सेकंडरी उपयोग, डी‑पहचान की सीमाएँ और कौन इसका आर्थिक लाभ उठाता है—जैसे प्रश्न उठते हैं। अच्छी गवर्नेंस में स्पष्ट मरीज नोटिस, कड़ाई से एक्सेस कंट्रोल और डेटा‑रिटेंशन व मॉडल‑अपडेट नीतियाँ शामिल होनी चाहिए।\n\n### “ह्यूमन‑इन‑द‑लूप” सुरक्षा पैटर्न के रूप में

\nकई क्लिनिकल एआई टूल्स को सहायता देने के लिए डिज़ाइन किया जाता है, न कि बदलने के लिए, ताकि अंतिम निर्णय के लिए क्लिनिशियन जिम्मेदार रहे। यह “ह्यूमन‑इन‑द‑लूप” तरीका गलतीयाँ पकड़ सकता है, मॉडल की कमी के संदर्भ पूरा कर सकता है, और जवाबदेही बना सकता है—हालाँकि यह तभी काम करता है जब वर्कफ़्लो और प्रेरणाएँ अंधाधुंध ऑटोमेशन को बढ़ावा न दें।\n\n## डॉक्टरों और हेल्थकेयर नौकरियों के लिए इसका क्या मतलब है\n\nखोसला का दावा अक्सर यह सुनाई देता है कि “डॉक्टर अप्रासंगिक हो जाएंगे।” उपयोगी पढ़ाई यह है कि हम (एआई एक कार्य एंड‑टू‑एंड करता है) को (मानव अभी भी परिणाम के मालिक हैं, पर काम निगरानी, सहानुभूति और समन्वय की ओर शिफ्ट होता है) से अलग करें।\n\n### प्रतिस्थापन बनाम पुन:आवंटन\n\nकई सेटिंग्स में एआई पहले क्लिनिकल काम के टुकड़ों को बदलना शुरू करेगा: नोट ड्राफ्ट करना, संभावित निदान उभारना, गाइडलाइन अनुपालन चेक करना, और मरीज इतिहास का सार देना। क्लिनिशियन का काम उत्तर देने से बदल कर का हो जाएगा।\n\n### किन भूमिकाओं में पहले परिवर्तन आएगा\n\nप्राइमरी केयर में बदलाव महसूस हो सकता है क्योंकि “फ्रंट डोर” ट्रायेज सुधरता है: सिम्पटम‑चेकर्स और एम्बियंट डॉक्यूमेंटेशन रूटीन विज़िट का समय घटाते हैं, जबकि जटिल मामले और रिश्ते‑आधारित देखभाल मानवीय होंगे।\n\nरेडियोलॉजी और पैथोलॉजी में सीधे कार्य प्रतिस्थापन का दबाव ज़्यादा हो सकता है क्योंकि काम डिजिटल और पैटर्न‑आधारित है। इसका मतलब रातों‑रात विशेषज्ञ कम होना नहीं—बल्कि अधिक थ्रूपुट, नए गुणवत्ता‑वर्कफ़्लोज़, और रीइम्बर्समेंट पर दबाव का होना अधिक संभावित है।\n\nनर्सिंग निदान से कम और सतत आकलन, शिक्षा और समन्वय से ज़्यादा जुड़ी है। एआई क्लेरिकल बोझ घटा सकता है, पर बिस्तर‑पर देखभाल और एस्केलेशन निर्णय मानवीय बने रहेंगे।\n\n### नई नौकरियाँ जो उभरेंगी

\nऐसी भूमिकाएँ बढ़ेंगी जैसे (मॉडल प्रदर्शन मॉनिटर करना), (वर्कफ़्लो + डेटा स्टेवार्डशिप), और (मॉडल द्वारा फ़्लैग किए गए गैप्स को बंद करना)। ये भूमिकाएँ मौजूद टीमों के अंदर बैठ सकती हैं बजाय अलग टाइटल्स के।\n\n### प्रशिक्षण और क्रेडेंशलिंग

\nमेडिकल शिक्षा में एआई साक्षरता जोड़ी जा सकती है: आउटपुट्स को कैसे मान्य करें, निर्भरता दस्तावेज़ करें, और फेल्योर‑मोड्स को कैसे पहचानें। क्रेडेंशलिंग “ह्यूमन‑इन‑द‑लूप” मानकों की ओर विकसित हो सकती है—कौन किस टूल का उपयोग कर सकता है, किस निगरानी के तहत, और एआई गलत होने पर जवाबदेही कैसे बांटी जाती है।\n\n## खोसला के विचार का सबसे मजबूत विरोध

\nखोसला का दावा उत्तेजक इसलिए है क्योंकि वह “डॉक्टर” को ज्यादातर निदान इंजन के रूप में लेता है। सबसे मजबूत प्रत्यावर्तन यह कहता है कि भले ही एआई पैटर्न‑रिकग्निशन में क्लिनिशियनों के बराबर हो जाए, डॉक्टरों को बदलना एक अलग काम है।\n\n### चिकित्सा केवल निदान नहीं है

\nक्लिनिकल वैल्यू का एक बड़ा हिस्सा समस्या का फ्रेम तैयार करने में बैठता है, न कि केवल उसका उत्तर बताने में। डॉक्टर गंदे कहानियों को काम करने योग्य विकल्पों में बदलते हैं, जोखिम/लाभ, लागत और रोगी की प्राथमिकताओं पर बातचीत करते हैं, और विशेषज्ञों के बीच समन्वय करते हैं। वे सहमति, अनिश्चितता और "वॉचफुल वेटिंग" को संभालते हैं—ऐसे क्षेत्र जहाँ भरोसा और जवाबदेही सटीकता जितनी ही महत्वपूर्ण है।\n\n### साक्ष्य‑खाई: ट्रायल, परिणाम और सामान्यीकरण

\nकई एआई सिस्टम रेट्रोस्पेक्टिव अध्ययनों में प्रभावशाली दिखते हैं, पर असली दुनिया में परिणाम बेहतर बनाते हैं यह साबित करना कठिन है। सबसे कठिन प्रमाण प्रोस्पेक्टिव है: क्या एआई मिस‑डायग्नोसिस, जटिलताओं या अनावश्यक परीक्षणों को कम करता है विभिन्न अस्पतालों, मरीज समूहों और वर्कफ़्लोज़ में?\n\nसामान्यीकरण एक कमजोर बिंदु है। मॉडल जनसंख्या बदलने पर, उपकरण भिन्न होने पर, या डॉक्यूमेंटेशन आदतें बदलने पर बिगड़ सकते हैं। एक साइट पर अच्छा प्रदर्शन करना दूसरे साइट पर कामयाब होना सुनिश्चित नहीं करता—खासकर दुर्लभ स्थिति के लिए।\n\n### ऑटोमेशन बायस और अतिरोहन

\nमज़बूत टूल भी नए विफलता‑मोड पैदा कर सकते हैं। क्लिनिशियन मॉडल के गलत होने पर उस पर निर्भर हो सकते हैं (ऑटोमेशन बायस) या वह दूसरी जाँच ना करें जो एज‑केस पकड़ती है। समय के साथ, कौशल भी सुस्त हो सकते हैं अगर इंसान केवल “रबर स्टैम्प” बन जाएँ, जिससे एआई अनिश्चित या गलत होने पर हस्तक्षेप करना मुश्किल हो जाएगा।\n\n### टेक काम कर भी रहा हो तो अपनाना धीमा हो सकता है

\nहेल्थकेयर शुद्ध तकनीकी बाज़ार नहीं है। दायित्व, रीइम्बर्समेंट, खरीद‑चक्र, EHR एकीकरण और क्लिनिशियन प्रशिक्षण सभी तैनाती को धीमा करते हैं। मरीज और नियामक भी उच्च‑जोखिम निर्णयों के लिए मानवीय निर्णयकर्ता मांग सकते हैं—जिसका अर्थ है कि “एआई हर जगह” लंबे समय तक “डॉक्टरों द्वारा निगरानी किए गए एआई” जैसा दिख सकता है।\n\n## मरीजों के लिए व्यावहारिक निष्कर्ष\n\nएआई पहले से ही स्वास्थ्य देखभाल में चुपचाप आ रहा है—आपके चार्ट में जोखिम स्कोर, स्कैन्स के स्वचालित रीड्स, सिम्पटम चेकर्स, और प्राथमिकता तय करने वाले टूल के रूप में। मरीजों के लिए लक्ष्य यह नहीं कि “एआई पर विश्वास करें” या “एआई का विरोध करें,” बल्कि यह जानना है कि क्या अपेक्षा रखें और कैसे नियंत्रण बनाए रखें।\n\n### आप क्या उम्मीद कर सकते हैं (अच्छा और कम‑अच्छा)

\nआप अधिक स्क्रीनिंग (संदेश, प्रश्नावली, वेरेबल डेटा) और तेज़ ट्रायेज देखेंगे—खासकर व्यस्त क्लिनिक्स और ER में। इससे सामान्य समस्याओं के लिए तेज़ उत्तर और कुछ स्थितियों के लिए पहले पहचान मिल सकती है।\n\nगुणवत्ता मिक्स्ड होगी। कुछ टूल संकुचित कार्यों में उत्कृष्ट हैं; अन्य आयु‑समूह, त्वचा‑टोन, दुर्लभ बीमारियाँ या गंदे वास्तविक‑दुनिया डेटा में असंगत हो सकते हैं। एआई को मददगार मानें, अंतिम निर्णय नहीं।\n\n### जब एआई शामिल हो तो पूछने वाले प्रश्न

\nअगर एआई आपकी देखभाल को प्रभावित कर रहा है, तो पूछें:\n\n- क्या निदान, इमेजिंग व्याख्या, ट्रायेज या उपचार सिफारिशों में एआई का उपयोग हुआ?\n- उसने कौन‑सा डेटा इस्तेमाल किया (मेरा इतिहास, लैब, इमेजेस, वेरेबल डेटा)?\n- क्या इसे मेरे जैसे मरीजों (आयु, लिंग, जातीयता, स्थितियाँ) पर वैलिडेट किया गया है?\n- अंतिम निर्णय के लिए जिम्मेदार कौन है—मेरा क्लिनिशियन या सॉफ़्टवेयर?\n- क्या मैं सिफारिश के पीछे की सोच या साक्ष्य देख सकता/सकती हूँ?\n\n### एआई आउटपुट को कैसे समझें

\nकई एआई आउटपुट संभावनाएँ देते हैं (“20% जोखिम”)—ये पक्के उत्तर नहीं होते। पूछें कि यह संख्या आपके लिए क्या मायने रखती है: अलग‑अलग जोखिम स्तरों पर क्या होगा, और झूठी चेतावनी दर क्या है।\n\nयदि सिफारिश उच्च‑जोखिम है (सर्जरी, कीमो, दवा बंद करना), तो मानव और/या दूसरे टूल से सेकंड ओपिनियन माँगें। यह पूछना ठीक है: “अगर यह एआई परिणाम न होता तो आप क्या करते?”\n\n### सूचित सहमति और पारदर्शिता

\nजब सॉफ़्टवेयर महत्वपूर्ण रूप से निर्णय आकारता है तो आपको बताया जाना चाहिए। अगर आपको असुविधा हो तो विकल्प, आपका डेटा कैसे संग्रहित है, और क्या ऑप्ट‑आउट करने पर सेवा प्रभावित होगी—इनके बारे में पूछें।\n\n## क्लिनिक्स और स्वास्थ्य टीमों के लिए व्यावहारिक निष्कर्ष\n\nएआई को अपनाना तब आसान होता है जब आप इसे किसी और क्लिनिकल उपकरण की तरह ट्रीट करें: उपयोग‑मामला परिभाषित करें, परखें, मॉनिटर करें, और जवाबदेही स्पष्ट करें।\n\n### जहाँ जोखिम कम और वॉल्यूम अधिक है वहाँ से शुरू करें

\nनिदान के लिए एआई उपयोग से पहले, उसे रोज़मर्रा की घर्षण दूर करने के लिए इस्तेमाल करें। सबसे सुरक्षित शुरुआती जीतें वे वर्कफ़्लोज़ हैं जो थ्रूपुट बढ़ाते हैं बिना चिकित्सीय निर्णय लेने के:

\n- डॉक्यूमेंटेशन समर्थन (विज़िट नोट्स, आफ्टर‑विज़िट समरी)\n- शेड्यूलिंग, रेफ़रल, प्रायर‑ऑथ ड्राफ्टिंग\n- मरीज संदेश ट्रायेज और रूटिंग\n\nये क्षेत्र अक्सर मापने योग्य समय‑बचत देते हैं, और टीमें परिवर्तन प्रबंधन में आत्मविश्वास बना सकती हैं।\n\nअगर आपकी टीम को हल्के‑फुल्के आंतरिक टूल्स चाहिए—इंटेक फॉर्म, रूटिंग डैशबोर्ड, ऑडिट लॉग, स्टाफ‑फेसिंग नॉलेज बेस—तो तेज़ ऐप‑बिल्डिंग मॉडल भी उतनी ही ज़रूरी हो सकती है जितनी मॉडल क्वालिटी। जैसे प्लेटफ़ॉर्म “vibe‑coding” टीमों के लिए बनाए गए हैं: आप चैट में ऐप का वर्णन करते हैं, जल्दी इटरेट करते हैं, और जब तैयार हों तो सोर्स‑कोड एक्सपोर्ट कर लेते हैं। क्लिनिकल संदर्भ के लिए इसे ऑपरेशन्स सॉफ़्टवेयर और पायलट्स तेज़ करने का एक तरीका समझें, पर सुरक्षा, कंप्लायंस और वैधता का काम जारी रखें।\n\n### रोलआउट से पहले एक सरल मूल्यांकन चेकलिस्ट\n\nकिसी भी एआई सिस्टम के लिए जो मरीज देखभाल को छूता है—even प्रत्यक्ष रूप से—साक्ष्य और संचालन नियंत्रण ज़रूरी हैं:\n\n- अपने मरीज मिक्स के खिलाफ मान्य करें, सिर्फ़ विक्रेता‑डेमो के बजाय\n- आयु, लिंग, नस्ल/जातीयता, भाषा और सह‑रोगों के पार प्रदर्शन जांचें\n- डिफ्ट चेक, अलर्ट थ्रेशहोल्ड और कौन प्रतिक्रिया देगा परिभाषित करें\n- इनपुट, आउटपुट, मॉडल/संस्करण, और क्लिनिशियन द्वारा लिए गए कार्य लॉग करें\n\nयदि विक्रेता यह नहीं समझा पाता कि मॉडल का मूल्यांकन, अपडेट और ऑडिट कैसे किया गया, तो उसे सुरक्षा संकेत के रूप में लें।\n\n### विफलताओं से बचाने के लिए कार्यान्वयन के बुनियादी सिद्धांत\n\n"हम इसे कैसे उपयोग करते हैं" को "यह क्या करता है" जितना ही स्पष्ट बनाएं। क्लिनिशियन प्रशिक्षण में सामान्य फेल्योर‑मोड शामिल करें, और स्थापित करें (कब एआई को अनदेखा करें, कब सहयोगी से पूछें, कब रेफ़र करें, कब ED भेजें)। अच्छा‑परफ़ॉर्मेंस रिव्यू और इन्सिडेंट रिपोर्टिंग के लिए मालिक असाइन करें।\n\nयदि आप टूल्स चुनने, पायलट करने, या नियंत्रित करने में मदद चाहते हैं, तो आंतरिक मार्ग जोड़ें ताकि हितधारक /contact के माध्यम से सहायता माँग सकें (या /pricing यदि आप डेप्लॉयमेंट सर्विसेस पैकेज करते हैं)।\n\n## एक यथार्थपरक टाइमलाइन और आगे क्या देखें\n\n“एआई डॉक्टरों की जगह लेगा” जैसी भविष्यवाणियाँ अक्सर इसलिए विफल होती हैं क्योंकि वे मेडिसिन को एक एकल काम और एक अंतिम लक्ष्य मान लेते हैं। अधिक यथार्थवादी देखो यह है कि बदलाव विषम रहेगा—विशेषज्ञता, सेटिंग और कार्य के अनुसार—और तब तेजी आएगी जब प्रेरणाएँ और नियम अन्ततः मेल खाते हैं।\n\n### निकट‑कालीन बनाम दीर्घकालीन अपेक्षाएँ (बिना किसी तारीख का दावा किए)

\nनज़दीकी अवधि में सबसे बड़े लाभ "वर्कफ़्लो विन्स" होंगे: बेहतर ट्रायेज, स्पष्ट डॉक्यूमेंटेशन, तेज़ प्रायर‑ऑथ और ऐसे डिसीजन सपोर्ट जो स्पष्ट गलतियों को कम करें। ये पहुँच बढ़ा सकते हैं बिना मरीजों को मशीन पर पूरा भरोसा करने के लिए मजबूर किए।\n\nलंबी अवधि में, आप किस‑का‑क्या करना है में धीरे‑धीरे बदलाव देखेंगे—खासकर उस मानकीकृत, हाई‑वॉल्यूम कोयर में जहाँ डेटा बहुत है और आउटकम्स मापने योग्य हैं।\n\n### "बदलाव" चरणबद्ध कैसे दिख सकता है\n\nबदलाव शायद इस तरह चरणबद्ध होगा:\n\n- एआई सुझाव देता, सारांश बनाता, और जोखिम फ़्लैग करता है; क्लिनिशियन प्राथमिक निर्णयकर्ता बने रहते हैं।\n- क्लिनिशियन एआई‑नेतृत्व आकलनों की निगरानी करते हैं, एज‑केस में हस्तक्षेप करते हैं और जवाबदेही संभालते हैं।\n- संकुचित, अच्छी तरह परिभाषित समस्याओं के लिए एआई पूरा लूप संभाले (स्क्रीन → निर्णय → फॉलो‑अप) मानव एस्केलेशन के साथ।\n\n### देखने लायक संकेत

\n- इंश्योरर्स एआई‑समर्थित विज़िट, रिमोट मॉनिटरिंग, या स्वायत्त स्क्रीनिंग के लिए भुगतान करें।\n- टूल्स सिर्फ़ “समर्थन” नहीं बल्कि क्लिनिकल निर्णय लेने और निष्पादित करने के लिए क्लियर किए जाएँ।\n- जब एआई गलत हो तो विक्रेता, क्लिनिशियन या हेल्थ सिस्टम में किसकी जिम्मेदारी है—इन नियमों में स्पष्टता।\n\nसंतुलित निष्कर्ष: प्रगति वास्तविक और कभी‑कभी चौंकाने वाली होगी, पर मेडिसिन केवल पैटर्न‑रिकग्निशन नहीं है। भरोसा, संदर्भ और मरीज‑केंद्रित देखभाल इंसानों को केंद्रीय बनाए रखेंगी—भले ही टूलकिट बदल जाए।