19 mag 2025·8 min

Crea un'app web per analizzare le cancellazioni e testare la retention

Scopri come pianificare, costruire e lanciare un'app web che traccia le cancellazioni di abbonamento, analizza le cause e conduce esperimenti di retention in modo sicuro.

Cosa stai costruendo e perché conta

Le cancellazioni sono uno dei momenti più ricchi di segnali in un business in abbonamento. Un cliente ti sta esplicitamente dicendo: “non vale più la pena,” spesso subito dopo aver incontrato attrito, delusione o una discrepanza tra prezzo e valore. Se tratti la cancellazione come un semplice cambio di stato, perdi una rara occasione per capire cosa si rompe—and per correggerlo.

Il problema che stai risolvendo

La maggior parte dei team vede il churn solo come un numero mensile. Questo nasconde la storia:

- Chi sta cancellando (nuovi utenti vs. clienti di lungo periodo, tipo di piano, segmento)

- Quando cancellano (giorno 1, dopo la trial, dopo un aumento di prezzo, dopo un pagamento fallito)

- Perché cancellano (troppo caro, mancano funzionalità, bug, passano a un concorrente, “non lo uso più”)

Questo è ciò che significa in pratica analisi delle cancellazioni di abbonamento: trasformare un click di cancellazione in dati strutturati di cui ti puoi fidare e che puoi segmentare.

Cosa intendiamo per “esperimenti di ritenzione”

Una volta che vedi i pattern, puoi testare cambiamenti progettati per ridurre il churn—senza indovinare. Gli esperimenti di ritenzione possono riguardare prodotto, prezzo o messaggistica, ad esempio:

- migliorare il flusso di cancellazione (opzioni più chiare, percorsi di downgrade migliori)

- offrire una sospensione temporanea o uno sconto al segmento giusto

- correggere gap di onboarding che correlano con cancellazioni precoci

La chiave è misurare l'impatto con dati puliti e confrontabili (per esempio, un A/B test).

Cosa costruirai in questa guida

Stai costruendo un piccolo sistema con tre parti connesse:

- Tracciamento: eventi intorno al ciclo di vita dell'abbonamento e al flusso di cancellazione, incluse le motivazioni.

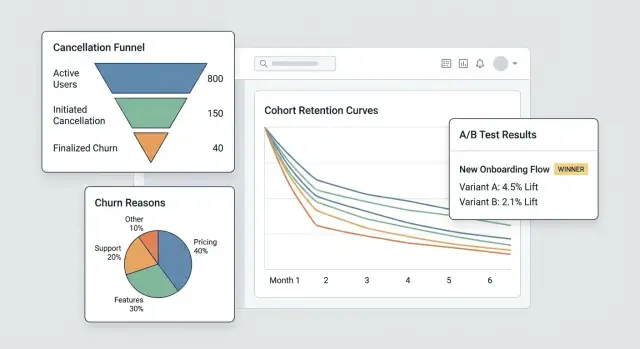

- Una dashboard: funnel, cohort e segmenti che rivelano da dove proviene il churn.

- Un loop di esperimenti: la capacità di eseguire test mirati e verificare se il churn diminuisce davvero.

Alla fine avrai un workflow che va da “abbiamo avuto più cancellazioni” a “questo specifico segmento cancella dopo la settimana 2 a causa di X—e questo cambiamento ha ridotto il churn del Y%”.

Come si misura il successo

Il successo non è un grafico più carino—è velocità e fiducia:

- Insight più rapidi (giorni, non mesi)

- Riduzione misurabile del churn legata a cambiamenti specifici

- Apprendimento ripetibile: ogni cancellazione ti insegna qualcosa su cui puoi agire

Definisci obiettivi, metriche e scope per l'MVP

Prima di costruire schermate, tracciamento o dashboard, sii dolorosamente chiaro su quali decisioni questo MVP deve permettere. Un'app di analytics per cancellazioni ha successo quando risponde a poche domande ad alto valore rapidamente—not quando cerca di misurare tutto.

Parti dalle domande che guidano l'azione

Scrivi le domande a cui vuoi rispondere nella prima release. Buone domande per un MVP sono specifiche e portano a passi successivi ovvi, per esempio:

- Quali sono le principali motivazioni di cancellazione e come differiscono per piano, regione o canale di acquisizione?

- Quanto tempo impiegano i clienti a cancellare (time-to-cancel) e quali pattern emergono nei primi 7/30/90 giorni?

- Quali piani (o cicli di fatturazione) hanno il tasso di cancellazione più alto e gli utenti stanno effettuando downgrade prima di cancellare?

Se una domanda non influenza una modifica di prodotto, una playbook di supporto o un esperimento, mettila da parte.

Scegli 3–5 metriche “north star” per l'MVP

Scegli una lista corta che rivedrai settimanalmente. Mantieni le definizioni inequivocabili così prodotto, support e leadership parlano degli stessi numeri.

Metriche tipiche di partenza:

- Tasso di cancellazione (su un periodo definito, es. settimanale/mensile)

- Tasso di salvataggio (percentuale dei tentativi di cancellazione che convertono in risultato di retention)

- Tasso di riattivazione (clienti che tornano dopo aver cancellato)

- Time-to-cancel (mediana dei giorni dall'inizio all'annullamento)

- Distribuzione delle motivazioni (motivazioni principali per volume e impatto sul fatturato)

Per ogni metrica, documenta la formula esatta, la finestra temporale e le esclusioni (trial, rimborsi, pagamenti falliti).

Nomina i proprietari e i vincoli

Identifica chi userà e manterrà il sistema: prodotto (decisioni), support/success (qualità delle motivazioni e follow-up), data (definizioni e validazione) e engineering (strumentazione e affidabilità).

Poi accordate i vincoli in anticipo: requisiti di privacy (minimizzazione PII, limiti di retention), integrazioni richieste (provider di fatturazione, CRM, tool di support), timeline e budget.

Scrivi una pagina di scope per fermare il feature creep

Tienila corta: obiettivi, utenti primari, le 3–5 metriche, integrazioni “must-have” e una chiara lista di non-obiettivi (es., “no BI suite completa”, “no multi-touch attribution in v1”). Questa singola pagina diventa il contratto dell'MVP quando arrivano nuove richieste.

Modella abbonamenti ed eventi del ciclo di vita

Prima di poter analizzare le cancellazioni, ti serve un modello di abbonamento che rifletta come i clienti si muovono realmente nel tuo prodotto. Se i dati memorizzano solo lo stato corrente dell'abbonamento, farai fatica a rispondere a domande basilari come “Quanto tempo sono stati attivi prima di cancellare?” o “I downgrade prevedevano il churn?”

Mappa il ciclo di vita che misurerai

Inizia con una mappa del ciclo di vita semplice ed esplicita su cui tutto il team concorda:

Trial → Attivo → Downgrade → Cancel → Win-back

Puoi aggiungere altri stati più avanti, ma anche questa catena base obbliga a chiarire cosa conta come “attivo” (pagato? entro il periodo di grazia?) e cosa conta come “win-back” (riattivato entro 30 giorni? in qualsiasi momento?).

Definisci le entità principali

Al minimo, modella queste entità così eventi e soldi possono essere collegati in modo coerente:

- User: la persona che usa l'app (può cambiare nel tempo)

- Account: il contenitore di fatturazione/cliente (spesso l'unità corretta per il churn)

- Subscription: l'accordo che può iniziare, rinnovare, cambiare o terminare

- Plan: il livello prodotto (nome, prezzo, intervallo di fatturazione)

- Invoice: ciò che è stato fatturato, quando e se è stato pagato/rimborsato

- Cancel event: quando è stata richiesta la cancellazione e quando è effettiva

Scegli identificatori stabili (account_id vs user_id)

Per l'analisi del churn, account_id è di solito l'identificatore principale più sicuro perché gli utenti possono cambiare (dipendenti che vanno via, amministratori che cambiano). Puoi comunque attribuire azioni a user_id, ma aggrega retention e cancellazioni a livello di account a meno che non vendi veramente abbonamenti personali.

Conserva la storia degli stati, non solo uno stato

Implementa una status history (effective_from/effective_to) così puoi interrogare stati passati in modo affidabile. Questo rende possibile l'analisi per cohort e l'analisi dei comportamenti pre-cancellazione.

Pianifica i casi limite in anticipo

Modella esplicitamente questi casi così non inquinano i numeri di churn:

- Sospensioni (fermata temporanea senza cancellazione)

- Rimborsi/chargeback (revoca del pagamento vs churn volontario)

- Switch di piano (upgrade/downgrade come eventi, non “nuovi abbonamenti”)

- Periodi di grazia (pagamento fallito vs cancellazione vera)

Strumenta il flusso di cancellazione (eventi e motivazioni)

Se vuoi capire il churn (e migliorare la retention), il flusso di cancellazione è il tuo momento della verità più prezioso. Strumentalo come una superficie di prodotto, non come un semplice form—ogni passo dovrebbe produrre eventi chiari e comparabili.

Traccia i passaggi chiave (e rendili non saltabili)

Al minimo, cattura una sequenza pulita così potrai costruire un funnel in seguito:

cancel_started— l'utente apre l'esperienza di cancellazioneoffer_shown— viene mostrata qualsiasi offerta di salvataggio, opzione di pausa, percorso di downgrade o CTA “parla con supporto”offer_accepted— l'utente accetta un'offerta (pausa, sconto, downgrade)cancel_submitted— cancellazione confermata

Questi nomi di evento dovrebbero essere coerenti su web/mobile e stabili nel tempo. Se evolvi il payload, aumenta la versione di schema (es., schema_version: 2) invece di cambiare significati silenziosamente.

Cattura il contesto che spiega perché è successo

Ogni evento correlato alla cancellazione dovrebbe includere gli stessi campi contestuali principali così puoi segmentare senza congetture:

- piano, anzianità, prezzo

- paese, dispositivo

- canale di acquisizione

Tienili come proprietà sull'evento (non inferirli dopo) per evitare attribuzioni rotte quando altri sistemi cambiano.

Raccogli motivazioni di churn che puoi analizzare e leggere

Usa una lista di motivazioni predefinite (per i grafici) più un testo libero opzionale (per la sfumatura).

cancel_reason_code(es.,too_expensive,missing_feature,switched_competitor)cancel_reason_text(opzionale)

Memorizza la motivazione su cancel_submitted, e considera anche di loggarla quando viene selezionata la prima volta (aiuta a rilevare indecisione o comportamenti avanti-e-indietro).

Non fermarti alla cancellazione: traccia anche gli esiti

Per misurare le interventi di retention, registra gli esiti a valle:

reactivateddowngradedsupport_ticket_opened

Con questi eventi puoi collegare l'intento di cancellazione agli esiti—e fare esperimenti senza discutere su cosa i dati “significhino veramente”.

Progetta la pipeline dati e lo storage

La buona analisi del churn inizia con decisioni noiose fatte bene: dove vivono gli eventi, come vengono puliti e come tutti concordano su cosa significa “una cancellazione”.

Scegli lo storage: OLTP + (opzionale) warehouse

Per la maggior parte degli MVP, conserva prima gli eventi raw di tracking nel database primario dell'app (OLTP). È semplice, transazionale e facile da interrogare per il debugging.

Se prevedi alto volume o report pesanti, aggiungi un warehouse analitico più tardi (replica in lettura Postgres, BigQuery, Snowflake, ClickHouse). Uno schema comune è: OLTP come “source of truth” + warehouse per dashboard veloci.

Tabelle core che ti serviranno

Progetta tabelle intorno a “cosa è successo” più che “cosa pensi ti servirà”. Un set minimo:

events: una riga per evento tracciato (es.,cancel_started,offer_shown,cancel_submitted) conuser_id,subscription_id, timestamp e proprietà JSON.cancellation_reasons: righe normalizzate per le selezioni di motivo, incluse eventuali note testuali.experiment_exposures: chi ha visto quale variante, quando e in quale contesto (feature flag / nome test).

Questa separazione mantiene la tua analytics flessibile: puoi joinare motivi ed esperimenti alle cancellazioni senza duplicare dati.

Eventi tardivi, duplicati e idempotenza

I flussi di cancellazione generano retry (indietro nel browser, problemi di rete, refresh). Aggiungi una idempotency_key (o event_id) e applica unicità così lo stesso evento non viene contato due volte.

Decidi anche una policy per eventi tardivi (mobile/offline): tipicamente accettali, ma usa il timestamp originale dell'evento per l'analisi e il tempo di ingest per il debugging.

ETL/ELT per le prestazioni dei report

Anche senza un warehouse completo, crea un job leggero che costruisca “tabelle di reporting” (aggregati giornalieri, passi di funnel, snapshot di cohort). Questo mantiene le dashboard veloci e riduce join costosi sugli eventi raw.

Documenta le definizioni così le metriche corrispondono

Scrivi un breve dizionario dati: nomi eventi, proprietà richieste e formule delle metriche (es., “churn rate usa cancel_effective_at”). Mettilo nel repository o nella docs interne così prodotto, data e engineering interpretano i grafici allo stesso modo.

Costruisci la dashboard: funnel, cohort e segmenti

Costruisci il tuo MVP in chat

Descrivi in chat il tuo MVP di analisi delle cancellazioni e genera rapidamente una base funzionante dell'app.

Una buona dashboard non cerca di rispondere a ogni domanda in una volta. Deve aiutarti a passare da “qualcosa non va” a “ecco il gruppo e il passo esatto che causa il problema” in pochi click.

Vista core che userai ogni settimana

Inizia con tre viste che rispecchiano come le persone indagano realmente il churn:

- Funnel di cancellazione: da

cancel_started→ motivo selezionato →offer_shown→offer_acceptedocancel_submitted. Questo rivela dove le persone abbandonano e dove il tuo flusso di salvataggio prende o non prende attenzione. - Distribuzione delle motivazioni: scomposizione delle motivazioni selezionate, con un bucket “Altro (testo libero)” che può essere campionato. Mostra sia conteggi che % così gli spike sono evidenti.

- Cohort per mese di inizio: retention o tasso di cancellazione per mese di inizio abbonamento. Le cohort rendono più difficile ingannarsi con stagionalità o cambi di mix di acquisizione.

Segmenti che rendono le insight azionabili

Ogni grafico dovrebbe essere filtrabile per gli attributi che influenzano churn e accettazione delle offerte:

- Piano o tier

- Anzianità (es., 0–7 giorni, 8–30, 31–90, 90+)

- Regione / paese

- Fonte di acquisizione (organico, paid, partner, sales)

- Metodo di pagamento (carta, fattura, PayPal, ecc.)

Mantieni la vista di default “Tutti i clienti”, ma ricorda: l'obiettivo è localizzare quale fetta sta cambiando, non solo se il churn si è mosso.

Controlli temporali e performance del “save flow”

Aggiungi preset di date veloci (ultimi 7/30/90 giorni) più un intervallo personalizzato. Usa lo stesso controllo temporale su tutte le viste per evitare confronti non coerenti.

Per il lavoro di retention, traccia il save flow come mini-funnel con impatto business:

- Visualizzazioni dell'offerta

- Tasso di accettazione dell'offerta

- Net retained MRR (MRR mantenuto dopo sconti, crediti o downgrade)

Drill-down senza perdere fiducia

Ogni grafico aggregato dovrebbe supportare un drill-down fino a una lista di account interessati (es., “clienti che hanno selezionato ‘Too expensive’ e hanno cancellato entro 14 giorni”). Includi colonne come piano, anzianità e ultima fattura.

Metti il drill-down dietro permessi (controllo ruoli) e considera di mascherare campi sensibili di default. La dashboard dovrebbe abilitare l'indagine rispettando privacy e regole interne di accesso.

Aggiungi un framework per esperimenti (A/B test e targeting)

Se vuoi ridurre le cancellazioni, ti serve un modo affidabile per testare cambiamenti (copy, offerte, timing, UI) senza discutere dalle opinioni. Un framework di esperimenti è il “vigile” che decide chi vede cosa, lo registra e lega gli esiti a una variante specifica.

1) Definisci l'unità di esperimento (evita contaminazioni)

Decidi se l'assegnazione avviene a livello account o user.

- Account-level è di solito più sicuro per SaaS: tutti nello stesso workspace vedono la stessa variante, evitando messaggi misti e risultati contaminati.

- User-level può funzionare per app consumer, ma fai attenzione a device condivisi, molti login o account di team.

Scrivi questa scelta per ogni esperimento così la tua analisi è coerente.

2) Scegli un metodo di assegnazione

Supporta alcuni modi di targeting:

- Random (classico A/B): miglior predefinito.

- Weighted (es., 90/10): utile quando si rollouta con cautela.

- Rules-based targeting: mostra una variante solo a segmenti specifici (piano, paese, anzianità, stato “sul punto di cancellare”). Mantieni le regole semplici e versionate.

3) Logga l'exposure quando avviene veramente

Non contare “assegnato” come “esposto”. Registra l'exposure quando l'utente vede effettivamente la variante (es., la schermata di cancellazione è renderizzata, il modal dell'offerta è aperto). Conserva: experiment_id, variant_id, unit id (account/user), timestamp e contesto rilevante (piano, numero di seat).

4) Definisci metriche: primaria + guardrail

Scegli una metrica primaria di successo, come save rate (cancel_started → outcome di retention). Aggiungi guardrail per evitare vittorie dannose: contatti al supporto, richieste di rimborso, tasso di reclami, time-to-cancel o churn da downgrade.

5) Pianifica durata e assunzioni sul campionamento

Prima di lanciare, decidi:

- Tempo minimo di esecuzione (spesso 1–2 cicli di fatturazione per comportamenti di abbonamento)

- Dimensione minima del campione basata sull'attuale save rate e sulla minima variazione che ti interessa

Questo evita di fermarsi troppo presto su dati rumorosi e aiuta la dashboard a mostrare “ancora in apprendimento” vs “statisticamente utile”.

Progetta interventi di retention da testare

Scala quando sei pronto

Supera le basi con più capacità quando il volume di eventi e le dashboard crescono.

Gli interventi di retention sono le “cose che mostri o offri” durante la cancellazione che potrebbero far cambiare idea—senza far sentire l'utente ingannato. L'obiettivo è apprendere quali opzioni riducono il churn mantenendo alta la fiducia.

Varianti comuni da provare

Inizia con un piccolo menu di pattern che puoi mixare:

- Offerte alternative: sconto limitato nel tempo, un mese gratuito o trial esteso

- Opzione pausa: permettere di sospendere la fatturazione per 1–3 mesi (e impostare aspettative sulla riattivazione)

- Downgrade di piano: passare a un tier più economico o ridurre i posti invece che cancellare completamente

- Copy del messaggio: copy breve e specifico che ricorda il valore (“Esporta i tuoi dati in qualsiasi momento”) vs copy generico (“Ci dispiace vederti andare via”)

Progetta offerte che non intrappolino gli utenti

Rendi ogni scelta chiara e reversibile quando possibile. Il percorso “Cancel” dovrebbe essere visibile e non richiedere una caccia. Se offri uno sconto, indica esattamente per quanto dura e a quale prezzo si tornerà dopo. Se offri una pausa, mostra cosa succede ad accesso e date di fatturazione.

Una buona regola: un utente dovrebbe poter spiegare in una frase cosa ha selezionato.

Usa disclosure progressiva

Mantieni il flusso leggero:

-

Chiedi una motivazione (un tap)

-

Mostra una risposta su misura (pausa per “troppo caro”, downgrade per “non lo uso abbastanza”, supporto per “bug”)

-

Conferma l'esito finale (pausa/downgrade/cancel)

Questo riduce l'attrito mantenendo l'esperienza rilevante.

Aggiungi una pagina di risultati e un changelog

Crea una pagina interna dei risultati degli esperimenti che mostri: conversione a outcome “salvato”, tasso di churn, lift vs controllo, e o un intervallo di confidenza o regole decisionali semplici (es., “ship se lift ≥ 3% e campione ≥ 500”).

Mantieni un changelog di cosa è stato testato e cosa è stato rilasciato, così i test futuri non ripetono idee vecchie e puoi collegare shift di retention a cambiamenti specifici.

Privacy, sicurezza e controllo degli accessi

I dati di cancellazione sono tra i più sensibili che tratterai: spesso includono contesto di fatturazione, identificatori e testo libero che può contenere dettagli personali. Tratta privacy e sicurezza come requisiti di prodotto, non come un ripensamento.

Autenticazione e ruoli

Inizia con accesso autenticato solo (SSO se possibile). Poi aggiungi ruoli semplici ed espliciti:

- Admin: gestisce impostazioni, retention dei dati, accessi e export.

- Analyst: vede dashboard, crea segmenti, esegue esperimenti.

- Support: vede la storia a livello cliente necessaria per aiutare (campi limitati).

- Read-only: vede dashboard aggregate senza drill-down.

Esegui i controlli di ruolo lato server, non solo nell'interfaccia.

Minimizza l'esposizione di dati sensibili

Limita chi può vedere record a livello cliente. Preferisci aggregati di default, con drill-down dietro permessi più forti.

- Maschera identificatori (email, customer ID) nell'UI dove possibile.

- Hash degli identificatori per join e deduping (es., SHA-256 con salt segreto) così gli analisti possono segmentare senza vedere la PII raw.

- Separa tabelle “billing/identity” dalle tabelle analitiche di eventi, collegate tramite chiave hashed.

Regole di retention dei dati

Definisci la retention in anticipo:

- Conserva dati evento solo quanto necessario per l'analisi di cohort (es., 13–18 mesi).

- Applica retention o redaction più corta per testo libero delle motivazioni di cancellazione, che può includere info personali accidentali.

- Fornisci workflow di cancellazione per onorare richieste utenti e policy interne.

Log di audit

Registra accessi e export della dashboard:

- Chi ha visto pagine a livello cliente

- Chi ha esportato dati, quando e quali filtri sono stati usati

- Modifiche admin a retention e permessi

Checklist di sicurezza per il lancio

Copri le basi prima di spedire: rischi OWASP principali (XSS/CSRF/injection), TLS ovunque, account DB con least-privilege, gestione segreti (niente chiavi nel codice), rate limiting sugli endpoint di auth e procedure di backup/restore testate.

Blueprint di implementazione (Frontend, Backend e testing)

Questa sezione mappa la build in tre parti—backend, frontend e qualità—così puoi consegnare un MVP coerente, abbastanza veloce per uso reale e sicuro da evolvere.

Backend: abbonamenti, eventi ed esperimenti

Inizia con una piccola API che supporti CRUD per le subscription (crea, aggiorna stato, pausa/riprendi, cancella) e memorizzi le date chiave del ciclo di vita. Mantieni i percorsi di scrittura semplici e convalidati.

Poi aggiungi un endpoint di ingestion eventi per tracciare azioni come “aperto pagina di cancellazione”, “motivo selezionato” e “conferma cancellazione”. Prediligi l'ingest lato server (dal backend) quando possibile per ridurre adblocker e manomissioni. Se devi accettare eventi client, firma le richieste e applica rate-limit.

Per gli esperimenti di retention, implementa l'assegnazione esperimenti lato server così lo stesso account riceve sempre la stessa variante. Un pattern tipico: fetch degli esperimenti eligibili → hash (account_id, experiment_id) → assegna variante → persisti l'assegnazione.

Se vuoi prototipare velocemente, una piattaforma di vibe-coding come Koder.ai può generare le fondamenta (dashboard React, backend Go, schema PostgreSQL) da una breve specifica in chat—poi puoi esportare il codice sorgente e adattare il modello dati, i contratti degli eventi e i permessi alle tue necessità.

Frontend: dashboard, filtri ed export

Costruisci alcune pagine di dashboard: funnel (cancel_started → offer_shown → cancel_submitted), cohort (per mese di signup) e segmenti (piano, paese, canale di acquisizione). Mantieni i filtri coerenti tra le pagine.

Per condivisione controllata, prevedi export CSV con guardrail: esporta solo risultati aggregati di default, richiedi permessi elevati per export a livello di riga e registra gli export per audit.

Basi di performance

Usa paginazione per liste di eventi, indicizza filtri comuni (data, subscription_id, piano) e aggiungi pre-aggregazioni per grafici pesanti (conteggi giornalieri, tabelle cohort). Cache i sommari degli “ultimi 30 giorni” con TTL breve.

Testing e affidabilità

Scrivi unit test per definizioni metriche (es., cosa conta come “cancellation started”) e per coerenza dell'assegnazione (lo stesso account cada sempre nella stessa variante).

Per i fallimenti di ingestion, implementa retry e una dead-letter queue per prevenire perdita silenziosa di dati. Mostra errori nei log e in una pagina admin così puoi correggere prima che distorcano le decisioni.

Deploy, monitoraggio e mantenimento della fiducia nei dati

Definisci chiaramente l'MVP

Usa la modalità planning per definire metriche, schemi e responsabili prima di scrivere codice.

Spedire l'app di analytics per le cancellazioni è solo metà del lavoro. L'altra metà è mantenerla accurata mentre prodotto ed esperimenti cambiano settimana dopo settimana.

Scegli un approccio di deployment

Scegli l'opzione più semplice che si adatti allo stile operativo del team:

- Managed hosting (PaaS): percorso più rapido in produzione se vuoi deploy, log e scaling integrati.

- Container (Docker + orchestrator): migliore quando hai bisogno di build ripetibili e controllo più stretto sulle dipendenze.

- Serverless: ottimo per carichi a picco (ingest eventi, job schedulati), ma monitorare cold start e limiti vendor.

Qualunque sia la scelta, tratta l'app analytics come un sistema di produzione: versionalo, automa i deploy e tieni la config nelle variabili d'ambiente.

Se non vuoi gestire tutta la pipeline dal giorno 1, Koder.ai può anche occuparsi di deployment e hosting (inclusi domini custom) e supporta snapshot e rollback—utile quando iteri velocemente su un flusso sensibile come la cancellazione.

Ambienti separati (e dati)

Crea dev, staging e production con chiara separazione:

- Database e bucket di storage separati così gli eventi di test non contaminano le metriche.

- Un ambiente staging dedicato che rispecchi schema e routing di produzione.

- Namespace di esperimenti distinti (es., prefix agli experiment ID in non-prod) per evitare “varianti fantasma” nelle dashboard.

Monitoraggio che protegge le decisioni

Non stai monitorando solo uptime—stai monitorando la verità:

- Uptime/health di API, worker background e dashboard.

- Lag di ingest (tempo evento vs tempo processato) con alert quando si discosta.

- Errori di assegnazione esperimenti: picchi improvvisi di “unità non assegnate”, sbilanciamento nelle varianti o assegnazioni che cambiano per lo stesso account.

Job automatici di validazione dei dati

Schedula controlli leggeri che falliscano rumorosamente:

- Eventi chiave mancanti (es.,

cancel_startedsenzacancel_submitted, dove atteso). - Cambiamenti di schema (nuove/properties rimosse, cambi tipi, enum inattesi).

- Anomalie di volume (eventi che scendono quasi a zero dopo un rilascio).

Piano di rollback per cambiamenti UI sugli esperimenti

Per ogni esperimento che tocca il flusso di cancellazione, pre-pianifica il rollback:

- Feature flag per disabilitare le varianti immediatamente.

- Un percorso rapido per ridistribuire l'ultimo build noto buono.

- Una nota nella dashboard che segna la finestra di rollback così gli analisti non interpretino male i dati.

Operare il sistema: dall'insight agli esperimenti continui

Un'app di analytics per cancellazioni paga solo quando diventa un'abitudine, non un report una-tantum. L'obiettivo è trasformare “abbiamo notato churn” in un ciclo continuo insight → ipotesi → test → decisione.

Esegui una cadenza settimanale semplice

Scegli un orario fisso ogni settimana (30–45 minuti) e mantieni il rituale leggero:

- Rivedi la dashboard per cambiamenti nelle metriche chiave (churn totale, churn per piano, churn per anzianità e motivazioni principali).

- Segnala un'anomalia da investigare (es., spike di churn tra rinnovi annuali o una motivazione che improvvisamente scala in top).

- Scegli esattamente un'ipotesi da testare la settimana successiva.

Limitarsi a una ipotesi forza chiarezza: cosa crediamo stia succedendo, chi è coinvolto e quale azione potrebbe cambiare i risultati?

Prioritizza gli esperimenti (impatto × sforzo)

Evita di eseguire troppi test contemporaneamente—soprattutto nel flusso di cancellazione—perché cambi sovrapposti rendono i risultati difficili da fidare.

Usa una griglia semplice:

- Alto impatto / basso sforzo: fatti prima (cambi di copy, routing al supporto, offerta di switch annuale).

- Alto impatto / alto sforzo: pianificali (flessibilità di fatturazione, fix di prodotto).

- Basso impatto: mettili in pausa.

Se sei nuovo all'exp, allineati sulle basi e regole decisionali prima di spedire: /blog/ab-testing-basics.

Chiudi il loop con input qualitativo

I numeri dicono cosa succede; le note del support e i commenti di cancellazione spesso dicono perché. Ogni settimana, campiona alcune cancellazioni recenti per segmento e sintetizza i temi. Poi mappa i temi in interventi testabili.

Costruisci un playbook di “interventi vincenti”

Traccia gli apprendimenti nel tempo: cosa ha funzionato, per chi e in quali condizioni. Conserva brevi voci come:

- Definizione del segmento (piano, anzianità, uso)

- Ipotesi e cambiamento inviato

- Risultato e confidenza

- Azione di follow-up (rilascio, iterazione o revert)

Quando sei pronto a standardizzare le offerte (e evitare sconti ad-hoc), collega il playbook alla tua packaging e ai limiti: /pricing.