10 nov 2025·8 min

Cambiamenti di schema e migrazioni nei sistemi costruiti con AI: una guida

Scopri come i sistemi costruiti con AI gestiscono i cambiamenti di schema in modo sicuro: versioning, rollout retrocompatibili, migrazioni dati, test, osservabilità e strategie di rollback.

Cosa significa “schema” nei sistemi costruiti con AI

Uno schema è semplicemente l'accordo condiviso sulla forma dei dati e cosa significa ogni campo. Nei sistemi costruiti con AI questo accordo appare in più posti rispetto alle sole tabelle del database — e cambia più spesso di quanto i team si aspettino.

Lo schema non è solo una cosa del database

Incontrerai schemi in almeno quattro livelli comuni:

- Database: nomi di tabelle/colonne, tipi di dato, vincoli, indici e relazioni.

- API: forma JSON di request/response, campi obbligatori vs opzionali, enum, formati degli errori, convenzioni di paginazione.

- Eventi e messaggi: i payload inviati attraverso stream, code e webhook (spesso versionati implicitamente attraverso i consumer).

- Configurazioni e contratti: feature flag, variabili d'ambiente, config YAML/JSON e “contratti nascosti” come formati di file e convenzioni di nomenclatura.

Se due parti del sistema si scambiano dati, esiste uno schema — anche se nessuno lo ha scritto.

Perché nei sistemi costruiti con AI gli schemi cambiano più spesso

Il codice generato dall'AI può accelerare drasticamente lo sviluppo, ma aumenta anche il churn:

- Il codice generato riflette il prompt e il contesto più recenti, quindi piccoli aggiustamenti del prompt possono cambiare nomi dei campi, annidamenti, valori predefiniti o validazioni.

- I requisiti evolvono più velocemente quando è economico rilasciare un nuovo endpoint o un nuovo step di pipeline.

- Convenzioni incoerenti (snake_case vs. camelCase,

idvs.userId) emergono quando si generano o refactorizzano componenti in modo distribuito.

Il risultato è una “drift” del contratto tra producer e consumer più frequente.

Se usi un workflow basato su generazione (per esempio generare handler, layer di accesso DB e integrazioni tramite chat), vale la pena integrare la disciplina degli schemi in quel workflow fin dal primo giorno. Piattaforme come Koder.ai aiutano i team a muoversi rapidamente generando app React/Go/PostgreSQL e Flutter da un'interfaccia chat — ma più veloce è il rilascio, più importante diventa versionare le interfacce, validare i payload e distribuire le modifiche con attenzione.

L'obiettivo di questa guida

Questo post si concentra su modi pratici per mantenere stabile la produzione pur iterando velocemente: mantenere la retrocompatibilità, distribuire le modifiche in sicurezza e migrare i dati senza sorprese.

Cosa non tratteremo

Non approfondiremo modellazione teorica, metodi formali o funzionalità specifiche di vendor. L'enfasi è su pattern applicabili trasversalmente — che il vostro sistema sia scritto a mano, assistito dall'AI o per lo più generato dall'AI.

Perché i cambiamenti di schema accadono più spesso con il codice generato dall'AI

Il codice generato dall'AI tende a far sembrare i cambiamenti di schema "normali" — non perché i team siano negligenti, ma perché gli input al sistema cambiano più frequentemente. Quando il comportamento dell'app è parzialmente guidato da prompt, versioni di modelli e codice "collante" generato, la forma dei dati è più soggetta a deriva nel tempo.

Trigger comuni che vedrai in pratica

Alcuni schemi ricorrono frequentemente e generano churn:

- Nuove feature di prodotto: aggiungere un nuovo campo (es.

risk_score,explanation,source_url) o dividere un concetto in più campi (es.addressinstreet,city,postal_code). - Cambiamenti nell'output del modello: un modello più nuovo potrebbe produrre strutture più dettagliate, valori enum diversi o naming leggermente modificato ("confidence" vs "score").

- Aggiornamenti del prompt: tweak del prompt volti a migliorare la qualità possono involontariamente cambiare formato, campi obbligatori o annidamento.

Pattern rischiosi che rendono gli sistemi AI fragili

Il codice generato dall'AI spesso “funziona” rapidamente, ma può codificare assunzioni fragili:

- Assunzioni implicite: il codice presume che un campo sia sempre presente, sempre numerico o sempre in un certo intervallo.

- Accoppiamento nascosto: un servizio si affida ai nomi interni dei campi di un altro servizio o all'ordine invece di un'interfaccia definita.

- Campi non documentati: il modello inizia a emettere una nuova proprietà e il codice a valle comincia a usarla senza che nessuno concordi esplicitamente che faccia parte del contratto.

Perché l'AI amplifica la frequenza dei cambiamenti

La generazione di codice incoraggia l'iterazione rapida: rigeneri handler, parser e layer di accesso al DB mentre i requisiti evolvono. Questa velocità è utile, ma rende anche facile rilasciare piccoli cambiamenti d'interfaccia ripetutamente — a volte senza accorgersene.

La mentalità più sicura è trattare ogni schema come un contratto: tabelle del database, payload API, eventi e anche risposte strutturate dall'LLM. Se un consumer dipende da qualcosa, versionalo, validalo e cambialo deliberatamente.

Tipi di cambiamenti di schema: additivi vs. breaking

I cambiamenti di schema non sono tutti uguali. La prima domanda utile è: i consumer esistenti continueranno a funzionare senza modifiche? Se sì, di solito è additivo. Se no, è breaking — e serve un piano di rollout coordinato.

Cambiamenti additivi (di solito sicuri)

I cambiamenti additivi estendono ciò che c'è già senza cambiarne il significato.

Esempi comuni su database:

- Aggiungere una colonna con un valore di default o permettere NULL (es.

preferred_language). - Aggiungere una nuova tabella o un indice.

- Aggiungere un campo opzionale a un blob JSON memorizzato in una colonna.

Esempi non-database:

- Aggiungere una nuova proprietà a una response API (i client che ignorano campi sconosciuti continuano a funzionare).

- Aggiungere un nuovo campo a un evento in uno stream/queue.

- Aggiungere un nuovo valore a un feature flag mantenendo il comportamento precedente come default.

Gli additivi sono “sicuri” solo se i consumer più vecchi sono tolleranti: devono ignorare campi sconosciuti e non richiedere i nuovi.

Cambiamenti breaking (rischiosi)

I cambiamenti breaking alterano o rimuovono qualcosa da cui i consumer già dipendono.

Tipici cambiamenti breaking su database:

- Cambiare il tipo di una colonna (string → integer, precisione timestamp diversa).

- Rinominare un campo/colonna (tutto ciò che leggeva il vecchio nome fallirà).

- Eliminare una colonna/tabella ancora interrogata.

Cambiamenti breaking non-database:

- Rinominare/rimuovere campi JSON in request/response.

- Cambiare la semantica di un evento (stesso nome campo, significato diverso).

- Modificare la struttura del payload di un webhook senza bump di versione.

Documenta sempre l'impatto sui consumer

Prima di fare merge, documenta:

- Chi lo consuma (servizi, cruscotti, pipeline di dati, partner).

- Compatibilità (backward/forward, e per quanto tempo).

- Modalità di fallimento (errori di parsing, corruzione silente dei dati, logica business sbagliata).

Questa breve “nota d'impatto” obbliga alla chiarezza — specialmente quando il codice generato dall'AI introduce cambiamenti di schema implicitamente.

Strategie di versioning per schemi e interfacce

Versionare è il modo per comunicare ad altri sistemi (e al te stesso futuro) “questo è cambiato, e qui c'è il rischio”. Lo scopo non è la burocrazia: è prevenire rotture silenziose quando client, servizi o pipeline aggiornano a velocità diverse.

Mentalità semantica semplice per il versioning

Pensa in termini major / minor / patch, anche se non pubblichi letteralmente 1.2.3:

- Major: cambiamento breaking. I vecchi consumer possono fallire o comportarsi male senza modifiche.

- Minor: aggiunta sicura. I vecchi consumer funzionano; i consumer nuovi possono usare le nuove capacità.

- Patch: fix o chiarimento che non cambia significato.

Una regola semplice che salva i team: non cambiare mai silenziosamente il significato di un campo esistente. Se status="active" significava "cliente pagante", non riutilizzarlo per significare "l'account esiste". Aggiungi un nuovo campo o una nuova versione.

Endpoint versionati vs. campi versionati

Di solito hai due opzioni pratiche:

1) Endpoint versionati (es. /api/v1/orders e /api/v2/orders):

Buono quando i cambiamenti sono veramente breaking o diffusi. È chiaro, ma può creare duplicazione e manutenzione a lungo termine se mantieni più versioni.

2) Campi versionati / evoluzione additiva (es. aggiungi new_field, mantieni old_field):

Buono quando puoi fare cambiamenti additivi. I client più vecchi ignorano ciò che non capiscono; i client nuovi leggono il nuovo campo. Col tempo, depreca e rimuovi il campo vecchio con un piano esplicito.

Schemi di eventi e registry

Per stream, queue e webhook, i consumer sono spesso fuori dal tuo controllo di deployment. Un schema registry (o qualsiasi catalogo centrale di schemi con controlli di compatibilità) aiuta a far rispettare regole come “solo cambiamenti additivi ammessi” e rende ovvio quali producer e consumer dipendono da quali versioni.

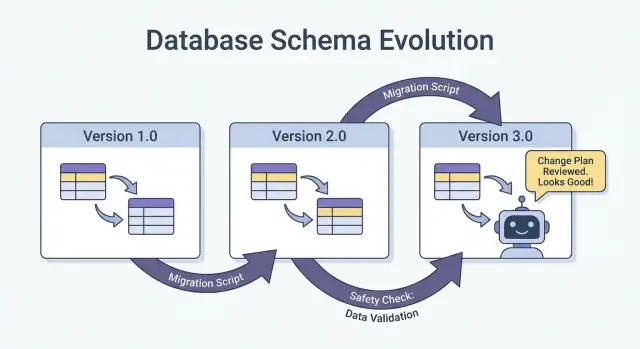

Rollout sicuri: Expand/Contract (il pattern più affidabile)

Il modo più sicuro per rilasciare cambiamenti di schema — specialmente quando hai più servizi, job e componenti generati dall'AI — è il pattern expand → backfill → switch → contract. Minimizza downtime ed evita deploy "tutto o niente" dove un consumer in ritardo rompe la produzione.

I quattro passi (e perché funzionano)

1) Expand: Introduci il nuovo schema in modo backward-compatible. Lettori e scrittori esistenti devono continuare a funzionare senza cambiamenti.

2) Backfill: Popola i nuovi campi per i dati storici (o reprocessa i messaggi) così il sistema diventa consistente.

3) Switch: Aggiorna writers e readers per usare il nuovo campo/formato. Questo può essere fatto gradualmente (canary, rollout percentuale) perché lo schema supporta entrambi.

4) Contract: Rimuovi il campo/formato vecchio solo dopo esserti assicurato che nulla dipenda più da esso.

Rollout in due fasi (expand → switch) o tre fasi (expand → backfill → switch) riduce downtime perché evita accoppiamenti stretti: gli scrittori possono muoversi prima, i lettori dopo, e viceversa.

Esempio: aggiungere una colonna, backfill, poi renderla obbligatoria

Supponiamo di voler aggiungere customer_tier.

- Expand: Aggiungi

customer_tiercome nullable con defaultNULL. - Backfill: Esegui un job per calcolare tier per le righe esistenti.

- Switch: Aggiorna app e pipeline per scrivere sempre

customer_tier, e aggiorna i reader per preferirlo. - Contract: Dopo il monitoraggio, rendilo NOT NULL (e opzionalmente elimina la logica legacy).

Coordinazione: scrittori e lettori devono concordare

Tratta ogni schema come un contratto tra producer (scrittori) e consumer (lettori). Nei sistemi costruiti con AI questo è facile da perdere di vista perché compaiono nuovi percorsi di codice rapidamente. Rendi i rollout espliciti: documenta quale versione scrive cosa, quali servizi possono leggere entrambi e la precisa “data del contratto” in cui i campi vecchi possono essere rimossi.

Migrazioni di database: come cambiare i dati senza rompere la produzione

Pianifica la tua prossima modifica di schema

Usa la modalità di pianificazione per mappare expand-backfill-switch-contract prima di generare codice.

Le migrazioni di database sono il "manuale d'istruzioni" per muovere dati e struttura di produzione da uno stato sicuro al successivo. Nei sistemi costruiti con AI contano ancora di più perché il codice generato può presumere che una colonna esista, rinominare campi in modo incoerente o cambiare vincoli senza considerare le righe esistenti.

File di migrazione vs. auto-migrations

File di migrazione (committati nel source control) sono passi espliciti come “add column X”, “create index Y” o “copy data from A to B”. Sono auditabili, revisionabili e possono essere riprodotti in staging e produzione.

Auto-migrations (generate da un ORM/framework) sono comode per sviluppo iniziale e prototipazione, ma possono produrre operazioni rischiose (dropping di colonne, ricostruzione di tabelle) o riordinare i cambiamenti in modi non intenzionati.

Una regola pratica: usa le auto-migrations per bozzare i cambiamenti, poi trasformale in file di migrazione revisionati per qualsiasi cosa tocchi la produzione.

Idempotenza e ordine

Rendi le migrazioni idempotenti dove possibile: rieseguirle non dovrebbe corrompere i dati o fallire a metà. Preferisci "create if not exists", aggiungi nuove colonne come nullable prima, e proteggi le trasformazioni di dati con check.

Mantieni anche un ordine chiaro. Ogni ambiente (locale, CI, staging, prod) dovrebbe applicare la stessa sequenza di migrazioni. Non “fixare” la produzione con SQL manuale a meno che non catturi la modifica in una migrazione dopo.

Migrazioni a lunga esecuzione senza bloccare la tabella

Alcuni cambiamenti di schema possono bloccare le scritture (o anche le letture) se bloccano una tabella grande. Modi di alto livello per ridurre il rischio:

- Usa operazioni online/minimizzanti i lock supportate dal tuo DB (es. build di indici concorrenti).

- Dividi i cambiamenti in passi: aggiungi prima le nuove strutture, backfill in batch, poi fai lo switch nell'app.

- Pianifica operazioni pesanti nelle finestre di bassa attività, con timeout e monitoraggio.

Setup multi-tenant e sharded

Per database multi-tenant, esegui migrazioni in un loop controllato per tenant, con tracking del progresso e retry sicuri. Per shard, tratta ogni shard come un sistema di produzione separato: rilascia migrazioni shard-per-shard, verifica la salute, poi procedi. Questo limita il raggio d'azione e rende il rollback fattibile.

Backfill e reprocessamento: aggiornare i dati esistenti

Un backfill è quando popoli nuovi campi (o correggi valori) per record esistenti. Il reprocessamento è quando fai passare i dati storici di nuovo in una pipeline — tipicamente perché le regole di business sono cambiate, è stato risolto un bug o l'output del modello è stato aggiornato.

Entrambi sono comuni dopo cambiamenti di schema: è facile iniziare a scrivere la nuova forma per i "nuovi dati", ma i sistemi di produzione dipendono anche dai dati di ieri coerenti.

Approcci comuni

Backfill online (in produzione, gradualmente). Esegui un job controllato che aggiorna i record in piccoli batch mentre il sistema resta live. È più sicuro per servizi critici perché puoi limitare il carico, mettere in pausa e riprendere.

Backfill batch (offline o job schedulati). Processi grandi chunk durante finestre di bassa attività. È operativamente più semplice, ma può creare picchi di carico e richiede più tempo per recuperare da errori.

Backfill pigro alla lettura. Quando si legge un record vecchio, l'app calcola/popola i campi mancanti e li scrive. Questo diluisce il costo nel tempo ed evita un grande job, ma rallenta la prima lettura e può lasciare dati "vecchi" non convertiti a lungo.

In pratica i team combinano spesso questi approcci: backfill pigro per la coda lunga e job online per i dati più frequentemente accessi.

Come validare un backfill

La validazione deve essere esplicita e misurabile:

- Conteggi: quante righe/eventi dovrebbero essere aggiornati vs quante lo sono state.

- Checksum/aggregati: confronta totali (es. somma degli importi, ID distinti) prima/dopo.

- Campionamento: controlli spot su un campione statisticamente significativo, incluse le edge case.

Valida anche gli effetti a valle: dashboard, indici di ricerca, cache ed eventuali esportazioni che dipendono dai campi aggiornati.

Costo, tempo e criteri di accettazione

I backfill bilanciano velocità (completare in fretta) contro rischio e costo (carico, compute e overhead operativo). Definisci i criteri di accettazione in anticipo: cosa significa “fatto”, runtime previsto, massimo tasso di errore accettabile e cosa fare se la validazione fallisce (pausa, retry o rollback).

Evoluzione degli schemi per eventi e messaggi (stream, queue, webhook)

Mantieni piena proprietà del codice

Esporta il codice sorgente per revisionare migrazioni, validazioni e modifiche ai contratti nel tuo repo.

Gli schemi non vivono solo nei database. Ogni volta che un sistema invia dati a un altro — topic Kafka, code SQS/RabbitMQ, payload webhook, anche “eventi” scritti su object storage — hai creato un contratto. Producer e consumer si muovono indipendentemente, quindi questi contratti tendono a rompersi più spesso rispetto alle tabelle interne di una singola app.

Il default più sicuro: evolvi gli eventi backward-compatibly

Per stream di eventi e payload webhook, preferisci cambiamenti che i vecchi consumer possano ignorare e che i nuovi consumer possano adottare.

Una regola pratica: aggiungi campi, non rimuovere o rinominare. Se devi deprecare qualcosa, continua a inviarlo per un po' e documentalo come deprecato.

Esempio: estendi un evento OrderCreated aggiungendo campi opzionali.

{

"event_type": "OrderCreated",

"order_id": "o_123",

"created_at": "2025-12-01T10:00:00Z",

"currency": "USD",

"discount_code": "WELCOME10"

}

I consumer più vecchi leggono order_id e created_at e ignorano il resto.

Contratti guidati dal consumer (versione in linguaggio semplice)

Invece di far indovinare al producer cosa possa rompere gli altri, i consumer pubblicano ciò da cui dipendono (campi, tipi, regole required/optional). Il producer poi valida i cambiamenti rispetto a quelle aspettative prima di rilasciare. Questo è particolarmente utile in codebase generate dall'AI, dove un modello potrebbe "utilemente" rinominare un campo o cambiare un tipo.

Gestire campi "sconosciuti" in sicurezza

Rendi i parser tolleranti:

- Ignora campi sconosciuti per default (non fallire solo perché appare una nuova chiave).

- Tratta i nuovi campi come opzionali finché non ne hai veramente bisogno.

- Logga i campi inaspettati a basso livello così puoi vedere l'adozione senza essere svegliato dalla notte.

Quando serve un breaking change, usa un nuovo tipo di evento o un nome versione (per esempio OrderCreated.v2) ed esegui entrambi in parallelo finché tutti i consumer non migrano.

Output AI come schema: prompt, modelli e risposte strutturate

Quando aggiungi un LLM a un sistema, i suoi output diventano rapidamente uno schema de facto — anche se nessuno ha scritto una specifica formale. Il codice a valle comincia a presumere "ci sarà un campo summary", "la prima riga è il titolo" o "i bullet sono separati da trattini". Quelle assunzioni si consolidano nel tempo, e un piccolo cambiamento nel comportamento del modello può romperle proprio come un rename di colonna.

Preferisci struttura esplicita (e validala)

Invece di parsare "testo carino", richiedi output strutturati (tipicamente JSON) e validali prima che entrino nel resto del sistema. Consideralo come la trasformazione da "best effort" a contratto.

Un approccio pratico:

- Definisci uno schema JSON (o un'interfaccia tipizzata) per la risposta del modello.

- Rifiuta o metti in quarantena le risposte non valide (non coerciarle silenziosamente).

- Logga gli errori di validazione così puoi vedere cosa sta cambiando.

Questo è particolarmente importante quando le risposte degli LLM alimentano pipeline di dati, automazioni o contenuti rivolti all'utente.

Pianifica il drift del modello

Anche con lo stesso prompt, gli output possono cambiare nel tempo: campi possono essere omessi, chiavi extra possono apparire e i tipi possono cambiare ("42" vs 42, array vs stringa). Tratta questi eventi come evoluzioni di schema.

Mitigazioni efficaci:

- Rendi i campi opzionali quando ragionevole e imposta default espliciti.

- Permetti chiavi sconosciute ma ignorale in modo sicuro (a meno che non sia necessario essere rigorosi per compliance).

- Aggiungi controlli di "guardrail" (es. campi obbligatori, lunghezze massime, valori enum).

Tratta i cambi di prompt come cambiamenti di API

Un prompt è un'interfaccia. Se lo modifichi, versionalo. Mantieni prompt_v1, prompt_v2 e rilascia gradualmente (feature flag, canary o toggles per tenant). Testa con un set di valutazione fisso prima di promuovere i cambiamenti e tieni le versioni più vecchie in esecuzione finché i consumer a valle non si sono adattati. Per maggiori dettagli sulle meccaniche dei rollout sicuri, collega il tuo approccio a /blog/safe-rollouts-expand-contract.

Test e validazione per i cambiamenti di schema

I cambiamenti di schema falliscono spesso in modi banali ma costosi: una nuova colonna manca in un ambiente, un consumer si aspetta ancora un campo vecchio, o una migrazione funziona su dati vuoti ma va in timeout in produzione. I test sono il modo per trasformare queste “sorprese” in lavoro prevedibile e riparabile.

Tre livelli di test (e cosa catturano)

Unit test proteggono la logica locale: funzioni di mapping, serializer/deserializer, validator e query builder. Se un campo viene rinominato o un tipo cambia, gli unit test dovrebbero fallire vicino al codice che va aggiornato.

Integration test assicurano che la tua app funzioni ancora con dipendenze reali: il motore di database reale, lo strumento di migrazione reale e i formati dei messaggi reali. Qui catturi problemi come “il modello ORM è cambiato ma la migrazione no” o “il nuovo nome dell'indice confligge”.

End-to-end test simulano outcome utente o workflow tra servizi: crea dati, migrali, leggili via API e verifica che i consumer a valle si comportino ancora correttamente.

Contract test per producer e consumer

L'evoluzione degli schemi spesso rompe ai confini: API service-to-service, stream, queue e webhook. Aggiungi contract test che girino da entrambe le parti:

- I producer dimostrano di poter emettere eventi/risposte che rispettano un contratto concordato.

- I consumer dimostrano di saper parsare sia la versione vecchia che quella nuova durante un rollout.

Test di migrazione: apply e rollback su ambienti freschi

Testa le migrazioni come le deployeresti:

- Parti da uno snapshot di DB pulito.

- Applica tutte le migrazioni in ordine.

- Verifica che l'app possa leggere/scrivere.

- Esegui un rollback (se supportato) o una migrazione "down" e conferma che torni a uno stato funzionante.

Fixture per versioni di schema vecchie e nuove

Conserva un piccolo set di fixture che rappresentino:

- Dati scritti con lo schema precedente (righe/eventi legacy).

- Dati scritti con il nuovo schema.

Queste fixture rendono regressioni evidenti, specialmente quando il codice generato dall'AI cambia sottilmente nomi di campo, optionalità o formattazione.

Osservabilità: rilevare le rotture presto

Fai evolvere gli schemi degli eventi con cura

Progetta payload di eventi che tollerino campi sconosciuti ed evitino di rompere i consumer.

I cambiamenti di schema raramente falliscono in modo rumoroso al momento del deploy. Più spesso la rottura si manifesta come un lento aumento di errori di parsing, avvisi “campo sconosciuto”, dati mancanti o job di background che restano indietro. Una buona osservabilità trasforma quei segnali deboli in feedback azionabili mentre puoi ancora mettere in pausa il rollout.

Cosa monitorare durante un rollout

Inizia dalle basi (salute dell'app), poi aggiungi segnali specifici per lo schema:

- Errori: picchi di 4xx/5xx, ma anche errori "soft" come fallimenti di parsing JSON, deserializzazione e retry.

- Latenza: p95/p99 dei tempi di risposta e tempo di elaborazione delle code. I cambi di schema possono aggiungere join, payload più grandi o validazioni extra.

- Segnali di qualità dei dati: aumento del tasso di null in colonne importanti, calo improvviso del volume di eventi, nuovi valori di default che appaiono troppo spesso o mismatch tra rappresentazioni vecchie e nuove.

- Ritardo delle pipeline: lag dei consumer in stream/queue, backlog di consegna webhook e throughput dei job di migrazione.

La chiave è comparare prima vs dopo e scomporre per versione client, versione schema e segmento di traffico (canary vs stable).

Cruscotti che aiutano davvero

Crea due viste di dashboard:

-

Dashboard comportamento applicazione

- Request rate, error rate, latenza (RED)

- Top eccezioni (raggruppate per messaggio)

- Conteggio e percentuale di errori di validazione/parsing

- Distribuzione della dimensione dei payload (per catturare messaggi inaspettatamente grandi)

-

Dashboard migrazioni e job background

- Progresso job di migrazione (% completato), righe processate/sec, ETA

- Tasso di fallimento e conteggio retry

- Profondità delle code / consumer lag

- Volume della dead-letter queue (se applicabile)

Se esegui un rollout expand/contract, includi un pannello che mostri letture/scritture separate per schema vecchio vs nuovo così puoi vedere quando è sicuro passare alla fase successiva.

Alert per failure specifiche dello schema

Fai partire pagine su problemi che indicano perdita o lettura errata dei dati:

- Tasso di errori di validazione schema sopra una soglia bassa (spesso <0.1% è già significativo)

- Fallimenti di parsing/deserializzazione (specialmente se concentrati su un producer/consumer)

- Avvisi campo inaspettato / campo richiesto mancante che aumentano nel tempo

- Job di migrazione bloccato (nessun progresso per N minuti) o lag che cresce più velocemente del throughput

Evita alert rumorosi su 500 grezzi senza contesto; collega gli alert al rollout dello schema usando tag come versione schema ed endpoint.

Logga la versione per debug veloci

Durante la transizione, includi e logga:

- Versione schema (es. header

X-Schema-Version, campo metadata nel messaggio) - Versione app producer e consumer

- Versione modello / versione prompt quando output generati da AI alimentano dati strutturati

Quel dettaglio rende la risposta alla domanda “perché questo payload ha fallito?” risolvibile in minuti, non giorni — specialmente quando servizi diversi (o versioni modello diverse) sono live contemporaneamente.

Rollback, recovery e change management

I cambiamenti di schema falliscono in due modi: il cambiamento stesso è sbagliato, o il sistema attorno ad esso si comporta diversamente dal previsto (soprattutto quando il codice generato dall'AI introduce assunzioni sottili). In entrambi i casi, ogni migrazione necessita di una storia di rollback prima di essere rilasciata — anche se quella storia è esplicitamente “nessun rollback”.

Scegliere “nessun rollback” può essere valido quando il cambiamento è irreversibile (per esempio droppare colonne, riscrivere identificatori o deduplicare record in modo distruttivo). Ma “nessun rollback” non significa assenza di piano; è una decisione che sposta il piano verso fix forward, restore e contenimento.

Opzioni pratiche di rollback che funzionano davvero

Feature flag / config gate: Incapsula nuovi reader, writer e campi API dietro un flag così puoi spegnere il nuovo comportamento senza ridistribuire. Questo è particolarmente utile quando codice generato dall'AI è sintatticamente corretto ma semanticamente sbagliato.

Disable dual-write: Se scrivi su schema vecchio e nuovo durante un rollout expand/contract, tieni uno switch per disattivare. Spegnere la nuova scrittura arresta ulteriori divergenze mentre indaghi.

Revert dei reader (non solo writer): Molti incidenti succedono perché i consumer iniziano a leggere campi o tabelle nuove troppo presto. Rendi semplice puntare i servizi alla versione precedente dello schema o ignorare i campi nuovi.

Conosci i limiti della reversibilità

Alcune migrazioni non possono essere annullate pulitamente:

- Trasformazioni distruttive (es. hashing, normalizzazione lossy).

- Drop/rename senza copia preservata.

- Backfill che sovrascrivono valori "source of truth".

Per questi, pianifica restore da backup, replay da eventi o ricomputazione dagli input grezzi — e verifica di avere ancora quegli input.

Checklist pre-flight (prima di spedire)

- Decisione sul rollback documentata ("revert", "forward fix" o "no rollback + restore path").

- Pulsante di stop chiaro: flag e/o switch per disabilitare dual-write.

- Backup/snapshot verificati; restore testato almeno una volta.

- Migrazione idempotente; rilanci non corrompono i dati.

- Monitoraggio e alert per tassi di errore, fallimenti di validazione schema e lag.

- Ownership: chi approva, chi esegue, chi è on-call durante il rollout.

Un buon change management rende rari i rollback — e rende il recovery noioso quando accade.

Se il tuo team itera rapidamente con sviluppo assistito dall'AI, aiuta accoppiare queste pratiche con tool che supportino sperimentazione sicura. Ad esempio, Koder.ai include la modalità di planning per la progettazione anticipata delle modifiche e snapshot/rollback per un recupero rapido quando una modifica generata accidentalmente sposta un contratto. Usati insieme, generazione rapida di codice e disciplina nell'evoluzione degli schemi ti permettono di muoverti più veloce senza trattare la produzione come un ambiente di test.