Cosa si rompe quando inizi a vendere alle aziende

Vendere a piccoli team riguarda soprattutto funzionalità e velocità. Vendere alle aziende cambia la definizione di “buono”. Un blackout, un bug di permessi o l'assenza di una traccia di audit possono vanificare mesi di fiducia.

In parole semplici, l'affidabilità significa tre cose: l'app resta attiva, i dati stanno al sicuro e il comportamento resta prevedibile. Quest'ultimo aspetto conta più di quanto sembri. Gli utenti enterprise pianificano il lavoro attorno al tuo sistema. Si aspettano lo stesso risultato oggi, la prossima settimana e dopo il prossimo aggiornamento.

Quello che di solito si rompe per primo non è un singolo server. È il divario tra ciò che hai costruito per pochi utenti e ciò che i grandi clienti presumono già presente. Portano più traffico, più ruoli, più integrazioni e più controlli di sicurezza e compliance.

I punti di stress iniziali sono prevedibili. Le aspettative di uptime passano da “va abbastanza bene” a “deve essere noiosamente stabile”, con una gestione degli incidenti chiara. La sicurezza dei dati diventa una questione a livello di consiglio: backup, recovery, log di accesso e proprietà dei dati. I permessi si complicano rapidamente: reparti, contrattisti e accesso a privilegi minimi. Le modifiche diventano rischiose: le release hanno bisogno di rollback e di modi per evitare comportamenti a sorpresa. Il supporto smette di essere solo “d'aiuto” e diventa parte del prodotto, con tempi di risposta e percorsi di escalation.

Un cliente startup può accettare due ore di blackout e una rapida scusa. Un cliente enterprise potrebbe volere un sommario della causa radice, prove che non si ripeterà e un piano per evitare guasti simili.

Una checklist di prontezza enterprise non riguarda il “software perfetto”. Si tratta di scalare senza rompere la fiducia, aggiornando insieme design del prodotto, abitudini del team e operazioni quotidiane.

Diane Greene e la mentalità VMware in una pagina

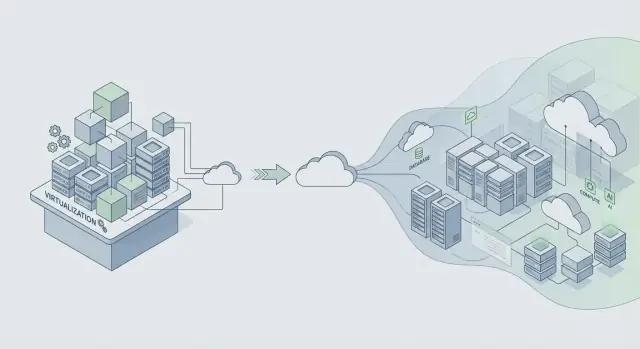

Diane Greene ha co-fondato VMware in un momento in cui l'IT aziendale affrontava un doloroso trade-off: muoversi velocemente rischiando blackout, o restare stabili accettando cambiamenti lenti. VMware è stata importante perché ha fatto comportare i server come mattoni affidabili. Questo ha permesso consolidamento, upgrade più sicuri e recovery più rapidi, senza chiedere a ogni team di riscrivere tutto.

La promessa core per l'enterprise è semplice: stabilità prima, funzionalità dopo. Le aziende vogliono capacità nuove, ma le vogliono su un sistema che continui a funzionare durante patch, scalature e errori di routine. Quando un prodotto diventa critico per il business, “lo sistemiamo la prossima settimana” si trasforma in ricavi persi, scadenze mancate e problemi di conformità.

La virtualizzazione era uno strumento pratico per l'affidabilità, non solo un risparmio di costi. Creava confini di isolamento: un workload poteva crashare senza portare giù tutta la macchina. Rendendo l'infrastruttura più ripetibile — snapshot, clone, spostamento di workload — si potevano testare le modifiche e recuperare più in fretta.

Questa mentalità vale ancora: progetta per cambiare senza downtime. Dai per scontato che i componenti falliranno, i requisiti muteranno e gli upgrade avverranno sotto carico reale. Poi costruisci abitudini che rendono il cambiamento sicuro.

Un modo rapido per descrivere la mentalità VMware è isolare i guasti in modo che un problema non si propaghi, trattare gli upgrade come routine, rendere il rollback veloce e preferire comportamenti prevedibili rispetto a trovate ingegnose. La fiducia si costruisce con affidabilità noiosa, giorno dopo giorno.

Se stai costruendo su piattaforme moderne (o generando app con strumenti come Koder.ai), la lezione rimane: rilascia funzionalità solo in modi che puoi distribuire, monitorare e annullare senza rompere le operazioni del cliente.

VMware è nato nel mondo del software confezionato dove “una release” era un grande evento. Le piattaforme cloud hanno cambiato il ritmo: piccoli cambi arrivano più spesso. Questo può essere più sicuro, ma solo se controlli il cambiamento.

La costante: il cambiamento è il rischio principale per l'affidabilità

Che tu rilasci un installer o una deploy cloud, la maggior parte dei blackout inizia allo stesso modo: arriva una modifica, si rompe un'ipotesi nascosta e il raggio d'azione è più grande del previsto. Le release più veloci non eliminano il rischio. Lo moltiplicano se mancano guardrail.

I team che scalano in modo affidabile presumono che ogni release possa fallire e costruiscono il sistema per fallire in sicurezza.

Un esempio semplice: una modifica “innocua” a un indice del database sembra ok in staging, ma in produzione aumenta la latenza delle scritture, accumula richieste e fa sembrare timeout errori di rete casuali. Le release frequenti ti danno più occasioni per introdurre sorprese di questo tipo.

L'infrastruttura condivisa ha cambiato i modi di guasto

Le app dell'era cloud spesso servono molti clienti su sistemi condivisi. I setup multi-tenant portano problemi nuovi che tuttavia applicano lo stesso principio: isolare i guasti.

Noisy neighbor (un cliente che picca rallenta gli altri) e guasti condivisi (un deploy sbagliato colpisce tutti) sono la versione moderna di “un bug porta giù il cluster”. I controlli sono familiari, però applicati continuamente: rollout graduali, controlli per tenant, limiti di risorse (quote, rate limit, timeout) e design che gestiscono il fallimento parziale.

L'osservabilità è l'altra costante. Non puoi proteggere l'affidabilità se non vedi cosa succede. Buoni log, metriche e trace ti aiutano a individuare regressioni rapidamente, specialmente durante i rollout.

Il rollback non è più una mossa d'emergenza rara. È uno strumento normale. Molti team abbinano rollback a snapshot e passi di deploy più sicuri. Piattaforme come Koder.ai includono snapshot e rollback, che possono aiutare i team a annullare cambi rischiosi rapidamente, ma il punto più importante è culturale: il rollback dovrebbe essere praticato, non improvvisato.

Fissa obiettivi di affidabilità prima di scalare

Se aspetti a definire l'affidabilità finché un contratto enterprise è sul tavolo, finisci a discutere a sentimento: “Sembra a posto.” I clienti più grandi vogliono promesse chiare che possano ripetere internamente, come “l'app resta attiva” e “le pagine caricano abbastanza velocemente durante i picchi.”

Inizia con un piccolo insieme di target scritti in linguaggio semplice. Due che i team possono concordare in fretta sono disponibilità (quanto spesso il servizio è utilizzabile) e tempo di risposta (quanto sono rapide le azioni chiave). Tieni i target legati a ciò che fanno gli utenti, non a una singola metrica di server.

Un error budget rende questi target utilizzabili nel quotidiano. È la quantità di fallimento che puoi “spendere” in un periodo pur mantenendo la promessa. Quando sei nel budget, puoi prendere più rischi sulla delivery. Quando lo consumi, il lavoro sull'affidabilità passa davanti alle nuove feature.

Per mantenere i target onesti, monitora pochi segnali che mappano l'impatto reale: latenza sulle azioni principali, errori (richieste fallite, crash, flussi interrotti), saturazione (CPU, memoria, connessioni DB, code) e disponibilità lungo il percorso critico end-to-end.

Una volta fissati i target, devono cambiare le decisioni. Se una release fa salire gli errori, non discutere: pausa, correggi o rollback.

Se usi una piattaforma che accelera lo sviluppo come Koder.ai, i target contano ancora di più. La velocità è utile solo se è vincolata a promesse di affidabilità che puoi mantenere.

Abitudini architetturali che proteggono l'affidabilità a scala

Il salto di affidabilità da “funziona per il nostro team” a “funziona per una Fortune 500” riguarda soprattutto l'architettura. Il cambio di mentalità chiave è semplice: dai per scontato che parti del sistema falliranno in una giornata normale, non solo durante un grande outage.

Progetta per il fallimento rendendo opzionali le dipendenze quando possibile. Se il tuo provider di billing, il servizio email o la pipeline di analytics è lenta, la tua app core dovrebbe comunque caricarsi, permettere il login e consentire le attività principali.

I confini di isolamento sono il tuo migliore amico. Separa il percorso critico (login, flussi core, scritture al database principale) dalle funzionalità nice-to-have (raccomandazioni, feed di attività, esportazioni). Quando le parti opzionali si rompono, devono fallire chiuse senza trascinare giù il core.

Alcune abitudini che prevengono i failure a cascata nella pratica:

- Metti timeout severi su ogni chiamata di rete.

- Ritenta solo le operazioni sicure da ripetere e aggiungi jitter per evitare storm di retry.

- Usa circuit breaker così una dipendenza fallante non consuma tutti i worker o le connessioni al DB.

- Controlla il carico con code e backpressure così i picchi diventano rallentamenti, non outage.

- Preferisci degradazione elegante: ritorna risultati parziali con un messaggio chiaro invece di un 500.

La sicurezza dei dati è il punto dove “lo sistemiamo dopo” si trasforma in downtime. Pianifica backup, cambi di schema e recovery come se ne avessi davvero bisogno, perché lo farai. Esegui drill di recovery come fai le prove antincendio.

Esempio: un team rilascia una React app con un'API in Go e PostgreSQL. Un nuovo cliente enterprise importa 5 milioni di record. Senza confini, l'import compete con il traffico normale e tutto rallenta. Con i guardrail giusti, l'import passa in una coda, scrive a batch, usa timeout e retry sicuri, e può essere messo in pausa senza impattare gli utenti giornalieri. Se costruisci su una piattaforma come Koder.ai, tratta il codice generato allo stesso modo: aggiungi questi guardrail prima che clienti reali ne dipendano.

Operazioni: la parte che la maggior parte dei prodotti introduce troppo tardi

Gli incidenti non sono la prova che hai fallito. Sono un costo normale del far girare software reale per clienti reali, specialmente quando l'uso cresce e le deploy avvengono più spesso. La differenza è se il team reagisce con calma e risolve la causa, o si affanna e ripete lo stesso blackout il mese successivo.

All'inizio molti prodotti contano su poche persone che “sanno cosa fare”. Le aziende non accetteranno questo. Vogliono risposta prevedibile, comunicazione chiara e prove che impari dai guasti.

Prontezza on-call (prima che serva)

L'on-call riguarda meno l'eroismo e più il togliere l'indecisione alle 2 di mattina. Un setup semplice copre la maggior parte di ciò che interessa i grandi clienti:

- Nomina un owner primario per ogni servizio.

- Mantieni runbook brevi per i principali modi di guasto.

- Definisci l'escalation: chi chiamare, quando e quanto velocemente.

- Esegui almeno una esercitazione programmata.

- Conserva un posto unico per controllare lo stato corrente e le modifiche recenti.

Monitoring che conta

Se gli alert suonano tutto il giorno, la gente li disabilita e l'unico incidente vero viene perso. Allerta sull'impatto utente: fallimento del login, aumento degli errori, latenza oltre una soglia chiara o job di background in arretrato.

Dopo un incidente, fai una review concentrata sulle correzioni, non sulle colpe. Cattura cosa è successo, quali segnali mancavano e quali guardrail avrebbero ridotto il raggio d'azione. Trasforma questo in una o due modifiche concrete, assegna un owner e imposta una scadenza.

Questi fondamenti operativi separano un “app che funziona” da un servizio che i clienti possono veramente fidarsi.

Passo dopo passo: indurire la tua app per clienti più grandi

I clienti più grandi raramente chiedono prima nuove feature. Chiedono: “Possiamo fidarci che funzioni in produzione, ogni giorno?” Il modo più veloce per rispondere è seguire un piano di hardening e produrre prove, non promesse.

Un piano pratico di hardening in 5 step

-

Elenca cosa soddisfi già e cosa manca. Scrivi le aspettative enterprise che puoi onestamente supportare oggi (target di uptime, controllo accessi, audit log, retention dei dati, data residency, SSO, orari di supporto). Segna ciascuno come pronto, parziale o non ancora. Questo trasforma una pressione vaga in un backlog corto.

-

Aggiungi sicurezza nelle release prima di spedire altro. Alle aziende interessa meno quanto spesso deployi e più se puoi deployare senza incidenti. Usa uno staging che rispecchi la produzione. Usa feature flag per i cambi rischiosi, canary per rollout graduali e un piano di rollback eseguibile rapidamente. Se la piattaforma supporta snapshot e rollback (Koder.ai lo fa), esercita il ripristino di una versione precedente finché non diventa memoria muscolare.

-

Dimostra la protezione dei dati, e poi dimostrala di nuovo. I backup non sono una casella da spuntare. Pianifica backup automatici, definisci la retention e fai test di restore con cadenza. Aggiungi audit trail per azioni chiave (cambi admin, esportazioni dati, modifiche ai permessi) così i clienti possono investigare e soddisfare esigenze di compliance.

-

Documenta supporto e risposta agli incidenti in linguaggio semplice. Scrivi una pagina promessa: come segnalare un incidente, tempi di risposta attesi, chi comunica gli aggiornamenti e come fate i post-incident report.

-

Esegui una review di readiness con un piano realistico di load test. Scegli uno scenario enterprise-like e testalo end-to-end: traffico di picco, database lento, un nodo che fallisce e un rollback. Esempio: un nuovo cliente importa 5 milioni di record il lunedì mattina mentre 2.000 utenti fanno login e generano report. Misura cosa si rompe, risolvi il collo di bottiglia principale e ripeti.

Segui questi cinque passi e le conversazioni di vendita diventano più semplici perché puoi mostrare il lavoro fatto.

Una storia realistica di scaling: un nuovo cliente enterprise

Un'app SaaS di medie dimensioni ha qualche centinaio di clienti e un team piccolo. Firma il suo primo cliente regolamentato: una banca regionale. Il contratto include aspettative strette di uptime, controlli accessi rigorosi e la promessa di rispondere rapidamente a domande di sicurezza. Nulla delle funzionalità principali cambia, ma le regole intorno all'esecuzione sì.

Nei primi 30 giorni il team implementa upgrade “invisibili” che però i clienti percepiscono. Il monitoring passa da “siamo su?” a “cosa è rotto, dove e per chi?” Aggiungono dashboard per servizio e alert legati all'impatto utente, non al rumore della CPU. I controlli di accesso vengono formalizzati: autenticazione più forte per azioni admin, ruoli revisionati e accesso in produzione registrato e limitato nel tempo. L'auditabilità diventa un requisito di prodotto, con log coerenti per login falliti, cambi permessi, esportazioni dati e modifiche di configurazione.

Due settimane dopo, una release va male. Una migrazione al database impiega più tempo del previsto e inizia a timeoutare le richieste per un sottoinsieme di utenti. Ciò che evita un incidente di più giorni è la disciplina di base: piano di rollback chiaro, un incident lead unico e uno script di comunicazione.

Pausano il rollout, deviano il traffico dalla strada lenta e rollbackano all'ultima versione conosciuta buona. Se la tua piattaforma supporta snapshot e rollback (Koder.ai lo fa), può essere molto più veloce, ma serve comunque una procedura praticata. Durante il recovery inviano aggiornamenti brevi ogni 30 minuti: cosa è impattato, cosa si sta facendo e quando il prossimo check-in.

Un mese dopo il “successo” è noioso nel senso migliore. Gli alert sono meno, ma più significativi. Il recupero è più rapido perché la responsabilità è chiara: una persona on-call, una persona che coordina e una che comunica. La banca smette di chiedere “state controllando?” e inizia a chiedere “quando possiamo estendere il rollout?”

Trappole comuni che danneggiano l'affidabilità mentre cresci

La crescita cambia le regole. Più utenti, più dati e clienti più grandi significano che piccoli buchi diventano outage, incidenti rumorosi o thread di supporto lunghi. Molti di questi problemi sembrano “accettabili” finché non firmi il primo grande contratto.

Le trappole più comuni:

- Rilasciare velocemente senza una via di undo sicura. Se non puoi rollbackare in minuti, ogni deploy diventa un evento ad alto rischio.

- Fare dell'affidabilità “colpa solo degli ingegneri”. Gli outage sono anche un problema di supporto e comunicazione. Se il support non ha aggiornamenti chiari, la correzione tecnica arriva troppo tardi per salvare la fiducia.

- Rumore di alert che insegna a ignorare gli allarmi. Se tutto fa paginare, nulla è urgente.

- Presumere che i backup significhino restore possibile. I backup mostrano che i dati sono stati salvati, non che puoi recuperare velocemente.

- Feature enterprise one-off che indeboliscono il core. Comportamenti custom, flag nascosti e deploy speciali aumentano la superficie di test e rendono più difficile diagnosticare gli incidenti.

Esempio semplice: un team aggiunge un'integrazione personalizzata per un grande cliente e la deploya come hotfix venerdì sera. Non c'è rollback veloce, gli alert sono già rumorosi e la persona on-call sta indovinando. Il bug è piccolo, ma il recovery si trascina per ore perché la via di ripristino non è mai stata testata.

Se la tua checklist di readiness contiene solo voci tecniche, ampliarla. Includi rollback, drill di restore e un piano di comunicazione che il support possa eseguire senza l'ingegnere in stanza.

Checklist di prontezza enterprise (verifiche rapide)

Quando i clienti più grandi chiedono “Siete pronti per l'enterprise?”, di solito chiedono una cosa: possiamo fidarci di questo in produzione? Usa questo come self-audit rapido prima di promettere niente in una call di vendita.

- Affidabilità e incidenti sono definiti (non impliciti). Hai target chiari di uptime e performance, monitoring con alert e un processo incidenti che le persone seguono davvero.

- Basi di sicurezza applicate di default. L'accesso segue il principio del least privilege, le azioni admin sono loggate e chiavi/segreti hanno un owner e un piano di rotazione.

- I dati possono essere recuperati intenzionalmente, non per caso. I backup sono automatici, i restore sono testati a calendario e sai spiegare migrazioni e retention in linguaggio semplice.

- Le release sono controllate e reversibili. Puoi fare staged release, rollback rapidi e hai un processo di approvazione semplice (anche solo una nota di modifica e un secondo paio d'occhi).

- Le promesse di supporto corrispondono alla realtà. Hai un workflow di supporto (intake, severità, tempi di risposta) e un owner chiaro per le escalation.

Prima di mostrare una demo, raccogli prove che puoi mostrare senza filosofeggiare: screenshot del monitoring che mostrano tasso di errori e latenza, un esempio redatto di audit log (“chi ha fatto cosa e quando”), una nota breve di un drill di restore (cosa hai ripristinato e quanto ci hai messo) e una pagina sulla release e rollback.

Se costruisci app su una piattaforma come Koder.ai, tratta queste verifiche allo stesso modo. Target, evidenze e abitudini ripetibili contano più degli strumenti usati.

La prontezza enterprise non è uno sforzo una tantum prima di un grande contratto. Trattala come una routine che mantiene il prodotto calmo sotto pressione, anche quando team, traffico e aspettative dei clienti crescono.

Trasforma la checklist in un piano d'azione breve. Scegli i top 3 gap che creano più rischio, rendili visibili e assegna owner e date realistiche. Definisci il “fatto” in termini semplici (per esempio, “l'alert scatta entro 5 minuti” o “restore testato end-to-end”). Tieni una piccola corsia nel backlog per i blocker enterprise così il lavoro urgente non sparisce.

Quando chiudi un gap, documenta cosa è cambiato così i nuovi membri del team possono ripetere il processo.

Crea un documento interno di readiness che riusi per ogni grande prospect. Mantienilo corto e aggiornalo dopo ogni conversazione significativa con un cliente. Un formato semplice funziona bene: target di reliability, basi di sicurezza, gestione dei dati, deploy e rollback e chi è on-call.

Fai revisioni di reliability mensili legate a eventi reali, non a opinioni. Usa incidenti e quasi-incidenti come agenda: cosa è fallito, come lo hai rilevato, come hai recuperato e cosa impedirà la ripetizione.

Se costruisci con Koder.ai, incorpora la readiness nel modo in cui rilasci. Usa Planning Mode presto per mappare i requisiti enterprise prima di impegnarti nelle build e sfrutta snapshot e rollback durante i rilasci così le correzioni rimangono a basso stress man mano che il processo matura. Se vuoi un posto unico per centralizzare quel flusso di lavoro, koder.ai è pensato per costruire e iterare via chat mantenendo controlli pratici come export del codice, deployment e rollback a portata di mano.