Perché la chiarezza conta nel cloud-native

Gli strumenti cloud-native promettono velocità e flessibilità, ma introducono anche nuovo vocabolario, nuove componenti e nuovi modi di pensare le operazioni. Quando la spiegazione è confusa, l'adozione rallenta per una ragione semplice: le persone non riescono a collegare con sicurezza lo strumento ai problemi che hanno davvero. I team esitano, i leader rimandano decisioni e i primi esperimenti diventano pilot a metà.

La chiarezza cambia questa dinamica. Una spiegazione chiara trasforma “Kubernetes spiegato” da slogan di marketing a comprensione condivisa: cosa fa Kubernetes, cosa non fa e di cosa il tuo team è responsabile quotidianamente. Una volta che quel modello mentale è presente, le conversazioni diventano pratiche—sui carichi di lavoro, l'affidabilità, la scalabilità, la sicurezza e le abitudini operative necessarie per gestire sistemi in produzione.

Perché buone spiegazioni accelerano l'adozione

Quando i concetti vengono esposti in linguaggio semplice, i team:

- Valutano i trade-off più velocemente (e smettono di considerare ogni funzione come obbligatoria).

- Identificano i prerequisiti precocemente (competenze, ownership, on‑call).

- Riducano la paura di “rompere la produzione” perché il sistema sembra conoscibile.

- Costruiscono allineamento tra sviluppatori, ops, SRE e leadership.

In altre parole, la comunicazione non è un optional; fa parte del piano di rollout.

Cosa imparerai in questo articolo

Questo pezzo si concentra su come lo stile didattico di Kelsey Hightower ha reso concetti core di DevOps e i fondamenti di Kubernetes più accessibili—e come quell'approccio abbia influenzato l'adozione cloud-native più ampia. Ne ricaverai lezioni applicabili nella tua organizzazione:

- Come spiegare decisioni di platform engineering senza gergo.

- Come insegnare il “perché” dietro l'eccellenza operativa, non solo il “come.”

- Come la condivisione di conoscenza guidata dalla community accelera l'adozione reale.

Lo scopo non è dibattere sugli strumenti. È mostrare come una comunicazione chiara—ripetuta, condivisa e migliorata dalla community—possa portare un'intera industria dalla curiosità all'uso fiducioso.

Chi è Kelsey Hightower (e perché la gente lo ascolta)

Kelsey Hightower è un noto educatore su Kubernetes e una voce della community il cui lavoro ha aiutato molti team a capire cosa comporta davvero l'orchestrazione di container—soprattutto le parti operative che le persone tendono a imparare alla peggio.

È stato visibile in ruoli pratici e pubblici: speaker a conferenze di settore, autore di tutorial e talk, e partecipante alla community cloud‑native dove i praticanti condividono pattern, fallimenti e soluzioni. Invece di presentare Kubernetes come un prodotto magico, il suo approccio tende a trattarlo come un sistema da operare—con parti in movimento, compromessi e reali modalità di guasto.

Una voce che risuona con chi fa operazioni (e con i principianti)

Ciò che emerge costantemente è l'empatia per le persone che sono sul campo quando qualcosa si rompe: ingegneri on‑call, team di piattaforma, SRE e sviluppatori che cercano di rilasciare mentre imparano nuova infrastruttura.

Quell'empatia si vede in come spiega:

- Di cosa è responsabile Kubernetes (e cosa non lo è).

- Da dove nasce la complessità (sistemi distribuiti, rete, identità, upgrade).

- Come costruire intuizione invece di memorizzare comandi.

Si vede anche nel modo in cui si rivolge ai principianti senza parlare dall'alto: il tono è diretto, concreto e prudente nelle affermazioni—più “ecco cosa succede sotto il cofano” che “questa è l'unica strada giusta.”

Lavoro osservabile più che personalità

Non serve trasformare nessuno in una mascotte per vedere l'impatto. L'evidenza è nel materiale stesso: talk ampiamente citati, risorse pratiche di apprendimento e spiegazioni riutilizzate da altri educatori e team di piattaforma interni. Quando qualcuno dice di aver “finalmente capito” un concetto come control plane, certificati o bootstrap di cluster, spesso è perché qualcuno lo ha spiegato chiaramente—e molte di quelle spiegazioni rimandano al suo stile didattico.

Se l'adozione di Kubernetes è in parte un problema di comunicazione, la sua influenza ricorda che l'insegnamento chiaro è anche una forma di infrastruttura.

Kubernetes prima che diventasse accessibile

Prima che Kubernetes diventasse la risposta predefinita a “come eseguiamo container in produzione?”, spesso sembrava un muro denso di nuovo vocabolario e assunzioni. Anche i team già a loro agio con Linux, CI/CD e servizi cloud si trovavano a fare domande di base—per poi sentirsi come se non dovessero farle.

Confusione iniziale: nuovi termini, nuovi modelli mentali

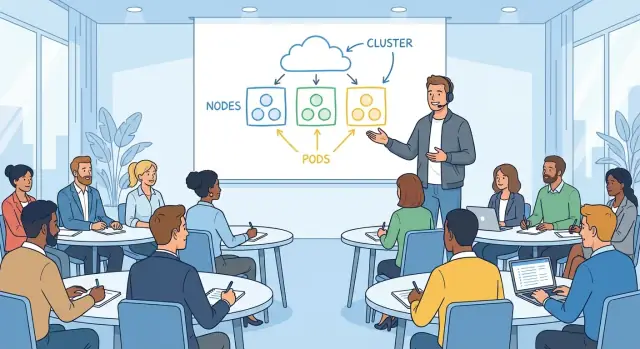

Kubernetes ha introdotto un modo diverso di pensare le applicazioni. Invece di “un server esegue la mia app”, all'improvviso hai pod, deployment, service, ingress, controller e cluster. Ogni termine suona semplice da solo, ma il significato dipende da come si collega al resto.

Un punto di attacco comune era lo scollamento del modello mentale:

- “Dove faccio SSH?” (Spesso: non lo fai.)

- “Su quale macchina è la mia app?” (Può cambiare.)

- “Perché si è riavviata?” (È progettata per farlo.)

Non si trattava solo di imparare uno strumento; era imparare un sistema che tratta l'infrastruttura come fluida.

Paure comuni: affidabilità, sicurezza e operazioni day‑2

La prima demo può mostrare un container che si scala senza problemi. L'ansia arriva dopo, quando le persone immaginano le vere domande operative:

- Cosa succede in caso di failure di un nodo?

- Come gestiamo i segreti in modo sicuro?

- Chi ha accesso a cosa nel cluster?

- Come patchiamo, aggiorniamo e rollbackiamo senza rompere la produzione?

Molti team non avevano paura dello YAML—avevano paura della complessità nascosta, dove gli errori possono rimanere silenti fino a un outage.

Il divario tra promesse di marketing e setup reale

Spesso Kubernetes veniva presentato come una piattaforma ordinata in cui “basta distribuire” e tutto è automatizzato. In pratica, arrivarci richiede scelte: rete, storage, identità, policy, monitoring, logging e strategia di upgrade.

Quel divario generava frustrazione. La gente non rifiutava Kubernetes; reagiva alla difficoltà di collegare la promessa (“semplice, portabile, self‑healing”) ai passi necessari per renderla vera nel proprio ambiente.

Uno stile di insegnamento pensato per ingegneri che lavorano

Kelsey Hightower insegna come qualcuno che è stato on‑call, ha avuto un deploy che è andato storto e ha comunque dovuto consegnare il giorno dopo. L'obiettivo non è impressionare con il vocabolario—è aiutarti a costruire un modello mentale che puoi usare alle 2 del mattino quando squilla il pager.

Linguaggio semplice, nel momento in cui serve

Una pratica chiave è definire i termini nel momento in cui contano. Invece di buttare un paragrafo di vocabolario Kubernetes all'inizio, spiega un concetto nel contesto: cos'è un Pod e perché raggruppi container, o cosa fa un Service quando la domanda è “come raggiungono le richieste la mia app?”.

Questo approccio riduce la sensazione di “essere indietro” che molti ingegneri provano con i temi cloud‑native. Non serve memorizzare un glossario; impari seguendo un problema fino alla sua soluzione.

Esempi concreti più che diagrammi astratti

Le sue spiegazioni tendono a partire da qualcosa di tangibile:

- “Se questo processo muore, cosa lo riavvia?”

- “Se il nodo scompare, cosa succede al traffico?”

- “Se passiamo da 2 a 20 istanze, come continuano a connettersi i client?”

Quelle domande portano naturalmente ai primitivi di Kubernetes, ma sono ancorate a scenari riconoscibili. I diagrammi aiutano, ma non sono la lezione intera—l'esempio fa il grosso del lavoro.

Rispetto per la realtà operativa

La didattica include le parti poco gloriose: upgrade, incidenti e compromessi. Non è “Kubernetes lo rende facile”, è “Kubernetes ti dà meccanismi—ora devi operarli”.

Questo significa riconoscere vincoli:

- Il version skew e la pianificazione degli upgrade non sono opzionali.

- L'osservabilità non è una casellina da spuntare; è come si debugga un guasto distribuito.

- Il carico on‑call fa parte del design del sistema, non è un ripensamento.

Per questo il suo contenuto risuona con chi lavora in produzione: tratta la produzione come classe e la chiarezza come forma di rispetto.

“Kubernetes the Hard Way”: imparare le fondamenta

Crea un'app didattica per Kubernetes

Genera un piccolo servizio web in Koder.ai da usare in demo, esercitazioni e documentazione.

“Kubernetes the Hard Way” è memorabile non perché sia difficile per il gusto di esserlo, ma perché ti fa toccare le parti che la maggior parte dei tutorial nasconde. Invece di cliccare in un wizard di servizio gestito, componi un cluster pezzo per pezzo. Questo “imparare facendo” trasforma l'infrastruttura da scatola nera a sistema che puoi ragionare.

Com'è l'apprendimento pratico

Il walkthrough ti fa creare i mattoni fondamentali: certificati, kubeconfig, componenti del control plane, rete e setup dei nodi worker. Anche se non hai intenzione di gestire Kubernetes in quel modo in produzione, l'esercizio insegna di cosa si occupa ciascun componente e cosa può andare storto quando è mal configurato.

Non senti solo che “etcd è importante”—vedi perché conta, cosa memorizza e cosa succede se non è disponibile. Non memorizzi solo “l'API server è la porta d'ingresso”—la configuri e capisci quali chiavi controlla prima di accettare le richieste.

Perché partire dalle basi costruisce fiducia

Molti team esitano ad adottare Kubernetes perché non sanno cosa succede sotto il cofano. Partire dalle basi ribalta quella sensazione. Quando capisci la catena di fiducia (certificati), la fonte di verità (etcd) e l'idea del control loop (i controller riconciliano stato desiderato e reale), il sistema sembra meno misterioso.

Quella fiducia è pratica: ti aiuta a valutare funzionalità dei vendor, interpretare incidenti e scegliere default sensati. Puoi dire “sappiamo cosa sta astrando questo servizio gestito”, invece di sperare sia corretto.

Passo dopo passo riduce la paura della complessità

Un buon walkthrough divide “Kubernetes” in piccoli passi testabili. Ogni passo ha un esito atteso chiaro—il servizio parte, un health check passa, un nodo si unisce. Il progresso è misurabile e gli errori sono localizzati.

Questa struttura abbassa l'ansia: la complessità diventa una serie di decisioni comprensibili, non un salto unico nel vuoto.

Rendere comprensibili i concetti core di Kubernetes

Gran parte della confusione nasce dal trattarlo come un insieme di funzionalità invece che come una promessa semplice: dichiari cosa vuoi e il sistema prova a far corrispondere la realtà a quella dichiarazione.

Stato desiderato (ciò che vuoi)

Lo “stato desiderato” è solo il tuo team che scrive il risultato che si aspetta: esegui tre copie di questa app, esponila su un indirizzo stabile, limita quanta CPU può usare. Non è un runbook passo‑passo.

Questa distinzione è importante perché rispecchia il lavoro operativo quotidiano. Invece di “SSH sul server A, avvia processo, copia config”, dichiari l'obiettivo e lasci alla piattaforma i passi ripetitivi.

Riconciliazione (come si mantiene)

La riconciliazione è il loop costante di verifica e correzione. Kubernetes confronta ciò che è in esecuzione con ciò che hai chiesto e, se qualcosa è fuori posto—un'app è crashata, un nodo è sparito, una config è cambiata—interviene per chiudere il divario.

In termini umani: è come avere un ingegnere on‑call che non dorme mai, che riapplica continuamente lo standard concordato.

Qui separare concetti da dettagli d'implementazione aiuta: il concetto è “il sistema corregge la deriva”. L'implementazione può coinvolgere controller, replica set o strategie di rollout—ma puoi apprendere questi dettagli dopo senza perdere l'idea centrale.

Scheduling (dove gira)

Lo scheduling risponde a una domanda pratica che ogni operatore riconosce: su quale macchina deve girare questo carico? Kubernetes guarda capacità disponibile, vincoli e policy, poi piazza il lavoro sui nodi.

Collegare i primitivi a compiti familiari fa scattare la comprensione:

- Pod sono un'unità eseguibile (come un gruppo di processi).

- Deployment significa “mantieni N copie in esecuzione e aggiorna in sicurezza”.

- Service è “dammi un modo stabile per raggiungerlo, anche quando le istanze cambiano”.

Una volta inquadrato Kubernetes come “dichiara, riconcilia, piazza”, il resto diventa vocabolario—utile, ma non più misterioso.

Spiegare le operazioni senza intimidire

Il linguaggio operativo può sembrare una lingua privata: SLI, error budget, “blast radius”, “capacity planning”. Quando le persone si sentono escluse, annuiscono o evitano l'argomento—entrambi i risultati portano a sistemi fragili.

Lo stile di Kelsey rende le operations normali ingegneria: una serie di domande pratiche che si imparano a porre, anche da principianti.

Traduci le ops in decisioni quotidiane

Invece di trattare le operations come astratte “best practice”, traducile in cosa il tuo servizio deve fare sotto stress.

L'affidabilità diventa: Cosa si rompe prima e come lo noteremo? La capacità diventa: Cosa succede al traffico il lunedì mattina? I failure mode diventano: Quale dipendenza ci mente, va in timeout o ritorna dati parziali? L'osservabilità diventa: Se un cliente si lamenta, riusciamo a rispondere “cosa è cambiato” in cinque minuti?

Quando i concetti ops vengono formulati così, smettono di suonare come trivia e diventano buon senso.

Rendi espliciti (e accettabili) i compromessi

Le ottime spiegazioni non affermano un'unica via corretta—mostrano il costo di ogni scelta.

Semplicità vs. controllo: un servizio gestito riduce il lavoro manuale, ma può limitare tuning di basso livello.

Velocità vs. sicurezza: rilasciare in fretta può significare meno controlli oggi, ma aumenta la probabilità di dover debugare in produzione domani.

Nominarli chiaramente permette ai team di discutere produttivamente senza far sentire qualcuno inadeguato.

Normalizza domande, errori e iterazione

Le operations si imparano osservando incidenti reali e quasi‑incidenti, non memorizzando terminologia. Una cultura operativa sana tratta le domande come lavoro, non come debolezza.

Un'abitudine pratica: dopo un outage o un alert preoccupante, annota tre cose—cosa ti aspettavi, cosa è successo e quale segnale ti avrebbe avvertito prima. Quel piccolo ciclo trasforma confusione in runbook migliori, dashboard più chiare e on‑call più tranquille.

Se vuoi che questa mentalità si diffonda, insegnala allo stesso modo: parole semplici, compromessi onesti e permesso di imparare ad alta voce.

Condividi un link demo pulito

Aggiungi un dominio personalizzato al tuo sandbox così gli stakeholder possono provarlo senza configurazioni.

Le spiegazioni chiare non aiutano solo una persona a “capire”. Viaggiano. Quando un relatore o un autore rende Kubernetes concreto—mostrando cosa fa ogni pezzo, perché esiste e dove fallisce nella vita reale—quelle idee vengono ripetute nei corridoi, copiate nei documenti interni e reinsegnate ai meetup.

Un vocabolario condiviso che riduce l'attrito

Kubernetes ha molti termini che suonano familiari ma hanno significati specifici: cluster, node, control plane, pod, service, deployment. Quando le spiegazioni sono precise, i team smettono di parlare oltre l'altro.

Alcuni esempi di come un vocabolario condiviso si manifesta:

- Uno sviluppatore dice “il Service è rotto” e tutti capiscono se si tratta di DNS, bilanciamento del carico o selector.

- Un SRE dice “il control plane è degradato” e il team sa che non è la stessa cosa di “l'app è giù”.

- Le persone di prodotto sentono “deployment” e imparano che è un oggetto Kubernetes, non solo “abbiamo rilasciato codice”.

Quell'allineamento accelera debug, pianificazione e onboarding perché si spende meno tempo a tradurre.

Fiducia al posto dell'ansia

Molti ingegneri evitano Kubernetes all'inizio non perché non possano impararlo, ma perché sembra una scatola nera. L'insegnamento chiaro sostituisce il mistero con un modello mentale: “Ecco cosa parla con cosa, ecco dove vive lo stato, ecco come viene instradato il traffico.”

Quando il modello scatta, sperimentare diventa più sicuro. Le persone sono più propense a:

- lanciare un piccolo cluster per testare idee

- leggere log ed eventi senza indovinare

- porre domande migliori nelle code review e nei canali incident

L'effetto a catena: talk, meetup e doc

Quando le spiegazioni sono memorabili, la community le ripete. Un diagramma o un'analogia semplice diventa il modo predefinito di insegnare e influenza:

- presentazioni ai meetup e alle conferenze (i nuovi speaker prendono in prestito l'inquadramento)

- lo stile della documentazione open source (più “perché” insieme al “come”)

- i runbook interni e le guide di onboarding (passi più chiari, aspettative più nette)

Col tempo, la chiarezza diventa un artefatto culturale: la community impara non solo Kubernetes, ma anche come parlarne e operarlo.

Come la comunicazione ha influenzato l'adozione industriale

La comunicazione chiara non ha reso Kubernetes solo più facile da imparare—ha cambiato anche come le organizzazioni decidevano di adottarlo. Quando sistemi complessi vengono spiegati in termini semplici, il rischio percepito cala e i team possono discutere risultati invece che gergo.

Perché ai decisori importava

Dirigenti e responsabili IT raramente necessitano di ogni dettaglio implementativo, ma vogliono una narrazione credibile sui compromessi. Spiegazioni semplici di cosa è (e non è) Kubernetes hanno aiutato a inquadrare conversazioni su:

- Rischio: cosa può rompersi, cosa è stabile e cosa richiede rollout attento

- Costo e ROI: dove l'automazione riduce il lavoro manuale, dove servono più risorse e quando la standardizzazione ripaga

- Responsabilità: chi gestisce i cluster, la sicurezza e gli SLA

Presentato come blocchi costruttivi comprensibili—piuttosto che come una piattaforma magica—Kubernetes è diventabile oggetto di budget e timeline meno speculative, facilitando piloti misurabili.

Come l'educazione ha supportato l'adozione

L'adozione non è cresciuta solo grazie ai pitch dei vendor; è cresciuta con l'insegnamento. Talk significativi, demo e guide pratiche hanno creato un vocabolario condiviso tra aziende e ruoli.

Quell'educazione si è tradotta tipicamente in tre acceleratori di adozione:

- Programmi di training che riducono il tempo di onboarding per ingegneri e operatori

- Enablement interno (doc, brown‑bag, template) che trasforma conoscenza tribale in pratica riutilizzabile

- Champion che spiegano il “perché” e il “come” ai colleghi, non solo eseguono il “cosa”

Quando i team potevano spiegare concetti come stato desiderato, controller e strategie di rollout, Kubernetes diventava discutibile—and quindi adottabile.

Dove la chiarezza non basta

Anche le spiegazioni migliori non possono sostituire il cambiamento organizzativo. L'adozione di Kubernetes richiede ancora:

- nuove competenze operative (affidabilità, risposta agli incidenti, igiene della sicurezza)

- ownership chiara della piattaforma e confini di servizio

- tempo per rifattorizzare i processi di delivery, non solo “installare un cluster”

La comunicazione ha reso Kubernetes accessibile; il successo dell'adozione richiede impegno, pratica e incentivi allineati.

Lezioni pratiche per i team che adottano Kubernetes

Rendi l'onboarding meno astratto

Dai ai nuovi assunti un'app funzionante da distribuire, scalare e debuggare.

L'adozione di Kubernetes fallisce di solito per ragioni ordinarie: le persone non riescono a prevedere le operazioni day‑2, non sanno cosa imparare per primo e la documentazione dà per scontato che tutti parlino già “cluster”. La soluzione pratica è trattare la chiarezza come parte del piano di rollout—non come un ripensamento.

Costruisci due percorsi di apprendimento (e indica quale è il tuo)

La maggior parte dei team confonde “come usare Kubernetes” con “come operare Kubernetes”. Dividi la formazione in due percorsi espliciti:

- Percorso principiante: concetti base, come distribuire, come debuggare un carico semplice, cosa significa “buono”.

- Percorso operatore: ciclo di vita del cluster, upgrade, rete, confini di sicurezza, backup/restore e risposta agli incidenti.

Metti la divisione subito in cima ai tuoi documenti così i nuovi assunti non iniziano per errore nel reparto avanzato.

Fai demo come se insegnaressi un'abitudine, non come se mostrassi un prodotto

Le demo dovrebbero partire dal sistema più piccolo funzionante e aggiungere complessità solo quando serve per rispondere a una domanda reale.

Inizia con un singolo Deployment e Service. Poi aggiungi configurazione, health check e autoscaling. Solo dopo che le basi sono stabili introduci ingress controller, service mesh o operatori custom. L'obiettivo è che le persone colleghino causa ed effetto, non memorizzino YAML.

Scrivi runbook che spiegano il “perché”, non solo il “fai così”

I runbook made of sole checklist diventano operazioni cargo‑cult. Ogni passo importante dovrebbe includere una frase di rationale: quale sintomo affronta, come appare il successo e cosa potrebbe andare storto.

Per esempio: “Riavviare il pod pulisce una pool di connessioni bloccata; se si ripresenta entro 10 minuti, controlla la latenza a valle e gli eventi dell'HPA.” Quel “perché” permette a qualcuno di improvvisare quando l'incidente non corrisponde esattamente allo script.

Misura la comprensione, non la partecipazione

Capirai che la formazione funziona quando:

- Le stesse domande smettono di ripetersi su Slack.

- Il triage degli incidenti diventa più veloce perché le persone condividono un modello mentale comune.

- I postmortem includono meno momenti di “non sapevamo dove guardare”.

Monitora questi risultati e aggiusta documenti e workshop di conseguenza. La chiarezza è un deliverable—trattala come tale.

Un modo sottovalutato per far “scattare” Kubernetes e i concetti di piattaforma è lasciare che i team sperimentino servizi realistici prima di toccare gli ambienti critici. Questo può significare costruire una piccola app interna di riferimento (API + UI + database) e usarla come esempio coerente in doc, demo ed esercitazioni.

Piattaforme come Koder.ai possono aiutare qui perché puoi generare un'app web funzionante, un servizio backend e il modello dati da uno spec guidato via chat, poi iterare in una “modalità di pianificazione” prima che chiunque si preoccupi del YAML perfetto. Il punto non è sostituire l'apprendimento di Kubernetes—è accorciare il tempo da idea → servizio in esecuzione così la tua formazione può concentrarsi sul modello mentale operativo (stato desiderato, rollout, osservabilità e cambi sicuri).

Il modo più rapido per far funzionare la “piattaforma” in azienda è renderla comprensibile. Non serve che ogni ingegnere diventi esperto di Kubernetes, ma serve un vocabolario condiviso e la fiducia a debugare problemi di base senza panico.

Un framework ripetibile: definire, mostrare, praticare, diagnosticare

Definire: Parti con una frase chiara. Esempio: “Un Service è un indirizzo stabile per un insieme variabile di Pod.” Evita di dare cinque definizioni insieme.

Mostrare: Dimostra il concetto con l'esempio più piccolo possibile. Un file YAML, un comando, un risultato atteso. Se non riesci a mostrarlo velocemente, l'ambito è troppo ampio.

Praticare: Dai un compito breve che le persone possano fare da sole (anche in sandbox). “Scala questo Deployment e guarda cosa succede al Service.” L'apprendimento resta quando le mani toccano gli strumenti.

Diagnosticare: Concludi rompendo l'esempio apposta e spiegando come penseresti. “Cosa controlleresti prima: eventi, log, endpoints o network policy?” Qui cresce la fiducia operativa.

Analogie che aiutano (e come evitare di fuorviare)

Le analogie servono per orientarsi, non per precisione. “I pod sono bestiame, non animali domestici” può spiegare la sostituibilità, ma può nascondere dettagli importanti (workload stateful, volumi persistenti, disruption budget).

Una buona regola: usa l'analogia per introdurre l'idea, poi passa subito ai termini reali. Dì: “È come X in un aspetto; ecco dove smette di essere come X.” Quella frase previene malintesi costosi dopo.

Checklist per talk interni che la gente userà davvero

Prima di presentare, valida quattro cose:

- Audience: Chi è il pubblico—sviluppatori app, ingegneri on‑call, nuovi assunti?

- Obiettivo: Cosa devono saper fare dopo 30 minuti?

- Demo: Una demo funzionante, provata, con un piano B.

- Passi successivi: Un doc, un runbook o un lab guidato che possano seguire domani.

Costruisci una cultura di insegnamento, non di gatekeeping

La coerenza batte la formazione intensiva occasionale. Prova rituali leggeri:

- Ore d'ufficio settimanali per “porta il tuo problema di cluster”.

- Brown‑bag mensili con un concetto e un esempio live.

- Rotazioni di pairing tra team di piattaforma e di prodotto durante gli incidenti.

Quando insegnare diventa normale, l'adozione è più calma—e la tua piattaforma smette di sembrare una scatola nera.