Obiettivi, utenti e ambito delle revisioni di sicurezza dei fornitori

Prima di progettare schermate o scegliere un database, allineatevi su cosa l'app deve raggiungere e per chi è pensata. La gestione delle revisioni di sicurezza dei fornitori fallisce più spesso quando team diversi usano le stesse parole ("revisione", "approvazione", "rischio") con significati diversi.

Chi userà l'app

La maggior parte dei programmi ha almeno quattro gruppi di utenti, ciascuno con esigenze diverse:

- Security / GRC: possiede il processo di revisione, le domande, i requisiti di evidenza e la decisione finale sul rischio.

- Procurement / Vendor Management: ha bisogno di un intake veloce, stato chiaro e visibilità sui rinnovi per non bloccare gli acquisti all'ultimo minuto.

- Legal / Privacy: si concentra sui termini di trattamento dei dati, DPA/SCC, notifiche di breach e dove i dati sono memorizzati.

- Contatti del fornitore: vogliono un portale semplice per rispondere alle domande una sola volta, caricare evidenze e rispondere ai follow-up senza lunghe catene di email.

Implicazione di design: non state costruendo "un solo workflow". State costruendo un sistema condiviso dove ogni ruolo vede una vista curata della stessa revisione.

Cosa significa “revisione di sicurezza del fornitore” nella vostra azienda

Definite i confini del processo in linguaggio semplice. Per esempio:

- Una revisione copre solo strumenti SaaS o anche consulenti, agenzie e provider di hosting?

- L'obiettivo è confermare controlli di base o quantificare il rischio e approvare eccezioni?

- State recensendo il fornitore (a livello aziendale) o il servizio (un prodotto specifico e come voi lo usate)?

Annotate cosa attiva una revisione (nuovo acquisto, rinnovo, cambiamento materiale, nuovo tipo di dato) e cosa significa “fatto” (approvato, approvato con condizioni, rifiutato o differito).

Problemi attuali da eliminare

Rendete concreto il vostro ambito elencando cosa crea problemi oggi:

- Stato intrappolato in thread email e caselle private

- Fogli di calcolo che si disallineano, senza una singola fonte di verità

- Evidenze mancanti o scadute (SOC 2, ISO, pen test) e nessun tracciamento di scadenza

- Passaggi poco chiari tra Security, Procurement e Legal

- Nessun modo coerente per registrare decisioni, eccezioni o controlli compensativi

Questi punti dolenti diventano il backlog dei requisiti.

Metriche di successo che mantengono il progetto onesto

Scegliete alcune metriche misurabili fin dal primo giorno:

- Tempo di ciclo (intake → decisione) per tier di fornitore

- Percentuale di completamento in tempo rispetto agli SLA

- Conteggio delle revisioni scadute e giorni medi di ritardo

- Tasso di rework (revisioni inviate indietro al fornitore per informazioni mancanti)

Se l'app non può riportare queste metriche in modo affidabile, non sta davvero gestendo il programma: sta solo archiviando documenti.

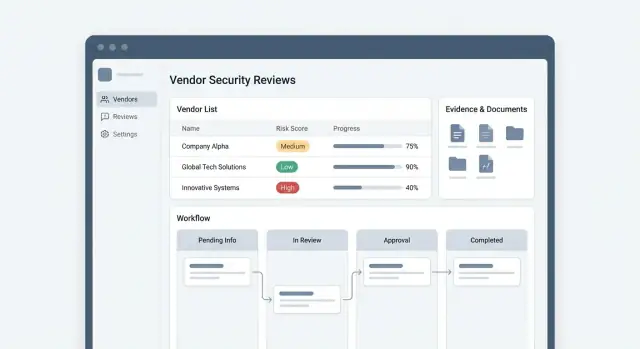

Progettazione del workflow: dall'intake all'approvazione

Un workflow chiaro fa la differenza tra “ping-pong di email” e un programma di revisione prevedibile. Prima di costruire schermate, mappate il percorso end-to-end che prende una richiesta e decidete cosa deve succedere in ogni passo per arrivare a un'approvazione.

Mappare il flusso end-to-end

Iniziate con una spina dorsale semplice e lineare che potete estendere dopo:

Intake → Triage → Questionario → Raccolta evidenze → Valutazione di sicurezza → Approvazione (o rifiuto).

Per ogni fase, definite cosa significa “completato”. Per esempio, “Questionario completo” potrebbe richiedere il 100% delle domande obbligatorie compilate e un referente di sicurezza assegnato. “Evidenze raccolte” potrebbe richiedere un set minimo di documenti (report SOC 2, riassunto pen test, diagramma di flusso dei dati) o un'eccezione giustificata.

Definire i punti di ingresso (come iniziano le revisioni)

La maggior parte delle app necessita di almeno tre modi per creare una revisione:

- Nuova richiesta fornitore: inizializzata da Procurement, IT o un owner di business

- Rinnovo: creata automaticamente in base a una data di scadenza della revisione

- Revisione attivata da incidente: creata quando si verifica una violazione del fornitore o un cambiamento materiale

Trattatele come template diversi: possono condividere lo stesso workflow ma usare priorità, questionari richiesti e date di scadenza differenti.

Stati, SLA e ownership

Rendete gli stati espliciti e misurabili—specialmente gli stati di “attesa”. Quelli comuni includono Waiting on vendor, In security review, Waiting on internal approver, Approved, Approved with exceptions, Rejected.

Collegate gli SLA al proprietario dello stato (fornitore vs team interno). Questo permette alla dashboard di mostrare “bloccato dal fornitore” separatamente dal “backlog interno”, cambiando il modo di personale e escalation.

Automazione vs giudizio umano

Automatizzate instradamento, promemoria e creazione dei rinnovi. Mantenete punti decisionali umani per l'accettazione del rischio, i controlli compensativi e le approvazioni.

Una regola utile: se un passaggio richiede contesto o compromessi, registrate un record di decisione invece di cercare di decidere automaticamente.

Modello dati core: Fornitori, Revisioni, Questionari, Evidenze

Un modello dati pulito è ciò che permette all'app di scalare da “questionario occasionale” a un programma ripetibile con rinnovi, metriche e decisioni coerenti. Trattate il fornitore come il record duraturo, e tutto il resto come attività legata al tempo ad esso collegata.

Fornitore (il profilo durevole)

Iniziate con un'entità Vendor che cambia lentamente e viene referenziata ovunque. Campi utili includono:

- Business owner (sponsor interno), dipartimento e contatti primari

- Criticità / tier (es. low/medium/high) e stato “in produzione”

- Tipi di dati trattati (PII, dati di pagamento, dati sanitari, codice sorgente, ecc.)

- Sistemi / integrazioni che toccano (SSO, data warehouse, tooling di supporto)

- Informazioni contrattuali (date di inizio/fine) in modo che i rinnovi possano essere automatizzati

Modelate tipi di dati e sistemi come valori strutturati (tabelle o enum), non testo libero, così il reporting resta accurato.

Review (una valutazione puntuale)

Ogni Review è uno snapshot: quando è iniziata, chi l'ha richiesta, scopo, tier al momento, date SLA e decisione finale (approved/approved with conditions/rejected). Salvate la motivazione della decisione e collegamenti a eventuali eccezioni.

Questionario (template e risposte)

Separate QuestionnaireTemplate da QuestionnaireResponse. I template dovrebbero supportare sezioni, domande riutilizzabili e branching (domande condizionate basate su risposte precedenti).

Per ogni domanda, definite se è richiesta evidenza, i tipi di risposta consentiti (sì/no, multi-select, upload file) e regole di validazione.

Evidenze e artefatti

Trattate upload e link come record Evidence collegati a una review e opzionalmente a una domanda specifica. Aggiungete metadata: tipo, timestamp, chi l'ha fornita e regole di retention.

Infine, memorizzate gli artefatti della review—note, riscontri, task di remediation e approvazioni—come entità di prima classe. Tenere una completa storia della review abilita rinnovi, tracking delle tendenze e review di follow-up più rapide senza riproporre tutte le domande.

Ruoli, permessi e accesso dei fornitori

Ruoli chiari e permessi stretti mantengono utile un'app di revisione senza trasformarla in un rischio di perdita dati. Progettate questo presto, perché i permessi influenzano workflow, UI, notifiche e traccia di audit.

Ruoli core da modellare

La maggior parte dei team finisce per aver bisogno di cinque ruoli:

- Requester: avvia una review (spesso Procurement, IT o business owner), traccia lo stato e risponde a domande contestuali (che dati tocca il fornitore, uso previsto, valore contrattuale).

- Reviewer: esegue la valutazione, richiede evidenze, segue e propone una decisione.

- Approver: accetta formalmente l'esito del rischio (approva, approva con condizioni, rifiuta), tipicamente leadership Security, Legal o Risk.

- Vendor respondent: completa i questionari e carica evidenze.

- Admin: gestisce template, integrazioni, assegnazioni di ruoli e impostazioni globali.

Tenete i ruoli separati dalle “persone”. Lo stesso dipendente può essere requester in una review e reviewer in un'altra.

Permessi per evidenze sensibili

Non tutti gli artefatti di review dovrebbero essere visibili a tutti. Trattate elementi come report SOC 2, risultati di penetration test, policy di sicurezza e contratti come evidenze ristrette.

Approccio pratico:

- Separate i metadata della review (nome fornitore, stato, data rinnovo) dagli allegati ristetti.

- Aggiungete una flag di visibilità per evidenza (es. “Tutti gli utenti interni”, “Solo team di revisione”, “Solo Legal + Security”).

- Loggate ogni accesso ai file ristetti (visualizzazione/download) per responsabilità.

Accesso sicuro dei fornitori (e isolamento)

I fornitori dovrebbero vedere solo ciò di cui hanno bisogno:

- Limitate gli account fornitore alla propria organizzazione e alle proprie richieste.

- Fornite una vista portal dedicata: questionari assegnati, richieste di upload e messaggistica—nient'altro.

- Disabilitate la ricerca cross-fornitore e nascondete i commenti interni per impostazione predefinita.

Delega, backup e continuità

Le review si bloccano quando una persona chiave è assente. Supportate:

- Delegati (copertura temporanea con gli stessi permessi)

- Backup di approvazione (approvatori secondari dopo una soglia SLA)

- Un'azione chiara “riassegna review” con motivo obbligatorio, catturato nel log di audit

Questo mantiene le review in movimento preservando il principio del minimo privilegio.

Un programma di revisione dei fornitori può sembrare lento quando ogni richiesta inizia con un questionario lungo. La soluzione è separare intake (rapido, leggero) dal triage (decidere il percorso corretto).

Scegliete pochi canali di intake (e manteneteli coerenti)

La maggior parte dei team necessita di tre punti di ingresso:

- Modulo di richiesta interno per i dipendenti (Procurement, Legal, Engineering) per iniziare una review

- Ticket Procurement (es. Jira/Service Desk) che può creare automaticamente un record di review

- API di intake per strumenti che sanno già quando un nuovo fornitore viene onboardato

Qualunque sia il canale, normalizzate le richieste nella stessa coda “New Intake” per non creare processi paralleli.

Raccogliete il minimo indispensabile inizialmente

Il form di intake dovrebbe essere abbastanza corto da non scoraggiare. Mirate a campi che consentano routing e prioritizzazione:

- Nome fornitore e sito web

- Business owner (requester interno) e dipartimento

- Cosa farà il fornitore (categoria/caso d'uso)

- Tipi di dati coinvolti (PII, dati pagamento, dati sanitari, nessuno)

- Livello di accesso (accesso produzione, uso interno, nessun accesso)

- Data di go-live / scadenza acquisto

Rimandate le domande di sicurezza approfondite finché non conoscete il livello di review.

Aggiungere regole di triage che creano percorsi chiari

Usate regole decisionali semplici per classificare rischio e urgenza. Per esempio, flaggate come alta priorità se il fornitore:

- Processa PII o dati di pagamento

- Ha accesso produzione o integrazione privilegiata

- È critico per le operazioni (fatturazione, autenticazione, infrastruttura core)

Instradare automaticamente alla coda e all'approvatore giusti

Una volta triaged, assegnate automaticamente:

- Il template di review corretto (lite vs full)

- La coda giusta (es. Security, Privacy, Compliance)

- Un approvatore basato su tipo di dato, regione o unità di business

Questo mantiene gli SLA prevedibili ed evita review “perse” nelle inbox.

UX per questionari e raccolta evidenze

Mappa i workflow in Planning Mode

Usa la Planning Mode per mappare entità, stati e SLA prima di generare le schermate.

La UX per questionari e evidenze è dove le revisioni o corrono veloci o si bloccano. Puntate a un flusso prevedibile per i revisori interni e realmente semplice per i fornitori.

Iniziate con template riutilizzabili per tier di rischio

Create una piccola libreria di template di questionario mappati al tier di rischio (low/medium/high). L'obiettivo è coerenza: lo stesso tipo di fornitore dovrebbe vedere le stesse domande ogni volta e i revisori non dovrebbero ricostruire i form da zero.

Tenete i template modulari:

- Un set “baseline” breve (info azienda, gestione dati, controlli accesso)

- Sezioni aggiuntive per casi ad alto rischio (incident response, SDLC, pentesting, subfornitori)

Quando viene creata una review, pre-selezionate il template in base al tier e mostrate ai fornitori un indicatore di avanzamento chiaro (es. 42 domande, ~20 minuti).

Rendete flessibile la sottomissione delle evidenze (upload + link)

I fornitori spesso hanno già artefatti come report SOC 2, certificati ISO, policy e riassunti di scan. Supportate sia upload di file che link sicuri così possono fornire quello che hanno senza frizione.

Per ogni richiesta, etichettatela in linguaggio semplice (“Carica il report SOC 2 Type II (PDF) o condividi un link a tempo limitato”) e includete un breve suggerimento “cos'è accettabile”.

Tracciate la freschezza e automatizzate i promemoria

Le evidenze non sono statiche. Memorizzate metadata accanto a ogni artefatto—data di emissione, data di scadenza, periodo di copertura e (opzionalmente) note del reviewer. Poi usate quei metadata per guidare i promemoria di rinnovo (sia per il fornitore che internamente) così la revisione annuale successiva è più rapida.

Siate vendor-friendly: guida e scadenze

Ogni pagina del fornitore dovrebbe rispondere a tre domande subito: cosa è richiesto, quando scade e chi contattare.

Usate date di scadenza chiare per ogni richiesta, permettete sottomissioni parziali e confermate la ricezione con uno stato semplice (“Submitted”, “Needs clarification”, “Accepted”). Se supportate accesso vendor, collegate i fornitori direttamente alla loro checklist invece di istruzioni generiche.

Punteggio del rischio, eccezioni e registrazione delle decisioni

Una review non è finita quando il questionario è “completo”. Serve un modo ripetibile per tradurre risposte ed evidenze in una decisione che stakeholder e auditor possano fidarsi e tracciare.

Un approccio di scoring che rimanga comprensibile

Iniziate con il tier basato sull'impatto del fornitore (es. sensibilità dati + criticità del sistema). Il tier stabilisce il livello di esame: un processore pagamenti e un servizio di consegna snack non devono essere valutati allo stesso modo.

Poi valutate all'interno del tier usando controlli pesati (crittografia, controlli accesso, incident response, copertura SOC 2, ecc.). Tenete visibili i pesi così i revisori possono spiegare i risultati.

Aggiungete red flag che possano sovrascrivere il punteggio numerico—elementi come “assenza MFA per accesso admin”, “breach noto senza piano di remediation” o “impossibilità di supportare la cancellazione dei dati”. I red flag devono essere regole esplicite, non intuizione del revisore.

Eccezioni senza perdere il controllo

La realtà richiede eccezioni. Modulatele come oggetti di prima classe con:

- Tipo: controllo compensativo, accesso a scope limitato, approvazione temporanea

- Owner: chi accetta il rischio

- Scadenza: basata su data, con promemoria di rinnovo

- Condizioni: cambiamenti richiesti (es. abilitare SSO entro 60 giorni)

Questo permette al business di procedere pur serrando il rischio nel tempo.

Registrare decisioni e follow-up richiesti

Ogni esito (Approve / Approve with conditions / Reject) dovrebbe catturare rationale, evidenze collegate e task di follow-up con date di scadenza. Questo evita la “conoscenza tribale” e accelera i rinnovi.

Un riassunto del rischio semplice per gli stakeholder

Esponete una vista “risk summary” a pagina unica: tier, punteggio, red flags, stato delle eccezioni, decisione e prossime milestone. Mantenetela leggibile per Procurement e leadership—i dettagli restino a un click più in profondità nel record completo della review.

Collaborazione, approvazioni e traccia di audit

Guadagna crediti con i referral

Crea contenuti o fai riferimento a colleghi per ottenere crediti per il tempo trascorso su Koder.ai.

Le review di sicurezza si bloccano quando il feedback è sparso tra email e note di riunione. La vostra app dovrebbe rendere la collaborazione la modalità predefinita: un record condiviso per ogni review, con ownership chiara, decisioni e timestamp.

Supportate commenti threadati sulla review, su singole domande del questionario e sugli elementi di evidenza. Aggiungete @mention per instradare il lavoro alle persone giuste (Security, Legal, Procurement, Engineering) e creare un feed di notifiche leggero.

Separate le note in due tipi:

- Note interne (solo la vostra organizzazione): pensieri di triage, motivazioni di rischio, punti di negoziazione e promemoria.

- Note visibili al fornitore: chiarimenti e richieste che il fornitore può agire.

Questa separazione previene oversharing accidentale mantenendo il fornitore reattivo.

Approvazioni, incluse approvazioni condizionate

Modellate le approvazioni come firme esplicite, non uno stato che qualcuno può modificare casualmente. Un pattern efficace è:

- Approve

- Reject

- Approve with conditions (piano di remediation)

Per l'approvazione condizionata, catturate: azioni richieste, scadenze, chi verifica e quale evidenza chiuderà la condizione. Questo consente al business di andare avanti mantenendo il lavoro di rischio misurabile.

Task, owner e sincronizzazione opzionale con ticket

Ogni richiesta dovrebbe trasformarsi in un task con owner e data di scadenza: “Review SOC 2”, “Confermare clausola retention”, “Validare impostazioni SSO”. Rendete i task assegnabili a utenti interni e, quando appropriato, ai fornitori.

Opzionalmente sincronizzate i task con strumenti di ticketing come Jira per far combaciare i workflow esistenti—mantenendo però la review come sistema di record.

Una traccia di audit completa

Mantenete una traccia di audit immutabile per: modifiche ai questionari, upload/cancellazione evidenze, cambi di stato, approvazioni e chiusure di condizioni.

Ogni voce dovrebbe includere chi l'ha fatta, quando, cosa è cambiato (prima/dopo) e la ragione quando rilevante. Fatto bene, questo supporta le audit, riduce il rework al rinnovo e rende il reporting credibile.

Integrazioni: SSO, ticketing, messaggistica e storage

Le integrazioni decidono se la vostra app per le revisioni dei fornitori sembra “un altro tool” o un'estensione naturale del lavoro esistente. L'obiettivo è semplice: minimizzare l'inserimento dati duplicato, mantenere le persone nei sistemi che già controllano e assicurare che evidenze e decisioni siano facili da trovare dopo.

SSO per utenti interni (e accesso vendor semplice)

Per i revisori interni, supportate SSO via SAML o OIDC in modo che l'accesso si allinei con il vostro identity provider (Okta, Azure AD, Google Workspace). Questo rende on/offboarding affidabile e abilita mapping di ruoli basati sui gruppi (es. “Security Reviewers” vs “Approvers”).

I fornitori di solito non dovrebbero aver bisogno di account completi. Un pattern comune è link magici a tempo limitati e vincolati a uno specifico questionario o richiesta di evidenza. Abbinate questo a verifica email opzionale e regole chiare di scadenza per ridurre la frizione mantenendo il controllo dell'accesso.

Quando una review richiede correzioni, i team spesso le tracciano in Jira o ServiceNow. Integrate in modo che i revisori possano creare ticket di remediation direttamente da un finding, precompilati con:

- nome fornitore e ID review

- sistema/prodotto interessato

- controllo richiesto e data di scadenza

- severità e criteri di accettazione consigliati

Sincronizzate lo stato del ticket (Open/In Progress/Done) con la vostra app così gli owner della review vedono i progressi senza inseguire aggiornamenti.

Messaggistica: Slack/Teams per scadenze e approvazioni

Aggiungete notifiche leggere dove le persone già lavorano:

- scadenze imminenti per questionari e upload evidenze

- richieste di approvazione con link profondo a una singola azione

- rimandi quando gli SLA stanno per essere violati

Mantenete i messaggi azionabili ma minimali e permettete agli utenti di configurare la frequenza per evitare fatigue da notifiche.

Archiviazione documenti (con controlli di accesso)

Le evidenze spesso vivono in Google Drive, SharePoint o S3. Integrate memorizzando riferimenti e metadata (ID file, versione, uploader, timestamp) ed enforce il principio del minimo privilegio.

Evitate di copiare file sensibili inutilmente; quando memorizzate file, applicate crittografia, regole di retention e permessi per review stretti.

Un approccio pratico: i link alle evidenze vivono nell'app, l'accesso è governato dal vostro IdP e i download sono loggati per l'audit.

Requisiti di sicurezza e privacy per l'app web

Uno strumento di revisione dei fornitori diventa presto un deposito di materiale sensibile: report SOC, sintesi di pen test, diagrammi di architettura, questionari di sicurezza e talvolta dati personali (nomi, email, telefoni). Trattatelo come un sistema interno ad alto valore.

Proteggere gli upload di evidenze

L'evidenza è la superficie di rischio maggiore perché accetta file non fidati.

Impostate vincoli chiari: whitelist di tipi di file, limiti di dimensione e timeout per upload lenti. Eseguite scansione malware su ogni file prima che sia disponibile ai revisori e quarantinate qualsiasi cosa sospetta.

Conservate i file crittografati a riposo (idealmente con chiavi per-tenant se servite più unità di business). Usate link di download firmati e a vita breve ed evitate di esporre percorsi diretti ad object storage.

Applicare default sicuri ovunque

La sicurezza deve essere il comportamento predefinito, non un'opzione di configurazione.

Usate il minimo privilegio: nuovi utenti iniziano con accesso minimo e gli account vendor vedono solo le proprie richieste. Proteggete form e sessioni con difese CSRF, cookie sicuri e scadenze di sessione rigorose.

Aggiungete rate limiting e controlli anti-abuso per login, endpoint di upload ed esportazioni. Validate e sanitize tutti gli input, specialmente campi di testo libero che potrebbero essere renderizzati nell'interfaccia.

Logging e auditability per azioni sensibili

Loggate l'accesso alle evidenze e gli eventi chiave del workflow: visualizzazione/download file, esportazioni report, modifiche al punteggio rischio, approvazione eccezioni e modifica permessi.

Rendete i log tamper-evident (archiviazione append-only) e ricercabili per fornitore, review e utente. Create un'interfaccia "audit trail" così stakeholder non tecnici possono rispondere a “chi ha visto cosa e quando?” senza scavare nei log grezzi.

Retention, cancellazione e blocchi legali

Definite per quanto tempo conservate questionari ed evidenze e rendetelo applicabile.

Supportate politiche di retention per vendor/tipo di review, workflow di cancellazione che includono file ed esportazioni derivate e flag di “legal hold” che sovrascrivono la cancellazione quando necessario. Documentate questi comportamenti nelle impostazioni prodotto e nelle policy interne e assicuratevi che le cancellazioni siano verificabili (es. ricevute di cancellazione e voci di audit amministrativo).

Reporting, dashboard e gestione rinnovi

Aggiungi la traccia di audit fin dal primo giorno

Implementa log di eventi e registri di approvazione fin dal primo giorno con coding guidato dalla chat.

Il reporting è dove il vostro programma di review diventa gestibile: smettete di inseguire aggiornamenti via email e iniziate a guidare il lavoro con visibilità condivisa. Puntate a dashboard che rispondono a “cosa succede adesso?” più esportazioni che soddisfino gli auditor senza lavoro manuale su fogli di calcolo.

Dashboard che spingono all'azione

Una home utile è meno chart e più code. Include:

- Pipeline delle review per stato (Intake, In Progress, Waiting on Vendor, Waiting on Approver, Approved/Rejected)

- Elementi scaduti (questionari, richieste evidenze, approvazioni) con owner e date di scadenza chiare

- Fornitori ad alto rischio e review “alto rischio + bloccate” che richiedono escalation

Rendete i filtri di prima classe: unità di business, criticità, reviewer, owner procurement, mese rinnovo e ticket collegati via integrazione.

Per Procurement e owner di business, fornite una vista più semplice “i miei fornitori”: cosa stanno aspettando, cosa è bloccato e cosa è approvato.

Esportazioni pronte per audit

Le audit solitamente richiedono prove, non riepiloghi. La vostra esportazione deve mostrare:

- Chi ha approvato cosa, quando e perché (decisione, punteggio rischio al tempo, testo dell'eccezione)

- Quali evidenze sono state esaminate (nome file/link, versione, timestamp)

- Traccia completa di audit degli eventi chiave (inviato, richieste di modifica, riaperture)

Supportate esportazioni CSV e PDF e permettete di esportare un singolo “pacchetto review” per un dato periodo.

Calendario rinnovi e promemoria

Trattate i rinnovi come una funzionalità di prodotto, non un foglio di calcolo.

Tracciate le date di scadenza delle evidenze (es. report SOC 2, pen test, assicurazioni) e create un calendario rinnovi con promemoria automatici: prima al fornitore, poi all'owner interno, poi escalation. Quando un'evidenza viene rinnovata, conservate la versione precedente per lo storico e aggiornate automaticamente la prossima data di rinnovo.

Piano di rollout, scope MVP e roadmap di iterazione

Rilasciare un'app per le revisioni dei fornitori è meno costruire tutto e più far funzionare un workflow end-to-end, poi raffinarlo con l'uso reale.

Ambito MVP (cosa spedire prima)

Iniziate con un flusso snello e affidabile che sostituisce fogli di calcolo e thread in inbox:

- Intake: un singolo form per richiedere una review (nome fornitore, servizio, tipi di dati, owner, data target)

- Questionario: invia un questionario standard e traccia lo stato (inviato, in progresso, inviato)

- Upload evidenze: area base evidenze per review (SOC 2, pen test, policy) con date di scadenza

- Decisione: registra esito (approva/approva con condizioni/rifiuta), rischi chiave e follow-up richiesti

Mantenete l'MVP opinionated: un questionario di default, un rating di rischio e un semplice timer SLA. Regole di routing sofisticate possono aspettare.

Se volete velocizzare la delivery, una piattaforma vibe-coding come Koder.ai può essere una soluzione pratica per questo tipo di sistema interno: potete iterare sull'intake, le viste basate sui ruoli e gli stati workflow tramite implementazione guidata dalla chat, quindi esportare il codice sorgente quando siete pronti a portarlo completamente in-house. Questo è particolarmente utile quando il vostro "MVP" necessita ancora di basi reali (SSO, audit trail, gestione file e dashboard) senza un ciclo di sviluppo di mesi.

Pilota prima, poi espandere

Eseguite un pilota con un team (es. IT, Procurement o Security) per 2–4 settimane. Scegliete 10–20 review attive e migrate solo il necessario (nome fornitore, stato corrente, decisione finale). Misurate:

- tempo da intake → decisione

- % di review mancanti di evidenza al momento della decisione

- punti di blocco per revisori e fornitori (dove si fermano)

Iterare settimanalmente (rilasci piccoli, vittorie visibili)

Adottate una cadenza settimanale con un breve feedback loop:

- check-in di 15 minuti con gli utenti pilota

- un miglioramento per ridurre attrito (testo template, meno campi, istruzioni più chiare per i fornitori)

- un miglioramento per ridurre il rischio (campi obbligatori per note di decisione, promemoria su scadenza evidenze)

Documentazione che previene ticket di supporto

Scrivete due guide semplici:

- Admin guide: come modificare questionari, gestire utenti e chiudere review.

- Vendor guide: come rispondere, caricare evidenze e cosa significa “approvato con condizioni”.

Roadmap: cosa aggiungere dopo l'MVP

Pianificate fasi dopo l'MVP: regole di automazione (instradamento per tipo di dato), un portale vendor più completo, API e integrazioni.

Se prezzo o packaging influenzano l'adozione (posti, numero di fornitori, storage), rimandate gli stakeholder a /pricing presto così le aspettative di rollout coincidono col piano.