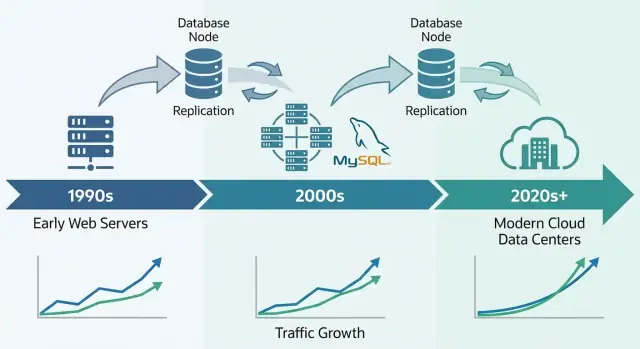

Perché MySQL è diventato una base per il primo web

MySQL è diventato il database di riferimento del primo web per una ragione semplice: rispondeva ai bisogni dei siti dell'epoca—memorizzare e recuperare dati strutturati rapidamente, funzionare su hardware modesto e restare facile da gestire per team piccoli.

Era accessibile. Si poteva installare velocemente, connettere dai linguaggi più comuni e far funzionare un sito senza assumere un DBA dedicato. Quel mix di “performance sufficienti” e bassa complessità operativa lo rese la scelta predefinita per startup, progetti hobbistici e aziende in crescita.

Cosa significa davvero qui “scalare”

Quando si dice che MySQL “ha scalato”, di solito si intende un mix di:

- Crescita del traffico: più utenti concorrenti e più query al secondo.

- Crescita dei dati: tabelle che passano da migliaia a milioni o miliardi di righe.

- Aspettative di affidabilità: restare online durante crash, deploy e guasti hardware.

- Vincoli di costo: ottenere il tutto senza budget riservati alle enterprise.

Le aziende del primo web non avevano bisogno solo di velocità; servivano performance prevedibili e uptime, mantenendo sotto controllo la spesa infrastrutturale.

Le leve principali che rivedremo

La storia dello scaling di MySQL è, in fondo, una storia di compromessi pratici e pattern ripetibili:

- Schema e progettazione delle query (cosa memorizzi, come fai join, cosa eviti)

- Indici (la differenza tra “funziona in dev” e “regge in produzione”)

- Caching (non interrogare il database per ogni page view)

- Replicazione e read replica (distribuire il traffico di lettura)

- Sharding/partizionamento (dividere i dati quando un singolo DB non ce la fa)

Ambito di questo articolo

Questa è una panoramica dei pattern usati per mantenere MySQL performante sotto traffico web reale—non un manuale completo di MySQL. L'obiettivo è spiegare come il database si adattava alle esigenze del web e perché le stesse idee ricompaiono ancora oggi in sistemi di produzione a larga scala.

L'era LAMP: come la semplicità ha aiutato la diffusione di MySQL

Il momento di svolta per MySQL è stato strettamente legato alla diffusione dell'hosting condiviso e di team piccoli che costruivano web app rapidamente. Non si trattava solo del fatto che MySQL fosse “abbastanza buono”—si adattava a come il web veniva distribuito, gestito e pagato.

Perché LAMP si adattava all'hosting iniziale

LAMP (Linux, Apache, MySQL, PHP/Perl/Python) funzionava perché si allineava al server di default che la maggior parte poteva permettersi: una singola macchina Linux con web server e database affiancati.

I provider potevano templateizzare questa configurazione, automatizzare le installazioni e offrirla a basso costo. Gli sviluppatori potevano contare sullo stesso ambiente quasi ovunque, riducendo le sorprese nel passaggio dallo sviluppo locale alla produzione.

La semplicità come strategia di diffusione

MySQL era semplice da installare, avviare e collegare. Parlava SQL comune, aveva un client da linea di comando semplice e si integrava bene con i linguaggi e i framework popolari dell'epoca.

Ugualmente importante era il modello operativo: un processo primario, pochi file di configurazione e modalità di errore chiare. Questo lo rendeva realistico da eseguire per sysadmin generalisti (e spesso per gli sviluppatori stessi) senza formazione specializzata.

L'open source eliminava l'attrito delle licenze iniziali. Un progetto studentesco, un forum amatoriale o un piccolo sito aziendale potevano usare lo stesso motore database delle grandi aziende.

Documentazione, mailing list e poi tutorial online crearono un effetto a rete: più utenti significavano più esempi, più strumenti e troubleshooting più veloce.

I workload iniziali che MySQL gestiva bene

La maggior parte dei primi siti era orientata alla lettura e piuttosto semplice: forum, blog, pagine CMS e piccoli cataloghi e-commerce. Queste app avevano bisogno di lookup veloci per ID, post recenti, account utente e filtri di base—esattamente il tipo di carico che MySQL poteva gestire efficacemente su hardware modesto.

Prime pressioni per lo scaling: più utenti, più letture, più scritture

Le prime installazioni MySQL spesso partivano come “un server, un database, un'app”. Funzionava per un forum hobbistico o un piccolo sito aziendale—finché l'app non diventava popolare. Page view diventarono sessioni, le sessioni divennero traffico costante e il database smise di essere una componente tranquilla dietro le quinte.

Perché le letture di solito prevalevano

La maggior parte delle web app era (e rimane) read-heavy. Una homepage, una lista di prodotti o una pagina profilo può essere visualizzata migliaia di volte per ogni singolo aggiornamento. Questo sbilanciamento ha modellato le decisioni iniziali di scaling: se puoi rendere le letture più veloci—o evitare del tutto il database per le letture—puoi servire molti più utenti senza riscrivere tutto.

Il problema: anche le app read-heavy hanno scritture critiche. Registrazioni, acquisti, commenti e aggiornamenti amministrativi non possono essere persi. Con l'aumento del traffico, il sistema deve gestire sia un flusso massiccio di letture sia le scritture che devono riuscire a tutti i costi.

I primi punti dolenti che i team percepivano

Con traffico più elevato, i problemi diventavano evidenti in termini semplici:

- Query lente: una pagina che prima si caricava subito ora “si bloccava” quando una query di tipo report scansionava troppe righe.

- Lock sulle tabelle: con alcuni setup iniziali le scritture potevano bloccare le letture (e viceversa), creando ingorghi.

- RAM limitata: indici e dati caldi non entravano in memoria, quindi il server leggeva più spesso da disco—molto più lento della memoria.

Separare le responsabilità fin da subito

I team impararono a dividere i compiti: l'app gestisce la logica di business, una cache assorbe le letture ripetute e il database si concentra su archiviazione accurata e query essenziali. Quel modello mentale ha preparato il terreno per passi successivi come il tuning delle query, indici migliori e lo scaling con repliche.

Motori di storage: il grande punto di svolta per l'affidabilità

Una caratteristica esclusiva di MySQL è che non è “un solo motore” sotto il cofano. È un server database che può usare diversi storage engine per memorizzare e recuperare i dati.

Cos'è in pratica un motore di storage

A livello alto, un motore di storage decide come le righe vengono scritte su disco, come si mantengono gli indici, come funzionano i lock e cosa succede dopo un crash. La tua SQL può restare identica, ma l'engine determina se il database si comporta più come un quaderno veloce o come un registro bancario.

MyISAM vs InnoDB (differenze in parole semplici)

Per molto tempo molte installazioni MySQL usavano MyISAM. Era semplice e spesso rapido per siti read-heavy, ma aveva compromessi:

- Locking: MyISAM usa comunemente lock a livello tabella. Una scrittura può bloccare altre letture/scritture più di quanto ci si aspetti.

- Crash: dopo uno shutdown non pulito, le tabelle MyISAM potevano richiedere riparazioni e perdere cambi recenti.

- Transazioni: MyISAM non supporta le transazioni, quindi non è possibile garantire che più operazioni vadano “tutte a buon fine o tutte falliscano”.

InnoDB capovolgeva queste assunzioni:

- Locking: locking a livello di riga riduce il blocco quando molti utenti aggiornano righe diverse.

- Recupero da crash: migliore durabilità e recupero automatico dopo i guasti.

- Transazioni: supporto completo alle transazioni, rendendo il comportamento dell'app molto più prevedibile.

Perché InnoDB è diventato il default in produzione

Con lo spostarsi delle app dal solo rendering di pagine a gestione di login, carrelli, pagamenti e messaggistica, correttezza e recovery sono diventati importanti quanto la velocità. InnoDB ha reso realistico scalare senza temere che un riavvio o un picco di traffico corrompesse i dati o bloccasse intere tabelle.

Il takeaway pratico: la scelta dell'engine influisce su performance e sicurezza. Non è solo un'opzione da spuntare—il modello di lock, il comportamento nei guasti e le garanzie per l'app dipendono da questa scelta.

Indici e progettazione delle query: il primo moltiplicatore di scala

Prima di sharding, repliche leggere o caching elaborato, molti guadagni iniziali su MySQL venivano da un cambiamento coerente: rendere le query prevedibili. Indici e design delle query sono stati il primo “moltiplicatore” perché riducevano la quantità di dati che MySQL doveva toccare per ogni richiesta.

Indici B-tree: lookup veloci vs scansioni full-table

La maggior parte degli indici MySQL sono basati su B-tree. Pensali come una rubrica ordinata: MySQL può saltare nel punto giusto e leggere una piccola porzione contigua di dati. Senza l'indice giusto, il server spesso ricorre alla scansione riga per riga. A basso traffico questo è solo lento; a scala diventa un amplificatore di carico—più CPU, più I/O su disco, più tempo di lock e latenza più alta per tutto il resto.

Antipattern di query che danneggiano a scala

Alcuni pattern causavano ripetutamente fallimenti del tipo “funzionava in staging”:

SELECT *: recupera colonne non necessarie, aumenta l'I/O e può annullare i benefici degli indici covering.- Wildcard iniziali:

WHERE name LIKE '%shoe' non può usare efficacemente un normale indice B-tree.

- Funzioni su colonne indicizzate:

WHERE DATE(created_at) = '2025-01-01' spesso impedisce l'uso dell'indice; preferisci filtri di range come created_at >= ... AND created_at < ....

Fai di EXPLAIN e dei slow log strumenti quotidiani

Due abitudini hanno scalato meglio di qualsiasi trucco intelligente:

- Esegui

EXPLAIN per verificare che venga usato l'indice previsto e non si stia facendo una scansione.

- Controlla il slow query log per individuare regressioni mentre le funzionalità vengono rilasciate, non settimane dopo.

Gli indici devono riflettere le funzionalità reali

Progetta gli indici attorno al comportamento del prodotto:

- Ricerca: valuta soluzioni full-text o strategie di prefisso invece di scansioni con wildcard.

- Feed: indici composti come

(user_id, created_at) rendono veloci le query “ultimi elementi”.

- Flussi di checkout: indici unici su identificatori di ordine/pagamento prevengono duplicati e velocizzano i lookup.

Un buon indexing non significa “più indici”. Significa i pochi giusti che corrispondono ai percorsi di lettura/scrittura critici.

Scaling verticale vs orizzontale: cosa cambia e perché

Testa scenari di scala in anticipo

Chiedi a Koder.ai di modellare traffico, requisiti di consistenza e comportamenti di failure prima del lancio.

Quando un prodotto basato su MySQL inizia a rallentare, la prima grande decisione è se scalare verticalmente (up) o orizzontalmente (out). Risolvono problemi diversi e cambiano la vita operativa in modi molto differenti.

Scaling verticale: la mossa “scatola più grande”

Lo scaling verticale significa dare a MySQL più risorse su una macchina: CPU più veloce, più RAM, storage migliore.

Funziona sorprendentemente bene perché molti colli di bottiglia sono locali:

- CPU: query complesse, sorting, join e WHERE inefficienti possono saturare i core.

- I/O: dischi lenti e letture/scritture random dominano quando i dati non stanno in memoria.

- Buffer pool / memoria: con InnoDB, più RAM mantiene in cache i dati e gli indici caldi, riducendo gli accessi disco.

- Limiti di connessione: troppe connessioni concorrenti possono sopraffare thread, memoria e context switching.

Lo scaling verticale è spesso la vittoria più rapida: meno parti in movimento, modalità di errore più semplici e meno cambi applicativi. Il rovescio è che esiste sempre un tetto (e gli upgrade possono richiedere downtime o migrazioni rischiose).

Scaling orizzontale: “più macchine”, più coordinazione

Lo scaling orizzontale aggiunge macchine. Per MySQL, tipicamente significa:

- Dividere le letture su repliche

- Dividere le scritture suddividendo i dati (sharding) o ristrutturando i workflow

È più complesso perché introduce problemi di coordinazione: lag di replicazione, comportamento di failover, compromessi di consistenza e più tooling operativo. L'app deve anche sapere a quale server parlare (o serve un layer proxy).

Aspettative realistiche: non correre subito allo sharding

La maggior parte dei team non ha bisogno di sharding come primo passo. Inizia confermando dove si spende il tempo (CPU vs I/O vs contesa per lock), correggi query lente e indici e dimensiona memoria e storage. Lo scaling orizzontale vale la pena quando una singola macchina non riesce a sostenere il tasso di scrittura, la dimensione dello storage o i requisiti di disponibilità—anche dopo un buon tuning.

Replicazione e read replica: scalare le letture in modo pratico

La replicazione è uno dei modi più pratici con cui i sistemi MySQL hanno gestito la crescita: invece di far fare tutto a un solo database, copi i suoi dati su altri server e distribuisci il lavoro.

Replicazione in termini semplici: un primario e delle repliche

Pensa a un primario (a volte chiamato “master”) come al database che accetta le modifiche—INSERT, UPDATE, DELETE. Una o più repliche (ex “slave”) tirano continuamente quelle modifiche e le applicano, mantenendo una copia quasi in tempo reale.

L'app può quindi:

- Inviare scritture al primario

- Inviare molte letture alle repliche

Questo pattern è diventato comune perché il traffico web spesso cresce “più in letture” rispetto alle scritture.

A cosa servivano le read replica

Le read replica non servivano solo a rispondere le pagine più velocemente. Aiutavano anche a isolare lavori che avrebbero rallentato il database principale:

- Scaling delle letture: pagine prodotto, feed, risultati di ricerca e altri endpoint read-heavy

- Analisi e reporting: eseguire query lunghe su una replica invece di bloccare il primario

- Backup: fare dump logici o eseguire tool di backup su una replica per ridurre l'impatto sul traffico di produzione

I compromessi da accettare

La replicazione non è gratis. Il problema più comune è il lag di replicazione—le repliche possono avere secondi (o più) di ritardo durante i picchi.

Questo porta a una domanda chiave a livello applicativo: read-your-writes consistency. Se un utente aggiorna un profilo e leggi immediatamente da una replica, potrebbe vedere i dati vecchi. Molti team risolvono leggendo dal primario per le viste “fresche” o usando una breve finestra “dopo la scrittura leggi dal primario”.

Replicazione non è la stessa cosa del failover

La replicazione copia i dati; non ti mantiene automaticamente online durante i guasti. Il failover—promuovere una replica, reindirizzare il traffico e assicurarsi che l'app si ricolleghi in sicurezza—è una capacità separata che richiede tooling, test e procedure operative chiare.

Fondamenti di alta disponibilità: restare online durante i guasti

Distribuisci senza tool aggiuntivi

Costruisci e ospita la tua app su Koder.ai, poi aggiungi un dominio personalizzato quando sei pronto.

L'alta disponibilità (HA) sono pratiche che mantengono l'app in funzione quando un server database crasha, una connessione di rete cade o serve manutenzione. Gli obiettivi sono semplici: ridurre i downtime, rendere le manutenzioni sicure e assicurare che il recovery sia prevedibile invece che improvvisato.

I pattern HA più comuni

Le prime installazioni MySQL spesso partivano con un primario. L'HA tipicamente aggiungeva una seconda macchina così che un guasto non significasse un lungo outage.

- Primary–standby (active–passive): un server gestisce il traffico; uno standby resta pronto a subentrare.

- Cluster multi-nodo: più nodi cooperano per mantenere il servizio disponibile, di solito con regole più severe sulle scritture.

- Failover automatizzato: il monitoraggio rileva il guasto del primario e promuove uno standby, aggiornando il target di connessione dell'app.

L'automazione aiuta, ma alza anche la posta: il team deve fidarsi della logica di rilevamento e prevenire lo “split brain” (due server che pensano entrambi di essere primari).

RPO e RTO, in parole semplici

Due metriche rendono le decisioni HA meno emotive e più misurabili:

- RPO (Recovery Point Objective): quanto dato puoi permetterti di perdere. Se una replica è indietro di 10 secondi, il tuo RPO può essere fino a ~10 secondi.

- RTO (Recovery Time Objective): quanto tempo puoi permetterti di essere down. Include rilevamento, promozione e tempo di ricollegamento dell'app.

Basi operative che rendono l'HA reale

L'HA non è solo topologia—è pratica.

I backup devono essere routinari, ma la chiave è testare il ripristino: riesci davvero a recuperare su un nuovo server, rapidamente, sotto pressione?

Anche le modifiche di schema contano. Alterare tabelle grandi può bloccare le scritture o rallentare le query. Approcci più sicuri includono eseguire cambi durante finestre a basso traffico, usare strumenti di online schema change e avere sempre un piano di rollback.

Fatto bene, l'HA trasforma i guasti da emergenze in eventi pianificati e provati.

Strategie di caching che tenevano MySQL veloce sotto traffico web

Il caching è stato uno dei modi più semplici con cui i primi team web mantenevano MySQL reattivo con l'aumentare del traffico. L'idea è semplice: servi richieste ripetute da qualcosa più veloce del database e colpisci MySQL solo quando necessario. Ben fatto, il caching riduce drasticamente il carico di lettura e fa sembrare gli spike di traffico una rampa dolce invece che una corsa sfrenata.

I livelli di caching più comuni

Cache applicativa/oggetto conserva “pezzi” di dati che il codice richiede spesso—profili utente, dettagli prodotto, controlli di permessi. Invece di eseguire la stessa SELECT centinaia di volte al minuto, l'app legge un oggetto precomputato per chiave.

Cache di pagina o frammento conserva HTML renderizzato (pagine intere o parti come una sidebar). È particolarmente efficace per siti content-heavy dove molti visitatori vedono le stesse pagine.

Caching dei risultati di query mantiene il risultato di una query specifica (o una versione normalizzata). Anche se non fai caching a livello SQL, puoi memorizzare “il risultato di questo endpoint” usando una chiave che rappresenta la richiesta.

Concettualmente i team usano store key/value in memoria, cache HTTP o caching incorporato nei framework. Lo strumento esatto importa meno di chiavi coerenti, TTL (scadenze) e ownership chiara.

La parte difficile: invalidazione della cache

Il caching scambia freschezza per velocità. Alcuni dati possono essere leggermente obsoleti (pagine di notizie, contatori di visualizzazioni). Altri no (totali del checkout, permessi). Di solito si sceglie tra:

- Scadenza basata sul tempo (semplice, permette breve staleness)

- Invalidazione basata su eventi (più precisa, più facile sbagliare)

Se l'invalidazione fallisce, gli utenti vedranno contenuti datati. Se è troppo aggressiva, perdi il beneficio e MySQL torna sotto pressione.

Perché smussa gli spike

Quando il traffico sale, le cache assorbono le letture ripetute mentre MySQL si concentra sul “vero lavoro” (scritture, cache miss, query complesse). Questo riduce le code, evita che i rallentamenti si propaghino e compra tempo per scalare in sicurezza.

Sharding e partizionamento: quando un database non basta più

C'è un punto in cui “hardware più grande” e un attento tuning delle query smettono di dare margine. Se un singolo server MySQL non regge il volume di scritture, la dimensione del dataset o le finestre di manutenzione, si inizia a pensare di dividere i dati.

Partizionamento vs sharding (e perché sono diversi)

Partizionamento divide una tabella in pezzi più piccoli all'interno della stessa istanza MySQL (per esempio per data). Può velocizzare delete, archiviazione e alcune query, ma non permette di superare i limiti di CPU, RAM e I/O di quella singola macchina.

Sharding divide i dati su più server MySQL. Ogni shard contiene un sottoinsieme di righe e l'app (o uno strato di routing) decide dove va ogni richiesta.

Quando lo sharding diventa necessario

Lo sharding compare quando:

- Le scritture saturano un primario anche dopo indici, correzioni di query e caching

- La crescita dello storage rende backup, restore e modifiche di schema troppo lenti

- Carichi “noisy neighbor” creano latenza imprevedibile per tutti

Chiavi di shard comuni

Una buona shard key distribuisce il traffico in modo uniforme e mantiene la maggior parte delle richieste su uno shard singolo:

- user_id: comune per app consumer; mantiene i dati di un utente insieme

- tenant_id: ideale per SaaS; forte isolamento tra clienti

- geografia: utile per latenza e requisiti di residenza dei dati, ma può creare hotspot

I costi reali

Lo sharding scambia semplicità per scala:

- Query cross-shard diventano più difficili (spesso risolte con fan-out + aggregazione)

- Transazioni cross-shard sono limitate; molti team passano a pattern di consistenza eventuale

- Migrazioni e rebalancing sono operativamente pesanti (spostare range, aggiornare il routing)

Un approccio a fasi (prima di impegnarsi)

Inizia con caching e read replica per alleggerire il primario. Poi isola le tabelle o workload più pesanti (a volte separando per feature o servizio). Solo dopo, passa allo sharding—idealmente in modo che tu possa aggiungere shard gradualmente senza ridisegnare tutto.

Operazioni a scala: monitoraggio, manutenzione e incidenti

Dall'idea al CRUD funzionante

Trasforma entità in form, API e tabelle del database senza cablare tutto a mano.

Gestire MySQL per un prodotto trafficato è meno questione di feature ingegnose e più di operazioni disciplinate. La maggior parte degli outage non inizia con un fallimento drammatico—inizia con piccoli segnali che nessuno coglie in tempo.

Cosa i team monitorano davvero

A scala, quattro segnali tendono a prevedere i problemi prima di altri:

- Latenza delle query (p50/p95/p99): l'aumento della latenza sulla coda conta più delle medie.

- Lock e lock waits: i picchi possono indicare righe calde, indici mancanti o transazioni lunghe.

- Lag di replicazione: il lag trasforma lo scaling in letture stale e può compromettere il failover.

- Crescita del disco e pressione I/O: il disco si riempie, ma la saturazione I/O spesso dà problemi prima.

Dashboard utili aggiungono contesto: traffico, tassi di errore, conteggi di connessione, buffer pool hit rate e top query. L'obiettivo è vedere il cambiamento, non memorizzare lo “stato normale”.

Perché le query lente emergono solo sotto carico reale

Molte query sembrano ok in staging e anche in produzione nelle ore tranquille. Sotto carico, il database si comporta diversamente: le cache smettono di aiutare, le richieste concorrenti amplificano la contesa per i lock e una query poco efficiente può generare più letture, tabelle temporanee o ordinamenti pesanti.

Per questo i team si affidano al slow query log, ai digest delle query e ad istogrammi di produzione reali piuttosto che a benchmark isolati.

Manutenzione senza sorprese

Pratiche di cambiamento sicure sono volutamente noiose: esegui migrazioni in piccoli batch, aggiungi indici con lock minimo quando possibile, verifica con explain plan e tieni rollback realistici (a volte il rollback è “interrompi il rollout e fai failover”). Le modifiche dovrebbero essere misurabili: latenza prima/dopo, lock waits e lag di replicazione.

Elementi base per gli incidenti: diagnosticare, mitigare, prevenire

Durante un incidente: conferma l'impatto, identifica il principale colpevole (una query, un host, una tabella), poi mitiga—limitando il traffico, killando query runaway, aggiungendo un indice temporaneo o spostando letture/scritture. Dopo, documenta l'accaduto, aggiungi alert sui segnali precoci e rendi la soluzione ripetibile per evitare recidive.

Perché MySQL ancora alimenta sistemi massivi oggi

MySQL resta una scelta di default per molti sistemi moderni perché corrisponde alla forma dei dati applicativi quotidiani: molte letture e scritture piccole, confini transazionali chiari e query prevedibili. Per questo è adatto a prodotti OLTP come SaaS, e-commerce, marketplace e piattaforme multi-tenant—specialmente quando si modella il dato attorno a entità reali e si mantengono transazioni focalizzate.

Un MySQL moderno è molto diverso dal “vecchio MySQL”

L'ecosistema MySQL di oggi beneficia di anni di lezioni trasformate in default migliori e pratiche operative più sicure. In pratica, i team si affidano a:

- InnoDB come motore standard, con recovery robusto e garanzie transazionali

- Funzionalità di performance migliorate (ottimizzatori migliori, opzioni di replicazione più veloci, concorrenza più prevedibile)

- Osservabilità più semplice da attivare: slow query log, performance_schema, exporter di metriche e dashboard che evidenziano i colli di bottiglia reali

- Automazione per schema change, backup e failover—così lo scaling non dipende da sforzi eroici manuali

MySQL gestito riduce il carico operativo

Molte aziende ora eseguono MySQL tramite servizi managed, dove il provider si occupa del lavoro di routine come patching, backup automatici, cifratura, point-in-time recovery e passi comuni di scaling (macchine più grandi, repliche, crescita dello storage). Rimangono a te schema, query e pattern di accesso ai dati—ma passi meno tempo su finestre di manutenzione e prove di recovery.

Integrare questi pattern nella delivery moderna delle app

Una ragione per cui il “playbook di scaling MySQL” conta ancora è che raramente è solo un problema di database—è un problema di architettura applicativa. Scelte come separazione letture/scritture, chiavi di cache e invalidazione, migrazioni sicure e piani di rollback funzionano meglio quando sono progettate insieme al prodotto, non aggiunte durante gli incidenti.

Se stai costruendo nuovi servizi e vuoi codificare queste decisioni fin da subito, un workflow di tipo vibe-coding può aiutare. Per esempio, Koder.ai può prendere una specifica in linguaggio semplice (entità, aspettative di traffico, esigenze di consistenza) e generare uno scaffold di app—tipicamente React per il web e servizi in Go—mantenendo il controllo sul livello dati. La sua Planning Mode, gli snapshot e il rollback sono particolarmente utili quando si iterano schemi e cambi di deployment senza trasformare ogni migrazione in un evento ad alto rischio.

Se vuoi esplorare i tier di Koder.ai (Free, Pro, Business, Enterprise), vedi /pricing.

Scegliere MySQL oggi (checklist guidata dai requisiti)

Scegli MySQL quando ti servono: transazioni solide, un modello relazionale, tool maturi, performance prevedibili e grande disponibilità di talenti. Considera alternative quando ti servono: un enorme fan-out di scritture con schemi flessibili (alcuni sistemi NoSQL), scritture multi-regione fortemente consistenti (database distribuiti specializzati), o workload analytics-first (data warehouse columnari).

Il takeaway pratico: parti dai requisiti (latenza, consistenza, modello dati, tasso di crescita, competenze del team), poi scegli il sistema più semplice che li soddisfa—e spesso MySQL continua a farlo.