Cosa intendiamo per “costo, tempo e attrito” nel lavoro software

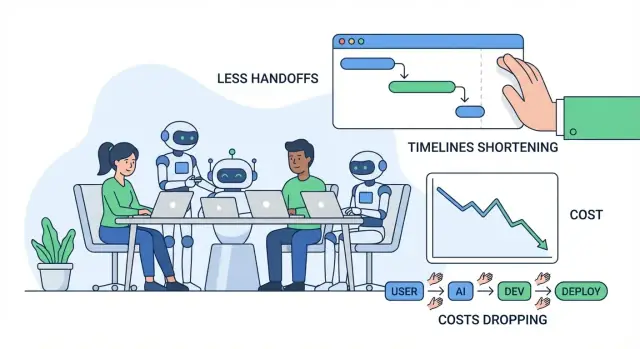

Quando si parla di migliorare la delivery del software, di solito si intendono tre cose: costo, tempo e attrito. Sono strettamente correlati, ma non identici—e vale la pena definirli in termini chiari prima di parlare di AI.

Costo: ciò che paghi per ottenere risultati

Costo è la spesa totale necessaria per rilasciare e mantenere una funzionalità: stipendi e ore dei contractor, bollette cloud, strumenti e i costi “nascosti” di riunioni, coordinamento e correzione degli errori. Una funzionalità che richiede due settimane in più non costa solo più tempo d'ingegneria—può anche ritardare ricavi, aumentare il carico di supporto o costringerti a mantenere sistemi legacy più a lungo.

Tempo: quanto ci vuole dall'idea al valore rilasciato

Tempo è il tempo di calendario da “dobbiamo costruire questo” a “i clienti lo possono usare in modo affidabile.” Include lo sviluppo, ma anche decisioni, approvazioni, attese per revisioni, attese per ambienti, attese per i risultati QA e attese per qualcuno con il contesto giusto che risponda a una domanda.

Attrito: lo sforzo perso in rallentamenti, confusione e interruzioni

Attrito è l'inerzia quotidiana che fa sembrare il lavoro più lento del dovuto: requisiti poco chiari, chiarimenti andata/ritorno, cambio di contesto, lavoro duplicato o passaggi di consegna lunghi tra ruoli o team.

La maggior parte degli sprechi nei progetti software si manifesta come passaggi di consegne, rifacimenti e attese. Un piccolo fraintendimento iniziale può trasformarsi in riprogettazioni, cacce ai bug o riunioni ripetute in seguito. Una coda di review lenta o una documentazione mancante possono bloccare il progresso anche quando tutti sono “impegnati”.

Cosa intendiamo per “strumenti AI” (e cosa non intendiamo)

In questo articolo, strumenti AI include copiloti di coding, assistenti in chat per ricerca e spiegazioni, analisi automatizzata per requisiti e ticket, generatori di test e automazioni di workflow in QA/DevOps.

L'AI può ridurre lo sforzo e velocizzare i cicli—ma non rimuove la responsabilità. I team hanno ancora bisogno di chiara ownership, buon giudizio, controlli di sicurezza e approvazione umana su ciò che viene rilasciato.

Dove i progetti software tipicamente perdono tempo e denaro

La maggior parte dei superamenti di budget non proviene dal “codice difficile”. Provengono da colli di bottiglia quotidiani che si sommano: requisiti poco chiari, continui cambi di contesto, code di revisione lente e test manuali fatti troppo tardi.

I colli di bottiglia comuni (e perché costano)

Requisiti poco chiari creano il costo maggiore a valle. Un piccolo fraintendimento iniziale può trasformarsi in una settimana di rifacimento—soprattutto quando persone diverse interpretano diversamente la stessa funzionalità.

Cambio di contesto è il killer silenzioso della produttività. Gli ingegneri saltano tra ticket, domande in chat, riunioni e problemi di produzione. Ogni cambio ha un costo di riavvio: ricaricare il codebase, la storia delle decisioni e il “perché”.

Revisioni lente non ritardano solo i merge—ritardano l'apprendimento. Se il feedback arriva giorni dopo, l'autore è già passato oltre e la correzione richiede più tempo.

Test manuali e QA tardivo spesso significa che i problemi vengono scoperti quando sono più costosi da risolvere: dopo che diverse funzionalità si sono accumulate o proprio prima del rilascio.

I costi nascosti che la gente non mette in budget

I costi evidenti sono stipendi e fatture dei fornitori. Quelli nascosti di solito fanno più male:

- Rifacimenti: riscrivere codice e riprogettare flussi perché i requisiti sono cambiati o sono stati fraintesi.

- Ritardi: attese per decisioni, approvazioni, ambienti di test o per “una persona chiave” che risponda.

- Overhead di coordinamento: sincronizzazione tra product, design, engineering, QA, sicurezza e stakeholder.

Un flusso semplice: idea → rilascio (con punti dolenti)

Idea → requisiti → design → build → review → test → rilascio → monitoraggio

Punti dolenti tipici: requisiti (ambiguità), build (interruzioni), review (tempo in coda), test (sforzo manuale), rilascio (passaggi), monitoraggio (troubleshooting lento).

Diagnostica rapida: mappare l'attrito

Prova una “mappa dell'attrito” in una sessione di 30 minuti: elenca ogni fase, poi marca (1) dove il lavoro aspetta, (2) dove le decisioni si bloccano e (3) dove avviene il rifacimento. Quelle aree segnate sono dove gli strumenti AI spesso creano i risparmi più rapidi—riducendo i fraintendimenti, velocizzando il feedback e tagliando il lavoro ripetitivo.

Discovery e requisiti assistiti dall'AI: meno fraintendimenti

La discovery è dove molti progetti deragliano silenziosamente: note sparse, feedback contraddittori e decisioni che vivono nella testa delle persone. L'AI non può sostituire parlare con gli utenti, ma può ridurre la “perdita di traduzione” tra conversazioni, documenti e ciò che gli ingegneri effettivamente costruiscono.

I team spesso raccolgono un mucchio di note di ricerca—trascrizioni di interviste, ticket di supporto, snippet di chiamate di vendita, risposte a sondaggi—e faticano a estrarre rapidamente i pattern. Gli strumenti AI possono velocizzare questo passaggio:

- Riepilogando lunghe note di ricerca in takeaway coerenti (punti di dolore, obiettivi, obiezioni)

- Raggruppando feedback in temi (es. confusione nell'onboarding vs integrazioni mancanti)

- Redigendo user story iniziali e job-to-be-done dalle input grezze

Questo non crea verità automaticamente, ma offre un punto di partenza chiaro, più facile da criticare, perfezionare e allineare.

Definire ambito e criteri di accettazione prima

I fraintendimenti di solito emergono più tardi come rifacimenti del tipo “non intendevo questo”. L'AI aiuta producendo rapidamente prime bozze di:

- Confini di ambito (cosa è dentro vs fuori per questa release)

- Casi limite e scenari “e se…” basati su pattern simili

- Criteri di accettazione abbastanza specifici da poter essere testati

Per esempio, se un requisito dice “gli utenti possono esportare report”, l'AI può spingere il team a chiarire: formati (CSV/PDF), permessi, intervalli di date, comportamento dei fusi orari e se le esportazioni vengono inviate via email o scaricate. Avere queste risposte presto riduce l'attrito durante sviluppo e QA.

Documentazione coerente che viene davvero usata

Quando i requisiti vivono su documenti, thread di chat e ticket, i team pagano una costante “tassa da cambio di contesto”. L'AI può aiutare a mantenere una narrazione unica e leggibile redigendo e aggiornando:

- Riepiloghi di riunioni con decisioni e questioni aperte

- Documenti dei requisiti e descrizioni dei ticket in un template coerente

- Glossari per i termini di dominio (così “account”, “workspace” e “org” non si confondono)

Il ritorno è meno interruzioni (“che cosa avevamo deciso?”) e passaggi di consegna più fluidi tra product, design, engineering e QA.

Guardrail: convalida le ipotesi, non delegarle

Gli output AI dovrebbero essere trattati come ipotesi, non come requisiti definitivi. Usa semplici guardrail:

- Revisiona sempre i riepiloghi contro le fonti originali (soprattutto citazioni e numeri)

- Segnala gli elementi incerti come domande, poi conferma con utenti e stakeholder

- Mantieni la proprietà delle decisioni nel team: l'AI redige, gli umani approvano

Usata così, la discovery assistita riduce i fraintendimenti senza indebolire la responsabilità—tagliando costo, tempo e attrito prima che venga scritto il primo rigo di codice.

Prototipazione e iterazione di design più rapide con l'AI

La prototipazione è il punto in cui molti team o risparmiano settimane—o le bruciano. L'AI rende più economico esplorare rapidamente idee, così puoi validare ciò che gli utenti vogliono prima di impegnare tempo di ingegneria in una build completa.

Bozze rapide per schermate e flussi

Invece di partire da una pagina bianca, puoi usare l'AI per generare:

- Copy UI per pulsanti, messaggi di errore, passaggi di onboarding e stati vuoti (con opzioni di tono come “amichevole” vs “formale”)

- Idee di wireframe espresse come descrizioni semplici della schermata (cosa c'è nella pagina, cosa è primario vs secondario)

- Esempi di user journey: “nuovo utente si registra → importa dati → imposta un obiettivo → riceve un promemoria”

Queste bozze non sono lavoro di design finale, ma danno al team qualcosa di concreto su cui reagire. Questo riduce il tira e molla tipo “pensavo intendessi X” o “non siamo ancora allineati sul flow”.

Demo app rapide e proof-of-concept

Per molte decisioni di prodotto, non serve codice di qualità di produzione per imparare. L'AI può aiutare ad assemblare una demo app o un proof-of-concept (POC) che mostra:

- L'interazione core (cosa clicca l'utente, cosa vede dopo)

- Dati esempio e casi limite realistici

- Un semplice “happy path” sufficiente per review interne o interviste utenti

Se vuoi spingerti oltre mockup statici, piattaforme vibe-coding come Koder.ai possono essere utili per iterazioni veloci: descrivi la funzionalità via chat, genera una bozza di app web o mobile funzionante (comunemente React per il web e Flutter per il mobile), e poi raffinane gli elementi con gli stakeholder prima di impegnarti in un ciclo di ingegneria completo.

Da dove vengono davvero i risparmi di tempo

I maggiori risparmi di solito non stanno nel “tempo di design”. Derivano dall'evitare build complete della cosa sbagliata. Quando un prototipo rivela confusione, passi mancanti o valore poco chiaro, puoi cambiare direzione mentre le modifiche sono ancora economiche.

Una cautela chiave: non rilasciare codice prototipo per sbaglio

I prototipi generati dall'AI spesso saltano pulizie importanti: controlli di sicurezza, accessibilità, performance, gestione degli errori e struttura mantenibile. Tratta il codice prototipo come usa e getta a meno che tu non decida esplicitamente di irrigidirlo—altrimenti rischi di trasformare un esperimento rapido in rifacimenti a lungo termine.

Se converti i prototipi in funzionalità reali, cerca workflow che rendano esplicita quella transizione (per esempio: modalità di pianificazione, snapshot e rollback). Questo aiuta i team a muoversi velocemente senza perdere tracciabilità.

Sviluppare più velocemente con assistenti AI (e dove aiutano di più)

Gli assistenti di coding sono più utili nelle parti poco glamour dello sviluppo: passare da “niente” a un punto di partenza funzionante e sfoltire il lavoro ripetitivo che rallenta i team. Non sostituiscono il giudizio di ingegneria, ma possono ridurre il tempo tra l'idea e una pull request revisionabile.

Come riducono il tempo del “foglio bianco”

Quando inizi un nuovo endpoint, job o flow UI, la prima ora spesso va in wiring, naming e copia di pattern dal codice precedente. Gli assistenti possono redigere rapidamente quella struttura iniziale: cartelle, funzioni di base, gestione degli errori, logging e test segnaposto. Così gli ingegneri dedicano più tempo alla logica di prodotto e ai casi limite, meno al boilerplate.

Per team che vogliono andare oltre “assist dentro l'editor”, piattaforme come Koder.ai impacchettano questo in un workflow completo: da una specifica in chat a un'app eseguibile con pezzi backend (spesso Go + PostgreSQL), più opzioni come esportazione del codice sorgente e deploy/hosting. Il beneficio pratico è ridurre il costo di coordinamento del “arrivare a qualcosa che puoi revisionare”.

Task più adatti (dove aiutano di più)

Rendono meglio nei lavori contenuti e basati su pattern, specialmente quando il codebase ha già convenzioni chiare:

- Scaffolding: nuove route/controller, schermate CRUD, comandi CLI, job in background, wrapper SDK.

- Refactor: rinominare e riorganizzare moduli, estrarre funzioni, applicare gestione errori coerente, aggiornare API deprecate.

- Traduzioni: portare piccoli componenti tra linguaggi/framework (es. Python a TypeScript) con test per confermare il comportamento.

- Piccole funzionalità: aggiunte ben delimitate come un filtro, esportazione, handler webhook o regola di validazione.

- Strumenti interni: pagine admin, script, fix dati, generatori di report—alto valore, basso polish UX.

Pattern di prompt che producono codice utilizzabile

Buoni prompt assomigliano meno a “scrivi la feature X” e più a una mini-spec. Includi:

- Contesto: cosa fa il modulo, dove vive e API circostanti.

- Vincoli: librerie, regole di stile, requisiti di performance o sicurezza.

- Esempi: file simili esistenti o un campione input/output.

- Test di accettazione: casi limite e controlli “fatto significa…” (anche in linguaggio naturale).

Add a /v1/invoices/export endpoint.

Context: Node/Express, uses InvoiceService.list(), auth middleware already exists.

Constraints: stream CSV, max 50k rows, no PII fields, follow existing error format.

Example: match style of routes/v1/customers/export.ts.

Acceptance: returns 401 if unauthenticated; CSV has headers A,B,C; handles empty results.

(Questo blocco di testo è un esempio: il contenuto del blocco di codice non va tradotto.)

La revisione è imprescindibile

Il codice generato dall'AI ha comunque bisogno degli stessi standard: code review, revisione di sicurezza e test. Gli sviluppatori sono ancora responsabili di correttezza, gestione dei dati e conformità—tratta l'assistente come una bozza rapida, non come autorità.

Ridurre i cicli di review e i rifacimenti con l'AI

La revisione del codice è dove si accumula molto del “costo nascosto”: attese per feedback, spiegare di nuovo l'intento e correggere le stesse categorie di errori ripetutamente. L'AI non può sostituire il giudizio del reviewer, ma può ridurre il tempo speso in controlli meccanici e fraintendimenti.

Come l'AI aiuta nelle review

Un buon workflow AI supporta i reviewer prima ancora che aprano la PR:

- Riepilogare le modifiche: Generare un sommario in linguaggio naturale di cosa fa la PR, quali file sono cambiati e quale comportamento è previsto. Questo aiuta i reviewer a concentrarsi più velocemente e riduce i commenti “cosa sto guardando?”.

- Segnalare pattern rischiosi: Evidenziare fonti comuni di bug—mancati controlli null, parsing di stringhe insicuro, logiche temporali fluttuanti, errori non gestiti o cambiamenti sospetti di permessi.

- Suggerire test: Proporre casi di test specifici basati sul diff (“aggiungi un test per input non valido”, “asserisci controllo accessi per ruolo X”, “copri il nuovo caso limite di paginazione”).

Meno ping-pong avanti e indietro

L'AI può anche migliorare chiarezza e coerenza, che sono ciò che di solito guida i rimbalzi nelle review:

- Redigere descrizioni PR migliori (motivazione, approccio, compromessi)

- Far rispettare coerenza nei nomi e nel formato per evitare dibattiti soggettivi

- Suggerire piccoli refactor che rendono il codice più leggibile, così i reviewer non chiedono riscritture ampie dopo

Regole pratiche per mantenerlo sicuro

Usa l'AI per velocizzare le review senza abbassare gli standard:

- Approvazione umana obbligatoria per ogni PR.

- Allinea i suggerimenti AI con la guida di stile e le regole di lint.

- Mantieni le PR piccole e focalizzate in modo che sia umani che AI possano ragionare su di esse.

Dove l'AI fatica ancora

L'AI è più debole nella logica di dominio e nell'architettura: regole di business, casi limite legati a utenti reali e compromessi di sistema richiedono ancora giudizio esperto. Tratta l'AI come assistente del reviewer, non come reviewer.

AI nei test e in QA: catturare i problemi prima con meno lavoro manuale

I test sono il luogo dove piccoli fraintendimenti si trasformano in sorprese costose. L'AI non può garantire qualità, ma può eliminare molto lavoro ripetitivo—in modo che gli umani passino più tempo sui casi difficili che realmente rompono i prodotti.

Generazione automatica di test: partire da percorsi di codice reali

Gli strumenti AI possono proporre test unitari leggendo il codice esistente e identificando i percorsi di esecuzione comuni (il “happy path”), più i rami facili da dimenticare (gestione errori, input null/vuoto, retry, timeout). Se fornisci anche una breve specifica o criteri di accettazione, l'AI può suggerire casi limite direttamente dai requisiti—per esempio, valori al limite, formati non validi, controlli di permessi e “e se il servizio upstream è down?”.

L'uso migliore qui è accelerazione: ottieni una bozza iniziale di test rapidamente, poi gli ingegneri aggiustano le asserzioni per allinearle alle regole di business reali.

Dati di test più veloci, mock e fixture

Un assorbente sorprendente in QA è creare dati di test realistici e collegare i mock. L'AI può aiutare:

- Generando record campione rappresentativi (inclusi casi “strani”) che rispettano le regole di validazione

- Scrivendo mock/stub per servizi esterni con risposte prevedibili

- Creando fixture riusabili che rendono i test più corti e leggibili

Questo accelera sia i test unitari scritti dagli sviluppatori sia i test di integrazione, specialmente quando sono coinvolte molte API.

Segnalazioni di bug migliori: correzioni più veloci

Quando i problemi sfuggono a QA o produzione, l'AI può migliorare i bug report trasformando note disordinate in passi di riproduzione strutturati e separando chiaramente atteso vs reale. Dati log o output della console, può riassumere pattern (cosa è fallito per primo, cosa si è ripetuto, cosa è correlato al fallimento) così gli ingegneri non passano la prima ora a capire il report.

Controlli di qualità (non negoziabili)

I test generati dall'AI devono comunque essere:

- Significativi: asserzioni legate a requisiti reali, non “gira senza crash”

- Deterministici: niente timing instabile, seed randomici non controllati o dipendenze esterne instabili

- Manutenuti: trattati come codice di produzione—revisionati, ben nominati e aggiornati quando il comportamento cambia

Usata così, l'AI riduce lo sforzo manuale aiutando i team a intercettare problemi prima—quando le correzioni costano meno.

Rilascio e operazioni: meno attese, troubleshooting più rapido

Il lavoro di rilascio è dove i “piccoli ritardi” si moltiplicano: pipeline instabili, errori poco chiari, variabili di configurazione mancanti o passaggi di consegna lenti tra dev e ops. Gli strumenti AI aiutano riducendo il tempo tra “qualcosa è rotto” e “sappiamo cosa fare dopo”.

AI per CI/CD e DevOps

I sistemi CI/CD moderni producono molti segnali (log di build, output dei test, eventi di deploy). L'AI può riassumere quel rumore in una vista breve e azionabile: cosa è fallito, dove è apparso per la prima volta e cosa è cambiato recentemente.

Può anche suggerire fix probabili in contesto—come indicare una mismatch di versione in un'immagine Docker, un passo fuori ordine in un workflow o una variabile d'ambiente mancante—senza dover scorrere manualmente centinaia di righe.

Se usi una piattaforma end-to-end come Koder.ai per costruire e ospitare, funzionalità operative come snapshot e rollback possono ridurre anche il rischio di rilascio: i team possono sperimentare, distribuire e tornare indietro rapidamente quando la realtà differisce dal piano.

Supporto agli incidenti: ipotesi e checklist più rapide

Durante gli incidenti, la velocità conta soprattutto nei primi 15–30 minuti. L'AI può:

- Redigere ipotesi di root-cause basate su log, alert e deploy recenti

- Generare una checklist di remediation (rollback, disattivare feature-flag, scalare, svuotare la coda, verificare connessioni DB)

- Proporre comandi/query mirati per confermare o escludere ogni ipotesi

Questo riduce il carico on-call accelerando il triage—non sostituendo gli umani che possiedono il servizio. L'ownership, il giudizio e la responsabilità restano del team.

Note di sicurezza (non saltarle)

L'AI è utile solo se usata in modo sicuro:

- Non incollare segreti (API key, token, dati clienti) nei prompt—usa redazione e accesso a privilegi minimi.

- Tratta l'output AI come suggerimento, non cambiamento. Code review, approvazioni e change management si applicano ancora.

- Preferisci strumenti che possano lavorare su log sanitizzati e che tengano audit trail per conformità.

Documentazione e condivisione della conoscenza: meno interruzioni e passaggi di consegne

Buona documentazione è uno dei modi meno costosi per ridurre l'attrito ingegneristico—tuttavia è spesso la prima cosa a saltare quando le scadenze si stringono. Gli strumenti AI aiutano trasformando la documentazione da attività “da rimandare” a parte leggera e ripetibile del lavoro quotidiano.

Cosa l'AI può velocizzare (senza sostituire la responsabilità)

I team vedono guadagni rapidi nella documentazione che segue pattern chiari:

- Documentazione API: generare descrizioni di endpoint, esempi request/response e tabelle di errori da spec esistenti o commenti nel codice.

- Runbook: redigere playbook di incidente passo-passo (“Se scatta l'alert X, controlla Y, poi fai Z”) da ticket passati e postmortem.

- Changelog e note di rilascio: riepilogare PR mergeate in versioni per i clienti e per uso interno.

- Guide di onboarding: creare checklist per la “prima settimana”, panoramiche dei servizi e pagine glossario dalla struttura del repo e doc esistenti.

La chiave è che l'AI produce una prima bozza solida; gli umani confermano cosa è vero, cosa è sicuro condividere e cosa è importante.

Meno interruzioni, meno colli di bottiglia

Quando la doc è cercabile e aggiornata, il team spende meno tempo a rispondere alle stesse domande tipo “Dov'è la config?” o “Come eseguo localmente?” Questo riduce il cambio di contesto, protegge il tempo di concentrazione e impedisce che la conoscenza resti ancorata a una singola persona “di riferimento”.

Documentazione ben mantenuta riduce anche i passaggi di consegna: nuovi membri, QA, support e stakeholder non tecnici possono auto-servirsi le risposte invece di aspettare uno sviluppatore.

Un workflow pratico che funziona

Un pattern semplice funziona per molti team:

- Generare aggiornamenti doc dalle PR (sommario + cosa è cambiato + come testare)

- Modifica e verifica umana (accuratezza, sicurezza, adeguatezza all'audience)

- Versionare la doc nel repo insieme al codice, così le modifiche sono revisionate e rilasciate insieme

Accessibilità per lettori non tecnici

L'AI può riscrivere appunti densi in linguaggio più chiaro, aggiungere intestazioni coerenti e standardizzare la struttura delle pagine. Questo rende la doc utilizzabile al di fuori dell'ingegneria—senza chiedere agli sviluppatori di diventare redattori professionisti.

Misurare il ROI: come quantificare i risparmi senza congetture

Il ROI diventa sfocato se chiedi solo “Abbiamo rilasciato più velocemente?” Un approccio più pulito è mettere un prezzo sui driver di costo che l'AI tocca, poi confrontare un baseline con una run “con-AI” per lo stesso workflow.

Mappa i tuoi veri driver di costo

Inizia elencando i bucket che davvero si muovono per il tuo team:

- Ore di ingegneria: build, review, test, fix, rifacimento.

- Spesa cloud: ambienti lasciati accesi, pipeline lente, test ripetuti.

- Abbonamenti strumenti: licenze AI, tool di testing, monitoring, design.

- Carico supporto: risposta agli incidenti, triage bug, ticket cliente.

- Costo del ritardo: ricavi posticipati, penali contrattuali, costo opportunità.

Una stima semplice baseline vs con-AI

Scegli una feature o uno sprint e scomponi il tempo in fasi. Poi misura due numeri per fase: ore medie senza AI vs con AI, più eventuali nuovi costi strumenti.

Una formula leggera:

Savings = (Hours_saved × Blended_hourly_rate) + Cloud_savings + Support_savings − Tool_cost

ROI % = Savings / Tool_cost × 100

Non serve un tracciamento perfetto—usa log dei tempi, tempo di ciclo PR, numero di round di review, tasso di flakiness dei test e lead time al deploy come proxy.

Non ignorare il “costo del rischio”

L'AI può anche introdurre costi se non gestita: esposizione di sicurezza, problemi di licensing/IP, gap di compliance o calo della qualità del codice. Metti un prezzo a questi come costo atteso:

- Costo del rischio = Probabilità × Impatto (es. rifacimento dopo una finding di sicurezza, tempo di remediation di audit).

Parti in piccolo, poi scala

Inizia con un workflow (per esempio, generazione test o chiarimento requisiti). Usalo per 2–4 settimane, registra metriche before/after e poi espandi ai team successivi. Questo trasforma l'adozione AI in un ciclo di miglioramento misurabile, non in un acquisto basato sulla fede.

Rischi e guardrail: sicurezza, qualità e compliance

L'AI può togliere molto lavoro noioso, ma introduce anche nuovi modi di fallire. Tratta l'output AI come un potente autocomplete: utile per la velocità, non fonte di verità.

Rischi chiave da prevedere

Primo, output incorretti o incompleti. I modelli possono sembrare convincenti pur tralasciando casi limite, inventando API o producendo codice che passa un test happy-path ma fallisce in produzione.

Secondo, perdite di sicurezza. Incollare segreti, dati cliente, log di incidente o codice proprietario in strumenti non approvati può creare esposizione accidentale. C'è anche il rischio di generare pattern di codice insicuri (autenticazione debole, deserializzazione non sicura, query vulnerabili a injection).

Terzo, licensing/IP. Il codice generato può somigliare a snippet coperti da copyright o introdurre dipendenze con licenze incompatibili se gli sviluppatori copiano senza controllo.

Quarto, decisioni pilotate da bias o incoerenza. L'AI può orientare priorità, wording o valutazioni in modi che escludono utenti o violano policy interne.

Salvaguardie pratiche che mantengono alta la velocità

Usa la revisione umana come regola, non suggerimento: richiedi review del codice per cambi generati dall'AI e chiedi ai reviewer di controllare sicurezza, gestione degli errori e test—non solo lo stile.

Aggiungi policy e controllo accessi leggeri: strumenti approvati, SSO, permessi basati sui ruoli e regole chiare su quali dati si possono condividere.

Mantieni audit trail: logga prompt e output in ambienti approvati quando possibile e registra quando l'AI è stata usata per requisiti, codice o test.

Nozioni base sulla gestione dei dati

Evita di mandare dati sensibili (PII, credenziali, log di produzione, contratti clienti) a strumenti AI generalisti. Preferisci ambienti approvati, redazione dei dati ed esempi sintetici.

Conclusione

Gli output AI sono suggerimenti, non garanzie. Con guardrail—revisione, policy, controllo accessi e tracciabilità—puoi ottenere guadagni di velocità senza scambiare sicurezza, qualità o compliance.

Roadmap pratica di adozione per team di qualsiasi dimensione

Adottare strumenti AI funziona meglio se lo tratti come qualsiasi altro cambiamento di processo: parti in piccolo, standardizza ciò che funziona ed espandi con guardrail chiari. L'obiettivo non è “usare AI ovunque”—è rimuovere il lavoro evitabile di tira e molla, rifacimenti e attese.

Fase 1: Pilot (1–2 settimane)

Scegli un team e un workflow dove gli errori sono a basso rischio ma i risparmi temporali visibili (es. scrivere user story, generare casi di test, refactor di un modulo piccolo). Mantieni lo scope ristretto e confrontalo con il tuo baseline normale.

Fase 2: Standard (leggeri, non burocratici)

Scrivi cosa significa un “buon uso dell'AI” per il tuo team.

- Template di prompt: prompt brevi e riusabili per task comuni (chiarimenti sui requisiti, note di review del codice, bozze di piani di test).

- Checklist di review: cosa gli umani devono verificare (correttezza, sicurezza, casi limite, allineamento ai requisiti).

- Lista Do/Don't:

- Do: fornire contesto, vincoli, criteri di accettazione ed esempi.

- Don't: incollare segreti, credenziali di produzione o dati proprietari che non si possono condividere.

Fase 3: Training (2–4 sessioni brevi)

Insegna a chiedere domande migliori e a convalidare gli output. Concentrati su scenari pratici: “trasforma un requisito vago in criteri di accettazione testabili” o “genera un piano di migrazione, poi verifica i rischi”.

Fase 4: Automazione (dove la ripetizione è dannosa)

Dopo che il team si fida del workflow, automatizza le parti ripetitive: bozze di descrizioni PR, scaffolding di test, note di rilascio e triage ticket. Mantieni sempre un passaggio di approvazione umana per tutto ciò che va in produzione.

Se valuti piattaforme, considera se supportano funzionalità di iterazione sicura (per esempio: modalità di pianificazione, snapshot e rollback) e opzioni pratiche di adozione (come esportare il codice sorgente). Questo è un ambito dove Koder.ai è pensato per inserirsi nelle aspettative di ingegneria esistenti: muoversi velocemente, ma mantenere il controllo.

Fase 5: Miglioramento continuo

Rivedi template e regole mensilmente. Ritira i prompt che non aiutano ed espandi gli standard solo quando vedi modelli di fallimento ricorrenti.

Metriche da tracciare (così il ROI non è congettura)

Traccia con costanza poche metriche:

- Cycle time (idea → deploy)

- Tempo di review (PR aperta → mergeata)

- Tasso di difetti (bug sfuggiti + bug trovati in QA)

- % di rifacimento (ticket riaperti, churn, cambi ripetuti)

- Soddisfazione del team (sondaggio rapido)

Checklist da usare nel prossimo progetto

Se pubblichi gli apprendimenti dal pilota, può valere la pena formalizzarli come linee guida interne o come write-up pubblico—molti team trovano che documentare metriche before/after rende l'adozione AI un processo ripetibile. (Alcune piattaforme, incluso Koder.ai, offrono anche programmi dove i team possono guadagnare crediti condividendo contenuti pratici o riferendo altri utenti, il che può compensare i costi degli strumenti durante le prime prove.)