Che problema risolve l'app (e chi la usa)

Un'ipotesi aziendale è una credenza su cui il tuo team agisce prima che sia completamente dimostrata. Può riguardare:

- Mercato: “Questo segmento cresce abbastanza da sostenere il nostro prodotto.”

- Cliente: “Gli utenti passeranno dai fogli di calcolo se la configurazione richiede meno di 10 minuti.”

- Prezzi: “I team pagheranno $49/mese per questo set di funzionalità.”

- Operazioni: “Il supporto può gestire l'onboarding con una sola persona.”

- Rischi: “Questo approccio non solleverà problemi di conformità.”

Queste ipotesi appaiono ovunque—pitch deck, discussioni sulla roadmap, chiamate di vendita, conversazioni informali—e poi scompaiono silenziosamente.

Perché i team perdono traccia delle ipotesi

La maggior parte dei team non perde le ipotesi perché non gli importi; le perdono perché la documentazione deriva, le persone cambiano ruolo e la conoscenza diventa tribale. La “verità più aggiornata” finisce divisa tra un documento, un thread Slack, qualche ticket e la memoria di qualcuno.

Quando succede, i team ripetono gli stessi dibattiti, rifanno esperimenti già fatti o prendono decisioni senza rendersene conto che qualcosa non è ancora provato.

Risultati da perseguire

Una semplice app per tracciare le ipotesi ti dà:

- Chiarezza: cosa crediamo, cosa è provato e cosa è in sospeso

- Responsabilità: chi è responsabile di ogni ipotesi e quando è stata rivista l'ultima volta

- Apprendimento più veloce: cicli più stretti tra ipotesi, esperimenti ed evidenze

- Meno rilitigazioni: un registro condiviso che riduce conversazioni circolari

Chi la usa (e quanto grande deve essere)

Product manager, fondatori, growth team, ricercatori e responsabili vendite ne traggono beneficio—chiunque faccia scommesse. Parti con un “registro delle ipotesi” leggero e facile da mantenere aggiornato, poi aggiungi funzionalità solo quando l'uso lo richiede.

Definire il modello dati principale

Prima di progettare schermate o scegliere lo stack tecnico, decidi quali “entità” conserverà l'app. Un modello dati chiaro mantiene il prodotto coerente e rende possibili report futuri.

Oggetti core (mantienili pochi)

Inizia con cinque oggetti che mappano come i team validano le idee:

- Assumption: la dichiarazione che ritieni vera (finché non è dimostrata)

- Evidence: link, note, file o metriche che supportano o indeboliscono un'ipotesi

- Experiment: un test strutturato (intervista, sondaggio, A/B test, prototipo) che genera evidenza

- Review: un checkpoint periodico in cui qualcuno conferma lo stato/confidenza attuale

- Comment: discussione leggera legata a un'ipotesi (e opzionalmente a evidence/experiments)

Campi raccomandati per Assumption

Un record Assumption dovrebbe essere veloce da creare, ma abbastanza ricco da essere azionabile:

- Statement (obbligatorio): una frase singola e testabile

- Category (obbligatorio): es. customer, problem, pricing, channel, feasibility

- Owner (obbligatorio): chi lo porterà avanti

- Confidence (obbligatorio): low/medium/high (o 1–5)

- Status (obbligatorio): draft, active, validated, invalidated, archived

Aggiungi timestamp così l'app può guidare i workflow di revisione:

- Created at, Last updated at (generati di sistema)

- Last reviewed at, Next review date (modificabili o derivati)

Relazioni

Modella il flusso di validazione:

- Una Assumption → molte Evidence

- Una Assumption → molti Experiments

- Una Assumption → molte Reviews e Comments

Obbligatorio vs. opzionale (riduci l'attrito)

Rendi obbligatori solo gli essenziali: statement, category, owner, confidence, status. Lascia dettagli come tag, impact e link opzionali così le persone possano registrare le ipotesi velocemente—e migliorarle in seguito quando arrivano le evidenze.

Imposta Status, Confidence e regole di Review

Se il registro delle ipotesi deve restare utile, ogni voce ha bisogno di un significato chiaro: dove si trova nel ciclo di vita, quanto forte è la credenza e quando va ricontrollata. Queste regole impediscono anche ai team di trattare silenziosamente congetture come fatti.

Un ciclo di vita semplice e coerente

Usa un flusso di status unico per ogni ipotesi:

Draft → Active → Validated / Invalidated → Archived

- Draft: catturata, ma non ancora concordata come qualcosa da tracciare.

- Active: il team ci si affida (o potrebbe farlo) e intende testarla o monitorarla.

- Validated: le evidenze soddisfano il tuo standard minimo (definito più avanti).

- Invalidated: le evidenze la contraddicono chiaramente; conserva per apprendimento.

- Archived: non più rilevante (prodotto cambiato, mercato evoluto, strategia spostata).

Scala di confidenza (1–5)

Scegli una scala 1–5 e definiscila in linguaggio semplice:

- Speculation (nessuna evidenza)

- Weak signal (un dato isolato)

- Some support (più segnali, ma ancora lacune)

- Strong support (evidenze consistenti, basso dubbio)

- Very strong (risultati ripetibili, stabili nel tempo)

Rendi la “confidence” relativa alla forza delle evidenze—non a quanto qualcuno desideri che sia vera.

Impatto decisionale: cosa validare per primo

Aggiungi Decision impact: Low / Medium / High. Le ipotesi ad alto impatto vanno testate prima perché influenzano prezzo, posizionamento, go-to-market o decisioni di sviluppo importanti.

Definire cosa significa “validated”

Scrivi criteri espliciti per ogni ipotesi: quale risultato conterà come successo e quale evidenza minima serve (es. 30+ risposte al sondaggio, 10+ chiamate di vendita con pattern coerente, A/B test con metrica di successo predefinita, 3 settimane di dati di retention).

Regole di revisione e revisiti

Imposta trigger di revisione automatici:

- Revisiona le ipotesi High-impact ogni 2–4 settimane

- Revisiona quando metriche core cambiano (conversione, churn, CAC)

- Revisiona dopo grandi cambiamenti di prodotto o mercato

Questo evita che “validated” diventi “vero per sempre”.

Progetta l'esperienza utente e le schermate chiave

Un'app di tracciamento delle ipotesi ha successo quando è più veloce di un foglio di calcolo. Progetta attorno alle poche azioni ripetute ogni settimana: aggiungere un'ipotesi, aggiornare le convinzioni, allegare ciò che hai imparato e fissare la prossima revisione.

Flussi primari (rendili a un clic)

Punta a un loop ristretto:

- Crea ipotesi: parti da un template (Problem, Customer, Pricing, Channel) con valori di default sensati.

- Aggiorna status: passa rapidamente tra Draft → Active → Validated/Invalidated, con nota opzionale.

- Allega evidenza: trascina il file o incolla un link, quindi taggalo a una o più ipotesi.

- Pianifica revisione: imposta “next review” subito dopo una modifica, così niente diventa obsoleto.

Schermate core di cui hai davvero bisogno

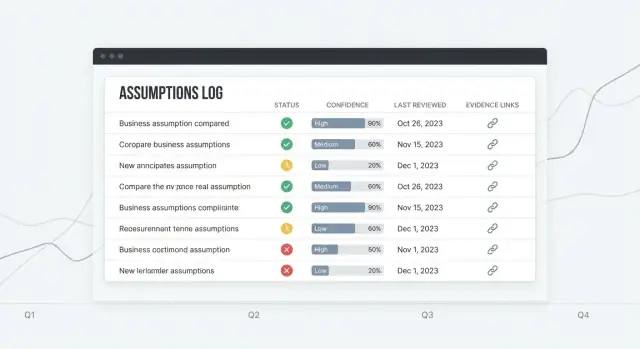

Assumptions list dovrebbe essere la home: una tabella leggibile con colonne chiare (Status, Confidence, Owner, Last reviewed, Next review). Aggiungi una riga “Quick add” prominente così i nuovi elementi non richiedono un form completo.

Assumption detail è dove si prendono decisioni: breve sintesi in cima, poi una timeline di aggiornamenti (cambi di status, cambi di confidence, commenti) e un pannello Evidence dedicato.

Evidence library aiuta a riusare gli apprendimenti: ricerca per tag, fonte e data, poi collega l'evidenza a più ipotesi.

Dashboard dovrebbe rispondere: “Cosa richiede attenzione?” Mostra revisioni imminenti, ipotesi modificate di recente e elementi ad alto impatto con bassa confidenza.

Filtri, ricerca e controllo del disordine

Rendi i filtri persistenti e veloci: category, owner, status, confidence, last reviewed date. Riduci il disordine con template, valori predefiniti e progressive disclosure (campi avanzati nascosti finché non servono).

Basi di accessibilità

Usa testo ad alto contrasto, etichette chiare e controlli accessibili da tastiera. Le tabelle devono supportare il focus su righe, intestazioni ordinabili e spaziatura leggibile—specialmente per badge di status e confidence.

Scegli uno stack tecnico pratico

Un'app per tracciare ipotesi è principalmente form, filtri, ricerca e audit trail. Questa è una buona notizia: puoi consegnare valore con uno stack semplice e concentrarti sul workflow (regole di revisione, evidenze, decisioni) invece che sull'infrastruttura.

Uno stack semplice che funziona

Una configurazione pratica comune è:

- Frontend: React, spesso con Next.js (UI veloce, routing, rendering server quando utile)

- Backend: Node.js (Express/Nest) o Python (FastAPI/Django)

- Database: Postgres

Se il tuo team già conosce uno di questi, scegli quello—coerenza batte novità.

Se vuoi prototipare rapidamente senza cablare tutto a mano, una piattaforma vibe-coding come Koder.ai può portarti a uno strumento interno funzionante in fretta: descrivi il modello dati e le schermate in chat, iterare in Planning Mode, e genera una UI React con backend pronto per la produzione (Go + PostgreSQL) che puoi poi export as source code se decidi di mantenerlo internamente.

Perché Postgres è una buona scelta

Postgres gestisce bene la natura “connessa” della gestione delle ipotesi: le ipotesi appartengono a workspace, hanno owner, si collegano a evidenze e si relazionano a esperimenti. Un DB relazionale mantiene questi legami affidabili.

È anche amico degli indici per le query che eseguirai spesso (per status, confidence, da revisionare, tag, owner), e amico degli audit quando aggiungi cronologia versioni e log di modifica. Puoi conservare eventi di cambiamento in una tabella separata e tenerli interrogabili per i report.

Mantieni hosting e ops leggeri

Punta ai servizi gestiti:

- Managed Postgres (backup automatici, upgrade, repliche di lettura più avanti)

- Hosting app per Next.js e la tua API (o un'unica app Next.js full-stack)

Questo riduce il rischio che “farla funzionare” ti occupi la settimana.

Se non vuoi gestire l'infrastruttura subito, Koder.ai può anche gestire deployment e hosting, più comodità come custom domains e snapshots/rollback mentre affini i workflow con utenti reali.

Approccio API: REST prima di tutto

Inizia con endpoint REST per CRUD, ricerca e feed di attività. È facile da debuggare e documentare. Considera GraphQL solo se hai davvero bisogno di query client-driven complesse su molti oggetti correlati.

Usa ambienti chiari

Pianifica tre ambienti fin dal primo giorno:

- Local (macchine degli sviluppatori)

- Staging (luogo sicuro per testare import, notifiche e permessi)

- Production (dati reali, accessi più restritti, monitoraggio)

Questa configurazione supporta il tracciamento delle ipotesi senza sovraingegnerizzare l'app.

Implementa autenticazione, ruoli e workspace

Go From Model to App

Turn your data model and screens into a React app with a Go and Postgres backend.

Se il registro delle ipotesi è condiviso, il controllo degli accessi deve essere noioso e prevedibile. Le persone devono sapere esattamente chi può vedere, modificare o approvare le modifiche—senza rallentare il team.

Autenticazione: parti semplice, aggiungi SSO quando serve

Per la maggior parte dei team, email + password è sufficiente per partire e imparare. Aggiungi Google o Microsoft SSO quando ti aspetti organizzazioni più grandi, politiche IT rigorose o frequente onboarding/offboarding. Se supporti entrambi, lascia che gli admin scelgano per workspace.

Mantieni minima la superficie di login: registrazione, accesso, reset password e (opzionalmente) MFA forzata più avanti.

Ruoli e permessi (Admin / Editor / Viewer)

Definisci i ruoli una volta e rendili coerenti nell'app:

- Admin: gestisce impostazioni workspace, membri, ruoli e integrazioni; può eliminare record (o richiedere eliminazione).

- Editor: crea e modifica ipotesi, allega evidenze, registra esperimenti e cambia status/confidenza.

- Viewer: accesso in sola lettura a ipotesi, evidenze, risultati degli esperimenti e dashboard.

Esegui i controlli di permesso server-side (non solo nell'interfaccia). Se aggiungi poi un flusso di “approvazione”, trattalo come un permesso, non come un nuovo ruolo.

Workspaces: separare team, prodotti e clienti

Un workspace è il confine per dati e membri. Ogni assumption, evidence e experiment appartiene esattamente a un workspace, così agenzie, aziende multi-prodotto o startup con più iniziative possono restare organizzate ed evitare condivisioni accidentali.

Inviti, offboarding e audit minimo

Usa inviti via email con una finestra di scadenza. Nell'offboarding, rimuovi l'accesso ma conserva la cronologia: le modifiche passate devono ancora mostrare l'autore originale.

Al minimo, conserva un audit trail: chi ha cambiato cosa e quando (user ID, timestamp, oggetto e azione). Questo supporta fiducia, responsabilità e debugging quando le decisioni vengono messe in discussione.

Costruisci CRUD con storico versioni e change log

CRUD è dove il tuo registro delle ipotesi smette di essere un documento e diventa un sistema. L'obiettivo non è solo creare e modificare ipotesi—è rendere ogni cambiamento comprensibile e reversibile.

Endpoint CRUD e azioni UI

Al minimo, supporta queste azioni per ipotesi ed evidenze:

- Creare, visualizzare, modificare, archiviare (soft-delete) e ripristinare ipotesi

- Allegare elementi di evidence (link, file, note) e modificare i loro metadati

- Cambiare status (es. Draft → Active → Validated/Invalidated)

Nell'interfaccia, mantieni queste azioni vicine alla pagina dettaglio: un chiaro “Edit”, un “Change status” dedicato e un'azione “Archive” intenzionalmente più difficile da cliccare.

Versioning: revisioni vs. log append-only

Hai due strategie pratiche:

-

Salvare revisioni complete (uno snapshot per salvataggio). Questo rende “ripristina precedente” semplice.

-

Log append-only (stream di eventi). Ogni modifica scrive un evento come “statement changed”, “confidence changed”, “evidence attached”. Ottimo per l'audit ma richiede più lavoro per ricostruire stati precedenti.

Molti team usano un ibrido: snapshot per modifiche importanti + eventi per azioni minori.

Rendi la cronologia leggibile (non solo archiviata)

Fornisci una timeline su ogni ipotesi:

- Chi ha cambiato cosa, quando

- Una vista diff per campi testuali (statement, hypothesis, success criteria)

- Un pulsante Restore previous sulle versioni precedenti (con conferma)

Richiedi una breve nota “perché” per modifiche significative (cambi di status/confidenza, archiviazione). Trattala come un log decisionale leggero: cosa è cambiato, quale evidenza lo ha innescato e cosa si intende fare dopo.

Evitare modifiche accidentali

Aggiungi conferme per azioni distruttive:

- Cambi di status che chiudono un'ipotesi

- Archiviazione

- Ripristino di una versione vecchia (avvisa che crea una nuova revisione)

Questo mantiene lo storico affidabile—anche quando si lavora velocemente.

Allegare evidenze e tracciare esperimenti

Le ipotesi diventano pericolose quando suonano “vere” senza nulla a cui poter puntare. L'app deve permettere ai team di allegare evidenze e registrare esperimenti leggeri così ogni affermazione abbia una traccia.

Evidence: cosa salvare (senza creare disordine)

Supporta tipi comuni: appunti di intervista, risultati di sondaggi, metriche prodotto o di fatturato, documenti (PDF, slide), e link semplici (es. dashboard analitici, ticket di supporto).

Quando qualcuno allega evidenza, cattura pochi metadati in modo che resti utilizzabile mesi dopo:

- Source (nome cliente, dataset, tool o proprietario del documento)

- Date collected (e opzionalmente date uploaded)

- Method (intervista, usability test, A/B test, desk research, ecc.)

- Quality / strength rating (più avanti)

Per evitare duplicati, modella evidence come entità separata e collegala many-to-many alle ipotesi: una nota di intervista può supportare tre ipotesi, e una ipotesi può avere dieci evidenze. Memorizza il file una sola volta (o solo il link), poi relazionalo dove serve.

Aggiungi un oggetto “Experiment” facile da compilare:

- Hypothesis (cosa ti aspetti e perché)

- Method (cosa farai)

- Key metric (la metrica da tenere d'occhio)

- Result (cosa è successo)

- Conclusion (mantieni, cambia o abbandona l'ipotesi)

Collega gli experiment alle ipotesi che testano e, opzionalmente, allega automaticamente evidenze generate (grafici, note, snapshot metriche).

Forza dell'evidenza: guida per evitare certezza falsa

Usa un semplice rubric (es. Weak / Moderate / Strong) con tooltip:

- Weak: opinioni, singola aneddoto, link non verificato

- Moderate: più interviste, segnale coerente nei sondaggi, trend metrico iniziale

- Strong: risultati ripetuti across segmenti, impatto metrico chiaro, esperimento controllato

Lo scopo non è la perfezione—è rendere la confidenza esplicita così le decisioni non si basino su sensazioni.

Aggiungi promemoria e workflow di revisione

Launch a Small MVP

Start with assumptions, evidence, experiments, and reviews-then expand only after weekly use.

Le ipotesi invecchiano silenziosamente. Un workflow di revisione semplice mantiene il registro utile trasformando “dobbiamo ricontrollare” in un'abitudine prevedibile.

Imposta una cadenza di revisione che rispecchia il rischio

Collega la frequenza di revisione a impact e confidence così non tratti tutte le ipotesi allo stesso modo.

- Settimanale: alto impatto + bassa confidenza (es. pricing centrale, canale di acquisizione principale)

- Mensile: alto impatto + confidenza media, o impatto medio + bassa confidenza

- Trimestrale (opz.): basso impatto + alta confidenza

Memorizza la next review date sull'ipotesi e ricalcolala automaticamente quando cambiano impact/confidence.

Promemoria senza diventare spam

Supporta sia email che notifiche in-app. Mantieni le impostazioni predefinite conservative: un promemoria quando scade, poi un follow-up gentile.

Rendi le notifiche configurabili per utente e workspace:

- preferenze canale (email/in-app)

- frequenza promemoria (daily/weekly)

- quiet hours / fuso orario

- opt-out per elementi a basso impatto

Digest che spingono all'azione

Invece di inviare lunghi elenchi, crea digest focalizzati:

- Needs review (scadute o prossime)

- High impact + low confidence (rischio massimo)

- Recent changes (ipotesi modificate, confidenza diminuita, evidenza rimossa)

Questi filtri dovrebbero essere first-class nell'UI in modo che la stessa logica alimenti dashboard e notifiche.

Regole di escalation semplici

L'escalation dovrebbe essere prevedibile e leggera:

- Notifica il owner quando scade.

- Se ancora scaduta dopo X giorni, notifica il team lead (o l'admin workspace).

Registra ogni promemoria ed escalation nella storia dell'ipotesi così i team possono vedere cosa è successo e quando.

Crea dashboard e report

I dashboard trasformano il registro delle ipotesi in qualcosa che i team consultano davvero. L'obiettivo non è l'analitica avanzata—è visibilità rapida su cosa è rischioso, cosa è obsoleto e cosa cambia.

KPI della dashboard che rispondono a “Siamo al sicuro?”

Inizia con pochi riquadri che si aggiornano automaticamente:

- Assumptions by status (Draft, Active, Validated, Invalidated, Archived)

- Confidence distribution (quanti sono 1–5, o Low/Medium/High)

- Overdue reviews (conteggio + link diretto alla lista delle scadute)

Associa a ogni KPI una vista click-through così le persone possono agire, non solo osservare.

Grafici di trend (utili, ma onesti)

Un grafico a linee semplice che mostra validations vs. invalidations over time aiuta a capire se l'apprendimento accelera o rallenta. Mantieni il messaggio prudente:

- Tratta i trend come segnali, non come prova di performance.

- Mostra la dimensione del campione (es. “8 outcomes questo mese”) così una singola settimana non sembra un breakthrough.

Visualizzazioni salvate per stakeholder diversi

Ruoli diversi fanno domande diverse. Fornisci filtri salvati come:

- Product: ipotesi legate alla discovery attiva, raggruppate per area prodotto

- Sales/CS: ipotesi su pricing, obiezioni, segmenti target

- Leadership: elementi ad alto impatto, rischi principali, salute delle revisioni

Le viste salvate dovrebbero essere condivisibili tramite un URL stabile (es. /assumptions?view=leadership-risk).

Evidenziare il rischio: alto impatto + evidenza debole

Crea una tabella “Risk Radar” che mostri elementi dove Impact è High ma Evidence strength è Low (o confidence è bassa). Questo diventa l'agenda per pianificazioni e pre-mortem.

Riepiloghi esportabili per le riunioni

Rendi i report portabili:

- Esportazione con un clic di una vista in PDF/CSV

- Un “Weekly Assumption Summary” che elenchi: cambiamenti principali, nuove invalidazioni e revisioni scadute

Così l'app rimane presente nelle riunioni senza costringere tutti a fare login.

Supporta import, export e integrazioni

Replace the Spreadsheet Loop

Turn your templates and filters into a usable app that beats a spreadsheet for weekly updates.

Un'app di tracciamento funziona solo se si integra con il modo in cui i team già lavorano. Import ed export aiutano a partire in fretta e mantenere la proprietà dei dati, mentre integrazioni leggere riducono copia/incolla—senza trasformare l'MVP in una piattaforma di integrazione.

Export che le persone usano davvero

Inizia con CSV export per tre tabelle: assumptions, evidence/experiments e change logs. Mantieni le colonne prevedibili (ID, statement, status, confidence, tag, owner, last reviewed, timestamps).

Aggiungi tocchi UX semplici:

- Esporta current view (filtri applicati) e full workspace

- Lascia scegliere se includere archived

- Includi un Assumption ID stabile così i fogli possono essere uniti in seguito

Importare da fogli (senza dolore)

La maggior parte dei team parte da un Google Sheet caotico. Fornisci un flusso di import che supporti:

- Carica CSV

- Column mapping (es. “Hypothesis” → Statement, “Risk” → Impact)

- Validazione con errori chiari (campi obbligatori mancanti, status sconosciuti, date non valide)

- Un'anteprima che mostri quante ipotesi verranno create vs. aggiornate

Tratta l'import come una feature primaria: spesso è il modo più veloce per ottenere adozione. Documenta il formato e le regole previste in /help/assumptions.

Integrazioni opzionali: semplici, non infinite

Mantieni le integrazioni opzionali così il core rimane semplice. Due pattern pratici:

- Webhooks: eventi come

assumption.created, status.changed, review.overdue.

- Link-out references: memorizza URL per ticket Jira, documenti Notion o cartelle di ricerca come “Related links” su un'ipotesi.

Per valore immediato, supporta una semplice integrazione Slack (via webhook) che posta quando un'ipotesi ad alto impatto cambia status o quando le revisioni scadono. Così i team sono avvisati senza dover cambiare strumenti.

Copri sicurezza, privacy e basi di protezione dei dati

Sicurezza e privacy sono feature di prodotto per un registro delle ipotesi. Le persone incolleranno link, note da chiamate e decisioni interne—progetta per essere “sicuro per default”, anche in una versione iniziale.

Basi di protezione dei dati

Usa TLS ovunque (solo HTTPS). Reindirizza HTTP su HTTPS e imposta cookie sicuri (HttpOnly, Secure, SameSite).

Conserva password usando un algoritmo moderno come Argon2id (preferito) o bcrypt con cost factor elevato. Mai memorizzare password in chiaro e non loggare token di autenticazione.

Applica il principio del privilegio minimo:

- Ruoli separati (admin, editor, viewer) e controlli di permesso su ogni azione di scrittura.

- Usa API key scoperte per integrazioni e lascia gli utenti revocarle.

- Restringi le credenziali DB così l'app non possa accedere a tabelle non necessarie.

Regole di accesso a riga (workspaces)

La maggior parte delle fughe di dati in app multi-tenant sono bug di autorizzazione. Fa' dell'isolamento workspace una regola primaria:

- Ogni record (assumption, evidence, experiment, comment) deve includere

workspace_id.

- Applica l'accesso al livello database con row-level security (RLS) o policy equivalenti, non solo nel codice applicativo.

- Nei test, crea due workspace e verifica che un utente del workspace A non possa leggere, cercare, esportare o indovinare ID del workspace B.

Backup e retention (cosa implementerai)

Definisci un piano semplice eseguibile:

- Backup giornalieri automatici del database memorizzati in una posizione separata.

- Una policy di retention (esempio: conserva 30 giorni di backup giornalieri e 12 mesi di backup mensili).

- Un drill di restore trimestrale: ripristina in staging e verifica i flussi principali.

Logging e gestione dei dati sensibili

Sii deliberato su cosa viene salvato. Evita di inserirе segreti nelle note di evidence (API key, password, link privati). Se gli utenti potrebbero incollarli ugualmente, mostra avvisi e considera la redazione automatica di pattern comuni.

Mantieni i log minimali: non loggare corpi di richiesta completi per endpoint che accettano note o allegati. Se servono diagnostica, logga metadati (workspace ID, record ID, codici errore) invece.

Privacy per appunti di intervista

Gli appunti di intervista possono contenere dati personali. Fornisci modi per:

- Segnare campi come “contiene dati personali” e limitare chi può vederli.

- Cancellare o anonimizzare note su richiesta.

- Documentare cosa memorizzi e perché in una breve nota sulla privacy (link da

/settings o /help).

Lancia, monitora e pianifica la prossima iterazione

Rilasciare un'app per le ipotesi non è una questione di “finito” ma di inserirla nei workflow reali in modo sicuro e imparare dall'uso.

Checklist pratica per il deployment

Prima di aprirla agli utenti, esegui una checklist ripetibile:

- Applica migrazioni DB (e verifica che siano reversibili).

- Carica dati seed (status, livelli di confidenza, cadenze di review).

- Crea il primo account admin e un workspace di default.

- Conferma impostazioni email/notifiche per i promemoria di review.

- Abilita backup di base e verifica il restore almeno una volta.

Se hai uno staging, prova il rilascio lì prima—soprattutto tutto ciò che tocca storico versioni e change log.

Parti semplice: vuoi visibilità senza settimane di setup.

Usa un tracker errori (es. Sentry/Rollbar) per catturare crash, chiamate API fallite e errori dei job in background. Aggiungi monitoraggio performance di base (APM o metriche server) per individuare pagine lente come dashboard e report.

Test che proteggono le regole core

Concentra i test dove gli errori costano di più:

- Test unitari per transizioni di status, regole di confidenza e scheduling delle review.

- Test di integrazione per i flussi principali: create assumption → attach evidence → log experiment → change status → vedere audit trail.

Onboarding che fa “click”

Fornisci template e ipotesi di esempio così i nuovi utenti non si trovino davanti a uno schermo vuoto. Un breve tour guidato (3–5 passaggi) dovrebbe evidenziare: dove aggiungere evidenze, come funzionano le review e come leggere il decision log.

Pianifica la prossima iterazione

Dopo il lancio, dai priorità agli miglioramenti basati sul comportamento reale:

- Modelli di scoring (impact × uncertainty, o formule di confidenza personalizzate).

- Flussi di approvazione per modifiche ad alto rischio.

- Sommari assistiti dall'AI di evidenze e risultati degli esperimenti.

Se iteri velocemente, considera strumenti che riducono il tempo tra “dobbiamo aggiungere questo workflow” e “è live per gli utenti”. Per esempio, team usano spesso Koder.ai per progettare nuove schermate e modifiche backend da un brief in chat, poi si affidano a snapshots and rollback per rilasciare esperimenti in sicurezza—and export il codice quando la direzione di prodotto è chiara.