29 apr 2025·7 min

Come creare una web app per esperimenti sui prezzi

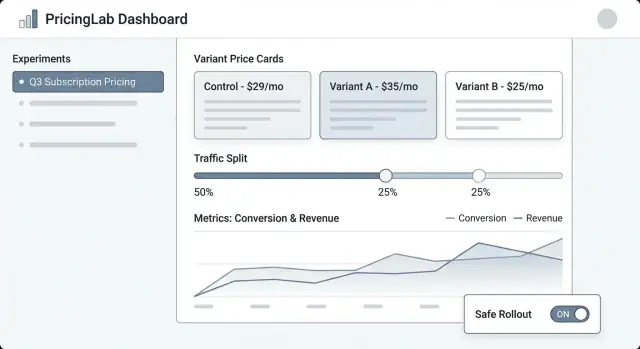

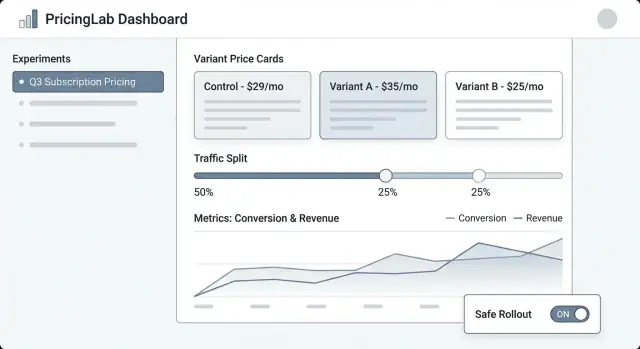

Progetta e lancia una web app interna per gestire esperimenti di prezzo: varianti, split traffico, assegnazione, metriche, dashboard e guardrail per rollout sicuri.

Progetta e lancia una web app interna per gestire esperimenti di prezzo: varianti, split traffico, assegnazione, metriche, dashboard e guardrail per rollout sicuri.

Gli esperimenti di prezzo sono test strutturati in cui mostri prezzi diversi (o packaging diversi) a gruppi differenti di clienti e misuri cosa cambia—conversione, upgrade, churn, revenue per visitatore e altro. È la versione sul prezzo di un test A/B, ma con un rischio aggiuntivo: un errore può confondere i clienti, generare ticket di supporto o perfino violare policy interne.

Un pricing experiment manager è il sistema che mantiene questi test controllati, osservabili e reversibili.

Controllo: i team hanno bisogno di un unico posto per definire cosa viene testato, dove e per chi. “Abbiamo cambiato il prezzo” non è un piano—un esperimento necessita di un'ipotesi chiara, date, regole di targeting e un kill switch.

Tracciamento: senza identificatori coerenti (experiment key, variant key, timestamp di assegnazione), l'analisi diventa un'ipotesi. Il manager deve garantire che ogni esposizione e acquisto sia attribuibile al test giusto.

Coerenza: i clienti non dovrebbero vedere un prezzo sulla pagina dei prezzi e un altro al checkout. Il manager deve coordinare come le varianti vengono applicate sulle diverse superfici in modo che l'esperienza sia coerente.

Sicurezza: gli errori di prezzo sono costosi. Servono guardrail come limiti di traffico, regole di eligibilità (es. solo nuovi clienti), passaggi di approvazione e auditabilità.

Questo post si concentra su un'app interna che gestisce esperimenti: crearli, assegnare varianti, raccogliere eventi e riportare i risultati.

Non è un motore di pricing completo (calcolo tasse, fatturazione, cataloghi multi-valuta, proration, ecc.). Invece, è il pannello di controllo e lo strato di tracciamento che rende i test di prezzo abbastanza sicuri da eseguire regolarmente.

Un pricing experiment manager è utile solo se è chiaro cosa farà—e cosa non farà. Un ambito ristretto mantiene il prodotto facile da gestire e più sicuro da rilasciare, specialmente quando c'è revenue reale in gioco.

Al minimo, la tua web app dovrebbe permettere a un operatore non tecnico di eseguire un esperimento end-to-end:

Se non costruisci altro, costruisci bene queste cose—with valori predefiniti chiari e guardrail.

Decidi presto quali formati di esperimento supporterai così UI, modello dati e logica di assegnazione restino coerenti:

Sii esplicito per prevenire lo “scope creep” che trasforma lo strumento in un sistema fragile e critico per il business:

Definisci il successo in termini operativi, non solo statistici:

Un'app per esperimenti di prezzo vive o muore con il suo modello dati. Se non puoi rispondere in modo affidabile a “che prezzo ha visto questo cliente, e quando?”, le metriche saranno rumorose e il team perderà fiducia.

Inizia con un set piccolo di oggetti core che mappano a come il pricing funziona realmente nel tuo prodotto:

Usa identificatori stabili tra i sistemi (product_id, plan_id, customer_id). Evita chiavi “belle” come nomi—possono cambiare.

I campi temporali sono altrettanto importanti:

Considera anche effective_from / effective_to sui record Price così puoi ricostruire il pricing in un qualsiasi momento nel passato.

Definisci relazioni in modo esplicito:

Praticamente, questo significa che un Event dovrebbe portare (o essere joinable a) customer_id, experiment_id e variant_id. Se memorizzi solo customer_id e “cerchi l'assignment più tardi”, rischi join errati quando le assegnazioni cambiano.

Gli esperimenti di prezzo richiedono una storia a prova di audit. Rendi record chiave append-only:

Questo approccio mantiene il reporting consistente e rende le funzionalità di governance, come gli audit log, più semplici da implementare in seguito.

Un pricing experiment manager necessita di un lifecycle chiaro così tutti capiscono cosa è modificabile, cosa è bloccato e cosa succede ai clienti quando lo stato dell'esperimento cambia.

Draft → Scheduled → Running → Stopped → Analyzed → Archived

Per ridurre lanci rischiosi, applica campi obbligatori man mano che l'esperimento avanza:

Per il pricing, aggiungi gate opzionali per Finance e Legal/Compliance. Solo gli approvatori possono spostare Scheduled → Running. Se supporti override (es. rollback urgente), registra chi ha fatto override, perché e quando, nell'audit log.

Quando un esperimento è Stopped, definisci due comportamenti espliciti:

Rendi questa scelta obbligatoria al momento dello stop così il team non può fermare un esperimento senza decidere l'impatto sui clienti.

Far bene l'assegnazione è la differenza tra un test di prezzo affidabile e rumore confuso. La tua app dovrebbe rendere semplice definire chi vede un prezzo e assicurarsi che lo veda in modo consistente.

Un cliente dovrebbe vedere la stessa variante tra sessioni, dispositivi (quando possibile) e refresh. Ciò significa che l'assegnazione deve essere deterministica: dato lo stesso assignment key e lo stesso esperimento, il risultato è sempre lo stesso.

Approcci comuni:

(experiment_id + assignment_key) e mappare il risultato su una variante.Molte squadre usano l'assegnazione basata su hash di default e memorizzano le assegnazioni solo quando necessario (per supporto o governance).

La tua app dovrebbe supportare più chiavi, perché il pricing può essere a livello utente o account:

user_id dopo la registrazione/login.Quella strada di upgrade è importante: se qualcuno naviga da anonimo e poi crea un account, dovresti decidere se mantenere la loro variante originale (continuità) o riassegnarli (regole di identità più pulite). Rendi questa impostazione chiara ed esplicita.

Supporta allocazioni flessibili:

Quando fai ramp, mantieni le assegnazioni sticky: l'aumento di traffico dovrebbe aggiungere nuovi utenti all'esperimento, non rimescolare quelli esistenti.

I test concorrenti possono entrare in conflitto. Costruisci guardrail per:

Una chiara schermata di “Assignment preview” (dato un esempio di user/account) aiuta i team non tecnici a verificare le regole prima del lancio.

Gli esperimenti di prezzo falliscono più spesso nel livello di integrazione—not perché la logica dell'esperimento è sbagliata, ma perché il prodotto mostra un prezzo e addebita un altro. La tua web app dovrebbe rendere molto esplicito “qual è il prezzo” e “come il prodotto lo usa”.

Tratta la definizione del prezzo come fonte di verità (le regole prezzo della variante, date effettive, valuta, tassazione, ecc.). Tratta la consegna del prezzo come un semplice meccanismo per recuperare il prezzo scelto tramite un endpoint API o un SDK.

Questa separazione mantiene pulito lo strumento di gestione esperimenti: i team non tecnici modificano definizioni, mentre gli ingegneri integrano un contratto di delivery stabile come GET /pricing?sku=....

Ci sono due pattern comuni:

Un approccio pratico è “display client, verify e compute server”, usando la stessa assegnazione dell'esperimento.

Le varianti devono seguire le stesse regole su:

Memorizza queste regole insieme al prezzo così ogni variante sia confrontabile e finance-friendly.

Se il servizio degli esperimenti è lento o non disponibile, il prodotto dovrebbe restituire un prezzo di default sicuro (di solito il baseline). Definisci timeout, caching e una chiara policy “fail closed” così il checkout non si rompe—e registra i fallback per quantificarne l'impatto.

Gli esperimenti di prezzo vivono o muoiono dalla misurazione. La tua app dovrebbe rendere difficile il “ship and hope” richiedendo metriche chiare, eventi puliti e un approccio di attribuzione coerente prima che un esperimento possa partire.

Inizia con una o due metriche che userai per decidere il vincitore. Scelte comuni per il pricing:

Una regola utile: se i team discutono ancora del risultato dopo il test, probabilmente non hai definito la metrica di decisione in modo sufficientemente chiaro.

I guardrail catturano danni che un prezzo più alto potrebbe causare anche se il revenue a breve termine sembra positivo:

La tua app può applicare soglie per i guardrail (es. “refund rate non deve aumentare oltre 0.3%”) e evidenziare le violazioni nella pagina dell'esperimento.

Al minimo, il tuo tracciamento deve includere identificatori stabili per esperimento e variante su ogni evento rilevante.

{

"event": "purchase_completed",

"timestamp": "2025-01-15T12:34:56Z",

"user_id": "u_123",

"experiment_id": "exp_earlybird_2025_01",

"variant_id": "v_price_29",

"currency": "USD",

"amount": 29.00

}

Rendi queste proprietà obbligatorie al momento dell'ingestione, non “best effort”. Se un evento arriva senza experiment_id/variant_id, instradalo in un bucket “unattributed” e segnala problemi di qualità dati.

Gli esiti del pricing sono spesso ritardati (renewal, upgrade, churn). Definisci:

Questo mantiene i team allineati su quando un risultato è affidabile—e previene decisioni premature.

Uno strumento per esperimenti di prezzo funziona solo se product manager, marketing e finance possono usarlo senza chiedere un ingegnere per ogni clic. La UI dovrebbe rispondere a tre domande rapidamente: Cosa è in esecuzione? Cosa cambierà per i clienti? Cosa è successo e perché?

Lista esperimenti dovrebbe sembrare una dashboard operativa. Mostra: nome, stato (Draft/Scheduled/Running/Paused/Ended), start/end, traffic split, metrica primaria e owner. Aggiungi un visibile “ultimo aggiornamento da” con timestamp così le persone si fidano dei dati.

Dettaglio esperimento è la home base. Metti un sommario compatto in alto (stato, date, audience, split, metrica primaria). Sotto, usa tab come Varianti, Targeting, Metriche, Change log e Risultati.

Editor variante deve essere semplice e opinabile. Ogni riga variante dovrebbe includere prezzo (o regola di prezzo), valuta, periodo di fatturazione e una descrizione in linguaggio naturale (“Piano annuale: $120 → $108”). Rendi difficile modificare accidentalmente una variante live richiedendo conferma.

Vista risultati dovrebbe partire dalla decisione, non solo dai grafici: “La Variante B ha aumentato la conversione checkout del 2.1% (95% CI …).” Poi fornisci drill-down e filtri di supporto.

Usa badge di stato coerenti e mostra una timeline delle date chiave. Visualizza lo split traffico sia in percentuale che con una piccola barra. Includi un pannello “Chi ha cambiato cosa” (o tab) che elenchi modifiche a varianti, targeting e metriche.

Prima di permettere Start, richiedi: almeno una metrica primaria selezionata, almeno due varianti con prezzi validi, un piano di ramp (opzionale ma raccomandato) e un piano di rollback o prezzo di fallback. Se manca qualcosa, mostra errori azionabili (“Aggiungi una metrica primaria per abilitare i risultati”).

Fornisci azioni sicure e prominenti: Pause, Stop, Ramp up (es. 10% → 25% → 50%), e Duplicate (copia impostazioni in un nuovo Draft). Per azioni rischiose, usa conferme che riassumono l'impatto (“La pausa congela le assegnazioni e ferma l'esposizione”).

Se vuoi validare i workflow (Draft → Scheduled → Running) prima di investire in una build completa, una piattaforma vibe-coding come Koder.ai può aiutarti a mettere in piedi un'app interna da una specifica chat-based—poi iterare velocemente con schermate basate su ruoli, audit log e dashboard semplici. È particolarmente utile per i prototipi iniziali dove vuoi un UI React funzionante e un backend Go/PostgreSQL che poi puoi esportare e rafforzare.

È un pannello di controllo interno e uno strato di tracciamento per i test di prezzo. Aiuta i team a definire esperimenti (ipotesi, pubblico, varianti), mostrare un prezzo coerente su tutte le superfici, raccogliere eventi attribuibili e avviare/pausare/interrompere in sicurezza con auditabilità.

Non è voluto essere un motore di fatturazione completo o gestione fiscale; orchestra gli esperimenti attorno allo stack di pricing/billing esistente.

Un MVP pratico include:

Se queste funzioni sono affidabili, si può iterare su targeting e reporting più ricchi in seguito.

Modella gli oggetti principali che ti permettono di rispondere: “Quale prezzo ha visto questo cliente, e quando?” Tipicamente:

Evita modifiche mutabili alla storia chiave: versione i prezzi e aggiungi nuovi record di assignment invece di sovrascrivere.

Definisci un lifecycle come Draft → Scheduled → Running → Stopped → Analyzed → Archived.

Blocca i campi a rischio quando l'esperimento è Running (varianti, targeting, split) e richiedi validazioni prima di cambiare stato (metriche selezionate, tracking confermato, piano di rollback). Questo evita modifiche a metà test che renderebbero i risultati inaffidabili e creerebbero incongruenze per i clienti.

Usa l'assegnazione sticky così lo stesso cliente ottiene la stessa variante su sessioni/dispositivi quando possibile.

Pattern comuni:

(experiment_id + assignment_key) e mappa il risultato su un bucket varianteMolte squadre usano hash-first e memorizzano le assegnazioni solo quando serve per governance o supporto.

Scegli una chiave che rispecchi come i clienti vivono il pricing:

Se inizi anonimo, definisci una regola esplicita di “identity upgrade” al signup/login (mantenere la variante originale per continuità vs riassegnare per pulizia).

Tratta “Stop” come due decisioni separate:

Rendi la policy di serving una scelta obbligatoria al momento dello stop, così il team riconosce l'impatto sui clienti.

Assicura che la stessa variante guidi sia la visualizzazione sia l'addebito:

Definisci anche fallback sicuri se il servizio è lento/non disponibile (di solito il prezzo baseline) e registra ogni fallback per visibilità.

Richiedi uno schema di eventi piccolo e coerente dove ogni evento rilevante includa experiment_id e variant_id.

In genere definisci:

Se un evento arriva senza i campi experiment/variant, instradalo in un bucket “unattributed” e segnala problemi di qualità dati.

Usa un modello di ruoli semplice e una cronologia completa delle modifiche:

Questo riduce lanci accidentali e facilita revisioni finanziarie/compliance e retrospettive future.