12 nov 2025·8 min

Da laboratorio no‑profit a leader AI: la storia di OpenAI

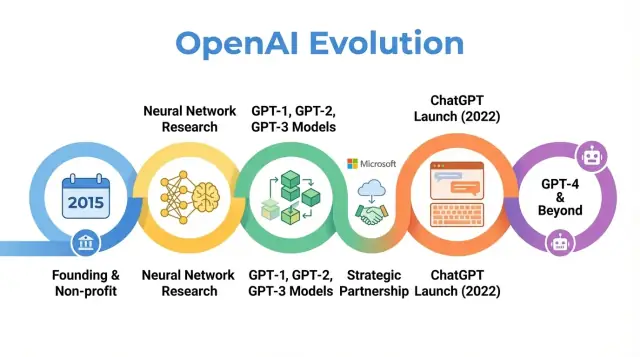

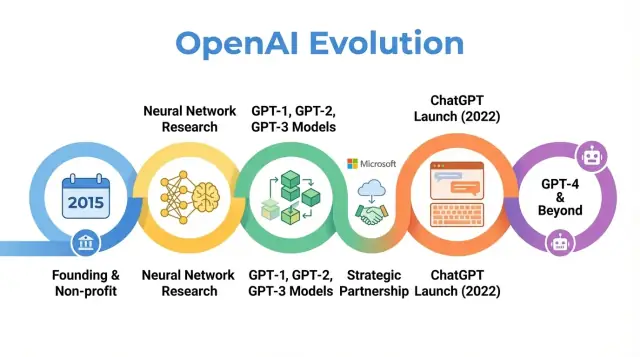

Esamina la storia di OpenAI, dalle origini no‑profit e i traguardi di ricerca fino al lancio di ChatGPT, GPT‑4 e alla sua missione in evoluzione.

Esamina la storia di OpenAI, dalle origini no‑profit e i traguardi di ricerca fino al lancio di ChatGPT, GPT‑4 e alla sua missione in evoluzione.

OpenAI è un'azienda di ricerca e deployment di AI il cui lavoro ha influenzato il modo in cui si pensa all'intelligenza artificiale, dai primi articoli di ricerca fino a prodotti come ChatGPT. Capire come OpenAI si è evoluta — da un piccolo laboratorio no‑profit nel 2015 a un attore centrale nell'AI — aiuta a spiegare perché l'AI moderna appare oggi in questo modo.

La storia di OpenAI non è soltanto una sequenza di rilasci di modelli. È uno studio di caso su come missione, incentivi, svolte tecniche e pressione pubblica interagiscono. L'organizzazione iniziò con forte enfasi sulla ricerca aperta e sul beneficio diffuso, poi si ristrutturò per attrarre capitale, formò una profonda partnership con Microsoft e lanciò prodotti usati da centinaia di milioni di persone.

Tracciare la storia di OpenAI illumina diverse tendenze più ampie nell'AI:

Missione e valori: OpenAI è stata fondata con l'obiettivo dichiarato di garantire che l'intelligenza artificiale generale (AGI) benefici tutta l'umanità. Come quella missione è stata interpretata e rivista nel tempo rivela le tensioni tra obiettivi idealistici e realtà commerciali.

Svolte nella ricerca: La progressione dai primi progetti a sistemi come GPT‑3, GPT‑4, DALL·E e Codex riflette lo spostamento verso modelli di base su larga scala che alimentano molte applicazioni AI attuali.

Governance e struttura: Il passaggio da una pura no‑profit a un'entità a profitto limitato e la creazione di meccanismi di governance complessi evidenziano come si stiano sperimentando nuove forme organizzative per gestire tecnologie potenti.

Impatto pubblico e scrutinio: Con ChatGPT e altri rilasci, OpenAI è passata da un laboratorio noto soprattutto nei circoli AI a un nome familiare, attirando attenzione su sicurezza, allineamento e regolamentazione che ora modellano i dibattiti politici a livello globale.

Questo articolo segue il percorso di OpenAI dal 2015 fino agli sviluppi più recenti, mostrando come ogni fase rifletta cambiamenti più ampi nella ricerca, nell'economia e nella governance dell'AI — e cosa ciò potrebbe significare per il futuro del settore.

OpenAI è stata fondata nel dicembre 2015, in un periodo in cui il machine learning — soprattutto il deep learning — stava rapidamente migliorando ma era ancora lontano dall'intelligenza generale. I benchmark per riconoscimento immagini calavano, i sistemi di speech miglioravano e aziende come Google, Facebook e Baidu investivano ingenti risorse nell'AI.

Una preoccupazione crescente tra ricercatori e leader tecnologici era che l'AI avanzata potesse finire controllata da poche grandi corporazioni o governi. OpenAI fu concepita come contrappeso: un'organizzazione di ricerca focalizzata sulla sicurezza a lungo termine e sulla distribuzione ampia dei benefici dell'AI, piuttosto che sul vantaggio commerciale ristretto.

Fin dal primo giorno, OpenAI ha definito la sua missione in termini di intelligenza artificiale generale (AGI), non solo progressi incrementali nel machine learning. L'affermazione centrale era che OpenAI avrebbe lavorato per assicurare che l'AGI, se creata, “beneficiasse tutta l'umanità”.

Questa missione aveva implicazioni concrete:

I primi post pubblici e la carta fondativa enfatizzavano sia apertura sia cautela: OpenAI avrebbe pubblicato gran parte del suo lavoro, ma avrebbe anche considerato l'impatto sociale del rilascio di capacità potenti.

OpenAI nacque come laboratorio di ricerca no‑profit. Gli impegni di finanziamento iniziali annunciati ammontavano a circa 1 miliardo di dollari in promesse, sebbene si trattasse di un impegno a lungo termine più che di liquidità immediata. Tra i primi sostenitori vi erano Elon Musk, Sam Altman, Reid Hoffman, Peter Thiel, Jessica Livingston e YC Research, con supporto anche da aziende come Amazon Web Services e Infosys.

Il team di leadership iniziale combinava esperienza da startup, ricerca e operazioni:

Questa miscela di imprenditorialità della Silicon Valley e ricerca ai massimi livelli ha plasmato la cultura iniziale di OpenAI: estremamente ambiziosa nel spingere i confini delle capacità AI, ma organizzata come no‑profit orientata a un impatto globale a lungo termine più che alla commercializzazione immediata.

Quando OpenAI iniziò come laboratorio no‑profit nel 2015, la promessa pubblica era semplice ma ambiziosa: avanzare l'intelligenza artificiale condividendo quanto più possibile con la comunità più ampia.

Gli anni iniziali furono definiti da una filosofia “aperta per default”. Gli articoli di ricerca venivano pubblicati rapidamente, il codice veniva solitamente rilasciato e gli strumenti interni venivano trasformati in progetti pubblici. L'idea era che accelerare il progresso scientifico e il controllo pubblico sarebbe stato più sicuro e più vantaggioso che concentrare capacità in un'unica azienda.

Allo stesso tempo, la sicurezza era già parte della conversazione. Il team discuteva quando l'apertura potesse aumentare il rischio di abuso e iniziò a elaborare idee per rilasci a fasi e revisioni politiche, anche se quelle idee erano ancora informali rispetto ai processi di governance successivi.

Il focus scientifico iniziale di OpenAI copriva diverse aree chiave:

Questi progetti erano più prove di ciò che era possibile con deep learning, capacità di calcolo e regimi di addestramento intelligenti, che prodotti rifiniti.

Due degli output più influenti di quest'era furono OpenAI Gym e Universe.

Entrambi i progetti riflettevano un impegno per infrastrutture condivise anziché vantaggi proprietari.

Durante questo periodo no‑profit, OpenAI veniva spesso ritratta come un contrappeso mission‑driven ai laboratori AI delle grandi aziende tecnologiche. I pari apprezzavano la qualità della ricerca, la disponibilità di codice e ambienti e la disponibilità a impegnarsi nelle discussioni sulla sicurezza.

La copertura mediatica enfatizzava la combinazione inusuale di finanziatori di alto profilo, una struttura non commerciale e la promessa di pubblicare apertamente. Quella reputazione — come laboratorio influente, aperto e preoccupato delle conseguenze a lungo termine — fissò aspettative che avrebbero poi influenzato le reazioni a ogni cambiamento strategico dell'organizzazione.

Il punto di svolta nella storia di OpenAI fu la decisione di concentrarsi su grandi modelli di linguaggio basati su transformer. Questo cambiamento trasformò OpenAI da un laboratorio principalmente orientato alla ricerca in un'azienda nota per modelli di base su cui altri costruiscono.

GPT‑1 era modesto rispetto agli standard successivi — 117 milioni di parametri, addestrato su BookCorpus — ma offrì una prova di concetto cruciale.

Invece di addestrare modelli separati per ogni compito NLP, GPT‑1 mostrò che un singolo modello transformer, addestrato con un obiettivo semplice (predire la parola successiva), poteva essere adattato con un minimo fine‑tuning a compiti come question answering, analisi del sentiment ed entailment testuale.

Per la roadmap interna di OpenAI, GPT‑1 convalidò tre idee:

GPT‑2 spinse la stessa ricetta molto più in là: 1,5 miliardi di parametri e un dataset molto più ampio derivato dal web. I suoi output erano spesso sorprendentemente coerenti: articoli multi‑paragrafo, storie di finzione e riassunti che a prima vista sembravano scritti da umani.

Quelle capacità sollevarono allarmi su potenziali abusi: propaganda automatizzata, spam, molestie e fake news su scala. Invece di rilasciare subito il modello completo, OpenAI adottò una strategia di rilascio a fasi:

Questo fu uno dei primi esempi di alto profilo in cui OpenAI legò esplicitamente decisioni di deployment alla sicurezza e all'impatto sociale, e plasmò il modo in cui l'organizzazione considerò disclosure, apertura e responsabilità.

GPT‑3 aumentò ancora la scala — questa volta a 175 miliardi di parametri. Invece di basarsi principalmente sul fine‑tuning per ogni compito, GPT‑3 dimostrò il few‑shot e persino lo zero‑shot learning: il modello poteva spesso svolgere un nuovo compito semplicemente da istruzioni e pochi esempi nel prompt.

Quel livello di generalità cambiò il modo in cui sia OpenAI sia l'intera industria pensavano ai sistemi AI. Piuttosto che costruire molti modelli stretti, un grande modello poteva fungere da motore general‑purpose per:

Crucialmente, OpenAI scelse di non open‑sourcare GPT‑3. L'accesso fu offerto tramite un'API commerciale. Questa decisione segnò una svolta strategica:

GPT‑1, GPT‑2 e GPT‑3 tracciano un arco chiaro nella storia di OpenAI: aumentare i transformer, scoprire capacità emergenti, confrontarsi con sicurezza e abusi e gettare le basi commerciali che avrebbero poi supportato prodotti come ChatGPT e lo sviluppo continuo di GPT‑4 e oltre.

Nel 2018, i leader di OpenAI erano convinti che restare un piccolo laboratorio finanziato da donazioni non sarebbe stato sufficiente per costruire e guidare in sicurezza sistemi AI molto grandi. L'addestramento di modelli all'avanguardia richiedeva già decine di milioni di dollari in compute e talento, con curve di costo orientate verso valori molto più alti. Per competere per i migliori ricercatori, effettuare esperimenti su scala e assicurarsi accesso a lungo termine all'infrastruttura cloud, OpenAI aveva bisogno di una struttura in grado di attrarre capitale serio senza abbandonare la missione originale.

Nel 2019 OpenAI lanciò OpenAI LP, una nuova limited partnership “capped‑profit”. L'obiettivo era sbloccare grandi investimenti esterni mantenendo la missione del nonprofit — assicurare che l'AGI beneficiasse tutta l'umanità — in cima alla gerarchia decisionale.

Le startup tradizionali finanziate da venture alla fine rispondono a azionisti che cercano ritorni non limitati. I fondatori di OpenAI temevano che questo avrebbe creato forti pressioni a privilegiare profitto rispetto a sicurezza, apertura o deployment attento. La struttura LP fu un compromesso: poteva emettere interessi simili a equity e raccogliere denaro su larga scala, ma con regole diverse.

Nel modello a profitto limitato, investitori e dipendenti possono ottenere ritorni sui loro investimenti, ma solo fino a un multiplo fisso dell'investimento iniziale (per gli investitori iniziali si è parlato di fino a 100x, con limiti inferiori nelle tranche successive). Una volta raggiunto quel cap, qualsiasi valore aggiuntivo creato dovrebbe fluire alla controllante no‑profit per essere usato in linea con la sua missione.

Questo contrasta nettamente con le startup tipiche, dove il valore azionario può, almeno teoricamente, crescere senza limiti e dove massimizzare il valore per gli azionisti è la norma legale e culturale.

La OpenAI Nonprofit rimane l'entità di controllo. Il suo consiglio supervisiona OpenAI LP ed è incaricato di dare priorità agli interessi dell'umanità rispetto a quelli di qualsiasi gruppo particolare di investitori o dipendenti.

Formalmente:

Questo disegno di governance mira a dare a OpenAI la flessibilità di raccolta fondi e assunzione di un'organizzazione commerciale mantenendo però il controllo orientato alla missione.

La ristrutturazione scatenò dibattiti dentro e fuori l'organizzazione. I sostenitori sostenevano che fosse l'unico modo pratico per assicurare i miliardi probabilmente necessari alla ricerca AI d'avanguardia pur limitando gli incentivi al profitto. I critici si chiedevano se una qualsiasi struttura che offre grandi ritorni potesse davvero resistere alla pressione commerciale e se i limiti fossero abbastanza bassi o chiaramente applicati.

Praticamente, OpenAI LP aprì la porta a grandi investimenti strategici, in particolare da parte di Microsoft, e permise all'azienda di offrire pacchetti retributivi competitivi legati a potenziali ritorni. Questo, a sua volta, permise a OpenAI di scalare i team di ricerca, espandere i cicli di addestramento per modelli come GPT‑3 e GPT‑4 e costruire l'infrastruttura necessaria per distribuire sistemi come ChatGPT su scala globale — tutto mantenendo un collegamento di governance formale con le sue origini no‑profit.

Nel 2019 OpenAI e Microsoft annunciarono una partnership pluriennale che rimodellò i ruoli di entrambe le aziende nell'AI. Microsoft investì un importo riportato di 1 miliardo di dollari, combinando denaro e crediti Azure, in cambio dello status di partner commerciale preferenziale di OpenAI.

L'accordo rispondeva al bisogno di OpenAI di enormi risorse di compute per addestrare modelli sempre più grandi, mentre dava a Microsoft accesso a tecnologie AI all'avanguardia per differenziare i suoi prodotti e la sua piattaforma cloud. Negli anni successivi la relazione si approfondì tramite finanziamenti aggiuntivi e collaborazione tecnica.

OpenAI scelse Microsoft Azure come piattaforma cloud primaria per diverse ragioni:

Questo rese Azure l'ambiente predefinito per l'addestramento e il serving di modelli come GPT‑3, Codex e successivamente GPT‑4.

La partnership portò alla realizzazione di uno dei più grandi sistemi supercomputing per AI al mondo, costruito su Azure per i carichi di lavoro di OpenAI. Microsoft mise in evidenza questi cluster come esempi di punta delle capacità AI di Azure, mentre OpenAI si affidò a essi per spingere dimensioni dei modelli, dati di addestramento e velocità di sperimentazione.

Questo sforzo infrastrutturale congiunto sfumò la linea tra “cliente” e “partner”: OpenAI influenzò la roadmap AI di Azure e Azure fu ottimizzato per le esigenze di OpenAI.

Microsoft ottenne diritti di licenza esclusivi su alcune tecnologie OpenAI, in particolare GPT‑3. Ciò permise a Microsoft di integrare i modelli OpenAI nei suoi prodotti — Bing, Office, GitHub Copilot, Azure OpenAI Service — mentre altre aziende vi accedevano tramite l'API di OpenAI.

Questa esclusività alimentò il dibattito: i sostenitori sostennero che forniva i fondi e la distribuzione necessari per scalare l'AI potente in modo sicuro; i critici temevano che concentrasse l'influenza sui modelli di frontiera in un'unica grande azienda tecnologica.

Allo stesso tempo, la partnership diede visibilità mainstream a OpenAI. Il branding di Microsoft, le integrazioni di prodotto e i canali di vendita enterprise aiutarono a trasformare i sistemi OpenAI da demo di ricerca a strumenti quotidiani usati da milioni, modellando la percezione pubblica di OpenAI come laboratorio indipendente e partner AI centrale di Microsoft.

Man mano che i modelli di OpenAI miglioravano nella comprensione e generazione del linguaggio, il team si spinse in nuove modalità: immagini e codice. Questo ampliamento estese l'impatto di OpenAI dalla scrittura e dal dialogo alla creatività visiva e allo sviluppo software.

CLIP (Contrastive Language–Image Pretraining), annunciato all'inizio del 2021, fu un passo importante verso modelli che capiscono il mondo in modo più simile agli umani.

Invece di addestrarsi solo su immagini etichettate, CLIP imparò da centinaia di milioni di coppie immagine‑didascalia raccolte dal web pubblico. Fu addestrato ad abbinare immagini con la loro descrizione testuale più probabile e a distinguerle da descrizioni errate.

Questo donò a CLIP abilità sorprendentemente generali:

CLIP diventò una base per il lavoro generativo su immagini successivo in OpenAI.

DALL·E (2021) applicò architetture in stile GPT alle immagini, generando immagini direttamente da prompt testuali: “una poltrona a forma di avocado” o “insegna di un negozio con scritto ‘openai’”. Dimostrò che i modelli linguistici potevano essere estesi per produrre immagini coerenti e spesso giocose.

DALL·E 2 (2022) migliorò significativamente risoluzione, realismo e controllabilità. Introdusse funzionalità come:

Questi sistemi cambiarono il modo in cui designer, marketer, artisti e hobbisti prototipavano idee, spostando parte del lavoro creativo verso l'esplorazione iterativa guidata da prompt.

Codex (2021) prese la famiglia GPT‑3 e l'adattò al codice sorgente, addestrandosi su grandi codebase pubbliche. Può tradurre linguaggio naturale in frammenti funzionanti per linguaggi come Python, JavaScript e molti altri.

GitHub Copilot, costruito su Codex, portò questa capacità dentro gli strumenti di sviluppo quotidiani. I programmatori cominciarono a ricevere funzioni intere, test e boilerplate come suggerimenti, usando commenti in linguaggio naturale come guida.

Per lo sviluppo software, Codex suggerì uno spostamento graduale:

Insieme, CLIP, DALL·E e Codex mostrarono che l'approccio di OpenAI poteva estendersi oltre il testo, ampliando l'impatto della ricerca in ambiti come arte, design e ingegneria.

OpenAI lanciò ChatGPT come “research preview” gratuito il 30 novembre 2022, annunciandolo con un breve post sul blog e un tweet piuttosto che con una grande campagna di prodotto. Il modello era basato su GPT‑3.5 e ottimizzato per il dialogo, con barriere per rifiutare alcune richieste dannose o pericolose.

L'uso esplose quasi immediatamente. Milioni di persone si iscrissero nel giro di giorni e ChatGPT divenne una delle applicazioni consumer a più rapida crescita di sempre. Screenshot di conversazioni inondarono i social mentre gli utenti testavano la sua capacità di scrivere saggi, debug del codice, redigere email e spiegare argomenti complessi in linguaggio semplice.

L'appeal di ChatGPT stava nella sua versatilità più che in un singolo caso d'uso.

Nell'istruzione, gli studenti lo usarono per riassumere letture, generare domande di pratica, tradurre o semplificare articoli accademici e ottenere spiegazioni passo‑passo di problemi di matematica o scienze. Gli insegnanti lo sperimentarono per progettare programmi, redigere rubriche e creare materiali di apprendimento differenziati, mentre le scuole dibattevano se e come consentirne l'uso.

Al lavoro, i professionisti chiesero a ChatGPT di redigere email, copy marketing e report, strutturare presentazioni, generare frammenti di codice, scrivere casi di test e fungere da partner di brainstorming per idee di prodotto o strategie. Freelancer e piccole imprese lo sfruttarono come assistente a basso costo per contenuti e analisi.

Per la risoluzione di problemi quotidiani, le persone si rivolsero a ChatGPT per piani di viaggio, idee di cucina con gli ingredienti a disposizione, spiegazioni legali o mediche di base (con l'avvertenza di cercare consulenze professionali), e aiuto per imparare nuove competenze o lingue.

Il preview gratuito serviva a ridurre le barriere e raccogliere feedback su fallimenti, abusi e funzionalità mancanti. Con la crescita dell'utilizzo, OpenAI affrontò costi infrastrutturali elevati e una domanda di accesso più affidabile.

Nel febbraio 2023 OpenAI introdusse ChatGPT Plus, un piano in abbonamento che offriva risposte più veloci, accesso prioritario nei momenti di picco e accesso anticipato a nuove funzionalità e modelli come GPT‑4. Questo creò una fonte di ricavi ricorrenti pur mantenendo un livello gratuito per l'accesso ampio.

Col tempo, OpenAI aggiunse opzioni più orientate al business: accesso API agli stessi modelli conversazionali, strumenti per l'integrazione in prodotti e flussi di lavoro e offerte come ChatGPT Enterprise e piani team rivolti alle organizzazioni che richiedono maggiore sicurezza, controlli amministrativi e conformità.

La visibilità improvvisa di ChatGPT intensificò dibattiti di lunga data sull'AI.

Regolatori e decisori politici si preoccupavano per privacy, protezione dei dati e conformità alle leggi esistenti, specialmente in aree come l'Unione Europea. Alcune autorità limitarono temporaneamente o investigarono ChatGPT mentre valutavano se la raccolta e il trattamento dei dati rispettassero gli standard legali.

Gli educatori affrontarono il problema del plagio e dell'integrità accademica, poiché gli studenti potevano generare saggi e compiti difficili da rilevare. Ciò portò a divieti o politiche rigide in alcune scuole, mentre altre riorientarono le valutazioni verso processi, esami orali o lavori svolti in classe.

Eticisti e ricercatori sollevarono allarmi su disinformazione, uso eccessivo dell'AI per decisioni critiche, bias nelle risposte e impatti sui lavori creativi e conoscitivi. Emersero anche questioni su dati di addestramento, copyright e diritti di artisti e scrittori il cui lavoro potrebbe aver influenzato il comportamento dei modelli.

Per OpenAI, ChatGPT segnò un punto di svolta: trasformò l'organizzazione da laboratorio principalmente orientato alla ricerca in un'azienda al centro delle discussioni globali su come i potenti modelli linguistici debbano essere distribuiti, governati e integrati nella vita quotidiana.

OpenAI rilasciò GPT‑4 nel marzo 2023 come passo significativo oltre GPT‑3.5, il modello che inizialmente alimentava ChatGPT. GPT‑4 migliorò nel ragionamento, nel seguire istruzioni complesse e nel mantenere coerenza su conversazioni più lunghe. Diventò anche molto migliore nel gestire prompt sfumati, come spiegare clausole legali, riassumere articoli tecnici o generare codice da requisiti ambigui.

Rispetto a GPT‑3.5, GPT‑4 ridusse molte modalità di errore evidenti: era meno propenso a inventare fonti quando gli si chiedevano citazioni, gestiva casi limite in matematica e logica in modo più affidabile e produceva output più consistenti su richieste ripetute.

GPT‑4 introdusse capacità multimodali: oltre al testo, in alcune configurazioni può accettare immagini come input. Ciò abilita casi d'uso come descrivere grafici, leggere note scritte a mano, interpretare screenshot di interfacce utente o analizzare foto per estrarre informazioni strutturate.

Sui benchmark standardizzati, GPT‑4 superò significativamente i modelli precedenti. Ottenne punteggi vicini ai migliori percentile in esami professionali simulati come l'esame di avvocatura, il SAT e vari test avanzati. Migliorò anche su benchmark di coding e ragionamento, riflettendo abilità più forti sia nella comprensione del linguaggio sia nella risoluzione di problemi.

GPT‑4 divenne rapidamente il nucleo dell'API di OpenAI e alimentò una nuova ondata di prodotti di terze parti: copiloti AI in suite di produttività, assistenti di coding, strumenti di supporto clienti, piattaforme educative e applicazioni verticali in ambiti come diritto, finanza e sanità.

Nonostante questi progressi, GPT‑4 continua a generare allucinazioni, può essere indotto a risposte non sicure o di parte e non possiede una comprensione genuina o conoscenze aggiornate in tempo reale. OpenAI ha concentrato molta attenzione sulla ricerca di allineamento per GPT‑4 — usando tecniche come reinforcement learning from human feedback, red‑teaming e regole di sicurezza a livello di sistema — ma sottolinea che un deployment attento, monitoraggio e ricerca continua sono ancora necessari per gestire rischi e abusi.

Fin dagli inizi, OpenAI ha inquadrato sicurezza e allineamento come centrali alla sua missione, non come un'aggiunta successiva ai lanci di prodotto. L'organizzazione dichiara costantemente che il suo obiettivo è costruire sistemi AI altamente capaci allineati ai valori umani e distribuirli in modo che beneficino tutti, non solo azionisti o partner iniziali.

Nel 2018 OpenAI pubblicò l'OpenAI Charter, che formalizzò le priorità:

Il Charter funge da bussola di governance, influenzando decisioni su direzioni di ricerca, velocità di deployment e partnership esterne.

Con l'aumentare delle capacità dei modelli, OpenAI ha costruito funzioni dedicate a safety e governance accanto ai team di ricerca core:

Questi gruppi influenzano decisioni di lancio, livelli di accesso e politiche d'uso per modelli come GPT‑4 e DALL·E.

Un approccio tecnico distintivo è stato il reinforcement learning from human feedback (RLHF). Etichettatori umani revisionano output dei modelli, li classificano e addestrano un modello di reward. Il modello principale viene poi ottimizzato per produrre risposte più vicine al comportamento preferito dagli umani, riducendo output tossici, di parte o pericolosi.

Col tempo OpenAI ha sovrapposto a RLHF ulteriori tecniche: policy di sicurezza a livello di sistema, filtri di contenuto, fine‑tuning per domini specifici e strumenti di monitoraggio che possono limitare o segnalare usi ad alto rischio.

OpenAI ha partecipato a framework pubblici di sicurezza, come impegni volontari con governi, pratiche di reporting sui modelli e standard di sicurezza per modelli di frontiera. Ha collaborato con accademici, organizzazioni della società civile e ricercatori di sicurezza su valutazioni, red‑teaming e audit.

Queste collaborazioni, insieme a documenti formali come l'OpenAI Charter e politiche d'uso in evoluzione, costituiscono la spina dorsale dell'approccio di OpenAI alla governance di sistemi AI sempre più potenti.

La rapida ascesa di OpenAI è stata accompagnata da critiche e tensioni interne, spesso centrate su quanto l'organizzazione mantenga ancora allineata la sua azione con la missione originaria di beneficio ampio e sicuro.

All'inizio OpenAI enfatizzava pubblicazioni e condivisione. Col crescere delle capacità di modelli come GPT‑2, GPT‑3 e GPT‑4, l'azienda si è spostata verso rilasci limitati, accesso solo via API e meno dettagli tecnici pubblici.

I critici hanno sostenuto che questo cambiamento contraddica la promessa implicita dal nome “OpenAI”. I sostenitori interni hanno replicato che trattenere pesi e dettagli di addestramento è necessario per gestire rischi di abuso e sicurezza.

OpenAI ha risposto pubblicando valutazioni di sicurezza, schede di sistema e documenti di policy, mantenendo però i pesi core dei modelli proprietari. Questo viene presentato come un equilibrio tra apertura, sicurezza e pressione competitiva.

Con l'approfondirsi della partnership con Microsoft — integrazione dei modelli in Azure e in prodotti come Copilot — sono emerse preoccupazioni sulla concentrazione di compute, dati e potere decisionale.

I critici temono che poche aziende controllino ora i modelli general‑purpose più avanzati e l'enorme infrastruttura dietro di essi. Altri sostengono che la commercializzazione aggressiva (ChatGPT Plus, offerte enterprise e licenze esclusive) si allontani dalla missione no‑profit di beneficio ampio.

La leadership di OpenAI inquadra i ricavi come necessari per finanziare la ricerca costosa, mantenendo una struttura a profitto limitato e un charter che dà priorità agli interessi dell'umanità rispetto ai ritorni azionari. Ha anche introdotto programmi come tier di accesso gratuito, partnership di ricerca e alcuni strumenti open source per dimostrare benefici pubblici.

Dissensi interni su quanto velocemente muoversi, quanto essere aperti e come dare priorità alla sicurezza sono emersi ripetutamente.

Dario Amodei e altri lasciarono nel 2020 per fondare Anthropic, citando visioni diverse su sicurezza e governance. Dimissioni successive di ricercatori chiave per la sicurezza, incluso Jan Leike nel 2024, hanno evidenziato preoccupazioni che obiettivi di prodotto a breve termine stessero prendendo il sopravvento sul lavoro di sicurezza a lungo termine.

La frattura più visibile avvenne nel novembre 2023, quando il consiglio destituì brevemente il CEO Sam Altman, citando perdita di fiducia. Dopo una forte reazione dei dipendenti e negoziazioni con Microsoft e altri stakeholder, Altman tornò, il consiglio fu riorganizzato e OpenAI promise riforme di governance, incluso un nuovo Safety and Security Committee.

Questi episodi sottolinearono che l'organizzazione sta ancora lottando per conciliare deployment rapido, successo commerciale e responsabilità dichiarate su sicurezza e beneficio ampio.

OpenAI è passata da un piccolo laboratorio di ricerca a un provider infrastrutturale centrale per l'AI, influenzando come nuovi strumenti vengono costruiti, regolati e percepiti.

Più che pubblicare modelli, OpenAI ora gestisce una piattaforma completa utilizzata da startup, imprese e sviluppatori solitari. Tramite API per modelli come GPT‑4, DALL·E e sistemi futuri, è diventata:

Questo ruolo di piattaforma significa che OpenAI non solo avanza la ricerca, ma imposta anche i default su come milioni di persone vivono l'esperienza iniziale con AI potenti.

Il lavoro di OpenAI spinge concorrenti e comunità open source a rispondere con nuovi modelli, metodi di addestramento e approcci alla sicurezza. Questa competizione accelera il progresso e al contempo acuisce i dibattiti su apertura, centralizzazione e commercializzazione dell'AI.

Governi e regolatori guardano sempre più alle pratiche, ai report di trasparenza e alla ricerca di allineamento di OpenAI quando redigono regole per il deployment, valutazioni di sicurezza e uso responsabile. Le conversazioni pubbliche su ChatGPT, GPT‑4 e sistemi futuri influenzano fortemente l'immaginario collettivo sui rischi e benefici dell'AI.

Con l'aumentare delle capacità dei modelli, questioni irrisolte sul ruolo di OpenAI diventano sempre più rilevanti:

Queste domande determineranno se i sistemi AI futuri amplificheranno disuguaglianze esistenti o contribuiranno a ridurle.

Sviluppatori e imprese possono:

Gli individui possono:

L'influenza futura di OpenAI dipenderà non solo dalle sue decisioni interne, ma anche da come governi, concorrenti, società civile e utenti comuni sceglieranno di interagire, criticare ed esigere responsabilità dai sistemi che costruisce.

OpenAI è stata fondata nel 2015 come laboratorio di ricerca no‑profit con la missione di garantire che l'intelligenza artificiale generale (AGI), se dovesse essere creata, benefici tutta l'umanità.

Diversi fattori hanno influenzato la sua nascita:

Questa storia d'origine continua a influenzare la struttura, le partnership e gli impegni pubblici di OpenAI ancora oggi.

AGI (intelligenza artificiale generale) indica sistemi AI in grado di svolgere un'ampia gamma di compiti cognitivi a livello umano o superiore, anziché essere strumenti ristretti ottimizzati per un singolo lavoro.

La missione di OpenAI è:

Questa missione è formalizzata nell'OpenAI Charter e guida le decisioni importanti su direzioni di ricerca e modalità di deployment.

OpenAI è passata da una pura organizzazione no‑profit a una limited partnership “capped‑profit” (OpenAI LP) per raccogliere il capitale consistente necessario alla ricerca AI d'avanguardia, cercando al contempo di mantenere la missione al centro.

Punti chiave:

È un esperimento di governance la cui efficacia è ancora oggetto di dibattito.

Microsoft fornisce a OpenAI grandi risorse di cloud compute tramite Azure e ha investito miliardi di dollari nell'azienda.

La partnership comprende:

In cambio, OpenAI ottiene le risorse necessarie per addestrare e distribuire modelli di punta su scala globale, mentre Microsoft ottiene capacità AI differenzianti per il suo ecosistema.

La serie GPT mostra una progressione in scala, capacità e strategia di distribuzione:

OpenAI iniziò con un approccio “open by default”, rilasciando articoli, codice e strumenti come OpenAI Gym. Con l'aumento delle capacità dei modelli, si è spostata verso:

OpenAI sostiene che ciò sia necessario per ridurre i rischi di abuso e gestire la sicurezza. I critici obiettano che questo si discosta dalla promessa implicita nel nome “OpenAI” e concentra potere in un'unica azienda.

OpenAI usa una combinazione di strutture organizzative e metodi tecnici per gestire sicurezza e abusi:

Queste misure riducono i rischi ma non eliminano problemi come allucinazioni, bias e possibili abusi, che rimangono sfide attive di ricerca e governance.

ChatGPT, lanciato alla fine del 2022, rese i modelli di linguaggio di grande dimensione direttamente accessibili al pubblico generale tramite una semplice interfaccia chat.

Ha cambiato l'adozione dell'AI:

Questa visibilità pubblica ha intensificato il controllo sulla governance, il modello di business e le pratiche di sicurezza di OpenAI.

I modelli di OpenAI, in particolare Codex e GPT‑4, stanno già modificando parti del lavoro cognitivo e creativo:

Benefici potenziali:

Rischi e preoccupazioni:

Puoi interagire con l'ecosistema OpenAI in vari modi:

In tutti i casi, è utile rimanere informati su come i modelli vengono addestrati e governati e fare pressione per trasparenza, responsabilità e accesso equo man mano che questi sistemi diventano più potenti.

Ogni passo ha spinto i confini tecnici e ha imposto nuove decisioni su sicurezza, accesso e commercializzazione.

L'impatto netto dipenderà molto da politiche, scelte organizzative e da come individui e imprese integreranno l'AI nei flussi di lavoro.