Perché C conta ancora

C è una di quelle tecnologie che la maggior parte delle persone non usa direttamente, eppure da cui dipende quasi tutto. Se usi un telefono, un laptop, un router, un'auto, uno smartwatch o anche una macchina per il caffè con display, è probabile che C sia coinvolto da qualche parte nello stack—facendo avviare il dispositivo, comunicare con l'hardware o eseguire abbastanza velocemente da risultare “istantaneo”.

Per chi costruisce sistemi, C resta uno strumento pratico perché offre un mix raro di controllo e portabilità. Può girare molto vicino alla macchina (quindi puoi gestire direttamente memoria e hardware), ma si può anche spostare tra CPU e sistemi operativi diversi con relativamente poche riscritture. Questa combinazione è difficile da sostituire.

I tre ambiti in cui C domina ancora

L'impronta più grande del C si vede in tre aree:

- Sistemi operativi: kernel, librerie core, driver e utility di basso livello da cui dipende il resto.

- Dispositivi embedded: sistemi piccoli con limiti stringenti su memoria, energia e storage, dove il comportamento prevedibile è fondamentale.

- Hotspot di performance: le parti critiche per la velocità di programmi più grandi—percorsi di codice dove pochi millisecondi o pochi watt contano.

Anche quando un'app è scritta in linguaggi di livello superiore, parti della sua base (o i moduli sensibili alle prestazioni) spesso risalgono al C.

Cosa imparerai in questo articolo

Questo pezzo collega i punti tra Dennis Ritchie, gli obiettivi originali dietro il C, e le ragioni per cui appare ancora nei prodotti moderni. Copriremo:

- una breve e leggibile porzione di storia (inclusa l'influenza di Unix),

- le scelte di design che rendono C piccolo ma potente,

- dove si colloca oggi il C—i suoi punti di forza e le sfide legate alla sicurezza.

Nota sullo scope

Qui parliamo specificamente del C, non di “tutti i linguaggi di basso livello.” C++ e Rust potranno apparire per confronto, ma l'attenzione è su cosa è C, perché è stato progettato così e perché i team continuano a sceglierlo per sistemi reali.

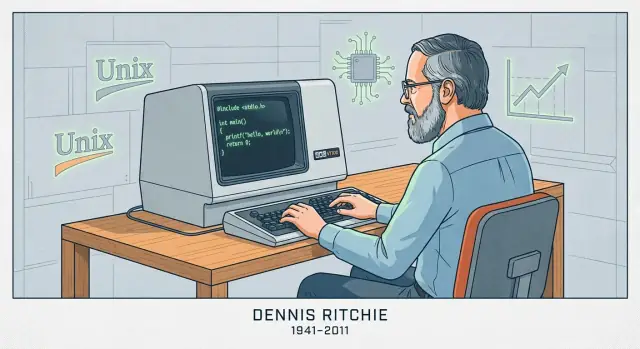

Dennis Ritchie in breve

Dennis Ritchie (1941–2011) è stato un informatico statunitense noto soprattutto per il suo lavoro ai Bell Labs di AT&T, un'organizzazione di ricerca centrale nei primi sviluppi dell'informatica e delle telecomunicazioni.

Bell Labs, Unix e un nuovo tipo di software di sistema

Ai Bell Labs tra la fine degli anni '60 e gli anni '70, Ritchie lavorò con Ken Thompson e altri su ricerca di sistemi operativi che portò a Unix. Thompson creò una versione iniziale di Unix; Ritchie divenne un co-creatore chiave mentre il sistema evolveva in qualcosa di manutenibile, migliorabile e condivisibile in ambito accademico e industriale.

Creare il C per costruire sistemi reali

Ritchie creò anche il linguaggio C, basandosi su idee di linguaggi precedenti usati ai Bell Labs. C fu progettato per essere pratico nella scrittura di software di sistema: dà ai programmatori controllo diretto sulla memoria e sulla rappresentazione dei dati, pur essendo più leggibile e portabile rispetto a scrivere tutto in assembly.

Questa combinazione contò perché Unix fu riscritto in C. Non fu una riscrittura per stile—rese Unix molto più semplice da spostare su nuovo hardware e da estendere nel tempo. Il risultato fu un circolo virtuoso: Unix fornì un caso d'uso serio e esigente per C, e C rese Unix più facile da adottare oltre una singola macchina.

Perché l'accoppiata Unix + C divenne influente

Insieme, Unix e C hanno definito la “programmazione di sistema” come la conosciamo: costruire sistemi operativi, librerie core e strumenti in un linguaggio vicino alla macchina ma non legato a un singolo processore. La loro influenza si vede nei sistemi operativi successivi, negli strumenti per sviluppatori e nelle convenzioni che molti ingegneri ancora imparano oggi—non per mito, ma perché l'approccio funzionava su larga scala.

Come è stato progettato C: piccolo, portabile, vicino alla macchina

I primi sistemi operativi erano per lo più scritti in assembly. Questo dava agli ingegneri pieno controllo sull'hardware, ma significava anche che ogni cambiamento era lento, soggetto a errori e strettamente legato a un processore specifico. Anche piccole feature potevano richiedere pagine di codice a basso livello, e spostare il sistema su una macchina diversa spesso significava riscrivere grandi porzioni da zero.

Da BCPL a B a C (versione breve)

Dennis Ritchie non inventò il C in isolamento. Crebbe da linguaggi di sistemi più semplici usati ai Bell Labs.

- BCPL offriva uno stile compatto per scrivere strumenti e software di sistema.

- B (creato da Ken Thompson) adattò idee di BCPL per i primi lavori su Unix, ma mancava dei tipi di dato e della struttura necessari per sistemi più grandi.

- C mantenne lo spirito di “linguaggio piccolo”, aggiungendo le feature che resero Unix praticabile da costruire e mantenere sull'hardware reale.

L'obiettivo di design: uno strato sottile sopra la macchina

C fu costruito per mappare in modo pulito a ciò che i computer effettivamente fanno: byte in memoria, operazioni su registri e salti nel codice. Per questo semplici tipi di dato, accesso esplicito alla memoria e operatori che rispecchiano le istruzioni della CPU sono centrali. Puoi scrivere codice sufficientemente di alto livello da gestire una grande codebase, ma ancora abbastanza diretto da controllare il layout in memoria e le prestazioni.

Cosa significa “portabile” in parole semplici

“Portabile” significa poter spostare lo stesso sorgente C su un computer diverso e, con cambiamenti minimi, compilarlo lì e ottenere lo stesso comportamento. Invece di riscrivere il sistema operativo per ogni nuovo processore, i team potevano mantenere la maggior parte del codice e sostituire solo le piccole parti specifiche dell'hardware. Questa miscela—codice per lo più condiviso e piccoli margini dipendenti dalla macchina—fu la svolta che aiutò Unix a diffondersi.

Le idee chiave che rendono C veloce

La velocità del C non è magia—deriva in gran parte da quanto direttamente mappa a ciò che la macchina fa e da quanto poco “lavoro extra” viene inserito fra il tuo codice e la CPU.

Cosa produce la compilazione

C è tipicamente compilato. Significa che scrivi codice leggibile dall'umano, poi un compilatore lo traduce in codice macchina: le istruzioni grezze che il processore esegue.

Nella pratica, un compilatore produce un eseguibile (o file oggetto poi collegati in uno). Il punto chiave è che il risultato finale non viene interpretato riga per riga a runtime—è già nella forma che la CPU capisce, il che riduce l'overhead.

Controllo prevedibile, basso overhead

C ti dà mattoni semplici: funzioni, cicli, interi, array e puntatori. Poiché il linguaggio è piccolo ed esplicito, il compilatore può spesso generare codice macchina diretto.

Di solito non c'è un runtime obbligatorio che faccia lavoro in background come tracciare ogni oggetto, inserire controlli nascosti o gestire metadati complessi. Quando scrivi un ciclo, in genere ottieni un ciclo. Quando accedi a un elemento di un array, in genere ottieni un accesso diretto alla memoria. Questa prevedibilità è una grande ragione per cui C rende bene nelle parti sensibili alle prestazioni.

Gestione manuale della memoria: controllo con conseguenze

C usa la gestione manuale della memoria, cioè il tuo programma richiede esplicitamente memoria (per esempio con malloc) e la rilascia esplicitamente (con free). Questo esiste perché il software di sistema spesso ha bisogno di controllo fine su quando la memoria viene allocata, quanto e per quanto tempo—con overhead nascosto ridotto al minimo.

Lo scambio è semplice: più controllo può significare più velocità ed efficienza, ma anche più responsabilità. Se dimentichi di liberare memoria, la liberi due volte o usi memoria dopo averla liberata, i bug possono essere gravi e talvolta critici per la sicurezza.

C nei sistemi operativi: kernel, driver e librerie core

I sistemi operativi stanno al confine tra software e hardware. Il kernel deve gestire memoria, schedulare la CPU, gestire interrupt, parlare con i dispositivi e fornire system call su cui tutto il resto si appoggia. Questi compiti non sono astratti—riguardano la lettura e scrittura di posizioni di memoria specifiche, il lavoro con registri della CPU e la reazione ad eventi che arrivano in momenti scomodi.

Perché kernel e driver necessitano accesso a basso livello

Driver di dispositivo e kernel necessitano di un linguaggio che esprima “fai esattamente questo” senza lavoro nascosto. In pratica significa:

- Controllo preciso del layout della memoria (strutture che corrispondono a formati definiti dall'hardware)

- Manipolazione diretta dei puntatori quando si mappano memorie di dispositivo o si costruiscono tabelle di pagina

- Capacità di interagire con interrupt e primitive di concorrenza

- Convenzioni di chiamata prevedibili e requisiti minimi di runtime

C si adatta bene perché il suo modello centrale è vicino alla macchina: byte, indirizzi e controllo di flusso semplice. Non c'è un runtime obbligatorio, un garbage collector o un sistema a oggetti che il kernel debba hostare prima di poter avviare.

C come scelta di default per kernel e librerie core

Unix e i primi lavori di sistema hanno popolarizzato l'approccio che Ritchie contribuì a plasmare: implementare grandi parti del SO in un linguaggio portabile, ma mantenere sottile il "confine hardware". Molti kernel moderni seguono ancora quel modello. Anche quando è necessario assembly (codice di boot, switch di contesto), il grosso dell'implementazione è spesso in C.

C domina anche le librerie di sistema core—componenti come le standard C library, il codice fondamentale di networking e pezzi runtime di basso livello su cui i linguaggi di alto livello spesso dipendono. Se hai usato Linux, BSD, macOS, Windows o un RTOS, probabilmente ti sei appoggiato a codice C senza accorgertene.

Perché i team continuano a fidarsi di C qui

L'appetibilità del C nel lavoro su OS è meno nostalgia e più economia dell'ingegneria:

- Toolchain stabili: compilatori, linker, debugger e profiler maturi e ben compresi

- Portabilità: lo stesso codebase C può essere portato su nuove CPU e schede con sforzo gestibile

- Modello mentale hardware chiaro: è più facile ragionare su cosa genererà il compilatore e come si comporterà il codice sotto vincoli stretti

Esistono altri linguaggi—ma C rimane la baseline

Rust, C++ e altri linguaggi sono usati in parti di sistemi operativi e possono portare vantaggi reali. Tuttavia, C resta il denominatore comune: il linguaggio in cui molti kernel sono scritti, quello che la maggior parte delle interfacce di basso livello presuppone e la baseline con cui gli altri linguaggi di sistema devono interoperare.

Ricevi ricompense per il rilascio

Condividi ciò che costruisci con Koder.ai e guadagna crediti per progetti futuri.

“Embedded” di solito significa computer che non pensi come computer: microcontrollori dentro termostati, smart speaker, router, auto, dispositivi medici, sensori industriali e innumerevoli elettrodomestici. Questi sistemi spesso eseguono un unico scopo per anni, con limiti stretti di costo, potenza e memoria.

I vincoli con cui vivono i team embedded

Molti target embedded hanno kilobyte (non gigabyte) di RAM e spazio flash limitato per il codice. Alcuni funzionano a batteria e devono dormire la maggior parte del tempo. Altri hanno deadline real-time—se un ciclo di controllo motore è in ritardo di pochi millisecondi, l'hardware può comportarsi male.

Questi vincoli plasmano ogni decisione: quanto è grande il programma, quanto spesso si sveglia e se la sua temporizzazione è prevedibile.

Perché C si adatta così bene

C tende a produrre binari piccoli con overhead di runtime minimo. Non c'è una macchina virtuale obbligatoria e spesso si può evitare l'allocazione dinamica del tutto. Questo conta quando devi far entrare il firmware in una flash di dimensione fissa o garantire che il dispositivo non "si blocchi" inaspettatamente.

Altrettanto importante, C rende semplice parlare con l'hardware. I chip embedded espongono periferiche—pin GPIO, timer, bus UART/SPI/I2C—tramite registri mappati in memoria. Il modello di C mappa naturalmente su questo: puoi leggere e scrivere indirizzi specifici, controllare singoli bit e farlo con pochissima astrazione che si interponga.

Pattern comuni nei progetti reali

Molto del C embedded è o:

- Bare-metal: nessun sistema operativo, solo codice di avvio, un main loop e handler di interrupt.

- Basato su RTOS: un piccolo sistema operativo real-time dove task C coordinano con code, semafori e timer.

In entrambi i casi vedrai codice costruito attorno a registri hardware (spesso marcati volatile), buffer a dimensione fissa e temporizzazione accurata. Quello stile "vicino alla macchina" è esattamente il motivo per cui C rimane scelta predefinita per firmware che deve essere piccolo, parsimonioso in energia e affidabile sotto deadline.

C nel software critico per le prestazioni: dove la velocità ripaga

"Critico per le prestazioni" è qualsiasi situazione in cui tempo e risorse fanno parte del prodotto: millisecondi influenzano l'esperienza utente, cicli CPU influenzano il costo dei server e l'uso della memoria determina se un programma entra o meno. In questi contesti, C resta una scelta standard perché permette ai team di controllare come i dati sono disposti in memoria, come il lavoro è schedulato e cosa il compilatore può ottimizzare.

Dove la velocità del C conta nel mondo reale

Spesso trovi C al cuore di sistemi dove il lavoro avviene ad alto volume o con budget di latenza stretti:

- Database e motori di storage (indicizzazione, caching, compressione, esecuzione di query)

- Codec per audio/video e elaborazione immagini (loop di encode/decode che girano miliardi di volte)

- Networking (elaborazione pacchetti, proxy, primitive TLS, event loop)

- Motori di gioco (budget per frame, fisica, streaming asset)

- Parti HPC (kernel numerici, routine vettorializzate, allocator di memoria custom)

Questi domini non sono “veloci” ovunque. Di solito hanno inner loop specifici che dominano il tempo di esecuzione.

L’"hot path": ottimizza il 5% che costa il 95%

I team raramente riscrivono un prodotto intero in C solo per essere più veloci. Invece profilano, trovano l'hot path (la piccola porzione di codice dove si spende la maggior parte del tempo) e la ottimizzano.

C aiuta perché gli hot path spesso sono limitati da dettagli di basso livello: pattern di accesso alla memoria, comportamento della cache, predizione dei rami e overhead di allocazione. Quando puoi mettere a punto le strutture dati, evitare copie non necessarie e controllare l'allocazione, i guadagni possono essere drammatici—senza toccare il resto dell'applicazione.

Lavorare con linguaggi di livello superiore: estensioni e FFI

I prodotti moderni sono frequentemente “multi-linguaggio”: Python, Java, JavaScript o Rust per la maggior parte del codice, e C per il core critico.

Approcci comuni di integrazione includono:

- Estensioni native (es., estensioni C per Python, addon Node-API)

- FFI (Foreign Function Interface) dove un linguaggio chiama funzioni C compilate attraverso un ABI stabile

- Librerie C come dipendenze condivise usate da molti runtime (una implementazione veloce, molti chiamanti)

Questo modello mantiene lo sviluppo pratico: iterazione rapida in un linguaggio alto e prestazioni previste dove servono. Il compromesso è la cura attorno ai confini—conversioni di dati, regole di ownership ed error handling—perché attraversare la linea FFI deve essere efficiente e sicuro.

Portabilità e standard: cosa rende C facilmente trasferibile

Distribuisci un prototipo oggi

Ospita la tua nuova app e rilascia aggiornamenti senza ricostruire tutta la pipeline.

Una ragione per cui C si diffuse così rapidamente è che viaggia: lo stesso nucleo del linguaggio può essere implementato su macchine estremamente diverse, da microcontrollori minuscoli a supercomputer. Quella portabilità non è magia—è il risultato di standard condivisi e di una cultura che scrive rispettando quegli standard.

Come gli standard hanno fatto diventare “C” la stessa cosa ovunque

Le prime implementazioni di C variavano per fornitore, rendendo il codice difficile da condividere. Il grande cambiamento arrivò con ANSI C (spesso chiamato C89/C90) e poi ISO C (revisioni come C99, C11, C17 e C23). Non serve memorizzare i numeri: il punto importante è che uno standard è un accordo pubblico su cosa il linguaggio e la libreria standard facciano.

Cosa ti dà in pratica uno standard C

Uno standard fornisce:

- Regole coerenti per il linguaggio (tipi, operatori, controllo di flusso)

- Una libreria standard con comportamento prevedibile (I/O, stringhe, math, allocazione memoria)

- Una base che gli autori di compilatori possono implementare e su cui i team possono contare

Per questo il codice scritto pensando allo standard può spesso essere spostato tra compilatori e piattaforme con poche modifiche.

Dove la portabilità si rompe nella vita reale

I problemi di portabilità di solito nascono dall'affidarsi a cose che lo standard non garantisce, tra cui:

- Undefined behavior: codice che il compilatore può trattare in qualsiasi modo (incluso “sembra ok” fino a quando una build non rompe). Esempi classici: leggere oltre i limiti di un array o usare un valore non inizializzato.

- Assunzioni sulle dimensioni:

int non è garantito essere a 32 bit e le dimensioni dei puntatori variano. Se il tuo programma assume dimensioni esatte, può fallire cambiando target.

- API specifiche della piattaforma: chiamare funzioni OS-specifiche può essere necessario, ma limita i posti in cui il codice può girare.

Consiglio pratico: scrivi “standard-first”, poi ottimizza

Un buon default è preferire la libreria standard e mantenere il codice non portabile dietro piccoli wrapper chiaramente nominati.

Inoltre, compila con flag che ti spingano verso un C portabile e ben definito. Scelte comuni includono:

- Selezionare una modalità standard (per esempio:

-std=c11)

- Abilitare warning (

-Wall -Wextra) e considerarli seriamente

Quella combinazione—codice pensato per lo standard più build rigorose—fa più per la portabilità di qualunque trucco “intelligente”.

La parte difficile: puntatori, memoria e classi di bug comuni

La forza del C è anche la sua lama affilata: ti permette di lavorare vicino alla memoria. Questo è un grande motivo per cui C è veloce e flessibile—ed è anche il motivo per cui principianti (e esperti stanchi) possono commettere errori che altri linguaggi prevengono.

I puntatori, spiegati con “indirizzi delle cassette”

Immagina la memoria del tuo programma come una lunga strada di cassette postali numerate. Una variabile è una cassetta che contiene qualcosa (come un intero). Un puntatore non è la cosa stessa—è l'indirizzo scritto su un foglietto che ti dice quale cassetta aprire.

Questo è utile: puoi passare l'indirizzo invece di copiare il contenuto della cassetta, e puoi puntare ad array, buffer, struct o perfino funzioni. Ma se l'indirizzo è sbagliato, apri la cassetta sbagliata.

Rischi comuni di cui sentirai parlare

- Buffer overflow: scrivere oltre la fine di un buffer (come riempire troppo la cassetta #10 e invadere la #11). Può causare crash o essere sfruttato.

- Use-after-free: liberare un blocco di memoria e poi usare un puntatore che ancora “ricorda” il vecchio indirizzo—anche se quella cassetta è stata riassegnata.

- Integer overflow: aritmetica che avvolge (es., un calcolo di dimensione diventa più piccolo del previsto), portando ad allocare meno memoria del necessario e poi a sovrascrivere buffer.

Perché questi bug contano

Questi problemi si manifestano come crash, corruzione silenziosa dei dati e vulnerabilità di sicurezza. Nel codice di sistema—dove il C è spesso usato—queste rotture possono influenzare tutto ciò che sta sopra.

Una visione equilibrata

C non è “insicuro per default.” È permissivo: il compilatore assume che tu intenda ciò che scrivi. Questo è ottimo per le prestazioni e per il controllo a basso livello, ma significa anche che C è facile da usare male a meno di abbinarlo a buone abitudini, review e tool adeguati.

Rendere il C più sicuro nella pratica

C ti dà controllo diretto, ma raramente perdona gli errori. La buona notizia è che “C sicuro” riguarda meno trucchi magici e più abitudini disciplinate, interfacce chiare e l'uso di strumenti che fanno i controlli noiosi.

Tecniche difensive che scalano

Progetta API che rendano difficile l'uso scorretto. Preferisci funzioni che prendono le dimensioni dei buffer insieme ai puntatori, che restituiscono codici di stato espliciti e che documentano chi è proprietario della memoria allocata.

Il controllo dei limiti dovrebbe essere routine, non eccezione. Se una funzione scrive in un buffer, deve validare le lunghezze a monte e fallire velocemente. Per l'ownership della memoria, mantieni regole semplici: un allocator, un percorso di free corrispondente e una regola chiara su chi libera le risorse.

I compilatori moderni possono avvertire su pattern rischiosi—tratta i warning come errori nella CI. Aggiungi controlli runtime in sviluppo con sanitizers (address, undefined behavior, leak) per scoprire scritture fuori bound, use-after-free, overflow interi e altri pericoli specifici del C.

Analisi statica e linters aiutano a trovare problemi che potrebbero non apparire nei test. Il fuzzing è particolarmente efficace per parser e handler di protocolli: genera input inaspettati che spesso rivelano buffer e bug di macchina a stati.

Pratiche di revisione e test

La code review dovrebbe guardare esplicitamente ai fallimenti comuni del C: off-by-one, terminatori NUL mancanti, mixo signed/unsigned, valori di ritorno non controllati e percorsi di errore che perdono memoria.

I test contano di più quando il linguaggio non ti protegge. I unit test sono utili; i test di integrazione sono meglio; e i test di regressione per bug già trovati sono l'ideale.

Sottinsiemi più sicuri e linee guida

Se il tuo progetto richiede affidabilità o sicurezza rigorosa, considera di adottare un “sottinsieme” restrittivo di C e un insieme scritto di regole (per esempio, limitare l'aritmetica dei puntatori, vietare alcune chiamate di libreria o richiedere wrapper). La chiave è la coerenza: scegli linee guida che il team possa far rispettare con tooling e review, non ideali che rimangono su una slide.

C vs altri linguaggi: perché i team lo scelgono ancora

Costruisci un'app companion per il dispositivo

Crea un'app Flutter per diagnostica, controlli di stato e supporto sul campo.

C si trova a un'intersezione insolita: è abbastanza piccolo da poter essere compreso end-to-end, ma abbastanza vicino all'hardware e ai confini del SO da essere il “collante” su cui tutto il resto dipende. Questa combinazione spiega perché i team lo scelgono ancora—anche quando linguaggi più nuovi sembrano più attraenti sulla carta.

C vs C++: obiettivi diversi, compatibilità complicata, mescolanza pratica

C++ è stato creato per aggiungere meccanismi di astrazione più forti (classi, template, RAII) restando in gran parte source-compatible con il C. Ma “compatibile” non significa “identico.” C++ ha regole diverse per conversioni implicite, risoluzione degli overload e persino su cosa è una dichiarazione valida in casi limite.

Nei prodotti reali è comune mixarli:

- Moduli di basso livello restano in C per ABI stabili e convenzioni di chiamata semplici.

- Strati superiori usano C++ per strutturazione e gestione più sicura delle risorse.

Il ponte è tipicamente un boundary API C. Il codice C++ esporta funzioni con extern "C" per evitare name mangling, e entrambe le parti concordano su strutture dati semplici. Questo permette di modernizzare a passi senza riscrivere tutto.

C vs Rust (a grandi linee): la sicurezza vince, ma i vincoli contano

La grande promessa di Rust è la sicurezza della memoria senza garbage collector, supportata da tooling solido ed ecosistema di pacchetti. Per molti progetti nuovi, può ridurre intere classi di bug (use-after-free, race di dati).

Ma l'adozione non è gratuita. I team possono essere vincolati da:

- Librerie, driver o SDK vendor esistenti in C

- Compilatori e debugger validati per target specifici

- Regimi di certificazione dove la maturità degli strumenti e le evidenze contano

- Ingegneri che devono mantenere il codice per decenni

Rust può interoperare con C, ma il confine aggiunge complessità, e non tutti i target embedded o ambienti di build sono ugualmente supportati.

Gran parte del codice fondamentale del mondo è in C, e riscriverlo è rischioso e costoso. C si adatta anche a ambienti dove servono binari prevedibili, assunzioni minime di runtime e ampia disponibilità di compilatori—from microcontrollori minuscoli alle CPU mainstream.

Scegli in base ai vincoli, non alle mode

Se hai bisogno di massima portata, interfacce stabili e toolchain provate, C rimane una scelta razionale. Se i tuoi vincoli lo permettono e la sicurezza è prioritaria, un linguaggio più recente può valere la pena. La decisione migliore parte quasi sempre dall'hardware target, dagli strumenti e dal piano di manutenzione a lungo termine—non da ciò che è trendy quest'anno.

Come sarà il futuro (e come imparare C oggi)

C non sta per sparire, ma il suo baricentro diventa più chiaro. Continuerà a prosperare dove il controllo diretto su memoria, temporizzazione e binari conta—e perderà terreno dove la sicurezza e la velocità di iterazione contano più dell'ultimo microsecondo.

Dove C resta forte

C probabilmente rimarrà scelta predefinita per:

- Kernel e lavoro di basso livello OS (scheduler, gestori di memoria, filesystem), dove servono prestazioni prevedibili e assunzioni minime di runtime.

- Driver e codice a contatto con l'hardware, dove mappi registri, gestisci interrupt e lavori entro vincoli stretti.

- Sistemi embedded con budget RAM/flash restritti e requisiti real-time.

- Librerie core e runtime (compressione, primitive crittografiche, VM di linguaggi, codec multimediali), dove ABI stabili e ampia portabilità sono preziose.

Questi ambiti evolvono lentamente, hanno enormi codebase legacy e premiano ingegneri che sanno ragionare su byte, convenzioni di chiamata e modalità di fallimento.

Dove il C potrebbe ridursi (e perché)

Per lo sviluppo di nuove applicazioni, molti team preferiscono linguaggi con garanzie di sicurezza più forti ed ecosistemi più ricchi. I bug di sicurezza legati alla memoria sono costosi, e i prodotti moderni spesso privilegiano consegne rapide, concorrenza e default sicuri. Anche nella programmazione di sistema, alcuni componenti nuovi migrano a linguaggi più sicuri—mentre il C resta la "roccia" con cui questi componenti interagiscono.

Nota su un workflow moderno: C nel prodotto più ampio

Anche quando il core low-level è in C, i team di solito hanno bisogno di software circostante: una dashboard web, un servizio API, un portale di device management, tool interni o una piccola app mobile per diagnostica. Quello strato superiore è spesso dove conta velocità di iterazione.

Se vuoi muoverti rapidamente su quegli strati senza ricostruire tutta la pipeline, Koder.ai può aiutare: è una piattaforma vibe-coding dove puoi creare web app (React), backend (Go + PostgreSQL) e app mobile (Flutter) tramite chat—utile per mettere in piedi un'interfaccia admin, un visualizzatore di log o un sistema di gestione fleet che si integra con un sistema basato su C. La modalità di pianificazione e l'export del codice rendono pratico prototipare e poi portare il codebase dove ti serve.

Come imparare C oggi (un percorso pratico)

Inizia con le basi, ma impara come i professionisti usano il C:

- Sintassi + modello dati: interi, array, struct, basi dei puntatori e come mappano in memoria.

- Tool di build: compilazione e linking, organizzazione degli header e un semplice Makefile (poi CMake).

- Debugging: fare stepping con gdb/lldb; imparare a leggere backtrace.

- Abitudini di sicurezza: compila con warning, usa AddressSanitizer/UBSan e scrivi piccoli test.

Se vuoi ulteriori articoli e percorsi di apprendimento orientati ai sistemi, sfoglia /blog.