Cosa intendo con "dominanza x86"

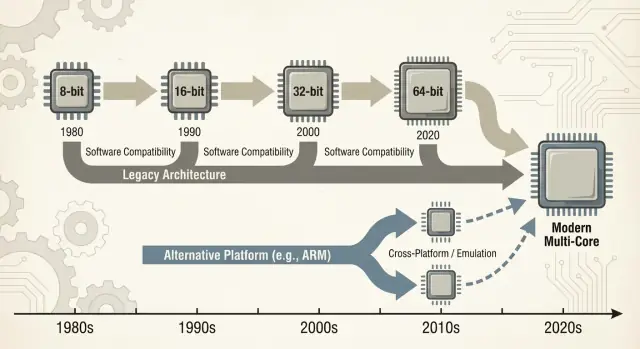

Quando si dice “x86” di solito ci si riferisce a una famiglia di istruzioni della CPU che è iniziata con il chip Intel 8086 e si è evoluta nel corso di decenni. Quelle istruzioni sono i verbi fondamentali che un processore capisce—somma, confronto, spostamento dati, e così via. Questo set di istruzioni si chiama ISA (instruction set architecture). Puoi pensare all'ISA come alla “lingua” che il software deve parlare per girare su un certo tipo di CPU.

Definizioni in parole semplici

x86: L'ISA più comune usata nei PC per la maggior parte degli ultimi 40 anni, implementata principalmente da Intel e anche da AMD.

Retrocompatibilità: La capacità dei computer più recenti di continuare a eseguire software più vecchio (a volte programmi vecchi decenni) senza riscritture importanti. Non è perfetta in ogni caso, ma è una promessa guida del mondo PC: “Le tue cose dovrebbero continuare a funzionare.”

Cosa significa “dominanza” in questo post

“Dominanza” qui non è solo una rivendicazione di prestazioni. È un vantaggio pratico e cumulativo su più dimensioni:

- Volume: Enormi numeri di chip x86 spediti in desktop, laptop e server.

- Supporto software: Uno dei cataloghi più vasti di app, giochi, software enterprise e strumenti per sviluppatori costruiti prima (o meglio) per x86.

- Mindshare: L'assunzione predefinita—da parte di acquirenti, reparti IT e sviluppatori—che un “computer normale” sia x86 a meno che non sia specificato diversamente.

Questa combinazione conta perché ogni livello rinforza gli altri. Più macchine incoraggiano più software; più software incoraggia più macchine.

Passare da un'ISA dominante non è come cambiare un componente. Può rompere—o quanto meno complicare—applicazioni, driver (per stampanti, GPU, dispositivi audio, periferiche di nicchia), toolchain per sviluppatori, e persino abitudini quotidiane (immagini disco, script IT, agenti di sicurezza, pipeline di deploy). Molte di queste dipendenze restano invisibili finché qualcosa non fallisce.

Ambito della discussione

Questo post si concentra principalmente su PC e server, dove x86 è stato il default per molto tempo. Faremo anche riferimento a transizioni recenti—soprattutto ARM—perché offrono lezioni moderne e facilmente confrontabili su cosa cambia senza intoppi, cosa no, e perché “basta ricompilarlo” raramente è tutta la storia.

Come l'era PC ha preparato il terreno per x86

Il mercato PC iniziale non è nato con un piano architetturale grandioso—è nato da vincoli pratici. Le aziende volevano macchine economiche, disponibili in volume e facili da riparare. Questo ha spinto i fornitori verso CPU e parti reperibili, abbinate a periferiche standard, assemblate senza ingegneria personalizzata.

CPU economiche + componenti standard

Il design originale del PC IBM si basava molto su componenti pronti e su un processore Intel 8088 relativamente economico. Questa scelta contava perché trasformava il “PC” da prodotto unico a una ricetta: una famiglia di CPU, una serie di slot di espansione, un approccio tastiera/display e uno stack software riproducibile.

Cloni, second source e mercato più grande

Quando l'IBM PC dimostrò che c'era domanda, il mercato si espanse tramite il cloning. Aziende come Compaq dimostrarono che si potevano costruire macchine compatibili che eseguivano lo stesso software—e venderle a prezzi diversi.

Ugualmente importante fu la produzione da second source: più fornitori potevano fornire processori o componenti compatibili. Per gli acquirenti questo riduceva il rischio di puntare su un singolo vendor. Per gli OEM aumentava l'offerta e la concorrenza, accelerando l'adozione.

“Gira gli stessi programmi” divenne la regola d'acquisto

In quell'ambiente la compatibilità divenne la caratteristica che la gente capiva e apprezzava. Gli acquirenti non dovevano sapere che cos'è un ISA; bastava sapere se Lotus 1-2-3 (e poi le applicazioni Windows) giravano.

La disponibilità di software diventò rapidamente un semplice euristico d'acquisto: se esegue gli stessi programmi degli altri PC, è una scelta sicura.

Gli standard hanno rinforzato il momentum

Convenzioni hardware e firmware hanno fatto molto lavoro invisibile. Bus comuni e approcci di espansione—insieme alle aspettative del BIOS/firmware e ai comportamenti di sistema condivisi—hanno reso più facile per produttori hardware e sviluppatori software mirare al “PC” come una piattaforma stabile.

Quella stabilità ha aiutato a consolidare x86 come base predefinita sotto un ecosistema in crescita.

Il volano dell'ecosistema software

x86 non ha vinto solo grazie a frequenze di clock o chip ingegnosi. Ha vinto perché il software ha seguito gli utenti, e gli utenti hanno seguito il software—un effetto di rete economico che si somma nel tempo.

Effetto rete: più utenti → più app → più utenti

Quando una piattaforma ottiene un vantaggio iniziale, gli sviluppatori vedono un pubblico più ampio e una strada più chiara verso i ricavi. Questo produce più applicazioni, migliore supporto e più componenti di terze parti. Questi miglioramenti rendono la piattaforma ancora più attraente per la prossima ondata di acquirenti.

Ripeti quel ciclo per anni e la piattaforma “di default” diventa difficile da scalzare—anche se le alternative sono tecnicamente interessanti.

Questo è il motivo per cui le transizioni di piattaforma non riguardano solo la costruzione di una CPU. Riguardano la ricreazione di un intero ecosistema: app, installer, canali di aggiornamento, periferiche, processi IT e il know-how collettivo di milioni di utenti.

Le aziende spesso mantengono applicazioni critiche per molto tempo: database personalizzati, strumenti interni, add-on ERP, software specifici di settore e macro di workflow che nessuno vuole toccare perché “funzionano”. Un target x86 stabile significava:

- Aggiornamenti prevedibili (i nuovi PC eseguono ancora il software vecchio)

- Cicli di vita hardware più lunghi

- Meno sorprese per gli help desk e budget di formazione

Anche se una nuova piattaforma prometteva costi inferiori o migliori prestazioni, il rischio di rompere un workflow che genera ricavi spesso superava il vantaggio.

Come le priorità degli sviluppatori seguono la base installata e i costi di supporto

Gli sviluppatori raramente ottimizzano per la “migliore” piattaforma in astratto. Ottimizzano per la piattaforma che minimizza il carico di supporto e massimizza la portata.

Se il 90% dei tuoi clienti è su x86 Windows, è lì che testi prima, spedici prima e risolvi i bug più in fretta. Supportare una seconda architettura significa pipeline di build aggiuntive, più matrici QA, più debug “funziona sulla mia macchina” e più script di supporto al cliente.

Il risultato è un divario autoalimentato: la piattaforma leader tende a ottenere software migliore, più velocemente.

Un esempio semplice: software contabile e driver della stampante

Immagina una piccola impresa. Il loro pacchetto contabile è solo x86, integrato con una decade di template e un plugin per le paghe. Si affidano anche a una stampante di etichette specifica e a uno scanner con driver capricciosi.

Ora proponi un cambio di piattaforma. Anche se le app principali esistono, i pezzi periferici contano: il driver della stampante, l'utility dello scanner, il plugin PDF, il modulo di importazione della banca. Quelle dipendenze “noiose” diventano imprescindibili—e quando mancano o sono instabili, tutta la migrazione si blocca.

Questo è il volano in azione: la piattaforma vincente accumula la lunga coda di compatibilità da cui tutti dipendono silenziosamente.

La retrocompatibilità come strategia di prodotto

La retrocompatibilità non è stata solo una caratteristica piacevole di x86—è diventata una strategia di prodotto deliberata. Intel ha mantenuto l'ISA x86 abbastanza stabile da permettere al software scritto anni prima di continuare a funzionare, cambiando però quasi tutto sotto al cofano.

La microarchitettura evolve; l'ISA rimane per lo più

La distinzione chiave è cosa è rimasto compatibile. L'ISA definisce le istruzioni di macchina su cui i programmi contano; la microarchitettura è il modo in cui un chip le esegue.

Intel poteva passare da pipeline più semplici a esecuzione out-of-order, aggiungere cache più grandi, migliorare la predizione dei branch o introdurre nuovi processi di fabbricazione—senza chiedere agli sviluppatori di riscrivere le loro app.

Quella stabilità ha creato un'aspettativa potente: i nuovi PC dovrebbero eseguire il vecchio software dal primo giorno.

Aggiungere potenza senza rompere il codice vecchio

x86 ha accumulato nuove capacità a strati. Estensioni del set di istruzioni come MMX, SSE, AVX e funzionalità successive sono state additive: i vecchi binari continuano a funzionare e le app più nuove possono rilevare e usare le nuove istruzioni quando disponibili.

Anche transizioni importanti sono state mitigate da meccanismi di compatibilità:

- Modalità legacy che preservano ambienti di esecuzione più vecchi (es. compatibilità 16-bit e 32-bit in processori successivi).

- Modalità protetta e long mode che permettono ai sistemi operativi moderni di usare più memoria e caratteristiche di sicurezza mantenendo il supporto per app più vecchie.

- Estensioni di virtualizzazione (come Intel VT-x) che hanno reso più facile eseguire vecchi OS o workload isolati in modo efficiente.

Il compromesso: il legacy diventa un vincolo

Lo svantaggio è la complessità. Supportare decenni di comportamento significa più modalità CPU, più casi limite e un onere di validazione più pesante. Ogni nuova generazione deve dimostrare che esegue ancora le app aziendali, i driver o gli installer di ieri.

Col tempo “non rompere le app esistenti” smette di essere una linea guida e diventa un vincolo strategico: protegge la base installata ma rende molto più difficile giustificare cambi radicali di piattaforma—nuove ISA, nuovi design di sistema, nuove assunzioni.

Il ciclo Wintel: OS, hardware e incentivi OEM

“Wintel” non era solo un'etichetta accattivante per Windows e i chip Intel. Descriveva un ciclo auto‑rinforzante in cui ogni parte dell'industria PC beneficiava dal rimanere sullo stesso target predefinito: Windows su x86.

Perché Windows + x86 è diventato l'obiettivo app predefinito

Per la maggior parte dei vendor di software consumer e enterprise la domanda pratica non era “qual è l'architettura migliore?” ma “dove sono i clienti e come saranno le chiamate al supporto?”

I PC Windows erano ampiamente distribuiti in case, uffici e scuole, e in gran parte basati su x86. Sviluppare per quella combinazione massimizzava la portata minimizzando le sorprese.

Una volta che una massa critica di applicazioni assumeva Windows + x86, i nuovi acquirenti avevano un altro motivo per sceglierlo: i loro programmi indispensabili già funzionavano lì. Questo, a sua volta, rendeva la piattaforma ancora più attraente per la prossima ondata di sviluppatori.

OEM, periferiche e il volano dei driver

I produttori di PC (OEM) hanno successo quando possono costruire molti modelli velocemente, procurarsi componenti da più fornitori e spedire macchine che “funzionano subito”. Una baseline comune Windows + x86 semplificava tutto questo.

Le aziende di periferiche seguirono il volume. Se la maggior parte degli acquirenti usava PC Windows, stampanti, scanner, interfacce audio, chip Wi‑Fi e altri dispositivi avrebbero privilegiato driver per Windows. Una migliore disponibilità di driver migliorava l'esperienza Windows PC, aiutava gli OEM a vendere più unità e manteneva alto il volume.

Realtà degli acquisti: il rischio più basso spesso vince

Gli acquisti aziendali e governativi tendono a premiare la prevedibilità: compatibilità con le app esistenti, costi di supporto gestibili, garanzie dei vendor e strumenti di deploy provati.

Anche quando le alternative erano interessanti, la scelta a rischio più basso spesso vinceva perché riduceva la formazione, evitava failure nei casi limite e si adattava ai processi IT consolidati.

Il risultato non fu una cospirazione ma una serie di incentivi allineati—ogni partecipante sceglieva il percorso che riduceva l'attrito—creando un momentum che rese il cambiamento di piattaforma particolarmente difficile.

Replace the one-off tools

Recreate that legacy utility and confirm what really needs porting.

Una “transizione di piattaforma” non è solo sostituire una CPU con un'altra. È una mossa a pacchetto: il set di istruzioni della CPU (ISA), il sistema operativo, il compilatore/toolchain che costruisce le app e lo stack dei driver che fa funzionare l'hardware. Cambiando uno di questi elementi spesso si turba il resto.

Le dipendenze nascoste che vedi solo quando falliscono

La maggior parte delle rotture non è un drammatico “l'app non si avvia”. È la morte per mille tagli:

- Installer e updater che presumono una certa versione di Windows, layout del registro o runtime x86.

- Protezione copia e license manager legati a ID hardware specifici, driver kernel o assunzioni di timing a basso livello.

- Plugin, add-in ed estensioni (pensate ai plugin CAD, VST audio, helper di browser) compilati per una sola architettura.

- Macro e automazioni dentro documenti Office, schermate ERP o app fatte in casa che dipendono da percorsi file esatti, oggetti COM o API deprecate.

Anche se l'app principale ha una nuova build, la “colla” attorno a essa potrebbe non averla.

Periferiche: il blocker di upgrade che nessuno budgetta

Stampanti, scanner, stampanti di etichette, schede PCIe/USB specializzate, dispositivi medici, hardware POS e dongle USB vivono e muoiono per i driver. Se il vendor è scomparso—o semplicemente disinteressato—potrebbe non esserci un driver per il nuovo OS o l'architettura.

In molte aziende un singolo dispositivo da 200$ può bloccare una flotta di PC da 2.000$.

Il problema della lunga coda software

Il blocco più grande spesso è costituito da strumenti interni “piccoli”: un database Access personalizzato, una cartella di Excel con macro, un'app VB scritta nel 2009, un'utility di produzione di nicchia usata da tre persone.

Queste cose non sono nella roadmap di nessuno, ma sono critiche. Le transizioni falliscono quando la lunga coda non viene migrata, testata e presa in carico da qualcuno.

L'economia reale del cambio

Una transizione di piattaforma non si giudica solo sui benchmark. Si giudica se il conto totale—denaro, tempo, rischio e perdita di slancio—rimane sotto il beneficio percepito. Per la maggior parte delle persone e delle organizzazioni quel conto è più alto di quanto sembri dall'esterno.

Il conto dell'utente: tempo, abitudini e rotture “piccole”

Per gli utenti i costi di switching iniziano dal lato ovvio (nuovo hardware, nuove periferiche, nuove garanzie) e rapidamente entrano nel disordinato: riaddestrare la memoria muscolare, riconfigurare i flussi di lavoro e rivalidare gli strumenti quotidiani.

Anche quando un'app “gira”, i dettagli possono cambiare: un plug-in non si carica, manca il driver della stampante, una macro si comporta diversamente, un anti-cheat di un gioco segnala qualcosa o un accessorio di nicchia smette di funzionare. Ognuno è una cosa minore; insieme possono annullare il valore dell'upgrade.

Il conto del vendor: espansione della QA e carico di supporto

I vendor pagano le transizioni di piattaforma con una matrice di test che esplode. Non è solo “si avvia?” ma:

- diverse versioni OS e canali di aggiornamento

- diverse generazioni CPU e set di feature

- driver, firmware e strumenti di sicurezza

- policy enterprise e modalità di lockdown

Ogni combinazione aggiuntiva aumenta il tempo di QA, la documentazione da mantenere e i ticket di supporto. Una transizione può trasformare un treno di rilascio prevedibile in un ciclo permanente di incident response.

Il conto dello sviluppatore: porting, prestazioni e fiducia

Gli sviluppatori assorbono il costo di portare librerie, riscrivere codice critico per le prestazioni (spesso ottimizzato a mano per un'ISA) e ricostruire i test automatici. La parte più dura è ristabilire la fiducia: dimostrare che la nuova build è corretta, sufficientemente veloce e stabile nei carichi reali.

L'assassino nascosto: costo opportunità

Il lavoro di migrazione compete direttamente con nuove feature. Se un team spende due trimestri per far funzionare di nuovo le cose, sono due trimestri in cui non hanno migliorato il prodotto.

Molte organizzazioni cambiano solo quando la vecchia piattaforma li blocca—o quando la nuova è così convincente da giustificare il compromesso.

Ponti: emulazione, traduzione e virtualizzazione

See if Koder.ai fits

Use the free tier to evaluate Koder.ai on your next prototype or pilot.

Quando arriva una nuova architettura CPU, gli utenti non chiedono degli ISA—chiedono se le loro app si aprono ancora. Ecco perché i “ponti” contano: permettono alle nuove macchine di eseguire il software vecchio abbastanza a lungo da far crescere l'ecosistema.

Emulazione vs traduzione: mantenere vive le vecchie app

Emulazione imita interamente una CPU via software. È l'opzione più compatibile, ma di solito la più lenta perché ogni istruzione viene “recitata” piuttosto che eseguita direttamente.

La traduzione binaria (spesso dinamica) riscrive blocchi di codice x86 nelle istruzioni native della nuova CPU mentre il programma gira. Questo è il modo in cui molte transizioni moderne offrono una storia day‑one: installi le tue app esistenti e un layer di compatibilità traduce silenziosamente.

Il valore è semplice: puoi acquistare nuovo hardware senza aspettare che ogni vendor ricompili.

Perché non è mai perfetto

I layer di compatibilità funzionano meglio per applicazioni mainstream e ben comportate—e arrancano ai margini:

- Cali di prestazioni: un carico può funzionare bene finché non incontra SIMD pesante, JIT o loop stretti che traducono male.

- Casi limite: protezioni copia, assunzioni di timing a basso livello o codice auto‑modificante possono rompersi.

- Driver e componenti kernel: puoi tradurre un'app, ma non puoi “tradurre” un driver della stampante mancante o un'estensione kernel legacy.

Il supporto hardware è spesso il vero blocco.

Virtualizzazione: un ponte parziale per il software business

La virtualizzazione aiuta quando serve un intero ambiente legacy (una versione specifica di Windows, uno stack Java vecchio, un'app di linea di business). È pulita operativamente—snapshot, isolamento, rollback facile—ma dipende da cosa virtualizzi.

Le VM su stessa architettura possono essere quasi native; le VM cross‑architettura di solito ricadono sull'emulazione e rallentano.

Quando “abbastanza buono” è davvero abbastanza?

Un ponte è di solito sufficiente per app d'ufficio, browser e produttività quotidiana—dove “abbastanza veloce” vince. È più rischioso per:

- periferiche e driver specializzati

- pipeline audio/video a bassa latenza

- calcolo ad alte prestazioni o grafica pesante

In pratica i ponti comprano tempo—ma raramente eliminano il lavoro di migrazione.

Prestazioni, consumo e mix di workload

Le discussioni sulle CPU spesso suonano come un unico tabellone: “più veloce vince”. In realtà le piattaforme vincono quando corrispondono ai vincoli dei dispositivi e ai carichi di lavoro reali.

x86 è diventato il default per i PC in parte perché offriva buone prestazioni di picco sotto alimentazione di rete, e perché l'industria ha costruito tutto attorno a quell'assunzione.

Prestazioni di picco vs efficienza energetica

Gli acquirenti di desktop e laptop hanno storicamente premiato prestazioni interattive reattive: avviare app, compilare codice, giocare, fogli di calcolo pesanti. Questo spinge i vendor verso clock boost elevati, core ampi e turbo aggressivo—ottimo quando puoi spendere watt liberamente.

L'efficienza energetica è un gioco diverso. Se il tuo prodotto è limitato da batteria, calore, rumore della ventola o uno chassis sottile, la CPU migliore è quella che fa “abbastanza” lavoro per watt, in modo consistente, senza throttling.

L'efficienza non è solo risparmio energetico; è rimanere entro limiti termici in modo che le prestazioni non crollino dopo un minuto.

Perché il mobile ha favorito altre architetture

Telefono e tablet vivono in involucri di potenza ristretti e sono sempre stati sensibili ai costi a volumi massicci. Questo ambiente ha premiato design ottimizzati per efficienza, componenti integrati e comportamento termico prevedibile.

Ha anche creato un ecosistema in cui OS, app e silicio sono evoluti insieme sotto assunti mobile‑first.

Server: affidabilità e maturità battono la pura velocità

Nei data center la scelta CPU raramente è una decisione basata solo sui benchmark. Gli operatori valutano caratteristiche di affidabilità, finestre di supporto lunghe, firmware stabile, monitoraggio e un ecosistema maturo di driver, hypervisor e strumenti di gestione.

Anche quando una nuova architettura sembra attraente su perf/watt, il rischio di sorprese operative può superare il vantaggio.

I carichi moderni sono diversi: il web serving favorisce alta throughput e scaling efficiente; i database premiano larghezza di banda di memoria, consistenza della latenza e tuning provato; l'AI sposta sempre più valore verso acceleratori e stack software.

Man mano che il mix cambia, la piattaforma vincente può cambiare—ma solo se l'ecosistema circostante riesce a tenere il passo.

Una nuova architettura CPU può essere tecnicamente eccellente e comunque fallire se gli strumenti quotidiani non rendono facile costruire, distribuire e supportare il software. Per la maggior parte dei team, “piattaforma” non è solo ISA—è tutta la pipeline di delivery.

Compilatori, debugger, profiler e librerie core plasmano silenziosamente il comportamento degli sviluppatori. Se le migliori flag del compilatore, gli stack trace, i sanitizer o gli strumenti di performance arrivano in ritardo (o si comportano diversamente), i team esitano a puntare i loro rilasci su di essi.

Anche piccoli gap contano: una libreria mancante, un plugin debugger instabile o una CI più lenta possono trasformare “potremmo portare questo” in “non lo faremo questo trimestre”. Quando la toolchain x86 è il default nelle IDE, nei sistemi di build e nei template CI, il percorso di minor resistenza continua a riportare gli sviluppatori indietro.

La distribuzione è attrito, non teoria

Il software arriva agli utenti tramite convenzioni di packaging: installer, updater, repository, app store, container e binari firmati. Una transizione di piattaforma pone domande scomode:

- Spediamo build separate (x86 e ARM), un pacchetto “universale” o ci affidiamo alla traduzione?

- Plugin/driver esistenti si installeranno ancora correttamente?

- Firma del codice, notarizzazione e aggiornamenti automatici sono coerenti tra architetture?

Se la distribuzione si fa confusa, i costi di supporto aumentano—e molti vendor eviteranno la migrazione.

La gestione enterprise è una soglia difficile

Le aziende comprano piattaforme che possono gestire su scala: imaging, enrollment dei dispositivi, policy, sicurezza endpoint, agenti EDR, client VPN e reportistica di compliance. Se uno qualsiasi di questi strumenti è in ritardo su una nuova architettura, i piloti si bloccano.

“Funziona sulla mia macchina” è irrilevante se l'IT non può distribuirlo e metterlo in sicurezza.

La metrica reale: velocità di rilascio

Sviluppatori e IT convergono su una domanda pratica: quanto velocemente possiamo spedire e supportare? Tooling e distribuzione spesso rispondono più decisivamente dei benchmark puri.

Un modo pratico per ridurre l'attrito di migrazione è accorciare il tempo tra un'idea e una build testabile—soprattutto quando si valida la stessa applicazione su ambienti diversi (x86 vs ARM, immagini OS differenti o target di deploy diversi).

Piattaforme come Koder.ai si inseriscono in questo flusso permettendo ai team di generare e iterare applicazioni reali tramite un'interfaccia chat—producono comunemente frontend web React, backend Go e database PostgreSQL (più Flutter per mobile). Per il lavoro di transizione di piattaforma, due capacità sono particolarmente rilevanti:

- Prototipazione rapida e ricostruzioni quando serve ricreare strumenti interni, pannelli admin o utility della “lunga coda” che non hanno un chiaro owner.

- Snapshot e rollback per testare cambiamenti in sicurezza mentre si bilanciano architetture, toolchain e ambienti di deploy.

Poiché Koder.ai supporta l'export del codice sorgente, può anche fungere da ponte tra sperimentazione e una pipeline di ingegneria convenzionale—utile quando serve muoversi velocemente ma mantenere codice manutenibile nel proprio repo.

Le lezioni recenti dalle transizioni ARM

Scope the long tail

Use Planning Mode to map features, risks, and dependencies before you rebuild.

La spinta di ARM verso laptop e desktop è un utile banco di prova su quanto siano dure le transizioni di piattaforma. Sulla carta il pitch è semplice: migliore performance per watt, macchine più silenziose, maggiore autonomia.

Nella pratica il successo dipende meno dal core CPU e più da tutto ciò che lo avvolge—app, driver, distribuzione e chi ha il potere di allineare gli incentivi.

Apple: il controllo riduce gli “sconosciuti”

La transizione di Apple da Intel ad Apple Silicon ha funzionato perché Apple controlla l'intero stack: design hardware, firmware, sistema operativo, strumenti per sviluppatori e canali principali di distribuzione delle app.

Quel controllo ha permesso all'azienda di fare una rottura pulita senza aspettare che decine di partner si muovessero in sincronia.

Ha anche permesso un periodo di “ponte” coordinato: gli sviluppatori hanno avuto target chiari, gli utenti percorsi di compatibilità e Apple ha potuto esercitare pressione su vendor chiave per rilasciare build native. Anche quando alcune app non erano native, l'esperienza utente è spesso rimasta accettabile perché il piano di transizione è stato progettato come prodotto, non solo come cambio di processore.

Windows su ARM: partner, tempistiche e gap

Windows su ARM mostra l'altro lato della medaglia. Microsoft non controlla completamente l'ecosistema hardware e i PC Windows dipendono fortemente dalle scelte degli OEM e da una lunga coda di driver di dispositivo.

Questo crea punti di fallimento comuni:

- Driver: stampanti, interfacce audio, periferiche enterprise e dispositivi corporate “one-off” possono bloccare l'adozione.

- Gap nelle app: alcuni strumenti professionali arrivano in ritardo (o mai), e plugin/add-on possono essere il blocco nascosto.

- Tempistica degli incentivi: gli OEM non investiranno massicciamente senza domanda, ma gli utenti non la richiederanno finché la compatibilità non sembrerà sicura.

Conclusione: le transizioni vincenti sono organizzative, non solo tecniche

I progressi recenti di ARM ribadiscono una lezione centrale: controllare più parti dello stack rende le transizioni più rapide e meno frammentate.

Quando ti affidi a partner, serve un coordinamento molto forte, percorsi di upgrade chiari e una ragione per ogni partecipante—vendor di chip, OEM, sviluppatori e buyer IT—per muoversi nello stesso momento.

Le transizioni falliscono per motivi noiosi: la piattaforma vecchia funziona ancora, tutti l'hanno già pagata (in denaro e abitudini) e i “casi limite” sono dove vivono le vere aziende.

Segnali che una transizione potrebbe effettivamente restare

Una nuova piattaforma tende a vincere solo quando tre cose si allineano:

Primo, il beneficio è ovvio per acquirenti normali—non solo per gli ingegneri: maggiore autonomia, costi significativamente più bassi, nuovi form factor o un salto nelle prestazioni per compiti comuni.

Secondo, esiste un piano di compatibilità credibile: emulazione/traduzione ottima, build “universali” facili e percorsi chiari per driver, periferiche e tool enterprise.

Terzo, gli incentivi si allineano lungo la catena: vendor OS, vendor chip, OEM e sviluppatori vedono un vantaggio e hanno motivo di dare priorità alla migrazione.

Come le aziende riducono il rischio

Le transizioni di successo assomigliano meno a uno switch e più a un overlap controllato. Rollout phased (prima gruppi pilota), build doppie (vecchio + nuovo) e telemetria (tassi di crash, prestazioni, uso delle feature) permettono di cogliere i problemi presto.

Ugualmente importante: una finestra di supporto pubblicata per la piattaforma vecchia, scadenze interne chiare e un piano per gli utenti che “non possono ancora muoversi”.

Una checklist pratica prima di cambiare

- Testa le tue app critiche (inclusi plugin e macro), non solo il software di punta.

- Valida periferiche e driver: dock, stampanti, scanner, interfacce audio, chiavi di sicurezza.

- Conferma sicurezza e gestione: cifratura disco, EDR, VPN, enrollment dispositivi, policy di compliance.

- Esegui test sulle prestazioni che riproducano i tuoi carichi (tempi di build, esportazioni video, analisi dati), oltre a test su batteria e termiche.

La visione bilanciata

x86 ha ancora un'enorme spinta: decenni di compatibilità, flussi di lavoro enterprise radicati e ampie opzioni hardware.

Ma la pressione cresce da nuove esigenze—efficienza energetica, integrazione più stretta, compute focalizzato su AI e flotte di dispositivi più semplici. Le battaglie più dure non riguardano la pura velocità; riguardano rendere lo switch sicuro, prevedibile e conveniente.