Perché codice generato dall'IA e test auto-generati stanno bene insieme

La logica applicativa scritta con l'aiuto di un assistente significa che le parti "operative" del tuo codebase vengono redatte con supporto: nuove funzioni, piccole feature, refactor, gestione di casi limite e persino riscritture di moduli esistenti. Sei comunque tu a decidere cosa costruire, ma la prima versione dell'implementazione spesso arriva più in fretta—e talvolta con assunzioni che noterai solo in seguito.

La generazione automatica dei test è la capacità corrispondente sul lato della verifica. Invece di scrivere ogni test a mano, gli strumenti possono proporre casi di test e asserzioni basate sul codice, su una specifica o su pattern appresi da bug precedenti. In pratica questo può sembrare:

- “Dati la firma di questa funzione e i rami, ecco test che coprono input tipici, limiti e percorsi di errore.”

- “Ecco test di regressione che riproducono il crash visto in produzione.”

La chiave: i test generati non sono automaticamente “buoni”

Un test generato può essere fuorviante: potrebbe asserire il comportamento attuale anche se il comportamento è sbagliato, o potrebbe non cogliere regole di prodotto che vivono nelle teste delle persone o nei commenti dei ticket. Per questo la revisione umana è importante. Qualcuno deve confermare che il nome del test, il setup e le asserzioni riflettano l'intento reale—non solo quello che il codice fa oggi.

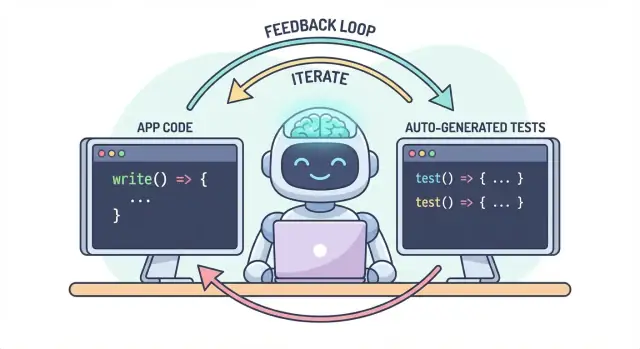

Un flusso di lavoro, due output

L'idea centrale è semplice: codice e test dovrebbero evolvere insieme come un unico flusso. Se l'IA ti aiuta a cambiare rapidamente la logica, la generazione automatica dei test ti aiuta a fissare il comportamento intenzionato altrettanto velocemente—così la modifica successiva (umana o IA) ha una definizione eseguibile di “ancora corretto”.

Nella pratica, questo approccio di “output accoppiato” è più facile da mantenere quando il tuo flusso di sviluppo è già guidato dalla chat. Per esempio, in Koder.ai (una piattaforma vibe-coding per costruire app web, backend e mobile via chat), è naturale trattare “feature + test” come un unico deliverable: descrivi il comportamento, genera l'implementazione, poi genera e rivedi i test nello stesso ciclo conversazionale prima del deploy.

Il problema: il codice più veloce può significare bug più rapidi

Il codice scritto dall'IA può sembrare un superpotere: le feature appaiono in fretta, il boilerplate scompare e i refactor che prima richiedevano ore possono avvenire prima che il tuo caffè si raffreddi. Il prezzo è che la velocità cambia la forma del rischio. Quando il codice è più facile da produrre, è anche più facile spedire errori—talvolta sottili.

Modalità di fallimento comuni della logica generata dall'IA

Gli assistenti IA sono bravi a generare implementazioni “ragionevoli”, ma ragionevole non è la stessa cosa di corretto per il tuo dominio specifico.

I casi limite sono la prima vittima. La logica generata dall'IA spesso gestisce bene il percorso felice, poi inciampa nelle condizioni al contorno: input vuoti, problemi con i fusi orari, arrotondamenti, valori nulli, comportamento di retry o stati “non dovrebbe succedere” che invece si verificano in produzione.

Assunzioni sbagliate sono un altro problema ricorrente. Un assistente può inferire requisiti non dichiarati (“gli utenti sono sempre autenticati”, “gli ID sono numerici”, “questo campo è sempre presente”) o implementare un pattern familiare che non corrisponde alle regole del tuo sistema.

Le regressioni silenziose sono spesso le più costose. Chiedi una piccola modifica, l'assistente riscrive un pezzo di logica e qualcosa di non correlato si rompe—senza errori evidenti. Il codice compila ancora, l'interfaccia utente si carica, ma una regola di prezzo, un controllo di permessi o una conversione dei dati è ora leggermente sbagliata.

Perché i test manuali non scalano con il codice più veloce

Quando le modifiche al codice accelerano, i test manuali diventano un collo di bottiglia e una scommessa. O passi più tempo a cliccare in giro (rallentando la consegna) o testi di meno (aumentando le fughe). Anche i team QA disciplinati non possono coprire manualmente ogni variante quando le modifiche sono frequenti e su larga scala.

Peggio: i controlli manuali sono difficili da ripetere in modo coerente. Vivono nella memoria di qualcuno o in una checklist e sono facili da saltare quando le scadenze si stringono—proprio quando il rischio è più alto.

I test come rete di sicurezza e strumento di comunicazione

I test automatizzati creano una rete di sicurezza durevole: rendono le aspettative eseguibili. Un buon test dice: “Dati questi input e questo contesto, questo è l'esito su cui contiamo.” Non è solo verifica; è comunicazione per il te futuro, per i colleghi e persino per l'assistente IA.

Quando esistono test, le modifiche diventano meno spaventose perché il feedback è immediato. Invece di scoprire problemi dopo la code review, in staging o dai clienti, li trovi minuti dopo la modifica.

Individuare i problemi prima per ridurre il lavoro rifatto

Prima si trova un bug, meno costa correggerlo. I test accorciano il ciclo di feedback: mettono in evidenza assunzioni sbagliate e casi limite mancanti mentre l'intento è ancora fresco. Questo riduce il lavoro rifatto, evita patch “fix-forward” e impedisce che la velocità dell'IA si trasformi in instabilità guidata dall'IA.

Come i test creano un ciclo di feedback per la logica generata dall'IA

Il codice scritto dall'IA è più efficace quando lo tratti come una conversazione, non come un deliverable una tantum. I test rendono quella conversazione misurabile.

Il ciclo “spec → codice → test” (in parole semplici)

-

Spec: descrivi cosa dovrebbe succedere (input, output, casi limite).

-

Codice: l'IA scrive l'implementazione che dichiara di rispettare quella descrizione.

-

Test: tu (o l'IA) generi controlli che dimostrano che il comportamento è effettivamente vero.

Ripeti questo ciclo e non stai solo producendo più codice: stai stringendo continuamente la definizione di “done”.

I test costringono a requisiti e interfacce più chiare

Un requisito vago come “gestire gli utenti non validi in modo elegante” è facile da trascurare nel codice. Un test non può essere vago. Costringe a specifiche:

- Cosa conta come “non valido”? ID mancante, stato bannato, email malformata?

- Cosa significa “in modo elegante”? Messaggio d'errore, codice di stato, valore di fallback?

- Qual è l'interfaccia? Firma della funzione, forma del ritorno, eccezioni?

Non appena provi a esprimere questi dettagli in un test, le parti poco chiare emergono immediatamente. Questa chiarezza migliora il prompt che dai all'IA e spesso porta a interfacce più semplici e stabili.

I test generati convalidano ciò che il codice afferma

Il codice IA può sembrare corretto mentre nasconde assunzioni. I test generati sono un modo pratico per verificare le asserzioni che il codice fa:

- “Questa funzione è pura” → testa l'assenza di effetti collaterali esterni.

- “Gestisce i casi limite” → testa null, liste vuote, valori al bordo.

- “Compatibile all'indietro” → testa input vecchi e output attesi.

L'obiettivo non è fidarsi ciecamente dei test generati: è usarli come scetticismo strutturato e veloce.

I test falliti diventano il prossimo prompt

Un test che fallisce è feedback azionabile: indica una discrepanza specifica tra la spec e l'implementazione. Invece di chiedere all'IA di “fixarlo”, puoi incollare il fallimento e dire: “Aggiorna il codice così questo test passi senza cambiare l'API pubblica.” Questo trasforma il debug in un'iterazione mirata, non in un gioco di indovinelli.

Dove si inserisce la generazione automatica dei test nella tua piramide di test

La generazione automatica è più utile quando supporta la strategia di test esistente—specialmente la classica “piramide di test”. La piramide non è una regola fine a se stessa; è un modo per mantenere il feedback veloce e affidabile pur catturando i fallimenti reali.

L'IA può aiutare a creare test a ogni livello, ma otterrai i migliori risultati quando generi di più i test economici (alla base della piramide) e di meno quelli costosi (in cima). Questo equilibrio mantiene la CI veloce e al tempo stesso protegge l'esperienza utente.

Test unitari: veloci, mirati e molto generabili

I test unitari sono controlli piccoli per funzioni, metodi o moduli. Si eseguono rapidamente, non hanno bisogno di sistemi esterni e sono ideali per una copertura generata dall'IA sui casi limite.

Un buon uso della generazione automatica qui è:

- Esercitare la validazione degli input e valori limite “strani”

- Validare regole di business (sconti, permessi, transizioni di stato)

- Bloccare le correzioni di bug con test di regressione difficili da dimenticare

Poiché i test unitari sono strettamente circoscritti, sono più facili da rivedere e meno propensi a essere flakky.

Test di integrazione: meno, ma ad alto valore

I test di integrazione verificano come i pezzi lavorano insieme: la tua API con il database, un servizio che chiama un altro servizio, l'elaborazione delle code, l'autenticazione, ecc.

I test di integrazione generati dall'IA possono essere utili, ma richiedono più disciplina:

- setup/teardown chiari per evitare perdite di dati

- ambienti di test stabili (container, database di test, mock dove appropriato)

- asserzioni che si concentrano sugli esiti, non su dettagli di implementazione interni

Pensali come “controlli di contratto” che dimostrano che le giunture tra i componenti reggono ancora.

Test end-to-end: genera con parsimonia

I test E2E verificano i flussi utente chiave. Sono anche i più costosi: più lenti, più fragili e più difficili da debug.

La generazione automatica può aiutare a stendere scenari E2E, ma devi curarli aggressivamente. Mantieni un piccolo set di percorsi critici (registrazione, checkout, workflow core) ed evita di generare test E2E per ogni feature.

Raccomandazione pratica: genera un mix bilanciato

Non cercare di generare tutto. Invece:

- Genera molti test unitari per mantenere onesta la logica IA a livello di funzione

- Aggiungi test di integrazione mirati per proteggere le giunture a maggior rischio (DB, auth, pagamenti)

- Mantieni una suite E2E minima per i pochi percorsi utente che non puoi permetterti di rompere

Questo mantiene intatta la piramide e fa della generazione automatica un moltiplicatore di forza invece che una fonte di rumore.

Cosa può essere generato: dal codice, dalle specifiche e dai bug reali

La generazione automatica non si limita a “scrivi unit test per questa funzione”. I generatori più utili attingono a tre fonti: il codice che hai, l'intento dietro di esso e i fallimenti che hai già visto.

1) Dalla struttura del codice: esercitare il comportamento, non solo le righe

Dato una funzione o un modulo, gli strumenti possono dedurre casi di test da input/output, rami e percorsi di eccezione. Di solito questo significa:

- input del “percorso felice” che dovrebbero produrre un risultato noto

- valori limite (stringhe vuote, zero, lunghezze massime)

- copertura dei rami (if/else)

- gestione degli errori (input non valido, campi mancanti, timeout)

Questo stile è ottimo per circondare rapidamente la logica generata dall'IA con controlli che confermano cosa fa oggi.

Se hai criteri di accettazione, user story o tabelle di esempi, i generatori possono convertirli in test che leggono come la specifica. Questo spesso ha più valore dei test derivati dal codice perché fissa il “cosa dovrebbe succedere”, non il “cosa succede attualmente”.

Un pattern pratico: fornisci qualche esempio concreto (input + outcome atteso) e chiedi al generatore di aggiungere casi limite coerenti con quelle regole.

3) Dai bug report: riprodurre prima, poi prevenire

La generazione basata sui bug è il modo più rapido per costruire una suite di regressione significativa. Fornisci i passi per riprodurre (o log e un payload minimo) e genera:

- un test che fallisce sul comportamento buggy corrente, poi

- lo stesso test che passa una volta corretto—a protezione per sempre.

Snapshot/golden tests: utili, con una avvertenza

I snapshot (golden) possono essere efficienti per output stabili (UI renderizzata, risposte serializzate). Usali con attenzione: snapshot grandi possono “approvare” errori sottili. Preferisci snapshot piccoli e mirati e abbinali ad asserzioni su campi chiave che devono essere corretti.

Scegliere cosa testare per primo (senza bollire l'oceano)

La generazione è più efficace quando la indirizzi con priorità chiare. Se punti l'IA a tutto il codebase e chiedi “tutti i test”, otterrai rumore: molti controlli a basso valore, copertura duplicata e test fragili che rallentano la consegna.

Inizia dove il business sentirebbe dolore

Comincia dai flussi che sarebbe più costoso rompere—finanziariamente, legalmente o reputazionalmente. Un filtro basato sul rischio mantiene l'ambito realistico migliorando la qualità rapidamente.

Concentrati prima su:

- percorsi critici per il business (registrazione, checkout, workflow core) e aree che cambiano spesso (feature attive, refactor, nuove integrazioni)

- domini ad alto rischio: pagamenti, autenticazione, integrità dei dati, permessi/ruoli e tutto ciò che impatta cosa gli utenti possono vedere o fare

Per ogni flusso scelto, genera test a strati: alcuni unit test veloci per la logica insidiosa, più uno o due test di integrazione che confermino che il percorso completo funziona.

“Percorso felice + casi limite principali” batte combinazioni esaustive

Chiedi una copertura che corrisponda ai fallimenti reali, non alle permutazioni teoriche. Un buon set iniziale è:

- un test del percorso felice che dimostri il comportamento atteso

- i casi limite principali che temi davvero: input mancanti/non validi, token scaduti, permessi insufficienti, conflitti di concorrenza e stato “vuoto” dei dati

Puoi sempre ampliare in seguito basandoti su bug, incidenti o feedback degli utenti.

Definisci “done” così rimane fatto

Stabilisci la regola esplicita: una feature non è completa finché non esistono test rilevanti. Questa definizione di done è ancora più importante con codice generato dall'IA, perché previene che il “rilascio veloce” diventi silenziosamente “regressioni veloci.”

Se vuoi che questa regola rimanga attiva, collegala al tuo flusso (per esempio, richiedendo i test rilevanti prima del merge nella CI) e riportala nella documentazione del team (ad esempio, la definizione di "done").

Pattern di prompting che producono test migliori

L'IA può generare test rapidamente, ma la qualità dipende molto da come chiedi. L'obiettivo è guidare il modello verso test che proteggano il comportamento—non test che si limitano ad eseguire il codice.

Metti il tuo standard di coding direttamente nel prompt

Inizia fissando la “forma” dei test in modo che l'output corrisponda al tuo repo.

Includi:

- linguaggio + framework di test (es. TypeScript + Jest, Python + pytest)

- regole di naming (es.

should_<behavior>_when_<condition>)

- posizione e struttura dei file (es.

src/ e tests/, o __tests__/)

- convenzioni (fixture, factory helper, libreria di mocking)

Questo evita che il modello inventi pattern che il tuo team non usa.

Fornisci 1–2 esempi reali di test da copiare

Incolla un file di test esistente (o un breve estratto) e dì esplicitamente: “Imita questo stile.” Questo ancora le decisioni su come organizzare i dati di test, come nominare le variabili e se preferisci test basati su tabelle.

Se il progetto ha helper (es. buildUser() o makeRequest()), includi anche quei frammenti così i test generati li riutilizzino invece di reimplementare tutto.

Chiedi asserzioni significative (non solo “si esegue”)

Sii esplicito su cosa significa “buono”:

- Asserire output e cambiamenti di stato

- Verificare effetti collaterali (es. scritture DB, eventi emessi)

- Asserire tipi/messaggi di errore quando necessario

Una riga utile da aggiungere al prompt: “Ogni test deve contenere almeno una asserzione sul comportamento di business (non solo ‘nessuna eccezione’).”

Richiedi test negativi e di confine

La maggior parte delle suite generate tende al percorso felice. Contrasta questo richiedendo:

- input non validi e i fallimenti attesi

- valori limite (stringhe vuote, zero, lunghezza massima)

- fallimenti di permessi/autorizzazioni

- dipendenze mancanti (es. risposte null, timeout)

Un template pratico per il prompt

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

Revisione umana: assicurarsi che i test generati aiutino davvero

L'IA può buttare giù molti test velocemente, ma non può giudicare definitivamente se quei test rappresentano il tuo intento. Una passata umana trasforma “test che si eseguono” in “test che ci proteggono.” L'obiettivo non è limare lo stile: è confermare che la suite di test catturerà regressioni significative senza diventare un onere di manutenzione.

Revisiona per correttezza e pertinenza

Inizia con due domande:

- Il test asserisce un comportamento che il prodotto davvero richiede?

- Saresti soddisfatto se questo test fallisse su una futura modifica—perché avrebbe segnalato un problema reale?

I test generati a volte fissano comportamenti accidentali (dettagli di implementazione) invece della regola desiderata. Se un test sembra una copia del codice più che una descrizione dell'esito atteso, spingilo verso asserzioni di livello più alto.

Occhio alla fragilità (il killer silenzioso della produttività)

Fonti comuni di test flakky o fragili includono over-mocking, timestamp codificati e valori casuali. Preferisci input deterministici e asserzioni stabili (per esempio, asserire una data parsata o un intervallo invece di una stringa Date.now() grezza). Se un test richiede troppo mocking per passare, potrebbe testare l'assemblaggio anziché il comportamento.

Assicurati che i fallimenti avvengano per il motivo giusto

Un test “passante” può essere inutile se passerebbe anche con la feature rotta (falsi positivi). Cerca asserzioni deboli come “non lancia eccezioni” o il controllo che una funzione sia stata chiamata. Rafforzale asserendo output, cambiamenti di stato, errori restituiti o dati persistiti.

Usa una checklist leggera per la code review

Una semplice checklist mantiene le revisioni coerenti:

- Leggibilità: nomi chiari, setup minimo, intento evidente

- Copertura dell'intento: casi limite e percorsi di errore principali inclusi

- Manutenibilità: evita di specificare eccessivamente l'interno; mocking minimo

- Qualità del segnale: fallirebbe su una regressione reale, non su refactor innocui

Tratta i test generati come codice qualunque: fai il merge solo di ciò che saresti disposto a mantenere tra sei mesi.

Farlo rimanere: controlli CI che tengono onesto il codice IA

L'IA può aiutare a scrivere codice velocemente, ma il vero guadagno è mantenerlo corretto nel tempo. Il modo più semplice per “fissare” la qualità è far eseguire automaticamente test e controlli a ogni modifica—così le regressioni vengono catturate prima del rilascio.

Un flusso pratico che funziona

Un workflow leggero adottato da molti team è:

- Generare o modificare la feature (assistita dall'IA o no).

- Generare test per il nuovo comportamento (e per il bug appena corretto).

- Eseguire tutto localmente per confermare il verde.

- Commit di codice + test insieme.

Quest'ultimo passo è cruciale: la logica generata dall'IA senza test tende a derivare. Con i test, registri il comportamento intenzionato in modo che la CI lo possa applicare.

CI come rete di sicurezza non negoziabile

Configura la tua pipeline CI per partire su ogni pull request (e idealmente sui merge verso main). Al minimo dovrebbe:

- installare le dipendenze in un ambiente pulito

- eseguire unit/integration test

- fallire la build su qualsiasi test non passato

Questo evita il “funziona sulla mia macchina” e cattura rotture accidentali quando un collega (o un prompt IA successivo) modifica il codice altrove.

Aggiungi qualche gate di qualità (leggero)

I test sono essenziali, ma non catturano tutto. Aggiungi piccoli gate veloci che completano la generazione automatica:

- linting (stile + errori comuni)

- controlli di tipi (dove applicabile)

- formattazione (così i diff restano leggibili)

Mantieni questi controlli rapidi—se la CI è lenta o rumorosa, la gente cercherà vie d'uscita.

Pianifica costi e capacità

Se ampli la CI perché stai generando più test, assicurati che il budget supporti il nuovo ritmo. Se monitori i minuti CI, vale la pena rivedere limiti e opzioni nella documentazione sui prezzi.

Usare i test fallenti per guidare l'iterazione IA successiva

Un modo sorprendentemente efficace di lavorare con il codice generato dall'IA è trattare i test fallenti come il tuo “prossimo prompt”. Invece di chiedere al modello di migliorare in modo generico la feature, gli fornisci un fallimento concreto e lasci che quel fallimento vincoli la modifica.

Il workflow: fallimento → prompt → fix → ripeti

- Esegui la suite (o la CI) e cattura un fallimento. Copia il nome del test che fallisce e il messaggio di asserzione/stack trace rilevante.

- Chiedi all'IA di risolvere solo quel fallimento. Fornisci il contesto minimo di codice (il test che fallisce e la funzione/modulo sotto test), più eventuali regole di business violate.

- Richiedi prima un test di regressione. Se il fallimento proviene da un bug o da produzione, chiedi all'IA di aggiungere/aggiustare un test che riproduca il bug prima di cambiare l'implementazione.

- Applica la modifica minima che fa passare il test. Riesegui i test immediatamente.

- Vai al prossimo test fallente. Un fallimento alla volta mantiene l'iterazione stretta e comprensibile.

Pattern di prompting: mantenerlo piccolo e verificabile

Invece di:

- “Migliora la logica di login e aggiorna i test.”

Usa:

- “Questo test fallisce:

shouldRejectExpiredToken. Ecco l'output di errore e il codice rilevante. Aggiorna l'implementazione in modo che questo test passi senza cambiare il comportamento non pubblico. Se serve, aggiungi un test di regressione che catturi il bug.”

Perché questo riduce i giri a vuoto

I test fallenti eliminano l'indovinello. Definiscono cosa è “corretto” in forma eseguibile, così non negozi i requisiti in chat. Eviti anche modifiche ampie: ogni prompt è limitato a un risultato misurabile, rendendo la revisione umana più veloce e più facile capire se l'IA ha “fixato” il sintomo ma rotto qualcos'altro.

Qui un workflow agent-style può pagare: un agente si concentra sulla modifica minima del codice, un altro propone la più piccola variazione del test, e tu rivedi il diff. Piattaforme come Koder.ai sono costruite intorno a questo flusso iterativo e chat-first—rendendo “i test come prossimo prompt” una modalità naturale, non una tecnica speciale.

Misurare il successo senza inseguire metriche di facciata

La generazione automatica può aumentare la suite di test da un giorno all'altro—ma “più grande” non significa “migliore”. L'obiettivo è fiducia: intercettare regressioni presto, ridurre i difetti in produzione e mantenere il team produttivo.

Metriche che riflettono davvero la qualità

Inizia con segnali che si collegano a risultati concreti:

- tasso di passaggio delle build (su main): se i merge rompono spesso, i test generati potrebbero essere troppo fragili o i prompt stanno producendo assunzioni errate

- tasso di test flakky: monitora quante volte i test falliscono e poi passano al rerun; un tasso in crescita è un costo sulla fiducia

- tempo per rilevare regressioni: misura il tempo dall'introduzione di un bug al rilevamento tramite CI. I test generati dovrebbero accorciare questa finestra

Tratta la coverage come un suggerimento, non come un punteggio

La coverage può essere un utile allarme—soprattutto per individuare percorsi critici non testati—ma è facile gonfiarla. I test generati possono aumentare la coverage senza asserzioni rilevanti. Preferisci indicatori come:

- asserzioni per test (controllo sommario, non KPI)

- risultati di mutation testing (se usato)

- se i test falliscono quando rompi deliberatamente il comportamento

Concentrati sui “difetti trovati prima del rilascio”

Se tracci solo numero di test o coverage, ottimizzi per volume. Tieni traccia dei difetti trovati prima del rilascio: bug intercettati in CI, QA o staging che sarebbero arrivati agli utenti. Quando la generazione automatica funziona, quel numero sale mentre gli incidenti in produzione scendono.

Pianifica la pulizia per mantenere i guadagni reali

Le suite generate hanno bisogno di manutenzione. Inserisci un'attività ricorrente per:

- rimuovere test ridondanti che non aggiungono protezione unica

- stabilizzare o eliminare test flakky

- consolidare casi sovrapposti in test più chiari e significativi

Il successo è una CI più calma, feedback più veloci e meno sorprese—non una dashboard che sembra impressionante.

Errori comuni e un piano di rollout pratico

La generazione automatica può alzare rapidamente la qualità—ma solo se la tratti come un aiuto, non come un'autorità. I fallimenti maggiori tendono a ripetersi tra i team, e sono evitabili.

Errori comuni da tenere d'occhio

L'affidamento eccessivo è la trappola classica: i test generati possono creare l'illusione di sicurezza mentre mancano i rischi reali. Se le persone smettono di pensare criticamente (“lo strumento ha scritto i test, quindi siamo coperti”), spedirai bug più velocemente—solo con più spunte verdi.

Un altro problema frequente è testare dettagli di implementazione invece del comportamento. Gli strumenti IA spesso si aggrappano a nomi di metodi attuali, helper interni o messaggi di errore esatti. Questi test diventano fragili: i refactor li rompono anche quando la feature funziona ancora. Preferisci test che descrivono cosa deve succedere, non come.

Sicurezza e privacy: non esporre ciò che non si dovrebbe condividere

La generazione spesso richiede di incollare codice, stack trace o log nel prompt. Questo può esporre segreti (API key), dati clienti o logica proprietaria.

Mantieni i prompt e i fixture di test privi di informazioni sensibili:

- redigi token, credenziali e URL interni

- evita log di produzione che possano contenere dati personali

- usa esempi sintetici (account finti, ID falsi) per i dati di test

- se devi condividere casi reali, minimizza e anonimizza

Se usi una piattaforma IA ospitata, applica la stessa disciplina. Anche quando la piattaforma offre deployment moderni e hosting regionale, i prompt e i fixture restano parte della tua postura di sicurezza.

Un piano di rollout pratico (che i team seguono davvero)

Inizia in piccolo e rendilo routine:

- Scegli un servizio o modulo con cambi frequenti.

- Genera unit test per i percorsi a più alto rischio (movimenti di denaro, permessi, trasformazioni dati).

- Aggiungi una regola CI semplice: le nuove feature generate dall'IA devono includere test.

- Richiedi una rapida checklist di revisione umana: “Questo test asserisce comportamento? Fallirebbe per il motivo giusto?”

- Traccia le regressioni prevenute (non solo la coverage), poi estendi ai test di integrazione quando i unit test sono stabili.

L'obiettivo non è massimizzare il numero di test—è ottenere feedback affidabili che mantengano onesta la logica generata dall'IA.