Cosa significa quando i dati incontrano l’economia fisica

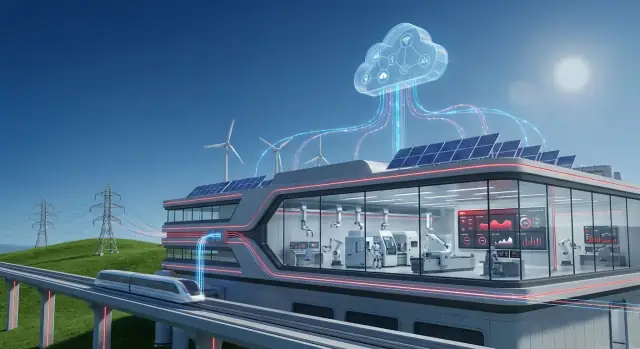

L’“economia fisica” è la parte dell’attività che muove atomi, non solo informazioni. È la centrale elettrica che bilancia domanda e offerta, la rete ferroviaria che mantiene gli orari, la fabbrica che trasforma materie prime in prodotti finiti e il servizio idrico che mantiene pressione e qualità in una città.

In questi ambienti il software non misura solo click o conversioni: influenza attrezzature reali, persone reali e costi reali. Una decisione di manutenzione presa in ritardo può diventare un guasto. Una piccola deriva di processo può trasformarsi in scarti, tempi di fermo o in un incidente di sicurezza.

Ecco perché i dati contano in modo diverso qui: devono essere tempestivi, affidabili e legati a ciò che accade sul campo.

Perché i dati sono diversi quando gestisci asset

Quando il tuo “prodotto” è disponibilità, throughput e affidabilità, i dati diventano uno strumento pratico:

- Per vedere cosa sta realmente succedendo (vibrazioni, temperatura, consumo energetico, tempi di ciclo)

- Per prevedere cosa è probabile che accada dopo (primi segnali di guasto, formazione di colli di bottiglia)

- Per scegliere la migliore azione (inviare una squadra, rallentare una linea, deviare potenza, riordinare pezzi)

Ma ci sono compromessi reali. Non puoi mettere in pausa una fabbrica per “aggiornare dopo”. I sensori possono essere rumorosi. La connettività non è sempre garantita. E le decisioni spesso devono essere spiegabili ad operatori, ingegneri e regolatori.

OT + IT: due mondi che devono cooperare

Qui la convergenza OT e IT comincia a fare la differenza.

- OT (Operational Technology) è il mondo delle macchine: sistemi di controllo, PLC, SCADA, strumentazione e le pratiche di sicurezza e affidabilità che mantengono le operazioni stabili.

- IT (Information Technology) è il mondo dei sistemi aziendali: ERP, registri asset, gestione dei servizi, analytics, identità e accessi e cybersecurity aziendale.

Quando OT e IT collaborano, i segnali operativi possono innescare workflow di business—come creare un work order, controllare l’inventario, schedulare squadre e tracciare i risultati.

Cosa aspettarsi da questa guida

Imparerai dove si manifesta tipicamente il valore (uptime, manutenzione, efficienza energetica), cosa serve a livello architetturale (pattern edge-to-cloud) e cosa tenere d’occhio (sicurezza, governance e change management). L’obiettivo è un quadro chiaro e realistico di come i dati industriali diventino decisioni migliori—non solo più cruscotti.

Hitachi nel contesto: radici industriali più capacità software

Hitachi si trova a un’intersezione sempre più rilevante per le organizzazioni moderne: i sistemi che fanno funzionare operazioni fisiche (treni, reti elettriche, fabbriche, impianti idrici) e il software che pianifica, misura e migliora le prestazioni di quelle operazioni.

Questo background conta perché gli ambienti industriali tendono a premiare l’ingegneria consolidata, cicli di vita degli asset lunghi e miglioramenti incrementali e costanti—non rapidi cambi di piattaforma.

Cosa include la “tecnologia industriale”

Quando si parla di “tecnologia industriale” in questo contesto, si fa riferimento tipicamente allo stack che mantiene i processi reali stabili e sicuri:

- Macchinari e asset: motori, azionamenti, materiale rotabile, trasformatori, pompe, turbine e altre macchine a lunga vita.

- Controlli e automazione: sensori, controllo in stile PLC/SCADA, sistemi di sicurezza e la strumentazione che dice agli operatori cosa sta succedendo.

- Pratiche di ingegneria e operazioni: routine di manutenzione, metodi di affidabilità, messa in servizio e gli standard che regolano uptime e sicurezza.

Questo lato riguarda la fisica, i vincoli e le condizioni operative—calore, vibrazione, carico, usura e le realtà del lavoro sul campo.

Cosa include il “software aziendale”

“Software aziendale” è l’insieme di sistemi che trasforma le operazioni in decisioni coordinate e azioni verificabili tra i team:

- Pianificazione e finanza (ERP): budget, acquisti, inventario e visibilità dei costi.

- Gestione asset e manutenzione (EAM/CMMS): work order, pezzi di ricambio, ispezioni e storico del ciclo di vita.

- Analytics e reporting: cruscotti, KPI e trend di performance.

- Workflow e collaborazione: approvazioni, tracciamento degli incidenti e coordinamento cross-funzionale.

La storia di Hitachi è rilevante perché riflette un cambiamento più ampio: le aziende industriali vogliono che i dati operativi fluiscano nei workflow aziendali senza perdere contesto o controllo. L’obiettivo non è “più dati” per il gusto di averne—ma un allineamento più stretto tra ciò che avviene sul campo e come l’organizzazione pianifica, mantiene e migliora i propri asset nel tempo.

Dalle macchine all’intuizione: il percorso dei dati operativi

I siti industriali sono pieni di segnali che descrivono cosa sta succedendo ora: temperature che derivano, vibrazioni che aumentano, qualità della potenza che fluttua, throughput che rallenta, allarmi che suonano. Fabbriche, ferrovie, miniere e servizi generano questi segnali continuamente perché l’equipaggiamento fisico deve essere monitorato per rimanere sicuro, efficiente e conforme.

La sfida non è ottenere più dati—è trasformare letture grezze in decisioni di cui le persone si fidano.

Da dove provengono realmente i dati

La maggior parte delle operazioni attinge da un mix di sistemi di controllo in tempo reale e registri di business:

- Sensori e contatori su pompe, turbine, motori, linee e sottostazioni (pressione, flusso, corrente, vibrazione, ecc.)

- Sistemi PLC e SCADA che controllano e supervisionano i processi, spesso memorizzando dati in un historian

- Registri di manutenzione e work order dagli strumenti EAM/CMMS (cosa è fallito, cosa è stato sostituito, quanto tempo ha impiegato)

- Dati ERP come ordini di produzione, inventario, approvvigionamenti e centri di costo—utili per collegare la performance al denaro

Da soli, ogni fonte racconta una storia parziale. Insieme, possono spiegare perché la performance cambia e cosa fare dopo.

Cosa va storto sulla strada verso l’“intuizione”

I dati operativi sono disordinati per motivi prevedibili. I sensori vengono sostituiti, i tag vengono rinominati e le reti perdono pacchetti. Problemi comuni includono:

- Valori mancanti o duplicati (gap durante blackout, campioni ripetuti dopo le riconnessioni)

- Tag e unità incoerenti ("Temp_1" vs "TMP-01", °C vs °F, kW vs MW)

- Problemi di sincronizzazione temporale tra dispositivi e sistemi (una deriva di cinque minuti può rompere l’analisi causa-effetto)

Se ti sei mai chiesto perché i cruscotti non coincidono, spesso è perché timestamp, nomenclature o unità non sono allineati.

Perché il contesto batte il volume

Una lettura diventa significativa solo quando puoi rispondere: a quale asset appartiene, dove si trova e in che stato era?

“Vibrazione = 8 mm/s” è molto più utilizzabile quando è collegata a Pompa P-204, nella Linea 3, in funzione all’80% di carico, dopo una sostituzione del cuscinetto il mese scorso, durante un particolare turno di produzione.

Questo contesto—gerarchia degli asset, posizione, modalità operativa e storia della manutenzione—è ciò che permette agli analytics di separare la variazione normale dai segnali di allarme precoce.

Il percorso dei dati operativi è essenzialmente uno spostamento da segnali → serie temporali pulite → eventi contestualizzati → decisioni, così i team possono passare dal reagire agli allarmi al gestire le prestazioni in modo deliberato.

Convergenza OT–IT: collegare due mondi senza romperne nessuno

L’OT è ciò che fa funzionare un’operazione fisica: macchine, sensori, sistemi di controllo e le procedure che mantengono in funzione in modo sicuro un impianto, una rete ferroviaria o una sottostazione.

L’IT è ciò che fa funzionare l’azienda: ERP, finanza, HR, approvvigionamenti, sistemi clienti e le reti e app che gli impiegati usano ogni giorno.

La convergenza OT–IT significa semplicemente far condividere a questi due mondi i dati giusti al momento giusto—senza mettere a rischio produzione, sicurezza o conformità.

Dove si manifesta di solito l’attrito

La maggior parte dei problemi non è prima di tutto tecnica; è operativa.

- Proprietà e incentivi: i team OT sono misurati su uptime e sicurezza. I team IT su standardizzazione, controllo dei costi e cybersecurity.

- Controllo delle modifiche: in OT un “piccolo aggiornamento” può fermare una linea. In IT patchare frequentemente è normale.

- Requisiti di uptime: i sistemi OT possono girare per anni con downtime minimo; le finestre di manutenzione sono rare e pianificate con cura.

- Vocabolari diversi: OT parla di allarmi, PLC e setpoint; IT parla di ticket, API e gestione delle identità.

Di cosa ha davvero bisogno l’integrazione

Per rendere pratica la convergenza servono di solito alcuni blocchi fondamentali:

- Connettori e protocolli che leggano segnali OT in modo sicuro (spesso tramite gateway) e li mappino in formati compatibili con l’IT.

- API per muovere i dati nelle app enterprise (manutenzione, inventario, finanza) e viceversa.

- Event stream per i momenti “qualcosa è appena successo”—come un picco di vibrazione che innesca un work order.

- Allineamento dei master data così tutti concordano su cosa significhi “asset”, “sito” o “work order” tra i sistemi.

Un percorso più sicuro: partire in piccolo, dimostrare valore, poi scalare

Un approccio pratico è scegliere un caso d’uso ad alto valore (per esempio manutenzione predittiva su un asset critico), collegare un set di dati limitato e concordare metriche di successo chiare.

Quando il workflow è stabile—qualità dei dati, alert, approvazioni e sicurezza—espandi ad altri asset, poi ad altri siti. Questo mantiene l’OT tranquillo sulla affidabilità e sul controllo delle modifiche, dando all’IT gli standard e la visibilità necessari per scalare.

Architettura edge-to-cloud in parole semplici

Costruisci la tua prima app OT-IT

Crea una piccola app workflow OT-IT da chat e iterala senza aspettare un ciclo di sviluppo completo.

I sistemi industriali generano segnali preziosi—temperature, vibrazioni, consumo energetico, throughput—ma non tutti appartengono allo stesso posto. “Edge-to-cloud” significa semplicemente dividere il lavoro tra computer vicino all’equipaggiamento (edge) e piattaforme centralizzate (cloud o data center), in base a ciò di cui l’operazione ha bisogno.

Perché parte dell’elaborazione resta vicino all’apparecchiatura

Alcune decisioni devono accadere in millisecondi o secondi. Se un motore sta surriscaldando o si attiva un interblocco di sicurezza, non puoi aspettare il round trip a un server distante.

L’elaborazione all’edge aiuta con:

- Controlli e alert a bassa latenza: risposte rapide per allarmi, controlli qualità e ottimizzazione locale.

- Affidabilità durante problemi di rete: l’impianto continua a funzionare anche se la connettività cade.

- Risparmio di banda: filtrare e comprimere flussi di sensori ad alta frequenza prima di mandare riepiloghi upstream.

Cosa si sposta alle piattaforme centralizzate

Le piattaforme centralizzate sono ideali quando il valore dipende dal combinare dati tra linee, impianti o regioni.

I lavori tipici “lato cloud” includono:

- Analytics cross-site: confrontare performance tra strutture, identificare best practice.

- Modelli a livello di flotta: migliorare la manutenzione predittiva imparando da molti asset simili.

- Reporting e compliance: cruscotti standardizzati per dirigenti, auditor e team di sostenibilità.

Un semplice flusso di riferimento (raccogli → pulisci → analizza → agisci)

- Raccogli: sensori/PLC/SCADA inviano dati a un gateway edge.

- Pulisci: l’edge normalizza unità, timestamp e tag; può rimuovere rumore ovvio.

- Analizza: regole rapide o modelli girano localmente; analisi più approfondite girano centralmente dove ci sono più risorse e storicità.

- Agisci: le azioni tornano come alert, work order o raccomandazioni di setpoint—spesso integrate con strumenti di manutenzione e enterprise (per esempio, via /blog/ot-it-convergence).

Fondamenti di governance: chi può accedere a quali dati—and perché

L’architettura riguarda anche fiducia. Una buona governance definisce:

- Ruoli e permessi: gli operatori vedono dati di processo live; gli ingegneri di affidabilità vedono lo stato degli asset; i dirigenti vedono i KPI.

- Proprietà dei dati: chi approva la condivisione dei dati tra siti o con i fornitori.

- Auditabilità: log di chi ha accesso ai dati e cosa è stato cambiato.

Quando edge e cloud sono progettati insieme, ottieni velocità sul piano operativo e coerenza a livello enterprise—senza obbligare ogni decisione a vivere in un unico posto.

Prestazioni degli asset + workflow aziendali: dove si vede il valore

Il software industriale crea il valore più visibile quando collega come si comportano gli asset con come risponde l’organizzazione. Non si tratta solo di sapere che una pompa si sta degradando—ma di assicurarsi che il lavoro giusto venga pianificato, approvato, eseguito e appreso.

APM vs. EAM (e perché entrambi sono importanti)

Asset Performance Management (APM) si concentra sui risultati di affidabilità: monitorare lo stato, rilevare anomalie, capire il rischio e raccomandare azioni per ridurre i guasti. Risponde a “cosa è probabile che si rompa, quando e cosa dovremmo fare?”

Enterprise Asset Management (EAM) è il sistema di registrazione per le operazioni di asset e manutenzione: gerarchie di asset, work order, manodopera, permessi, inventario e storico di conformità. Risponde a “come pianifichiamo, tracciamo e controlliamo il lavoro e i costi?”

Usati insieme, APM può dare priorità agli interventi giusti, mentre l’EAM assicura che quegli interventi avvengano con controlli adeguati—supportando affidabilità e controllo dei costi.

Manutenzione predittiva che incide sul bilancio

La manutenzione predittiva diventa significativa quando produce risultati misurabili come:

- Riduzione dei fermi non pianificati (meno arresti linea, meno chiamate d’emergenza)

- Minori spese per ricambi (meno scorte “per sicurezza”, meno ordini urgenti)

- Operazioni più sicure (rilevamento precoce riduce guasti catastrofici e lavori reattivi rischiosi)

- Migliore utilizzo degli asset (manutenzione allineata alle condizioni, non al caso)

Cosa serve per avere successo

I programmi che funzionano di solito partono dai fondamentali:

- Una lista chiara di modi di guasto per gli asset critici (cosa si rompe davvero e come)

- Baseline delle prestazioni e della storia della manutenzione (così il miglioramento è dimostrabile)

- Processi di lavoro definiti che collegano gli alert all’azione (triage, approvazione, schedulazione, chiusura)

- Proprietà: chi rivede gli insight, chi decide e chi esegue

Evita la trappola “solo AI”

L’analytics senza conseguenze diventa un cruscotto che nessuno si fida. Se un modello segnala usura di un cuscinetto ma nessuno crea un work order, prenota i pezzi o registra i risultati dopo la riparazione, il sistema non può imparare—e l’azienda non percepirà il beneficio.

Digital twin e simulazione per decisioni nel mondo reale

Un digital twin va inteso come un modello pratico e operativo di un asset o processo reale—costruito per rispondere a domande “e se?” prima di cambiare il sistema reale. Non è una semplice animazione 3D per presentazioni (anche se può includere visualizzazioni). È uno strumento decisionale che combina come qualcosa è progettato per comportarsi con come si sta comportando realmente.

Cosa puoi simulare (e perché conta)

Quando un twin riflette la realtà abbastanza bene, i team possono testare opzioni in sicurezza:

- Throughput e colli di bottiglia: “Se cambiamo la velocità di linea o la dimensione del lotto, dove si sposta la congestione?”

- Consumo energetico: “Qual è l’impatto energetico del far girare le pompe diversamente, spostare i turni o cambiare setpoint?”

- Usura e vita residua: “Come influenza la vita dei cuscinetti operare a carichi maggiori?”

- Vincoli e compromessi: “Riusciamo a raggiungere gli obiettivi di output senza superare limiti di temperatura, soglie di vibrazione o margini di sicurezza?”

Qui la simulazione diventa preziosa: puoi confrontare scenari e scegliere quello che meglio bilancia produzione, costi, rischio e conformità.

Cosa serve a un twin per essere credibile

I twin utili combinano due tipi di dati:

- Dati di ingegneria: specifiche di progetto, logiche di controllo, curve dell’equipaggiamento, modelli CAD/BIM, manuali di manutenzione e vincoli di processo.

- Dati operativi live: letture dei sensori, tag PLC/SCADA, trend da historian, work order, condizioni ambientali e input degli operatori.

I programmi software industriali (inclusi setup edge-to-cloud) aiutano a mantenere sincronizzate queste fonti così il twin rifletta l’operatività quotidiana piuttosto che assunzioni “come progettato”.

Limitazioni da pianificare

I digital twin non sono “imposti e dimenticati”. Problemi comuni includono:

- Deriva del modello: il mondo reale cambia—componenti invecchiano, condizioni di processo cambiano—quindi le previsioni perdono accuratezza.

- Gap e qualità dei sensori: tag mancanti, cattiva calibrazione o campionamenti incoerenti possono indebolire il twin.

- Manutenzione continua: aggiornare parametri, validare output e gestire il controllo versioni richiedono ownership e routine.

Un buon approccio è partire con una decisione strettamente definita (una linea, una classe di asset, un KPI), dimostrarne il valore e poi espandere.

Sicurezza, safety e affidabilità nell’industria connessa

Rilascia con controllo delle modifiche

Esporta il codice sorgente, distribuisci e mantieni i cambiamenti più sicuri con snapshot e rollback.

Connettere fabbriche, sistemi ferroviari, asset energetici ed edifici crea valore—ma cambia anche il profilo di rischio. Quando il software tocca operazioni fisiche, la sicurezza non riguarda più solo la protezione dei dati; riguarda mantenere i sistemi stabili, le persone al sicuro e il servizio in funzione.

Perché la cybersecurity industriale è diversa dall’IT d’ufficio

Nell’IT d’ufficio una violazione è spesso misurata in informazioni perse o downtime per i knowledge worker. Nell’OT le interruzioni possono fermare linee di produzione, danneggiare apparecchiature o creare condizioni non sicure.

Gli ambienti OT tendono anche a eseguire sistemi più datati per cicli di vita lunghi, non possono sempre riavviare a piacimento e devono dare priorità a comportamenti prevedibili rispetto a cambi rapidi.

Controlli essenziali che riducono davvero il rischio

Parti dai fondamentali adattati alla realtà industriale:

- Segmentazione di rete: separa le reti di business da quelle operative, poi segmenta le zone critiche (es. sistemi di sicurezza, controller, historian/piattaforme dati). Limita i percorsi tra zone e documenta il traffico “permesso”.

- Identità e accesso: usa account nominativi, accesso basato sui ruoli e autenticazione a più fattori dove praticabile—specialmente per accessi remoti. Restringi l’accesso dei fornitori con approvazioni a tempo.

- Strategia di patch: tratta le patch come cambiamenti di ingegneria. Testa gli aggiornamenti, pianifica finestre di manutenzione e usa controlli compensativi (segmentazione, allowlist) quando patchare non è possibile.

- Monitoraggio e rilevamento: raccogli log da dispositivi edge, gateway, server e punti chiave di rete. Concentrati su comportamenti insoliti (nuove connessioni, comandi inattesi), non solo su firme di malware.

Aspetti di safety e requisiti normativi

I programmi industriali dovrebbero allineare le azioni di sicurezza con le esigenze operative di safety e compliance: controllo delle modifiche chiaro, tracciabilità di chi ha fatto cosa ed evidenze che i sistemi critici restano entro limiti operativi sicuri.

Prontezza agli incidenti: pianifica il recupero, non solo la prevenzione

Dai per scontato che qualcosa fallirà—sia un evento cyber, una misconfigurazione o un guasto hardware. Mantieni backup offline, prova procedure di ripristino, definisci priorità di recovery e assegna responsabilità chiare tra IT, OT e leadership operativa.

L’affidabilità migliora quando tutti sanno cosa fare prima che accada un incidente.

Risultati di sostenibilità guidati dall’intelligenza operativa

La sostenibilità nell’industria pesante non è principalmente un’operazione di branding—è un problema operativo. Quando puoi vedere cosa fanno macchine, impianti, flotte e reti di fornitura (in quasi tempo reale), puoi mirare alle fonti specifiche di spreco energetico, downtime non pianificato, scarti e rilavorazioni che guidano sia i costi che le emissioni.

Come dati operativi migliori riducono sprechi ed emissioni

L’intelligence operativa trasforma “pensiamo che questa linea sia inefficiente” in evidenza: quali asset consumano troppo, quali step di processo sono fuori specifica e quali arresti forzano cicli di riavvio che consumano carburante extra.

Anche piccoli miglioramenti—tempi di warm-up più corti, meno ore di idle, controllo più stretto dei setpoint—si sommano su migliaia di ore di esercizio.

Le leve pratiche che producono risultati

Tre leve si ripetono spesso:

- Ottimizzazione: aggiusta pianificazioni, setpoint e throughput basandoti sui vincoli (salute degli asset, prezzo dell’energia, domanda) per evitare funzionamenti spreconi.

- Manutenzione basata sulle condizioni: usa vibrazione, temperatura, assorbimento di potenza e allarmi per intervenire quando cambiano indicatori—evitando guasti che causano eventi di stop/start energeticamente costosi e scarti.

- Reporting: automatizza la raccolta di KPI energetici, materiali e operativi così i team passano meno tempo a compilare fogli di calcolo e più tempo a risolvere le cause profonde.

Misurazione vs attribuzione vs riduzione

È utile separare tre concetti:

- Misurazione: catturare dati accurati (metering, integrità dei sensori, timestamp coerenti).

- Attribuzione: collegare consumi ed emissioni a processo, prodotto, linea o sito (così sai dove agire).

- Riduzione: implementare cambiamenti che abbassino in modo sostenibile il consumo o le emissioni (e mantenere i guadagni).

Metriche trasparenti contano. Usa baseline chiare, documenta le assunzioni e supporta le affermazioni con evidenze pronte per l’audit. Questa disciplina aiuta a evitare affermazioni eccessive e facilita la scalabilità dei progressi.

Come valutare e implementare un programma software industriale

Correggi tag e unità

Crea uno strumento leggero di normalizzazione tag e unità per ridurre i “cruscotti che non concordano”.

Scegliere software industriale non è solo confrontare funzionalità—è un impegno su come il lavoro viene svolto tra operations, manutenzione, ingegneria e IT.

Una valutazione pratica inizia allineando le decisioni che vuoi migliorare (per esempio: meno outage non pianificati, work order più veloci, migliore performance energetica) e i siti dove intendi provarle per primi.

Criteri di valutazione che contano

Usa una scorecard che rifletta sia il piano operativo sia le esigenze enterprise:

- Compatibilità di integrazione: può connettersi ai tuoi PLC/SCADA, historian, CMMS/EAM, ERP e piattaforme dati senza lavoro custom fragile?

- Scalabilità: lo stesso approccio funzionerà per una linea, un sito e poi decine—senza cali di prestazioni o riprogettazioni?

- Supporto del fornitore: cerca servizi di deployment provati, SLA chiari, percorsi di upgrade e un ecosistema di partner per il tuo settore.

- Costo totale di proprietà: la licenza è solo una parte—includi connettività, hardware edge, implementazione, cybersecurity, formazione e amministrazione continua.

Un piano di rollout a fasi (con vittorie misurabili)

Evita i deployment “big bang”. Un approccio a fasi riduce il rischio e costruisce credibilità:

- Pilot (4–12 settimane): scegli una classe di asset o un collo di bottiglia del processo. Definisci metriche di successo in anticipo (es. % riduzione del downtime, tempo di risposta manutentiva, energia per unità).

- Scala a un sito: standardizza tag, convenzioni di naming e workflow. Documenta cosa è cambiato e perché.

- Replica tra siti: crea template (cruscotti, alert, trigger di work order) e un modello di governance così ogni sito non re-inventa la ruota.

In pratica, i team sottovalutano spesso quanti “piccoli” strumenti interni serviranno durante il rollout—code di triage, revisioni delle eccezioni, form per arricchire work order, workflow di approvazione e portali semplici che connettano segnali OT ai sistemi IT. Piattaforme come Koder.ai possono aiutare qui permettendo ai team di costruire e iterare rapidamente queste app web di supporto via chat, poi integrarle con le API esistenti—senza aspettare un ciclo di sviluppo full custom.

Change management: la parte che determina l’adozione

Il software industriale ha successo quando i team di prima linea si fidano. Prevedi tempo per formazione basata sui ruoli, procedure aggiornate (chi riconosce gli alert, chi approva i work order) e incentivi che premiano comportamenti guidati dai dati—non solo spegnere incendi.

Se stai mappando opzioni, può aiutare rivedere i use case confezionati di un fornitore sotto /solutions, capire i modelli commerciali su /pricing e discutere il tuo ambiente tramite /contact.

Cosa segue per la tecnologia industriale e il software aziendale

La tecnologia industriale si muove da “attrezzature connesse” a “risultati connessi”. La direzione è chiara: più automazione sul shop floor, più dati operativi disponibili ai team di business e cicli di feedback più rapidi tra pianificazione ed esecuzione.

Invece di aspettare report settimanali, le organizzazioni pretenderanno visibilità quasi in tempo reale su produzione, uso energetico, qualità e salute degli asset—e agiranno con il minimo di passaggi manuali.

Trend di mercato: automazione + condivisione dati più sicura

L’automazione si estenderà oltre i sistemi di controllo nei workflow decisionali: schedulazione, pianificazione della manutenzione, rifornimento inventario e gestione delle eccezioni.

Allo stesso tempo la condivisione dei dati diventerà più ampia—ma anche più selettiva. Le aziende vogliono condividere i dati giusti con i partner giusti (OEM, appaltatori, utility, fornitori logistici) senza esporre dettagli sensibili di processo.

Questo spinge vendor e operatori a trattare i dati come prodotto: ben definiti, permissioned e tracciabili. Il successo dipenderà da governance che sia pratica per le operazioni, non solo compliance-driven per l’IT.

L’interoperabilità deciderà velocità (e costi)

Mentre le organizzazioni mescolano apparecchiature legacy con nuovi sensori e software, l’interoperabilità diventa la differenza tra scalare e bloccarsi. Standard aperti e API ben supportate riducono il lock-in, accorciano i tempi di integrazione e permettono ai team di aggiornare una parte dello stack senza riscrivere tutto.

In parole semplici: se non riesci a connettere facilmente asset, historian, ERP/EAM e strumenti analytics, spenderai il budget in tubature invece che in performance.

Probabili prossimi passi: copiloti e ottimizzazione autonoma

Aspettati “copilot AI” progettati per ruoli industriali specifici—pianificatori di manutenzione, ingegneri di affidabilità, operatori sala controllo e tecnici in campo. Questi strumenti non sostituiranno l’esperienza; riassumeranno allarmi, raccomanderanno azioni, redigeranno work order e aiuteranno i team a spiegare perché viene suggerito un cambiamento.

Qui entrano naturalmente piattaforme “vibe-coding” come Koder.ai: accelerano la creazione di copiloti interni e app di workflow (per esempio, un riepilogatore di incidenti o un assistente per la pianificazione della manutenzione) consentendo comunque ai team di esportare codice sorgente, distribuire e iterare con snapshot e rollback.

Successivamente, più siti adotteranno ottimizzazione autonoma in ambiti ristretti: sintonizzare automaticamente setpoint entro limiti di sicurezza, bilanciare throughput vs costo energetico e adattare le finestre di manutenzione in base alle condizioni reali.

Semplice checklist interna per avviare la conversazione

- Quali decisioni vogliamo prendere più velocemente (manutenzione, qualità, energia, pianificazione)?

- Quali dati mancano—o sono intrappolati in silos—to supportare quelle decisioni?

- Quali sistemi devono interoperare per primi (fonti OT, EAM/ERP, analytics, reporting)?

- Quali requisiti di “standard aperto” o API dovremmo imporre negli acquisti futuri?

- Dove possiamo pilotare in sicurezza (una linea, un sito, una classe di asset) e misurare il ROI?

- Chi è responsabile per sicurezza, accesso e change management tra OT e IT?