Cosa significa “iterazione” — e dove entra l'AI

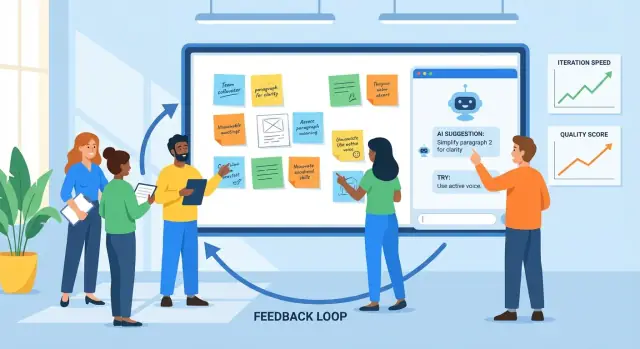

L'iterazione è la pratica di creare qualcosa, raccogliere feedback, migliorarlo e ripetere il ciclo. La vedi nel design di prodotto (rilasci una funzione, osservi l'uso, affini), nel marketing (testi un messaggio, impari, riscrivi) e nella scrittura (bozza, revisione, editing).

Il feedback è qualsiasi segnale che ti dice cosa funziona e cosa no: commenti degli utenti, ticket di supporto, segnalazioni di bug, risposte ai sondaggi, metriche di performance, note degli stakeholder—anche il tuo giudizio dopo aver usato personalmente il prodotto. Il miglioramento è ciò che cambi in base a quei segnali, da piccoli aggiustamenti a riprogettazioni più ampie.

Perché cicli più brevi contano

I cicli di feedback più brevi tendono a produrre risultati migliori per due motivi principali:

- La qualità migliora più rapidamente: intercetti fraintendimenti e difetti quando sono ancora limitati, prima che si diffondano su più pagine, schermate o rilasci.

- La velocità aumenta senza ipotesi: spendi meno tempo a discutere teoricamente e più tempo a imparare da evidenze reali.

Un buon ritmo di iterazione non è “vai veloce e rompe tutto”. È “muoviti a piccoli passi e impara in fretta”.

Dove aiuta l'AI (e dove non lo fa)

L'AI è utile all'interno del loop quando c'è molta informazione e serve aiuto per processarla. Può:

- riassumere feedback provenienti da molte fonti in temi

- individuare lamentele ripetute, formulazioni confuse o dettagli mancanti

- proporre versioni alternative (copy, layout, formulazione di task) da considerare

- fare da secondo paio d'occhi per chiarezza, tono e coerenza

Ma l'AI non può sostituire le decisioni fondamentali. Non conosce i tuoi obiettivi di business, i vincoli legali o cosa significa “buono” per i tuoi utenti a meno che tu non lo definisca. Può suggerire cambiamenti rischiosi, fuori brand o basati su presupposti errati.

Stabilisci aspettative chiare: l'AI supporta il giudizio. La tua squadra decide ancora cosa dare priorità, cosa cambiare, cosa significa successo—e valida i miglioramenti con utenti e dati reali.

Il loop di base del feedback: un modello pratico

L'iterazione è più semplice quando tutti seguono lo stesso loop e sanno cosa significa “fatto”. Un modello pratico è:

draft → feedback → revise → check → ship

I team spesso si bloccano perché un passaggio è lento (le revisioni), disordinato (feedback sparso su strumenti diversi) o ambiguo (cosa bisogna cambiare esattamente?). Usata deliberatamente, l'AI può ridurre l'attrito in ogni punto.

Step 1: Draft (arrivare a qualcosa di recensibile)

L'obiettivo non è la perfezione; è una prima versione solida su cui altri possano reagire. Un assistente AI può aiutare a strutturare, generare alternative o colmare lacune così arrivi prima a una bozza recensibile.

Dove aiuta di più: trasformare un brief grezzo in una bozza strutturata e produrre opzioni multiple (es. tre titoli, due flussi di onboarding) da confrontare.

Step 2: Feedback (raccogliere e condensare)

Il feedback arriva spesso come commenti lunghi, thread di chat, note di chiamate e ticket di supporto. L'AI è utile per:

- riassumere temi ripetuti (cosa viene continuamente menzionato)

- raggruppare il feedback per argomento (prezzi, onboarding, tono, bug)

- estrarre domande e elementi “da correggere assolutamente” vs. “nice-to-have”

Il collo di bottiglia che rimuovi: lettura lenta e interpretazioni incoerenti di ciò che i revisori intendevano.

È qui che i team perdono tempo in riscritture: feedback poco chiaro porta a modifiche che non soddisfano il revisore e il loop ricomincia. L'AI può suggerire modifiche concrete, proporre copy rivisto o generare una seconda versione che affronti esplicitamente i temi principali del feedback.

Step 4: Check (qualità prima del rilascio)

Prima del rilascio, usa l'AI come secondo paio d'occhi: la nuova versione introduce contraddizioni, passaggi mancanti, requisiti rotti o deriva di tono? Lo scopo non è “approvare” il lavoro; è intercettare problemi evidenti in anticipo.

Step 5: Ship con una singola fonte di verità

L'iterazione accelera quando le modifiche vivono in un unico posto: un ticket, un documento o la descrizione di una PR che registra (1) il riassunto del feedback, (2) le decisioni e (3) cosa è cambiato.

L'AI può aiutare a mantenere quella “singola fonte di verità” redigendo note di aggiornamento e mantenendo i criteri di accettazione allineati con le ultime decisioni. Nei team che sviluppano e rilasciano software direttamente (non solo documenti), piattaforme come Koder.ai possono abbreviare questo passaggio mantenendo pianificazione, implementazione e deploy strettamente connessi—così la narrazione di “cosa è cambiato” resta vicina al rilascio effettivo.

Raccogliere feedback: cosa l'AI può processare bene

L'AI può migliorare solo ciò che le viene dato. La buona notizia è che la maggior parte dei team ha già molto feedback—è solo sparso in posti diversi e scritto in stili differenti. Il tuo compito è raccoglierlo in modo coerente così l'AI può riassumerlo, individuare pattern e aiutarti a decidere cosa cambiare dopo.

L'AI è più efficace con input testuali disordinati, inclusi:

- commenti degli utenti (in-app, post di community, chat)

- ticket di supporto e trascrizioni chat

- risposte aperte ai sondaggi

- recensioni su app store e marketplace

- note di chiamate sales/CS e sommari delle riunioni

- segnalazioni di bug e richieste di funzionalità interne

Non serve una formattazione perfetta. Conta catturare le parole originali e qualche metadato leggero (data, area prodotto, piano, ecc.).

Da “una pila di citazioni” a temi e punti dolenti

Una volta raccolto, l'AI può raggruppare il feedback in temi—confusione sui pagamenti, attrito nell'onboarding, integrazioni mancanti, performance lenta—e mostrare cosa si ripete più spesso. Questo è importante perché il commento più rumoroso non è necessariamente il problema più comune.

Un approccio pratico è chiedere all'AI:

- una lista di temi con etichette brevi

- citazioni rappresentative per tema (per poterle verificare)

- segnali di frequenza (es. “menzionato in 18 ticket questa settimana”)

- suggerimenti sull'impatto (chi è coinvolto e cosa blocca)

Mantenere il contesto così gli insight restano rilevanti

Il feedback senza contesto può portare a conclusioni generiche. Allegare un contesto leggero a ogni elemento aiuta, per esempio:

- persona o tipo di cliente (nuovo utente, admin, utente avanzato)

- obiettivo dell'utente (“esportare un report”, “invitare colleghi”)

- vincoli (dispositivo, regione, piano, requisiti di conformità)

Anche pochi campi coerenti rendono i raggruppamenti e i riassunti dell'AI molto più azionabili.

Basi di privacy e gestione dei dati

Prima dell'analisi, redigi le informazioni sensibili: nomi, email, numeri di telefono, indirizzi, dettagli di pagamento e qualsiasi contenuto riservato nelle note di chiamata. Preferisci la minimizzazione dei dati—condividi solo ciò che serve per il compito—e conserva gli export raw in modo sicuro. Se usi tool di terze parti, conferma la policy del team su retention e training e limita gli accessi al dataset.

Il feedback grezzo è spesso un insieme di input disomogenei: ticket di supporto, recensioni, commenti ai sondaggi, note di vendita e thread Slack. L'AI è utile perché può leggere linguaggi "disordinati" su larga scala e aiutarti a trasformarli in una lista breve di temi su cui lavorare.

Inizia fornendo all'AI un batch di feedback (dopo aver rimosso i dati sensibili) e chiedile di raggruppare gli elementi in categorie coerenti come onboarding, performance, prezzi, confusione UI, bug e richieste di funzionalità. Lo scopo non è una tassonomia perfetta—è una mappa condivisa che il team può usare.

Un output pratico somiglia a:

- Categoria: Confusione nell'onboarding

- Cosa gli utenti cercano di fare: Collegare account, importare dati

- Ostacoli osservati: “Non riuscivo a trovare il pulsante di importazione”, “Non ero sicuro che avesse funzionato”

2) Aggiungi priorità con una rubrica semplice

Una volta raggruppato il feedback, chiedi all'AI di proporre un punteggio di priorità usando una rubrica che puoi rivedere:

- Impatto: Quanto influisce sul successo dell'utente o sul fatturato?

- Frequenza: Quanto spesso compare tra le fonti?

- Sforzo: Quanto è difficile da sistemare (tempo, dipendenze)?

- Rischio: Probabilità di rompere qualcosa o creare problemi di compliance/supporto?

Puoi mantenerla leggera (Alto/Medio/Basso) o numerica (1–5). L'importante è che l'AI rediga una prima versione e gli umani confermino le assunzioni.

3) Riassumere senza perdere sfumature (conserva le ricevute)

I riassunti diventano pericolosi quando cancellano il “perché”. Un pattern utile è: riassunto del tema + 2–4 citazioni rappresentative. Per esempio:

“Ho collegato Stripe ma non è successo nulla—si è sincronizzato?”

“Il wizard di setup ha saltato un passaggio e non sapevo cosa fare dopo.”

Le citazioni preservano tono ed emozione—e impediscono al team di trattare ogni problema come identico.

4) Attenzione ai bias: il più rumoroso non è sempre il più comune

L'AI può sovrappesare un linguaggio drammatico o ripetere commentatori frequenti se non la guidi. Chiedile di separare:

- Segnali basati sul volume (quanti utenti unici ne parlano)

- Segnali basati sulla gravità (quanto è grave quando succede)

Poi verifica con i dati di utilizzo e la segmentazione. Una lamentela di utenti avanzati può essere molto importante—oppure riflettere un flusso di nicchia. L'AI aiuta a vedere pattern, ma non può decidere cosa “rappresenta i tuoi utenti” senza il tuo contesto.

Usare l'AI per generare versioni, non solo “la risposta”

Fai dell'iterazione un'abitudine

Vai più veloce come squadra mantenendo decisioni, build e rilasci in un unico posto.

Un modo utile di pensare a uno strumento AI è come a un generatore di versioni. Invece di chiedere una singola risposta “migliore”, chiedi più bozze plausibili da confrontare, mescolare e rifinire. Questa mentalità ti mantiene al comando e rende l'iterazione più veloce.

Questo è particolarmente potente quando itera sulle superfici del prodotto (flussi di onboarding, copy UI, wording di specifiche). Per esempio, se costruisci uno strumento interno o una semplice app cliente su Koder.ai, puoi usare lo stesso approccio di “genera più versioni” per esplorare schermate, flussi e requisiti in Planning Mode prima di impegnarti—e poi appoggiarti a snapshot e rollback per mantenere i cambi rapidi al sicuro.

Dai vincoli così le varianti sono confrontabili

Se richiedi “scrivi questo per me”, spesso ottieni output generico. Meglio: definire confini così l'AI può esplorare opzioni all'interno di essi.

Prova a specificare:

- Audience + intento: “Nuovi utenti che decidono se iscriversi” vs. “Clienti esistenti che hanno bisogno di rassicurazioni.”

- Tono: amichevole, diretto, formale, giocoso (scegline uno).

- Lunghezza: es. “120–150 parole” o “max 3 punti.”

- Formato: email, hero di landing page, FAQ, nota di rilascio.

- Fatti da mantenere: prezzi, date, garanzie, limiti di prodotto.

- Da evitare: claim vietati, formulazioni sensibili, menzioni di competitor.

Con vincoli, puoi generare “Versione A: concisa”, “Versione B: più empatica”, “Versione C: più specifica” senza perdere accuratezza.

Genera più opzioni, poi scegli (o combina)

Chiedi 3–5 alternative in un colpo solo e rendi esplicite le differenze: “Ogni versione deve usare una struttura e una frase d'apertura diverse.” Questo crea reale contrasto, che ti aiuta a vedere cosa manca e cosa risuona.

Workflow pratico:

- Genera 3–5 versioni.

- Scegli le parti migliori (apertura da A, proof point da C, CTA da B).

- Chiedi all'AI di unirle in una bozza, mantenendo i fatti da preservare.

Checklist rapida: cosa contiene una “buona bozza”

Prima di mandare una bozza a revisione o test:

- un obiettivo chiaro (cosa il lettore dovrebbe fare/capire)

- fatti chiave coerenti e preservati

- un motivo credibile per interessarsi (beneficio + prova)

- una call-to-action principale

- linguaggio semplice e poco gergo

- nessuna promessa non supportata o superlativo vago

Usata così, l'AI non sostituisce il giudizio—accelera la ricerca della versione migliore.

L'AI come revisore: intercettare problemi in anticipo

Prima di pubblicare una bozza—che sia una specifica di prodotto, una nota di rilascio, un articolo di help o una pagina marketing—uno strumento AI può fungere da primo revisore veloce. Lo scopo non è rimpiazzare il giudizio umano; è far emergere problemi evidenti prima che il team si concentri sulle decisioni difficili anziché sulla pulizia di base.

Cosa fanno bene le revisioni assistite dall'AI

Le revisioni AI sono utili per:

- Chiarezza: individuare frasi lunghe, termini poco chiari o mancanza di contesto per un lettore nuovo.

- Coerenza: controllare naming (etichette funzione, maiuscole), affermazioni ripetute e contraddizioni tra sezioni.

- Tono: allineare la voce all'audience (amichevole, diretta, formale) e segnalare formulazioni che possono sembrare difensive o vaghe.

- Completezza: evidenziare passaggi mancanti, casi limite, prerequisiti o gap su “cosa succede dopo”.

Prompt pratici di revisione riutilizzabili

Incolla la tua bozza e chiedi un tipo specifico di critica. Per esempio:

- “Revisione per gap: quali domande avrebbe ancora un utente alla prima esperienza?”

- “Segnala assunzioni: su cosa sto assumendo che sia vero riguardo prodotto, utente o workflow?”

- “Semplifica: riscrivi ogni frase oltre le 25 parole mantenendo lo stesso significato.”

- “Controlla inconsistenze: elenca i termini usati in più modi.”

Critiche basate sui ruoli per ampliare la prospettiva

Un modo rapido per ampliare la prospettiva è chiedere al modello di recensire dal punto di vista di ruoli diversi:

- “Come cliente, cosa risulta confuso o rischioso?”

- “Come supporto, quali ticket potrebbe generare?”

- “Come PM, quali criteri di accettazione mancano?”

- “Come legal/compliance, quali claim o promesse vanno rivisti?”

Controllo di sicurezza: verifica i fatti

L'AI può criticare la formulazione mentre sbaglia sui dettagli di prodotto. Tratta gli elementi fattuali—prezzi, disponibilità di feature, claims di sicurezza, tempistiche—come “da verificare”. Abitua il team a marcare le affermazioni con fonti (documenti, ticket, decisioni) così la versione finale rifletta la realtà, non una supposizione plausibile.

Convertire il feedback in edit, task e criteri di accettazione

Il feedback grezzo raramente è pronto per essere implementato. Tende a essere emotivo (“questo non mi convince”), misto (“mi piace ma…”) o poco specifico (“rendilo più chiaro”). L'AI può aiutare a tradurlo in elementi di lavoro che il team può realmente consegnare—tenendo però il commento originale allegato così da giustificare le decisioni in futuro.

Un template semplice che l'AI può compilare

Chiedi allo strumento di riscrivere ogni feedback usando questa struttura:

Problem → Evidence → Proposed change → Success metric

- Problem: cosa non funziona?

- Evidence: cosa ha detto/fatto l'utente? Includi la citazione, riferimento screenshot o timestamp della chiamata.

- Proposed change: cosa cambierai (un cambiamento per voce).

- Success metric: come saprai che è migliorato (qualitativo o quantitativo).

Questo costringe a essere chiari senza “inventare” nuovi requisiti.

Esempio di feedback input:

“La pagina checkout è confusa e ci mette troppo.”

Output assistito dall'AI (modificato da te):

- Problem: Gli utenti non comprendono i passaggi e abbandonano durante il checkout.

- Evidence: 6/20 intervistati hanno chiesto “qual è il prossimo passo?”; analytics mostrano un calo del 38% tra Shipping → Payment (10–20 dicembre).

- Proposed change: Aggiungere un indicatore di progresso in 3 step e rinominare il pulsante principale da “Continue” a “Continua al pagamento”.

- Success metric: Ridurre il drop-off Shipping → Payment dal 38% a ≤30% in 2 settimane.

Poi converti in un task con confini chiari:

Task: Aggiungere indicatore di progresso + aggiornare etichetta pulsante nel checkout.

Out of scope: cambiare provider di pagamento, riprogettare l'intero checkout, riscrivere tutto il copy di prodotto.

Criteri di accettazione (rendili testabili)

Usa l'AI per abbozzare i criteri di accettazione, poi stringili:

- L'indicatore di progresso appare su mobile e desktop.

- Gli step riflettono lo stato corrente (Spedizione, Pagamento, Revisione).

- L'etichetta del pulsante è aggiornata sia su Shipping che su Payment.

- Nessuna modifica a prezzi, tasse o elaborazione pagamenti.

Mantieni tracciabile il feedback

Conserva sempre:

- il feedback originale (citazione/link al ticket/registrazione)

- il task trasformato dall'AI

- la decisione finale e la motivazione

Quella tracciabilità protegge la responsabilità, evita decisioni basate su “l'AI ha detto così” e accelera le iterazioni future perché puoi vedere cosa è cambiato—e perché.

Testare i miglioramenti: esperimenti che l'AI può accelerare

Sfrutta al massimo il budget

Allunga il budget guadagnando crediti condividendo quello che costruisci o invitando colleghi su Koder.ai.

L'iterazione diventa concreta quando testi un cambiamento contro un risultato misurabile. L'AI può aiutare a progettare piccoli esperimenti rapidi—senza trasformare ogni miglioramento in un progetto di settimane.

Un modello semplice di esperimento (che l'AI può aiutare a redigere)

Un template pratico è:

- Ipotesi: Se cambiamo X, allora Y migliorerà perché Z.

- Varianti: Versione A (corrente) vs. Versione B (una modifica intenzionale).

- Metrica di successo: il numero che userai per decidere (open rate, activation rate, conversion rate, tempo al primo valore).

- Audience + durata: chi vede la variante e per quanto tempo.

Puoi chiedere a uno strumento AI di proporre 3–5 ipotesi candidate basate sui temi di feedback (es. “gli utenti dicono che il setup è confuso”), poi trasformarle in enunciati testabili con metriche chiare.

Esempi rapidi che l'AI può generare (e che puoi testare)

Oggetti email (metrica: open rate):

- A: “Il tuo report settimanale è pronto”

- B: “3 insight sulla tua settimana (2 minuti per leggerli)”

Messaggio di onboarding (metrica: completamento step 1):

- A: “Benvenuto! Impostiamo il tuo account.”

- B: “Benvenuto—aggiungi il tuo primo progetto e vedi i risultati in meno di 5 minuti.”

Microcopy su un pulsante (metrica: click-through rate):

- A: “Invia”

- B: “Salva e continua”

L'AI è utile perché può produrre rapidamente più varianti plausibili—toni, lunghezze e proposte di valore diverse—così puoi scegliere una modifica chiara da testare.

Regole d'oro: rendi il test interpretabile

La velocità è ottima, ma mantieni gli esperimenti leggibili:

- Cambia una variabile alla volta quando possibile. Se riscrivi headline e pulsante e layout, non saprai cosa ha funzionato.

- Mantieni un controllo. Conserva sempre la Versione A.

- Definisci la metrica prima di guardare i dati. Altrimenti rischi di “scovare” vittorie per caso.

Misura risultati, non sensazioni

L'AI può dirti cosa “suona meglio”, ma a decidere sono gli utenti. Usa l'AI per:

- suggerire soglie di successo (es. “landeremo B se migliora CTR del 5%+”)

- redigere un template di sintesi dei risultati

- tradurre i riscontri nel passo successivo di ipotesi

Così ogni test insegna qualcosa, anche quando la nuova versione perde.

Misurare i risultati e imparare da ogni ciclo

L'iterazione funziona solo se puoi dire se l'ultimo cambiamento ha davvero aiutato. L'AI può velocizzare il passaggio da misurazione a apprendimento, ma non sostituisce la disciplina: metriche chiare, confronti puliti e decisioni scritte.

Scegli metriche che corrispondono all'obiettivo

Scegli un piccolo set di numeri da controllare ogni ciclo, raggruppati per ciò che vuoi migliorare:

- Conversione: iscrizioni, avvii trial, completamento checkout, CTR su una CTA chiave

- Retention: tasso di ritorno a 7/30 giorni, churn, riacquisti, riutilizzo di feature

- Tempo di completamento: tempo di onboarding, tempo al primo valore, tempo di risoluzione supporto

- Tasso di errore / qualità: submit falliti, segnalazioni bug, resi, difetti QA

- Soddisfazione: CSAT, NPS, valutazioni app, sentiment nei ticket di supporto

L'importante è la coerenza: se cambi le definizioni metriche ogni sprint, i numeri non ti insegneranno nulla.

Lascia che l'AI riassuma i risultati—e indichi dove sono cambiati

Quando hai readout di esperimenti, dashboard o CSV esportati, l'AI è utile per trasformarli in una narrazione:

- riassumere cosa si è mosso (e cosa no) in linguaggio semplice

- evidenziare segmenti notevoli: nuovi vs. utenti di ritorno, tipo di device, sorgente traffico, regione, piano, power user vs. casual

- far emergere correlazioni sorprendenti da approfondire (es. conversione su per il totale ma giù su mobile Safari)

Un prompt pratico: incolla la tabella dei risultati e chiedi all'assistente di produrre (1) un paragrafo di sintesi, (2) le maggiori differenze tra segmenti, e (3) domande di follow-up per validare.

Evita certezze fasulle

L'AI può rendere i risultati definitivi anche quando non lo sono. Continua a controllare:

- Dimensione del campione: piccole variazioni su campioni piccoli sono spesso rumore.

- Stagionalità e eventi esterni: festività, promozioni, outage, menzioni stampa.

- Cambi multipli insieme: se sono cambiate tre cose, potresti non sapere cosa ha causato l'effetto.

Tieni un learning log leggero

Dopo ogni ciclo, scrivi una breve nota:

- Cosa è cambiato (link al ticket o documento)

- Cosa è successo (metriche + segmenti notevoli)

- Cosa pensiamo significhi (la spiegazione migliore)

- Cosa proveremo dopo (un follow-up concreto)

L'AI può redigere l'entry, ma il team approva la conclusione. Col tempo, questo registro diventa la tua memoria—così non ripeti gli stessi esperimenti e inizi a consolidare i successi.

Rendere il processo ripetibile: workflow che scalano

Parti da uno stack reale

Trasforma la tua idea in un'app React con backend Go e PostgreSQL, guidato via chat.

La velocità è bella, ma è la coerenza che fa sì che l'iterazione componga valore. L'obiettivo è trasformare “dobbiamo migliorare questo” in una routine che il team può eseguire senza eroi.

Pattern di workflow leggeri

Un loop scalabile non richiede processi pesanti. Alcune piccole abitudini vincono su sistemi complicati:

- Revisione settimanale (30–60 minuti): scegli 1–3 elementi da migliorare, rivedi le modifiche della settimana e decidi cosa testare. Porta riassunti preparati dall'AI (temi, lamentele principali, rischi emergenti) così la riunione resta focalizzata.

- Change log: tieni una nota continua di cosa è cambiato, perché e cosa ti aspetti. Un documento semplice basta; l'importante è la costanza.

- Decision notes: per cambiamenti significativi, cattura la decisione in cinque righe: contesto, opzioni considerate, decisione, owner, data. L'AI può redigerle dalle note di riunione, ma confermi tu il testo.

Template di prompt + checklist riutilizzabili

Tratta i prompt come asset. Salvali in una cartella condivisa e versionali come il resto del lavoro.

Mantieni una piccola libreria:

- Template di prompt per attività ripetute (riassumi feedback, proponi varianti, riscrivi per tono, genera criteri di accettazione).

- Checklist riutilizzabili per la qualità (chiarezza, completezza, conformità, voce del brand, accessibilità). Chiedi all'AI di eseguire la checklist e evidenziare gap, poi un umano verifica.

Una convenzione semplice aiuta: “Task + Audience + Constraints” (es. “Release notes — non tecnico — 120 parole — includi rischi”).

Aggiungi un passo di approvazione umana per output sensibili

Per tutto ciò che tocca fiducia o responsabilità—prezzi, testi legali, indicazioni mediche o finanziarie—usa l'AI per abbozzare e segnalare rischi, ma richiedi un approvatore nominato prima della pubblicazione. Rendi questo passaggio esplicito così non venga saltato per fretta.

Nomi di versione che evitano confusione

L'iterazione rapida crea file disordinati se non li etichetti chiaramente. Usa un pattern prevedibile come:

FeatureOrDoc_Scope_V#_YYYY-MM-DD_Owner

Esempio: OnboardingEmail_NewTrial_V3_2025-12-26_JP.

Quando l'AI genera opzioni, raggruppale sotto la stessa versione (V3A, V3B) così tutti sanno cosa è stato confrontato e cosa è effettivamente stato pubblicato.

Errori comuni, controlli di sicurezza e uso responsabile

L'AI può accelerare l'iterazione, ma può anche accelerare gli errori. Trattala come un compagno potente: utile, veloce e talvolta sicuro di sé in modo eccessivo.

Modalità di fallimento comuni (e come evitarle)

Affidarsi troppo all'AI. I modelli possono produrre testo, riassunti o “insight” plausibili che non corrispondono alla realtà. Abitua il team a verificare tutto ciò che può influire su clienti, budget o decisioni.

Prompt vaghi portano a lavori vaghi. Se l'input è “migliora questo”, otterrai modifiche generiche. Specifica audience, obiettivo, vincoli e cosa significa “migliore” (più breve, più chiaro, on-brand, meno ticket, più conversione, ecc.).

Nessuna metrica, nessun apprendimento. L'iterazione senza misurazione è solo cambiamento. Decidi in anticipo cosa tracciare (activation rate, tempo al primo valore, churn, temi NPS, tasso di errore) e confronta prima/dopo.

Gestione dei dati: proteggi utenti e azienda

Non incollare informazioni personali, clienti o confidenziali in strumenti a meno che l'organizzazione non lo consenta esplicitamente e tu conosca le policy di retention/training.

Regola pratica: condividi il minimo indispensabile.

- Rimuovi nomi, email, telefoni, indirizzi, ID d'ordine e note free-text che possano contenere dettagli sensibili.

- Riassumi internamente, poi chiedi al modello di lavorare dal sommario.

- Se serve analizzare feedback reali, redigi prima e conserva l'originale nel sistema approvato.

Allucinazioni: verifica fatti e fonti

L'AI può inventare numeri, citazioni, dettagli di feature o citazioni utenti. Quando l'accuratezza conta:

- Chiedi le assunzioni e i punti di incertezza (“Su cosa non sei sicuro?”).

- Richiedi fonti primarie solo se puoi verificarle personalmente.

- Controlla rispetto a documenti, analytics, changelog o sistema di supporto.

Checklist "prima di pubblicare"

Prima di pubblicare una modifica assistita dall'AI fai un rapido controllo:

- Obiettivo & metrica definiti (cosa significa successo).

- PII/dati confidenziali rimossi da prompt e log.

- Fatti verificati (claim, numeri, policy, citazioni).

- Casi limite rivisti (accessibilità, tono, note legali/compliance).

- Sign-off umano dal proprietario giusto (PM, support, legal, brand).

- Piano di rollback se la modifica performa peggio.

Così l'AI resta un moltiplicatore del buon giudizio—non un suo sostituto.