03 nov 2025·8 min

Leslie Lamport e i sistemi distribuiti: tempo, ordine, correttezza

Scopri le idee chiave di Lamport sui sistemi distribuiti—orologi logici, ordinamento, consenso e correttezza—e perché guidano ancora l'infrastruttura moderna.

Perché Lamport conta ancora per i sistemi distribuiti moderni

Leslie Lamport è uno di quei rari ricercatori il cui lavoro “teorico” ricompare ogni volta che distribuisci un sistema reale. Se hai mai gestito un cluster di database, una coda di messaggi, un motore di workflow o qualsiasi cosa che riprovi richieste e sopravviva ai guasti, stai affrontando problemi che Lamport ha contribuito a nominare e risolvere.

Ciò che rende le sue idee durature è che non sono legate a una singola tecnologia. Descrivono le verità scomode che emergono ogni volta che più macchine cercano di comportarsi come un unico sistema: gli orologi non concordano, le reti ritardano o perdono messaggi e i guasti sono la normalità, non l'eccezione.

Tre temi che useremo ovunque

Tempo: in un sistema distribuito, “che ora è?” non è una domanda semplice. Gli orologi fisici deragliano e l'ordine con cui osservi gli eventi può differire tra le macchine.

Ordine: quando non puoi fidarti di un unico orologio, servono altri modi per parlare di quali eventi sono avvenuti prima—e quando devi costringere tutti a seguire la stessa sequenza.

Correttezza: “funziona di solito” non è un progetto. Lamport ha spinto il campo verso definizioni nette (safety vs. liveness) e specifiche con cui si può ragionare, non solo testare.

Cosa aspettarsi (niente matematica pesante)

Ci concentreremo su concetti e intuizioni: i problemi, gli strumenti minimi per pensare in modo chiaro e come quegli strumenti plasmano i progetti concreti.

Ecco la mappa:

- Perché l'assenza di un orologio condiviso implica l'assenza di una storia globale unica degli eventi

- Come la causalità ("happened-before") porta agli orologi logici e ai timestamp di Lamport

- Quando l'ordine parziale non basta e serve una sola timeline

- Come consenso e Paxos servono per mettersi d'accordo su un ordine

- Perché la replica della macchina a stati funziona quando l'ordinamento è condiviso

- Come parlare di correttezza nelle specifiche—e come strumenti di modellazione come TLA+ aiutano

Il problema centrale: niente orologio condiviso, niente realtà unica

Un sistema è “distribuito” quando è composto da più macchine che coordinano via rete per svolgere un lavoro. Sembra semplice finché non accetti due fatti: le macchine possono guastarsi in modo indipendente (guasti parziali) e la rete può ritardare, perdere, duplicare o riordinare i messaggi.

In un programma singolo su un computer puoi di solito indicare “cosa è successo prima”. In un sistema distribuito, macchine diverse possono osservare sequenze diverse di eventi—e entrambe possono essere corrette dal loro punto di vista locale.

Perché non ti puoi fidare di un orologio globale

È allettante risolvere il coordinamento timestampando tutto. Ma non esiste un orologio unico su cui fare affidamento tra macchine:

- L'orologio hardware di ogni server deriva a velocità diverse.

- La sincronizzazione degli orologi (come NTP) è best-effort, non una garanzia.

- Virtualizzazione, carico CPU o pause possono far saltare avanti o indietro il tempo.

Quindi “l'evento A è avvenuto alle 10:01:05.123” su un host non si confronta in modo affidabile con “10:01:05.120” su un altro.

Come i ritardi mandano in confusione la realtà

I ritardi di rete possono invertire ciò che pensavi di aver visto. Una scrittura può essere inviata prima ma arrivare dopo. Un retry può arrivare dopo l'originale. Due datacenter possono processare la stessa richiesta in ordini opposti.

Questo rende il debugging particolarmente confuso: i log di macchine diverse possono non concordare, e “ordinato per timestamp” può creare una storia che non è mai realmente accaduta.

Conseguenze concrete

Quando assumi una timeline unica che non esiste, ottieni fallimenti concreti:

- Doppia elaborazione (un pagamento addebitato due volte dopo retry)

- Incoerenze (due utenti che entrambi rivendicano con successo l'ultimo articolo)

- Apparente perdita di dati (un aggiornamento arrivato dopo sovrascrive uno più recente)

L'intuizione chiave di Lamport comincia qui: se non puoi condividere il tempo, devi ragionare sull'ordine in modo diverso.

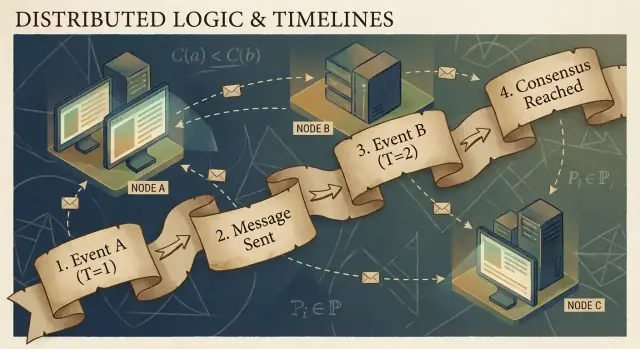

Causalità e la relazione happened-before

I programmi distribuiti sono fatti di eventi: qualcosa che accade in un nodo specifico (un processo, un server o un thread). Esempi includono “ricevuta una richiesta”, “scritta una riga”, o “inviato un messaggio”. Un messaggio è il connettore tra nodi: un evento è il send, un altro è il receive.

L'intuizione di Lamport è che in un sistema senza un orologio condiviso, la cosa più affidabile che puoi tracciare è la causalità—quali eventi potrebbero avere influenzato quali altri eventi.

La relazione happened-before (→)

Lamport definì una regola semplice chiamata happened-before, scritta come A → B (l'evento A è avvenuto prima dell'evento B):

- Ordine nello stesso processo: se A e B avvengono nello stesso processo/macchina, e A è osservato avvenire prima in quel processo, allora A → B.

- Ordine per messaggio: se A è “invia messaggio m” e B è “riceve messaggio m”, allora A → B.

- Transitività: se A → B e B → C, allora A → C.

Questa relazione ti dà un ordine parziale: ti dice che alcune coppie sono ordinate, ma non tutte.

Una storia concreta: utente → richiesta → DB → cache

Un utente clicca “Compra”. Quel clic genera una richiesta a un server API (evento A). Il server scrive una riga d'ordine nel database (evento B). Dopo che la scrittura è completa, il server pubblica un messaggio “order created” (evento C), e un servizio cache lo riceve e aggiorna una voce di cache (evento D).

Qui, A → B → C → D. Anche se gli orologi non concordano, i messaggi e la struttura del programma creano legami causali reali.

Cosa significa davvero “concurrente"

Due eventi sono concorrenti quando nessuno dei due ha causato l'altro: non (A → B) e non (B → A). Concorrenza non significa “stesso istante”—significa “nessun percorso causale li collega”. Per questo due servizi possono entrambi sostenere di aver agito “prima”, e entrambi avere ragione a meno che non si aggiunga una regola di ordinamento.

Orologi logici: i timestamp di Lamport in parole semplici

Se hai mai provato a ricostruire “cosa è successo prima” su più macchine, hai incontrato il problema di base: i computer non condividono un orologio perfettamente sincronizzato. La soluzione di Lamport è smettere di inseguire il tempo perfetto e iniziare a tracciare l'ordine.

L'idea: un contatore associato a ogni evento

Un timestamp di Lamport è semplicemente un numero che alleghi a ogni evento significativo in un processo (un'istanza di servizio, un nodo, un thread—quello che scegli). Pensalo come un “contatore di eventi” che ti dà un modo coerente di dire “questo evento è avvenuto prima di quello”, anche quando il tempo a parete è inaffidabile.

Le due regole (e sono proprio così semplici)

-

Incrementa localmente: prima di registrare un evento (es. “scritto su DB”, “inviata richiesta”, “append log entry”), incrementa il tuo contatore locale.

-

Al ricevimento, fai max + 1: quando ricevi un messaggio che include il timestamp del mittente, imposta il tuo contatore a:

max(local_counter, received_counter) + 1

Poi timbra l'evento di ricezione con quel valore.

Queste regole assicurano che i timestamp rispettino la causalità: se l'evento A poteva aver influenzato l'evento B (perché l'informazione è passata via messaggi), allora il timestamp di A sarà minore di quello di B.

Cosa i timestamp di Lamport possono (e non possono) dirti

Possono dirti dell'ordinamento causale:

- Se

TS(A) < TS(B), A potrebbe essere avvenuto prima di B. - Se A ha causato B (direttamente o indirettamente), allora necessariamente

TS(A) < TS(B).

Non possono dirti il tempo reale:

- Un timestamp più basso non significa “prima in secondi”.

- Due eventi concorrenti (nessuno ha causato l'altro) possono comunque ottenere timestamp diversi per via dei pattern di messaggi.

Quindi i timestamp di Lamport sono ottimi per ordinare, non per misurare latenza o rispondere a “che ora era?”.

Esempio pratico: ordinare le voci di log tra servizi

Immagina che il Servizio A chiami il Servizio B e entrambi scrivano log di audit. Vuoi una vista unificata dei log che rispetti causa ed effetto.

- Il Servizio A incrementa il suo contatore, registra “starting payment”, invia la richiesta a B con timestamp 42.

- Il Servizio B riceve la richiesta con 42, imposta il suo contatore a

max(local, 42) + 1, diciamo 43, e registra “validated card”. - B risponde con 44; A riceve, aggiorna a 45, e registra “payment completed”.

Ora, aggregando i log di entrambi i servizi, ordinare per (lamport_timestamp, service_id) ti dà una timeline stabile e spiegabile che corrisponde alla catena reale di influenza—anche se gli orologi a parete non erano sincronizzati o la rete ha ritardato messaggi.

Dall'ordine parziale all'ordine totale: quando ti serve una sola timeline

La causalità ti dà un ordine parziale: alcuni eventi sono chiaramente “prima” di altri (perché un messaggio o una dipendenza li collega), ma molti eventi sono semplicemente concorrenti. Non è un bug—è la forma naturale della realtà distribuita.

L'ordine parziale basta per molte domande

Se stai facendo debug su “cosa poteva aver influenzato questo?” o imponendo regole come “una risposta deve seguire la sua richiesta”, l'ordine parziale è esattamente ciò che ti serve. Devi solo rispettare gli edge di happened-before; tutto il resto può essere trattato come indipendente.

Ordine totale: obbligatorio quando il sistema deve scegliere una storia unica

Alcuni sistemi non possono accettare “qualsiasi ordine va bene”. Hanno bisogno di una sequenza unica di operazioni, specialmente per:

- Scritture su un oggetto condiviso (“set balance”, “update profile”, “append to log”)

- Comandi che devono essere applicati identicamente ovunque (state machine replication)

- Risoluzione dei conflitti dove “last write wins” deve avere lo stesso significato per ogni nodo

Senza un ordine totale, due repliche potrebbero essere entrambe “corrette” localmente ma divergere globalmente: una applica A poi B, un'altra applica B poi A, e ottieni risultati diversi.

Come ottieni una sola timeline?

Introduci un meccanismo che crea l'ordine:

- Un sequencer/leader che assegna una posizione monotonica a ogni comando.

- Oppure il consenso (es. approcci in stile Paxos) in modo che il cluster si metta d'accordo sulla prossima voce di log anche con ritardi e guasti.

I compromessi impossibili da evitare

Un ordine totale è potente, ma ha un costo:

- Latenza: potresti dover aspettare il coordinamento prima di commettere.

- Throughput: un singolo log ordinato può diventare un collo di bottiglia.

- Disponibilità sotto guasti: se non raggiungi abbastanza nodi per accordarti, il progresso può fermarsi per proteggere la correttezza.

La scelta di progettazione è semplice da enunciare: quando la correttezza richiede una narrazione condivisa, paghi il costo del coordinamento per ottenerla.

Consenso: mettersi d'accordo nonostante ritardi e guasti

Fund your experiments

Ottieni crediti condividendo ciò che costruisci su Koder.ai o invitando colleghi a provare.

Il consenso è il problema di far sì che più macchine concordino su una decisione—un valore da commettere, un leader da seguire, una configurazione da attivare—anche se ogni macchina vede solo i propri eventi locali e i messaggi che le arrivano.

Sembra semplice finché non ricordi cosa può fare un sistema distribuito: i messaggi possono essere ritardati, duplicati, riordinati o persi; le macchine possono crashare e riavviarsi; e raramente ottieni un segnale netto che “questo nodo è definitivamente morto”. Il consenso riguarda rendere l'accordo sicuro in queste condizioni.

Perché l'accordo è complicato

Se due nodi temporaneamente non riescono a parlarsi (partizione di rete), ogni lato può provare ad “andare avanti” da solo. Se entrambi decidono valori diversi, puoi finire con uno split-brain: due leader, due configurazioni diverse o due storie concorrenti.

Anche senza partizioni, il solo ritardo crea problemi. Nel momento in cui un nodo viene a sapere di una proposta, altri potrebbero essere andati avanti. Senza orologio condiviso, non puoi dire in modo affidabile “la proposta A è avvenuta prima della proposta B” solo perché A ha un timestamp più antico—il tempo fisico non è autoritativo qui.

Dove incontri il consenso nei sistemi reali

Potresti non chiamarlo “consenso” tutti i giorni, ma appare in compiti infrastrutturali comuni:

- Elezione del leader (chi è responsabile ora?)

- Log replicati (qual è la prossima voce nella storia condivisa?)

- Cambi di configurazione (quale insieme di nodi può votare/commettere?)

In ogni caso, il sistema ha bisogno di un risultato unico su cui tutti convergano, o almeno una regola che impedisca che risultati contraddittori siano entrambi considerati validi.

Paxos come risposta di Lamport

Paxos di Lamport è una soluzione fondamentale a questo problema di “accordo sicuro”. L'idea chiave non è un timeout magico o un leader perfetto—sono un insieme di regole che garantiscono che solo un valore possa essere scelto, anche quando i messaggi sono in ritardo e i nodi falliscono.

Paxos separa la safety (“non scegliere mai due valori diversi”) dal progress (“alla fine scegliere qualcosa”), rendendolo un modello pratico: puoi ottimizzare le prestazioni reali mantenendo intatta la garanzia di base.

Paxos, senza il mal di testa: l'intuizione chiave sulla safety

Paxos ha la reputazione di essere illeggibile, ma molto di questo deriva dal fatto che “Paxos” non è un singolo algoritmo facile da riassumere. È una famiglia di pattern correlati per far concordare un gruppo, anche quando i messaggi sono in ritardo, duplicati o i macchine falliscono temporaneamente.

Il cast: proponenti, acceptor e quorum

Un modello mentale utile separa chi propone da chi valida.

- Proposer cerca di far scegliere un valore (per esempio: “la prossima voce del log è X”).

- Acceptor vota sulle proposte.

- Un quorum è “sufficienti acceptor” per fare progress—tipicamente una maggioranza.

L'idea strutturale da tenere a mente: due maggioranze qualsiasi si sovrappongono. In quella sovrapposizione vive la safety.

L'obiettivo di safety: non decidere mai due valori diversi

La safety di Paxos è semplice da enunciare: una volta che il sistema decide un valore, non deve mai decidere un altro—niente split-brain.

L'intuizione chiave è che le proposte hanno dei numeri (pensa: ID di ballot). Gli acceptor promettono di ignorare proposte con numero più vecchio dopo averne visto una con numero più nuovo. E quando un proposer tenta con un nuovo numero, prima chiede a un quorum cosa hanno già accettato.

Poiché i quorum si sovrappongono, un nuovo proposer sentirà inevitabilmente da almeno un acceptor che “ricorda” il valore più recentemente accettato. La regola è: se qualcuno nel quorum ha accettato qualcosa, devi proporre quel valore (o il più recente tra essi). Questa costrizione impedisce che due valori diversi vengano scelti.

Liveness, a grandi linee

La liveness significa che il sistema alla fine decide qualcosa in condizioni ragionevoli (per esempio, emerge un leader stabile e la rete alla fine consegna i messaggi). Paxos non promette velocità nel caos; promette correttezza e progresso una volta che le cose si stabilizzano.

Replica della macchina a stati: correttezza tramite ordinamento condiviso

Experiment with consensus

Progetta un servizio di elezione del leader e testa rapidamente i casi di failure con snapshot e rollback.

La state machine replication (SMR) è il pattern di lavoro dietro molti sistemi ad alta disponibilità: invece di lasciare che un singolo server prenda decisioni, esegui più repliche che processano tutte la stessa sequenza di comandi.

L'idea del log replicato

Al centro c'è un log replicato: una lista ordinata di comandi come “put key=K value=V” o “trasferisci $10 da A a B.” I client non inviano comandi a ogni replica sperando per il meglio. Presentano comandi al gruppo, e il sistema si accorda su un ordine per quei comandi; poi ogni replica li applica localmente.

Perché l'ordine ti dà correttezza

Se ogni replica parte dallo stesso stato iniziale ed esegue gli stessi comandi nello stesso ordine, finiranno nello stesso stato. Questa è l'intuizione di safety: non cerchi di mantenere più macchine “sincronizzate” per tempo; le rendi identiche tramite determinismo e ordinamento condiviso.

Questo è il motivo per cui il consenso (come protocolli in stile Paxos/Raft) viene spesso accoppiato con SMR: il consenso decide la prossima voce di log, e SMR trasforma quella decisione in uno stato consistente tra le repliche.

Dove lo vedi nei sistemi reali

- Servizi di coordinamento (es. per configurazione ed elezione del leader)

- Database con write-ahead log replicati

- Sistemi di messaggistica che richiedono un ordinamento rigoroso delle partizioni

Preoccupazioni pratiche che gli ingegneri non possono ignorare

Il log cresce all'infinito a meno che non lo gestisci:

- Snapshot: catturare periodicamente lo stato corrente così i nuovi nodi possono recuperare senza riprodurre tutta la storia.

- Compattazione del log: scartare in sicurezza voci vecchie una volta che sono riflesse in uno snapshot e non sono più necessarie.

- Cambi di membership: aggiungere/rimuovere repliche deve essere ordinato anch'esso, altrimenti nodi diversi potrebbero disaccordarsi su chi fa parte del gruppo, causando split-brain.

SMR non è magia; è un modo disciplinato per trasformare “accordo sull'ordine” in “accordo sullo stato”.

Correttezza: safety, liveness e scrivere una specifica chiara

I sistemi distribuiti falliscono in modi strani: messaggi arrivano tardi, nodi si riavviano, gli orologi non concordano e le reti si separano. “Correttezza” non è un'impressione—è un insieme di promesse che puoi esprimere con precisione e poi verificare in ogni situazione, compresi i guasti.

Safety vs. liveness (con esempi concreti)

Safety significa “non succede nulla di male”. Esempio: in un key-value replicato, non devono mai essere commessi due valori diversi per lo stesso indice di log. Un altro: un servizio di lock non deve mai concedere lo stesso lock a due client contemporaneamente.

Liveness significa “alla fine accade qualcosa di buono”. Esempio: se la maggioranza delle repliche è attiva e la rete consegna i messaggi, una scrittura alla fine si completa. Una richiesta di lock alla fine ottiene un sì o un no (non attesa infinita).

La safety riguarda la prevenzione delle contraddizioni; la liveness riguarda evitare blocchi permanenti.

Invarianti: i tuoi non negoziabili

Un'invariante è una condizione che deve sempre valere, in ogni stato raggiungibile. Per esempio:

- “Ogni indice di log ha al massimo un valore commesso.”

- “Il numero del term di un leader non diminuisce mai.”

Se un'invariante può essere violata durante un crash, timeout, retry o partizione, allora non era realmente applicata.

Cosa significa una prova qui

Una prova è un argomento che copre tutte le esecuzioni possibili, non solo il percorso normale. Si ragiona su ogni caso: perdita, duplicazione e riordino dei messaggi; crash e riavvio dei nodi; leader in competizione; client che ritentano.

Le specifiche prevengono comportamenti inattesi

Una specifica chiara definisce stato, azioni consentite e proprietà richieste. Questo evita requisiti vaghi come “il sistema dovrebbe essere consistente” che si trasformano in aspettative contrastanti. Le specifiche ti costringono a dire cosa succede durante le partizioni, cosa significa “commit” e su cosa i client possono contare—prima che la produzione ti insegni la lezione.

Dalla teoria alla pratica: modellare con TLA+

Una delle lezioni più pratiche di Lamport è che puoi (e spesso dovresti) progettare un protocollo distribuito a un livello più alto del codice. Prima di preoccuparti di thread, RPC e loop di retry, puoi scrivere le regole del sistema: quali azioni sono consentite, quale stato può cambiare e cosa non deve mai succedere.

A cosa serve TLA+

TLA+ è un linguaggio di specifica e uno strumento di model-checking per descrivere sistemi concorrenti e distribuiti. Scrivi un modello semplice e quasi matematico del tuo sistema—stati e transizioni—più le proprietà che ti interessano (per esempio, “al massimo un leader” o “una voce commessa non scompare”).

Poi il model checker esplora possibili interleaving, ritardi dei messaggi e guasti per trovare un controesempio: una sequenza concreta di passi che viola la proprietà. Invece di dibattere casi limite in riunioni, ottieni un argomento eseguibile.

Un bug che un modello può catturare

Considera un passo di “commit” in un log replicato. Nel codice è facile permettere involontariamente a due nodi di segnare due voci diverse come commesse allo stesso indice in uno scenario di tempistiche rare.

Un modello TLA+ può rivelare una traccia come:

- Il nodo A commette l'entry X all'indice 10 dopo aver sentito una maggioranza.

- Il nodo B (con dati obsoleti) forma anche lui una maggioranza e commette l'entry Y all'indice 10.

Quella è una commit duplicata—una violazione di safety che potrebbe apparire solo una volta al mese in produzione ma che emerge rapidamente con ricerca esaustiva. Modelli simili spesso trovano aggiornamenti persi, doppie applicazioni o situazioni di “ack ma non durabile”.

Quando vale la pena modellare

TLA+ è più prezioso per la logica critica di coordinamento: elezione del leader, cambi di membership, flussi simili al consenso e qualsiasi protocollo dove ordinamento e gestione dei guasti interagiscono. Se un bug può corrompere i dati o richiedere un recupero manuale, un piccolo modello è spesso più economico del debugging successivo.

Se stai costruendo tool interni attorno a queste idee, un workflow pratico è scrivere una specifica leggera (anche informale), poi implementare il sistema e generare test dalle invarianti della specifica. Piattaforme come Koder.ai possono aiutare qui accelerando il ciclo build-test: puoi descrivere il comportamento di ordinamento/consenso in linguaggio naturale, iterare sullo scaffolding del servizio (front-end React, backend Go con PostgreSQL, client Flutter) e mantenere visibile “ciò che non deve mai succedere” mentre distribuisci.

Consigli pratici per costruire e gestire sistemi affidabili

Prototype a replicated log

Prototipa un'API per un log replicato con interfaccia React e backend in Go con PostgreSQL.

Il grande regalo di Lamport ai praticanti è una mentalità: tratta tempo e ordinamento come dati da modellare, non come assunzioni ereditate dall'orologio a muro. Quella mentalità diventa un insieme di abitudini che puoi applicare subito.

Trasforma la teoria in pratiche ingegneristiche quotidiane

Se i messaggi possono essere ritardati, duplicati o arrivare fuori ordine, progetta ogni interazione per essere sicura in queste condizioni.

- Idempotenza per impostazione predefinita: rendi il “fai di nuovo” innocuo. Usa idempotency key per pagamenti, provisioning o qualsiasi scrittura che può essere ritentata.

- Retry con deduplicazione: i retry sono necessari, ma senza dedup generi doppie scritture. Traccia gli ID delle richieste e conserva marcatori “già processato”.

- Delivery almeno-una volta + effetti esattamente-una-volta: accetta che la rete possa consegnare due volte; assicurati che i cambi di stato non lo facciano.

Fai attenzione a timeout e orologi

I timeout non sono verità; sono politiche. Un timeout ti dice solo “non ho ricevuto risposta in tempo”, non “l'altra parte non ha agito”. Due implicazioni concrete:

- Non trattare un timeout come un fallimento definitivo. Progetta percorsi di compensazione e riconciliazione.

- Evita di usare l'ora locale per ordinare eventi tra nodi. Usa numeri di sequenza, contatori monotoni o metadati causali espliciti (per esempio, “questo aggiornamento sostituisce la versione X”).

Osservabilità che rispetta la causalità

Buoni strumenti di debugging codificano l'ordinamento, non solo i timestamp.

- Trace ID ovunque: propaga un correlation/trace ID in ogni hop e riga di log.

- Indizi causali nei log: registra ID dei messaggi, parent request ID e “quale versione credevo fosse l'ultima” quando prendi decisioni.

- Replay deterministico: registra gli input (comandi) così puoi riprodurre il comportamento e confermare se un bug è dipendente dalle tempistiche o dalla logica.

Domande di progettazione da porsi prima di spedire

Prima di aggiungere una funzionalità distribuita, richiedi chiarezza con alcune domande:

- Cosa succede se la stessa richiesta viene processata due volte?

- Quale ordinamento ci serve (se ne serve uno) e dove viene applicato?

- Quali guasti sono “sicuri” (nessuno stato scorretto) vs. “rumorosi” (visibili all'utente) vs. “silenti” (corruzione nascosta)?

- Qual è il percorso di recupero dopo un outage parziale o una partizione di rete?

- Cosa registreremo per ricostruire la storia di happened-before in produzione?

Queste domande non richiedono un dottorato—solo la disciplina di trattare ordinamento e correttezza come requisiti di prodotto di primo piano.

Conclusione e passi suggeriti successivi

Il dono duraturo di Lamport è un modo di pensare chiaro quando i sistemi non condividono un orologio e non concordano di default su “cosa è successo”. Invece di inseguire il tempo perfetto, tracci la causalità (ciò che poteva aver influenzato cosa), rappresentala con il tempo logico (timestamp di Lamport) e—quando il prodotto richiede una storia unica—costruisci accordo (consenso) così ogni replica applica la stessa sequenza di decisioni.

Quello filo conduce a una mentalità ingegneristica pratica:

Specifica prima, poi costruisci

Annota le regole che ti servono: cosa non deve mai succedere (safety) e cosa deve succedere alla fine (liveness). Poi implementa in base a quella specifica e testa il sistema sotto ritardi, partizioni, retry, messaggi duplicati e riavvii dei nodi. Molti “outage misteriosi” sono in realtà affermazioni mancanti come “una richiesta può essere processata due volte” o “i leader possono cambiare in qualsiasi momento”.

Impara di più con passi mirati

Se vuoi approfondire senza affogare nella formalità:

- Leggi “Time, Clocks, and the Ordering of Events in a Distributed System” di Lamport per interiorizzare happened-before.

- Sfoglia “Paxos Made Simple” per l'intuizione sulla safety: una volta che un valore è scelto, il progresso futuro non può contraddirlo.

- Guarda una presentazione introduttiva su TLA+, poi modella un piccolo protocollo (un servizio di lock o un registro a due repliche) e verificane la correttezza.

Prova un esercizio pratico

Scegli un componente di cui ti occupi e scrivi un “contratto di fallimento” di una pagina: cosa assumi sulla rete e sullo storage, quali operazioni sono idempotenti e quali garanzie di ordinamento fornisci.

Se vuoi rendere l'esercizio più concreto, costruisci un piccolo servizio “ordering demo”: un'API che appende comandi a un log, un worker in background che li applica e una vista admin che mostra metadati di causalità e retry. Farlo su Koder.ai può accelerare l'iterazione—specialmente se ti servono scaffolding rapidi, deploy/hosting, snapshot/rollback per esperimenti e esportazione del codice quando sei soddisfatto.

Se fatto bene, queste idee riducono gli outage perché meno comportamenti rimangono impliciti. Inoltre semplificano il ragionamento: smetti di discutere sul tempo e inizi a dimostrare cosa significano davvero ordinamento, accordo e correttezza per il tuo sistema.