05 giu 2025·8 min

Come i linguaggi di programmazione rispecchiano le esigenze della loro epoca

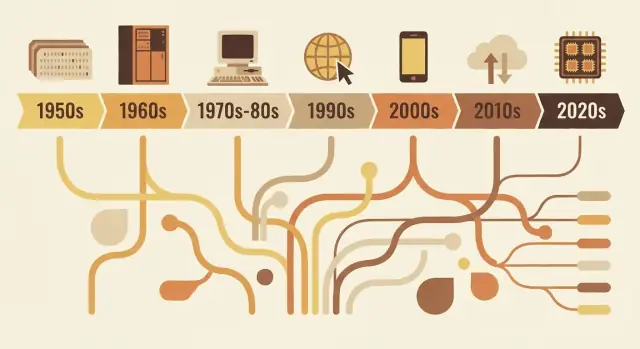

Da FORTRAN a Rust, i linguaggi riflettono le priorità della loro epoca: limiti hardware, sicurezza, web e lavoro di squadra. Scopri come le scelte progettuali rispondono a problemi reali.

Perché i linguaggi sono come li vediamo

I linguaggi di programmazione non sono semplicemente versioni “migliori” o “peggiori” l’uno dell'altro. Sono risposte progettuali ai problemi che le persone dovevano risolvere in un momento particolare dell'informatica.

Cosa comprende davvero la “progettazione del linguaggio”

Quando parliamo di progettazione del linguaggio, intendiamo più della sola forma del codice sulla pagina. Un linguaggio è un insieme di decisioni come:

- Sintassi: come esprimi le idee (parole chiave, punteggiatura, leggibilità)

- Tipi: se i valori hanno categorie dichiarate (e quanto severamente il linguaggio le controlla)

- Modello di memoria: chi gestisce la memoria e quali garanzie di sicurezza esistono

- Modello di esecuzione: compilato vs interpretato, comportamento a runtime, compromessi sulle prestazioni

- Libreria standard + tooling: pacchetti, sistemi di build, debugger, formatter e come i team rilasciano il software

Queste scelte tendono a raggrupparsi attorno ai vincoli dell'epoca: hardware limitato, tempo macchina costoso, mancanza di funzionalità del sistema operativo o (più tardi) team enormi, reti globali e minacce alla sicurezza.

L'idea centrale

I linguaggi rispecchiano il loro tempo. I primi linguaggi privilegiavano il massimo rendimento da macchine scarse. Quelli successivi puntarono sulla portabilità, perché il software doveva girare su molti sistemi. Con la crescita dei progetti, i linguaggi si orientarono a struttura, astrazione e strumenti per mantenere grandi codebase comprensibili. Più di recente, concorrenza, distribuzione cloud e pressioni sulla sicurezza hanno spostato i compromessi.

Questo articolo si concentra su esempi rappresentativi—non è una cronologia completa anno per anno. Vedrai come alcuni linguaggi influenti incarnano i bisogni del loro periodo e come le idee vengano riciclate e affinate.

Perché conta oggi nella scelta degli strumenti

Capire il “perché” dietro un linguaggio ti aiuta a prevederne punti di forza e limiti. Chiarisce domande come: questo linguaggio è ottimizzato per prestazioni strette, iterazione rapida, manutenzione in team numerosi o sicurezza? Quando decidi cosa imparare o cosa usare per un progetto, quel contesto è pratico quanto qualsiasi checklist di funzionalità.

I vincoli dell'informatica iniziale che hanno modellato tutto

I primi linguaggi di programmazione nacquero meno per gusto e più per fisica e bilanci dei costi. Le macchine avevano pochissima memoria, lo storage era scarso e le CPU erano lente rispetto agli standard moderni. Questo obbligava a compromessi continui: ogni caratteristica in più, ogni istruzione più lunga e ogni livello di astrazione avevano un costo reale.

Memoria ridotta, cicli costosi

Se hai spazio solo per un piccolo programma e un piccolo dataset, progetti linguaggi e strumenti che mantengono i programmi compatti e prevedibili. I sistemi iniziali spingevano i programmatori verso flussi di controllo semplici e supporto runtime minimale. Anche caratteristiche “belle da avere”—come stringhe ricche, gestione dinamica della memoria o strutture dati di alto livello—erano spesso impraticabili perché richiedevano codice e gestione aggiuntivi.

Elaborazione batch e feedback lenta

Molti programmi venivano eseguiti in batch. Preparavi un job (spesso tramite schede perforate), lo inviavi e aspettavi. Se qualcosa andava storto, potevi scoprire l'errore molto più tardi—dopo che il job era terminato o fallito.

Quel ciclo di feedback lungo cambiava le priorità:

- I programmi dovevano funzionare correttamente alla prima esecuzione, perché ripetere costava caro.

- Il debugging era più lento, quindi gli sviluppatori si affidavano a pianificazione accurata e convenzioni.

- Tooling e esplorazione interattiva non erano l'esperienza predefinita.

Perché la leggibilità e i messaggi d'errore non erano primari

Quando il tempo macchina era prezioso e le interfacce limitate, i linguaggi non privilegiavano diagnosi amichevoli o chiarezza per i principianti. I messaggi d'errore dovevano spesso essere brevi, talvolta criptici, e mirati ad aiutare un operatore a localizzare un problema in una pila di schede o in una riga di output stampato.

Scienza e matematica hanno guidato le prime caratteristiche

Gran parte della domanda iniziale proveniva da lavoro scientifico e ingegneristico: calcoli, simulazioni e metodi numerici. Per questo le prime caratteristiche del linguaggio si concentravano su operazioni aritmetiche efficienti, array e modi di esprimere formule che mappassero bene sull'hardware e sul modo in cui gli scienziati lavoravano su carta.

FORTRAN, COBOL e linguaggi costruiti per compiti specifici

Alcuni primi linguaggi non cercavano di essere universali. Erano progettati per risolvere bene una classe ristretta di problemi—perché i computer erano costosi, il tempo era scarso e “abbastanza buono per tutto” significava spesso “ottimo per nulla”.

FORTRAN: calcoli numerici, velocità e il carico di lavoro dello scienziato

FORTRAN (FORmula TRANslation) era rivolto all'informatica ingegneristica e scientifica. La sua promessa centrale era pratica: permettere alle persone di scrivere programmi ricchi di matematica senza codificare ogni dettaglio in assembly.

Quell'obiettivo ha modellato il suo design. Puntava su operazioni numeriche e calcoli su array, e spingeva molto sulle prestazioni. L'innovazione reale non fu solo la sintassi, ma l'idea che un compilatore potesse generare codice macchina abbastanza efficiente da essere affidabile per gli scienziati. Quando il tuo lavoro principale sono simulazioni o tabelle balistiche, risparmiare tempo di esecuzione è la differenza tra risultati oggi o la settimana prossima.

COBOL: dati aziendali, leggibilità e reportistica

COBOL mirava a un universo diverso: governi, banche, assicurazioni, paghe e inventario. Questi sono problemi di “record e report”—dati strutturati, flussi di lavoro prevedibili e molta verifica.

Così COBOL privilegiò uno stile verboso e vicino all'inglese che rendeva i programmi più facili da rivedere e mantenere in grandi organizzazioni. Le definizioni dei dati erano una preoccupazione di primo piano, perché il software aziendale vive e muore in base a quanto bene modella maschere, conti e transazioni.

Cosa significa davvero “vicino al dominio”

Entrambi i linguaggi mostrano un principio progettuale ancora valido: il vocabolario dovrebbe riflettere il lavoro.

FORTRAN parla il linguaggio della matematica e del calcolo. COBOL parla in record e procedure. La loro popolarità rivela le priorità del tempo: non sperimentazione astratta, ma portare a termine carichi di lavoro reali—che significava calcolo numerico veloce o gestione chiara dei dati aziendali.

L'era dei sistemi: portabilità e controllo (C, Unix)

Verso la fine degli anni '60 e negli anni '70, i computer diventavano più economici e diffusi—ma restavano molto diversi l'uno dall'altro. Se scrivevi software per una macchina, portarlo su un'altra spesso significava riscrivere grandi porzioni a mano.

Il dolore dell'assembly spinse i linguaggi più in alto

Molto software importante era scritto in assembly, che dava massime prestazioni e controllo, ma a caro prezzo: ogni CPU aveva il suo set di istruzioni, il codice era difficile da leggere e anche piccole modifiche potevano richiedere giorni di lavoro accurato. Quello creò domanda per un linguaggio che fosse ancora “vicino all'hardware”, ma non ti intrappolasse su un singolo processore.

L'obiettivo di C: codice di sistema portabile

C emerse come compromesso pratico. Fu progettato per scrivere sistemi operativi e strumenti—specialmente Unix—pur rimanendo portabile tra hardware. C offriva agli sviluppatori:

- Un insieme di funzionalità semplice e compatto compilabile su molte macchine

- Accesso diretto alla memoria tramite puntatori

- La possibilità di scrivere codice a basso livello senza tornare all'assembly per ogni dettaglio

La riscrittura di Unix in C è il punto di svolta famoso: il sistema operativo poteva viaggiare su nuovo hardware molto più facilmente di un sistema scritto solo in assembly.

Perché la gestione manuale della memoria era accettabile

C si aspettava che gestissi la memoria da solo (allocarla, liberarla, evitare errori). Oggi sembra rischioso, ma allora rispondeva alle priorità dell'epoca. Le macchine avevano risorse limitate, i sistemi operativi richiedevano prestazioni prevedibili e i programmatori lavoravano spesso vicino all'hardware—talvolta conoscendo esattamente la disposizione della memoria che volevano.

Il compromesso duraturo

C ottimizzava per velocità e controllo, e lo ha fatto. Il prezzo fu la sicurezza e la facilità d'uso: overflow di buffer, crash e bug sottili diventarono rischi normali. In quell'epoca, quei rischi erano spesso considerati un costo accettabile per portabilità e prestazioni.

Rendere i programmi grandi manutenibili: struttura e tipi

Quando i programmi passarono da semplici utility monouso a prodotti che gestivano attività aziendali, un nuovo problema dominò: non solo “funziona?” ma “riusciamo a mantenerlo funzionante per anni?” Il codice iniziale spesso evolveva per tentativi con patch e salti tramite goto, producendo “spaghetti code” difficile da leggere, testare o modificare in sicurezza.

Cosa cercava di risolvere la programmazione strutturata

La programmazione strutturata promosse un'idea semplice: il codice dovrebbe avere una forma chiara. Invece di saltare a linee arbitrarie, gli sviluppatori usarono blocchi ben definiti—if/else, while, for e switch—per rendere il flusso di controllo prevedibile.

Quella prevedibilità importava perché il debugging è in gran parte rispondere a “come ci siamo arrivati qui?” Quando il flusso è visibile nella struttura, meno bug si nascondono nelle pieghe.

L'ascesa dei team e delle codebase durature

Quando il software divenne attività di team, la manutenibilità divenne un problema sociale oltre che tecnico. I nuovi membri dovevano capire codice che non avevano scritto. I manager avevano bisogno di stime per le modifiche. Le aziende dovevano avere fiducia che aggiornamenti non rompessero tutto.

I linguaggi risposero incoraggiando convenzioni che scalano oltre la memoria di una singola persona: confini di funzione coerenti, durate delle variabili più chiare e modi per organizzare il codice in file e librerie separati.

Perché tipi, moduli e scope acquisirono valore

I tipi divennero più importanti perché fungono da “documentazione incorporata” e dal rilevamento precoce degli errori. Se una funzione si aspetta un numero ma riceve testo, un sistema di tipi forte può catturarlo prima che raggiunga gli utenti.

Moduli e scope aiutavano a limitare la raggio di impatto delle modifiche. Mantenendo dettagli privati ed esponendo solo interfacce stabili, i team potevano rifattorizzare internamente senza riscrivere tutto.

Mosse di design che favorirono la composizione

Miglioramenti comuni includevano:

- Funzioni più piccole e ben nominate che fanno un solo lavoro

- Scoping lessicale per evitare interazioni accidentali tra variabili

- Migliori pattern di composizione (passare funzioni/dati in modo pulito invece di fare affidamento su stato globale)

Insieme, questi cambiamenti spostarono i linguaggi verso codice più facile da leggere, revisionare e far evolvere in sicurezza.

Oggetti e enterprise: perché l'OOP è diventato mainstream

Dal build al deploy

Distribuisci e ospita la tua app senza creare una pipeline separata.

La programmazione orientata agli oggetti (OOP) non “vinse” perché fosse l'unica buona idea—vinse perché rifletteva ciò che molti team stavano cercando di costruire: software aziendale duraturo mantenuto da molte persone.

Cosa prometteva l'OOP

L'OOP offriva una narrazione ordinata per la complessità: rappresentare il programma come un insieme di “oggetti” con responsabilità chiare.

L'incapsulamento (nascondere i dettagli interni) sembrava un modo pratico per prevenire rotture accidentali. Ereditarietà e polimorfismo promettevano riuso: scrivi una versione generale una volta, specializzala poi e inserisci implementazioni diverse nella stessa interfaccia.

Perché GUI e applicazioni aziendali l'hanno favorita

Con la diffusione del software desktop e delle interfacce grafiche, gli sviluppatori avevano bisogno di modi per gestire molti componenti interattivi: finestre, pulsanti, documenti, menu ed eventi. Pensare in termini di oggetti e messaggi si mappava bene a queste parti.

Allo stesso tempo, i sistemi enterprise crescevano attorno a domini come banche, assicurazioni, inventario e HR. Questi ambienti valorizzavano coerenza, collaborazione di team e codebase che potessero evolvere per anni. L'OOP si adattava a un bisogno organizzativo: dividere il lavoro in moduli di proprietà di team diversi, imporre confini e standardizzare come si aggiungono funzionalità.

Dove ha aiutato—e dove ha creato problemi

L'OOP è efficace quando crea confini stabili e componenti riutilizzabili. Diventa dolorosa quando gli sviluppatori sovramodellano tutto, creando gerarchie di classi profonde, “oggetti dio” o pattern usati più per moda che per necessità. Troppe astrazioni possono trasformare una semplice modifica in una burocrazia.

Influenza duratura

Anche linguaggi non “puri OOP” hanno preso in prestito i suoi concetti: strutture simili a classi, interfacce, modificatori di accesso e design pattern. Gran parte della sintassi moderna riflette ancora questo periodo focalizzato sull'organizzazione di grandi team attorno a grandi codebase.

L'era di Java: portabilità, sicurezza e scala enterprise

Java è cresciuto insieme a un tipo specifico di boom software: grandi sistemi aziendali duraturi distribuiti su un mix eterogeneo di server, sistemi operativi e hardware vendor. Le aziende volevano deploy prevedibili, meno crash e team che potessero crescere senza riscrivere tutto ogni pochi anni.

Cosa risolse la JVM: portabilità con un runtime gestito

Invece di compilare direttamente alle istruzioni di una macchina, Java compila in bytecode che gira sulla Java Virtual Machine (JVM). La JVM divenne lo “strato standard” di cui le imprese potevano fidarsi: distribuisci lo stesso artefatto applicativo e falla girare su Windows, Linux o grandi Unix con cambiamenti minimi.

Questo è il cuore del “write once, run anywhere”: non una garanzia di assenza di differenze di piattaforma, ma un modo pratico per ridurre costi e rischi di supportare molti ambienti.

Default di sicurezza che ridussero i guasti in produzione

Java rese la sicurezza una caratteristica primaria piuttosto che una disciplina opzionale.

La garbage collection eliminò una categoria di bug di memoria (puntatori dangling, double-free) comuni negli ambienti non gestiti. I controlli sui limiti degli array aiutarono a prevenire letture o scritture fuori struttura. Unito a un sistema di tipi più restrittivo, tutto questo mirava a trasformare guasti catastrofici in eccezioni prevedibili—più facili da riprodurre, loggare e correggere.

Perché si adattò alla realtà enterprise

Le imprese valorizzavano stabilità, tooling e governance: processi di build standardizzati, forte supporto IDE, librerie estese e un runtime che potesse essere monitorato e gestito. La JVM abilitò anche un ecosistema ricco di application server e framework che resero lo sviluppo in team numerosi più coerente.

I compromessi: overhead, tuning, complessità

I benefici di Java non erano gratuiti. Un runtime gestito aggiunge tempo di avvio e overhead di memoria, e la garbage collection può creare picchi di latenza se non ottimizzata. Col tempo, l'ecosistema accumulò complessità—livelli di framework, configurazioni e modelli di deploy—che richiedevano competenze specializzate.

Tuttavia, per molte organizzazioni il compromesso valeva: meno fallimenti a basso livello, deploy cross-platform più semplici e un runtime condiviso che cresceva con le dimensioni del business e del codice.

Linguaggi di scripting e la spinta alla produttività

Itera senza paura

Salva il progresso con snapshot e torna indietro in sicurezza quando sperimenti.

A fine anni '90 e anni 2000, molti team non scrivevano sistemi operativi—collegavano database, costruivano siti web e automatizzavano flussi interni. Il collo di bottiglia si spostò dall'efficienza della CPU al tempo degli sviluppatori. Feedback più rapidi e cicli di rilascio corti resero la domanda “quanto velocemente possiamo cambiare questo?” una priorità centrale.

Perché l'iterazione rapida divenne prioritaria

Le app web si evolvono in giorni, non anni. Le aziende volevano nuove pagine, nuovi report, nuove integrazioni e correzioni rapide senza un lungo ciclo di compilazione-deploy. I linguaggi di scripting si adattavano a quel ritmo: modifica un file, eseguilo, vedi il risultato.

Questo cambiò anche chi poteva costruire software. Amministratori di sistema, analisti e piccoli team potevano rilasciare strumenti utili senza conoscenze profonde di gestione della memoria o sistemi di build.

Tipizzazione dinamica ed ecosistemi “batterie incluse”

Linguaggi come Python e Ruby puntarono sulla tipizzazione dinamica: puoi esprimere un'idea con meno dichiarazioni e meno cerimonie. Unita a librerie standard ricche, questa caratteristica rese molte attività comuni “a un import di distanza”:

- elaborazione di testo e gestione file

- HTTP, email e networking di base

- accesso a database e formati dati (CSV, JSON, XML)

Questo approccio “batterie incluse” premiava la sperimentazione e permetteva a script di automazione di trasformarsi naturalmente in applicazioni reali.

Python, Ruby e PHP come risposte pratiche

Python divenne la scelta per automazione e programmazione generale, Ruby accelerò lo sviluppo web (soprattutto tramite framework) e PHP dominò il web server-side iniziale perché era facile da integrare direttamente nelle pagine e da distribuire ovunque.

I compromessi: velocità, errori a runtime, pratiche di scaling

Le stesse caratteristiche che rendevano produttivi i linguaggi di scripting introdussero costi:

- esecuzione più lenta rispetto ai linguaggi compilati

- più errori scoperti a runtime

- lo scaling richiedeva disciplina: testing, code review, linter e convenzioni

In altre parole, i linguaggi di scripting ottimizzavano il cambiamento. I team impararono a “ricomprare” affidabilità con strumenti e pratiche—preparando il terreno per ecosistemi moderni dove velocità di sviluppo e qualità del software sono entrambe attese.

JavaScript e il boom guidato dal browser

Il browser web è diventato un “computer” distribuito a milioni di persone. Ma non era una tela vuota: era una sandbox, girava su hardware imprevedibile e doveva rimanere reattivo mentre disegnava schermi e attendeva reti. Quell'ambiente ha modellato il ruolo di JavaScript più di qualsiasi idea astratta di linguaggio perfetto.

Una piattaforma con vincoli particolari

I browser richiedevano codice che fosse consegnabile istantaneamente, eseguibile in sicurezza vicino a contenuti non fidati e capace di mantenere la pagina interattiva. Questo spinse JavaScript verso avvio rapido, comportamento dinamico e API strettamente legate alla pagina: click, input, timer e poi richieste di rete.

Perché “ovunque” batté “perfetto”

JavaScript vinse principalmente perché era già presente. Se volevi comportamento nel browser, JavaScript era l'opzione di default—nessun passaggio di installazione, nessun permesso, nessun runtime separato da convincere gli utenti a scaricare. Idee concorrenti potevano sembrare più pulite sulla carta, ma non uguagliavano il vantaggio di distribuzione di “gira su ogni sito”.

Event-driven per necessità

Il browser è fondamentalmente reattivo: gli utenti cliccano, le pagine scorrono, le richieste tornano quando tornano. Lo stile event-driven di JavaScript (callback, eventi, promise) rispecchia quella realtà. Invece di un programma che va dall'inizio alla fine, gran parte del codice web è “aspetta qualcosa, poi rispondi”, che si adatta naturalmente a UI e I/O di rete.

Effetti a lungo termine: ecosistemi e compatibilità

Il successo ha creato un pozzo gravitazionale. Si sono formati enormi ecosistemi attorno a framework e librerie, e la pipeline di build è diventata una categoria di prodotto: transpiler, bundler, minifier e package manager. Allo stesso tempo, la promessa del web di compatibilità retroattiva ha fatto sì che decisioni passate restassero—così il JavaScript moderno spesso sembra strati di nuovi strumenti costruiti per convivere con i vincoli di ieri.

Concorrenza e la realtà multicore

Per molto tempo, avere un computer più veloce significava semplicemente che il tuo programma girava più in fretta senza cambiare una riga di codice. Quel patto si ruppe quando i chip raggiunsero limiti di calore e potenza e cominciarono ad aggiungere core invece che aumentare la frequenza. Improvvisamente, ottenere più prestazioni spesso richiedeva fare più cose contemporaneamente.

Perché il multicore ha reso la concorrenza inevitabile

Le app moderne raramente svolgono un singolo compito isolato. Gestiscono molte richieste, parlano con database, renderizzano UI, elaborano file e aspettano reti—tutto mentre gli utenti si aspettano risposte istantanee. L'hardware multicore rese possibile il lavoro parallelo, ma rese anche doloroso quando un linguaggio o runtime presumeva “un thread principale, un flusso”.

Cosa hanno aggiunto i linguaggi per aiutare

La concorrenza iniziale si basava su thread OS e lock. Molti linguaggi li esponevano direttamente, il che funzionava—ma scaricava la complessità sugli sviluppatori quotidiani.

I design più recenti cercano di rendere i pattern comuni più semplici:

- Thread con primitive più sicure: mutex migliori, pool di thread e modelli di memoria più chiari.

- async/await: un modo per scrivere codice non bloccante che però legge come logica passo-passo.

- Canali e passaggio di messaggi: “condividi dato comunicando” (ispirato a CSP) per ridurre bug legati allo stato condiviso.

Server e sistemi distribuiti hanno cambiato i default

Con il passaggio a servizi always-on, il programma “normale” è diventato un server che gestisce migliaia di richieste concorrenti. I linguaggi hanno iniziato a ottimizzare per workload I/O-intensive, timeout/cancellazioni e prestazioni prevedibili sotto carico.

Insidie che i linguaggi cercano di prevenire

I guasti di concorrenza sono spesso rari e difficili da riprodurre. Il design dei linguaggi mira sempre più a prevenire:

- Race condition (due task che aggiornano gli stessi dati in modo imprevedibile)

- Deadlock (task in attesa reciproca infinita)

- Starvation (alcuni lavori non ricevono mai CPU)

Lo spostamento importante: la concorrenza ha smesso di essere un argomento avanzato ed è diventata un'aspettativa di base.

Priorità moderne: sicurezza, semplicità e tooling (Go, Rust)

Ricevi ricompense per i referral

Invita colleghi o amici e guadagna crediti quando iniziano a usare Koder.ai.

Negli anni 2010, molti team non avevano più problemi a esprimere algoritmi—avevano problemi a mantenere servizi sicuri, stabili e facili da cambiare sotto continue pressioni di deploy. Due problemi risaltavano: bug di sicurezza dovuti a errori di memoria e attrito ingegneristico causato da stack troppo complessi e tooling incoerente.

Risolvere i bug che si ripetono

Una larga parte delle vulnerabilità ad alta gravità ancora deriva da problemi di sicurezza della memoria: buffer overflow, use-after-free e comportamenti indefiniti che emergono solo in certe build o macchine. Il design moderno dei linguaggi tratta questi come “armi automatiche” inaccettabili, non solo errori dei programmatori.

Rust è la risposta più chiara. Le sue regole di ownership e borrowing sono essenzialmente un patto: scrivi codice che soddisfa controlli severi a compile-time e in cambio ottieni forti garanzie di sicurezza della memoria senza garbage collector. Questo rende Rust attraente per codice di sistema che storicamente era in C/C++—servizi di rete, componenti embedded e librerie critiche per le prestazioni—dove sicurezza e velocità contano entrambe.

Semplicità e servizi come workload predefinito

Go prende una direzione quasi opposta: limitare le caratteristiche del linguaggio per mantenere le codebase leggibili e prevedibili in team numerosi. Il suo design riflette un mondo di servizi long-running, API e infrastruttura cloud.

La libreria standard e le primitive di concorrenza integrate (goroutine, channel) supportano direttamente lo sviluppo di servizi, mentre il compilatore veloce e la storia di dipendenze semplice riducono l'attrito quotidiano.

L'esperienza sviluppatore diventa una caratteristica

Il tooling è passato dall'essere un opzionale a far parte della promessa del linguaggio. Go ha normalizzato questa mentalità con gofmt e una cultura forte di formattazione standard. Rust ha seguito con rustfmt, clippy e un tool di build ben integrato (cargo).

Nell'ambiente di oggi, che spinge al continuo deploy, questa storia di tooling si estende oltre compilatori e linter a workflow di più alto livello: pianificazione, scaffolding e cicli di iterazione più rapidi. Piattaforme come Koder.ai riflettono questo spostamento permettendo ai team di costruire applicazioni web, backend e mobile tramite un'interfaccia chat—poi esportare il codice sorgente, distribuire e tornare a versioni precedenti con snapshot quando serve. È un altro esempio del medesimo schema storico: gli strumenti che si diffondono più velocemente sono quelli che rendono il lavoro comune dell'epoca più economico e meno soggetto a errori.

Quando formatter, linter e sistemi di build sono di prima classe, i team spendono meno tempo a discutere lo stile o a combattere ambienti incoerenti e più tempo a rilasciare software affidabile.

Cosa suggeriscono i problemi di oggi sui linguaggi di domani

I linguaggi non “vincono” perché sono perfetti. Vincono quando rendono il lavoro più comune del momento più economico, sicuro o veloce—soprattutto se accompagnati dalle librerie e dalle abitudini di deploy giuste.

AI, lavoro sui dati e il potere degli ecosistemi

Un grande motivo dell'attuale popolarità di alcuni linguaggi è dove si trova il lavoro: pipeline di dati, analytics, machine learning e automazione. Per questo Python continua a crescere—non solo per la sintassi, ma per l'ecosistema: NumPy/Pandas per i dati, PyTorch/TensorFlow per ML, notebook per l'esplorazione e una grande comunità che produce componenti riutilizzabili.

SQL è l'esempio più silenzioso dello stesso effetto. Non è di moda, ma resta l'interfaccia di default ai dati aziendali perché si adatta al compito: query dichiarative, ottimizzatori prevedibili e ampia compatibilità tra strumenti e vendor. I nuovi linguaggi spesso finiscono per integrare SQL piuttosto che sostituirlo.

Nel frattempo, l'AI ad alte prestazioni spinge avanti il tooling orientato alla GPU. Vediamo più attenzione a prima classe su vettorizzazione, batching e accelerazione hardware—sia attraverso ecosistemi CUDA, MLIR e catene di compilatori, sia tramite linguaggi che semplificano il binding a questi runtime.

Cosa potrebbe modellare i progetti futuri dei linguaggi

Diversi fattori probabilmente influenzeranno i linguaggi della “prossima era” o gli aggiornamenti maggiori:

- Verifica e correttezza: sistemi di tipi più forti, concorrenza più sicura e strumenti che dimostrano proprietà invece di limitarsi ai test.

- Privacy e policy: miglior supporto per governance dei dati, auditabilità e vincoli su dati sensibili.

- Uso dell'energia ed efficienza: linguaggi e runtime che rendono più facile scrivere codice veloce senza micromanagement manuale.

Conclusione pratica

Quando scegli un linguaggio, abbinalo ai tuoi vincoli: esperienza del team, bacino di assunzione, librerie di cui dipenderai, target di deploy e requisiti di affidabilità. Un linguaggio “buono” spesso è quello che rende le tue attività più frequenti noiose—e i tuoi errori più facili da prevenire e diagnosticare.

Se ti serve un ecosistema basato su framework, scegli per l'ecosistema; se cerchi correttezza e controllo, scegli per sicurezza e prestazioni. Per una checklist di decisione più approfondita, vedi /blog/how-to-choose-a-programming-language.