Cosa significa “il modello software del PC” — e perché contava

Il “modello software del PC” non era un singolo prodotto o un trucco di licenza intelligente. Era un modo ripetibile in cui un intero mercato funzionava: come gli sviluppatori costruivano il software, come lo spedivano agli utenti e come ci guadagnavano.

Sembra banale, finché non si ricorda quanto fosse insolito all'inizio dell'informatica personale. I primi computer venivano spesso venduti come sistemi chiusi con hardware proprietario, ambienti operativi su misura e percorsi poco chiari per sviluppatori terzi. L'era del PC ha cambiato questo trasformando il software in qualcosa che poteva scalare oltre una singola macchina — o una sola azienda.

Una definizione in parole semplici del “modello software”

In termini pratici, un modello software è l'insieme di assunzioni che rispondono a:

- Per quale target sto costruendo? (una base stabile di OS e hardware)

- Come lo costruisco in modo efficiente? (strumenti, linguaggi, documentazione)

- Come raggiungo i clienti e ricevo pagamento? (distribuzione e termini commerciali)

Quando queste risposte sono prevedibili, gli sviluppatori investono. Quando non lo sono, esitano.

I tre pilastri che si rafforzavano a vicenda

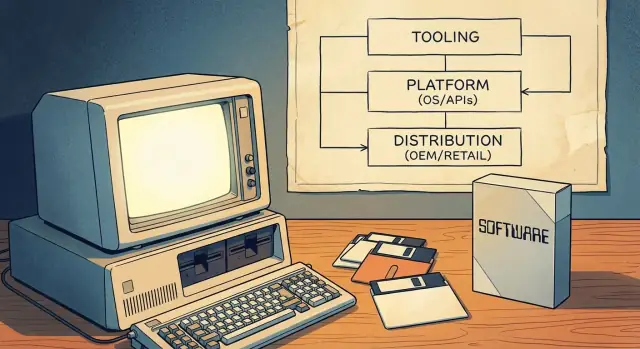

Il modello software del PC funzionava perché legava insieme tre pilastri in un volano:

- Strumenti di sviluppo: linguaggi accessibili, compilatori, IDE ed esempi che abbassavano il costo di avvio.

- Superficie di piattaforma: API e SDK coerenti che permettevano al software di terzi di integrarsi con l'OS (e con altre app).

- Canali go‑to‑market: modi chiari di distribuire — tramite preinstallazione OEM, retail e, più tardi, shareware — così il software poteva davvero diventare un'attività.

Insieme, questi elementi hanno reso il PC un “posto” affidabile in cui costruire. Quell'affidabilità ha trasformato l'informatica personale in un ecosistema di sviluppatori mainstream — non solo una scena da hobbisti.

Prima dei PC di massa: target frammentati e portata limitata

Prima dei PC di massa, “computing” significava spesso mainframe e minicomputer posseduti da governi, università e grandi aziende. L'accesso era scarso, costoso e mediato dai dipartimenti IT. Se eri sviluppatore, scrivevi software per una specifica organizzazione — non per un mercato pubblico ampio.

Molte macchine, molte incompatibilità

Esistevano computer personali e per hobbisti, ma non formavano un mercato affidabile unico. L'hardware variava molto (famiglie di CPU, formati disco, grafica, periferiche) e gli sistemi operativi erano incoerenti o proprietari. Un programma che girava su una macchina spesso richiedeva una riscrittura per funzionare su un'altra.

Quella frammentazione ha modellato l'economia del software:

- Il software veniva spesso fornito in bundle con l'hardware o consegnato come parte di un acquisto più grande.

- Molto era costruito su misura per il flusso di lavoro di un singolo cliente.

- I vendor legavano strettamente le app alle proprie macchine per proteggere le vendite hardware.

La portata limitata significava incentivi limitati

Poiché il pubblico indirizzabile per una singola configurazione era piccolo, gli sviluppatori indipendenti avevano difficoltà a giustificare tempo e costi necessari per costruire prodotti rifiniti e ampiamente supportati. Anche la distribuzione era limitata: potevi spedire nastri o dischi direttamente a un cliente, contare sui gruppi di utenti o condividere codice informalmente. Niente di tutto questo somigliava a un business scalabile.

Cosa cambiò quando i PC divennero mainstream

Quando i PC divennero prodotti di consumo e d'ufficio comuni, il valore si spostò da installazioni one‑off a vendite di software ripetibili. L'idea chiave fu un target standard: una combinazione prevedibile di aspettative hardware, convenzioni di sistema operativo e percorsi di distribuzione su cui gli sviluppatori potevano scommettere.

Una volta raggiunta una massa critica di acquirenti e macchine compatibili, scrivere software divenne meno “Girerà anche altrove?” e più “Quanto velocemente raggiungiamo tutti quelli che usano questo standard?”.

Prima gli strumenti: i linguaggi come porta d'ingresso per gli sviluppatori

Prima che Microsoft diventasse sinonimo di sistemi operativi, era fortemente identificata con i linguaggi di programmazione — in particolare BASIC. Questa scelta non fu casuale. Se vuoi un ecosistema, prima servono persone che sappiano costruire cose, e i linguaggi sono la via di ingresso a più bassa frizione.

BASIC come “kit di partenza”

I primi microcomputer spesso includevano BASIC in ROM, e le versioni Microsoft divennero un punto di riferimento su molte macchine. Per uno studente, un hobbista o una piccola impresa era semplice: accendi la macchina, ottieni un prompt, scrivi codice, vedi il risultato. Quell'immediatezza contava più dell'eleganza. Faceva sembrare la programmazione un uso normale del computer, non una professione specializzata.

Accessibilità che amplia il bacino di creatori

Concentrandosi su strumenti accessibili, Microsoft contribuì ad allargare il funnel degli sviluppatori potenziali. Più persone che scrivevano piccoli programmi significavano più esperimenti, più app locali e più domanda per strumenti migliori. È un esempio precoce di come la mindshare degli sviluppatori agisca come interesse composto: una generazione che impara su un linguaggio e suoi strumenti tende a continuare a costruire — e comprare — all'interno di quell'orbita.

Coerenza tra le macchine costruisce fiducia

L'era dei microcomputer era frammentata, ma Microsoft portava idee coerenti da piattaforma a piattaforma: sintassi simile, aspettative simili sugli strumenti e la crescente sensazione che “se riesci a programmare qui, probabilmente puoi programmare lì”. Quella prevedibilità ridusse il rischio percepito nell'imparare a programmare.

La lezione strategica è semplice: le piattaforme non iniziano con mercati o monetizzazione. Iniziano con strumenti che rendono possibile la creazione — e poi guadagnano fedeltà rendendo quell'esperienza ripetibile.

MS‑DOS e la standardizzazione del target PC

Un grande sblocco nell'informatica personale fu l'idea di un “layer OS standard”: invece di scrivere una versione separata della tua app per ogni combinazione hardware, potevi mirare a un'interfaccia comune. Per gli sviluppatori, ciò significava meno porting, meno chiamate di supporto e una strada più chiara per spedire qualcosa che funzionasse per molti clienti.

Un solo posto dove puntare il tuo software

MS‑DOS si posizionava tra le applicazioni e la variegata varietà dell'hardware PC. Rimanevano diverse schede grafiche, stampanti, controller disco e configurazioni di memoria — ma MS‑DOS forniva una baseline condivisa per accesso ai file, caricamento dei programmi e interazione di base con i dispositivi. Quel livello comune trasformò “il PC” in un mercato indirizzabile unico anziché in una collezione di macchine quasi‑compatibili.

Cosa significava la “compatibilità” nella pratica

Per i clienti, compatibilità significava fiducia: se un programma diceva che girava su MS‑DOS (e, per estensione, su PC compatibili IBM), era più probabile che funzionasse anche sulla loro macchina. Per gli sviluppatori, significava comportamento prevedibile — chiamate di sistema documentate, un modello di esecuzione stabile e convenzioni su come installare e avviare i programmi.

Quella prevedibilità rendeva razionale investire in rifiniture, documentazione e aggiornamenti continui, perché il pubblico non era limitato agli utenti di un solo vendor hardware.

Il compromesso centrale: progresso vs conservazione

La standardizzazione creò anche un vincolo: mantenere la compatibilità con il software vecchio divenne una priorità. Questa pressione verso la retrocompatibilità può rallentare cambiamenti importanti, perché rompere programmi popolari mina la fiducia nella piattaforma. Il vantaggio è una libreria di software in crescita; lo svantaggio è una corsia più stretta per innovazioni radicali a livello di OS senza piani di transizione attenti.

Put platform theory into practice

Applica il ciclo tooling + target + distribution al tuo prossimo prodotto.

Windows non si limitò a stare “sopra” MS‑DOS — cambiò ciò che gli sviluppatori potevano assumere sulla macchina. Invece che ogni programma inventasse il proprio modo di disegnare schermate, gestire input e parlare con le periferiche, Windows offrì un modello UI condiviso e un insieme crescente di servizi di sistema.

Cosa ha aggiunto Windows oltre a DOS

Il cambiamento principale fu l'interfaccia grafica: finestre, menu, dialoghi e font che avevano aspetto e comportamento coerenti tra le app. Questo era importante perché la coerenza abbassava il costo di “reinventare le basi”. Gli sviluppatori potevano dedicare tempo alle funzionalità rilevanti per gli utenti, non a costruire un altro toolkit UI.

Windows ampliò anche i servizi comuni che erano dolorosi nell'era DOS:

- Un modo standard per lavorare con file e cartelle

- Stampa tramite driver condivisi e dialoghi di stampa

- Supporto di rete che non richiedeva l'approccio personalizzato di ogni vendor

Convenzioni GUI e componenti condivisi

Le convenzioni Windows — come scorciatoie da tastiera standard, layout di dialogo e controlli comuni (pulsanti, liste, caselle di testo) — riducevano lo sforzo di sviluppo e la formazione degli utenti contemporaneamente. I componenti condivisi significavano meno soluzioni su misura e meno sorprese di compatibilità quando l'hardware cambiava.

Versioni, compatibilità e pianificazione

Con l'evoluzione di Windows, gli sviluppatori dovevano scegliere: supportare versioni più vecchie per raggiungere più utenti, o adottare API più recenti per funzionalità migliori. Quella pianificazione ha modellato roadmap, test e marketing.

Col tempo, strumenti, documentazione, librerie di terze parti e aspettative degli utenti iniziarono a concentrarsi su Windows come target di default — non solo come sistema operativo, ma come piattaforma con norme e slancio.

Esperienza sviluppatore: IDE, compilatori, documentazione ed esempi

Una piattaforma non sembra “reale” agli sviluppatori finché non è facile pubblicare software su di essa. Nell'era PC, quella facilità fu determinata più dall'esperienza quotidiana di scrivere, costruire, fare debug e impacchettare programmi che dal marketing.

Gli strumenti sono moltiplicatori di produttività

Compilatori, linker, debugger e sistemi di build fissano il ritmo di un ecosistema. Quando i tempi di compilazione diminuiscono, i messaggi di errore migliorano e il debug diventa affidabile, gli sviluppatori possono iterare più velocemente — e l'iterazione è ciò che trasforma un'idea mezza funzionante in un prodotto.

Gli IDE hanno spinto oltre questo concetto raggruppando editing, build, debug e gestione del progetto in un unico flusso di lavoro. Un buon IDE riduce il “lavoro di colla” che altrimenti consumerebbe ore: impostare i percorsi di include, gestire le librerie, mantenere build coerenti e rintracciare crash a runtime.

Rischio più basso per team piccoli

Strumenti migliori non sono solo “belli da avere” — cambiano l'economia per i team piccoli. Se uno o due sviluppatori possono costruire e testare con fiducia, possono affrontare progetti che altrimenti richiederebbero uno staff più grande. Questo abbassa i costi, accorcia i tempi e rende meno rischioso per una piccola ISV scommettere su un nuovo prodotto.

Documentazione e esempi spesso battono le feature

Documentazione ed esempi eseguibili funzionano come un secondo prodotto: insegnano il modello mentale, mostrano le best practice e prevengono errori comuni. Molti sviluppatori non adottano un'API perché è potente — la adottano perché esiste un esempio chiaro che funziona dal primo giorno.

Gli strumenti plasmano ciò che sembra “facile” (e quindi “standard”)

I vendor di strumenti influenzano quali modelli di programmazione prevalgono rendendo alcuni percorsi senza attrito. Se template, wizard, librerie e viste di debug spingono verso un approccio particolare, quell'approccio diventa il default — non perché sia teoricamente superiore, ma perché è più veloce da imparare e più sicuro da spedire.

API e SDK: rendere il software di terzi possibile su scala

Un sistema operativo non è automaticamente una “piattaforma”. Lo diventa quando gli sviluppatori esterni possono costruirci sopra in modo prevedibile. È qui che API e SDK hanno contato nell'era PC.

Un'API è fondamentalmente un menu di funzionalità che un'app può usare: disegnare una finestra, stampare un documento, salvare un file, parlare con l'hardware, riprodurre suoni. Invece che ogni sviluppatore inventi il proprio modo di fare queste cose, la piattaforma offre blocchi condivisi.

Uno SDK è il pacchetto che rende quei blocchi utilizzabili: librerie, header, strumenti, documentazione e codice d'esempio che mostrano come ordinare dal menu.

Gli sviluppatori sostengono costi reali quando costruiscono software: tempo, assunzioni, supporto, marketing e aggiornamenti continui. API stabili riducono il rischio che un aggiornamento rompa funzioni core.

Quando le regole restano coerenti — i dialoghi di file si comportano allo stesso modo, la stampa funziona allo stesso modo, i controlli di finestra seguono lo stesso pattern — le aziende terze possono pianificare roadmap pluriennali. Questa prevedibilità è una grande ragione per cui il modello sviluppatori di Windows ha attratto ISV seri invece di soli hobbisti.

I programmi per sviluppatori creano un ciclo di feedback

I team di piattaforma non si limitano a pubblicare API; coltivano l'adozione. Programmi per sviluppatori, documentazione iniziale, beta e release preview permettono ai produttori di software di testare la compatibilità prima del lancio completo.

Questo crea un ciclo: gli sviluppatori trovano casi limite, la piattaforma li corregge e la prossima ondata di app viene rilasciata con meno sorprese. Col tempo, questo migliora la qualità per gli utenti e riduce i costi di supporto per tutti.

I rischi: rotture, segnali contrastanti, frammentazione

Le API possono anche diventare un peso. I breaking changes costringono a riscritture costose. Linee guida incoerenti (convenzionali UI diverse tra app di sistema) fanno sembrare le app di terzi “sbagliate” anche quando funzionano. E la frammentazione — API multiple sovrapposte per lo stesso compito — divide l'attenzione e rallenta lo slancio dell'ecosistema.

Su larga scala, la strategia di piattaforma migliore è spesso noiosa: promesse chiare, deprecazione attenta e documentazione aggiornata.

Canali di distribuzione: accordi OEM, scaffali retail e shareware

Pick a stable target stack

Usa uno stack coerente per app pronti alla produzione: React, Go, PostgreSQL e Flutter.

Una piattaforma non è solo API e strumenti — è anche come il software raggiunge le persone. Nell'era PC, la distribuzione decideva quali prodotti diventavano “predefiniti”, quali trovavano un pubblico e quali sparivano silenziosamente.

Accordi OEM: il potere di essere già presenti

Quando i produttori di PC preinstallavano software (o lo bundlavano nella scatola), modellavano le aspettative degli utenti. Se un foglio di calcolo, un word processor o un runtime arrivava con la macchina, non era solo comodo — diventava il punto di partenza. Le partnership OEM riducevano anche l'attrito per gli acquirenti: nessuna visita in negozio, nessun dubbio sulla compatibilità.

Per gli sviluppatori, le relazioni OEM offrivano qualcosa di ancora più prezioso del marketing: volume prevedibile. Spedire con una linea hardware popolare poteva significare vendite costanti e prevedibili — fondamentale per team che dovevano finanziare supporto, aggiornamenti e documentazione.

Scaffali retail e cataloghi: la visibilità come caratteristica

Le confezioni software in negozio, i cataloghi mail‑order e poi i grandi store creavano una “competizione per lo spazio sugli scaffali”. Packaging, riconoscibilità del marchio e budget di distribuzione contavano. Un prodotto migliore poteva perdere contro uno più visibile.

Questa visibilità generava un ciclo: forti vendite giustificavano più presenza sugli scaffali, che generava altre vendite. Gli sviluppatori impararono che il canale non è neutrale — premia prodotti che possono scalare promozione e supporto.

Shareware: un motore di distribuzione dal basso

Lo shareware (spesso distribuito su dischi attraverso gruppi di utenti, riviste e BBS) abbassava la barriera d'ingresso per i nuovi arrivanti. Gli utenti potevano provare il software prima di pagare, e piccoli sviluppatori potevano raggiungere nicchie senza accordi retail.

Il filo comune tra tutti questi canali era portata e prevedibilità. Quando gli sviluppatori possono contare su come i clienti scopriranno, proveranno e pagheranno il software, possono pianificare staff, prezzi, aggiornamenti e scommesse di prodotto a lungo termine.

L'economia che attirò sviluppatori mainstream e ISV

Una grande ragione per cui l'era PC attirò sviluppatori mainstream non fu solo la possibilità tecnica — fu l'economia prevedibile. Il “modello software del PC” rese più semplice prevedere ricavi, finanziare miglioramenti continui e costruire attività attorno al software piuttosto che ai servizi.

Prezzi, licenze e cicli di upgrade

Il prezzo del software confezionato (e più tardi la licenza per postazioni) creava aspettative di ricavo chiare: vendi una copia, guadagni margine, ripeti. Gli upgrade periodici a pagamento contavano perché trasformavano la "manutenzione" in un modello di business — gli sviluppatori potevano pianificare nuove versioni ogni 12–24 mesi, allineare il marketing ai rilasci e giustificare gli investimenti in supporto e documentazione.

Per i team piccoli, questo era enorme: non serviva un contratto personalizzato per ogni cliente. Un prodotto poteva scalare.

La base installata decide cosa viene costruito

Una volta che una piattaforma raggiungeva una grande base installata, cambiava quali app valeva la pena sviluppare. Software verticali di nicchia (contabilità per dentisti, gestione inventario per officine), piccole utility e giochi divennero sostenibili perché una piccola percentuale di un grande mercato poteva comunque essere un business.

Gli sviluppatori cominciarono anche a ottimizzare per prodotti adatti alla distribuzione: cose che demoavano bene, tenevano spazio sugli scaffali e risolvevano rapidamente un problema specifico.

Compatibilità, costi di supporto e realtà delle piccole imprese

I compratori aziendali davano valore alla stabilità più che alla novità. La compatibilità con file, stampanti e workflow esistenti riduceva le chiamate di supporto — spesso il costo nascosto più grande per i vendor di software PC. Le piattaforme che mantenevano le vecchie app funzionanti riducevano il rischio sia per i clienti sia per gli sviluppatori.

Cosa significava essere un ISV

Un ISV era una società il cui prodotto dipendeva dalla piattaforma di qualcun altro. Il compromesso era semplice: ottenevi portata e leva distributiva, ma vivevi secondo le regole della piattaforma, i cambi di versione e le aspettative di supporto dettate dall'ecosistema.

Effetti di rete e il ciclo di feedback dell'adozione

Ship without the glue work

Vai da build funzionante a deployment live senza dover incollare strumenti.

Gli effetti di rete sono semplici: quando una piattaforma ha più utenti, è più facile per gli sviluppatori giustificare la costruzione di app per essa. E quando ha più app, diventa più preziosa per gli utenti. Quel ciclo è il modo in cui piattaforme “abbastanza buone” diventano default.

Perché si affermano i default (anche con alternative)

Nell'era PC, la scelta di dove costruire non riguardava solo l'eleganza tecnica. Riguardava raggiungere il mercato indirizzabile più grande con la minore frizione. Una volta che MS‑DOS e poi Windows divennero il target comune, gli sviluppatori potevano spedire un prodotto e aspettarsi che funzionasse per una grande quota di clienti.

Gli utenti seguivano il software che desideravano — fogli di calcolo, word processor, giochi — e le aziende seguivano il bacino di talenti. Col tempo, la piattaforma con il catalogo più profondo sembrava più sicura: migliore reclutamento, più materiali di formazione, più integrazioni di terze parti e meno incertezze “funzionerà?”.

Standard che rafforzavano il ciclo

Gli effetti di rete non riguardavano solo il numero di app. Gli standard stringevano il ciclo:

- Formati di file che permettevano di condividere documenti senza conversioni.

- Periferiche e driver che “funzionavano” su molte macchine.

- API comuni che riducevano il costo di supportare stampanti, grafica e rete.

Ogni standard riduceva i costi di switching per gli utenti — e i costi di supporto per gli sviluppatori — rendendo la scelta di default ancora più stabile.

Quando il modello può fallire

Il volano si rompe quando gli sviluppatori non riescono a avere successo:

- Strumenti scadenti, documentazione confusa o API instabili.

- Distribuzione debole (i clienti non trovano o non installano facilmente le app).

- Frammentazione che richiede build multiple per dispositivi simili.

Una piattaforma può avere utenti, ma senza una via affidabile per gli sviluppatori per costruire, spedire e farsi pagare, l'ecosistema si blocca — e il ciclo si inverte.

Il modello software del PC ha creato grandi vantaggi per chi stabiliva l'ambiente “predefinito” — ma non ha mai significato controllo totale. L'ascesa di Microsoft avvenne in un mercato competitivo e talvolta instabile dove altre aziende potevano (e hanno) cambiare le regole.

Concorrenza che teneva il terreno in movimento

Apple offriva un'alternativa integrata: meno combinazioni hardware, un'esperienza utente più controllata e una storia per gli sviluppatori diversa. Dall'altra parte, l'ecosistema “IBM‑compatible” non era tanto un singolo concorrente quanto una coalizione vasta di produttori di clone, fornitori di chip e publisher di software — ognuno dei quali poteva spostare standard o potere contrattuale.

Anche all'interno dell'orbita IBM la direzione della piattaforma era contesa. OS/2 fu un serio tentativo di definire il prossimo ambiente mainstream per PC, e il suo destino mostrò quanto sia difficile migrare sviluppatori quando il target esistente (MS‑DOS, poi Windows) ha già slancio.

Più tardi, l'era del browser ha introdotto un nuovo layer di piattaforma sopra l'OS, ricontestualizzando la competizione attorno ai default, alla distribuzione e al runtime su cui gli sviluppatori potevano contare.

Lo scrutinio antitrust — senza entrare nei dettagli legali — evidenzia una tensione ricorrente delle piattaforme: le stesse mosse che semplificano la vita per gli utenti (feature in bundle, software preinstallato, impostazioni di default) possono restringere le scelte reali per sviluppatori e rivali.

Quando un componente bundle diventa il default, gli sviluppatori spesso seguono la base installata piuttosto che l'"opzione migliore". Questo può accelerare la standardizzazione, ma anche escludere alternative e ridurre la sperimentazione.

Un takeaway equilibrato

Le strategie di crescita della piattaforma creano responsabilità di ecosistema. Se trai profitto dall'essere il predefinito, stai anche plasmando la struttura delle opportunità di mercato — chi può raggiungere gli utenti, cosa viene finanziato e quanto è facile costruire qualcosa di nuovo. Più chiare e trasparenti sono le regole della piattaforma, più duratura sarà la fiducia degli sviluppatori che la sostiene.