Definisci obiettivi e il significato di copertura dell'automazione

Prima di costruire qualsiasi cosa, scrivi cosa significa “copertura dell'automazione” nella tua organizzazione. Altrimenti il cruscotto diventa un insieme di numeri scollegati che team diversi interpretano in modo diverso.

Cosa conta come copertura dell'automazione?

Inizia scegliendo le unità che misurerai. Opzioni comuni includono:

- Processi aziendali o operativi (es. “onboarding nuovo cliente”): la copertura significa “passaggi automatizzati vs manuali”.

- Test (unitari/integrati/e2e): la copertura indica “quali flussi critici sono verificati automaticamente”.

- Job e runbook (attività pianificate, playbook per incidenti): la copertura significa “quanto lavoro può girare senza intervento umano”.

- Script e bot (script one-off, RPA, tool interni): la copertura indica “attività ripetibili gestite con intervento umano minimo”.

Scegli una definizione primaria per la v1, quindi annota i tipi secondari che potresti aggiungere dopo. Sii esplicito sui casi limite, come i passaggi “semi-automatizzati” che richiedono ancora approvazioni.

Chi userà l'app e quali domande devono poter rispondere?

Pubblico diverso si pone domande diverse:

- Engineering / QA: Quali aree sono sotto-automatizzate? Cosa è cambiato questa settimana? Dove sono le automazioni instabili?

- Ops / Support: Quali workflow dipendono ancora da persone? Cosa si rompe più spesso?

- Leadership: Stiamo riducendo il rischio e il lavoro manuale nel tempo? Quali team necessitano investimenti?

Scrivi 5–10 “domande principali” e trattale come requisiti di prodotto.

Risultati, ambito e criteri di successo

Definisci i risultati primari: visibilità (cosa esiste), prioritizzazione (cosa automatizzare dopo), responsabilità (chi ne è il proprietario) e monitoraggio delle tendenze (sta migliorando?).

Stabilisci confini chiari per la v1. Esempi: “Non valuteremo ancora la qualità”, “Non misureremo il tempo risparmiato”, o “Includeremo solo test basati su CI, non script locali.”

Infine, decidi cosa significa successo: adozione coerente (utenti attivi settimanali), alta freschezza dei dati (aggiornamenti entro 24 ore), meno zone cieche (copertura mappata per tutti i sistemi critici) e follow-through misurabile (proprietari assegnati e gap che si riducono mese dopo mese).

Mappa le fonti dati e le opzioni di ingestione

Prima di poter misurare la copertura dell'automazione, devi sapere dove risiede effettivamente la “prova” dell'automazione. Nella maggior parte delle organizzazioni l'automazione è sparsa tra strumenti adottati in momenti diversi e da team diversi.

Fai l'inventario delle tue fonti di automazione

Inizia con un inventario pragmatico che risponde: Quali segnali provano che un'attività è automatizzata e dove possiamo recuperarli?

Le fonti tipiche includono pipeline CI (job di build/test), framework di test (risultati unit/integration/E2E), strumenti di workflow (approvazioni, deploy, transizioni di ticket), runbook (script e procedure documentate) e piattaforme RPA. Per ogni fonte, cattura l'identificatore su cui puoi fare join in seguito (repo, nome servizio, environment, team) e la “prova” che salverai (esecuzione job, report suite di test, regola di automazione, esecuzione script).

Identifica i sistemi di record

Poi, elenca i tuoi sistemi di record che definiscono cosa “dovrebbe esistere”: hosting dei repo, tracker delle issue e CMDB/catalogo servizi. Queste fonti solitamente forniscono l'elenco autorevole di servizi, proprietari e criticità—essenziali per calcolare la copertura invece di contare solo l'attività.

Scegli i metodi di ingestione

Abbina ogni fonte al metodo di ingestione meno fragile:

- Polling API per tool con buone API ma supporto webhook limitato.

- Webhooks quando hai bisogno di aggiornamenti quasi real-time (es. eventi di completamento pipeline).

- Import schedulati per esportazioni CSV o data warehouse.

- Inserimento manuale per coprire gap (con etichettatura chiara), specialmente per runbook o automazioni legacy.

Documenta vincoli e affidabilità

Registra rate limit, metodi di autenticazione (PAT, OAuth, service account), finestre di retention e problemi noti di qualità dei dati (servizi rinominati, naming incoerente, proprietari mancanti).

Infine, pianifica un punteggio di affidabilità della fonte per ogni connettore (e opzionalmente per ogni metrica) così gli utenti possono vedere se un numero è “alta confidenza” o “sforzo migliore”. Questo evita una falsa precisione e aiuta a dare priorità ai miglioramenti dei connettori in seguito.

Progetta un modello dati per copertura, evidenza e ownership

Un cruscotto di copertura utile parte da un modello dati che separa ciò che intendi automatizzare da ciò che è effettivamente eseguito di recente. Se mescoli questi aspetti, i numeri possono sembrare buoni anche quando l'automazione è obsoleta.

Entità core (tienile poche, ma esplicite)

Inizia con questi blocchi costitutivi:

- Application/Service: l'area di prodotto su cui riporti (spesso mappa a un repo o a una voce del catalogo servizi).

- Process: il workflow aziendale o engineering che vuoi automatizzare (es. “Deploy in staging”, “Riconciliazione fatture”).

- Requirement: un obiettivo che dovrebbe essere coperto (passo di processo, controllo, caso di test o item di checklist).

- Automation Asset: l'elemento che dichiara copertura (workflow CI, script, bot, suite di test).

- Run (evidenza): una singola esecuzione con stato, log/URL e environment.

- Owner: persona/team responsabile del requisito o dell'asset.

Decidi granularità presto

Scegli un livello di report primario e mantienilo:

- per servizio (buono per rollup a livello leadership)

- per processo o passo di processo (migliore come verità operativa)

- per suite di test (adatto per organizzazioni guidate dalla QA)

- per environment (prod vs staging spesso cambia la storia)

Puoi supportare più viste in seguito, ma la prima versione dovrebbe avere un unico livello di verità.

Identificatori stabili (evita che i rename rompano la storia)

Usa ID che sopravvivono ai refactor:

- repo + path file (per workflow/script)

- CI job/workflow ID (se stabile)

- ID personalizzati memorizzati in un manifest (meglio quando gli strumenti variano)

Tratta i nomi di visualizzazione come editabili, non come identificatori.

Modella le relazioni: target, claim e evidenza

Un pattern pratico:

- Requirement è il target.

- CoverageClaim collega un Requirement ↔ Automation Asset (la asserzione di copertura).

- Run si collega a un Automation Asset (la prova).

Questo ti permette di rispondere a: “Cosa dovrebbe essere coperto?”, “Cosa dichiara di coprirlo?” e “Cosa è realmente stato eseguito?”.

Timestamp di freschezza che guidano la fiducia

Cattura:

last_seen_at (l'asset esiste ancora)last_run_at, last_failure_atlast_reviewed_at (qualcuno ha confermato che il claim è valido)

I campi di freschezza rendono semplice evidenziare elementi “coperti ma obsoleti” senza discussioni infinite.

Definisci metriche di copertura e regole di scoring

Se la tua metrica di copertura è vaga, ogni grafico diventa fonte di discussione. Inizia scegliendo una metrica principale per i sommari esecutivi, poi aggiungi breakdown di supporto per i team.

Scegli la metrica da ottimizzare

La maggior parte delle organizzazioni sceglie una di queste:

- % automatizzato per conteggio: più facile da spiegare (es. “120 di 200 task”). Buono quando i task sono simili.

- % automatizzato per sforzo ponderato: meglio quando alcuni elementi sono molto più grandi. Pondera per ore stimate o complessità.

- % automatizzato per rischio: focalizza l'attenzione su ciò che può fare più danno (impatto cliente, compliance, outage).

Puoi mostrare tutte e tre, ma rendi esplicito quale è il numero “headline”.

Definisci cosa significa “automatizzato”

Scrivi regole esplicite così i team possono segnare gli elementi in modo coerente:

- Automatizzato: esegue end-to-end senza passaggi manuali e produce un output verificabile.

- Parzialmente automatizzato: l'automazione esiste ma richiede ancora approvazioni manuali, preparazione dati manuale o correzioni frequenti.

- Manuale: nessuna automazione, o script esistono ma non sono eseguibili in modo affidabile.

Mantieni regole misurabili. Se due persone non riescono a valutare lo stesso elemento nello stesso modo, affina la definizione.

Aggiungi pesi semplici (mantieni le scale noiose)

Usa scale di piccoli interi (1–5) per input come rischio, impatto business, frequenza di esecuzione e tempo risparmiato. Esempio: weight = risk + impact + frequency.

Previeni il gaming con requisiti di evidenza

Non contare un elemento come “automatizzato” a meno che non abbia evidenza, ad esempio:

- almeno N esecuzioni riuscite negli ultimi 30 giorni

- un job CI collegato, log di esecuzione, o un ticket che provi l'esecuzione

Questo trasforma la copertura da claim auto-dichiarato a segnale osservabile.

Documenta le assunzioni

Metti le regole di scoring e esempi in una pagina condivisa (interna) e linkala dal cruscotto. L'interpretazione coerente è ciò che rende affidabili le tendenze.

Scegli un'architettura adatta all'uso interno

Un'app di copertura interna dovrebbe essere “noiosa” nel senso migliore: facile da gestire, semplice da modificare e chiara su da dove provengono i numeri. Una forma semplice “API + database + cruscotto” di solito batte un sistema distribuito finché non serve davvero.

Parti con uno stack semplice

Scegli uno stack che il tuo team già supporta. Un baseline comune è:

- Backend: un'API web singola (es. Node/Express, Python/FastAPI, Ruby on Rails)

- Database: Postgres per le entità principali

- Frontend: un dashboard leggero (React/Vue) che legge dall'API

Se vuoi muoverti più velocemente sulla prima versione interna, un approccio vibe-coding può funzionare: per esempio, Koder.ai può aiutare a generare una dashboard React più un backend Go + PostgreSQL da una specifica strutturata, poi lasciar iterare il team via chat mantenendo esportazione completa del codice e deployment convenzionale.

Componenti core di cui avrai veramente bisogno

Anche in un sistema “semplice”, separa responsabilità:

- Worker di ingestione: estraggono dati da CI, ticket, repo o tool di test e scrivono record normalizzati

- API: serve metriche di copertura, liste drill-down e viste per ownership

- UI: dashboard, filtri e pagine di dettaglio per team e servizi

- Auth: SSO + accesso basato sui ruoli per chi può vedere/modificare mapping

- Job in background: ricalcolo schedulato, deduping, backfill

- Notifiche: avvisi, digest settimanali e messaggi “azione richiesta”

Adattamento del database: relazionale + trend

Usa tabelle relazionali per entità canoniche (team, servizi, automazioni, evidenze, owner). Per i trend (esecuzioni nel tempo, copertura per settimane), tieni:

- Una tabella time-series dedicata in Postgres (partizionata per data), oppure

- Un store time-series separato solo se il volume di query lo richiede

Pianifica la separazione multi-team

Se più team condividono l'app, aggiungi campi org_id/team_id espliciti presto. Questo abilita permessi e evita migrazioni dolorose quando la leadership chiede “un cruscotto unico, ma segmentato”.

Esegui dev/staging/prod e definisci come i dati si muovono:

- Usa schemi simili alla produzione ovunque

- In staging, ingerisci da scope limitati o dataset sintetici

- Promuovi il codice via CI; evita edit manuali delle mappature in produzione (preferisci cambi auditati via UI)

Per approfondire l'usabilità della UI, vedi design-dashboard-ux.

Autenticazione, ruoli e basi di sicurezza

Mantieni il controllo completo del codice

Esporta il codice sorgente completo così puoi fare revisioni, audit e CI come fai già.

Un cruscotto di copertura diventa rapidamente fonte di verità, quindi il controllo accessi e la gestione dei dati contano tanto quanto i grafici. Parti semplice, ma progetta in modo che la sicurezza possa irrigidirsi senza riscritture importanti.

Sign-in: SSO prima, proxy se ti serve velocità

Se l'azienda ha già SSO, integralo fin dal giorno uno (OIDC è spesso il più semplice; SAML è comune nelle realtà più grandi). Se serve un lancio rapido, puoi iniziare dietro un auth proxy interno che inietta header di identità e poi passare a SSO nativo più avanti.

Normalizza l'identità in una chiave utente stabile (l'email può cambiare). Conserva un profilo minimo utente e recupera membership di gruppo/team quando possibile.

Ruoli e permessi che rispecchiano il modo di lavorare

Definisci un set piccolo di ruoli e mantieni l'autorizzazione coerente su UI e API:

- Viewer: può leggere cruscotti e approfondire evidenze.

- Editor: può proporre o applicare cambi metadata (ownership, tag) e inviare correzioni.

- Admin: può gestire integrazioni, regole di scoring e impostazioni globali.

- Service owner (scope-based): può aggiornare claim e workflow solo per i servizi di cui è proprietario.

Preferisci permessi basati sullo scope (team/servizio) rispetto ai “super user”. Riduce il rischio e evita colli di bottiglia.

Gestisci con cura evidenze sensibili

La prova di copertura spesso include link a log CI, ticket incidenti o documenti interni. Restringi l'accesso a quegli URL e ai log grezzi. Conserva solo ciò che ti serve per la verifica (es. build ID, timestamp e un breve sommario di stato) piuttosto che copiare interi log nel database.

Audit e retention

Qualsiasi modifica manuale ai claim di copertura o ai metadata dovrebbe creare un record di audit: chi ha cambiato cosa, quando e perché (motivo testuale). Infine, definisci una policy di retention per la cronologia delle esecuzioni e delle evidenze—decidi per quanto tempo conservarle e implementa cancellazioni sicure così i record vecchi possono essere rimossi senza rompere i calcoli di copertura correnti.

Progetta la UX del dashboard per chiarezza e drill-down

Un cruscotto di copertura funziona quando qualcuno può rispondere a tre domande in meno di un minuto: Come stiamo andando? Cosa è cambiato? Cosa dobbiamo correggere dopo? Progetta la UX attorno a queste decisioni, non attorno alle fonti dati.

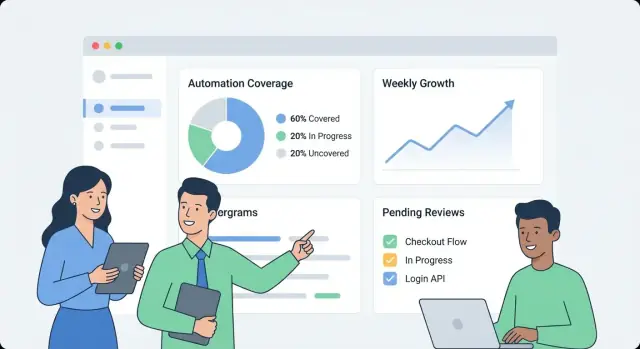

Parti con una “status board” di alto livello

Rendi la prima schermata una panoramica semplice:

- Copertura complessiva dell'automazione (un numero headline) con tooltip di definizione breve (“% di processi con almeno una run verificata negli ultimi X giorni”).

- Trend nel tempo (ultimi 30/90 giorni) così i team vedono se la copertura migliora o peggiora.

- Freschezza (quanto recentemente è stata osservata l'evidenza). Un segnale obsoleto dovrebbe essere distinto visivamente da una run fallita.

- Top gap: una breve lista delle aree maggiormente scoperte o obsolete, ordinate per impatto (es. criticità × volume).

Mantieni le etichette in linguaggio semplice (“Automatizzato di recente” è meglio di “Recency evidence”), ed evita di costringere i lettori a interpretare stati tecnici.

Fai sembrare il drill-down una narrazione

Da ogni metrica di overview, permetti agli utenti di cliccare su una pagina servizio/processo che risponde “cosa” e “con cosa”:

- Cosa è automatizzato (quali step/capacità) e cosa non lo è.

- Con quale asset (script, workflow, job CI, bot RPA), inclusi ultimo run e ultimo risultato.

- Una timeline compatta o la cronologia di run per mostrare se i failure sono one-off o ricorrenti.

Progetta ogni riga/card per includere il “perché dietro il numero”: link all'evidenza, owner, stato dell'ultimo run e una chiara prossima azione (“Re-run job”, “Assegna owner”, “Aggiungi evidenza mancante”).

Filtri che rispecchiano domande reali

Offri filtri che mappano al modo in cui l'organizzazione lavora:

- Team, environment (prod/staging), criticità, intervallo temporale e sistema sorgente.

Mantieni lo stato dei filtri visibile e condivisibile (parametri URL), così qualcuno può inviare un link come “Prod + Tier-1 + ultimi 14 giorni” a uno stakeholder.

Aiuta i non tecnici senza ingombrare

Usa definizioni inline, non documentazione lunga:

- Tooltip per le metriche e brevi callout come “La copertura esclude i controlli manuali.”

- Semantica di colori coerente (es. verde = verificato, giallo = obsoleto, rosso = fallito), con icone/testo per accessibilità.

- Un “Scopri cosa significa” che punti alla spiegazione interna docs/coverage-metrics.

Implementa integrazioni e normalizzazione dei dati

Ottieni uno starter React + Go

Genera un'interfaccia React con backend in Go e PostgreSQL che puoi estendere come una normale applicazione.

Le integrazioni sono dove l'app di copertura diventa reale. L'obiettivo non è replicare ogni feature di CI o tool di test—è estrarre un set coerente di fatti: cosa è stato eseguito, quando, cosa ha coperto e chi ne è il proprietario.

Inizia con i sistemi che già producono segnali di automazione: CI (GitHub Actions, GitLab CI, Jenkins), runner di test (JUnit, pytest) e tool di qualità (report di coverage, linter, scan di sicurezza).

Un connettore dovrebbe prelevare (o ricevere via webhook) il payload minimo:

- identificatori pipeline/build e stati

- nomi suite di test, risultati singoli test (opzionale) e conteggio pass/fail

- timestamp di run, durata e environment (es. staging/prod)

- repository, branch e commit SHA

Mantieni i connettori idempotenti: pull ripetuti non devono creare duplicati.

Aggiungi un workflow manuale per le eccezioni

Alcuni gap di copertura sono intenzionali (sistemi legacy, vincoli di terze parti, iniziative in pausa). Fornisci un record di “eccezione” leggero che richieda:

- un owner (persona o team)

- una ragione/categoria (es. blocked, out of scope, deprecated)

- una data di review (così le eccezioni scadono se non riaffermate)

Questo evita zone cieche permanenti e mantiene oneste le viste della leadership.

Normalizza i nomi tra gli strumenti

Le sorgenti raramente concordano sugli identificatori: un sistema dice “payments-service”, un altro “payments” e un terzo usa uno slug repo.

Crea regole di normalizzazione per:

- nomi servizi

- nomi repo

- environment (prod, production, live → prod)

Fallo presto; ogni metrica downstream dipende da questa normalizzazione.

Gestisci duplicati e rename con alias

Introduci tabelle alias (es. service_aliases, repo_aliases) che mappano molti nomi esterni a un'entità canonica. Quando arrivano nuovi dati, prova a matchare prima con gli ID canonici, poi con gli alias.

Se un nuovo nome non corrisponde, genera suggerimenti di merge (es. “payments-api” sembra “payments-service”) per l'approvazione di un admin.

Aggiungi un job per la freschezza dei dati

Schedula un job ricorrente che controlla l'ultimo timestamp di run per sorgente e segnala tutto ciò che è obsoleto (es. nessun run CI negli ultimi 7 giorni). Espori questo nello UI così una bassa copertura non venga confusa con dati mancanti.

Aggiungi avvisi, report e workflow di ownership

Un cruscotto è utile, ma sono gli avvisi e i workflow leggeri che trasformano dati interessanti in miglioramenti costanti. L'obiettivo è semplice: notificare le persone giuste al momento giusto, con abbastanza contesto per agire.

Tipi di alert che inducono azione

Inizia con un piccolo set di alert ad alto segnale:

- Calo di copertura (es. un servizio scende da 80% a 65% dopo un rilascio)

- Evidenza obsoleta (l'automazione esiste, ma le prove/link non sono stati aggiornati in N giorni)

- Automazione fallente (test o job che falliscono ripetutamente, quindi la copertura non è reale)

- Mancanza di owner (un servizio o workflow critico non ha un team responsabile)

Ogni alert dovrebbe linkare direttamente alla vista drill-down rilevante (es. services/payments?tab=coverage o teams/platform?tab=owners) così le persone non devono cercare.

Soglie per team/servizio (evita regole globali rumorose)

Evita soglie one-size-fits-all. Permetti ai team di impostare regole come:

- Percentuale minima di copertura per i loro servizi

- Finestra di “stale” per l'evidenza (7 giorni per sistemi veloci, 30 per quelli stabili)

- Conteggio di fallimenti o durata prima di fare paging vs solo notifica

Questo mantiene i segnali significativi e riduce la fatica da alert.

Notifiche + riepiloghi settimanali

Manda gli alert ai canali esistenti (email e Slack), e includi: cosa è cambiato, perché è importante e il proprietario. Accanto agli alert in tempo reale, aggiungi un riepilogo settimanale che copre:

- Cambi di copertura dalla settimana precedente

- Principali opportunità di automazione (gap più grandi per impatto)

- Elementi bloccati (owner mancanti, pipeline rotte, evidenze mancanti)

Riconoscere, assegnare e chiudere il ciclo

Tratta gli alert come task: permetti acknowledgement, assegnazione e stato (open/triaged/resolved). Una breve traccia di commenti (“fix in PR #1234”) rende il reporting credibile e previene che gli stessi problemi ricompaiano silenziosamente.

Costruisci API e job backend per le prestazioni

Un cruscotto di monitoraggio sembra veloce quando l'API risponde alle domande che l'UI realmente pone—senza costringere il browser a combinare dozzine di chiamate. Parti con una superficie API minimale, orientata al dashboard, poi aggiungi job in background per precomputare ciò che è costoso.

Parti con un'API minimale che combaci con l'UI

Mantieni la prima versione focalizzata sulle schermate core:

- Elenco servizi:

GET /api/services (filtri come team, language, tier)

- Sommario copertura:

GET /api/services/{id}/coverage (punteggio complessivo + breakdown chiave)

- Esecuzioni di evidenza:

GET /api/services/{id}/evidence?status=passed&since=...

- Aggiorna metadata (owner, tag, status):

PATCH /api/services/{id}

Progetta le risposte in modo che il cruscotto possa renderizzare immediatamente: includi nome servizio, owner, ultimo tempo di evidenza e punteggio corrente in un unico payload invece di richiedere lookup aggiuntivi.

Rendi le query del cruscotto economiche: paginazione, caching e rollup

Liste e tabelle drill-down devono sempre essere paginate (limit + cursor). Per endpoint molto usati, aggiungi caching a livello API (o cache condivisa) indicizzata per filtri e ambito di accesso del chiamante.

Per tutto ciò che richiede scansioni ampie di evidenze (es. “copertura per team”), pre-calcola rollup in un job notturno. Conserva i rollup in una tabella separata (o materialized view) così le letture sono semplici e prevedibili.

Aggiungi trend tramite snapshot giornalieri

I trend sono più semplici quando salvi snapshot giornalieri:

- Un job schedulato calcola la copertura per servizio ogni giorno.

- L'API espone

GET /api/services/{id}/trend?days=90.

Gli snapshot evitano ricalcoli storici a ogni caricamento pagina e rendono facile tracciare la “freschezza” (quanto recentemente è stata eseguita evidenza).

Import/export e guardie di consistenza

Il bulk onboarding è più fluido con:

POST /api/import/services (upload CSV)GET /api/export/services.csv

Infine, applica validazioni in scrittura: owner richiesto, valori di status ammessi e timestamp sensati (niente evidenze nel futuro). Rifiutare dati errati presto evita fix lenti e confusione quando i rollup dipendono da input coerenti.

Deployment, osservabilità e manutenzione

Costruisci rapidamente un cruscotto di copertura

Trasforma le domande sulla copertura dell'automazione in un cruscotto interno funzionante partendo da una specifica in chat.

Un cruscotto di copertura è utile solo se la gente si fida. Tratta deployment e operazioni come parte del prodotto: release prevedibili, segnali di salute chiari e recovery semplice quando qualcosa si rompe.

Parti con un deployment adatto all'uso interno

Per un'app interna, ottimizza per basso overhead e iterazione rapida.

- Distribuisci internamente prima usando un'immagine container + database gestito (es. Postgres), o una PaaS che supporti job schedulati e variabili d'ambiente.

- Mantieni la configurazione fuori dall'immagine (env vars o secrets manager) così puoi promuovere lo stesso build tra gli environment.

Se usi una piattaforma come Koder.ai per accelerare lo sviluppo, sfrutta l'esportazione del codice sorgente e i workflow di deployment/importazione presto, così la tua app interna segue pratiche standard di promozione, review e rollback.

Aggiungi l'osservabilità minima che risponde a “funziona?”

Non serve uno stack complesso per ottenere segnali affidabili.

- Instrumenta log strutturati per eventi chiave: inizio/fine ingestione, record processati, errori di normalizzazione.

- Monitora metriche che impattano la fiducia degli utenti:

- Ingestion lag (quanto sono stantii i dati)

- Job failures (connettori, parser, job di scoring)

- API latency (p95 per endpoint core)

- Espori health checks (liveness/readiness) e crea una piccola pagina admin che mostri lo stato dei connettori, l'ultimo sync riuscito e l'ultimo messaggio d'errore.

Backup e restore: testa, non presumere

Configura backup DB automatici e una policy di retention che risponda ai tuoi bisogni.

- Schedula backup e verifica che tu sappia ripristinare su una nuova istanza.

- Esegui un breve drill di restore dopo cambi di schema o upgrade di connettore.

Runbook operativi mantengono l'app “noiosa” (in senso buono)

Documenta runbook per:

- Rotazione di secret e token API

- Re-esecuzione degli import in sicurezza (job idempotenti, backfill)

- Passi per incident: disabilitare un connettore, fare rollback e comunicare la freschezza dei dati nel cruscotto

Un minimo di disciplina operativa evita che la “copertura” diventi congettura.

Piano di rollout, governance e miglioramento continuo

Un'app di monitoraggio aiuta solo se i team si fidano e la usano. Tratta il rollout come un lancio di prodotto: parti in piccolo, definisci ownership chiara e integra un ritmo prevedibile per gli aggiornamenti.

Onboarding di un nuovo team

Mantieni l'onboarding leggero e ripetibile:

- Mappa cosa tracciare: lista servizi, repo e pipeline che rappresentano il flow reale di delivery del team.

- Connetti le fonti: CI, ticketing, runbook, strumenti incident—qualsiasi cosa usiate come evidenza di automazione.

- Assegna owner: un owner primario per servizio (e un backup). Gli owner sono responsabili di correggere dati obsoleti e rivedere i gap.

Un buon obiettivo è “prima vista del cruscotto in 30 minuti”, non una configurazione di una settimana.

Cadenza di review

Stabilisci due ritmi:

- Review mensile della copertura: ogni team rivede i cambi, spiega cali/picchi significativi e conferma le principali 1–3 azioni di miglioramento.

- Check trimestrale delle regole metriche: rivedi le regole di scoring per equità e rilevanza (es. nuovo standard CI, tool deprecato).

Governance: chi può cambiare le definizioni

I punteggi di copertura possono diventare politici se le regole cambiano all'improvviso. Definisci un piccolo gruppo di governance (spesso Eng Productivity + Security/Quality) che possa:

- aggiornare definizioni globali (cosa conta come evidenza)

- modificare regole di scoring e pesi

- approvare nuovi connettori che impattano molti team

Pubblica i cambiamenti in un changelog semplice docs/scoring-changelog.

Misura adozione e migliora continuamente

Monitora l'adozione con poche metriche chiare: utenti attivi, servizi tracciati e compliance di freschezza (quanti servizi hanno evidenza aggiornata). Usa questi dati per guidare l'iterazione: pesatura migliore, tipi di evidenza più ricchi e connettori aggiuntivi—dando priorità sempre a miglioramenti che riducono lavoro manuale per i team.

Se decidi di condividere le tue esperienze internamente o pubblicamente, considera la standardizzazione di note di build e template: i team che usano Koder.ai possono anche guadagnare crediti creando contenuti sul loro workflow di sviluppo o referenziando altri utenti, il che può aiutare a finanziare l'iterazione continua sugli strumenti interni.