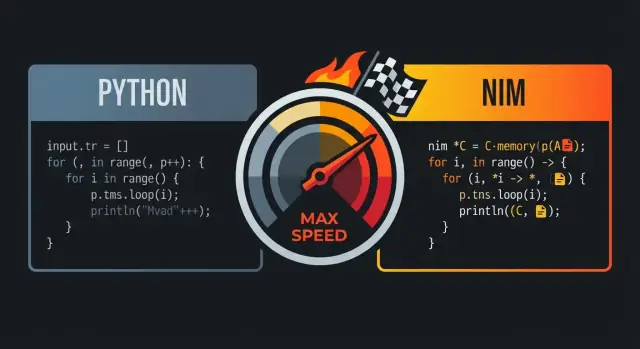

Perché si paragona Nim a Python e C

Nim viene spesso accostato a Python e C perché punta al punto di equilibrio tra i due: codice che si legge come un linguaggio di scripting di alto livello, ma che compila in eseguibili nativi veloci.

La promessa centrale: leggibilità più velocità

A prima vista, Nim spesso dà una sensazione “pythonica”: indentazione pulita, flusso di controllo semplice e funzionalità della libreria standard che favoriscono codice chiaro e compatto. La differenza chiave è ciò che succede dopo averlo scritto: Nim è progettato per compilare in codice macchina efficiente anziché girare su un runtime pesante.

Per molte squadre quella combinazione è il punto: puoi scrivere codice che assomiglia a ciò che prototiperesti in Python, ma distribuirlo come un singolo binario nativo.

A chi interessa

Questo paragone risuona soprattutto con:

- sviluppatori Python che incontrano limiti di prestazioni (carichi CPU-heavy, loop stretti, elaborazione dati)

- team di prodotto che vogliono iterare velocemente senza dipendere da un runtime lento

- ingegneri che apprezzano la velocità del C ma non vogliono la cerimonia low-level per il codice quotidiano

Cosa significa “prestazioni a livello C” nella pratica

“Prestazioni a livello C” non vuol dire che ogni programma Nim eguagli automaticamente un C scritto a mano. Significa che Nim può generare codice competitivo con C per molti carichi di lavoro—soprattutto dove l’overhead conta: loop numerici, parsing, algoritmi e servizi che richiedono latenza prevedibile.

Generalmente vedrai i maggiori guadagni quando elimini l’overhead dell’interprete, minimizzi le allocazioni e mantieni semplici i percorsi caldi del codice.

Aspettative: la velocità dipende dalle scelte

Nim non salverà un algoritmo inefficiente, e puoi comunque scrivere codice lento se allochi troppo, copi grandi strutture dati o ignori il profiling. La promessa è che il linguaggio ti dà una strada dal codice leggibile al codice veloce senza riscrivere tutto in un ecosistema diverso.

Il risultato: un linguaggio che si sente amichevole come Python, ma pronto ad avvicinarsi all’hardware quando le prestazioni contano.

Sintassi simile a Python: codice leggibile senza l’overhead

Nim è spesso descritto come “simile a Python” perché il codice appare e scorre in modo familiare: blocchi definiti dall’indentazione, punteggiatura minima e preferenza per costrutti di alto livello leggibili. La differenza è che Nim resta un linguaggio staticamente tipizzato e compilato—quindi ottieni quella superficie pulita senza pagare una “tassa” di runtime.

Blocchi basati sull’indentazione e struttura pulita

Come Python, Nim usa l’indentazione per definire i blocchi, il che rende il flusso di controllo facile da leggere nelle revisioni e nei diff. Non hai bisogno di parentesi graffe dappertutto e raramente ti servono parentesi tonde se non per chiarezza.

let limit = 10

for i in 0..\u003climit:

if i mod 2 == 0:

echo i

Questa semplicità visiva conta quando scrivi codice sensibile alle prestazioni: spendi meno tempo a combattere la sintassi e più tempo a esprimere l’intento.

Costrutti familiari: loop, slice, stringhe

Molti costrutti quotidiani mappano da vicino a ciò che gli utenti Python si aspettano.

- Loop: i

for su range e collezioni risultano naturali.

- Slice: sequenze e stringhe supportano operazioni in stile slicing.

- Stringhe: la gestione delle stringhe è semplice, con una libreria standard pensata per lavori pratici.

let nums = @[10, 20, 30, 40, 50]

let middle = nums[1..3] # slice: @[20, 30, 40]

let s = "hello nim"

echo s[0..4] # "hello"

La differenza principale rispetto a Python è ciò che avviene sotto il cofano: questi costrutti compilano in codice nativo efficiente anziché essere interpretati da una VM.

Tipizzazione statica che non intralcia

Nim è fortemente tipizzato staticamente, ma si affida molto all’inferenzà dei tipi, quindi non ti ritrovi a scrivere annotate verbose solo per lavorare.

var total = 0 # inferito come int

let name = "Nim" # inferito come string

Quando vuoi tipi espliciti (per API pubbliche, chiarezza o confini sensibili alle prestazioni), Nim li supporta in modo pulito—senza obbligarli ovunque.

Errori e warning del compilatore utili

Una parte importante della “leggibilità” è poter mantenere il codice in sicurezza. Il compilatore di Nim è pignolo in modi utili: segnala mismatch di tipo, variabili non usate e conversioni sospette precocemente, spesso con messaggi azionabili. Questo ciclo di feedback ti aiuta a mantenere codice semplice in stile Python pur beneficiando dei controlli a compile-time.

Se ti piace la leggibilità di Python, la sintassi di Nim ti farà sentire a casa. La differenza è che il compilatore di Nim può validare le tue ipotesi e poi produrre binari nativi veloci e prevedibili—senza trasformare il tuo codice in boilerplate.

Come Nim compila: dal sorgente ai binari nativi

Nim è un linguaggio compilato: scrivi file .nim e il compilatore li trasforma in un eseguibile nativo che puoi eseguire direttamente sulla tua macchina. La via più comune è tramite il backend C di Nim (può anche mirare a C++ o Objective-C), dove il codice Nim viene tradotto in codice sorgente per il backend e poi compilato da un compilatore di sistema come GCC o Clang.

Cosa significa davvero “binario nativo”

Un binario nativo gira senza una macchina virtuale del linguaggio e senza un interprete che esegue il codice riga per riga. Questa è una grande ragione per cui Nim può sembrare di alto livello ma evitare molti costi di runtime associati a VM bytecode o interpreti: il tempo di avvio è generalmente rapido, le chiamate di funzione sono dirette e i loop caldi possono eseguire vicino all’hardware.

Opportunità di ottimizzazione sull’intero programma

Poiché Nim compila ahead-of-time, la toolchain può ottimizzare sull’intero programma. Questo può abilitare inlining migliore, eliminazione del codice morto e ottimizzazioni al link-time (a seconda dei flag e del compilatore C/C++ usato). Il risultato sono spesso eseguibili più piccoli e veloci—specialmente rispetto a distribuire un runtime oltre al sorgente.

Workflow tipico: compila, esegui, distribuisci

Durante lo sviluppo normalmente itererai con comandi come nim c -r yourfile.nim (compila ed esegui) o userai modalità di build diverse per debug vs release. Quando è il momento di distribuire, consegni l’eseguibile prodotto (e eventuali librerie dinamiche richieste, se le colleghi). Non c’è uno step separato di “deploy dell’interprete”: l’output è già un programma eseguibile dal sistema operativo.

Potenza a compile-time: fare lavoro prima che il programma giri

Uno dei più grandi vantaggi di velocità di Nim è la possibilità di eseguire certo lavoro a compile-time (a volte chiamato CTFE: compile-time function execution). In termini semplici: invece di calcolare qualcosa ogni volta che il programma gira, chiedi al compilatore di calcolarlo una volta durante la build e incorporare il risultato nel binario finale.

Perché il lavoro a compile-time conta

I tempi di esecuzione spesso vengono consumati da “costi di setup”: costruire tabelle, parsare formati noti, verificare invarianti o precomputare valori che non cambiano. Se questi risultati sono predicibili da costanti, Nim può spostare lo sforzo nella compilazione.

Questo significa:

- meno tempo di avvio (niente fase di “warm-up”)

- meno allocazioni e branch durante l’esecuzione

- percorsi runtime più semplici (più facili da ottimizzare per il compilatore)

Esempi pratici

Generare tabelle di lookup. Se ti serve una tabella per mapping veloci (es. classi di caratteri ASCII o una piccola mappa hash di stringhe note), puoi generarla a compile-time e conservarla come array costante. Il programma fa poi lookup O(1) senza setup.

Validare costanti in anticipo. Se una costante è fuori range (una porta, una dimensione di buffer fissa, una versione di protocollo), puoi far fallire la build invece di distribuire un binario che scopre l’errore in produzione.

Precomputare costanti derivate. Maschere, pattern di bit o default normalizzati possono essere calcolati una volta e riutilizzati ovunque.

Nota di cautela: mantieni la leggibilità

La logica a compile-time è potente, ma rimane codice che qualcuno deve capire. Preferisci helper piccoli e ben nominati; aggiungi commenti che spieghino il “perché ora” (tempo di compilazione) vs “perché più tardi” (runtime). E testa gli helper a compile-time come testeresti normali funzioni—così le ottimizzazioni non diventano errori di build difficili da debuggare.

Le macro di Nim vanno intese come “codice che scrive codice” durante la compilazione. Invece di eseguire logica riflessiva a runtime (pagando il costo ad ogni esecuzione), puoi generare codice Nim specializzato una sola volta e distribuire il binario veloce risultante.

Rimuovere boilerplate (e controlli a runtime)

Un uso comune è sostituire pattern ripetitivi che altrimenti gonfierebbero il codebase o aggiungerebbero overhead per chiamata. Per esempio, puoi:

- generare funzioni di serializzazione/deserializzazione per un tipo invece di scriverle a mano campo per campo

- produrre codice di validazione degli input basato su uno schema compatto, invece di controllare ogni campo con una serie di

if

- costruire dispatch ottimizzato (es. mappare comandi a handler) senza tabelle di lookup a runtime

Poiché la macro si espande in codice Nim normale, il compilatore può ancora inline-are, ottimizzare e rimuovere rami morti—quindi l’astrazione spesso scompare nell’eseguibile finale.

Sintassi specifica del dominio (senza compilatore custom)

Le macro permettono anche sintassi DSL leggere. I team usano questo per esprimere l’intento chiaramente:

- parser veloci: scrivi una descrizione dichiarativa tipo grammatica, la macro emette codice di parsing efficiente

- serializer: specifica tag/format e genera packing/unpacking

- mini-DSL per routing, costruzione di query SQL o mapping di configurazione

Ben fatto, questo può far sembrare il call site come Python—pulito e diretto—pur compilando in loop efficienti e operazioni sicure sui puntatori.

Mantenere le macro manutenibili

La metaprogrammazione può diventare intricata se si trasforma in un linguaggio nascosto nel progetto. Alcune regole utili:

- documenta cosa genera la macro e mostra un piccolo esempio del codice espanso

- mantieni le macro strette: risolvono un problema chiaro invece di diventare un “framework” general purpose

- preferisci generici/template quando bastano; usa macro quando davvero servono trasformazioni AST

Gestione della memoria: ARC/ORC e prestazioni prevedibili

Aggiungi un client mobile

Crea un’app companion Flutter per il tuo servizio Nim, generata da una specifica in chat.

La gestione della memoria di default in Nim è una ragione importante per cui può sembrare “pythonico” pur comportandosi come un linguaggio di sistema. Invece di un garbage collector tracing classico che scansiona periodicamente la memoria per trovare oggetti non raggiungibili, Nim usa tipicamente ARC (Automatic Reference Counting) o ORC (Optimized Reference Counting).

ARC/ORC vs GC tracing (a grandi linee)

Un GC tracing lavora a raffiche: mette in pausa il lavoro normale per attraversare gli oggetti e decidere cosa liberare. Quel modello può essere ottimo per l’ergonomia dello sviluppo, ma le pause possono essere difficili da prevedere.

Con ARC/ORC la maggior parte della memoria viene liberata appena l’ultima referenza scompare. In pratica tende a produrre una latenza più consistente e rende più semplice ragionare su quando vengono rilasciate le risorse (memoria, file, socket).

Perché la predicibilità aiuta le prestazioni

Un comportamento di memoria prevedibile riduce i rallentamenti a sorpresa. Se allocazioni e free avvengono continuamente e localmente—anziché in cicli globali occasionali—i tempi del programma sono più facili da controllare. Questo conta per giochi, server, strumenti CLI e tutto ciò che deve restare reattivo.

Aiuta anche il compilatore ad ottimizzare: quando le lifetime sono più chiare, il compilatore può talvolta mantenere i dati nei registri o nello stack ed evitare bookkeeping extra.

Stack vs heap, lifetime e copia vs spostamento

A grandi linee:

- Stack: valori di breve vita, economici da creare; scompaiono alla fine dello scope.

- Heap: valori che vivono più a lungo e possono essere condivisi; allocarli è più costoso.

Nim ti lascia scrivere codice di alto livello pur tenendo conto delle lifetime. Osserva quando stai copiando grandi strutture (duplicando dati) o le muovendo (trasferendo ownership senza duplicare). Evita copie accidentali nei loop caldi.

Consigli pratici per evitare allocazioni inutili

Se vuoi “velocità da C”, l’allocazione più veloce è quella che non fai:

- riusa buffer (per stringhe, sequence, IO) invece di ricrearli continuamente

- preferisci aggiornamenti in-place nei percorsi caldi

- costruisci dati incrementali con capacità preallocata quando possibile

Queste abitudini vanno bene con ARC/ORC: meno oggetti heap significa meno traffico di reference-count e più tempo per fare il lavoro vero.

Strutture dati e layout: ottenere velocità dalla semplicità

Nim può sembrare di alto livello, ma le sue prestazioni spesso si riducono a un dettaglio low-level: cosa viene allocato, dove vive e come è disposto in memoria. Se scegli le forme giuste per i dati, ottieni velocità “gratis”, senza scrivere codice illeggibile.

Tipi per valore vs ref: dove avviene l’allocazione

La maggior parte dei tipi Nim è value type per default: int, float, bool, enum e anche object plain. I value type tipicamente vivono inline (spesso nello stack o embedded in altre strutture), il che mantiene accessi memoria stretti e prevedibili.

Quando usi ref (es. ref object), stai aggiungendo un livello di indirezione: il valore vive solitamente nell’heap e maneggi un puntatore. Questo può essere utile per dati condivisi, di lunga durata o opzionali, ma può aggiungere overhead nei loop caldi perché la CPU deve seguire puntatori.

Regola pratica: preferisci object plain per dati critici per le prestazioni; usa ref quando hai davvero bisogno di semantiche per referenza.

seq e string: comodi, ma conosci i costi

seq[T] e string sono contenitori dinamici ridimensionabili. Sono ottimi per la programmazione quotidiana, ma possono allocare e riallocare mentre crescono. Il pattern di costo da osservare:

- append può occasionalmente causare resize (copia degli elementi esistenti)

- molte piccole

seq o stringhe possono creare molti blocchi heap separati

Se conosci le dimensioni in anticipo, pre-dimensiona (newSeq, setLen) e riusa i buffer per ridurre il churn.

Perché il layout conta: modello mentale semplice per la cache CPU

Le CPU sono più veloci quando leggono memoria contigua. Un seq[MyObj] dove MyObj è un oggetto valore è tipicamente cache-friendly: gli elementi stanno uno accanto all’altro.

Ma un seq[ref MyObj] è una lista di puntatori sparsi nell’heap; iterarla significa saltare in memoria, ed è più lenta.

Consigli pratici per i percorsi caldi

Per loop stretti e codice sensibile alle prestazioni:

- preferisci

array (dimensione fissa) o seq di oggetti valore

- tieni i campi frequentemente accessi insieme nello stesso

object

- evita “catene di puntatori” (

ref dentro ref) a meno che non servano

Queste scelte mantengono i dati compatti e locali—esattamente ciò che piacciono alle CPU moderne.

Astrazioni che si compilano via

Distribuisci con fiducia

Distribuisci e ospita la tua app, poi usa snapshot e rollback quando qualcosa va storto.

Una ragione per cui Nim può essere di alto livello senza pagare un grande costo a runtime è che molte feature sono progettate per compilare in codice macchina semplice. Scrivi codice espressivo; il compilatore lo abbassa in loop stretti e chiamate dirette.

Cosa significa “astrazione a costo zero” in Nim

Un’astrazione a costo zero è una feature che rende il codice più leggibile o riutilizzabile, ma non aggiunge lavoro extra a runtime rispetto alla versione low-level scritta a mano.

Un esempio intuitivo è usare un’API stile iterator per filtrare valori, ottenendo comunque un semplice loop nell’eseguibile finale.

proc sumPositives(a: openArray[int]): int =

for x in a:

if x \u003e 0:

result += x

Anche se openArray sembra flessibile e “alto livello”, questo tipicamente compila in una semplice scansione indicizzata della memoria (nessun overhead stile oggetto di Python). L’API è piacevole, ma il codice generato è vicino al loop C ovvio.

Inlining, generici e specializzazione (versione in parole semplici)

Nim fa molto inlining di piccole procedure quando aiuta: la chiamata può sparire e il corpo viene incollato nel chiamante.

Con i generici, puoi scrivere una funzione che funziona per più tipi. Il compilatore poi la specializza: crea una versione su misura per ogni tipo concreto usato. Questo spesso produce codice efficiente quanto funzioni scritte a mano per tipo specifico—senza duplicare la logica.

API “belle” che diventano comunque loop stretti

Pattern come piccoli helper (mapIt, filterIt), tipi distinct e controlli di range possono essere ottimizzati quando il compilatore riesce a vedere attraverso di essi. Il risultato può essere un singolo loop con branching minimo.

La grande caveat: astrazioni che forzano allocazioni

Le astrazioni smettono di essere “gratis” quando creano allocazioni heap o copie nascoste. Restituire nuove sequence ripetutamente, costruire stringhe temporanee nei loop interni o catturare grandi closure può introdurre overhead.

Regola pratica: se un’astrazione alloca per iterazione, può dominare il tempo di esecuzione. Preferisci dati friendly per lo stack, riusa buffer e controlla API che creano nuove seq o string silenziosamente nei percorsi caldi.

Interoperabilità con C: riutilizzare velocità ed ecosistemi

Una ragione pratica per cui Nim può sembrare di alto livello pur restando veloce è la possibilità di chiamare C direttamente. Invece di riscrivere una libreria C collaudata in Nim, puoi importarne le dichiarazioni, linkare la libreria compilata e chiamare le funzioni quasi come se fossero procedure Nim native.

A grandi linee l’FFI C di Nim

L’FFI di Nim si basa sul descrivere le funzioni e i tipi C che vuoi usare. In molti casi puoi:

- dichiarare i simboli C in Nim con

importc (indicando il nome C esatto), o

- usare tool che generano dichiarazioni Nim a partire dagli header C.

Dopodiché il compilatore Nim linka tutto nello stesso binario nativo, quindi l’overhead di chiamata è minimo.

Perché questo conta: riuso senza riscritture

Questo ti dà accesso immediato ad ecosistemi maturi: compressione (zlib), primitive crypto, codec immagine/audio, client di database, API OS e utilità performance-critical. Mantieni la struttura leggibile in stile Python per la logica applicativa mentre appoggi il lavoro pesante a librerie C collaudate.

Insidie da tenere d’occhio: ownership e conversioni

I bug FFI solitamente derivano da aspettative non corrispondenti:

- Regole di ownership: chi alloca e chi libera? Se una funzione C ritorna un puntatore che devi liberare, devi avere un chiaro percorso di freeing in Nim. Se C mantiene un puntatore passato, devi assicurarti che la memoria rimanga viva.

- Stringhe e buffer: le stringhe Nim non sono stringhe C. Convertire in

cstring è semplice, ma devi garantire la terminazione nulla e la lifetime. Per dati binari, preferisci coppie ptr uint8/lunghezza esplicite.

Wrappare le API C in modo sicuro (e testabile)

Un buon pattern è scrivere un piccolo wrapper Nim che:

- espone

proc e tipi idiomatici Nim,

- centralizza conversioni e gestione degli errori,

- nasconde i puntatori raw dietro helper RAII-like (

defer, distruttori) quando opportuno.

Questo rende più semplice il testing e riduce la possibilità che dettagli low-level fuoriescano nel resto del codebase.

Nim può sembrare veloce “di default”, ma l’ultimo 20–50% spesso dipende da come buildi e come misuri. La buona notizia: il compilatore Nim espone controlli di performance in modo accessibile anche se non sei un esperto di sistemi.

Modalità di build che contano

Per numeri reali evita benchmark su build di debug. Parti con una build di release e aggiungi controlli extra solo quando cerchi bug.

nim c -d:release --opt:speed myapp.nim

nim c -d:danger --opt:speed myapp.nim

nim c -d:release --opt:speed --passC:-march=native myapp.nim

Una regola semplice: usa -d:release per benchmark e produzione, e riserva -d:danger quando hai già fiducia con i test.

Workflow di profiling: misura prima, ottimizza dopo

Un flusso pratico:

- Misura end-to-end prima (tempo reale, memoria, throughput). Tool come

hyperfine o un semplice time sono spesso sufficienti.

- Trova gli hotspot. Nim supporta profiling integrato (

--profiler:on) e funziona bene con profiler esterni (Linux perf, Instruments su macOS, strumenti Windows) perché produci binari nativi.

- Ottimizza le 1–2 funzioni più calde, poi misura di nuovo. Se l’hotspot si sposta, è progresso.

Quando usi profiler esterni, compila con debug info per ottenere stack trace leggibili e simboli:

nim c -d:release --opt:speed --debuginfo myapp.nim

Micro-ottimizzazioni da evitare

È allettante modificare dettagli minori (unrolling manuale dei loop, riarrangiare espressioni, trucchi “furbi”) prima di avere dati. In Nim i guadagni maggiori provengono spesso da:

- scegliere un algoritmo migliore,

- ridurre allocazioni e copie,

- migliorare il layout dei dati (es. usare rappresentazioni contigue quando possibile),

- abbassare l’overhead nei loop critici.

Benchmark in CI e controlli di regressione

Le regressioni sono più facili da risolvere se rilevate presto. Un approccio leggero è aggiungere una piccola suite di benchmark (spesso via un task Nimble come nimble bench) e eseguirla in CI su un runner stabile. Conserva baseline (anche come semplice output JSON) e fai fallire la build quando metriche chiave deviano oltre una soglia consentita. Così il “veloce oggi” non diventa “lento il mese prossimo” senza che nessuno se ne accorga.

Dove Nim eccelle (e dove potrebbe non essere la scelta ideale)

Aggiungi una dashboard React

Trasforma il tuo CLI o servizio in una semplice dashboard web da condividere con il team.

Nim è una buona scelta quando vuoi codice che si legga come un linguaggio di alto livello ma che venga distribuito come un singolo eseguibile veloce. Premia team che tengono alle prestazioni, alla semplicità della distribuzione e al controllo delle dipendenze.

Abbinamenti ideali

Per molte squadre Nim brilla in software “product-like”—cose che compili, testi e distribuisci.

- CLI e strumenti per sviluppatori: distribuisci un binario nativo, avvii rapidi e bassa latenza d’avvio.

- Strumenti e servizi di rete: buon throughput e latenza prevedibile, mantenendo il codice leggibile.

- Tooling per giochi e pipeline: convertitori di asset, strumenti di build, editor e automazione dove la velocità conta ma non vuoi la complessità di C/C++.

Casi in cui essere cauti

Nim può essere meno ideale quando il successo dipende più dalla dinamicità a runtime che dalle prestazioni compilate.

- Sistemi di plugin molto dinamici: se prevedi di caricare e scaricare molte estensioni terze a runtime, il modello compilato di Nim può aggiungere attriti.

- Script rapidi e usa-e-getta: se il tuo workflow è “modifica, esegui subito, butta via”, Python (o script shell) può essere più veloce per piccole attività.

Considerazioni per il team

Nim è accessibile, ma ha comunque una curva di apprendimento.

- Concorda convenzioni di stile presto (layout dei moduli, gestione errori, naming) per evitare che “ognuno scriva Nim a modo suo”.

- Pianifica l’onboarding: pair programming e una guida interna breve aiutano più di documenti lunghi.

- Sii realistico sui gap dell’ecosistema: alcune librerie esistono, ma non troverai un pacchetto per tutto come in Python.

Approccio pilota

Scegli un progetto piccolo e misurabile—come riscrivere un passo lento di un CLI o un’utilità di rete. Definisci metriche di successo (tempo di esecuzione, memoria, tempo di build, dimensione del deploy), distribuisci a un’audience interna ridotta e decidi in base ai risultati, non all’hype.

Se il lavoro Nim ha bisogno di una superficie prodotto intorno—una dashboard admin, un runner di benchmark UI o un gateway API—strumenti come Koder.ai possono aiutare a scaffoldare rapidamente quelle parti. Puoi vibe-code un frontend React e un backend Go + PostgreSQL, poi integrare il tuo binario Nim come servizio via HTTP, mantenendo il nucleo performance-critical in Nim mentre accelera il resto.

Checklist pratica per ottenere codice in stile Python a velocità C

Nim guadagna la reputazione “simile a Python ma veloce” combinando sintassi leggibile con un compilatore nativo che ottimizza, una gestione memoria prevedibile (ARC/ORC) e una cultura che presta attenzione al layout dei dati e alle allocazioni. Se vuoi i benefici di velocità senza trasformare il codebase in spaghetti low-level, usa questa checklist come workflow ripetibile.

Checklist orientata alla velocità (senza sacrificare la chiarezza)

- Compila come se lo intendessi: usa una build di release per misurazioni reali.

- Parti con

-d:release e considera --opt:speed.

- Abilita ottimizzazioni link-time quando opportuno (

--passC:-flto --passL:-flto).

- Scegli strutture dati intenzionalmente: preferisci rappresentazioni semplici e contigue.

seq[T] è ottimo, ma i loop stretti spesso beneficiano di array, openArray ed evitare ridimensionamenti inutili.- Mantieni i dati caldi piccoli e vicini; meno puntatori significa meno cache miss.

- Sii consapevole delle allocazioni: ARC/ORC aiuta, ma non può eliminare il lavoro che crei.

- Riusa buffer, prealloca con

newSeqOfCap e evita di costruire stringhe temporanee nei loop.

- Fai attenzione alle copie nascoste durante slicing o concatenazioni.

- Lascia che le astrazioni si compilino via: scrivi codice pulito, poi verifica che si riduca.

- Preferisci iteratori/template per espressività, ma conferma che siano inlineate in build di release.

- Misura prima di “ottimizzare”: profila per trovare i veri hotspot.

- Se sei nuovo al profiling, vedi /blog/performance-profiling-basics.

Prossimi passi: dimostralo sulla tua macchina

- Prova un piccolo benchmark: scegli una funzione che faccia lavoro reale (parsing, filtraggio, calcoli) e confronta build debug vs release.

- Distribuisci una feature reale: implementa un piccolo modulo end-to-end, poi affina solo il percorso caldo (non l’intero codebase).

Se stai ancora decidendo tra linguaggi, /blog/nim-vs-python può aiutare a inquadrare i compromessi. Per team che valutano tooling o opzioni di supporto, puoi anche controllare /pricing.