17 ago 2025·8 min

Perché i flussi di lavoro guidati dall'IA riducono l'astrazione prematura

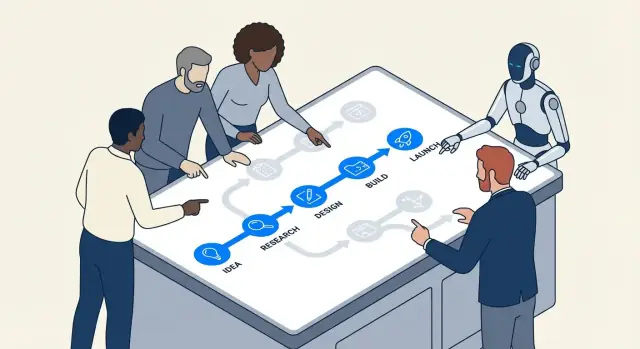

I flussi di lavoro guidati dall'IA spingono i team verso passi concreti, feedback rapidi e risultati misurabili—riducendo la tentazione di sovraastrarre e sovraingegnerizzare troppo presto.

Cosa intendiamo per astrazione prematura e sovraingegnerizzazione

L'astrazione prematura è quando costruisci una “soluzione generale” prima di aver visto abbastanza casi reali per sapere cosa debba essere generalizzato.

Invece di scrivere il codice più semplice che risolve il problema di oggi, inventi un framework: interfacce extra, sistemi di configurazione, punti plug-in o moduli riutilizzabili—perché presumi che ti serviranno in seguito.

La sovraingegnerizzazione è l'abitudine più ampia dietro questo comportamento. Significa aggiungere complessità che al momento non ripaga: layer in più, pattern, servizi o opzioni che non riducono chiaramente costi o rischi ora.

Esempi in lingua comune

Se il tuo prodotto ha un solo piano tariffario e costruisci un motore di pricing multi-tenant “per sicurezza”, quello è astrazione prematura.

Se una funzionalità potrebbe essere una singola funzione semplice, ma la suddividi in sei classi con factory e registry per renderla “estendibile”, quello è sovraingegnerizzazione.

Perché emerge all'inizio dei progetti

Queste abitudini sono comuni all'inizio perché i progetti iniziali sono pieni di incertezza:

- Timore della rifattorizzazione: i team temono che se costruiscono qualcosa di semplice dovranno riscriverlo più tardi.

- Requisiti poco chiari: quando nessuno è sicuro di cosa diventerà il prodotto, è allettante costruire uno scheletro flessibile che possa “gestire qualsiasi cosa”.

- Pressione sociale: gli ingegneri spesso vogliono guardare avanti e “farlo bene”, anche quando il “bene” non è ancora conoscibile.

Il problema è che “flessibile” spesso significa “più difficile da cambiare”. I layer extra possono rendere le modifiche quotidiane più lente, il debug più complicato e l'onboarding più doloroso. Paghi il costo della complessità subito, mentre i benefici potrebbero non arrivare mai.

Dove si inserisce l'IA (e dove non lo fa)

I flussi di lavoro guidati dall'IA possono incoraggiare i team a mantenere il lavoro concreto—accelerando i prototipi, producendo esempi rapidamente e rendendo più semplice testare le ipotesi. Questo può ridurre l'ansia che alimenta il design speculativo.

Ma l'IA non sostituisce il giudizio ingegneristico. Può generare architetture e astrazioni intelligenti su richiesta. Il tuo compito è ancora chiedere: Qual è la cosa più semplice che funziona oggi, e quale evidenza giustificherebbe aggiungere struttura domani?

Strumenti come Koder.ai sono particolarmente efficaci perché rendono facile passare da un prompt in chat a una porzione eseguibile di una vera app (web, backend o mobile) rapidamente—così i team possono convalidare cosa serve prima di “future-proofare” qualsiasi cosa.

Come i flussi di lavoro con IA spingono i team verso il lavoro concreto

Lo sviluppo assistito dall'IA tende a partire da qualcosa di tangibile: un bug specifico, una piccola funzionalità, una trasformazione di dati, una schermata UI. Questa inquadratura è importante. Quando il flusso di lavoro inizia con “ecco la cosa esatta di cui abbiamo bisogno”, i team sono meno propensi a inventare un'architettura generalizzata prima di aver capito realmente il problema.

Prompt concreti producono codice concreto

La maggior parte degli strumenti IA risponde meglio quando fornisci dettagli: input, output, vincoli ed esempi. Un prompt come “progetta un sistema di notifiche flessibile” è vago, quindi il modello spesso “riempie i vuoti” con layer extra—interfacce, factory, configurazioni—perché non vede i reali confini.

Ma quando il prompt è ancorato, l'output lo è altrettanto:

- Input: “Dato questi stati dell'ordine…”

- Output: “Restituisci il messaggio user-facing e la CTA…”

- Vincoli: “Deve essere veloce; nessuna chiamata al DB; deve supportare l'internazionalizzazione (i18n)…”

- Esempi: “Per

PENDING_PAYMENTmostra …”

Questo spinge naturalmente i team a implementare una fetta stretta che funziona end-to-end. Una volta che puoi eseguirla, rivederla e mostrarla, sei nel mondo reale anziché nella speculazione.

“Fallo funzionare prima” diventa il comportamento predefinito

La programmazione in coppia con IA rende l'iterazione economica. Se una prima versione è un po' disordinata ma corretta, il passo successivo è di solito “refatta questa” piuttosto che “progetta un sistema per tutti i casi futuri”. Questa sequenza—codice funzionante prima, raffinamento dopo—riduce l'impulso a costruire astrazioni che non si sono guadagnate la loro complessità.

In pratica, i team trovano un ritmo:

- Chiedere un'implementazione minima.

- Provarla con esempi reali.

- Aggiustare in base a cosa si rompe o risulta scomodo.

- Solo allora estrarre un helper, un modulo o un pattern.

La specificità espone i requisiti mancanti presto

I prompt ti costringono a dire ciò che intendi veramente. Se non riesci a definire chiaramente input/output, è un segnale che non sei pronto ad astrarre—stai ancora scoprendo i requisiti. Gli strumenti IA premiano la chiarezza, quindi addestrano in modo sottile i team a chiarire prima e generalizzare dopo.

Cicli di feedback brevi riducono il design speculativo

Un feedback rapido cambia ciò che significa “buona ingegneria”. Quando puoi provare un'idea in pochi minuti, l'architettura speculativa smette di essere una coperta di sicurezza e comincia a sembrare un costo evitabile.

Il loop: bozza → esegui → ispeziona → regola

I flussi guidati dall'IA comprimono il ciclo:

- Bozza: chiedi all'assistente una piccola porzione funzionante (uno script, un handler, una query)

- Esegui: eseguila immediatamente con input reali

- Ispeziona: guarda output, log, casi limite e come fallisce

- Regola: affina il codice e i requisiti contemporaneamente

Questo loop premia il progresso concreto. Invece di discutere “avremo bisogno di un sistema plugin” o “questo deve supportare 12 sorgenti dati”, il team vede cosa richiede davvero il problema attuale.

Perché la velocità riduce l'architettura speculativa

L'astrazione prematura spesso nasce quando i team temono il cambiamento: se i cambiamenti sono costosi, provi a prevedere il futuro e a progettare per esso. Con loop brevi, il cambiamento è economico. Questo inverte l'incentivo:

- Puoi rimandare la generalizzazione finché il lavoro ripetuto non dimostra che è necessario.

- Scopri vincoli reali (performance, forma dei dati, comportamento utente) presto.

- Smetti di costruire “per sicurezza” perché puoi iterare “just in time”.

Un esempio semplice: prima un endpoint, poi il framework

Immagina di aggiungere una funzionalità interna “esporta in CSV”. La strada sovraingegnerizzata inizia progettando un framework di export generico, più formati, job queue e layer di configurazione.

Un percorso a loop veloce è più piccolo: genera un singolo endpoint /exports/orders.csv (o uno script one-off), eseguilo su dati di staging e ispeziona la dimensione del file, il tempo di esecuzione e i campi mancanti. Se, dopo due o tre esportazioni, vedi pattern ripetuti—stessa logica di paginazione, filtri condivisi, intestazioni comuni—allora un'astrazione si è guadagnata il suo posto perché è fondata su evidenze, non su supposizioni.

I cambiamenti incrementali fanno guadagnare alle astrazioni il loro valore

La consegna incrementale cambia l'economia del design. Quando spedisci a piccoli pezzi, ogni layer “bello da avere” deve dimostrare che aiuta ora—non in un futuro immaginato. Qui i flussi IA riducono silenziosamente l'astrazione prematura: l'IA è brava a proporre strutture, ma queste sono più facili da convalidare quando l'ambito è piccolo.

Un ambito piccolo rende testabili i suggerimenti dell'IA

Se chiedi a un assistente di rifattorizzare un singolo modulo o aggiungere un nuovo endpoint, puoi rapidamente verificare se la sua astrazione migliora davvero la chiarezza, riduce la duplicazione o facilita la prossima modifica. Con una diff piccola, il feedback è immediato: i test passano o falliscono, il codice è più leggibile o peggiore e la funzionalità si comporta correttamente o no.

Quando l'ambito è ampio, i suggerimenti dell'IA possono sembrare plausibili senza essere dimostrabilmente utili. Potresti accettare un framework generalizzato solo perché “sembra pulito”, per poi scoprire che complica i casi limite reali.

Piccoli componenti rivelano cosa tenere (e cosa eliminare)

Lavorare per incrementi incoraggia a costruire prima piccoli componenti usa e getta—helper, adapter, forme di dati semplici. Dopo poche iterazioni diventa ovvio quali pezzi vengono riutilizzati in più funzionalità (da conservare) e quali erano necessari solo per un esperimento (sicuri da eliminare).

Le astrazioni diventano così una registrazione del riuso reale, non del riuso previsto.

La delivery incrementale riduce il rischio del refactor

Quando le modifiche vengono consegnate continuamente, il refactor è meno spaventoso. Non devi “azzeccare tutto” da subito perché puoi evolvere il design man mano che le evidenze si accumulano. Se un pattern davvero si guadagna il suo posto—riducendo lavoro ripetuto su più incrementi—promuoverlo a astrazione è una mossa a basso rischio e alta confidenza.

Questa mentalità inverte il default: costruisci prima la versione più semplice, poi astrai solo quando il passo incrementale successivo ne beneficia chiaramente.

Sperimentazione facile favorisce la semplicità rispetto al “grande progetto”

Ottieni cicli di feedback rapidi

Distribuisci presto così l'uso reale, non le ipotesi, decide cosa merita un'astrazione.

I flussi di lavoro con IA rendono la sperimentazione così economica che “costruire un grande sistema” smette di essere il comportamento predefinito. Quando un team può generare, modificare e rieseguire più approcci in un pomeriggio, è più facile scoprire cosa funziona davvero che prevedere cosa potrebbe funzionare.

L'IA rende quasi gratuite le piccole varianti

Invece di investire giorni nel progettare un'architettura generalizzata, i team possono chiedere all'IA di creare alcune implementazioni concrete e ristrette:

- una versione diretta che gestisce bene il percorso felice

- una versione ottimizzata per leggibilità e manutenibilità

- una versione che aggiunge una sola capacità extra (es.: un secondo formato di input)

Poiché creare queste varianti è veloce, il team può esplorare i compromessi senza impegnarsi in un “grande progetto” iniziale. L'obiettivo non è spedire tutte le varianti—è ottenere evidenza.

Confrontare le varianti premia naturalmente le soluzioni più semplici

Una volta che puoi mettere due o tre opzioni funzionanti affiancate, la complessità diventa visibile. La variante più semplice spesso:

- soddisfa gli stessi requisiti reali

- ha meno parti mobili da debugare

- rende i cambi futuri più facili perché c'è meno accoppiamento nascosto

Nel frattempo, le opzioni sovraingegnerizzate tendono a giustificarsi con bisogni ipotetici. Il confronto tra varianti è un antidoto: se l'astrazione aggiuntiva non produce benefici chiari e a breve termine, appare come un costo.

Checklist: cosa misurare quando confronti le opzioni

Quando esegui esperimenti leggeri, concorda cosa significa “meglio”. Una checklist pratica:

- Tempo al primo risultato funzionante: quanto tempo fino a coprire gli scenari di base?

- Complessità di implementazione: file/moduli toccati, concetti introdotti e quante “regole” un collega deve ricordare.

- Costo del cambiamento: quanto è difficile aggiungere un nuovo requisito (il prossimo probabile, non una fantasia lontana)?

- Modi di fallimento: cosa si rompe, quanto gravemente e quanto è facile rilevarlo (errori chiari vs output sbagliato silenzioso).

- Rischio operativo: nuove dipendenze, superfici di configurazione e punti in cui il comportamento in produzione può deviare.

- Testabilità: quanto è facile scrivere un piccolo set di test che documentino il comportamento.

Se una variante più astratta non vince su almeno una o due di queste misure, l'approccio più semplice e funzionante è di solito la scelta giusta—for now.

L'IA aiuta a chiarire i requisiti prima di astrarre

L'astrazione prematura spesso inizia con una frase del tipo: “Potremmo averne bisogno più avanti.” Questo è diverso da: “Ne abbiamo bisogno ora.” La prima è una supposizione sulla variabilità futura; la seconda è un vincolo che puoi verificare oggi.

I flussi di lavoro guidati dall'IA rendono questa differenza più difficile da ignorare perché sono bravi a trasformare conversazioni sfocate in enunciati espliciti che puoi ispezionare.

Trasforma l'ambiguità in un contratto scritto (senza sforzarti a impegnarti)

Quando una richiesta di funzionalità è vaga, i team tendono a “future-proofare” costruendo un framework generale. Usa invece l'IA per produrre rapidamente una snapshot dei requisiti di una pagina che separi ciò che è reale da ciò che è immaginato:

- Cosa sappiamo (vincoli attuali): utenti target, piattaforme supportate, aspettative di performance, integrazioni richieste.

- Cosa stiamo assumendo: “Gli utenti avranno più account”, “supporteremo 10 localizzazioni”, “esisteranno tier di pricing”.

- Cosa non sappiamo ancora: casi limite, vincoli legali, scala, necessità di migrazione.

Questa semplice separazione cambia la conversazione ingegneristica. Smetti di progettare per un futuro sconosciuto e inizi a costruire per il presente noto—tenendo però una lista visibile delle incertezze da rivedere.

La Planning Mode di Koder.ai si adatta bene a questo: puoi trasformare una richiesta vaga in un piano concreto (passi, modello dati, endpoint, stati UI) prima di generare l'implementazione—senza impegnarti in un'architettura ramificata.

Un approccio leggero “friendly con il futuro”

Puoi comunque lasciare spazio per evolvere senza costruire un profondo layer di astrazione. Prediligi meccanismi facili da cambiare o rimuovere:

- Feature flag per spedire una versione ristretta e imparare dall'uso reale.

- Configurazione per valori che variano (timeout, soglie, testi) invece di sistemi polimorfici.

- Punti di estensione piccoli (una sola interfaccia, un hook, un evento) solo dove la variazione è già probabile.

Una buona regola: se non riesci a nominare le prossime due variazioni concrete, non costruire il framework. Annota le variazioni sospette come “incertezze”, rilascia il percorso più semplice funzionante e lascia che il feedback reale giustifichi l'astrazione più tardi.

Se vuoi formalizzare questa abitudine, cattura queste note nel tuo template di PR o in un documento interno “assumptions” collegato dal ticket (es.: /blog/engineering-assumptions-checklist).

Test ed esempi espongono la generalizzazione inutile

Una ragione comune per cui i team sovraingegnerizzano è che progettano per scenari immaginati. I test e gli esempi concreti capovolgono questo: ti costringono a descrivere input reali, output reali e modalità di fallimento reali. Una volta scritti, le astrazioni “generiche” spesso appaiono meno utili e più costose di un'implementazione piccola e chiara.

Come l'IA mette in luce i casi limite (senza inventare architetture)

Quando chiedi a un assistente IA di aiutarti a scrivere test, ti spinge naturalmente verso la specificità. Invece di “rendilo flessibile”, ottieni domande come: Cosa restituisce questa funzione quando la lista è vuota? Qual è il valore massimo consentito? Come rappresentiamo uno stato invalido?

Questo interrogarsi è prezioso perché trova i casi limite presto, mentre stai ancora decidendo cosa la funzionalità debba realmente coprire. Se quei casi limite sono rari o fuori ambito, puoi documentarli e andare avanti—senza costruire un'astrazione “per sicurezza”.

Scrivere test prima rivela se serve un'astrazione

Le astrazioni si guadagnano il loro posto quando più test condividono la stessa configurazione o pattern di comportamento. Se la tua suite di test ha solo uno o due scenari concreti, creare un framework o un sistema plugin è di solito un segnale che stai ottimizzando per lavoro futuro ipotetico.

Una regola pratica: se non riesci a esprimere almeno tre comportamenti distinti che richiedono la stessa interfaccia generalizzata, probabilmente l'astrazione è prematura.

Mini-template per casi di test pratici

Usa questa struttura leggera prima di cercare una “design generalizzato”:

- Happy path: input tipico → output atteso.

- Boundary: valori min/max, collezioni vuote, limiti (es.: 0, 1, 1000).

- Failure: input invalido, dipendenze mancanti, timeout, errori di permessi → errore o comportamento di fallback atteso.

Una volta scritti, il codice spesso vuole essere semplice. Se la ripetizione appare attraverso più test, quello è il segnale per refattorizzare—non il punto di partenza.

I costi di manutenzione visibili scoraggiano la sovraingegnerizzazione

Progetta per il passo successivo

Crea uno schermo React per il happy path, poi espandi solo quando la realtà lo richiede.

La sovraingegnerizzazione spesso si nasconde dietro buone intenzioni: “Ne avremo bisogno dopo.” Il problema è che le astrazioni hanno costi ricorrenti che non emergono nel ticket iniziale.

Il conto reale per un'astrazione

Ogni nuovo layer introdotto crea di solito lavoro ricorrente:

- Superficie API: più metodi, parametri e casi limite da supportare (e mantenere compatibili a posteriori).

- Documentazione ed esempi: fare onboarding agli altri significa spiegare l'astrazione, non solo la funzionalità.

- Migrazioni: una volta che altro codice dipende da un'interfaccia generalizzata, modificarla richiede adapter, deprecazioni e note di rilascio.

- Matrice di test: il codice “generico” amplia gli scenari—più implementazioni, più mock, più punti di integrazione.

I flussi di lavoro guidati dall'IA rendono questi costi più difficili da ignorare perché possono rapidamente elencare cosa stai sottoscrivendo.

Usare l'IA per stimare la complessità: conta le parti mobili

Un prompt pratico è: “Elenca le parti mobili e le dipendenze introdotte da questo design.” Un buon assistente IA può scomporre il piano in elementi concreti come:

- nuovi moduli/package

- interfacce pubbliche e aspettative di versioning

- cambiamenti di schema DB e passi di migrazione

- chiamate cross-service e modalità di fallimento

- nuovi flag di configurazione, permessi o code

Vedere quell'elenco affiancato a un'implementazione più diretta trasforma gli argomenti di “clean architecture” in un tradeoff più chiaro: vuoi mantenere otto concetti nuovi per evitare una duplicazione che potresti non avere mai?

Un “budget di complessità” per mantenere l'onestà

Una policy leggera: limita il numero di concetti nuovi per funzionalità. Per esempio, consenti al massimo:

- 1 nuova API pubblica

- 1 nuova astrazione condivisa (interfaccia/classe base)

- 1 nuovo modello dati/tabella

Se la feature supera il budget, richiedi una giustificazione: quale cambiamento futuro abilita e quali evidenze hai che sia imminente? I team che usano l'IA per redigere questa giustificazione (e prevedere i compiti di manutenzione) tendono a scegliere passi più piccoli e reversibili—perché i costi a regime sono visibili prima della messa in produzione.

Quando l'IA può spingerti nella direzione sbagliata (e come evitarlo)

I flussi con IA spesso guidano verso passi piccoli e testabili—ma possono anche fare il contrario. Poiché l'IA è brava a produrre soluzioni “complete” rapidamente, può predefinire pattern familiari, aggiungere struttura extra o generare scaffolding non richiesto. Il risultato può essere più codice del necessario, prima del necessario.

Come l'IA incoraggia involontariamente la sovraingegnerizzazione

Un modello tende a essere premiato (percezionalmente) per sembrare accurato. Questo può tradursi in layer aggiuntivi, più file e design generalizzati che appaiono professionali ma non risolvono un problema reale e attuale.

Segnali d'allarme comuni includono:

- Nuove astrazioni senza un caso d'uso concreto (es.: “per flessibilità futura”)

- Layer extra: service → manager → adapter → factory, quando basterebbe una funzione

- Interfacce generiche con una sola implementazione

- Sistemi plugin, bus di eventi o dependency-injection introdotti troppo presto

- Un “framework dentro il framework” creato per standardizzare qualcosa che non si è ancora ripetuto

Mitigazioni per mantenere l'output IA ancorato

Tratta l'IA come mani veloci, non come un comitato di architettura. Alcuni vincoli aiutano molto:

- Vincola i prompt al presente. Chiedi il più piccolo cambiamento che soddisfa il requisito di oggi e vieta esplicitamente nuovi pattern a meno che non siano necessari.

- Richiedi esempi reali. Prima di accettare un'astrazione, esigi 2–3 call site concreti (o flussi utente) e assicurati che l'astrazione li semplifichi.

- Limita il cambiamento architetturale per iterazione. Consenti una sola modifica strutturale alla volta (es.: “introdurre un nuovo modulo” o “nessun nuovo layer in questa PR”).

- Verifica la cancellabilità. Se rimuovere il nuovo layer quasi non cambia il comportamento, probabilmente non se lo è meritato.

Una regola semplice: non permettere all'IA di generalizzare finché la codebase non manifesta un dolore ripetuto.

Un framework decisionale pratico: costruisci prima, astrai dopo

Prototipa in pochi minuti, non settimane

Rilascia una piccola porzione end-to-end per web, backend o mobile da un prompt in chat.

L'IA rende economico generare codice, rifattorizzare e provare alternative. È un dono—se lo usi per rimandare l'astrazione finché non te la sei guadagnata.

Passo 1: Parti concreti (ottimizza per l'apprendimento)

Inizia con la versione più semplice che risolve il problema di oggi per un solo “happy path”. Nomina le cose direttamente in base a ciò che fanno (non a ciò che potrebbero fare in futuro) e tieni le API strette. Se non sei sicuro se un parametro, un'interfaccia o un sistema plugin sia necessario, rilascia senza di esso.

Una regola utile: preferisci la duplicazione alla speculazione. Il codice duplicato è visibile e facile da cancellare; la generalità speculativa nasconde la complessità nell'indirezione.

Passo 2: Estrai più tardi (ottimizza per la stabilità)

Una volta che la funzionalità è usata e soggetta a cambiamenti, rifattorizza con evidenze. Con l'assistenza dell'IA puoi muoverti velocemente qui: chiedile di proporre un'estrazione, ma insisti su una diff minima e nomi leggibili.

Se il tuo tooling lo supporta, usa safety net che rendano i refactor a basso rischio. Per esempio, gli snapshot e il rollback di Koder.ai facilitano l'esperimento con i refactor in sicurezza, perché puoi tornare indietro rapidamente se il design “più pulito” si rivela peggiore nella pratica.

Quando l'astrazione è giustificata (checklist rapida)

Un'astrazione si guadagna il suo posto quando la maggior parte di questi punti è vera:

- Logica ripetuta: lo stesso comportamento esiste in 2–3 posti e gli aggiornamenti hanno già richiesto più modifiche.

- Variabilità provata: hai visto variazioni reali in produzione o in prototipi convalidati (non “potremmo aver bisogno di X un giorno”).

- Ownership chiara: una persona/team possiede l'astrazione, la documentazione e i futuri cambiamenti.

- Confine stabile: la forma input/output è rimasta coerente in almeno un paio di iterazioni.

- Semplificazione netta: l'estrazione riduce il codice totale e il carico cognitivo, non si limita a riorganizzarlo.

Un piccolo rituale: la revisione “una settimana dopo”

Aggiungi un promemoria una settimana dopo il rilascio di una funzionalità:

- Riapri la diff e annota cosa è cambiato dal rilascio.

- Identifica eventuali edit da copia-incolla o bug ricorrenti.

- Decidi uno dei tre esiti: mantieni concreto, estrai un piccolo helper, o introduci un modulo condiviso.

Questo mantiene la postura predefinita: costruisci prima, poi generalizza solo quando la realtà ti costringe.

Cosa misurare per mantenere l'ingegneria snella

L'ingegneria snella non è un sentimento—è qualcosa che puoi osservare. I flussi con IA rendono più facile rilasciare piccoli cambi rapidamente, ma servono alcuni segnali per notare quando il team ricade nel design speculativo.

Un piccolo set di metriche che catturano la sovraingegnerizzazione presto

Traccia pochi indicatori che correlano con l'astrazione inutile:

- Cycle time: tempo da “lavoro iniziato” a “merged e deployato”. Quando il tempo cresce senza un aumento chiaro dello scope, spesso significa più indirezioni o layer.

- Dimensione della diff: linee modificate (o file toccati) per cambiamento. Diff grandi sono più difficili da rivedere e invitano soluzioni generalizzate.

- Numero di concetti introdotti: conta nuovi moduli/servizi/package, nuove interfacce, nuovi knob di configurazione, primitive “da framework”. I concetti sono una tassa che paghi per sempre.

- Tasso di difetti: bug in produzione o ticket di supporto per release. Le astrazioni possono nascondere i casi limite; un aumento dei difetti dopo il “cleanup” è un segnale d'allarme.

- Tempo di onboarding: quanto ci mette un nuovo ingegnere a spedire la sua prima piccola modifica. Se l'onboarding rallenta, il sistema potrebbe ottimizzare per l'eleganza piuttosto che per la chiarezza.

Non serve perfezione—le linee di tendenza bastano. Rivedile settimanalmente o per iterazione e chiediti: “Abbiamo introdotto più concetti del necessario per il prodotto?”

Documentazione leggera che previene astrazioni misteriose

Richiedi una breve nota “perché esiste” ogni volta che qualcuno introduce una nuova astrazione (nuova interfaccia, layer helper, libreria interna, ecc.). Mantienila a poche righe nel README o come commento vicino al punto d'ingresso:

- Quale problema concreto ha risolto oggi?

- Quali alternative sono state provate?

- Cosa giustificherebbe la sua eliminazione?

Un piano d'azione per iniziare

Pilota un piccolo flusso di lavoro assistito dall'IA per un team per 2–4 settimane: breakdown dei ticket con l'IA, checklist di code review assistite dall'IA e casi di test generati dall'IA.

Alla fine, confronta le metriche sopra e fai una breve retro: mantieni ciò che ha ridotto cycle time e friction nell'onboarding; rollbacka ciò che ha aumentato il “numero di concetti introdotti” senza benefici misurabili per il prodotto.

Se cerchi un ambiente pratico per eseguire l'esperimento end-to-end, una piattaforma vibe-coding come Koder.ai può aiutare a trasformare queste piccole fette concrete in app distribuibili rapidamente (con esportazione del sorgente disponibile quando ne hai bisogno), rafforzando l'abitudine che questo articolo sostiene: lancia qualcosa di reale, impara, e solo allora astrai.