Perché le versioni iniziali grezze sono così comuni

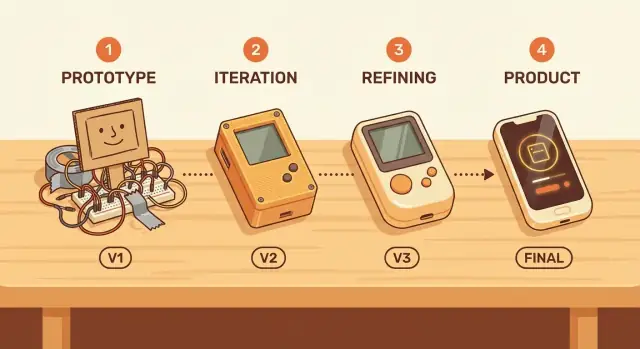

Una “versione iniziale grezza” non è la stessa cosa di una qualità trascurata. È un prodotto che funziona abbastanza bene da poter essere provato da persone reali, ma che ha ancora funzionalità mancanti, flussi macchinosi e molto spazio per migliorare. La differenza è l’intento: grezzo significa focalizzato e limitato; trascurato significa inaffidabile e pericoloso.

La perfezione è rara all’inizio perché la maggior parte di ciò che significa “perfetto” è sconosciuto fino a quando gli utenti non interagiscono con il prodotto. I team possono indovinare quali funzionalità contano, quale linguaggio ha senso o dove le persone resteranno bloccate—ma gli indizi spesso sono sbagliati. Anche chi ha esperienza scopre regolarmente che il problema reale che i clienti vogliono risolvere è leggermente diverso da quello immaginato.

Grezzo non significa “spedire spazzatura”

Lo scopo di un inizio imperfetto è l’apprendimento, non l’abbassamento degli standard. Una buona versione iniziale grezza rispetta comunque l’utente:

- Risolve un problema chiaro da un capo all’altro.

- È sufficientemente stabile perché i guasti siano l’eccezione, non la regola.

- Imposta aspettative oneste su ciò che è incluso (e su ciò che non lo è).

Quando i team adottano una mentalità di apprendimento prima di tutto, smettono di trattare il primo rilascio come un esame finale e iniziano a trattarlo come un test sul campo. Questo cambiamento rende più facile restringere lo scope, rilasciare prima e migliorare basandosi su prove invece che su opinioni.

Nelle sezioni successive vedrai esempi pratici—come rilasci in stile MVP e programmi per early adopter—e delle linee guida per evitare errori comuni (per esempio: come tracciare una linea netta tra “imperfetto” e “inascoltabile”, e come raccogliere feedback senza essere trascinati in richieste personalizzate infinite).

L’incertezza è più alta all’inizio

All’inizio della vita di un prodotto, la fiducia è spesso un’illusione. I team possono scrivere specifiche dettagliate e roadmap, ma le domande più importanti non si risolvono in una sala riunioni.

Cosa non puoi davvero sapere a priori

Prima che utenti reali tocchino il prodotto, stai indovinando su:

- Chi sono gli utenti davvero motivati (e quali descrizioni di “cliente ideale” sono desiderio più che realtà)

- Flussi di lavoro reali: come le persone svolgono il lavoro oggi, cosa si rifiutano di cambiare e cosa delegheranno volentieri al software

- Prezzi e disponibilità a pagare: ciò che suona giusto nelle interviste vs. ciò che porta a tirare fuori la carta di credito

- Canali di acquisizione: dove l’attenzione è accessibile, quali messaggi risuonano e cosa viene ignorato

Puoi ricercare tutto questo, ma non puoi confermarlo senza uso reale.

Perché i piani si rompono senza dati d’uso reali

La pianificazione tradizionale presume che tu possa prevedere i bisogni, dare priorità alle funzionalità e poi costruire verso una destinazione nota. I prodotti in fase iniziale sono pieni di incognite, quindi il piano è costruito su assunzioni. Quando quelle assunzioni sono sbagliate, non perdi solo una scadenza—costruisci la cosa sbagliata in modo efficiente.

Ecco perché i primi rilasci contano: trasformano i dibattiti in prove. I dati d’uso, i ticket di supporto, l’attrito, i tassi di attivazione e anche “l’abbiamo provato e poi smesso” sono segnali che chiariscono cosa è reale.

Le funzionalità “belle da avere” spesso nascondono assunzioni

Una lunga lista di miglioramenti può sembrare orientata al cliente, ma spesso contiene scommesse nascoste:

- “Gli utenti vorranno dashboard” presume che gli utenti controlleranno lo strumento frequentemente.

- “Ruoli e permessi team” presume adozione multi-utente fin dal primo giorno.

- “Integrazioni con tutto” presume che il costo di switching sia il tuo ostacolo principale.

Costruisci queste cose troppo presto e stai impegnando risorse su assunzioni prima di averle validate.

Apprendimento validato: progresso su cui puoi fidarti

L’apprendimento validato significa che l’obiettivo di una versione iniziale non è sembrare finita—è ridurre l’incertezza. Una versione iniziale grezza è di successo se ti insegna qualcosa di misurabile sul comportamento degli utenti, sul valore e sulla disponibilità a continuare.

Quell’apprendimento diventa la base per l’iterazione successiva—una basata su prove, non su speranza.

La velocità di apprendimento batte la velocità di costruzione

I team spesso considerano il progresso come “più funzionalità rilasciate”. Ma all’inizio, l’obiettivo non è costruire in fretta—è imparare in fretta. Una versione grezza che raggiunge utenti reali trasforma le assunzioni in evidenza.

Cicli di feedback brevi cambiano tutto

Quando rilasci presto, i loop di feedback si accorciano da mesi a giorni. Invece di dibattere cosa potrebbero fare gli utenti, vedi cosa fanno davvero.

Un modello comune:

- Mesi di ipotesi: scrivere lunghi documenti di requisiti, perfezionare design, costruire casi limite per problemi che nessuno ha confermato.

- Giorni di feedback reale: lanciare una versione piccola, osservare dove le persone si bloccano e aggiustare con chiarezza.

Quella velocità si compone. Ogni ciclo breve rimuove incertezza e previene il “costruire molto bene la cosa sbagliata”.

Apprendimento che puoi misurare

“Apprendere” non è una sensazione vaga. Anche prodotti semplici possono tracciare segnali che mostrano se l’idea funziona:

- Attivazione: le persone raggiungono il primo momento significativo (es. creare un progetto, invitare un collega, completare un’attività)?

- Ritenzione: tornano la settimana successiva senza essere sollecitati?

- Ticket di supporto e domande: cosa confonde gli utenti in modo ricorrente? Cosa chiedono a parole loro?

Queste metriche fanno più che convalidare. Indicano il prossimo miglioramento con maggiore fiducia rispetto alle opinioni interne.

Veloce, ma mai spericolato

La velocità non significa ignorare sicurezza o fiducia. I rilasci iniziali devono ancora proteggere gli utenti dai danni:

- Sii chiaro su cosa il prodotto fa e non fa.

- Evita funzionalità che potrebbero esporre dati sensibili o creare rischi finanziari/legali.

- Aggiungi protezioni di base (permessi, backup, annulla chiaro) prima dei “growth hack”.

Costruisci per l’apprendimento prima—tenendo gli utenti al sicuro—e la tua versione iniziale grezza diventa un passo intenzionale, non una scommessa.

MVP: piccoli rilasci che testano l’idea più rischiosa

Un MVP (minimum viable product) è la versione più piccola del tuo prodotto che può testare se una promessa chiave è preziosa per persone reali. Non è “la prima versione di tutto”. È il percorso più breve per rispondere a una domanda ad alto rischio come: Qualcuno lo userà? Lo pagherà? Cambierà la propria routine per questo?

Cos’è un MVP—e cosa non è

Un MVP è un esperimento focalizzato che puoi rilasciare, da cui imparare e migliorare.

Un MVP non è:

- Una demo lucida che evita l’uso reale

- Un rilascio “mezzo rotto” che frustra le persone

- Un ammasso di funzionalità che ritarda l’apprendimento

L’obiettivo è viable: l’esperienza dovrebbe funzionare end-to-end per un gruppo ristretto di utenti, anche se lo scope è piccolo.

Prodotti diversi possono testare lo stesso valore in forme differenti:

- Concierge MVP: offri il valore manualmente (high-touch) a pochi utenti. Ottimo per capire i bisogni e la disponibilità a pagare.

- “Manual behind the scenes” (Wizard-of-Oz): gli utenti vedono un’interfaccia semplice, ma il lavoro è svolto manualmente o con strumenti arrangiati internamente. Ottimo per validare la domanda prima di costruire l’automazione.

- Prodotto a funzionalità limitate: costruisci solo il flusso core che dimostra il beneficio principale, lasciando intenzionalmente fuori i “nice-to-have”. Ottimo quando l’interazione richiede software.

Parti dall’assunzione più rischiosa

Lo scope dell’MVP dovrebbe corrispondere alla tua incertezza maggiore. Se il rischio è la domanda, prioritizza il test dell’uso reale e dei segnali di pagamento. Se il rischio è il risultato, concentrati nel dimostrare che puoi fornire risultati in modo affidabile—anche se il processo è manuale.

Un modo pratico per supportare questo approccio è usare un flusso build-and-iterate che minimizza il costo di setup. Per esempio, una piattaforma vibe-coding come Koder.ai ti permette di prototipare web, backend o app mobile via chat, poi esportare il codice sorgente e distribuire—utile quando vuoi un MVP end-to-end reale senza impegnarti in un lungo ciclo di ingegneria prima di aver validato la promessa centrale.

La differenza tra “imperfetto” e “inascoltabile”

Una versione iniziale grezza può comunque essere un ottimo inizio—se aiuta una persona specifica a svolgere un compito specifico. “Sufficientemente buono” non è uno standard universale; dipende dal job-to-be-done dell’utente. Un percorso da prototipo a prodotto funziona meglio quando definisci chiaramente quel compito (per esempio: “inviare una fattura in meno di due minuti” o “condividere un file in modo sicuro con un solo link”).

Una soglia di qualità semplice: affidabile per il compito core

Un inizio imperfetto può essere piccolo e un po’ scomodo. Non può però essere inaffidabile sulla cosa che promette.

Una soglia pratica minima per un MVP:

- Il compito core funziona end-to-end, ogni volta, senza correzioni manuali.

- Gli errori sono comprensibili (niente fallimenti misteriosi).

- Gli utenti possono recuperare (annulla, riprova o istruzioni chiare).

Se il flusso core si rompe, i primi utilizzatori non possono fornire feedback utile—perché non raggiungono mai il momento in cui il prodotto offre valore.

Compromessi: meno funzionalità, più chiarezza

“Spedire in fretta” spesso va storto quando i team tagliano le cose sbagliate. Togliere funzionalità extra va bene; togliere chiarezza no. Un MVP dovrebbe preferire:

- Meno opzioni, ma impostazioni predefinite più chiare

- Onboarding semplice, non una lunga lista di funzionalità

- Un caso d’uso ben definito, non cinque supportati a metà

Questo rende l’iterazione più veloce perché il feedback riguarda ciò che conta, non la confusione.

Non negoziabili: accessibilità e prestazioni di base

Anche in un rilascio iniziale, accessibilità e prestazioni di base non dovrebbero essere trattate come “nice-to-have”. Se il testo non si può leggere, le azioni non si possono completare con la tastiera o le pagine impiegano troppo a caricare, non stai testando il product-market fit—stai testando la pazienza delle persone. Il miglioramento continuo inizia con una base che rispetta il tempo e i bisogni degli utenti.

Trovare il product-market fit richiede uso reale

Test a Mobile MVP

Valida la domanda con un MVP mobile Flutter senza mesi di setup.

Il product-market fit (PMF) si definisce meglio a parole semplici: gli utenti sentirebbero la tua mancanza se il prodotto sparisse. Non “gli piace l’idea”, non “hanno cliccato l’annuncio”, ma una dipendenza reale—qualcosa che hanno integrato nella loro routine.

Perché non puoi prevedere il PMF dall’interno

I team sono influenzati dalle proprie assunzioni. Conosci la roadmap, capisci i casi limite e puoi immaginare tutto il valore futuro. Ma i clienti non comprano la tua intenzione—they sperimentano ciò che esiste oggi.

Le opinioni interne soffrono anche di “dimensione del campione = persone come noi”. Colleghi, amici e tester iniziali spesso condividono il tuo contesto. L’uso reale introduce i vincoli disordinati che non puoi simulare: pressione temporale, alternative concorrenti e zero pazienza per flussi confusi.

Cerca comportamenti che suggeriscono che il prodotto risolve un problema ricorrente:

- Uso ripetuto: le persone tornano senza promemoria e l’uso si mantiene dopo che la novità passa.

- Referenze: gli utenti lo raccomandano spontaneamente perché li fa sembrare utili.

- Disponibilità a pagare: non solo dire “pagherei”, ma pagare davvero, aggiornare o accettare uno scambio significativo.

Non sovrastimare metriche di vanità

I numeri iniziali possono ingannare. Sii cauto con:

- Page view e iscrizioni che non si traducono in attivazione

- Picchi di trial gratuiti guidati da curiosità o promozioni

- Coinvolgimento sociale che indica interesse per l’argomento, non per il prodotto

Una versione iniziale grezza è preziosa perché ti porta rapidamente a questi check di realtà. Il PMF non è il risultato di una riunione—è un pattern che osservi quando utenti reali usano il prodotto.

I primi utilizzatori aiutano a plasmare il prodotto

I primi utilizzatori non tollerano i margini di errore perché amano i glitch—lo fanno perché il beneficio per loro è insolitamente alto. Sono persone con un problema ripetuto e acuto, che cercano attivamente una soluzione. Se la tua versione iniziale grezza rimuove un grande dolore (anche imperfettamente), scambieranno la lucidità con il progresso.

Perché i primi utilizzatori accettano le imperfezioni

I primi utilizzatori spesso:

- Pagano tempo o denaro per alternative macchinose (spreadsheet, controlli manuali, copia-incolla)

- Vivono il problema più intensamente degli utenti medi

- Sono disposti a investire sforzo se questo porta sollievo prima

Quando il “prima” è abbastanza doloroso, un “dopo” incompleto sembra comunque una vittoria.

Come trovare i primi utilizzatori giusti

Cerca dove il dolore viene già discusso: Slack/Discord di nicchia, subreddit, forum di settore e comunità professionali. Un segnale affidabile: persone che hanno costruito i propri hack (template, script, board Notion) per gestire il problema—ti stanno dicendo che hanno bisogno di uno strumento migliore.

Considera anche nicchie “adiacenti”—segmenti più piccoli con lo stesso job-to-be-done ma requisiti minori. Possono essere più facili da servire inizialmente.

Imposta aspettative apertamente

Sii esplicito su cosa è incluso e cosa no: cosa il prodotto può fare oggi, cosa è sperimentale, cosa manca e che tipo di problemi è probabile incontrare. Aspettative chiare prevengono delusioni e aumentano la fiducia.

Crea canali di feedback rapidi

Rendi il feedback semplice e immediato: un breve prompt in-app, un’email di risposta e qualche chiamata programmata con utenti attivi. Chiedi dettagli: cosa hanno provato a fare, dove si sono bloccati e cosa hanno fatto invece. Quel livello di dettaglio trasforma l’uso iniziale in una roadmap focalizzata.

I vincoli possono portare a decisioni migliori

Stretch Your MVP Budget

Ottieni crediti quando condividi ciò che hai costruito o riferisci altri a provare Koder.ai.

I vincoli hanno cattiva fama, ma spesso costringono a pensare in modo più chiaro. Quando tempo, budget o dimensione del team sono limitati, non puoi “risolvere” l’incertezza aggiungendo funzionalità. Devi decidere cosa conta di più, definire cosa significa successo e spedire qualcosa che provi (o confuti) il valore centrale.

I vincoli creano semplicità

Un vincolo stretto agisce come filtro: se una funzionalità non aiuta a validare la promessa principale, aspetta. Così ottieni soluzioni semplici e chiare—perché il prodotto è costruito attorno a un lavoro che fa bene, non a dieci lavori fatti male.

Questo è particolarmente utile all’inizio, quando stai ancora indovinando cosa vogliono davvero gli utenti. Più limiti lo scope, più è facile collegare un risultato a una modifica.

Aggiungere “nice-to-have” può mascherare il problema reale: la proposta di valore non è ancora nitida. Se gli utenti non sono entusiasti della versione più semplice, più funzionalità raramente risolvono—aggiungono solo rumore. Un prodotto ricco di funzionalità può sembrare pieno ma comunque non rispondere alla domanda fondamentale: “Perché dovrei usarlo?”

Esempi pratici di validazione guidata dai vincoli

Alcuni modi compatibili con i vincoli per testare l’idea più rischiosa:

- Test con landing page: scrivi una promessa chiara e una call to action (waitlist, richiesta demo, preordine). Se la conversione non avviene, hai imparato qualcosa senza costruire il prodotto.

- Prototipo invece della piattaforma: un prototipo cliccabile può validare se il flusso ha senso prima di investire in ingegneria.

- Strumento a funzionalità singola: molti prodotti nascono come una utility affilata (un report, un’automazione, un pulsante) a cui le persone tornano ripetutamente.

Dire “no” protegge il focus

Tratta il “no” come una competenza di prodotto. Dì no a funzionalità che non supportano l’ipotesi corrente, no a segmenti utente extra prima che uno funzioni e no alla lucidità che non cambia decisioni. I vincoli rendono quei “no” più facili—e mantengono il tuo prodotto iniziale onesto su ciò che consegna davvero.

Evitare la trappola dell’eccesso di costruzione

L’eccesso di costruzione avviene quando un team tratta il primo rilascio come il verdetto finale. Invece di testare l’idea centrale, il prodotto diventa un pacchetto di “nice-to-have” che sembra più sicuro di un esperimento chiaro sì/no.

Perché i team esagerano nel costruire

La paura è il motore principale: paura del feedback negativo, di sembrare poco professionali, o che un concorrente appaia più lucido.

Il confronto alimenta il fenomeno. Se ti confronti con prodotti maturi, è facile copiare il loro set di funzionalità senza notare che se le sono guadagnate con anni di uso reale.

La politica interna può spingere oltre. Le funzionalità extra diventano un modo per accontentare più stakeholder (“aggiungi questo così Sales può usarlo”, “aggiungi quello così Support non si lamenta”), anche se nulla dimostra che il prodotto sarà desiderato.

Il costo nascosto: il costo sommerso rallenta il cambiamento

Più costruisci, più è difficile cambiare direzione. Questo è l’effetto sunk cost: una volta che tempo, denaro e orgoglio sono investiti, i team difendono decisioni che andrebbero riviste.

Versioni sovrabbellite creano impegni costosi—codice complesso, onboarding più pesante, più casi limite, più documentazione, più riunioni di coordinamento. Poi anche miglioramenti ovvi sembrano rischiosi perché minacciano tutto quell’investimento.

Come le versioni grezze riducono lo spreco

Una versione iniziale grezza limita le opzioni in modo benefico. Mantenendo lo scope piccolo, impari prima se l’idea è preziosa e eviti di lucidare funzionalità che non conteranno.

Una regola semplice aiuta:

Costruisci la cosa più piccola che risponda a una domanda.

Esempi di “una domanda”:

- Le persone completeranno questo compito se rimuoviamo l’aiuto manuale?

- Gli utenti preferiscono l’opzione A o B quando devono scegliere?

- Questo problema è abbastanza urgente perché qualcuno torni domani?

Se il tuo “MVP” non può rispondere chiaramente a una domanda, probabilmente non è minimale—è solo un sovrabuilding in fase iniziale.

Rischi di rilasciare presto—e come gestirli

Rilasciare presto è utile, ma non è gratuito. Una versione iniziale grezza può creare danni reali se ignori i rischi.

I rischi più comuni

I rischi maggiori rientrano di solito in quattro categorie:

- Fiducia e credibilità: una prima esperienza piena di bug può far supporre che il prodotto sia trascurato o inaffidabile.

- Sicurezza e privacy: il codice iniziale spesso ha lacune—soprattutto su autenticazione, permessi e gestione dei dati.

- Perdita di dati: se gli utenti inseriscono informazioni e queste scompaiono, potrebbero non tornare mai più.

- Cattive prime impressioni: onboarding confuso o valore poco chiaro porta a churn “non capisco”.

Mitigazioni pratiche che ti mantengono in movimento

Puoi ridurre i danni senza rallentare eccessivamente:

- Etichettalo chiaramente: “Beta” o “Preview” imposta le aspettative. Dì cosa è pronto e cosa no.

- Limita l’accesso: inizia con un gruppo ristretto (solo su invito, lista d’attesa o segmento specifico) così gli errori restano contenuti.

- Backup e annulla: anche semplici garanzie—opzioni di export, cronologia versioni o backup notturni—proteggono gli utenti dai peggiori scenari.

- Percorsi di supporto chiari: un help email/chat visibile e risposte rapide possono salvare momenti traballanti e costruire fiducia.

Se usi una piattaforma per spedire rapidamente, cerca funzionalità di sicurezza che supportino l’iterazione iniziale. Per esempio, Koder.ai include snapshot e rollback (così puoi recuperare da un cattivo rilascio) e supporta deployment/hosting—utile quando vuoi muoverti in fretta senza trasformare ogni cambiamento in un evento ad alto rischio.

Rilasci graduali e feature flag (in termini semplici)

Invece di rilasciare a tutti in una volta, fai un rilascio graduale: prima il 5% degli utenti, poi il 25%, poi il 100% man mano che aumenti la fiducia.

Una feature flag è un semplice interruttore che ti permette di attivare o disattivare una nuova funzione senza ridistribuire tutto. Se qualcosa si rompe, la spegni e il resto del prodotto continua a funzionare.

Quando non dovresti rilasciare presto

Non “testare in produzione” quando le poste in gioco sono alte: funzionalità legate alla sicurezza, requisiti legali/compliance, pagamenti o dati personali sensibili, o qualsiasi cosa che richieda affidabilità critica (es. ambito medico, emergenze, finanza centrale). In quei casi, valida con prototipi, test interni e pilot controllati prima dell’uso pubblico.

Test One Big Assumption

Trasforma una promessa centrale in un'app web o backend funzionante da mettere nelle mani degli utenti.

Lanciare una versione iniziale grezza è utile solo se trasformi le reazioni reali in decisioni migliori. L’obiettivo non è “più feedback”—è un loop di apprendimento costante che rende il prodotto più chiaro, veloce e facile da usare.

Cosa misurare (per non indovinare)

Inizia con pochi segnali che riflettono se le persone ottengono realmente valore:

- Attivazione: quale percentuale raggiunge il momento “aha” (es. completa un primo progetto, invita un collega, pubblica qualcosa)

- Time-to-value: quanto tempo serve per ottenere il primo risultato

- Ritenzione: chi torna dopo un giorno/settimana/mese

- Motivi di churn: il perché dietro cancellazioni o abbandoni (prezzo, funzionalità mancanti, confusione, scarsa corrispondenza)

Queste metriche ti aiutano a separare “curiosità” da “successo”.

Raccogli feedback qualitativo che spiega i numeri

I numeri ti dicono cosa è successo. Il feedback qualitativo spiega perché.

Usa una combinazione di:

- Brevi interviste con nuovi utenti (15 minuti bastano)

- Sondaggi leggeri dopo momenti chiave (“Cosa era confuso?” “Cosa ti ha quasi fermato?”)

- Log di supporto e trascrizioni chat (spesso il feedback più onesto)

Cattura le esatte frasi degli utenti. Quelle parole sono carburante per onboarding migliori, pulsanti più chiari e pagine prezzi più semplici.

Non fare una lista di tutto ciò che viene richiesto. Raggruppa gli input in temi, poi prioritizza per impatto (quanto migliora attivazione/ritenzione) e sforzo (quanto è difficile da realizzare). Una piccola correzione che rimuove un grosso punto di confusione spesso batte una grande nuova funzionalità.

Collega l’apprendimento a un ritmo di rilascio regolare—aggiornamenti settimanali o bisettimanali—così gli utenti vedono progressi e tu continui a ridurre l’incertezza a ogni iterazione.

Un framework pratico per iniziare imperfetti e avere successo

Una versione iniziale grezza funziona quando è intenzionalmente grezza: focalizzata nel provare (o confutare) una scommessa chiave, ma abbastanza affidabile perché persone reali la provino.

Step 1: Scegli una promessa centrale

Scrivi una frase che spieghi il lavoro che il tuo prodotto farà per l’utente.

Esempi:

- “Aiutare i freelance a inviare una fattura in meno di 2 minuti.”

- “Permettere ai team di vedere le vendite di ieri in un’unica schermata.”

Se il tuo MVP non riesce a mantenere chiaramente quella promessa, non è pronto—indipendentemente da quanto sia rifinita l’interfaccia.

Step 2: Fissa una soglia di qualità chiara (imperfetto, non inascoltabile)

Decidi cosa deve essere vero affinché gli utenti si fidino dell’esperienza.

Checklist:

- Promessa centrale: qual è l’unico risultato che garantisci?

- Soglia di qualità: cosa renderebbe l’esperienza rotta o rischiosa (totali errati, perdita dati, checkout confuso, ecc.)?

- Metriche di successo: quali numeri ti diranno che funziona (tasso di attivazione, uso ripetuto, time-to-value, ritenzione a 7 giorni)?

Step 3: Definisci il test più piccolo che può insegnarti qualcosa

Riduci lo scope fino a poter rilasciare velocemente senza indebolire il test. Una buona regola: taglia funzionalità che non cambiano la decisione che prenderai dopo il lancio.

Chiedi:

- Qual è l’assunzione più rischiosa?

- Qual è il modo più rapido per validarla con uso reale?

Se il collo di bottiglia è la velocità di implementazione, considera una toolchain che accorcia il percorso idea → software funzionante. Per esempio, Koder.ai può generare una web app React, un backend Go + PostgreSQL, o una app mobile Flutter da una specifica guidata in chat, poi permetterti di esportare il codice quando sei pronto a possedere il repo—utile per arrivare a un test utente reale più in fretta.

Step 4: Esegui un ciclo di feedback breve

Rilascia a un gruppo piccolo e specifico, poi raccogli feedback in due canali:

- Comportamento: cosa fanno effettivamente (abbandoni, ripetizioni, time-to-value)

- Conversazione: chiamate da 10–15 minuti o brevi sondaggi che si concentrano sul risultato, non sulle opinioni

Suggerimento di timeline (per un piano articolo ~3000 parole)

- Settimana 1: scegli la promessa centrale + soglia di qualità, raccogli 3–5 user stories

- Settimana 2: costruisci solo ciò che serve per mantenere la promessa una volta

- Settimana 3: rilascia ai primi utenti, misura, fai interviste

- Settimana 4: stringi l’esperienza intorno a ciò che viene usato; rimuovi ciò che non serve

Invito all’azione

Dedica cinque minuti oggi: scrivi la tua promessa centrale, elenca la soglia di qualità e cerchia l’assunzione più rischiosa. Poi riduci lo scope dell’MVP finché non può testare quell’assunzione nelle prossime 2–3 settimane.

Se vuoi altri template ed esempi, sfoglia i post correlati in /blog.