Cosa sono i runtime JavaScript e perché contano

JavaScript è il linguaggio. Un runtime JavaScript è l’ambiente che rende il linguaggio utile fuori dal browser: incorpora un motore JavaScript (come V8) e gli fornisce le funzionalità di sistema che le app reali richiedono—accesso ai file, networking, timer, gestione dei processi e API per crittografia, stream e altro.

Se il motore è il “cervello” che capisce JavaScript, il runtime è l’intero “corpo” che può parlare con il sistema operativo e Internet.

Dove compaiono i runtime

I runtime moderni non servono solo per i server web. Alimentano:

- Server e API (app backend tradizionali)

- Strumenti CLI (formatter, tool di build, script di automazione)

- Funzioni edge (codice che gira vicino agli utenti, spesso con limiti più stringenti)

- App desktop (spesso tramite framework che includono un runtime)

Lo stesso linguaggio può girare in tutti questi contesti, ma ogni ambiente ha vincoli diversi—tempo di avvio, limiti di memoria, confini di sicurezza e API disponibili.

Perché esistono più runtime (e cambiano continuamente)

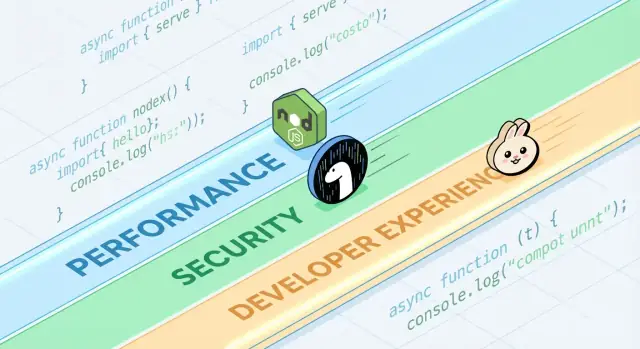

I runtime evolvono perché gli sviluppatori vogliono compromessi diversi. Alcuni privilegiano la massima compatibilità con l’ecosistema Node.js esistente. Altri puntano a default di sicurezza più rigidi, migliore ergonomia TypeScript o avvii a freddo più rapidi per gli strumenti.

Anche se due runtime condividono lo stesso motore, possono differire molto in:

- API integrate e supporto degli standard

- Approccio alla gestione dei pacchetti

- Modello di permessi e sandboxing

- Esperienza di tooling (test, formattazione, bundling)

Cosa significa davvero “competere”

La competizione non riguarda solo la velocità. I runtime competono per adozione (community e mindshare), compatibilità (quanto codice esistente “funziona così com’è”) e fiducia (postura di sicurezza, stabilità, manutenzione a lungo termine). Questi fattori determinano se un runtime diventa una scelta di default o rimane uno strumento di nicchia da usare solo in progetti specifici.

Un rapido tour dei runtime popolari

Quando si parla di “runtime JavaScript”, di solito si intende “l’ambiente che esegue JS fuori (o dentro) un browser, più le API che usi per costruire le cose”. Il runtime che scegli influenza come leggi file, avvii server, installi pacchetti, gestisci permessi e fai debugging in produzione.

Esempi comuni

Node.js è il default di lunga data per JavaScript lato server. Ha l’ecosistema più ampio, tooling maturo e una forte spinta dalla community.

Deno è stato progettato con default moderni: supporto TypeScript di prima classe, postura di sicurezza più rigorosa per default e un approccio di libreria standard “batteries included”.

Bun punta molto sulla velocità e sulla comodità per lo sviluppatore, unendo un runtime veloce con una toolchain integrata (installazione pacchetti, test) pensata per ridurre la configurazione.

I runtime del browser (Chrome, Firefox, Safari) restano i runtime JS più diffusi in assoluto. Sono ottimizzati per l’interfaccia utente e forniscono Web API come DOM, fetch e storage—ma non offrono accesso diretto al file system come i runtime server.

Cosa hanno in comune i runtime

La maggior parte dei runtime abbina un motore JavaScript (spesso V8) con un event loop e un insieme di API per networking, timer, stream e altro. Il motore esegue il codice; l’event loop coordina il lavoro asincrono; le API sono ciò che usi quotidianamente.

Cosa differisce (e perché conta nella pratica)

Le differenze emergono in funzionalità integrate (ad esempio gestione nativa di TypeScript), tooling di default (formatter, linter, test runner), compatibilità con le API di Node e modelli di sicurezza (per esempio accesso file/network libero o basato su permessi). Per questo la scelta del runtime non è astratta: influisce su quanto velocemente avvii un progetto, su quanto è sicuro eseguire script e su quanto è doloroso (o fluido) il deployment e il debugging.

Prestazioni: le metriche su cui i runtime si confrontano

“Veloce” non è un singolo valore. Un runtime può apparire eccellente in un grafico e ordinario in un altro, perché ottimizza definizioni diverse di velocità.

Latency vs throughput

La latenza è quanto rapidamente una singola richiesta termina; il throughput è quante richieste puoi completare al secondo. Un runtime ottimizzato per avvio rapido e risposte veloci può sacrificare throughput massimo sotto alta concorrenza, e viceversa.

Per esempio, un’API che serve profili utente si preoccupa della latenza di coda (p95/p99). Un job batch che elabora migliaia di eventi al secondo guarda più al throughput e all’efficienza in stato stazionario.

Cold start (serverless e CLI)

Il cold start è il tempo che va da “nulla in esecuzione” a “pronto per lavorare”. Conta molto per le funzioni serverless che scalano a zero e per gli strumenti CLI che gli utenti eseguono spesso.

I cold start dipendono da caricamento dei moduli, transpiling TypeScript (se presente), inizializzazione delle API integrate e da quanto lavoro fa il runtime prima che il tuo codice venga eseguito. Un runtime può essere molto veloce una volta caldo, ma dare la sensazione di lentezza se impiega tempo extra per avviarsi.

Prestazioni I/O: rete, file system, stream

Gran parte del JavaScript server-side è legato all’I/O: richieste HTTP, chiamate al database, lettura file, streaming dati. Qui, le prestazioni dipendono spesso dall’efficienza dell’event loop, dalla qualità dei binding I/O asincroni, dalle implementazioni di stream e da quanto bene viene gestita la backpressure.

Piccole differenze—come la velocità con cui il runtime analizza gli header, pianifica timer o svuota i buffer di scrittura—possono trasformarsi in guadagni tangibili in web server e proxy.

Lavoro CPU-bound: punti di forza e limiti del motore

Attività pesanti in CPU (parsing, compressione, elaborazione immagini, crypto, analisi) mettono sotto stress il motore JavaScript e il JIT. I motori possono ottimizzare i percorsi caldi, ma JavaScript ha ancora limiti per carichi numerici prolungati.

Se domina il lavoro CPU-bound, il “runtime più veloce” potrebbe essere quello che rende più semplice spostare i loop caldi in codice nativo o usare worker thread senza complessità.

Controllo della realtà dei benchmark (e trappole comuni)

I benchmark possono essere utili, ma sono facili da fraintendere—soprattutto quando vengono trattati come classifiche universali. Un runtime che “vince” un grafico potrebbe comunque essere più lento per la tua API, la tua pipeline di build o il tuo job di elaborazione dati.

Microbenchmark vs applicazioni reali

I microbenchmark testano di norma una singola operazione piccola (parsing JSON, regex, hashing) in un loop ristretto. Serve per misurare un ingrediente, non il pasto completo.

Le app reali spendono tempo in cose che i microbenchmark ignorano: attese di rete, chiamate al database, I/O su file, overhead di framework, logging e pressione di memoria. Se il tuo carico è perlopiù I/O-bound, un ciclo CPU del 20% più veloce potrebbe non muovere affatto la latenza end-to-end.

I risultati cambiano con carico, OS e versioni

Piccole differenze nell’ambiente possono capovolgere i risultati:

- Forma del carico: molte richieste piccole vs poche grandi; streaming vs buffering.

- OS e hardware: Linux vs macOS; CPU diverse; limiti in container.

- Versioni del runtime e dipendenze: aggiornamenti del motore, differenze di libc e cambi nelle librerie possono dominare.

Quando vedi uno screenshot di benchmark, chiedi quali versioni e flag sono stati usati—e se corrispondono al tuo setup di produzione.

Warm-up (JIT) e effetti di cache

I motori JavaScript usano JIT: il codice può girare più lento all’inizio e poi accelerare quando l’engine “impara” i percorsi caldi. Se un benchmark misura solo i primi secondi, può premiare le cose sbagliate.

La cache conta: cache su disco, cache DNS, keep-alive HTTP e cache applicative possono rendere le esecuzioni successive molto più veloci. È reale, ma va controllato.

Progettare test equi e ripetibili

Punta a benchmark che rispondano alle tue domande, non a quelle di altri:

- Misura end-to-end: includi framework + middleware tipici + dimensioni payload realistiche.

- Separa cold vs warm: registra avvio, prima richiesta e stato stazionario.

- Esegui più tentativi: riporta mediana e varianza, non solo la migliore esecuzione.

- Blocca l’ambiente: fissa le versioni, isola la CPU e documenta i comandi.

Se ti serve un template pratico, cattura l’harness di test in un repo e documentalo nei tuoi manuali interni (o in una pagina /blog) così i risultati possono essere riprodotti in seguito.

Sotto il cofano: motori, API e modelli di esecuzione

Ship an app, not debates

Turn your idea into a React web app plus backend, then decide where JS runtimes fit.

Quando si confrontano Node.js, Deno e Bun, spesso si parla di feature e benchmark. Sotto, la “sensazione” di un runtime è modellata da quattro parti principali: il motore JavaScript, le API integrate, il modello di esecuzione (event loop + scheduler) e come il codice nativo è collegato.

Motori: V8, JavaScriptCore e perché contano

Il motore è la parte che analizza ed esegue JavaScript. V8 (usato da Node.js e Deno) e JavaScriptCore (usato da Bun) fanno ottimizzazioni avanzate come JIT e garbage collection.

Nella pratica, la scelta del motore può influenzare:

- Tempo di avvio e comportamento della memoria (quanto velocemente un processo diventa utile)

- Prestazioni del “codice caldo” dopo che le ottimizzazioni entrano in gioco

- Quali feature di basso livello compaiono per prime (alcuni motori introducono nuove capacità JS prima di altri)

API integrate: più di un semplice “posso fetchare?”

I runtime moderni competono su quanto completa sembri la loro libreria standard. Avere built-in come fetch, Web Streams, utility URL, API file e crypto può ridurre la proliferazione di dipendenze e rendere il codice più portabile tra server e browser.

Il problema: lo stesso nome di API non sempre significa comportamento identico. Differenze in streaming, timeout o file watching possono influenzare le app reali più della pura velocità.

Modelli di esecuzione: event loop, scheduler e binding nativi

JavaScript è single-threaded nella parte alta, ma i runtime coordinano lavoro in background (networking, I/O su file, timer) tramite un event loop e scheduler interni. Alcuni runtime si affidano molto a binding nativi (codice compilato) per I/O e task critici per le prestazioni, mentre altri enfatizzano interfacce web-standard.

WebAssembly: quando aiuta

WebAssembly (Wasm) è utile quando servono calcoli veloci e prevedibili (parsing, elaborazione immagini, compressione) o per riutilizzare codice in Rust/C/C++. Non velocizzerà magicamente un tipico server I/O-bound, ma può essere uno strumento valido per moduli CPU-bound.

Sicurezza: default, permessi e realtà della supply-chain

“Secure by default” in un runtime JavaScript generalmente significa che il runtime considera il codice non affidabile finché non gli concedi esplicitamente l’accesso. Questo ribalta il modello server tradizionale (dove gli script spesso possono leggere file, chiamare la rete e ispezionare variabili d’ambiente di default) verso un approccio più cauto.

Molti incidenti reali iniziano però prima che il tuo codice venga eseguito—dentro le dipendenze e il processo di installazione—quindi la sicurezza a livello di runtime è uno strato, non tutta la strategia.

Prompt di permesso e allowlist

Alcuni runtime possono limitare capacità sensibili dietro permessi. Nella pratica, questo prende la forma di un’allowlist:

- File system: permettere lettura/scrittura solo su percorsi specifici (es., una directory di config)

- Network: permettere richieste solo verso host/porte approvati

- Variabili d’ambiente: esporre solo chiavi specifiche invece dell’intero process env

Questo può ridurre fughe accidentali di dati (come l’invio di segreti a endpoint non previsti) e limitare il raggio d’azione quando esegui script di terze parti—soprattutto in CLI, tool di build e automazione.

Sandboxing ha dei limiti

I permessi non sono una protezione magica. Se concedi accesso di rete a “api.mycompany.com”, una dipendenza compromessa può comunque esfiltrare dati verso lo stesso host. E se permetti la lettura di una directory, stai fidandoti di tutto ciò che c’è dentro. Il modello aiuta a esprimere intenzioni, ma serve comunque vetting delle dipendenze, lockfile e revisioni attente di ciò che si concede.

Default sicuri nelle API comuni

La sicurezza vive anche nei piccoli default:

- TLS/HTTPS: validazione dei certificati sensata e impostazioni di protocollo moderne di default

- HTTP: comportamento sicuro sui redirect e controllo chiaro su header/cookie

- API crypto: primitive moderne con interfacce difficili da usare in modo sbagliato

Il compromesso è attrito: default più severi possono rompere script legacy o aggiungere flag da mantenere. La scelta migliore dipende dal valore che dai alla comodità per servizi fidati rispetto ai guardrail per codice a fiducia mista.

Rischi della supply-chain da non ignorare

Gli attacchi alla supply-chain spesso sfruttano come i pacchetti vengono scoperti e installati:

- Typosquatting: pacchetto malevolo con un nome molto simile a uno popolare (es.,

expresss).

- Dependency confusion: un pacchetto pubblico pubblicato con lo stesso nome di uno interno, che inganna gli installer.

- Maintainer compromessi: un takeover dell’account pubblica un aggiornamento “legittimo” con codice iniettato.

Questi rischi riguardano qualsiasi runtime che scarica da un registro pubblico—quindi l’igiene conta quanto le feature del runtime.

Lockfile, controlli di integrità e provenienza

I lockfile fissano versioni esatte (incluse le dipendenze transitive), rendendo le installazioni riproducibili e riducendo aggiornamenti a sorpresa. I controlli di integrità (hash registrati nel lockfile o metadata) aiutano a rilevare manomissioni durante il download.

La provenienza è il passo successivo: poter rispondere “chi ha costruito questo artefatto, da quale sorgente, usando quale workflow?”. Anche se non adotti ancora tooling di provenienza completo, puoi avvicinarti preferendo pacchetti ben mantenuti, evitando dipendenze Git non fissate per build di produzione e richiedendo tag/release invece di commit casuali.

Workflow di audit e aggiornamenti che funzionano

Tratta le dipendenze come manutenzione routinaria:

- esegui audit automatici in CI su ogni pull request,

- programma finestre regolari di aggiornamento (settimanali/bi-settimanali) per evitare grandi salti,

- leggi i changelog per aggiornamenti maggiori e fix di sicurezza.

Policy di team che non rallentino la consegna

Regole leggere vanno lontano:

- blocca nuove dipendenze a meno che non ci sia un bisogno chiaro e un owner,

- limita gli script di install dove possibile (sono vie comuni di esecuzione),

- usa un registro privato o package scoped per nomi interni per ridurre la confusione.

Una buona igiene è meno questione di perfezione e più di abitudini coerenti e noiose.

Compatibilità ed ecosistema come vantaggi competitivi

Prestazioni e sicurezza fanno notizia, ma spesso sono compatibilità ed ecosistema a decidere cosa viene effettivamente messo in produzione. Un runtime che esegue il tuo codice esistente, supporta le tue dipendenze e si comporta in modo coerente tra gli ambienti riduce il rischio più di qualsiasi singola feature.

La compatibilità influisce su sicurezza e manutenzione

La compatibilità non è solo comodità. Pochi riscritture significano meno possibilità di introdurre bug sottili e meno patch una tantum che poi dimentichi di aggiornare. Gli ecosistemi maturi tendono anche ad avere modalità di failure note: le librerie comuni sono più spesso auditate, i problemi documentati e le mitigazioni più facili da trovare.

D’altro canto, la “compatibilità a tutti i costi” può mantenere in vita pattern legacy (come accessi troppo ampi a file/rete), quindi i team devono comunque definire confini chiari e mantenere buona igiene delle dipendenze.

Layer di compatibilità Node vs API web-standard

I runtime che mirano a essere drop-in compatibili con Node.js possono eseguire la maggior parte del codice server-side immediatamente, il che è un enorme vantaggio pratico. I layer di compatibilità possono colmare le differenze, ma possono anche nascondere comportamenti specifici del runtime—soprattutto attorno a filesystem, networking e risoluzione moduli—rendendo il debugging più difficile quando qualcosa si comporta diversamente in produzione.

Le API web-standard (come fetch, URL e Web Streams) spingono il codice verso la portabilità tra runtime e persino ambienti edge. Il compromesso: alcuni pacchetti Node-specifici assumono internals di Node e non funzioneranno senza shim.

Ecosistema NPM: punti di forza e compromessi

La forza più grande di NPM è semplice: ha quasi tutto. Questa ampiezza accelera la consegna, ma aumenta l’esposizione al rischio della supply-chain e al gonfiore di dipendenze. Anche se un pacchetto è “popolare”, le sue dipendenze transitive possono sorprenderti.

Quando “funziona ovunque” batte le nuove feature

Se la tua priorità è deployment prevedibili, assunzioni più semplici e meno sorprese d’integrazione, “funziona ovunque” spesso è la caratteristica vincente. Le nuove capacità del runtime sono entusiasmanti—ma la portabilità e un ecosistema provato possono farti risparmiare settimane nel ciclo di vita di un progetto.

Experiment with an easy rollback

Iterate on a prototype safely with snapshots and rollback when experiments go sideways.

L’esperienza sviluppatore è dove i runtime vincono o perdono silenziosamente. Due runtime possono eseguire lo stesso codice e però risultare totalmente diversi quando configuri un progetto, inseguendo un bug o cercando di consegnare un servizio piccolo rapidamente.

Supporto TypeScript: integrato vs “porta il tuo”

TypeScript è un buon indicatore di DX. Alcuni runtime lo trattano come input di prima classe (puoi eseguire file .ts con poca cerimonia), mentre altri si aspettano una toolchain tradizionale (tsc, bundler, o un loader) che configuri da te.

Nessun approccio è universalmente “migliore”:

- Il supporto integrato riduce la configurazione e può standardizzare i default nel team.

- Il tooling configurato dà maggiore controllo su tsconfig, target di emissione e output—utile per librerie e monorepo più grandi.

La domanda chiave è se la storia TypeScript del tuo runtime coincide con il modo in cui il tuo team effettivamente distribuisce codice: esecuzione diretta in dev, build compilati in CI, o entrambi.

Bundling, transpiling e default per i test

I runtime moderni sempre più spesso includono tooling opinabili: bundler, transpiler, linter e test runner pronti out of the box. Questo può eliminare il costo di scegliere lo stack per progetti piccoli.

Ma i default sono positivi per la DX solo quando sono prevedibili:

- Puoi cambiare facilmente formati di output (ESM/CJS), target e dipendenze esterne?

- Il test runner si integra bene con coverage e CI?

- La configurazione è minima e stabile attraverso le versioni?

Se inizi spesso nuovi servizi, un runtime con buone integrazioni built-in e documentazione può far risparmiare ore per progetto.

Debugging: stack trace, sourcemap e inspector

Il debugging è dove la cura del runtime si vede chiaramente. Stack trace di qualità, gestione corretta delle sourcemap e un inspector che “funziona” determinano quanto velocemente comprendi i problemi.

Cerca:

- Errori chiari che puntano al tuo sorgente (non al codice generato)

- Stack trace async affidabili

- Buona integrazione con editor e inspector in stile Chrome DevTools

Template e scaffolding che riducono l’attrito

I generatori di progetti possono essere sottovalutati: un template pulito per un’API, una CLI o un worker spesso dà il tono al codebase. Preferisci scaffold che creino una struttura minima ma pronta per la produzione (logging, gestione env, test), senza bloccarti in un framework pesante.

Se cerchi ispirazione, vedi le guide correlate in /blog.

Nella pratica, i team a volte usano Koder.ai per prototipare un piccolo servizio o CLI in diversi “stili runtime” (Node-first vs API web-standard), poi esportano il codice generato per un vero passaggio di benchmark. Non sostituisce i test di produzione, ma può accorciare il tempo da idea → confronto eseguibile quando valuti i compromessi.

La gestione dei pacchetti plasma la DX

La gestione dei pacchetti è dove la “developer experience” diventa tangibile: velocità di installazione, comportamento del lockfile, supporto workspace e quanto affidabile sia CI nel riprodurre una build. I runtime sempre più spesso trattano questo come una feature di prima classe.

Node.js storicamente si è appoggiato a tooling esterno (npm, Yarn, pnpm), il che è forza (scelta) e fonte di incoerenza tra team. I runtime più nuovi portano opinioni: Deno integra la gestione dipendenze via deno.json (e supporta pacchetti npm), mentre Bun include un installer veloce e un lockfile.

Questi tool nativi spesso ottimizzano per meno round-trip di rete, caching aggressivo e integrazione stretta con il loader dei moduli del runtime—utile per cold start in CI e per far onboard di nuovi colleghi.

Monorepo, workspace e basi di caching

La maggior parte dei team arriva a bisogno di workspace: pacchetti interni condivisi, versioni consistenti delle dipendenze e regole di hoisting prevedibili. npm, Yarn e pnpm supportano workspace ma differiscono in uso disco, layout di node_modules e deduplicazione. Questo incide su tempo di install, risoluzione editor e bug “funziona sulla mia macchina”.

Il caching è altrettanto importante. Una buona baseline è fare cache dello store del package manager (o della cache di download) più passi di install basati su lockfile, poi mantenere gli script deterministici. Se vuoi un punto di partenza semplice, documentalo insieme ai tuoi step di build in /docs.

Pubblicazione e consumo: cosa serve ai team

La pubblicazione interna di pacchetti (o il consumo di registri privati) ti spinge a standardizzare auth, URL dei registry e regole di versioning. Assicurati che il tuo runtime/tooling supporti le stesse convenzioni .npmrc, controlli di integrità e aspettative di provenienza.

Preoccupazioni di migrazione: cambi di lockfile e aggiustamenti CI

Cambiare package manager o adottare un installer incluso nel runtime tipicamente cambia lockfile e comandi di install. Pianifica churn nelle PR, aggiorna le immagini CI e allinea un unico lockfile “fonte di verità”—altrimenti debuggherai drift delle dipendenze invece di consegnare feature.

Scegliere un runtime in base al caso d’uso (non all’hype)

Compare Node vs web APIs

Prototype a Node compatible version and a web standard API version side by side.

Scegliere un runtime JavaScript è meno questione di “chi vince la classifica” e più di forma del tuo lavoro: come distribuisci, con cosa devi integrarti e quanto rischio può sostenere il tuo team. Una buona scelta è quella che riduce l’attrito per i tuoi vincoli.

Workload serverless e edge

Qui contano tanto il cold-start quanto il comportamento in concorrenza quanto il throughput. Cerca:

- Tempo di avvio (quanto velocemente una funzione inizia a gestire richieste)

- Modello di isolamento (processi vs isolate/stile worker)

- Disponibilità API (Web API, fetch, stream, crypto) nella piattaforma target

Node.js è ampiamente supportato dai provider; le API web-standard e il modello permessi di Deno possono essere attraenti quando disponibili; la velocità di Bun può aiutare, ma verifica supporto della piattaforma e compatibilità edge prima di impegnarti.

CLI e automazione

Per utility da linea di comando, la distribuzione può dominare la decisione. Prioritizza:

- Build in singolo binario e install prevedibili

- Comportamento cross-platform (macOS, Windows, Linux)

- Avvio rapido e buona ergonomia per lo sviluppatore

Il tooling integrato di Deno e la distribuzione facilitata sono forti per le CLI. Node.js è solido quando ti serve la vastità di npm. Bun può andare bene per script veloci, ma valida il packaging e il supporto Windows per il tuo pubblico.

Container e servizi long-running

Nei container, stabilità, comportamento della memoria e osservabilità spesso pesano più dei benchmark di copertina. Valuta l’uso di memoria in stato stazionario, il comportamento del GC sotto carico e la maturità degli strumenti di debug/profiling. Node.js tende a essere il “default sicuro” per servizi di lunga durata grazie alla maturità dell’ecosistema e alla familiarità operativa.

I vincoli del team battono la novità

Scegli il runtime che si allinea con le competenze del team, le librerie e l’operatività (CI, monitoraggio, incident response). Se un runtime costringe a riscritture, nuovi workflow di debugging o pratiche di dipendenza poco chiare, qualsiasi guadagno in prestazioni può essere annullato dal rischio di delivery.

Se l’obiettivo è consegnare velocemente funzionalità di prodotto (non solo discutere sui runtime), considera dove JavaScript è effettivamente critico nello stack. Per esempio, Koder.ai si concentra sulla costruzione di applicazioni complete via chat—frontend web in React, backend in Go con PostgreSQL e app mobile in Flutter—quindi i team spesso riservano le decisioni sul runtime JS ai punti in cui Node/Deno/Bun contano davvero (tooling, script edge o servizi JS esistenti), continuando a muoversi velocemente con una baseline pronta per la produzione.

Checklist decisionale e prossimi passi

Scegliere un runtime è più questione di ridurre il rischio migliorando i risultati per il team e il prodotto.

Una breve checklist

- Test di performance: conosci i tuoi 3 colli di bottiglia principali (tempo di avvio, throughput richieste, lavoro CPU-bound, latenza I/O)? Riesci a riprodurli localmente e in CI?

- Esigenze di sicurezza: ti serve un modello di permessi (accesso file/rete/env), sandboxing più rigido o controlli per conformità?

- Priorità DX: quale attrito ti costa di più oggi—setup TypeScript, debugging, hot reload, tooling di test o packaging per il deployment?

Domande da porsi prima di cambiare runtime

- Quale problema stiamo risolvendo: costo, latenza, velocità sviluppatore o sicurezza?

- Quali parti del sistema sono sensibili al runtime (funzioni edge, CLI, API, job in background)?

- Siamo vincolati a comportamenti di un ecosistema di pacchetti (addon nativi, script postinstall, aspettative CommonJS/ESM)?

- Qual è il piano di rollback se una dipendenza o integrazione piattaforma si comporta diversamente?

- Chi sarà responsabile degli upgrade del runtime e del monitoraggio dei breaking change?

Un piano pilota pratico

Inizia in piccolo e misurabile:

- Scegli un servizio o strumento interno con input/output chiari (es., un webhook handler, una CLI, un piccolo worker).

- Definisci metriche di successo: p95 latency, memoria, CPU, tempo di build, cold start e tempo sviluppatore per risolvere.

- Esegui il pilot in due ambienti: staging e un canary di produzione (se fattibile).

- Confronta i risultati, documenta le sorprese, poi itera (tuning di config, scelte di dipendenza) prima di considerare una migrazione più ampia.

Se vuoi stringere il loop di feedback, puoi prototipare il servizio pilota e l’harness di benchmark rapidamente in Koder.ai, usare la Planning Mode per definire esperimento (metriche, endpoint, payload) e poi esportare il codice sorgente in modo che le misurazioni finali girino nell’ambiente che controlli.

Dove approfondire

Usa fonti primarie e segnali continui:

- Documentazione ufficiale e note di compatibilità per Node.js, Deno e Bun

- Release notes e changelog (tieni d’occhio fix di sicurezza e breaking change)

- Avvisi di sicurezza e feed CVE rilevanti per le tue dipendenze

- Issue tracker community per intercettare edge case reali

Se vuoi una guida più approfondita su come misurare i runtime in modo equo, vedi /blog/benchmarking-javascript-runtimes.