28 ago 2025·8 min

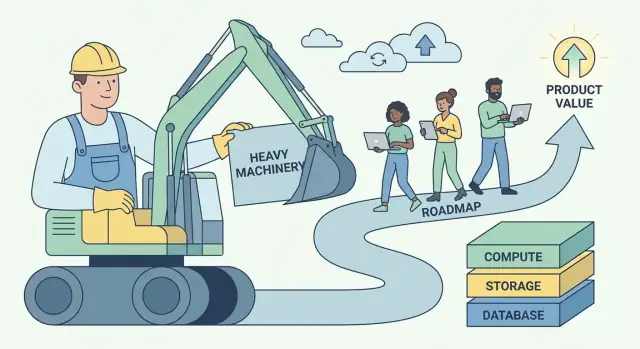

Il playbook di Andy Jassy per AWS: trasformare il lavoro pesante in valore

Come Andy Jassy ha costruito AWS attorno al “lavoro operativo non differenziato” trasformandolo in un modello ripetibile per creare business software scalabili e piattaforme.

Cosa significa davvero “lavoro operativo non differenziato”

“Lavoro operativo non differenziato” è un'idea semplice con un taglio netto: è il lavoro che devi fare per far funzionare il tuo software, ma che non spinge i clienti a sceglierti.

Include attività come il provisioning di server, l'applicazione di patch ai database, la rotazione delle credenziali, la configurazione del monitoraggio, la gestione dei failover, la scalabilità della capacità e l'inseguire incidenti di produzione causati dall'infrastruttura più che dal prodotto. Questi compiti sono reali, importanti e spesso urgenti—ma raramente creano un'esperienza unica per gli utenti.

Definizione in parole semplici

Se un'attività è:

- Necessaria (non la puoi evitare se vuoi affidabilità)

- Ripetibile (ogni team fa una versione simile)

- Non un vantaggio competitivo (i clienti non pagherebbero di più perché tu l'hai fatta internamente)

…allora è lavoro operativo non differenziato.

Perché la frase ha risuonato con sviluppatori e dirigenti

Gli sviluppatori hanno trovato sollievo: il permesso di smettere di considerare il lavoro operativo come un distintivo d'onore. Se tutti reinventano gli stessi script di deployment e i runbook on-call, non è artigianato—è dispersione di energie.

I dirigenti hanno colto la leva: questa categoria di lavoro è costosa, scala male con le persone e genera rischio. Ridurla migliora margini, affidabilità e velocità contemporaneamente.

Il modello di business a cui punta questa idea

AWS ha reso popolare un playbook ripetibile:

- Eliminare il lavoro ripetitivo trasformando operazioni fragili, gestite team per team, in un servizio.

- Standardizzare le parti comuni in modo che la qualità diventi consistente.

- Scalare tramite automazione e infrastruttura condivisa.

- Reinvestire i risparmi in prodotti migliori e consegne più rapide.

Questo è più ampio dell'infrastruttura cloud: è “platform thinking” applicato a qualsiasi business software.

Cosa aspettarsi da questo articolo

Tradurremo il concetto in segnali pratici che puoi riconoscere nel tuo prodotto e nel tuo team, mostreremo come i servizi gestiti e le piattaforme interne confezionano le operazioni come prodotto e affronteremo i veri compromessi (controllo, costo e lock-in). Ti lascerai con un framework per decidere cosa costruire vs. comprare—e come trasformare il lavoro non differenziato in valore aziendale composto.

L'intuizione centrale di Andy Jassy: i clienti vogliono costruire, non fare i babysitter

Andy Jassy è stato uno dei leader che ha aiutato a trasformare le capacità infrastrutturali interne di Amazon in quello che è diventato AWS. Il suo compito non era solo “vendere server su internet.” Era osservare un problema ricorrente dei clienti e confezionare una soluzione che potesse scalare across migliaia di team.

Il dolore reale: le operazioni rubano attenzione al prodotto

La maggior parte dei team software non si sveglia entusiasta di applicare patch ai sistemi operativi, predisporre capacità, ruotare credenziali o ripristinare un disco guasto. Lo fanno perché devono—altrimenti l'app non gira.

L'intuizione centrale di Jassy era che gran parte di questo lavoro è necessario ma non differenziante. Se gestisci un sito di e-commerce, un'app fintech o uno strumento HR interno, i tuoi clienti valutano le tue funzionalità: checkout più veloce, migliori controlli antifrode, onboarding più fluido. Raramente ti premiano per mantenere una flotta di server perfettamente ottimizzata.

Così il “baby-sitting” dell'infrastruttura diventa una tassa:

- Consuma tempo che potrebbe essere speso per rilasciare miglioramenti.

- Costringe i team ad assumere competenze in cui non vogliono specializzarsi.

- Aumenta il rischio perché ogni azienda deve riapprendere le stesse lezioni operative.

Perché il tempismo è stato determinante

Questa idea è arrivata in un momento in cui le esigenze crescevano su più fronti:

- Scala internet rendeva il traffico imprevedibile; pianificare per il picco era costoso.

- Startup dovevano muoversi velocemente senza costruire un team di data center.

- IT aziendale era sotto pressione per consegnare più rapidamente pur gestendo sicurezza e compliance.

Il principio non era “sposta tutto sul cloud.” Era più semplice: eliminare gli oneri operativi ripetibili così i clienti possono dedicare più energia a ciò che li differenzia. Quel cambiamento—tempo e attenzione di nuovo sul costruire—è diventato la base per un business piattaforma.

Riconoscere il lavoro pesante nel tuo prodotto e nel tuo team

Il primo passo è separare il lavoro di base (necessario per tenere un prodotto credibile) dalla differenziazione (i motivi per cui i clienti ti scelgono).

Il lavoro di base non è “poco importante.” Spesso è critico per affidabilità e fiducia. Ma raramente crea preferenza da solo—soprattutto quando i concorrenti possono soddisfare lo stesso livello minimo.

Segnali comuni di “lavoro operativo”

Se non sei sicuro di cosa appartenga al bucket non differenziato, cerca lavoro che sia:

- Necessario, ripetitivo e non negoziabile

- Costoso quando si rompe, ma per lo più invisibile quando funziona

- Risolvibile in modi ampiamente simili tra aziende

Nei team software, spesso include:

- Gestione di server o cluster

- Patch di sicurezza e aggiornamenti delle dipendenze

- Backup e drill di disaster recovery

- Auto-scaling e capacity planning

- Monitoraggio di base, logging e alerting

- Rotazione on-call per modalità di guasto prevedibili

Nessuno di questi è “male.” La domanda è se farli internamente sia parte del valore del tuo prodotto—o solo il prezzo d'ingresso.

Il test più semplice: i clienti pagherebbero per questo?

Una regola pratica è:

“I clienti pagherebbero specificamente per questo, o si aspetterebbero solo che sia incluso?”

Se la risposta è “si arrabbierebbero solo se mancasse,” probabilmente stai guardando a lavoro operativo non differenziato.

Un secondo test: se togliessimo questo lavoro domani adottando un servizio gestito, i tuoi migliori clienti continuerebbero a valutarti per ciò che resta? Se sì, hai trovato un candidato da scaricare, automatizzare o trasformare in prodotto.

“Non differenziato” cambia in base al mercato

Ciò che è non differenziato in un'azienda può essere IP centrale in un'altra. Un fornitore di database può differenziarsi su backup e replica. Un prodotto fintech probabilmente no. Il tuo obiettivo non è copiare il confine altrui—è tracciare il tuo in base a ciò che i tuoi clienti ricompensano in modo univoco.

Mappando roadmap e lavoro operativo con questa lente, inizi a vedere dove tempo, talento e attenzione vengono spesi solo per restare al passo.

Perché questa idea crea enorme valore di business

“Lavoro operativo non differenziato” non è solo un trucco di produttività. È un modello di business: prendi un problema che molte aziende devono risolvere, ma su cui nessuno vuole differenziarsi, e trasformalo in un servizio per cui le persone pagano volentieri.

I problemi commoditizzati sono carburante per le piattaforme

I migliori candidati sono necessità con bassa unicità strategica: provisioning di server, patch dei database, rotazione delle credenziali, scalare code, gestione backup. Ogni team li richiede, quasi tutti preferirebbero non costruirli, e la “risposta giusta” è simile tra aziende.

Questa combinazione crea un mercato prevedibile: alta domanda, requisiti ricorrenti e metriche di successo chiare (uptime, latenza, compliance, tempi di recovery). Una piattaforma può standardizzare la soluzione e migliorarla col tempo.

Economie di scala: distribuire i costi fissi sui clienti

L'eccellenza operativa ha grandi costi fissi—SRE, specialisti di sicurezza, rotazioni on-call, audit, tooling per incidenti e monitoraggio 24/7. Quando ogni azienda costruisce questo da sola, quei costi si duplicano migliaia di volte.

Una piattaforma distribuisce quegli investimenti fissi su molti clienti. Il costo per cliente cala con l'adozione, mentre la qualità può aumentare perché il provider può giustificare una specializzazione più profonda.

Il circolo della affidabilità: la specializzazione compone uptime e sicurezza

Quando un team di servizio gestisce lo stesso componente per molti clienti, osserva più edge case, rileva pattern più velocemente e costruisce automazione migliore. Gli incidenti diventano input: ogni fallimento indurisce il sistema, migliora i playbook e stringe i guardrail.

La sicurezza beneficia allo stesso modo. Team dedicati possono investire in threat modeling, patching continuo e controlli di compliance che sarebbero difficili da sostenere per un singolo team di prodotto.

Potere di prezzo: uso-based + fiducia + costi di switching (con attenzione)

Le piattaforme spesso guadagnano potere di prezzo tramite prezzi basati sull'uso: i clienti pagano in rapporto al valore consumato e possono partire in piccolo. Col tempo, la fiducia diventa differenziante—affidabilità e sicurezza rendono il servizio “default sicuro.”

I costi di switching crescono man mano che le integrazioni si approfondiscono, ma la versione più sana è guadagnata, non imposta: miglior performance, migliori strumenti, fatturazione chiara e meno incidenti. Questo mantiene i clienti nel tempo anche quando esistono alternative. Per come questo si manifesta in packaging e monetizzazione, vedi /pricing.

Il modello AWS: dai primitivi ai servizi gestiti

AWS non ha vinto offrendo “server su internet.” Ha vinto prendendo ripetutamente problemi operativi difficili, scomponendoli in blocchi più semplici e poi rimbundling quei blocchi in servizi dove AWS si occupa del lavoro day-2 per te.

La scala ripetibile: primitivo → servizio → servizio gestito → piattaforma

Pensalo come una scala di maturità:

- Primitivo: Ingredienti grezzi che puoi assemblare da solo (VM, dischi, reti)

- Servizio: Un'API più opinionata intorno a una capacità (object storage, load balancing)

- Servizio gestito: AWS opera scaling, patching, backup e recovery (database, code)

- Piattaforma: Un portafoglio dove i servizi si compongono bene, con identità condivisa, fatturazione, monitoraggio e policy

Ogni passo rimuove decisioni, manutenzione e il “e se si rompe alle 3 di notte?” dalla responsabilità del cliente.

Esempi AWS (mappatura concettuale)

AWS ha applicato lo stesso pattern in categorie chiave:

-

Compute: Si parte con macchine virtuali (EC2). Si sale verso livelli di compute più alti dove deployment e scaling diventano default (es. container gestiti/serverless). Il cliente si concentra sul codice e sull'intento di capacità, non sulla cura degli host.

-

Storage: Dai volumi e file system all'object storage (S3). L'astrazione passa da “gestire volumi” a “put/get oggetti”, mentre durabilità, replica e scalabilità diventano problema di AWS.

-

Database: Dal “installare un DB su una VM” ai database gestiti (RDS, DynamoDB). Backup, patching, repliche di lettura e failover smettono di essere runbook personalizzati e diventano configurazioni.

-

Messaging: Dalle code fatte in casa a messaging gestito (SQS/SNS). Semantiche di consegna, retry e tuning della throughput vengono standardizzati così i team possono costruire workflow invece che infrastruttura.

Perché le astrazioni riducono il carico cognitivo

I servizi gestiti riducono il carico cognitivo in due modi:

- Meno parti in movimento da ragionare. Il tuo diagramma architetturale si riduce da “istanze + script + cron + alerting + backup” a “servizio + impostazioni.”

- Meno modalità di guasto di cui ti devi occupare. Progetti ancora per la resilienza, ma non sei più responsabile per i meccanismi di patching, clustering e recupero di routine.

Il risultato è onboarding più rapido, meno runbook costruiti ad hoc e operazioni più consistenti tra i team.

Checklist da riutilizzare (usala nel tuo prodotto)

- Cosa stanno costruendo i clienti che è necessario ma non differenziante?

- Puoi trasformare i loro runbook ricorrenti in una singola API stabile?

- Quali attività puoi rendere di default (backup, scaling, upgrade) invece che opzionali?

- Gli “spigoli vivi” sono stati spostati dietro limiti e guardrail sensati?

- Più team possono riutilizzarlo senza competenze esperte?

- Si compone con il resto del tuo sistema (identità, monitoraggio, fatturazione, policy)?

Confezionare le operazioni come prodotto

Standardizza il tuo front-end

Genera una base per app React senza ricreare sempre lo stesso scaffolding.

Un modo utile di leggere AWS è: non vende solo tecnologia, vende operazioni. Il “prodotto” non è solo un endpoint API—è tutto ciò che serve per eseguire quella capacità in modo sicuro, prevedibile e su scala.

API vs self-service vs gestione completa

Un'API ti dà i mattoni. Puoi predisporre risorse, ma devi ancora progettare i guardrail, monitorare i guasti, gestire gli upgrade e rispondere a “chi ha cambiato cosa?”.

Il self-service aggiunge un livello che i clienti possono usare senza aprire ticket: console, template, default sensati e provisioning automatizzato. Il cliente mantiene la maggior parte del lavoro day-2, ma è meno manuale.

La gestione completa è quando il provider si assume le responsabilità continue: patching, scaling, backup, failover e molte classi di risposta agli incidenti. I clienti si concentrano sul configurare cosa vogliono, non come rimane in esecuzione.

Le funzionalità “noiose” di cui i clienti non possono fare a meno

Le capacità su cui le persone fanno affidamento quotidianamente raramente sono appariscenti:

- IAM e permessi: chi può fare cosa e come si auditano gli accessi

- Fatturazione e visibilità dei costi: budget, fatture, tag e alert

- Quote e rate limit: protezioni che prevengono incidenti—e stabiliscono aspettative chiare

Non sono missioni secondarie. Fanno parte della promessa che i clienti comprano.

Le operazioni come funzione di prodotto di prima classe

Ciò che rende un servizio gestito “reale” è il pacchetto operativo attorno a esso: documentazione chiara, canali di supporto prevedibili e limiti di servizio espliciti. Buona documentazione riduce il carico di supporto, ma più importante riduce l'ansia del cliente. Limiti pubblicati e processi di quota trasformano le sorprese in vincoli noti.

Quando confezioni le operazioni come prodotto, non stai solo rilasciando funzionalità—stai spedendo fiducia.

Il design organizzativo che rende le piattaforme efficaci

Una piattaforma riesce o fallisce meno sui diagrammi di architettura e più sul design organizzativo. Se i team non hanno clienti chiari, incentivi e loop di feedback, la “piattaforma” diventa un backlog di opinioni.

I team interni come primi clienti (dogfooding)

Il modo più rapido per mantenere una piattaforma onesta è fare dei team di prodotto interni i primi—e più rumorosi—clienti. Questo significa:

- I team piattaforma rilasciano ai team interni attraverso le stesse interfacce e documentazione che vedrebbero gli utenti esterni.

- L'adozione si guadagna (con utilità), non si impone (con policy).

- Ticket di supporto, review di incidenti e decisioni di roadmap trattano i team interni come clienti veri, con SLA chiari.

Il dogfooding forza chiarezza: se i tuoi team evitano la piattaforma, anche i clienti esterni la eviteranno.

Modelli organizzativi: centrale vs federato

Due pattern organizzativi ricorrono spesso:

Team piattaforma centrale: un team possiede i blocchi core (CI/CD, identità, osservabilità, runtime, primitive dati). Ottimo per consistenza ed economie di scala, ma rischia di diventare un collo di bottiglia.

Modello federato: un piccolo team centrale definisce standard e primitive condivise, mentre i team di dominio possiedono “slice” di piattaforma (es. data platform, ML platform). Migliora velocità e fit per il dominio, ma richiede governance forte per evitare frammentazione.

Metriche che contano (e insidie delle piattaforme)

Le metriche utili sono outcome, non attività:

- Lead time to production (quanto velocemente i team possono consegnare)

- Disponibilità e tasso di incidenti dei servizi di piattaforma

- Costo per workload (economia unitaria, non solo spesa totale)

Le insidie comuni sono incentivi non allineati (piattaforma giudicata sul numero di feature e non sull'adozione), over-design (costruire per scala ipotetica) e successo misurato da imposizioni piuttosto che uso volontario.

La flywheel composita dietro la crescita della piattaforma

Rilascia la prima versione più rapidamente

Costruisci un progetto web, backend o mobile da un prompt chiaro e poi iteralo velocemente.

Le piattaforme crescono diversamente dai prodotti one-off. Il loro vantaggio non è solo “più funzionalità”—è un loop di feedback dove ogni nuovo cliente rende la piattaforma più facile da gestire, migliorare e difficile da ignorare.

La flywheel in termini semplici

Più clienti → più dati d'uso reali → pattern più chiari su cosa si rompe, cosa è lento, cosa confonde → default e automazioni migliori → servizio migliore per tutti → più clienti.

AWS ha beneficiato di questo perché i servizi gestiti trasformano il lavoro operativo in una capacità condivisa e ripetibile. Quando gli stessi problemi compaiono in migliaia di team (monitoraggio, patching, scaling, backup), il provider può risolverli una volta e distribuire il miglioramento a tutti i clienti.

Perché la standardizzazione accelera l'innovazione

La standardizzazione è spesso vista come “meno flessibilità,” ma per le piattaforme è un moltiplicatore di velocità. Quando infrastruttura e operazioni diventano consistenti—un set di API, un approccio all'identità, un modo di osservare i sistemi—gli sviluppatori smettono di reinventare le basi.

Quel tempo riconquistato si traduce in innovazione di più alto livello: esperienze di prodotto migliori, esperimenti più rapidi e nuove capacità costruite sulla piattaforma (non accanto ad essa). La standardizzazione riduce anche il carico cognitivo per i team: meno decisioni, meno modalità di guasto, onboarding più veloce.

La scommessa a lungo termine: composizione su scala

Piccoli miglioramenti si compongono quando si applicano a milioni di richieste e migliaia di clienti. Una riduzione del 2% nel tasso di incidenti, un algoritmo di autoscaling leggermente migliore o una configurazione predefinita più chiara non aiutano solo una azienda—alza il baseline della piattaforma.

Come la rimozione del lavoro pesante si traduce in rilasci più rapidi

Eliminare il lavoro operativo non differenziato non solo salva ore—cambia il comportamento dei team. Quando il lavoro di “tenere in funzione” diminuisce, le roadmap smettono di essere dominate da compiti di manutenzione (patching server, rotazione chiavi, baby-sitting delle code) e iniziano a riflettere scommesse di prodotto: nuove funzionalità, UX migliore, più esperimenti.

Gli effetti di secondo ordine che si compongono

Meno lavoro ripetitivo crea una reazione a catena:

- Onboarding più semplice. Nuovi ingegneri possono rilasciare in giorni invece di studiare un labirinto di runbook interni.

- Gli incidenti calano—e diventano più semplici. Meno sistemi ad hoc significano meno modalità di guasto strane e meno escalation alle 3 di notte.

- I rilasci diventano routine. I team possono rilasciare più spesso perché deployment, rollback e monitoraggio sono standardizzati.

Velocità vs. caos: rilasciare vs. spegnere incendi

La vera velocità è una cadenza costante di rilasci piccoli e prevedibili. Il caos è movimento senza progresso: bug urgenti, lavoro infrastrutturale d'emergenza e cambi “rapidi” che generano altro debito.

La rimozione del lavoro operativo riduce il caos perché elimina intere categorie di attività che interrompono ripetutamente la consegna pianificata. Un team che prima passava il 40% del tempo a reagire può reindirizzare quella capacità verso funzionalità—e mantenerla lì.

Esempi pratici SaaS

Autenticazione: Invece di mantenere internamente storage password, flussi MFA, gestione sessioni e audit di compliance, usa un identity provider gestito. Risultato: meno incidenti di sicurezza, rollout SSO più rapidi e meno tempo a aggiornare librerie auth.

Pagamenti: Esternalizza processamento pagamenti, gestione tasse/VAT e controlli antifrode a un provider specializzato. Risultato: espansione in nuove regioni più veloce, meno sorprese con chargeback e meno tempo di ingegneria sui casi limite.

Observability: Standardizza su uno stack di logging/metriche/tracing gestito invece di cruscotti fatti in casa. Risultato: debug più rapido, ownership degli incidenti più chiara e fiducia a deployare più frequentemente.

Il pattern è semplice: quando le operazioni diventano un prodotto che consumi, il tempo degli ingegneri ritorna a costruire ciò per cui i clienti pagano.

Compromessi: lock-in, controllo e costo

Rimuovere il lavoro operativo non differenziato non è un pranzo gratis. I servizi gestiti in stile AWS spesso scambiano lo sforzo quotidiano per un accoppiamento più stretto, meno manopole e bollette che possono sorprendere.

I tre grandi compromessi

Vendor lock-in. Più dipendi da API proprietarie (code, policy IAM, motori di workflow), più sarà difficile migrare dopo. Il lock-in non è sempre negativo—può essere il prezzo della velocità—ma va scelto deliberatamente.

Perdita di controllo. I servizi gestiti riducono la possibilità di tunare performance, scegliere versioni esatte o debug profondi di infrastruttura. Quando accade un outage, potresti dover aspettare i tempi del provider.

Sorprese sui costi. La pricing basata sul consumo premia l'uso efficiente, ma può punire la crescita, architetture “chatty” e default “set-and-forget”. I team spesso scoprono i costi dopo il rilascio.

Quando è razionale costruire

Costruire (o self-host) può avere senso quando hai requisiti unici (latenza personalizzata, modelli di dati speciali), scala massiccia dove l'economia unitaria cambia, o vincoli di compliance/residenza dati che i servizi gestiti non soddisfano.

Guardrail per rimanere veloci senza restare intrappolati

Progetta confini di servizio: incapsula le chiamate al provider dietro una tua interfaccia così puoi cambiare implementazione.

Mantieni un piano di portabilità: documenta cosa sarebbe più difficile migrare e conserva una “exit minima vitale” (anche se lenta).

Aggiungi monitoraggio dei costi presto: budget, alert, tagging e revisioni regolari dei maggiori consumi.

Matrìce decisionale copiabile

| Domanda | Preferisci Managed | Preferisci Build/Self-host |

|---|---|---|

| È un differenziatore per i clienti? | No | Sì |

| Possiamo tollerare limiti/opinionated behavior del provider? | Sì | No |

| Abbiamo esigenze di compliance/controllo speciali? | No | Sì |

| La velocità sul mercato è priorità assoluta? | Sì | No |

| Il costo è prevedibile col nostro pattern d'uso? | Sì | No |

Un framework pratico per applicare il pattern in qualsiasi business software

Delega il lavoro operativo post-lancio

Lascia che Koder.ai gestisca deployment e hosting così puoi concentrarti sulle modifiche di prodotto.

Non devi gestire un cloud hyperscale per usare il playbook “rimuovi lavoro operativo non differenziato”. Qualsiasi team software—SaaS, piattaforme interne, prodotti dati, anche strumenti con pesante supporto—ha lavoro ricorrente costoso, soggetto a errori e non davvero differenziante.

Metodo passo-passo (dal toil al prodotto)

-

Elenca i toil ricorrenti: Scrivi i task ripetuti che le persone fanno per mantenere le cose in funzione—deployment manuali, triage dei ticket, backfill di dati, richieste di accesso, handoff di incidenti, script fragili, checklist di “conoscenza tribale”.

-

Quantificali: Per ogni voce, stima frequenza, tempo speso e costo degli errori. Una semplice score funziona: ore/settimana + gravità degli errori + numero di team coinvolti. Questo trasforma il dolore vago in un backlog ordinato.

-

Standardizza il workflow: Prima di automatizzare, definisci “la via migliore”. Crea un template, una golden path o un set minimo di opzioni supportate. Ridurre la variazione è spesso il guadagno più grande.

-

Automatizza e confeziona: Costruisci tool self-serve (API, UI, runbook-as-code) e trattali come un prodotto: ownership chiara, versioning, documentazione e un modello di supporto.

Una variante moderna è rappresentata da piattaforme “vibe-coding” che trasformano scaffolding ripetitivo e setup day-1 in un flusso guidato. Ad esempio, Koder.ai permette ai team di creare app web, backend e mobile da un'interfaccia chat (React per il web, Go + PostgreSQL per il backend, Flutter per il mobile) e poi esportare il codice sorgente o deployare/hostare—utile quando il collo di bottiglia è passare dall'idea a una baseline affidabile senza rifare sempre la stessa infrastruttura del progetto.

Inizia con un workflow (e prova il loop)

Scegli un singolo workflow ad alta frequenza dove il successo è misurabile—deploy, pipeline dati o strumenti di supporto sono buoni candidati. Punta a una vittoria rapida: meno passi, meno pagine, meno approvazioni, recovery più veloce.

Sequenza: cosa fare prima

- Affidabilità prima: rendi il processo consistente e sicuro.

- Funzionalità dopo: aggiungi capacità richieste dagli utenti.

- Ottimizzazione terza: affina costi e performance dopo che l'uso si è stabilizzato.

Punti chiave e prossimi passi

La lezione riutilizzabile dalla strategia AWS di Andy Jassy è semplice: vinci facendo sparire il lavoro comune. Quando i clienti (o i team interni) smettono di spendere tempo in setup, patching, scaling e babysitting degli incidenti, possono dedicare quel tempo a ciò che davvero li differenzia—funzionalità, esperienze e nuove scommesse.

Il concetto da tenere sempre a mente

“Lavoro operativo non differenziato” non è solo “lavoro duro.” È lavoro che molti team ripetono, che deve essere fatto per operare in modo affidabile, ma che raramente genera credito unico sul mercato. Trasformare quel lavoro in prodotto—soprattutto in servizio gestito—crea valore due volte: abbassi il costo di gestione del software e aumenti la velocità di rilascio.

Scegli una cosa da eliminare questo trimestre

Non partire da una riscrittura epocale della piattaforma. Parti da un dolore ricorrente che appare nei ticket, nelle pagine on-call o nel lavoro spostato di sprint. Buoni candidati:

- Setup degli ambienti che varia per team

- Rilasci e rollback manuali

- Revisioni di sicurezza ripetute per gli stessi pattern

- Default di scaling/monitoring che tutti riscoprono a fatica

Scegline uno, definisci il “done” in linguaggio semplice (es.: “un nuovo servizio può essere deployato in sicurezza in 15 minuti”) e rilascia la versione minima che elimina il lavoro ripetuto.

Letture interne correlate

Se vuoi più pattern pratici su platform thinking e decisioni build-vs.-buy, sfoglia /blog. Se stai valutando cosa standardizzare rispetto a cosa offrire come capacità interna (o esterna) a pagamento, /pricing può aiutare a inquadrare packaging e tier.

Prossimo passo: un backlog di piattaforma semplice

Questa settimana, fai tre cose: audita dove il tempo si perde per lavoro operativo ripetuto, priorizza per frequenza × dolore × rischio, e costruisci un backlog di piattaforma semplice con 3–5 elementi che puoi rilasciare incrementally.