Cosa significano davvero “vibe coding” e “messa in sicurezza per la produzione"

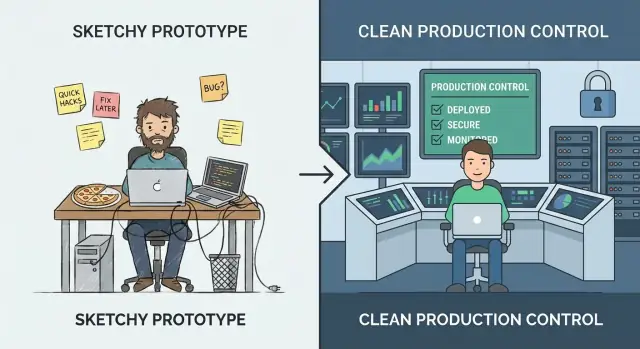

“Vibe coding” è la fase in cui la velocità prevale sulla precisione. Stai sperimentando, imparando cosa vogliono davvero gli utenti e provando idee che magari non sopravvivono alla settimana. L'obiettivo è la conoscenza: validare un flusso, dimostrare una proposta di valore o confermare che i dati necessari esistono. In questo modo, i bordi grezzi sono normali: passaggi manuali, gestione degli errori debole e codice ottimizzato per arrivare rapidamente al “funziona”.

La messa in sicurezza per la produzione è diversa. È il lavoro che rende il comportamento prevedibile sotto uso reale: input sporchi, interruzioni parziali, picchi di traffico e persone che fanno cose che non hai previsto. Indurire non riguarda tanto aggiungere funzionalità quanto ridurre le sorprese—così il sistema fallisce in modo sicuro, si riprende pulitamente ed è comprensibile per la prossima persona che deve gestirlo.

Passare troppo presto vs. troppo tardi

Se indurisci troppo presto, puoi rallentare l'apprendimento. Potresti investire in scalabilità, automazione o architettura levigata per una direzione prodotto che cambia la settimana successiva. È costoso e può far sentire intrappolato un team piccolo.

Se indurisci troppo tardi, crei rischio. Le stesse scorciatoie accettabili per una demo diventano incidenti visibili ai clienti: incoerenze nei dati, lacune di sicurezza e downtime che danneggiano la fiducia.

Non devi scegliere per sempre

Un approccio pratico è continuare a sperimentare mentre indurisci la “thin waist” del sistema: i pochi percorsi chiave che devono essere affidabili (registrazione, pagamenti, scritture sui dati, integrazioni critiche). Puoi ancora iterare rapidamente sulle funzionalità periferiche—basta non lasciare che le assunzioni del prototipo governino le parti di cui gli utenti reali dipendono ogni giorno.

Questo è anche il punto dove le scelte degli strumenti contano. Piattaforme costruite per l'iterazione rapida possono aiutarti a restare in modalità “vibe” senza perdere la possibilità di professionalizzare più avanti. Per esempio, Koder.ai è progettato per il vibe-coding via chat per creare app web, backend e mobile, ma supporta anche l'export del codice sorgente, il deploy/hosting, domini personalizzati e snapshot/rollback—caratteristiche che si mappano direttamente alla mentalità della “thin waist” (spedire velocemente, ma proteggere i percorsi critici e recuperare in fretta).

Un semplice modello di maturità: da demo a affidabile

Il vibe coding brilla quando stai cercando di imparare in fretta: questa idea può funzionare o no? L'errore è assumere che le stesse abitudini reggeranno quando persone reali (o processi aziendali) dipenderanno dal risultato.

Le fasi che la maggior parte dei team attraversa

Un modo utile per decidere cosa indurire è nominare la fase in cui ti trovi:

- Idea: esplorazione di fattibilità; codice usa e getta va bene.

- Demo: prova cliccabile o eseguibile; il successo è “mostra il concetto”.

- Pilot: un piccolo workflow reale; il successo è “aiuta alcune persone in modo affidabile”.

- Beta: accesso più ampio; il successo è “funziona la maggior parte del tempo, con supporto”.

- Produzione: strumento predefinito per un lavoro; il successo è “è affidabile, sicuro e mantenibile”.

Come cambiano i requisiti quando gli esiti contano

Man mano che vai a destra, la domanda cambia da “Funziona?” a “Possiamo fidarcene?”. Questo aggiunge aspettative come prestazioni prevedibili, gestione chiara degli errori, auditabilità e la capacità di rollbackare le modifiche. Ti costringe anche a definire la proprietà: chi è responsabile quando qualcosa si rompe?

La curva dei costi che nessuno ama

I bug risolti durante idea/demo sono economici perché il codice su cui lavori non è ancora critico. Dopo il lancio, lo stesso bug può innescare tempo di supporto, pulizia dati, perdita di clienti o scadenze mancate. Indurire non è perfezionismo—è ridurre il raggio d'azione degli errori inevitabili.

“Produzione” non significa solo rivolto al cliente

Uno strumento interno che genera fatture, instrada lead o controlla accessi è già in produzione se l'azienda ne dipende. Se un guasto fermerebbe il lavoro, esporrebbe dati o creerebbe rischio finanziario, trattalo come produzione—anche se lo usano solo 20 persone.

Segnali che hai superato la fase prototipo

Un prototipo può essere fragile. Serve a dimostrare un'idea, ad aprire una conversazione e a farti imparare in fretta. Il momento in cui persone reali iniziano a farci affidamento, il costo delle “riparazioni rapide” sale—e i rischi passano dall'inconveniente all'impatto sul business.

I segnali più chiari da osservare

Il tuo pubblico cambia. Se il numero di utenti cresce costantemente, hai clienti paganti, o hai firmato accordi con aspettative di uptime/risposta, non stai più sperimentando—stai offrendo un servizio.

I dati diventano più sensibili. Il giorno in cui il sistema inizia a toccare PII (nomi, email, indirizzi), dati finanziari, credenziali o file privati, hai bisogno di controlli di accesso più forti, tracce di audit e impostazioni di sicurezza predefinite. Un prototipo può essere “abbastanza sicuro per una demo”. Dati reali no.

L'uso diventa routine o critico per la missione. Quando lo strumento entra nel flusso di lavoro quotidiano di qualcuno—o quando i guasti bloccano ordini, report, onboarding o supporto—downtime e casi limite strani smettono di essere accettabili.

Altri team dipendono dai tuoi output. Se team interni costruiscono processi intorno alle tue dashboard, esportazioni, webhook o API, ogni cambiamento diventa una potenziale rottura. Sentirai pressione per mantenere comportamento consistente e comunicare le modifiche.

I guasti diventano ricorrenti. Un flusso costante di “si è rotto”, ping su Slack e ticket è un forte indicatore che passi più tempo a reagire che a imparare. È il segnale per investire in stabilità anziché in nuove funzionalità.

Un rapido controllo istintivo

Se un'ora di outage sarebbe imbarazzante, ti stai avvicinando alla produzione. Se sarebbe costoso—perdita di ricavi, promesse infrante o fiducia danneggiata—sei già lì.

Decidi basandoti sul rischio, non sulle sensazioni

Se stai discutendo se l'app è “pronta”, stai già ponendo la domanda sbagliata. La domanda migliore è: qual è il costo di sbagliare? L'indurimento per la produzione non è un distintivo d'onore—è una risposta al rischio.

Inizia definendo il “fallimento” in termini semplici

Scrivi cosa significa fallire per il tuo sistema. Categorie comuni:

- Downtime: il servizio non è utilizzabile

- Risultati errati: funziona ma produce output sbagliati (spesso peggio del downtime)

- Risposte lente: gli utenti abbandonano, le automazioni scadono, i ticket di supporto aumentano

Sii specifico. “La ricerca impiega 12 secondi per il 20% degli utenti durante il picco” è azionabile; “problemi di performance” no.

Stima l'impatto sul business (anche approssimativamente)

Non servono numeri perfetti—usa intervalli.

- Ricavi: vendite perse, rinnovi mancati, penali SLA

- Churn e fiducia: gli utenti non ritornano dopo una brutta esperienza

- Perdita di produttività: team interni bloccati, workaround manuali che si moltiplicano

- Conformità: sanzioni di audit, violazioni contrattuali, obblighi di reporting

Se l'impatto è difficile da quantificare, chiedi: Chi viene allertato? Chi si scusa? Chi paga?

Elenca i principali rischi che porti con te

I fallimenti da prototipo a produzione si raggruppano spesso in poche categorie:

- Perdita o corruzione dei dati (assenza di backup, migrazioni non sicure, controlli di accesso deboli)

- Violazione della sicurezza (token esposti, permessi troppo ampi, endpoint scoperti)

- Automazioni errate (azioni LLM o script che sbagliano cambiamenti su larga scala)

Classifica i rischi per probabilità × impatto. Questo diventa la tua roadmap di indurimento.

Scegli un obiettivo di affidabilità “sufficientemente buono” per il tuo stadio

Evita la perfezione. Scegli un obiettivo che corrisponda agli stake attuali—per esempio, “disponibilità durante l'orario lavorativo”, “99% di successi per i workflow core” o “ripristino entro 1 ora”. Man mano che uso e dipendenza crescono, alza la barra deliberatamente anziché reagire nel panico.

La prontezza alla produzione inizia con proprietà e ambito

“Indurire per la produzione” spesso fallisce per una ragione semplice: nessuno può dire chi è responsabile end-to-end del sistema, e nessuno può dire cosa significa “fatto”.

Prima di aggiungere rate limit, test di carico o un nuovo stack di logging, definisci due basi: proprietà e ambito. Trasformano un progetto di ingegneria senza fine in un insieme gestibile di impegni.

Nomina un proprietario (end-to-end)

Annota chi possiede il sistema end-to-end—non solo il codice. Il proprietario è responsabile di disponibilità, qualità dei dati, rilasci e impatto sugli utenti. Non significa che faccia tutto; significa che prende decisioni, coordina il lavoro e garantisce che ci sia qualcuno pronto quando le cose vanno male.

Se la proprietà è condivisa, nomina comunque un primario: una persona/team che possa dire “sì/no” e mantenere le priorità coerenti.

Definisci prima i percorsi critici

Identifica i percorsi utente primari e i percorsi critici. Sono i flussi in cui il fallimento crea danno reale: signup/login, checkout, invio messaggi, importazione dati, generazione report, ecc.

Una volta identificati, puoi indurire selettivamente:

- Imposta obiettivi di affidabilità intorno a quei percorsi prima di tutto.

- Decidi quali dati non devono mai andare persi.

- Scegli le poche metriche che definiscono “funzionante”.

Imposta l'ambito per evitare un indurimento infinito

Documenta cosa è nel perimetro ora e cosa verrà dopo per evitare indurimenti senza fine. La prontezza alla produzione non è “software perfetto”; è “sufficientemente sicuro per questo pubblico, con limiti noti”. Sii esplicito su cosa non supporti ancora (regioni, browser, picchi di traffico, integrazioni).

Avvia uno scheletro di runbook

Crea uno scheletro leggero di runbook: come deployare, rollbackare, debuggare. Mantienilo corto e utilizzabile alle 2 di notte—una checklist, dashboard chiave, modalità di guasto comuni e chi contattare. Puoi evolverlo col tempo, ma non puoi improvvisarlo durante il primo incidente.

Affidabilità: rendi il sistema prevedibile sotto carico

L'affidabilità non significa rendere i guasti impossibili—significa rendere il comportamento prevedibile quando qualcosa va storto o il carico aumenta. I prototipi spesso “funzionano sulla mia macchina” perché il traffico è basso, gli input sono puliti e nessuno esegue ripetutamente lo stesso endpoint.

Metti dei guardrail su ogni richiesta

Inizia con difese noiose ma ad alto impatto:

- Validazione degli input ai confini (API, form UI, payload webhook). Rifiuta i dati errati subito con messaggi d'errore chiari.

- Timeout ovunque venga chiamato qualcosa di lento o esterno (DB, API di terze parti, code). Un timeout mancante trasforma un piccolo intoppo in un ingorgo.

- Retry, con cautela: ripeti solo operazioni sicure, usa backoff esponenziale + jitter e limita i tentativi. Retry ciechi possono amplificare gli outage.

- Circuit breaker per smettere di chiamare dipendenze che falliscono e per recuperare automaticamente quando si stabilizzano.

Fallire in modo sicuro e visibile

Quando il sistema non può svolgere pienamente il lavoro, dovrebbe comunque fare ciò che è più sicuro. Può significare servire un valore in cache, disabilitare una funzionalità non critica o restituire un “ritenta” con un request ID. Preferisci la degradazione graduale a scritture parziali silenziose o errori generici fuorvianti.

Concorrenza e idempotenza non sono opzionali

Sotto carico, richieste duplicate e job sovrapposti accadono (doppi clic, retry di rete, redelivery delle code). Progetta per questo:

- Rendi le azioni chiave idempotenti (la stessa richiesta processata due volte produce lo stesso risultato).

- Usa lock o concorrenza ottimistica dove necessario per prevenire condizioni di race.

Proteggi l'integrità dei dati

L'affidabilità include “non corrompere i dati”. Usa transazioni per scritture multi-step, aggiungi vincoli (chiavi uniche, foreign key) e pratica disciplina nelle migrazioni (cambi retrocompatibili, rollout testati).

Applica limiti alle risorse

Imposta limiti su CPU, memoria, pool di connessioni, dimensioni delle code e payload delle richieste. Senza limiti, un tenant rumoroso—o una query sbagliata—può togliere risorse a tutto il resto.

Sicurezza: la soglia minima prima di utenti reali

La messa in sicurezza non significa trasformare il prototipo in una fortezza. Significa raggiungere uno standard minimo dove un errore normale—un link esposto, un token trapelato, un utente curioso—non diventi un incidente che impatta i clienti.

Inizia con separazione: dev, staging, prod

Se hai “un solo ambiente”, hai un solo raggio d'azione. Crea dev/staging/prod separati con segreti minimi condivisi. Staging dovrebbe essere abbastanza vicino alla produzione da rivelare problemi, ma non dovrebbe riutilizzare credenziali o dati sensibili di produzione.

Autenticazione e autorizzazione (authn/authz)

Molti prototipi si fermano a “il login funziona”. La produzione richiede minimo privilegio:

- Definisci ruoli chiari (es. admin, support, utente standard) e applica i limiti server-side.

- Blocca gli strumenti interni e gli endpoint di admin.

- Mantieni tracce di audit per azioni sensibili (login, reset password, cambi ruolo, esportazioni, cancellazioni). Non servono analytics perfetti—solo abbastanza per rispondere a “chi ha fatto cosa e quando?”.

Gestione dei segreti: fuori dal codice e dai log

Sposta chiavi API, password DB e segreti di firma in un secrets manager o in variabili d'ambiente sicure. Poi assicurati che non possano trapelare:

- Non stampare token nei log applicativi.

- Evita di inviare segreti al codice client-side.

- Ruota qualsiasi credenziale mai committata in un repo.

Minacce da prioritizzare presto

Avrai più valore concentrandoti su alcuni failure mode comuni:

- Injection (SQL/comandi): usa query parametrizzate e librerie sicure.

- Controllo degli accessi rotto: verifica permessi su ogni richiesta, non solo nella UI.

- Esposizione dati: cifra in transito, limita i dati restituiti per default ed evita esportazioni troppo ampie.

Piano di patching per le dipendenze

Decidi chi possiede gli aggiornamenti e con quale frequenza patchare dipendenze e immagini base. Un piano semplice (controllo settimanale + aggiornamenti mensili, fix urgenti entro 24–72 ore) batte il “lo faremo più tardi”.

Testing: intercetta i guasti prima che li vedano i clienti

Il testing è ciò che trasforma “funzionava sulla mia macchina” in “continua a funzionare per i clienti”. L'obiettivo non è la copertura perfetta—è la fiducia nei comportamenti che sarebbe più costoso rompere: fatturazione, integrità dei dati, permessi, workflow chiave e qualsiasi cosa difficile da debugare una volta deployata.

Una piramide di test che rispecchia la realtà

Una piramide pratica solitamente appare così:

- Unit test per logica pura (veloci, molti)

- Test di integrazione per i confini (DB, code, API esterne dietro mock)

- E2E per pochi percorsi utente critici (lenti, mantenerli minimi)

Se la tua app è principalmente API + DB, appoggiati di più sui test di integrazione. Se è molto UI, mantieni un piccolo set di flussi E2E che rispecchino come gli utenti effettivamente riescono (e falliscono).

Test di regressione dove fa più male

Quando un bug costa tempo, soldi o fiducia, aggiungi subito un test di regressione. Prioritizza comportamenti come “un cliente non può completare il checkout”, “un job addebita due volte” o “un aggiornamento corrompe record”. Questo crea una rete di sicurezza crescente attorno alle aree a più alto rischio invece di spargere test ovunque.

Test di integrazione ripetibili con dati seedati

I test di integrazione devono essere deterministici. Usa fixture e dati seedati così le esecuzioni non dipendono da ciò che c'è nel DB locale di uno sviluppatore. Ripristina lo stato tra i test e mantieni i dati di test piccoli ma rappresentativi.

Non serve un programma completo di load testing ancora, ma dovresti avere controlli rapidi di performance per endpoint chiave e job in background. Un semplice smoke test basato su soglie (es. p95 sotto X ms con piccola concorrenza) cattura regressioni ovvie presto.

Automatizza i controlli in CI

Ogni modifica dovrebbe eseguire cancelli automatici:

- linting e formattazione

- controlli di tipo (se applicabili)

- suite unit + integrazione

- scan di sicurezza di base (dipendenze/vulnerabilità)

Se i test non vengono eseguiti automaticamente, sono opzionali—e la produzione lo dimostrerà prima o poi.

Osservabilità: sapere cosa succede senza indovinare

Quando un prototipo si rompe, di solito puoi “riprovare”. In produzione, quell'approccio diventa downtime, churn e notti in bianco. L'osservabilità accorcia il tempo tra “qualcosa non va” e “ecco esattamente cosa è cambiato, dove e chi è impattato”.

Inizia con log che rispondono a domande reali

Logga ciò che conta, non tutto. Vuoi abbastanza contesto per riprodurre un problema senza scaricare dati sensibili.

- Includi un request ID in ogni richiesta e portalo attraverso il sistema.

- Aggiungi identificatori utente/sessione in modo sicuro (hashati o ID interni; mai password, dati di pagamento o segreti in chiaro).

- Registra esiti: successo/fallimento, codici di stato e motivi d'errore significativi.

Una buona regola: ogni log d'errore dovrebbe rendere ovvio cosa è fallito e cosa controllare dopo.

Misura i “golden signals”

Le metriche ti danno un battito vitale in tempo reale. Al minimo, traccia i golden signals:

- Latenza (quanto è lento)

- Errori (quanto è rotto)

- Traffico (quanto)

- Saturazione (quanto vicino alla capacità)

Queste metriche ti aiutano a distinguere “più utenti” da “qualcosa non va”.

Aggiungi tracing quando le richieste attraversano confini

Se un'azione utente scatena più servizi, code o chiamate terze, il tracing trasforma un mistero in una timeline. Anche un tracing distribuito basilare mostra dove si trascorre tempo e quale dipendenza sta fallendo.

Gli alert devono essere azionabili, non rumorosi

Lo spam di alert addestra le persone a ignorarli. Definisci:

- Quali condizioni meritano paging (impatto visibile all'utente)

- Chi è on-call e i tempi di risposta attesi

- Come appare il “bene” (soglie legate a SLA/SLO)

Una dashboard che risponde alle tre grandi domande

Costruisci una dashboard semplice che risponda subito: È giù? È lento? Perché? Se non può rispondere, è decorazione e non operatività.

Rilasci e operazioni: distribuire cambiamenti senza drammi

Indurire non riguarda solo la qualità del codice—riguarda anche come cambi il sistema una volta che le persone contano su di esso. I prototipi tollerano il “push su main e speriamo”. La produzione no. Le pratiche di rilascio e operazione trasformano il deploy in un'attività routinaria anziché in un evento ad alto rischio.

Standardizza build e deployment (CI/CD)

Rendi build e deploy ripetibili, scriptati e noiosi. Una pipeline CI/CD semplice dovrebbe: eseguire controlli, costruire l'artifact nello stesso modo ogni volta, deployare in un ambiente noto e registrare esattamente cosa è cambiato.

Il vantaggio è la coerenza: puoi riprodurre un rilascio, confrontare due versioni ed evitare sorprese “funziona sulla mia macchina”.

Usa feature flag per distribuire in sicurezza

I feature flag separano deploy (mettere il codice in produzione) da release (attivarlo per gli utenti). Così puoi spedire piccoli cambi frequentemente, abilitarli gradualmente e spegnerli rapidamente se qualcosa va storto.

Mantieni disciplina: nomina chiaramente le flag, assegna proprietari e rimuovile quando l'esperimento è finito. Le “flag misteriose” permanenti diventano un rischio operativo a loro volta.

Definisci il rollback—e esercitalo

Una strategia di rollback è reale solo se l'hai testata. Decidi cosa significa “rollback” per il tuo sistema:

- Ridistribuire la versione precedente?

- Disabilitare una feature flag?

- Procedere con un fix (roll forward)?

- Ripristinare dati dai backup (lento, rischioso, a volte necessario)?

Poi prova in un ambiente sicuro. Cronometra quanto ci vuole e documenta i passi esatti. Se il rollback richiede un esperto in vacanza, non è una strategia.

Se usi una piattaforma che già supporta inversioni sicure, sfruttala. Per esempio, gli snapshot e il workflow di rollback di Koder.ai possono fare del “fermare l'emorragia” un'azione prima-classificata e ripetibile mentre continui a iterare velocemente.

Versiona le API e registra i cambiamenti ai dati

Quando altri sistemi o clienti dipendono dalle tue interfacce, i cambiamenti necessitano di guardrail.

Per le API: introduci versioning (anche semplice /v1) e pubblica un changelog così i consumatori sanno cosa cambia e quando.

Per i cambi di dati/schema: trattali come rilasci a tutti gli effetti. Preferisci migrazioni retrocompatibili (aggiungi campi prima di rimuovere i vecchi) e documentale insieme ai rilasci applicativi.

Basi di capacity: quote, rate limit, soglie di scaling

“Funzionava ieri” spesso si rompe perché traffico, job batch o uso cliente è cresciuto.

Imposta protezioni e aspettative di base:

- Quote e rate limit per evitare che un tenant/utente sovrasti il sistema

- Soglie di scaling chiare (CPU, profondità code, latenza) che scatenano azione

- Un piano leggero per cosa succede quando raggiungi i limiti (throttle, shed load o scale)

Fatto bene, la disciplina di rilascio e operazioni fa sembrare sicuro lo shipping—anche quando ti muovi in fretta.

Incidenti: preparati al primo giorno nero

Gli incidenti sono inevitabili una volta che utenti reali dipendono dal tuo sistema. La differenza tra “una giornata storta” e “una giornata che minaccia il business” è sapere—prima—chi fa cosa, come comunichi e come impari.

Una checklist leggera per gli incidenti

Tienila come documento corto e reperibile (pinnala su Slack, linkala nel README o mettila nei /runbooks). Una checklist pratica include solitamente:

- Identificare: conferma l'impatto, ora d'inizio, utenti coinvolti e sintomi correnti.

- Mitigare: fermare l'emorragia prima (rollback, disabilita feature flag, scala, failover).

- Comunicare: un proprietario posta aggiornamenti a intervalli fissi (es. ogni 15–30 minuti) agli stakeholder interni e, se necessario, ai clienti.

- Imparare: cattura cosa è successo mentre è fresco; programma un postmortem.

Postmortem senza colpe

Scrivi postmortem che si concentrano su fix, non colpe. I buoni postmortem producono follow-up concreti: alert mancante → aggiungi alert; proprietà poco chiara → assegna on-call; deploy rischioso → aggiungi step canary. Mantieni il tono fattuale e rendi facile contribuire.

Traccia le ripetizioni esplicitamente: lo stesso timeout ogni settimana non è “sfortuna”, è backlog. Mantieni una lista di problemi ricorrenti e trasforma i colpevoli principali in lavoro pianificato con proprietari e scadenze.

Fai attenzione con SLA/SLO

Definisci SLA/SLO solo quando sei pronto a misurarli e mantenerli. Se non hai monitoraggio consistente e qualcuno responsabile della risposta, inizia con obiettivi interni e alert base, poi formalizza le promesse più avanti.

Una checklist pratica di decisione e passi successivi

Non devi indurire tutto in una volta. Devi indurire le parti che possono danneggiare utenti, soldi o reputazione—e mantenere il resto flessibile così puoi continuare a imparare.

Da indurire ora (percorsi critici)

Se uno di questi fa parte del percorso utente, trattalo come “percorsi di produzione” e induriscilo prima di ampliare l'accesso:

- Auth & autorizzazioni: login, reset password, controlli di ruolo, cancellazione account.

- Soldi & impegni: fatturazione, rimborsi, cambi piano, checkout, fatture.

- Integrità dei dati: scritture su record primari, idempotenza, migrazioni, backup/restore.

- Affidabilità visibile all'utente: timeouts richieste, retry, rate limit, degradazione graduale.

- Basi di sicurezza: gestione dei segreti, accesso minimo privilegi, validazione input, audit per azioni sensibili.

- Basi operative: monitoraggio per SLI chiave (error rate, latenza, saturazione), alert che chiamano una persona, runbook per i principali failure mode.

Può restare vibey (per ora)

Mantieni più leggeri questi elementi mentre cerchi product–market fit:

- Tooling interno usato da un piccolo team formato.

- Esperimenti e prototipi usa e getta dietro feature flag.

- Polish UI che non cambia i workflow core.

- Automazioni non critiche con fallback manuali semplici.

Esegui uno sprint di indurimento a tempo limitato

Prova 1–2 settimane focalizzate solo sul percorso critico. I criteri di uscita devono essere concreti:

- I principali flussi utente hanno test basici e una run di test ripetibile.

- Dashboard + alert esistono per i flussi importanti.

- Il rollback o deploy sicuro è provato (anche se manuale).

- Rischi noti sono scritti con proprietario e piano di mitigazione.

Gate semplici go/no-go

- Gate di lancio (accesso limitato): “Rileviamo i guasti rapidamente, fermiamo l'emorragia e proteggiamo i dati.”

- Gate di espansione (più utenti/traffico): “Possiamo gestire aumenti prevedibili di carico e recuperare da un deploy fallito senza eroi.”

Un ritmo sostenibile

Per evitare oscillazioni tra caos e sovraingegnerizzazione, alterna:

- Settimane di esperimento: spedire cambi focalizzati sull'apprendimento velocemente.

- Settimane di stabilizzazione: pagare debito di affidabilità/sicurezza/testing scoperto durante gli esperimenti.

Se vuoi una versione in una pagina di tutto questo, trasforma i punti sopra in una checklist e rivedila a ogni lancio o espansione d'accesso.