Perché Shannon conta ancora nella tecnologia di tutti i giorni

Usi le idee di Claude Shannon ogni volta che mandi un messaggio, guardi un video o ti connetti al Wi‑Fi. Non perché il tuo telefono “conosca Shannon”, ma perché i sistemi digitali moderni si basano su una promessa semplice: possiamo trasformare messaggi disordinati in bit, far transitare quei bit su canali imperfetti e comunque recuperare il contenuto originale con alta affidabilità.

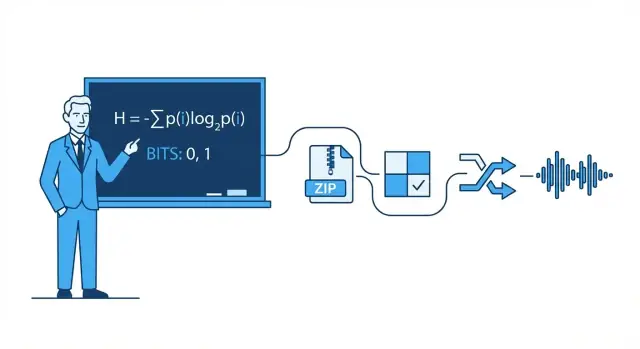

La teoria dell'informazione è la matematica dei messaggi: quanta scelta (incertezza) contiene un messaggio, quanto efficientemente può essere rappresentato e quanto affidabilmente può essere trasmesso quando rumore, interferenze e congestione si mettono di mezzo.

C'è matematica dietro, ma non serve essere matematici per avere l'intuizione pratica. Usiamo esempi di tutti i giorni — come perché alcune foto si comprimono meglio di altre, o perché una chiamata può andare bene anche con segnale debole — per spiegare le idee senza formule pesanti.

I quattro pilastri che vedrai ovunque

Questo articolo ruota attorno a quattro pilastri ispirati a Shannon che compaiono nella tecnologia moderna:

- Compressione: ridurre i dati (audio, video, file) senza perdere ciò che conta.

- Correzione degli errori: aggiungere giusti bit extra in modo che gli errori possano essere rilevati e corretti.

- Affidabilità di rete: gestire pacchetti persi con ritrasmissioni, ordinamento e compromessi di throughput.

- Comunicazione digitale end-to-end: vedere l'intera catena dalla sorgente (il tuo messaggio) al canale (Wi‑Fi, cellulare, fibra) e ritorno.

Cosa saprai valutare alla fine

Alla fine dovresti riuscire a ragionare sui compromessi reali: perché qualità video più alta richiede più banda, perché “più tacche” non significa sempre internet più veloce, perché alcune app sembrano immediate mentre altre fanno buffering, e perché ogni sistema incontra limiti — in particolare il famoso limite di Shannon sulla quantità di dati affidabili che un canale può trasportare.

Claude Shannon in una pagina: l'idea principale

Nel 1948, il matematico e ingegnere Claude Shannon pubblicò un articolo intitolato A Mathematical Theory of Communication che ha rimodellato il modo di pensare alla trasmissione dei dati. Invece di considerare la comunicazione come un'arte, la trattò come un problema di ingegneria: una sorgente produce messaggi, un canale li trasporta, il rumore li corrompe e un ricevitore cerca di ricostruire quanto inviato.

La mossa chiave di Shannon fu definire informazione in modo misurabile e utile per le macchine. Nel suo quadro, l'informazione non riguarda quanto importante sembra un messaggio, cosa significa o se è vera. Riguarda quanto è sorprendente — quanta incertezza viene rimossa quando conosci il risultato.

Se sai già cosa succederà, il messaggio porta quasi nessuna informazione. Se sei veramente incerto, apprendere il risultato ne porta di più.

Il bit: l'unità più semplice che puoi contare

Per misurare l'informazione, Shannon rese popolare il bit (binary digit). Un bit è la quantità di informazione necessaria per risolvere una semplice incertezza sì/no.

Esempio: se chiedo “La luce è accesa?” e non hai idea prima, la risposta (sì o no) può essere vista come 1 bit di informazione. Molti messaggi reali si possono scomporre in lunghe sequenze di queste scelte binarie, per questo tutto, dal testo alle foto all'audio, può essere memorizzato e trasmesso come bit.

Cosa farà (e non farà) questo post

Questo articolo si concentra sull'intuizione pratica dietro le idee di Shannon e sul perché appaiono ovunque: compressione (rendere i file più piccoli), correzione degli errori (riparare le corruzioni), affidabilità di rete (ritrasmissioni e throughput) e capacità del canale (quanto velocemente puoi inviare dati su un link rumoroso).

Non faremo dimostrazioni matematiche pesanti. Non serve matematica avanzata per capire il succo: una volta che puoi misurare l'informazione, puoi progettare sistemi che si avvicinano al massimo dell'efficienza possibile — spesso sorprendentemente vicino ai limiti teorici che Shannon descrisse.

Bit, simboli e codici: un vocabolario pratico

Prima di parlare di entropia, compressione o correzione degli errori, conviene fissare alcuni termini quotidiani. Le idee di Shannon sono più facili se puoi chiamare i pezzi per nome.

Simboli, alfabeti e messaggi

Un simbolo è un “token” preso da un insieme concordato. Quell'insieme è l'alfabeto. Nel testo in inglese l'alfabeto può essere lettere (più spazio e punteggiatura). In un file informatico l'alfabeto può essere i valori di byte 0–255.

Un messaggio è una sequenza di simboli di quell'alfabeto: una parola, una frase, un file immagine o uno stream di campioni audio.

Per rendere le cose concrete, immagina un alfabeto piccolo: {A, B, C}. Un messaggio potrebbe essere:

A A B C A B A ...

Bit e codici

Un bit è una cifra binaria: 0 o 1. I computer memorizzano e trasmettono bit perché l'hardware distingue in modo affidabile due stati.

Un codice è una regola per rappresentare simboli usando bit (o altri simboli). Per il nostro alfabeto {A, B, C}, un codice binario possibile è:

Ora qualsiasi messaggio fatto di A/B/C può essere trasformato in uno stream di bit.

Codifica vs. compressione vs. crittografia

Questi termini si confondono spesso:

- Codifica: tradurre i dati in un formato scelto per poterli memorizzare/trasmettere/processare (come mappare A/B/C in bit o convertire testo in UTF‑8).

- Compressione: una codifica che usa meno bit in media sfruttando pattern e frequenze non uniformi.

- Crittografia: mescolare i dati con una chiave in modo che gli esterni non possano leggerli; riguarda la segretezza, non la dimensione.

Una veloce intuizione di probabilità

I messaggi reali non sono casuali: alcuni simboli appaiono più spesso di altri. Supponiamo che A accada il 70% delle volte, B il 20%, C il 10%. Una buona compressione darà sequenze di bit più corte ai simboli comuni (A) e più lunghe a quelli rari (C). Questa diseguaglianza è ciò che le sezioni successive quantificheranno con l'entropia.

Entropia: misurare la sorpresa (e perché predice la comprimibilità)

L'idea più famosa di Shannon è l'entropia: un modo per misurare quanta “sorpresa” c'è in una sorgente di informazione. Non sorpresa come emozione, ma come imprevedibilità. Più è imprevedibile il prossimo simbolo, più informazione contiene quando arriva.

Immagina di guardare lanci di moneta.

- Moneta equa (50/50): ogni lancio è difficile da prevedere. Testa è tanto probabile quanto croce, quindi sei spesso “sorpreso” in entrambi i casi. Alta imprevedibilità significa alta entropia.

- Moneta truccata (es. 95% testa, 5% croce): la maggior parte dei lanci è testa. Dopo pochi lanci ti aspetti testa, perciò vedere testa aggiunge poca informazione. Solo la rara croce è sorprendente. In media, la sequenza ha bassa entropia.

Questa frammentazione di “sorpresa media” si accorda con i pattern quotidiani: un file di testo con spazi e parole comuni è più facile da prevedere di un file di caratteri casuali.

Perché prevedibilità implica comprimibilità

La compressione funziona assegnando codici più corti ai simboli comuni e codici più lunghi ai rari. Se la sorgente è prevedibile (bassa entropia), puoi usare spesso codici corti e risparmiare spazio. Se è quasi casuale (alta entropia), c'è meno margine per ridurla perché niente compare abbastanza spesso da sfruttarlo.

Shannon mostrò che l'entropia fissa un benchmark concettuale: è il limite inferiore sulla media di bit per simbolo che puoi ottenere codificando dati da quella sorgente.

Importante: l'entropia non è un algoritmo di compressione. Non ti dice esattamente come comprimere un file. Ti dice cosa è teoricamente possibile—e quando sei già vicino al limite.

La compressione avviene quando prendi un messaggio che potrebbe essere descritto con meno bit e lo fai davvero. L'intuizione di Shannon è che i dati con entropia più bassa (più prevedibilità) hanno spazio per ridursi, mentre dati ad alta entropia non ce l'hanno.

Perché i pattern e le frequenze sbilanciate si comprimono bene

I pattern ripetuti sono il beneficio ovvio: se un file contiene le stesse sequenze molte volte, puoi memorizzare la sequenza una sola volta e riferirti a essa spesso. Ma anche senza ripetizioni evidenti, le frequenze dei simboli sbilanciate aiutano.

Se in un testo la “e” appare molto più spesso della “z”, o un file di log ripete timestamp e parole chiave, non serve spendere lo stesso numero di bit per ogni carattere. Più le frequenze sono diseguali, più la sorgente è prevedibile e più si può comprimere.

Codifica a lunghezza variabile (l'intuizione centrale)

Un modo pratico per sfruttare frequenze sbilanciate è la codifica a lunghezza variabile:

- I simboli frequenti hanno codici corti

- I simboli rari hanno codici lunghi

Fatto con cura, questo riduce la media dei bit per simbolo senza perdere informazione.

I compressori lossless reali spesso combinano più idee, ma di solito senti parlare di queste famiglie:

- Codifica di Huffman: costruisce un dizionario efficiente “corto-per-comune”.

- Codifica aritmetica: comprime simboli in un intervallo frazionario, spesso avvicinandosi di più al limite dell'entropia.

- Metodi LZ (Lempel–Ziv): trovano sottostringhe ripetute e le sostituiscono con riferimenti (usati in molti formati stile ZIP).

Lossless vs. lossy (ZIP vs. JPEG/MP3)

Compressione lossless riproduce l'originale perfettamente (es. ZIP, PNG). È essenziale per software, documenti e tutto ciò in cui un singolo bit sbagliato conta.

Compressione lossy scarta intenzionalmente informazioni che di solito le persone non notano (es. JPEG per immagini, MP3/AAC per audio). L'obiettivo diventa “stessa esperienza” invece di “stessi bit”, ottenendo spesso file molto più piccoli eliminando dettagli percettivi minori.

Gli errori succedono: perché la ridondanza è utile

Costruisci un prototipo in fretta

Trasforma questi tradeoff di Shannon in un'app funzionante partendo da una specifica in chat su Koder.ai.

Ogni sistema digitale si regge su un presupposto fragile: un 0 rimane 0 e un 1 rimane 1. In realtà i bit possono cambiare.

Da dove vengono gli errori

In trasmissione, interferenze elettriche, segnali Wi‑Fi deboli o rumore radio possono spostare un segnale oltre una soglia rendendo il ricevitore interpreti male. Nello storage, effetti fisici minori—usura nella memoria flash, graffi sui supporti ottici, perfino radiazione—possono alterare uno stato memorizzato.

Poiché gli errori sono inevitabili, gli ingegneri aggiungono intenzionalmente ridondanza: bit extra che non portano informazione “nuova”, ma aiutano a rilevare o riparare danni.

Ridondanza semplice che già usi

Bit di parità (rilevazione rapida). Aggiungi un bit in modo che il totale dei 1 sia pari o dispari. Se un singolo bit cambia, il controllo di parità fallisce.

- Pro: economico e veloce.

- Contro: di solito non dice quale bit è sbagliato, e due flip possono annullarsi a vicenda.

Checksum (rilevazione migliore per blocchi). Invece di un bit, calcoli un piccolo numero riassuntivo su un pacchetto o file (es. somma, CRC). Il ricevitore ricalcola e confronta.

- Pro: cattura molti errori multi-bit su un blocco.

- Contro: solo rilevazione; se fallisce, serve una ritrasmissione o una copia di backup.

Codice per ripetizione (correzione semplice). Invia ogni bit tre volte: 0 diventa 000, 1 diventa 111. Il ricevitore usa la maggioranza.

- Pro: può correggere un singolo bit sbagliato in ogni gruppo di tre.

- Contro: estremamente inefficiente—triplica i dati.

Rilevazione vs. correzione (e quando usare ciascuna)

Rilevazione degli errori risponde: “È successo qualcosa di sbagliato?” Comune quando le ritrasmissioni sono economiche—come pacchetti di rete che possono essere inviati di nuovo.

Correzione degli errori risponde: “Quali erano i bit originali?” Utile quando ritrasmettere è costoso o impossibile—streaming su link rumorosi, comunicazioni nello spazio profondo o lettura di dati di storage dove rileggere potrebbe comunque fallire.

La ridondanza può sembrare spreco, ma è il motivo per cui i sistemi moderni possono essere veloci e affidabili nonostante hardware imperfetto e canali rumorosi.

Capacità del canale e il limite di Shannon (senza matematica pesante)

Quando invii dati su un canale reale—Wi‑Fi, cellulare, cavo USB, o anche un hard disk—rumore e interferenze possono capovolgere bit o sfocare simboli. La grande promessa di Shannon fu sorprendente: la comunicazione affidabile è possibile, anche su canali rumorosi, purché non si tenti di spingere troppa informazione attraverso.

Capacità del canale in termini semplici

La capacità del canale è il “limite di velocità” del canale: la massima velocità (bit al secondo) con cui puoi trasmettere con errori portati arbitrariamente vicino a zero, dato il livello di rumore e vincoli come banda e potenza.

Non è lo stesso del tasso simbolico grezzo (quanto velocemente cambi un segnale). Riguarda quanta informazione significativa sopravvive dopo il rumore—quando usi codifica, ridondanza e decodifica intelligenti.

Il limite di Shannon: un confine che gli ingegneri inseguono

Il limite di Shannon è il nome pratico per questo confine: sotto di esso puoi (in teoria) rendere la comunicazione tanto affidabile quanto vuoi; sopra di esso non puoi—gli errori rimangono nonostante ogni accorgimento.

Gli ingegneri lavorano molto per avvicinarsi a questo limite con modulazione e codici migliori. Sistemi moderni come LTE/5G e Wi‑Fi usano codifiche avanzate per operare vicino a questo confine invece di sprecare potenza del segnale o banda.

Il compromesso chiave (velocità vs. probabilità di errore)

Pensalo come caricare oggetti in un furgone su una strada sconnessa:

- Se carichi troppo pieno (velocità sopra la capacità), alcuni oggetti si romperanno sempre (un tasso di errore non nullo).

- Se carichi con spazio e imbottitura (velocità sotto la capacità), puoi rendere le rotture rarissime—a costo di throughput minore o più ridondanza.

Shannon non ci diede un “codice migliore”, ma dimostrò che il limite esiste—e che vale la pena avvicinarsi.

Codici correttori di errore nei sistemi reali

Collabora e invita

Invita i colleghi con un referral link e costruite lo stack completo insieme.

Il teorema del canale rumoroso di Shannon è spesso riassunto come una promessa: se invii dati sotto la capacità di un canale, esistono codici che rendono gli errori arbitrariamente rari. L'ingegneria pratica trasforma quella prova di esistenza in schemi concreti che si adattano a chip, batterie e scadenze.

Il kit pratico: blocchi, interleaving e decisioni migliori

La maggior parte dei sistemi reali usa codici a blocchi (proteggono un pezzo di bit alla volta) o codici a flusso (proteggono una sequenza continua).

Con i codici a blocchi, aggiungi ridondanza progettata a ciascun blocco in modo che il ricevitore possa rilevare e correggere errori. Con interleaving, rimescoli l'ordine dei bit/simboli trasmessi così che un burst di rumore (molti errori consecutivi) si sparga in errori più piccoli e correggibili su più blocchi—fondamentale per wireless e storage.

Un'altra grande distinzione è come il ricevitore “decide” cosa ha ricevuto:

- Decisioni hard: ogni segnale ricevuto diventa subito 0 o 1.

- Decisioni soft: il ricevitore mantiene anche una confidenza (es. “probabilmente 1, ma non ne sono sicuro”).

Le decisioni soft forniscono più informazione al decoder e possono migliorare molto l'affidabilità, specialmente in Wi‑Fi e cellulare.

Codici che hai già usato

- Reed–Solomon: operano su simboli (non su singoli bit) e sono eccellenti contro burst. Usati in QR code, CD/DVD e alcuni sistemi di broadcast/storage.

- Codici convoluzionali: scelta classica per flussi continui; usati storicamente in link satellitari.

- Turbo code: grande progresso negli anni '90, diffusi in 3G/4G.

- LDPC (Low-Density Parity-Check): codici a blocchi moderni ed efficienti usati in Wi‑Fi, 5G e molti sistemi ad alto throughput.

Dove contano

Dalla comunicazione nello spazio profondo (dove ritrasmettere è costoso o impossibile) a satelliti, Wi‑Fi e 5G, i codici correttori sono il ponte pratico tra la teoria di Shannon e la realtà dei canali rumorosi: scambiano bit e calcolo extra per meno chiamate cadute, download più veloci e link più affidabili.

Affidabilità di rete: pacchetti, ritrasmissioni e throughput

Internet funziona anche se i link individuali sono imperfetti. Il Wi‑Fi svanisce, i segnali mobili vengono bloccati, e rame e fibra soffrono comunque rumore, interferenza e guasti occasionali. Il messaggio centrale di Shannon—il rumore è inevitabile ma l'affidabilità è raggiungibile—si vede nelle reti come una miscela attenta di rilevazione/correzione degli errori e ritrasmissioni.

Pacchetti: piccole scommesse invece di una grande

I dati sono spezzati in pacchetti così la rete può instradare intorno ai problemi e recuperare perdite senza ritrasmettere tutto. Ogni pacchetto porta bit extra (header e checksum) che aiutano il ricevitore a capire se quello arrivato è affidabile.

Un modello comune è ARQ (Automatic Repeat reQuest):

- Il ricevitore controlla un pacchetto (tipicamente con checksum/CRC).

- Se va bene, invia un acknowledgment (ACK).

- Se manca o è corrotto, il mittente ritrasmette dopo un timeout (o su richiesta di negative acknowledgment).

Correggere o ritrasmettere: il compromesso di latenza

Quando un pacchetto è sbagliato, hai due scelte principali:

- Correggerlo subito con forward error correction (FEC): aggiungi abbastanza ridondanza perché il ricevitore possa riparare alcuni errori senza chiedere altro.

- Ritrasmettere con ARQ: mandi meno ridondanza iniziale, ma paghi tempo extra quando qualcosa va storto.

FEC può ridurre i ritardi su link dove le ritrasmissioni sono costose (alta latenza, perdita intermittente). ARQ è efficiente quando le perdite sono rare, perché non gravano ogni pacchetto con molta ridondanza.

Throughput, congestione e perché l'affidabilità non è gratis

I meccanismi di affidabilità consumano capacità: bit extra, pacchetti in più e attese. Le ritrasmissioni aumentano il carico, peggiorando la congestione; la congestione a sua volta aumenta ritardo e perdita, scatenando altre ritrasmissioni.

Un buon design di rete cerca un equilibrio: abbastanza affidabilità per consegnare dati corretti mantenendo l'overhead basso così che la rete possa sostenere un throughput sano in condizioni variabili.

Comunicazione digitale end-to-end: dalla sorgente al canale

Un modo utile per capire i sistemi digitali moderni è pensarli come una pipeline con due compiti: ridurre la dimensione del messaggio e far sopravvivere il messaggio al viaggio. L'intuizione di Shannon è che spesso puoi trattare queste due cose come livelli separati—anche se i prodotti reali a volte li mescolano.

Passo 1: source coding (compressione)

Si parte da una “sorgente”: testo, audio, video, letture di sensori. Il source coding rimuove la struttura prevedibile per non sprecare bit. Può essere ZIP per file, AAC/Opus per audio o H.264/AV1 per video.

La compressione è dove l'entropia entra in gioco: più prevedibile è il contenuto, meno bit servono in media.

Passo 2: channel coding (correzione degli errori)

Poi i bit compressi devono attraversare un canale rumoroso: Wi‑Fi, cellulare, fibra, cavo USB. Il channel coding aggiunge ridondanza progettata in modo che il ricevitore possa rilevare e correggere errori. Questo è il mondo di CRC, Reed–Solomon, LDPC e altri metodi FEC.

L'idea di separazione di Shannon (un modello mentale utile)

Shannon mostrò che, in teoria, puoi progettare il source coding per avvicinarsi alla miglior compressione possibile e il channel coding per avvicinarsi alla miglior affidabilità fino alla capacità del canale—in modo indipendente.

Nella pratica, questa separazione è ancora un buon modo per fare debug: se le prestazioni sono scadenti, chiediti se perdi efficienza nella compressione (source coding), se perdi affidabilità sul link (channel coding), o se paghi troppa latenza con ritrasmissioni e buffering.

Esempio concreto: streaming video su Wi‑Fi

Quando guardi uno stream video, l'app usa un codec per comprimere i fotogrammi. Su Wi‑Fi, i pacchetti possono andare persi o corrompersi, quindi il sistema aggiunge rilevazione degli errori, a volte FEC, e poi usa le ritrasmissioni (ARQ) quando necessario. Se la connessione peggiora, il player può passare a un flusso a bitrate più basso.

I sistemi reali mescolano i livelli perché il tempo conta: aspettare ritrasmissioni può causare buffering, e le condizioni wireless cambiano in fretta. Per questo gli stack di streaming combinano scelte di compressione, ridondanza e adattamento insieme—non perfettamente separati, ma ancora guidati dal modello di Shannon.

Concezioni errate comuni e compromessi pratici

Condividi con il tuo team

Metti il prototipo su un dominio personalizzato per condivisione e test rapido con utenti reali.

La teoria dell'informazione è spesso citata e alcune idee vengono semplificate troppo. Ecco malintesi comuni—e i reali compromessi che gli ingegneri fanno quando progettano compressione, storage e reti.

Malinteso 1: “Entropia significa casuale”

Nel linguaggio comune “casuale” può voler dire “disordinato” o “imprevedibile”. L'entropia di Shannon è più precisa: misura la sorpresa data un modello di probabilità.

- Un flusso perfettamente prevedibile (tutti zeri) ha bassa entropia.

- Un flusso difficile da prevedere dato ciò che sai ha entropia più alta.

Quindi l'entropia non è un'impressione: è un numero legato alle assunzioni su come si comporta la sorgente.

Malinteso 2: “Più compressione è sempre meglio”

La compressione rimuove ridondanza. La correzione degli errori spesso aggiunge ridondanza apposta così il ricevitore può riparare danni.

Questo crea una tensione pratica:

- Se comprimi aggressivamente e poi invii su un canale rumoroso, potresti avere meno margine per recuperare dai danni.

- I sistemi ben progettati di solito comprimono prima (rimuovono pattern prevedibili), poi aggiungono ridondanza strutturata (codici correttori) per il canale.

Malinteso 3: “Possiamo essere perfettamente affidabili a qualsiasi velocità”

La capacità del canale dice che ogni canale ha un throughput affidabile massimo sotto certe condizioni di rumore. Sotto quel limite, i tassi di errore possono essere ridotti moltissimo con la codifica giusta; sopra quel limite, gli errori sono inevitabili.

Questo è il motivo per cui “perfettamente affidabile a qualsiasi velocità” non è possibile: aumentare la velocità di solito significa accettare maggiore probabilità di errore, più latenza (più ritrasmissioni) o più overhead (codifica più forte).

Una checklist semplice per i sistemi reali

Quando valuti un prodotto o un'architettura, chiediti:

- Statistiche della sorgente: i dati sono prevedibili (testo, log) o già vicini al caso (cifrati, compressi)?

- Rumore: cosa può corromperli—interferenza wireless, degrado fisico, perdita di pacchetti?

- Budget di latenza: puoi permetterti ritrasmissioni e buffering, o deve essere in tempo reale?

- Scelte di overhead: stai spendendo bit per compressione, correzione, ritrasmissioni o una combinazione?

Azzeccare questi quattro punti conta più che memorizzare formule.

Conclusioni e dove approfondire

Il messaggio centrale di Shannon è che l'informazione si può misurare, muovere, proteggere e comprimere con poche idee fondamentali.

- Un bit è la valuta comune che permette di trattare testo, audio, video e dati di sensori allo stesso modo una volta codificati.

- L'entropia misura quanto una sorgente è imprevedibile e predice quanto bene i dati si possono comprimere.

- Il rumore e la perdita sono inevitabili, quindi i sistemi affidabili aggiungono ridondanza tramite rilevazione e codici correttori.

- La capacità del canale stabilisce un tetto reale: oltre una certa velocità, non puoi “lavorare di più” e restare affidabile; devi abbassare la velocità, migliorare il canale o cambiare la codifica.

Reti e sistemi di storage moderni sono essenzialmente continui compromessi tra velocità, affidabilità, latenza e risorse di calcolo.

Nota pratica per chi costruisce

Se stai sviluppando prodotti reali—API, funzionalità di streaming, app mobile, pipeline di telemetry—il quadro di Shannon è una checklist utile: comprimi ciò che puoi, proteggi ciò che devi e sii esplicito sul budget di latenza/throughput. Un esempio immediato è quando prototipi sistemi end-to-end rapidamente e poi iteri: con una piattaforma di vibe-coding come Koder.ai, i team possono lanciare rapidamente una web app React, un backend Go con PostgreSQL e persino un client mobile Flutter da una specifica guidata via chat, quindi testare i compromessi reali (dimensione del payload, ritrasmissioni, comportamento del buffering) in anticipo. Funzionalità come planning mode, snapshot e rollback rendono più semplice sperimentare cambiamenti tra “maggiore affidabilità vs. minore overhead” senza perdere slancio.

Chi dovrebbe approfondire

Approfondire conviene a:

- Studenti che vogliono un modello mentale chiaro che colleghi probabilità, compressione e codifica

- Product manager che devono bilanciare qualità, latenza, banda e costi

- Ingegneri che lavorano su networking, codec multimediali, storage, telemetry o pipeline dati per ML

Per continuare, sfoglia gli explainer correlati in /blog, poi controlla /docs per come il nostro prodotto espone impostazioni e API legate a comunicazione e compressione. Se confronti piani o limiti di throughput, /pricing è la prossima tappa.