Definisci obiettivi, domande e metriche di successo

Prima di tracciare qualsiasi cosa, decidi cosa significa davvero “adozione” per il tuo prodotto. Se salti questo passaggio, raccoglierai molti dati—e continuerai a discutere in riunione su cosa “significa”.

Definisci “adozione” in termini semplici

L’adozione di solito non è un singolo momento. Scegli una o più definizioni che corrispondono a come viene erogato il valore:

- Use: un utente prova la funzionalità almeno una volta (utile per lanci nuovi).

- Repeat use: l’utente la usa di nuovo entro una finestra temporale (buono per workflow che creano abitudine).

- Value achieved: l’utente raggiunge un risultato che la funzionalità dovrebbe abilitare (spesso il segnale migliore).

Esempio: per “Saved Searches”, l’adozione potrebbe essere creato una ricerca salvata (use), eseguita 3+ volte in 14 giorni (repeat) e ricevuto un alert e cliccato (value achieved).

Elenca le decisioni che il tracciamento deve supportare

Il tuo tracciamento dovrebbe rispondere a domande che portano ad azioni, come:

- Cosa dovremmo migliorare perché è usato ma non porta valore?

- Cosa dovremmo ritirare perché aggiunge complessità con bassa adozione?

- Cosa dovremmo promuovere perché aumenta retention o upgrade?

Scrivi queste come enunciati di decisione (es. “Se l’attivazione cala dopo la release X, revertiamo le modifiche all’onboarding.”).

Identifica gli stakeholder e come useranno i report

Team diversi hanno bisogni diversi:

- Product (PM): adozione per segmento, impatto post-release, milestone di valore.

- Growth/Marketing: lift delle campagne, funnel di conversione, re-engagement.

- Support/Success: quali funzionalità correlano a meno ticket o rinnovi più alti.

- Engineering: salute dell’instrumentazione, variazioni di volume eventi, marker di release.

Stabilisci metriche di successo e cadenza

Scegli un piccolo insieme di metriche da rivedere settimanale, più un controllo leggero dopo ogni deploy. Definisci soglie (es. “tasso di adozione ≥ 25% tra utenti attivi in 30 giorni”) così il report guida le decisioni e non la discussione.

Mappa i dati necessari: utenti, funzionalità, eventi, outcomes

Prima di fare instrumentazione, decidi quali “entità” descriverà il tuo sistema di analytics. Se definisci bene queste entità, i report restano comprensibili anche quando il prodotto evolve.

Parti dalle entità core

Definisci ogni entità in linguaggio semplice, poi traducila in ID che puoi memorizzare:

- User: una persona che usa l’app (può iniziare anonima, poi autenticata).

- Account / workspace: il cliente pagante o il contenitore team a cui appartengono più utenti.

- Session: una visita limitata nel tempo (utile per engagement e troubleshooting; opzionale per alcuni prodotti).

- Feature: una capacità nominata che vuoi misurare (spesso un gruppo di eventi, non un singolo click).

- Event: un’azione o un’occorrenza di sistema che puoi registrare (es.

project_created, invite_sent).

- Outcome: la milestone di valore che vuoi che utenti/account raggiungano (es. “primo report condiviso”, “abbonamento attivato”).

Annota le proprietà minime per ogni evento: user_id (o anonymous ID), account_id, timestamp e poche proprietà rilevanti (plan, ruolo, device, feature flag, ecc.). Evita di riversare tutto “nel caso serva”.

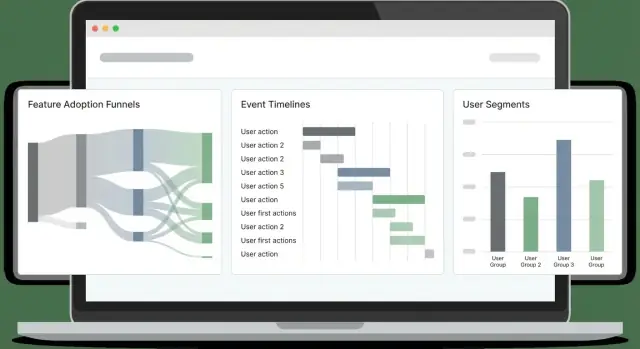

Scegli le viste di adozione che supporterai

Scegli gli angoli di report che corrispondono ai tuoi obiettivi di prodotto:

- Funnels (attivazione step-by-step)

- Cohorts (gruppi per data di signup, piano, canale)

- Retention (tornano e ripetono azioni chiave?)

- Paths (sequenze comuni prima/dopo una milestone)

- Time-to-first-value (quanto tempo fino al primo outcome significativo)

Il design degli eventi dovrebbe rendere questi calcoli semplici.

Sii esplicito sul perimetro: solo web inizialmente, o web + mobile sin da subito. Il tracciamento cross-platform è più semplice se standardizzi nomi eventi e proprietà presto.

Infine, definisci target non negoziabili: impatto accettabile sulle pagine, ingestion latency (quanto freschi devono essere i dashboard) e tempo di caricamento dashboard. Questi vincoli guidano le scelte successive su tracking, storage e querying.

Progetta uno schema di tracciamento degli eventi che resti consistente

Un buon schema non è “tracciare tutto” ma rendere gli eventi prevedibili. Se nomi e proprietà cambiano, i dashboard si rompono, gli analisti smettono di fidarsi dei dati e gli ingegneri esitano a instrumentare nuove funzionalità.

Parti da una convenzione di naming chiara

Scegli un pattern semplice e ripetibile. Una scelta comune è verb_noun:

viewed_pricing_pagestarted_trialenabled_featureexported_report

Usa un tempo coerente (passato o presente) e evita sinonimi (clicked, pressed, tapped) a meno che significhino cose diverse.

Definisci proprietà richieste (il “contratto”)

Ogni evento dovrebbe portare un piccolo set di proprietà obbligatorie per poter segmentare, filtrare e unire con affidabilità. Al minimo, definisci:

user_id (nullable per utenti anonimi, ma presente se conosciuto)account_id (se il prodotto è B2B/multi-seat)timestamp (generato dal server quando possibile)feature_key (identificatore stabile come bulk_upload)plan (es. free, pro, enterprise)

Queste proprietà rendono il tracciamento dell’adozione e l’analisi del comportamento molto più semplici perché non devi indovinare cosa manca in ogni evento.

Consenti proprietà opzionali—ma con moderazione

I campi opzionali aggiungono contesto, ma è facile esagerare. Tipiche proprietà opzionali:

device, os, browserpage, referrerexperiment_variant (o ab_variant)

Mantieni le proprietà opzionali coerenti tra eventi (stesse chiavi, stessi formati) e documenta i “valori permessi” quando possibile.

Versiona lo schema e scrivi una spec di instrumentazione

Supponi che lo schema evolverà. Aggiungi event_version (es. 1, 2) e aggiornalo quando cambi il significato o i campi obbligatori.

Infine, scrivi una spec di instrumentazione che elenchi ogni evento, quando scatta, proprietà obbligatorie/opzionali ed esempi. Conserva quel documento nel controllo versione insieme all’app così i cambiamenti di schema vengono revisionati come il codice.

Risolvi l’identità: anonimo, autenticato e viste a livello account

Se il modello di identità è fragile, le metriche di adozione saranno rumorose: i funnel non combaceranno, la retention sembrerà peggiore e gli “utenti attivi” saranno gonfiati da duplicati. L’obiettivo è supportare tre viste contemporanee: visitatori anonimi, utenti autenticati e attività a livello account/workspace.

Utenti anonimi vs identificati (quando collegare)

Inizia ogni dispositivo/sessione con un anonymous_id (cookie/localStorage). Nel momento in cui un utente si autentica, collega quella cronologia anonima a un user_id identificato.

Collega le identità quando l’utente ha provato di possedere l’account (login riuscito, magic link verificato, SSO). Evita di collegare su segnali deboli (email digitata in un form) a meno che non la separi chiaramente come “pre-auth”.

Login, logout e cambio account senza rompere le metriche

Tratta le transizioni di auth come eventi:

login_success (include user_id, account_id e l’attuale anonymous_id)logoutaccount_switched (da account_id → account_id)

Importante: non cambiare il cookie anonimo al logout. Se lo ruoti, frammenterai le sessioni e gonfierai gli utenti unici. Mantieni invece anonymous_id stabile, ma smetti di allegare user_id dopo il logout.

Regole di merge identità (ed evitare doppio conteggio)

Definisci regole di merge esplicite:

- User merge: preferisci un

user_id interno stabile. Se devi unire usando l’email, fallo server-side e solo per email verificate. Conserva una traccia audit.

- Account merge: usa un

account_id/workspace_id stabile generato dal tuo sistema, non un nome modificabile.

Durante i merge, mantieni una tabella di mapping (vecchio → nuovo) e applicala coerentemente a query time o tramite job di backfill. Questo evita che “due utenti” compaiano in cohort.

Conserva chiavi stabili

Memorizza e invia:

anonymous_id (stabile per browser/device)user_id (stabile per persona)account_id (stabile per workspace)

Con queste tre chiavi puoi misurare comportamento pre-login, adozione per utente e adozione a livello account senza doppio conteggio.

Scegli tracking client-side vs server-side (o un mix)

Dove tracci cambi ciò in cui puoi fidarti. Gli eventi browser dicono cosa le persone hanno tentato di fare; gli eventi server dicono cosa è realmente accaduto.

Tracking client-side (browser)

Usa il tracking client-side per interazioni UI e per il contesto disponibile solo nel browser. Esempi tipici:

- Page/screen views, click di bottoni, cambio tab, apertura/chiusura di modal

- “Viewed feature” (es. pagina impostazioni aperta)

- Contesto client: URL, referrer, UTM, tipo device, viewport, lingua

Batcha gli eventi per ridurre il traffico: metti in memoria, flush ogni N secondi o a N eventi, e esegui flush anche su visibilitychange/page hide.

Tracking server-side (API e job)

Usa il tracking server-side per eventi che rappresentano un risultato completato o azioni sensibili per fatturazione/sicurezza:

- Funzionalità abilitata/disabilitata salvata con successo

- Invito accettato, pagamento riuscito, export generato

- Job in background: sync terminato, report consegnato, email inviata

Il tracking server-side è spesso più accurato perché non è bloccato da ad blocker, reload o connettività instabile.

Approccio raccomandato: ibrido di default

Un pattern pratico: tracciare l’intento nel client e il successo sul server.

Per esempio, emetti feature_x_clicked_enable (client) e feature_x_enabled (server). Poi arricchisci gli eventi server con contesto client passando un context_id (o request ID) dal browser all’API.

Affidabilità: retry, backoff, buffering offline

Aggiungi resilienza dove gli eventi rischiano di perdersi:

- Client: mantieni una piccola coda in

localStorage/IndexedDB, ritenta con backoff esponenziale, imposta un limite e deduplica con event_id.

- Server: ritenta su errori transitori, usa una coda interna e assicurati idempotenza così un retry non duplica conteggi.

Questo mix dà dettagli comportamentali ricchi senza sacrificare metriche di adozione affidabili.

Pianifica l’architettura del sistema: ingestion, storage e query

Track web plus mobile

Create web and mobile apps together so event names stay consistent across platforms.

Un’app analytics per adozione funzionalità è principalmente una pipeline: cattura eventi in modo affidabile, memorizzali economicamente e interrogali abbastanza velocemente da guadagnare fiducia.

Componenti core (e perché contano)

Inizia con servizi semplici e separabili:

- Collector endpoint: un piccolo servizio HTTP che riceve eventi (da browser, mobile, backend). Rendilo rapido e minimale—valida il minimo, aggiungi timestamp server e rispondi velocemente.

- Queue/stream: ammortizza picchi di traffico e disaccoppia ingestion da processing (Kafka, Kinesis, Pub/Sub, SQS).

- Workers: consumano lo stream per arricchire, deduplicare, applicare schema e instradare i dati allo storage.

- Analytics store: ottimizzato per grandi volumi append-only di eventi (ClickHouse, BigQuery, Snowflake, Redshift).

- API: espone endpoint di query coerenti per dashboard (funnels, cohorts, retention) e per i permessi.

- UI: dashboard e strumenti di esplorazione; tienili separati così puoi cambiare storage/query senza riscrivere il frontend.

Se vuoi prototipare velocemente una web app analytics interna, una piattaforma vibe-coding come Koder.ai può aiutarti a mettere su rapidamente UI dashboard (React) e backend (Go + PostgreSQL) da uno spec guidato a chat—utile per avere una “slice” funzionante prima di consolidare la pipeline.

Storage: eventi raw vs aggregati

Usa due livelli:

- Eventi raw append-only per auditabilità e reprocessing. Trattali come fonte di verità.

- Aggregate/materialized views per velocità (DAU, utenti attivi per feature, conteggi step funnel). Le materialized views sono utili quando le stesse query vengono eseguite frequentemente.

Real-time vs batch (scegli in base alle decisioni)

Scegli la freschezza che il team realmente richiede:

- Near real-time (secondi/minuti) per monitorare lanci, drop di onboarding o outage.

- Daily batch per report di trend, adozione settimanale e riepiloghi esecutivi—più economico e spesso più semplice.

Molti team fanno entrambi: contatori real-time per “cosa sta succedendo ora” e job notturni che ricalcolano metriche canoniche.

Piano di scalabilità: partitioning e crescita

Progetta la crescita presto usando partizionamento:

- Per tempo (daily/monthly) per mantenere le query limitate e facilitare le retention policy.

- Per account/tenant per supportare permessi B2B e performance.

- Opzionalmente per tipo evento se pochi eventi ad alto volume dominano.

Prevedi anche retention (es. 13 mesi raw, aggregate più a lungo) e una strada per il replay così puoi correggere bug reprocessando eventi invece di patchare i dashboard.

Modellazione dei dati per eventi e query analitiche veloci

Una buona analytics parte da un modello che risponde rapidamente a domande comuni (funnels, retention, uso funzionalità) senza trasformare ogni query in un progetto ingegneristico su misura.

Scegli una strategia database a due livelli

La maggior parte dei team ottiene il meglio con due store:

- Relazionale (Postgres/MySQL) per metadata stabili che cambiano lentamente: utenti, account, definizioni di feature, access control e configurazione.

- Columnar/warehouse (ClickHouse/BigQuery/Snowflake) per eventi ad alto volume, dove servono scansioni e aggregazioni veloci.

Questa separazione mantiene il DB di prodotto snello e rende le query analitiche più economiche e rapide.

Definisci le tabelle core (e mantienile semplici)

Un baseline pratico:

- raw_events: una riga per evento (event_name, timestamp, user_id/anonymous_id, session_id, account_id, properties JSON, source).

- users: profilo utente + identificatori correnti.

- accounts: entità company/organization per rollup B2B.

- feature_catalog: lista canonica di feature (key, display_name, category, lifecycle status).

- sessions: confini di sessione (start/end, device, referrer) per analisi comportamentale.

- aggregates: metriche precomputate giornaliere/settimanali (es. DAU, feature_active_users, conteggi step funnel).

Nel warehouse, denormalizza ciò che interroghi spesso (es. copia account_id sugli eventi) per evitare join costosi.

Controlla costi e velocità con retention + partitioning

Partiziona raw_events per tempo (daily è comune) e opzionalmente per workspace/app. Applica retention in base al tipo evento:

- Conserva gli eventi prodotto di alto valore più a lungo (mesi/anni).

- Scarta rapidamente eventi di debug rumorosi.

Questo previene che la crescita “infinita” diventi il tuo problema analytics maggiore.

Inserisci controlli qualità nel modello

Considera i controlli qualità parte del modeling, non una pulizia successiva:

- Proprietà richieste mancanti (es. feature_key)

- Timestamp errati (date future, problemi di parsing timezone)

- Eventi duplicati (retry, doppia strumentazione)

Memorizza i risultati di validazione (o una tabella di eventi scartati) così puoi monitorare la salute dell’instrumentazione e correggere i problemi prima che i dashboard derivino.

Calcola metriche di adozione: funnels, cohort, retention e paths

Ship an event schema faster

Turn your event schema and required properties into endpoints, tables, and docs in one place.

Una volta che gli eventi scorrono, il passo successivo è trasformare click grezzi in metriche che rispondono: “Questa funzionalità viene davvero adottata, e da chi?” Concentrati su quattro viste che si completano: funnels, cohorts, retention e paths.

Funnels: adozione come sequenza (non un singolo click)

Definisci un funnel per ogni funzionalità così vedi dove gli utenti abbandonano. Un pattern pratico:

- Discovery → l’utente vede il punto d’ingresso della feature (bottone, menu, banner)

- First use → la prima interazione significativa (es.

feature_used)

- Repeat use → un secondo uso entro una finestra ragionevole (es. 7 giorni)

- Value action → l’azione che prova il valore (export creato, automation abilitata, report condiviso)

Mantieni i passaggi del funnel legati ad eventi di cui ti fidi e nominarli in modo coerente. Se “first use” può avvenire in modi diversi, trattalo come uno step con condizioni OR (es. import_started OR integration_connected).

Cohorts: confronta simili con simili

Le cohort ti aiutano a misurare miglioramenti nel tempo senza mischiare utenti vecchi e nuovi. Cohort comuni:

- Nuovi utenti per settimana (settimana di signup)

- Utenti attivati (hanno raggiunto l’evento di attivazione)

- Utenti retained (sono tornati e hanno fatto qualcosa di significativo)

- Power users (alta frequenza o azioni avanzate)

Monitora i tassi di adozione dentro ogni cohort per vedere se onboarding o cambi UI recenti aiutano.

Retention: “tornano e continuano a usarla?”

La retention è più utile quando è legata a una funzionalità, non solo a “aperture app”. Definiscila come la ripetizione dell’evento core della feature (o dell’action di valore) a Giorno 7/30. Traccia anche il “tempo al secondo uso” — spesso è più sensibile della retention grezza.

Segmentazione e paths: chi adotta e come ci arrivano

Scomponi le metriche per dimensioni che spiegano il comportamento: plan, ruolo, settore, device, canale di acquisizione. I segmenti spesso rivelano che l’adozione è alta per un gruppo e vicina allo zero per un altro.

Aggiungi path analysis per trovare sequenze comuni prima e dopo l’adozione (es. utenti che adottano visitano spesso pricing, poi docs, poi connettono un’integrazione). Usa questo per migliorare onboarding e rimuovere vicoli ciechi.

Costruisci dashboard che le persone useranno davvero

I dashboard falliscono quando cercano di servire tutti con una sola “vista master”. Progetta invece poche pagine focalizzate che rispondono a domande chiare e rendi ogni pagina utile per decisioni specifiche.

Inizia con pagine specifiche per pubblico

Un overview esecutivo dovrebbe essere un check rapido di salute: trend di adozione, utenti attivi, top feature e cambiamenti rilevanti dalla release più recente. Una deep dive per una feature dovrebbe servire PM e ingegneri: dove iniziano gli utenti, dove abbandonano e quali segmenti si comportano diversamente.

Una struttura semplice che funziona bene:

- Overview: trend di adozione, trend di retention e poche KPI principali

- Feature page: funnel, cohort retention e frequenza d’uso per una singola feature

- Segment explorer: confronta piani, regioni o dimensioni workspace affiancati

Rendi l’esplorazione semplice (senza creare caos)

Includi grafici di trend per il “cosa”, breakdown segmentati per il “chi” e drill-down per il “perché”. Il drill-down dovrebbe permettere di cliccare una barra/punto e vedere utenti o workspace di esempio (con permessi appropriati), così i team possono validare pattern e investigare sessioni reali.

Mantieni i filtri coerenti tra le pagine così gli utenti non devono riapprendere i controlli. I filtri più utili per il tracciamento adozione sono:

- Intervallo di date

- Plan / tier

- Attributi workspace/account (dimensione, settore)

- Regione

- Versione app (o canale di release)

Condivisione, export e viste salvate

I dashboard entrano nei workflow quando le persone possono condividere esattamente ciò che vedono. Aggiungi:

- Export in CSV per analisi rapide in fogli di calcolo

- Share con una vista salvata (filtri + stato grafici + segmento selezionato)

- Email/Slack programmati che rimandano alla vista salvata

Se lo stai costruendo in un’app di product analytics, considera una pagina /dashboards con viste salvate “Pinned” così gli stakeholder atterrano sempre sui report che contano.

Aggiungi alert, anomalie e marker di release

I dashboard sono ottimi per esplorare, ma i team spesso si accorgono dei problemi quando un cliente si lamenta. Gli alert ribaltano la situazione: apprendi di una rottura pochi minuti dopo e la colleghi a cosa è cambiato.

Imposta regole di alert che corrispondono a failure reali

Inizia con pochi alert ad alto segnale che proteggono il flusso di adozione core:

- Calo improvviso nel first use (es. eventi “Feature X: first_use” per ora giù del 40% vs baseline). Spesso indica regressione UI, cambio permessi o bug di tracciamento.

- Picco di errori (errori client, API 4xx/5xx o eventi

feature_failed). Includi soglie assolute e basate su tasso (errori ogni 1.000 sessioni).

- Eventi mancanti dopo una release (conteggi eventi quasi a zero). Questo cattura rapidamente instrumentation rotta—soprattutto dopo refactor.

Mantieni le definizioni degli alert leggibili e versionate (anche un semplice YAML nel repo) così non diventano conoscenza tribale.

Rilevamento anomalie: comincia semplice

Un rilevatore di anomalie base può essere molto efficace senza ML avanzato:

- Confronta valori correnti con una media mobile (es. ultimi 7 giorni, stessa ora del giorno).

- Aggiungi consapevolezza stagionale dove conta (giorni feriali vs weekend, orario lavorativo vs notte).

- Usa una regola di volume minimo così metriche a basso traffico non spammino.

Marker di release: una timeline per “cosa è cambiato?”

Aggiungi una stream di marker di release direttamente nei grafici: deploy, rollout feature flag, cambi di pricing, tweak onboarding. Ogni marker dovrebbe includere timestamp, owner e una breve nota. Quando le metriche cambiano, vedrai subito le probabili cause.

Routing, quiet hours e ownership

Invia alert via email e canali tipo Slack, ma supporta quiet hours ed escalation (warn → page) per problemi gravi. Ogni alert necessita un owner e un link al runbook (anche breve) che spiega cosa controllare per primo.

Privacy, consenso e controllo accessi

Go from spec to deploy

Deploy and host your analytics web app quickly, then iterate as teams start using it.

I dati analytics diventano presto dati personali se non stai attento. Tratta la privacy come parte del design del tracciamento: riduce il rischio, costruisce fiducia e evita dolorose rifacimenti.

Consenso: raccogli solo ciò che gli utenti accettano

Rispetta i requisiti di consenso e consenti l’opt-out. Praticamente significa che il layer di tracking dovrebbe verificare un flag di consenso prima di inviare eventi e poter fermare il tracciamento a metà sessione se l’utente cambia idea.

Per regioni con regole più severe, considera funzionalità “consent-gated”:

- Carica le librerie analytics solo dopo il consenso (non solo “smetti di inviare”).

- Conserva la decisione di consenso con timestamp e versione per prova.

- Fornisci un’impostazione semplice nell’app per le preferenze.

Minimizza i dati sensibili (e tienili fuori dagli eventi)

Limita i dati sensibili: evita email raw negli eventi; usa ID hashed/opaque. I payload dovrebbero descrivere il comportamento (cosa è successo), non l’identità (chi è la persona). Se devi collegare eventi a un account, invia un user_id/account_id interno e conserva la mappa nel DB con controlli di sicurezza.

Evita anche di raccogliere:

- Campi testo libero (spesso contengono dati personali accidentali)

- URL completi che possono includere token o query param

- Qualsiasi cosa che non vorresti in uno screenshot

Sii trasparente: documentazione e pagina privacy chiara

Documenta cosa raccogli e perché; fornisci una pagina privacy leggibile. Crea un “dizionario di tracciamento” leggero che spiega ogni evento, scopo e periodo di retention. Nell’interfaccia prodotto, collega a /privacy e mantieni il linguaggio semplice: cosa tracci, cosa non tracci e come opt-out.

Controllo accessi: limita chi vede dati a livello utente

Implementa accessi basati sui ruoli così solo team autorizzati possono vedere dati a livello utente. La maggior parte delle persone ha bisogno solo di dashboard aggregati; riserva le viste raw per un gruppo ristretto (es. data/product ops). Aggiungi log di audit per export e lookups e imposta retention così i dati vecchi scadono automaticamente.

Fatto bene, il controllo privacy non rallenterà l’analisi—renderà il sistema più sicuro, chiaro e manutenibile.

Piano di rollout, QA e manutenzione a lungo termine

Rilasciare analytics è come rilasciare una funzionalità: inizia con un piccolo rilascio verificabile, poi iterazioni costanti. Tratta il lavoro di tracciamento come codice di produzione con owner, revisioni e test.

Inizia in piccolo con “golden events”

Comincia con un set ristretto di golden events per un’area funzionale (es.: Feature Viewed, Feature Started, Feature Completed, Feature Error). Questi devono rispondere direttamente alle domande che il team farà settimanalmente.

Mantieni lo scopo limitato apposta: meno eventi significa che puoi validare la qualità rapidamente e imparerai quali proprietà servono davvero (plan, ruolo, source, feature variant) prima di scalare.

Valida il tracciamento in staging e produzione

Usa una checklist prima di considerare il tracking “done”:

- L’evento si attiva una volta sola (niente doppio-tracking su refresh, retry o SPA route changes)

- Proprietà richieste presenti e tipate coerentemente

- PII esclusa o mascherata correttamente

- Eventi ricevuti entro la latenza attesa

- Identità collegate correttamente (anonymous → logged-in)

Aggiungi query di esempio da eseguire in staging e produzione. Esempi:

- “Count events by name in the last 30 minutes” (individua eventi mancanti/in più)

- “Top 20 property values for

feature_name” (cattura typo come Search vs search)

- “Completion rate = Completed / Started by app version” (scopri regressioni di release)

Workflow QA di instrumentazione per ogni rilascio

Rendi la instrumentazione parte del processo di rilascio:

- Cambio di tracking nello stesso PR della UI/API change

- Reviewer verifica nomi eventi/proprietà contro lo schema

- QA verifica eventi in staging con account di test noto

- Note di release includono cambi di tracking (nuovi eventi, proprietà rinominate)

Manutenzione a lungo termine (schema, backfill, docs)

Pianifica il cambiamento: depreca eventi invece di cancellarli, versiona le proprietà quando cambia il significato e programma audit periodici.

Quando aggiungi una proprietà obbligatoria o sistemi una bug, decidi se serve un backfill (e documenta la finestra temporale con dati parziali).

Infine, conserva una guida light-weight nello spazio documentazione e collegala da dashboard e PR template. Un buon punto di partenza è una breve checklist come /blog/event-tracking-checklist.