Parti dal problema: quale lavoro manuale vuoi tracciare?

Prima di abbozzare schermate o scegliere un database, chiarisci cosa vuoi misurare. L'obiettivo non è “tracciare tutto ciò che fanno i dipendenti”. È catturare il lavoro manuale in modo sufficientemente affidabile da decidere cosa automatizzare per primo—sulla base di evidenze, non opinioni.

Definisci il lavoro manuale in termini semplici

Annota le attività ricorrenti svolte a mano (copia/incolla tra sistemi, reinserimento dati, verifica documenti, inseguire approvazioni, riconciliazione di fogli di calcolo). Per ogni attività descrivi:

- Cosa la attiva (un nuovo ordine, una email, una scadenza settimanale)

- Cosa significa “fatto” (inviato, verificato, pagato, spedito)

- Dove avviene (quali strumenti, cartelle, caselle di posta)

Se non riesci a descriverla in due frasi, probabilmente stai mescolando più workflow.

Identifica gli utenti target (e i loro incentivi)

Un'app di tracciamento funziona quando serve tutti coloro che toccano il lavoro—non solo chi vuole il report.

- Operatori / personale operativo: hanno bisogno di registrare rapidamente con il minimo disturbo.

- Team lead: vogliono visibilità su colli di bottiglia ed eccezioni.

- Manager: cercano segnali per priorizzare automazione e organico.

- Finance: ha bisogno di numeri credibili per costo, ROI e budget.

- IT / team di automazione: necessita di input puliti per costruire automazioni in sicurezza.

Aspettati motivazioni diverse: gli operatori vogliono meno burocrazia; i manager prevedibilità; l'IT requisiti stabili.

Decidi quali risultati misurerai

Tracciare serve solo se è collegato a risultati. Scegli un piccolo set che puoi calcolare in modo coerente:

- Tempo risparmiato: minuti manuali di base per attività, da confrontare dopo i cambiamenti.

- Errori ridotti: conteggi di rilavorazioni, correzioni, controlli falliti.

- Tempo di esecuzione: dal trigger al completamento, inclusi stati di attesa.

- Conformità / auditabilità: prova che i passaggi richiesti sono avvenuti (chi, cosa, quando).

Chiarisci cosa l'app non è

Definisci i confini presto per evitare di costruire un mostro per caso.

Questa app di solito non è:

- Un sostituto completo di un ERP

- Un sistema di ticketing esaustivo

- Uno strumento di monitoraggio del personale

Può completare questi sistemi—e talvolta sostituire una fetta ristretta—se è questa la tua intenzione esplicita. Se usi già ticket, il tuo tracker potrebbe semplicemente allegare dati strutturati di “sforzo manuale” agli elementi esistenti (vedi /blog/integrations).

Scegli i workflow e definisci uno scope chiaro

Un tracker ha successo o fallisce in base al focus. Se provi a catturare ogni “cosa impegnativa” che la gente fa, raccoglierai dati rumorosi, frustrerai gli utenti e non saprai comunque cosa automatizzare per primo. Parti con uno scope piccolo ed esplicito che si possa misurare in modo coerente.

Scegli i primi 3–5 workflow

Seleziona workflow comuni, ripetibili e già dolorosi. Un buon set iniziale copre diversi tipi di lavoro manuale, per esempio:

- Copia/incolla tra sistemi (es. CRM → foglio di calcolo → email)

- Inserimento dati e riformattazione (es. fatture, aggiornamenti cliente)

- Approvazioni (es. sconti, rimborsi, richieste di accesso)

- Riconciliazioni (es. confrontare pagamenti, verifiche inventario)

- Reporting (es. report settimanali assemblati manualmente)

Definisci cosa conta come “lavoro manuale”

Scrivi una definizione semplice che tutti possano applicare allo stesso modo. Per esempio: “Qualsiasi passaggio in cui una persona sposta, verifica o trasforma informazioni senza che un sistema lo faccia automaticamente.” Includi esempi e alcune esclusioni (es. chiamate con i clienti, scrittura creativa, gestione relazionale) così le persone non registrano tutto.

Metti confini per evitare lo scope creep

Sii esplicito su dove inizia e finisce il workflow:

- Dipartimenti/team inclusi (e esclusi)

- Regioni e canali (telefono, email, in presenza)

- Sistemi coinvolti (e qualsiasi sistema che non integrerai per ora)

Concorda una finestra di misurazione

Decidi come registrare il tempo: per task, per turno o per settimana. “Per task” dà il segnale migliore per l'automazione, ma “per turno/settimana” può essere un MVP pratico se i task sono troppo frammentati. La chiave è la coerenza, non la precisione.

Mappa il processo attuale prima di progettare qualsiasi cosa

Prima di scegliere campi, schermate o dashboard, ottieni un quadro chiaro di come il lavoro avviene oggi. Una mappa leggera ti svelerà cosa tracciare e cosa puoi ignorare.

Costruisci una mappa semplice del flusso

Inizia con un singolo workflow e scrivilo in linea retta:

Trigger → step → handoff → outcome

Sii concreto. “La richiesta arriva in una casella condivisa” è meglio di “avviene un intake”. Per ogni step annota chi lo fa, quale strumento usa e cosa significa “fatto”. Se ci sono passaggi tra team (Sales → Ops, Ops → Finance), segnalali esplicitamente—i passaggi sono dove il lavoro scompare.

Cattura dove avvengono ritardi e rilavorazioni

Il tuo tracker dovrebbe evidenziare l'attrito, non solo l'attività. Mentre mappi il flusso, marca:

- Attesa per informazioni mancanti (dati cliente, allegati, conferme)

- Approvazioni (chi approva, quanto tempo ci mette, cosa viene respinto)

- Vincoli di accesso ai sistemi (permessi, code, limiti di velocità)

- Cicli di rilavorazione (task che tornano a uno step precedente)

Questi punti di ritardo diventano in seguito campi ad alto valore (es. “motivo blocco”) e candidati prioritari per l'automazione.

Identifica le fonti di verità

Elenca i sistemi su cui le persone si basano per completare il lavoro: thread email, fogli di calcolo, strumenti di ticketing, drive condivisi, app legacy, chat. Quando più fonti divergono, annota quale è la fonte ufficiale. Questo è essenziale per le integrazioni future e per evitare inserimenti duplicati.

Documenta variabilità ed eccezioni

La maggior parte del lavoro manuale è disordinata. Nota i motivi comuni per cui i task deviano: condizioni speciali del cliente, documenti mancanti, regole regionali, approvazioni una tantum. Non stai cercando di modellare ogni caso limite—registra solo le categorie che spiegano perché un task ha impiegato più tempo o ha richiesto passaggi extra.

Progetta i dati da catturare (senza esagerare)

Un tracker del lavoro manuale vince o perde su una cosa: se le persone riescono a registrare il lavoro velocemente producendo al contempo dati utili. L'obiettivo non è “collezionare tutto”. È catturare la struttura minima per individuare pattern, quantificare impatto e trasformare il dolore ripetuto in candidati all'automazione.

Parti da un piccolo insieme di entità riutilizzabili

Mantieni il modello dati centrale semplice e coerente tra i team:

- Work Item: la cosa che viene processata (ordine, richiesta, ticket, reclamo). Includi un ID di riferimento esterno se esiste.

- Process e Step: dove si trova il lavoro (es. “Rimborsi” → “Verifica ricevuta”). Gli step ti aiutano a far emergere i colli di bottiglia senza analytics complessi.

- Task: una singola unità di sforzo manuale eseguita in un momento specifico (spesso collegata a Work Item + Step).

- Assignee: chi l'ha svolto (e opzionalmente team/ruolo).

- System: quali strumenti sono stati coinvolti (CRM, foglio di calcolo, email, portale).

- Evidence (opzionale): allegati o schermate quando servono per audit.

Questa struttura supporta sia la registrazione quotidiana sia l'analisi successiva senza costringere gli utenti a un questionario lungo.

Registra il tempo in modo amichevole e a bassa frizione

Il tempo è essenziale per prioritizzare l'automazione, ma deve essere semplice:

- Timer start/stop per chi lavora concentrato.

- Inserimento manuale quando i task sono in brevi scoppi di lavoro.

- Modifiche in batch per azioni ripetute (“L'ho fatto 12 volte oggi”).

Se il tempo sembra una forma di controllo, l'adozione cala. Posizionalo come modo per rimuovere lavoro noioso, non per monitorare le persone.

Cattura il “perché manuale” con categorie leggere

Aggiungi un campo obbligatorio che spieghi perché il lavoro non è stato automatizzato:

- Integrazione mancante

- Requisito normativo/compliance

- Regole poco chiare/casi limite

- Limitazioni dello strumento o UX scadente

Usa un dropdown breve più una nota opzionale. Il dropdown rende possibile il reporting; la nota fornisce contesto per le eccezioni.

Memorizza risultati strutturati (così i log diventano azionabili)

Ogni Task dovrebbe terminare con alcuni esiti coerenti:

- Status (completed, blocked, escalated)

- Error type (se rilevante)

- Rework count (0, 1, 2+)

- Completion notes (brevi, opzionali)

Con questi campi puoi quantificare gli sprechi (rilavorazione), identificare i guasti più comuni (tipi di errore) e costruire un backlog di automazione credibile basato sul lavoro reale—non sulle opinioni.

Se registrare un work item richiede più tempo che svolgere il lavoro, le persone salteranno la registrazione—o inseriranno dati vaghi inutili. L'obiettivo UX è semplice: catturare il minimo dettaglio utile con la minima frizione.

Schermate indispensabili (semplici)

Inizia con un piccolo set di schermate che coprono il ciclo completo:

- Task intake: modo rapido per aggiungere lavoro (inserimento manuale o “crea da template”).

- Work queue: lista prioritaria con filtri (new, in progress, blocked, done).

- Work item detail: contesto, stato, note e una chiara “next action”.

- Cattura tempo/evidenze: timer start/stop, inserimento rapido della durata, allega file o incolla link.

- Report: vista leggera di volume, tempo speso e motivi/esiti principali.

Rendilo veloce: meno click, più flusso

Progetta per la velocità più che per la completezza. Usa scorciatoie da tastiera per azioni comuni (crea item, cambia stato, salva). Fornisci template per lavoro ripetuto così gli utenti non riscrivono descrizioni e passaggi.

Dove possibile usa editing in place e default sensati (es. auto-assegna all'utente corrente, imposta “started at” quando aprono un item).

Campi guidati che standardizzano i dati

Il testo libero è utile, ma non si aggrega bene. Aggiungi campi guidati che rendano il reporting affidabile:

- Dropdown per reason, outcome, error type e channel (email/chat/phone).

- Campi obbligatori solo quando prevengono ambiguità—non “perché possiamo”.

Basi di accessibilità da non saltare

Rendi l'app leggibile e utilizzabile da tutti: contrasto elevato, etichette chiare (non solo placeholder), stati di focus visibili per la navigazione da tastiera e layout mobile-friendly per registrare rapidamente in movimento.

Permessi, approvazioni e auditabilità

From schema to screens

Passa dal modello dati a form, code e report con iterazioni guidate.

Se l'app serve a orientare decisioni di automazione, le persone devono fidarsi dei dati. La fiducia si rompe quando chiunque può modificare tutto, le approvazioni sono poco chiare o non esiste traccia delle modifiche. Un modello di permessi semplice più una traccia di audit leggera risolvono gran parte del problema.

Definisci ruoli chiari (e mantienili semplici)

Inizia con quattro ruoli che riflettono come il lavoro viene effettivamente registrato:

- Contributor: registra lavoro (tempo, step, evidenze) e modifica le proprie bozze.

- Reviewer/Approver: convalida le voci, richiede chiarimenti, approva o respinge.

- Manager: vede l'attività del team, risolve dispute, può sovrascrivere approvazioni quando necessario.

- Admin: configura workflow, permessi, retention e integrazioni.

Evita regole per utente all'inizio; l'accesso basato sui ruoli è più semplice da spiegare e mantenere.

Regole di modifica dopo la submission

Decidi quali campi sono “fatti” e quali sono “note”, e limita la modifica dei fatti dopo la revisione.

Un approccio pratico:

- I contributor possono modificare liberamente le bozze.

- Dopo l'invio, i contributor possono editare solo campi non critici (es. descrizione) fino a quando la revisione non inizia.

- Dopo l'approvazione, le modifiche a voci di tempo, stato del workflow, costo o evidenze allegate dovrebbero essere limitate a reviewer/manager e preferibilmente richiedere una motivazione.

Questo mantiene i report stabili pur consentendo correzioni legittime.

Traccia di audit che risponde a “chi ha cambiato cosa?”

Aggiungi un registro attività per eventi chiave: cambi di stato, aggiustamenti del tempo, approvazioni/rifiuti, evidenze aggiunte/rimosse e modifiche ai permessi. Memorizza almeno: attore, timestamp, valore vecchio, valore nuovo e (opzionalmente) un breve commento.

Rendilo visibile su ogni record (es. tab “Activity”) così le dispute non diventano ricerche su Slack.

Retention e gestione delle evidenze

Stabilisci regole di retention presto: quanto tempo conservare i log e le evidenze correlate (immagini, file, link). Molti team mantengono 12–24 mesi per i log e meno per gli allegati ingombranti.

Se permetti upload, trattali come parte della storia di audit: versiona i file, registra le cancellazioni e limita l'accesso per ruolo. Questo conta quando una voce diventa base per un progetto di automazione.

Architettura tecnica per un MVP pratico

Un MVP pratico deve essere facile da costruire, facile da cambiare e banale da gestire. L'obiettivo non è prevedere la tua futura piattaforma di automazione—ma catturare evidenze sul lavoro manuale con la minima frizione.

Una baseline semplice e scalabile

Inizia con una struttura lineare:

- Client web (UI nel browser)

- API (logica di business + validazione)

- Database (record strutturati)

- Storage file (screenshot, PDF, email esportate come file)

Questa separazione mantiene la UI veloce da iterare mentre l'API resta fonte di verità.

Scegli componenti affidabili

Preferisci uno stack che il tuo team può consegnare rapidamente e con comunità solide. Combinazioni comuni:

- Frontend: React o Vue

- Backend: Node (Express/Nest), Django o Rails

- Database: Postgres

- Storage file: storage compatibile S3 (o equivalente gestito)

Evita tecnologie esotiche all'inizio—il rischio più grande è l'incertezza del prodotto, non le prestazioni.

Se vuoi accelerare l'MVP senza bloccarti in uno strumento morto, una piattaforma come Koder.ai può aiutarti a passare da uno spec scritto a un'app React con API Go e PostgreSQL—via chat—mantenendo la possibilità di esportare il codice sorgente, distribuire/ospitare e tornare indietro in sicurezza usando snapshot. Questo è particolarmente utile per tool interni come i tracker del lavoro manuale, dove i requisiti cambiano velocemente dopo il primo pilota.

Definisci l'API attorno alle azioni utente

Progetta endpoint che rispecchino ciò che gli utenti fanno, non come sono organizzate le tabelle. Capacità tipiche “a verbo”:

- Creare un work item (task/case)

- Registrare tempo (start/stop o durata + note)

- Allegare evidenze (upload file + breve descrizione)

- Cambiare stato (es. New → In Progress → Done)

Questo rende più semplice supportare futuri client (mobile, integrazioni) senza riscrivere il core.

POST /work-items

POST /work-items/{id}/time-logs

POST /work-items/{id}/attachments

POST /work-items/{id}/status

GET /work-items?assignee=me\u0026status=in_progress

Pianifica import/export CSV fin dal giorno uno

Anche i primi utilizzatori chiederanno: “Posso caricare quello che ho già?” e “Posso estrarre i miei dati?” Aggiungi:

- Import CSV per migrazione iniziale o creazione bulk

- Export CSV per report, audit e fiducia

Riduce la re-immissione, velocizza l'onboarding e evita che l'MVP sembri una strada senza uscita.

Integrazioni che riducono lo sforzo di logging

Prototype the tracker fast

Crea rapidamente un'app React con API Go e PostgreSQL senza partire da zero.

Se l'app dipende dal ricordo delle persone, l'adozione scema. Un approccio pratico è partire con inserimento manuale (così il flusso è chiaro), poi aggiungere connettori solo dove rimuovono davvero lavoro—soprattutto per attività ad alto volume e ripetitive.

Dove le integrazioni aiutano di più

Cerca passaggi dove le persone già lasciano una traccia altrove. Integrazioni a basso attrito comuni:

- Ingestione email: inoltrare messaggi a un indirizzo speciale per creare/aggiornare un work item.

- Fogli di calcolo: importare righe (o sincronizzare) dal foglio che i team già mantengono.

- Notifiche Slack/Teams: prompt rapidi (“registra l'esito”) e aggiornamenti di stato quando un item è approvato o riassegnato.

- Webhooks: ricevere eventi da altri strumenti (submit moduli, aggiornamenti ticket, errori di pagamento) per creare bozza automaticamente.

Usa identificatori unici per collegare i sistemi

Le integrazioni diventano complicate se non puoi abbinare con affidabilità gli elementi tra sistemi. Crea un identificatore unico (es. MW-10482) e conserva gli ID esterni accanto a esso (ID messaggio email, chiave riga foglio, ID ticket). Mostra quell'identificatore nelle notifiche e negli export così le persone possono fare riferimento allo stesso item dovunque.

Progetta per l'automazione parziale (non tutto o niente)

L'obiettivo non è eliminare subito l'intervento umano—ma ridurre la digitazione e evitare rilavorazioni.

Precompila i campi dalle integrazioni (requester, subject, timestamp, allegati) ma mantieni l'override umano così il log riflette la realtà. Per esempio, una email può suggerire categoria e sforzo stimato, mentre la persona conferma il tempo effettivo e l'esito.

Una buona regola: le integrazioni dovrebbero creare bozze di default, e gli umani dovrebbero “confermare e inviare” finché non si fidano del mapping.

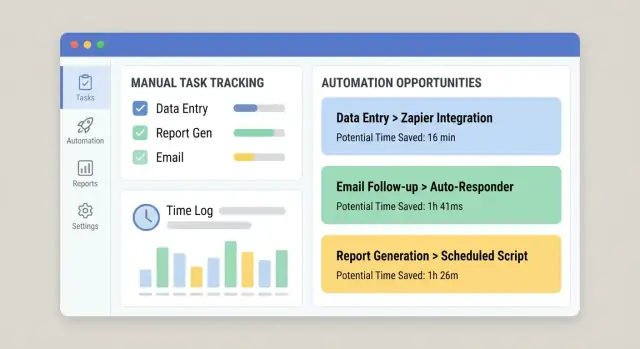

Tracciare il lavoro manuale vale solo se si traduce in decisioni. L'obiettivo dell'app dovrebbe essere convertire i log grezzi in una lista prioritaria di opportunità di automazione—il tuo “automation backlog”—facile da rivedere in una riunione settimanale ops o di miglioramento.

Crea criteri di scoring che la gente si sia fiducia

Inizia con un punteggio semplice e spiegabile così gli stakeholder vedono perché qualcosa arriva in cima. Criteri pratici:

- Volume: quanto spesso accade (al giorno/settimana/mese)

- Tempo per task: minuti mediani per completamento (non il massimo)

- Tasso di errore: quanto spesso succede rilavorazione o escalation

- Impatto di business: costo, impatto cliente, rischio di compliance, SLA violati

- Fattibilità: chiarezza delle regole, accesso ai sistemi, stabilità degli input, numero di eccezioni

Tieni il punteggio visibile vicino ai numeri sottostanti così non sembra una scatola nera.

Genera un “automation backlog” dalle attività reali

Aggiungi una vista dedicata che raggrupi i log in “work items” ripetibili (per esempio: “Aggiorna indirizzo cliente in Sistema A poi conferma in Sistema B”). Ordina automaticamente per punteggio e mostra:

- Tempo totale speso (ultimi 30/90 giorni)

- Trend di frequenza

- Team/ruoli principali coinvolti

- Punti di fallimento comuni (dove gli utenti segnano “bloccato” o rilavoro)

Tagga pattern ripetuti per trovare ciò che è automatizzabile

Rendi il tagging leggero: tag con un click come system, input type e exception type. Col tempo rivelano pattern stabili (buoni per automazione) vs casi limite disordinati (meglio formazione o miglioramenti di processo).

Aggiungi una stima ROI di base

Una stima semplice basta:

ROI (tempo) = (tempo risparmiato × frequenza) − ipotesi di manutenzione

Per la manutenzione usa una stima oraria fissa mensile (es. 2–6 h/mese) così i team confrontano opportunità in modo coerente. Questo mantiene il backlog focalizzato sull'impatto, non sulle opinioni.

Report e dashboard che la gente userà davvero

I dashboard sono utili solo se rispondono a domande reali: “Dove stiamo spendendo tempo?” “Cosa ci rallenta?” e “L'ultima modifica ha davvero aiutato?” Progetta il reporting attorno alle decisioni, non a grafici di vanità.

Parti da viste per i leader

La maggior parte dei leader non vuole ogni dettaglio—vogliono segnali chiari. Una baseline pratica include:

- Ore spese su lavoro manuale, suddivise per team, workflow e categoria

- Top processi manuali (ordinati per tempo totale, frequenza o entrambi)

- Cycle time (dal start al completamento) e dove il tempo è in attesa

- Rilavorazione (item riaperti, inviati indietro o modificati dopo l'invio)

Rendi ogni card cliccabile così un leader può passare dal numero headline al dettaglio che lo motiva.

Mostra trend e confronti prima/dopo

Una singola settimana può ingannare. Aggiungi linee di trend e filtri semplici per date (ultimi 7/30/90 giorni). Quando cambi un workflow—es. aggiungi un'integrazione o semplifichi un form—rendi facile confrontare prima vs dopo.

Un approccio leggero: memorizza un “change marker” (data e descrizione) e mostra una linea verticale sui grafici. Aiuta a collegare i miglioramenti a interventi reali invece di indovinare.

Evita metriche fuorvianti

Tracciare il lavoro manuale mescola spesso dati duri (timestamp, conteggi) e input più morbidi (tempo stimato). Etichetta chiaramente le metriche:

- Measured: catturate automaticamente (start/end time, numero di item)

- Reported: inserite dagli utenti (tempo speso, codici motivo)

- Derived: calcolate (cycle time, tasso di rilavoro)

Se il tempo è stimato, dillo nell'interfaccia. Meglio essere onesti che apparire precisi e sbagliati.

Permetti il drill-down fino ai work item

Ogni grafico dovrebbe permettere “mostrami i record”. Il drill-down costruisce fiducia e accelera l'azione: gli utenti filtrano per workflow, team e intervallo, poi aprono i work item sottostanti per vedere note, passaggi e blocchi comuni.

Collega i dashboard alla vista “automation backlog” così i maggiori sink di tempo possono diventare candidati a miglioramento mentre il contesto è ancora fresco.

Basi di sicurezza e affidabilità

Offset your build costs

Recupera crediti condividendo ciò che hai costruito o invitando colleghi a Koder.ai.

Se l'app cattura come si svolge il lavoro, raccoglierà presto dettagli sensibili: nomi clienti, note interne, allegati e “chi ha fatto cosa e quando”. Sicurezza e affidabilità non sono optional—perderai fiducia (e adozione) senza di esse.

Proteggi i dati con il principio del minimo privilegio

Inizia con accesso basato sui ruoli che rispecchi le responsabilità reali. La maggior parte degli utenti dovrebbe vedere solo i propri log o quelli del proprio team. Limita i poteri admin a un gruppo ristretto e separa “può modificare voci” da “può approvare/esportare dati”.

Per gli upload, considera ogni allegato non attendibile:

- Scansiona gli upload (o passa per un provider che lo fa).

- Conserva i file in object storage privato, non nel filesystem del web server.

- Usa URL firmati a breve termine per il download.

Difese di base per l'app

Non serve sicurezza enterprise per l'MVP, ma servono le basi:

- Autenticazione (SSO se possibile, altrimenti password robuste + MFA).

- Rate limiting su login e endpoint scrittura per ridurre abusi.

- Validazione input su ogni campo (server-side), specialmente testo libero e ID.

- Backup regolari con procedura di restore testata (un backup che non si può ripristinare non conta).

Logging utile (senza esporre segreti)

Cattura eventi di sistema per troubleshooting e audit: accessi, cambi permessi, approvazioni, job di import, integrazioni fallite. Mantieni i log strutturati e ricercabili, ma non salvare segreti—mai scrivere token API, password o contenuti completi di allegati nei log. Redigi campi sensibili per default.

Preparazione alla compliance (solo se applicabile)

Se tratti PII, decidi presto:

- Regole di retention (quanto mantenere log e file)

- Flussi di esportazione e cancellazione per richieste di accesso

- Dove i dati sono memorizzati e chi vi può accedere

Queste scelte influenzano schema, permessi e backup—meglio pianificarle ora che retrofit dopo.

Piano di rollout, adozione e miglioramento continuo

Un tracker vince o perde sull'adozione. Tratta il rollout come un lancio prodotto: parti piccoli, misura il comportamento e itera rapidamente.

Parti con un pilota focalizzato

Fai un pilota con un team—idealmente chi sente già il dolore del lavoro manuale e ha un workflow chiaro. Mantieni lo scope ristretto (uno o due tipi di lavoro) così puoi supportare gli utenti da vicino e aggiustare l'app senza disturbare tutta l'organizzazione.

Durante il pilota raccogli feedback al volo: un prompt “Qualcosa è stato difficile” con un click dopo la registrazione, più un check-in settimanale di 15 minuti. Quando l'adozione si stabilizza, espandi al team successivo con pattern di lavoro simili.

Definisci metriche di successo presto

Imposta target semplici e visibili così tutti sanno cosa significa “bene”:

- % di lavoro registrato (coverage)

- Qualità dei dati (es. campi richiesti compilati, meno voci “Altro”)

- Riduzione ore manuali (auto-riportato o inferito da meno task ripetuti)

Traccia queste metriche in una dashboard interna e rivedile con i team lead.

Rendi facile imparare facendo

Aggiungi guide in-app dove gli utenti esitano:

- Esempi sotto ogni campo (“Buona descrizione: ‘Riconcilia fattura #1842’”)

- Tooltip per categorie e tag

- Breve onboarding le prime volte che qualcuno registra (2–3 passaggi max)

Mantieni il miglioramento continuo (e visibile)

Imposta una cadenza di review (mensile funziona bene) per decidere cosa automatizzare dopo e perché. Usa i dati dei log per prioritizzare: prima attività ad alta frequenza + alto tempo, con chiari proprietari e impatto atteso.

Chiudi il cerchio mostrando i risultati: “Perché hai registrato X, abbiamo automatizzato Y.” È il modo più rapido per mantenere la registrazione.

Se stai iterando rapidamente tra team, considera strumenti che supportano cambi rapidi senza destabilizzare l'app. Per esempio, la planning mode di Koder.ai ti aiuta a definire scope e flussi prima di generare cambi, e gli snapshot/rollback rendono più sicuro modificare campi, permessi e workflow mentre impari dal pilota.