04 mag 2025·8 min

La teoria dei database di Jeffrey Ullman per query veloci e scalabili

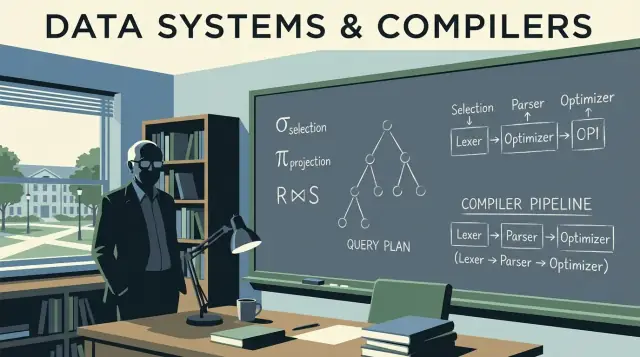

Come le idee fondamentali di Jeffrey Ullman alimentano i database moderni: algebra relazionale, regole di ottimizzazione, join e pianificazione in stile compilatore che aiutano i sistemi a scalare.

Perché Ullman è importante per i dati moderni

Molte persone che scrivono SQL, costruiscono dashboard o ottimizzano una query lenta hanno beneficiato del lavoro di Jeffrey Ullman, anche se non hanno mai sentito il suo nome. Ullman è un informatico e docente il cui lavoro di ricerca e i suoi libri di testo hanno aiutato a definire come i database descrivono i dati, ragionano sulle query e le eseguono in modo efficiente.

L'influenza silenziosa dietro gli strumenti quotidiani

Quando un motore di database trasforma il tuo SQL in qualcosa che può eseguire velocemente, si appoggia a idee che devono essere precise e adattabili. Ullman ha contribuito a formalizzare il significato delle query (così il sistema può riscriverle in sicurezza) e a collegare il pensiero sui database con quello sui compilatori (così una query può essere parsata, ottimizzata e tradotta in passi eseguibili).

Quell'influenza è silenziosa perché non appare come un pulsante nel tuo strumento BI o come una funzione visibile nella console cloud. Si vede invece in:

- Query che girano più veloci dopo che aggiungi un indice o riscrivi un

JOIN - Ottimizzatori che scelgono piani diversi mano a mano che i dati crescono

- Sistemi che possono scalare senza cambiare il risultato restituito dalla query

Cosa imparerai in questo articolo (senza overload di matematica)

Questo post usa le idee centrali di Ullman come guida agli internals dei database che contano nella pratica: come l'algebra relazionale sta sotto SQL, come le riscritture di query preservano il significato, perché gli ottimizzatori basati sui costi fanno le scelte che fanno e come gli algoritmi di join spesso decidono se un job finisce in secondi o in ore.

Inseriremo anche qualche concetto in stile compilatore — parsing, riscrittura e pianificazione — perché i motori di database si comportano più come compilatori sofisticati di quanto molti immaginino.

Una promessa rapida: terremo la discussione accurata ma eviteremo dimostrazioni pesanti di matematica. L'obiettivo è fornire modelli mentali che puoi applicare al lavoro la prossima volta che compaiono problemi di prestazioni, scalabilità o comportamenti di query confusi.

Fondamenti di database che Ullman ha contribuito a cementare

Se hai mai scritto una query SQL e ti sei aspettato che "significasse" una sola cosa, stai usando idee che Jeffrey Ullman ha aiutato a popolarizzare e formalizzare: un modello chiaro per i dati, più modi precisi per descrivere cosa chiede una query.

Il modello relazionale in termini semplici

Alla base, il modello relazionale tratta i dati come tabelle (relazioni). Ogni tabella ha righe (tuple) e colonne (attributi). Ora sembra ovvio, ma la parte importante è la disciplina che crea:

- Chiavi che identificano le righe. Una primary key è il "cartellino" per ogni record.

- Relazioni che collegano le tabelle tramite foreign key, così puoi tenere i fatti in un posto e riferirli altrove.

Questa cornice rende possibile ragionare su correttezza e prestazioni senza giri di parole. Quando sai cosa rappresenta una tabella e come le righe sono identificate, puoi prevedere cosa faranno i join, cosa significano i duplicati e perché certi filtri cambiano i risultati.

Algebra relazionale: una calcolatrice per le query

L'insegnamento di Ullman usa spesso l'algebra relazionale come una specie di calcolatrice per le query: un piccolo insieme di operazioni (select, project, join, union, difference) che puoi combinare per esprimere ciò che desideri.

Perché è utile lavorando con SQL: i database traducono SQL in una forma algebrica e poi la riscrivono in un'altra forma equivalente. Due query che sembrano diverse possono essere algebricamente uguali — ed è così che gli ottimizzatori possono riordinare i join, spostare filtri in basso o rimuovere lavoro ridondante mantenendo intatto il significato.

Algebra vs. calcolo (a grandi linee)

- Algebra relazionale è più il “come”: una sequenza di operazioni per calcolare il risultato.

- Calcolo relazionale è più il “cosa”: una descrizione del risultato che desideri.

SQL è in gran parte “cosa”, ma i motori spesso ottimizzano usando l'algebra come “come”.

Fondamenti battono memorizzare un dialetto

I dialetti SQL variano (Postgres vs. Snowflake vs. MySQL), ma i fondamentali no. Capire chiavi, relazioni e equivalenza algebrica ti aiuta a capire quando una query è logicamente errata, quando è solo lenta e quali cambiamenti preservano il significato attraverso piattaforme diverse.

Algebra relazionale: il linguaggio nascosto sotto SQL

L'algebra relazionale è la "matematica sotto" SQL: un piccolo set di operatori che descrivono il risultato che desideri. Il lavoro di Jeffrey Ullman ha reso questa visione operatoriale netta e insegnabile — ed è ancora il modello mentale che la maggior parte degli ottimizzatori usa.

Gli operatori di base (e cosa significano)

Una query di database può essere espressa come una pipeline di pochi mattoncini:

- Select (σ): filtra le righe (l'idea di

WHEREin SQL) - Project (π): conserva colonne specifiche (l'idea di

SELECT col1, col2) - Join (⋈): combina tabelle in base a una condizione (

JOIN ... ON ...) - Union (∪): sovrappone risultati con la stessa forma (

UNION) - Difference (−): righe in A ma non in B (come

EXCEPTin molti dialetti SQL)

Poiché l'insieme è piccolo, diventa più semplice ragionare sulla correttezza: se due espressioni algebriche sono equivalenti, restituiscono la stessa tabella per ogni stato valido del database.

Come SQL si mappa all'algebra (concettualmente)

Prendi una query familiare:

SELECT c.name

FROM customers c

JOIN orders o ON o.customer_id = c.id

WHERE o.total > 100;

Concettualmente, questo è:

-

iniziare con un join di customers e orders:

customers ⋈ orders -

select solo gli ordini superiori a 100:

σ(o.total > 100)(...) -

project la colonna che vuoi:

π(c.name)(...)

Non è la notazione interna esatta usata da ogni motore, ma è l'idea giusta: SQL diventa un albero di operatori.

Equivalenza: la porta per l'ottimizzazione

Molti alberi diversi possono significare lo stesso risultato. Per esempio, i filtri spesso possono essere spostati prima (applicare σ prima di un grande join), e le proiezioni possono eliminare colonne inutilizzate prima (applicare π presto).

Quelle regole di equivalenza permettono al database di riscrivere la tua query in un piano più economico senza cambiare il significato. Una volta che vedi le query come algebra, l’“ottimizzazione” smette di essere magia e diventa una rimodellazione sicura guidata da regole.

Da SQL a piani di query: riscritture che preservano il significato

Quando scrivi SQL, il database non lo esegue "così com'è". Traduce la tua istruzione in un piano di query: una rappresentazione strutturata del lavoro da fare.

Un buon modello mentale è un albero di operatori. Le foglie leggono tabelle o indici; i nodi interni trasformano e combinano righe. Gli operatori comuni includono scan, filter (selezione), project (scegli colonne), join, group/aggregate e sort.

Piano logico vs piano fisico (cosa vs come)

I database tipicamente separano la pianificazione in due livelli:

- Piano logico: cosa calcolare, espresso con operatori astratti (filter, join, aggregate) e le relazioni tra loro.

- Piano fisico: come eseguirlo su storage reale e hardware (index scan vs full scan, hash join vs nested-loop join, parallelismo vs single-thread).

L'influenza di Ullman emerge nell'enfasi sulle trasformazioni che preservano il significato: riorganizza il piano logico in molti modi senza cambiare la risposta, poi scegli una strategia fisica efficiente.

Riscritture basate su regole che riducono il lavoro

Prima di scegliere l'approccio finale di esecuzione, gli ottimizzatori applicano regole algebriche di "pulizia". Queste riscritture non cambiano i risultati; riducono il lavoro inutile.

Esempi comuni:

- Selection pushdown: applicare i filtri il prima possibile così meno righe passano ai passaggi successivi.

- Projection pruning: conservare solo le colonne necessarie, riducendo I/O e memoria.

- Join reordering: unire prima risultati più piccoli/intermedi quando è sicuro, invece di seguire l'ordine superficiale del SQL.

Un esempio semplice di riscrittura

Supponiamo che tu voglia gli ordini di utenti in un paese:

SELECT o.order_id, o.total

FROM users u

JOIN orders o ON o.user_id = u.id

WHERE u.country = 'CA';

Un'interpretazione ingenua potrebbe unire tutti gli users con tutti gli orders e poi filtrare il Canada. Una riscrittura che preserva il significato spinge il filtro più in basso così il join tocca meno righe:

- Filtrare users con

country = 'CA' - Poi unire quegli users con orders

- Poi proiettare solo

order_idetotal

In termini di piano, l'ottimizzatore prova a trasformare:

Join(Users, Orders) → Filter(country='CA') → Project(order_id,total)

in qualcosa più simile a:

Filter(country='CA') on Users → Join(with Orders) → Project(order_id,total)

Stesso risultato. Meno lavoro.

Queste riscritture sono facili da non notare perché non le scrivi mai esplicitamente — eppure sono una delle ragioni principali per cui lo stesso SQL può essere veloce su un database e lento su un altro.

Ottimizzazione basata sui costi senza il gergo

Quando esegui una query SQL, il database considera più modi validi per ottenere la stessa risposta, poi sceglie quello che si aspetta sia il meno costoso. Quel processo decisionale si chiama ottimizzazione basata sui costi — ed è uno dei punti più pratici in cui la teoria in stile Ullman si manifesta nelle prestazioni di tutti i giorni.

Cos'è davvero un “modello di costi”

Un modello di costi è un sistema di punteggio che l'ottimizzatore usa per confrontare piani alternativi. La maggior parte dei motori stima il costo usando poche risorse chiave:

- Righe processate (il lavoro tende a scalare con la quantità di dati che fluiscono in ogni passaggio)

- I/O (lettura di pagine da disco o SSD, più effetti di cache)

- CPU (filtraggio, hashing, ordinamento, aggregazione)

- Memoria (se un'operazione entra in RAM o deve spillare su disco)

Il modello non deve essere perfetto; deve essere direzionalmente corretto abbastanza spesso da scegliere piani buoni.

Stima della cardinalità, in termini semplici

Prima di poter valutare i piani, l'ottimizzatore si pone una domanda a ogni passo: quante righe produrrà questo? Questa è la stima della cardinalità.

Se filtri WHERE country = 'CA', il motore stima quale frazione della tabella corrisponde. Se unisci customers con orders, stima quante coppie corrisponderanno sulla chiave di join. Queste stime di conteggio delle righe determinano se preferisce un index scan a una scansione completa, un hash join a un nested loop, o se un ordinamento sarà piccolo o enorme.

Perché le statistiche contano (e cosa succede senza di esse)

Le ipotesi dell'ottimizzatore si basano su statistiche: conteggi, distribuzioni di valori, tassi di null e talvolta correlazioni fra colonne.

Quando le statistiche sono obsolete o mancanti, il motore può sbagliare le stime di ordini di grandezza. Un piano che sembra economico sulla carta può diventare costoso nella realtà — sintomi classici sono rallentamenti improvvisi dopo la crescita dei dati, cambi di piano “casuali” o join che improvvisamente spillano su disco.

Il compromesso inevitabile: accuratezza vs tempo di pianificazione

Stime migliori spesso richiedono più lavoro: statistiche più dettagliate, campionamento o esplorare più piani candidati. Ma anche la pianificazione ha un costo, specialmente per query complesse.

Quindi gli ottimizzatori bilanciano due obiettivi:

- Pianificare abbastanza in fretta per workload interattivi

- Pianificare abbastanza bene da evitare scelte catastrofiche

Capire quel compromesso ti aiuta a interpretare l'output di EXPLAIN: l'ottimizzatore non cerca di essere brillante — cerca di essere predicibilmente corretto con informazioni limitate.

Algoritmi di join e il cuore delle prestazioni di query

Invia un livello dati più veloce

Avvia un'API in Go con PostgreSQL e valida indici e filtri in anticipo.

Il lavoro di Ullman ha aiutato a diffondere un'idea semplice ma potente: SQL non viene tanto “eseguito” quanto tradotto in un piano di esecuzione. Dove ciò è più evidente è nei join. Due query che restituiscono le stesse righe possono avere tempi di esecuzione molto diversi a seconda dell'algoritmo di join scelto dal motore — e dell'ordine in cui unisce le tabelle.

Nested loop, hash join, merge join — quando conviene ciascuno

Nested loop join è concettualmente semplice: per ogni riga a sinistra, trova le righe corrispondenti a destra. Può essere veloce quando il lato sinistro è piccolo e il lato destro ha un indice utile.

Hash join costruisce una tabella hash da un input (di solito il più piccolo) e la usa per sondare l'altro. Brilla per input grandi e non ordinati con condizioni di uguaglianza (es. A.id = B.id), ma richiede memoria; lo spill su disco può annullare il vantaggio.

Merge join scorre due input in ordine ordinato. È ideale quando entrambi i lati sono già ordinati (o ordinabili a basso costo), come quando gli indici forniscono righe in ordine di chiave di join.

Perché l'ordine dei join può dominare le prestazioni

Con tre o più tabelle, il numero di possibili ordini di join esplode. Unire prima due tabelle grandi può creare un enorme risultato intermedio che rallenta tutto il resto. Un ordine migliore spesso inizia dal filtro più selettivo (poche righe) e si estende verso l'esterno, mantenendo piccoli gli intermedi.

Gli indici cambiano il menù di piani validi

Gli indici non solo velocizzano le ricerche: rendono certe strategie di join praticabili. Un indice sulla chiave di join può trasformare un nested loop costoso in una rapida "seek per riga". Viceversa, indici mancanti o inutilizzabili possono spingere il motore verso hash join o grandi ordinamenti per i merge join.

Checklist pratica: sintomi di un piano di join pessimo

- Il tempo di esecuzione cresce drasticamente con un piccolo aumento dei dati (probabilmente l'ordine dei join amplifica risultati intermedi).

- Il piano mostra grandi differenze tra “righe stimate” e “righe reali” (ipotesi di cardinalità errate che portano a scelte sbagliate).

- Vedi grandi ordinamenti o spill di hash su disco (pressione di memoria o indici mancanti).

- Una tabella filtrata e piccola viene unita tardi invece che presto (i filtri non vengono applicati abbastanza presto).

- Il predicato di join non è una chiara uguaglianza su tipi compatibili (impedisce comportamenti efficienti hash/merge).

Idee da compilatore dentro i motori di database

I database non si limitano a “eseguire SQL”. Lo compilano. L'influenza di Ullman copre sia la teoria dei database sia il pensiero sui compilatori, e quel collegamento spiega perché i motori di query si comportano come catene di strumenti di linguaggi: traducono, riscrivono e ottimizzano prima di fare qualsiasi lavoro.

Parsing e alberi sintattici: come viene letto SQL

Quando invii una query, il primo passo somiglia al front end di un compilatore. Il motore tokenizza parole chiave e identificatori, verifica la grammatica e costruisce un parse tree (spesso semplificato in un abstract syntax tree). Qui si catturano errori basilari: virgole mancanti, nomi di colonna ambigui, regole di grouping non valide.

Un modello mentale utile: SQL è un linguaggio di programmazione il cui “programma” descrive relazioni di dati invece di cicli.

Dal parse tree agli operatori logici

I compilatori convertono la sintassi in una rappresentazione intermedia (IR). I database fanno qualcosa di simile: traducono la sintassi SQL in operatori logici come:

- Selection (filtrare righe)

- Projection (scegliere colonne)

- Join (combinare tabelle)

- Aggregazione (

GROUP BY)

Quella forma logica è più vicina all'algebra relazionale del testo SQL, il che facilita il ragionamento su significato ed equivalenza.

Perché gli ottimizzatori somigliano alle ottimizzazioni dei compilatori

Le ottimizzazioni dei compilatori mantengono identici i risultati del programma riducendone il costo di esecuzione. Gli ottimizzatori dei database fanno lo stesso, usando sistemi di regole come:

- spostare i filtri prima possibile (ridurre il lavoro)

- riordinare i join (stesso risultato, costo diverso)

- rimuovere calcoli ridondanti

Questa è la versione database della “eliminazione del codice morto”: non le stesse tecniche, ma la stessa filosofia — preservare la semantica, ridurre il costo.

Debugging: leggere i piani come codice compilato

Se la tua query è lenta, non fissare solo l'SQL. Guarda il piano di query come faresti con l'output di un compilatore. Un piano ti dice cosa il motore ha effettivamente scelto: ordine dei join, uso degli indici e dove si spende il tempo.

Pratica utile: impara a leggere l'output di EXPLAIN come un "assembly" delle prestazioni. Trasforma il tuning da congettura a debugging basato su prove. Per approfondire l'abitudine pratica, vedi /blog/practical-query-optimization-habits.

Teoria del design dello schema che impatta le prestazioni reali

Vedi le prestazioni in produzione

Distribuisci la tua app e individua query lente sotto carico realistico prima possibile.

Una buona performance delle query spesso parte ancora prima che tu scriva SQL. La teoria del design dello schema di Ullman (in particolare la normalizzazione) riguarda strutturare i dati così il database può mantenerli corretti, prevedibili ed efficienti man mano che crescono.

Obiettivi della normalizzazione (perché esiste)

La normalizzazione mira a:

- Ridurre anomalie (es. aggiornare l'indirizzo di un cliente in cinque posti e dimenticarne uno)

- Migliorare la coerenza facendo vivere ogni fatto in una sola "casa"

- Rendere esprimibili i vincoli (chiavi, foreign key) così il motore può applicare regole invece di affidarsi al codice applicativo

Questi benefici di correttezza si traducono in vantaggi di prestazioni: meno campi duplicati, indici più piccoli e aggiornamenti meno costosi.

Forme normali in linguaggio semplice

Non serve memorizzare dimostrazioni per usare le idee:

- 1NF: conserva valori in colonne atomiche (niente liste separate da virgole). Questo rende filtraggio e indicizzazione più semplici.

- 2NF: in tabelle con chiave composta, ogni colonna non chiave dovrebbe dipendere dall'intera chiave (non solo da una parte). Evita la ripetizione di attributi su molte righe.

- 3NF: le colonne non chiave dovrebbero dipendere solo dalla chiave, non da altre colonne non chiave. Previene duplicazioni nascoste.

- BCNF: versione più rigorosa della 3NF dove ogni determinante è una candidate key — utile quando colonne "quasi uniche" creano duplicati sottili.

Quando la denormalizzazione è ragionevole

Denormalizzare può avere senso quando:

- stai costruendo tabelle per analytics (tabelle fatto ampie per reporting)

- i join diventano il collo di bottiglia e puoi accettare ridondanza controllata

- stai ottimizzando per la velocità di lettura con regole chiare di aggiornamento (es. ricostruzione notturna)

La chiave è denormalizzare deliberatamente, con un processo per mantenere sincroniche le duplicazioni.

Come le scelte di schema influenzano l'ottimizzatore e la scalabilità

Il design dello schema condiziona ciò che l'ottimizzatore può fare. Chiavi e foreign key chiare abilitano migliori strategie di join, riscritture più sicure e stime di cardinalità più accurate. Nel frattempo, duplicazioni eccessive possono gonfiare indici e rallentare le scritture, e colonne multivalore bloccano predicati efficienti. Con la crescita dei dati, queste decisioni di modellazione iniziali spesso contano più dell'ottimizzazione fine di una singola query.

Come la teoria si manifesta quando i sistemi scalano

Quando un sistema "scala", raramente è solo aggiungere macchine più grandi. Spesso la parte difficile è che lo stesso significato di query deve essere preservato mentre il motore sceglie una strategia fisica molto diversa per mantenere i tempi di esecuzione prevedibili. L'enfasi di Ullman sulle equivalenze formali è proprio ciò che permette quei cambi di strategia senza modificare i risultati.

La scala è spesso un layout fisico + scelta di piano

A taglie piccole, molti piani "funzionano". A scala, la differenza tra scansionare una tabella, usare un indice o usare un risultato precomputato può essere tra secondi e ore. La parte teorica conta perché l'ottimizzatore ha bisogno di un insieme sicuro di regole di riscrittura (es. spingere filtri, riordinare join) che non alterino la risposta — anche se cambiano radicalmente il lavoro svolto.

Il partizionamento cambia la query che viene eseguita, anche se l'SQL sembra lo stesso

Il partizionamento (per data, cliente, regione, ecc.) trasforma una tabella logica in molti pezzi fisici. Questo influenza la pianificazione:

- quali partizioni possono essere saltate (partition pruning)

- se i join avvengono entro partizioni o richiedono rimescolamento dei dati fra nodi

- se i raggruppamenti possono essere fatti localmente prima di combinare i risultati

Il testo SQL può restare identico, ma il miglior piano dipende da dove vivono le righe.

Materialized view: la precomputazione come scorciatoia algebrica

Le materialized view sono essenzialmente "sotto-espressioni salvate". Se il motore può provare che la tua query corrisponde (o può essere riscritta per corrispondere) a un risultato memorizzato, può sostituire lavoro costoso — come join e aggregazioni ripetute — con una semplice ricerca. Questo è pensiero di algebra relazionale in pratica: riconoscere l'equivalenza e riutilizzare.

Caching: utile, ma non risolve una forma di lavoro sbagliata

La cache può velocizzare letture ripetute, ma non salverà una query che deve scansionare troppi dati, rimescolare enormi intermedi o calcolare un join gigantesco. Quando emergono problemi di scala, la soluzione è spesso: ridurre la quantità di dati toccata (layout/partizionamento), ridurre il calcolo ripetuto (materialized views) o cambiare il piano — non solo "aggiungere cache".

Abitudini pratiche di ottimizzazione ispirate da Ullman

L'influenza di Ullman si vede in una mentalità semplice: tratta una query lenta come una dichiarazione di intento che il database è libero di riscrivere, poi verifica cosa ha effettivamente deciso di fare. Non serve essere un teorico per trarne vantaggio — serve solo una routine ripetibile.

1) Leggi un piano EXPLAIN: cosa guardare per primo

Inizia dalle parti che solitamente dominano i tempi di esecuzione:

- Metodo di accesso: il motore sta scansionando tutta la tabella quando ti aspettavi un lookup per indice?

- Stime righe vs reali (se il DB le mostra): grandi gap spesso spiegano rallentamenti "misteriosi".

- Ordine dei join: quale tabella guida il join e inizia con il filtro più selettivo?

- Operatori costosi: sort, build di hash, nested loop su grandi input — spesso rivelano dove si concentra il lavoro.

Se fai una sola cosa, individua il primo operatore dove il conteggio delle righe esplode. Quello è di solito la causa principale.

2) Anti-pattern comuni che fregano gli ottimizzatori

Sono facili da scrivere e sorprendentemente costosi:

- Funzioni su colonne indicizzate:

WHERE LOWER(email) = ...può impedire l'uso dell'indice (usa una colonna normalizzata o un indice funzionale se supportato). - Predicati mancanti: dimenticare un filtro per data o tenant trasforma una query mirata in una scansione ampia.

- Cross join accidentali: una condizione di join mancante può moltiplicare le righe e costringere a risultati intermedi enormi.

3) Forma un'ipotesi usando il pensiero algebrico

L'algebra relazionale incoraggia due mosse pratiche:

- Spostare i filtri prima: applicare condizioni

WHEREprima dei join quando possibile per ridurre gli input. - Ridurre le colonne presto: selezionare solo le colonne necessarie (soprattutto prima dei join) per ridurre memoria e I/O.

Una buona ipotesi suona così: “Questo join è costoso perché stiamo unendo troppe righe; se filtriamo orders agli ultimi 30 giorni prima, l'input del join diminuisce.”

4) Indice, riscrivi o cambia schema?

Usa una regola decisionale semplice:

- Aggiungi un indice quando la query è corretta, selettiva e ripetuta.

- Riscrivi la query quando

EXPLAINmostra lavoro evitabile (join inutili, filtri tardivi, predicati non sargable). - Cambia lo schema quando il pattern di carico è stabile e combatti ripetutamente lo stesso collo di bottiglia (es. aggregati precomputati, campi denormalizzati, partizionamento per tempo/tenant).

L'obiettivo non è "SQL furbo" ma risultati intermedi prevedibili e ridotti — proprio il tipo di miglioramento che le idee di Ullman rendono più facili da individuare.

Applicare queste idee quando costruisci prodotti reali

Trasforma la teoria in una demo

Crea una piccola app Postgres in chat e controlla le SQL che il tuo prodotto eseguirà.

Questi concetti non sono solo per i DBA. Se stai mettendo in produzione un'applicazione, stai prendendo decisioni di database e pianificazione delle query anche senza saperlo: forma dello schema, scelte di chiavi, pattern di query e layer di accesso ai dati influenzano ciò che l'ottimizzatore può fare.

Se usi un flusso di lavoro a sviluppo accelerato (per esempio, generare un'app React + Go + PostgreSQL da un'interfaccia chat in Koder.ai), i modelli mentali in stile Ullman sono una rete di sicurezza pratica: puoi rivedere lo schema generato per chiavi e relazioni pulite, ispezionare le query su cui l'app si basa e convalidare le prestazioni con EXPLAIN prima che i problemi raggiungano la produzione. Più velocemente iteri sul ciclo “intento della query → piano → correzione”, più valore ottieni dallo sviluppo accelerato.

Dove imparare di più e come applicarlo al lavoro

Non serve "studiare la teoria" come hobby separato. Il modo più rapido per beneficiare dei fondamenti in stile Ullman è imparare quanto basta per leggere i piani di query con sicurezza — e poi esercitarsi sul proprio database.

Risorse accessibili per iniziare

Cerca questi libri e argomenti di lezione (nessuna affiliazione — solo punti di partenza ampiamente citati):

- “A First Course in Database Systems” (Ullman & Widom) — fondamenta dei database accessibili con inquadramento pratico.

- “Principles of Database and Knowledge-Base Systems” (Ullman) — teoria più profonda se vuoi maggiore rigore.

- “Compilers: Principles, Techniques, and Tools” (Aho, Lam, Sethi, Ullman) — per la connessione “perché gli ottimizzatori assomigliano ai compilatori?”.

- Argomenti/lezioni da cercare: algebra relazionale, riscrittura delle query, ordinamento dei join, ottimizzazione basata sui costi, indici e selettività, parsing e linguaggi di query.

Un percorso leggero di apprendimento

Inizia in piccolo e mantieni ogni passo legato a qualcosa che puoi osservare:

- Algebra relazionale: impara selection, projection, join e regole di equivalenza.

- Piani: impara a leggere i nodi del piano (tipi di scan, filtri, join, sort, aggregati).

- Join: capisci nested loop vs hash join vs merge join e quando ciascuno tende a vincere.

- Modelli di costo: impara pochi input che guidano le decisioni (conteggi righe, selettività, I/O vs CPU).

Piccoli esercizi che ripagano rapidamente

Scegli 2–3 query reali e iterale:

- Riscrivi: cambia

INinEXISTS, spingi i predicati prima, rimuovi colonne non necessarie e confronta i risultati. - Confronta piani: cattura i piani “prima/dopo” e annota cosa è cambiato (ordine dei join, tipo di join, tipo di scan).

- Varia indici: prova ad aggiungere/togliere un indice alla volta e osserva le stime vs i conteggi reali.

Comunicare i risultati ai colleghi

Usa un linguaggio chiaro e basato sui piani:

- “Il piano è passato da una scansione sequenziale a una index scan perché il filtro è diventato selettivo.”

- “Le stime delle righe erano sbagliate di 100×, quindi l'ottimizzatore ha scelto l'ordine di join sbagliato.”

- “Questa riscrittura è equivalente (stesso risultato), ma abilita il predicate pushdown e meno righe nel join.”

Questo è il vantaggio pratico delle fondamenta di Ullman: ottieni un vocabolario condiviso per spiegare le prestazioni — senza indovinare.

Domande frequenti

Chi è Jeffrey Ullman e perché il suo lavoro conta se io scrivo solo SQL?

Jeffrey Ullman ha contribuito a formalizzare come i database rappresentano il significato delle query e come possono trasformarle in equivalenti più veloci in modo sicuro. Queste basi si vedono ogni volta che un motore riscrive una query, riorganizza i join o sceglie un piano d'esecuzione diverso garantendo lo stesso insieme di risultati.

Che cos'è l'algebra relazionale e come si collega a SQL?

L'algebra relazionale è un piccolo insieme di operatori (select, project, join, union, difference) che descrivono con precisione il risultato di una query. I motori traducono spesso SQL in una struttura simile a un albero di operatori in modo da poter applicare regole di equivalenza (come spostare i filtri più in basso) prima di scegliere una strategia di esecuzione.

Perché le riscritture di query "che preservano il significato" sono importanti nella pratica?

Perché l'ottimizzazione si basa sulla prova che una query riscritta restituisce gli stessi risultati. Le regole di equivalenza permettono all'ottimizzatore di fare cose come:

- spostare i filtri

WHEREprima di un join - eliminare colonne inutilizzate precocemente

- riordinare i join quando è logicamente sicuro farlo

Queste modifiche possono ridurre drasticamente il lavoro senza cambiare il significato.

Qual è la differenza tra piano logico e piano fisico di una query?

Un piano logico descrive cosa va calcolato (filtri, join, aggregazioni) indipendentemente dai dettagli di storage. Un piano fisico decide come eseguirlo (index scan vs full scan, hash join vs nested loop, parallelismo, strategie di ordinamento). La maggior parte delle differenze di prestazioni deriva dalle scelte fisiche, rese possibili dalle riscritture logiche.

Cos'è l'ottimizzazione basata sui costi in parole semplici?

L'ottimizzazione basata sui costi valuta più piani validi e sceglie quello con il costo stimato più basso. I costi sono tipicamente guidati da fattori pratici come righe processate, I/O, CPU e memoria (incluso il rischio che hash o sort debbano essere spillati su disco).

Cos'è la stima della cardinalità e perché provoca prestazioni imprevedibili?

La cardinalità stimata è la stima del numero di righe che produrrà un dato step. Queste stime guidano l'ordine dei join, il tipo di join e la scelta fra index scan e full scan. Quando le stime sbagliano (spesso per statistiche vecchie o mancanti), possono verificarsi rallentamenti improvvisi, grandi spill su disco o cambi di piano inattesi.

Quando è più veloce nested loop, hash join o merge join?

- Nested loop join: ottimo quando il lato sinistro è piccolo e il lato destro può essere cercato efficacemente (spesso tramite indice).

- Hash join: ideale per grandi join di uguaglianza su dati non ordinati, ma richiede memoria adeguata per evitare spill su disco.

- Merge join: vantaggioso quando entrambi gli input sono già ordinati (o possono esserlo a basso costo), spesso aiutato da indici che forniscono l'ordine sulle chiavi di join.

Come leggo un piano EXPLAIN senza perdermi?

Concentrati su alcuni segnali ad alto valore:

- dove esplodono i conteggi di righe (il primo grande aumento spesso è la causa principale)

- differenze tra “stimato” e “reale” (statistiche errate o ipotesi sbagliate)

- operatori costosi (ordini grandi, build di hash, nested loop su input vasti)

- scelta di scansione (full scan quando ti aspettavi un index)

Tratta il piano come un output compilato: mostra cosa il motore ha effettivamente deciso di fare.

Come influisce la normalizzazione sulle prestazioni e quando è accettabile denormalizzare?

La normalizzazione riduce fatti duplicati e anomalie di aggiornamento, il che spesso si traduce in tabelle e indici più piccoli e join più affidabili. La denormalizzazione può essere appropriata per analytics o pattern di lettura intensiva, ma deve essere deliberata (regole chiare di refresh e ridondanza nota) per non compromettere la correttezza nel tempo.

Quali tecniche aiutano a mantenere le query veloci man mano che i dati crescono senza cambiare i risultati?

La scala spesso richiede di cambiare la strategia fisica mantenendo identico il significato della query. Strumenti comuni:

- partizionamento per pruning e località

- materialized view per riutilizzare sotto-risultati equivalenti

- aggiornamento delle statistiche per guidare scelte di piano diverse man mano che i dati crescono

La cache aiuta letture ripetute, ma non risolve una query che deve toccare troppi dati o produrre intermedi giganteschi.