02 dic 2025·8 min

La visione originale dell'IA di Larry Page dietro il piano a lungo termine di Google

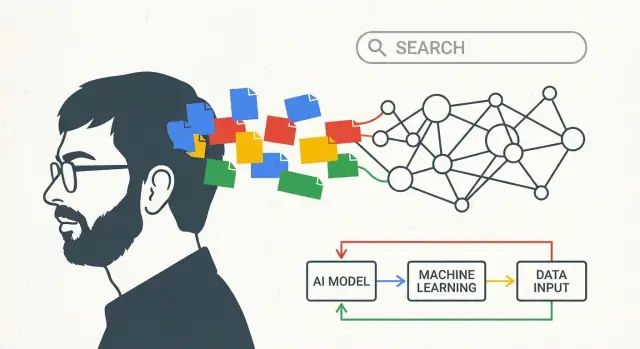

Scopri come le idee iniziali di Larry Page sull'IA e sulla conoscenza hanno plasmato la strategia a lungo termine di Google — dalla qualità della ricerca ai moonshot e alle scommesse AI-first.

Cosa intende questo post per “la visione IA di Larry Page”

Non è un pezzo sensazionalistico su un singolo momento di svolta. Parla di pensiero a lungo termine: come un'azienda può scegliere una direzione presto, continuare a investire attraverso più cambiamenti tecnologici e trasformare lentamente una grande idea in prodotti quotidiani.

Quando qui si parla di “la visione IA di Larry Page”, non si intende “Google ha previsto gli attuali chatbot”. Significa qualcosa di più semplice — e più duraturo: costruire sistemi che imparano dall'esperienza.

Una definizione in termini semplici

In questo post, “visione IA” si riferisce a poche convinzioni connesse:

- I computer dovrebbero migliorare le loro prestazioni imparando dai dati, non solo seguendo regole scritte a mano.

- I migliori sistemi migliorano nel tempo perché l'uso reale genera feedback (quello su cui le persone cliccano, ciò che ignorano, come riformulano le richieste).

- Per rendere l'apprendimento praticabile, serve infrastruttura: calcolo veloce, storage affidabile e un modo per eseguire esperimenti in sicurezza su scala enorme.

In altre parole, la “visione” riguarda meno un singolo modello e più un motore: raccogli segnali, impara pattern, rilascia miglioramenti, ripeti.

L'arco che seguiremo

Per rendere concreta quell'idea, il resto del post traccia una progressione semplice:

- Ricerca: parti da un problema chiaro — aiutare le persone a trovare buone risposte.

- Dati + infrastruttura: usa l'uso reale per imparare cosa sia “buono” e costruisci la macchina per processarlo.

- Prodotti AI-first: tratta i sistemi che apprendono come approccio predefinito, così voce, immagini e nuove interfacce possono funzionare bene senza riscrivere tutto da zero.

Alla fine, “la visione IA di Larry Page” dovrebbe sembrare meno uno slogan e più una strategia: investi presto nei sistemi di apprendimento, costruisci le tubature che li alimentano e sii paziente mentre i progressi si compongono nel corso degli anni.

Il problema iniziale che Google cercò di risolvere: trovare buone risposte

Il web iniziale aveva un problema semplice con conseguenze disordinate: c'era improvvisamente molta più informazione di quanto una persona potesse setacciare, e la maggior parte degli strumenti di ricerca indovinava cosa fosse rilevante.

Se scrivevi una query, molti motori si affidavano a segnali ovvi — quanto spesso una parola appariva in una pagina, se era nel titolo o quante volte il proprietario del sito poteva “riempirla” in testo invisibile. Questo rendeva i risultati facili da manipolare e difficili da fidarsi. Il web cresceva più in fretta degli strumenti pensati per organizzarne i contenuti.

PageRank, spiegato come spiegheresti una raccomandazione

L'intuizione chiave di Larry Page e Sergey Brin era che il web conteneva già un sistema di voto incorporato: i link.

Un link da una pagina a un'altra è un po' come una citazione in un articolo o una raccomandazione di un amico. Non tutte le raccomandazioni valgono uguale: un link da una pagina che molte altre considerano preziosa dovrebbe contare più di un link da una pagina sconosciuta. PageRank trasformò quell'idea in matematica: invece di classificare le pagine solo in base a quanto dicevano di sé, Google le classificava in base a ciò che il resto del web “diceva” di loro tramite i link.

Questo fece due cose importanti insieme:

- Aiutò a far emergere pagine autorevoli anche quando non ripetevano esattamente i termini della query.

- Respinse le manipolazioni, perché la credibilità doveva essere guadagnata nella rete di siti.

Perché misurazione e iterazione contavano fin dal primo giorno

Avere un'idea di ranking intelligente non bastava. La qualità della ricerca è un bersaglio mobile: appaiono nuove pagine, lo spam si adatta e ciò che le persone intendono con una query può cambiare.

Quindi il sistema doveva essere misurabile e aggiornabile. Google si appoggiò a test continui — provare cambiamenti, misurare se i risultati miglioravano e ripetere. Quella abitudine all'iterazione plasmò l'approccio a lungo termine dell'azienda ai sistemi che “imparano”: tratta la ricerca come qualcosa che puoi valutare continuamente, non come un progetto ingegneristico una tantum.

I dati come volano: imparare dall'uso reale

Una grande ricerca non riguarda solo algoritmi intelligenti: riguarda la qualità e la quantità di segnali da cui quegli algoritmi possono imparare.

Google iniziale aveva un vantaggio incorporato: il web è pieno di “voti” su cosa conta. I link tra le pagine (la base di PageRank) funzionano come citazioni, e l'anchor text (“clicca qui” vs. “migliori scarpe da trekking”) aggiunge significato. Inoltre, i pattern linguistici tra le pagine aiutano un sistema a capire sinonimi, varianti di ortografia e i molti modi in cui le persone pongono la stessa domanda.

Il loop di feedback che si compone

Una volta che le persone cominciano a usare un motore di ricerca su vasta scala, l'uso genera segnali aggiuntivi:

- I clic mostrano quali risultati sembrano rilevanti agli utenti per una data query.

- I “clic lunghi” rispetto ai ritorni rapidi possono suggerire soddisfazione.

- Le riformulazioni di query (ricercare di nuovo con parole diverse) possono rivelare disallineamenti tra intento e risultati.

Questo è il volano: risultati migliori attraggono più utilizzo; più utilizzo crea segnali più ricchi; segnali più ricchi migliorano il ranking e la comprensione; e quel miglioramento attira ancora più utenti. Col tempo, la ricerca somiglia sempre meno a un insieme fisso di regole e sempre più a un sistema che impara cosa le persone trovano utile.

Perché la varietà dei dati conta

Tipi diversi di dati si rinforzano a vicenda. La struttura dei link può far emergere l'autorità, mentre il comportamento di clic riflette preferenze correnti, e i dati linguistici aiutano a interpretare query ambigue (“jaguar” l'animale vs. l'auto). Insieme, permettono di rispondere non solo a “quali pagine contengono queste parole”, ma “qual è la miglior risposta per questo intento”.

Una nota sulla privacy

Questo volano solleva ovvie questioni di privacy. Report pubblici hanno da tempo notato che i grandi prodotti consumer generano enormi quantità di dati di interazione e che le aziende usano segnali aggregati per migliorare la qualità. È anche ampiamente documentato che Google ha investito nel tempo in controlli di privacy e sicurezza, anche se i dettagli e l'efficacia sono oggetto di dibattito.

La conclusione è semplice: imparare dall'uso reale è potente — e la fiducia dipende da quanto responsabilmente avviene quell'apprendimento.

Costruire la “macchina”: infrastruttura che rese l'IA pratica

Google non investì presto nel computing distribuito perché fosse di moda — era l'unico modo per stare al passo con la scala disordinata del web. Se vuoi scansionare miliardi di pagine, aggiornare i ranking frequentemente e rispondere alle query in frazioni di secondo, non puoi affidarti a un unico grande computer. Ti servono migliaia di macchine più economiche che lavorano insieme, con software che tratta i guasti come normali.

Perché il computing distribuito contava così presto

La ricerca costrinse Google a costruire sistemi in grado di memorizzare e processare grandi quantità di dati in modo affidabile. Quello stesso approccio “molte macchine, un sistema” divenne la base per tutto ciò che seguì: indicizzazione, analytics, sperimentazione e, infine, machine learning.

L'intuizione chiave è che l'infrastruttura non è separata dall'IA — determina che tipi di modelli sono possibili.

Come l'infrastruttura trasforma l'IA da demo a prodotto

Addestrare un modello utile significa mostrargli molti esempi reali. E servirlo significa eseguirlo per milioni di persone, istantaneamente, senza interruzioni. Entrambi sono “problemi di scala”:

- Addestramento richiede compute massiccio per elaborare i dati ripetutamente.

- Serving richiede sistemi a bassa latenza per fare predizioni velocemente (spesso in millisecondi), anche durante picchi di traffico.

Una volta costruite pipeline per immagazzinare dati, distribuire calcolo, monitorare le prestazioni e distribuire aggiornamenti in sicurezza, i sistemi basati sull'apprendimento possono migliorare continuamente invece di arrivare come riscritture rare e rischiose.

Esempi quotidiani semplici di “IA alimentata dalle tubature”

Alcune funzionalità familiari mostrano perché la macchina era importante:

- Correzione ortografica: notare pattern come “restarant” → “restaurant” richiede l'apprendimento da molte ricerche e clic, quindi applicare correzioni istantaneamente al momento della query.

- Autocomplete: prevedere cosa stai per digitare dipende dal comportamento aggregato e da inferenze veloci — altrimenti i suggerimenti laggano e sembrano sbagliati.

- Traduzione: una traduzione migliore deriva dall'addestramento su grandi dataset e dall'abilitare modelli che possano girare rapidamente per utenti in tutto il mondo.

Il vantaggio a lungo termine di Google non era avere solo algoritmi brillanti — era costruire il motore operativo che permetteva agli algoritmi di imparare, essere distribuiti e migliorare su scala internet.

Da regole ad apprendimento: come la ricerca è diventata più “IA” senza clamore

Make infrastructure practical

Avvia un'app React, Go e PostgreSQL che può supportare metriche reali e iterazioni.

Google iniziale sembrava già “intelligente”, ma gran parte di quella intelligenza era ingegnerizzata: analisi dei link (PageRank), segnali di ranking calibrati a mano e molte euristiche per lo spam. Col tempo, il baricentro si spostò dalle regole scritte esplicitamente a sistemi che apprendono pattern dai dati — specialmente su cosa le persone intendono, non solo su cosa digitano.

Come l'ML cambiò la percezione della ricerca

Il machine learning migliorò gradualmente tre aspetti che gli utenti notano ogni giorno:

- Qualità del ranking: invece di pesare i segnali con formule fisse, i modelli imparavano quali combinazioni di segnali tendevano a soddisfare gli utenti (misurato tramite comportamento aggregato anonimizzato e feedback di valutatori umani).

- Comprensione dell'intento: query come “jaguar speed” o “apple support” costringevano i modelli a inferire significato, contesto e ambiguità. I sistemi basati sull'apprendimento diventarono migliori nel mappare le parole a concetti e obiettivi probabili.

- Spam e fiducia: con la crescita di content farm e SEO manipolativo, l'ML aiutò a rilevare pattern di link artificiali, contenuti sottili e altre tattiche — supportando lo spostamento verso risultati di alta qualità.

Una timeline in chiave leggibile

- 1998: PageRank e il paper originale posano le basi della rilevanza tramite i link.

- Primi anni 2000: correzione ortografica statistica e suggerimenti di query migliorano il “did you mean” e le riformulazioni.

- 2011: Panda prende di mira i contenuti di bassa qualità; i segnali di qualità diventano più sistematici.

- 2012: Penguin penalizza la manipolazione dei link, spingendo l'anti-spam oltre le regole manuali.

- 2015: RankBrain (componente di ranking basato sull'apprendimento) aiuta con query poco familiari o ambigue.

- 2018–2019: neural matching e BERT introducono una comprensione linguistica più forte, specialmente per query più lunghe e per le preposizioni.

- 2021+: i modelli multi-task dell'era MUM e gli sforzi sul “contenuto utile” spingono verso segnali di intento e utilità più profondi.

Fonti da considerare

Per credibilità, cita un mix di ricerca primaria e spiegazioni pubbliche di prodotto:

- Paper di ricerca: Brin & Page (PageRank, 1998), BERT (Devlin et al., 2018).

- Annunci ufficiali di Search: post del blog di Google Search su RankBrain, BERT, MUM, aggiornamenti Panda/Penguin.

- Talk/interviste/eventi: interviste ad Amit Singhal sull'evoluzione del ranking; keynote di Sundar Pichai (Google I/O); eventi “Search On” per tappe moderne.

Cultura di ricerca: trasformare le scommesse lunghe in sistemi utili

Il gioco a lungo termine di Google non riguardava solo grandi idee — dipendeva da una cultura di ricerca in grado di trasformare paper accademici in cose che milioni di persone usavano davvero. Questo significava premiare la curiosità, ma anche costruire percorsi da un prototipo a un prodotto affidabile.

Dal “pubblica” al “rilascia”

Molte aziende trattano la ricerca come un'isola separata. Google promosse un anello più stretto: i ricercatori potevano esplorare direzioni ambiziose, pubblicare risultati e collaborare con i team di prodotto che si preoccupavano di latenza, affidabilità e fiducia degli utenti. Quando quel loop funziona, un paper non è il traguardo — è l'inizio di un sistema più veloce e migliore.

Una modalità pratica per vedere questo è come le idee di modello compaiono in funzioni “piccole”: correzione ortografica migliore, ranking più intelligente, raccomandazioni migliorate o traduzioni che suonano meno letterali. Ogni passo può sembrare incrementale, ma insieme cambiano l'esperienza della ricerca.

Sforzi simbolo che fecero da apripista

Diversi progetti divennero simboli di quella pipeline da paper a prodotto. Google Brain spinse il deep learning dentro l'azienda dimostrando che, con abbastanza dati e compute, poteva superare approcci più vecchi. Più tardi, TensorFlow rese più facile per i team addestrare e distribuire modelli in modo consistente — un ingrediente poco appariscente ma cruciale per scalare il machine learning su molti prodotti.

La ricerca su neural machine translation, riconoscimento vocale e visione passò similmente da risultati di laboratorio a esperienze quotidiane, spesso dopo molte iterazioni che migliorarono qualità e ridussero i costi.

Perché la pazienza conta

La curva di rendimento raramente è immediata. Le prime versioni possono essere costose, imprecise o difficili da integrare. Il vantaggio arriva dall'essere rimasti sull'idea abbastanza a lungo da costruire infrastruttura, raccogliere feedback e perfezionare il modello fino a renderlo affidabile.

Quella pazienza — finanziare “scommesse lunghe”, accettare deviazioni e iterare per anni — aiutò a convertire concetti ambiziosi di IA in sistemi utili e affidabili alla scala di Google.

Nuovi input: voce, immagini e video costrinsero modelli più intelligenti

La ricerca testuale premiava trucchi di ranking intelligenti. Ma nel momento in cui Google cominciò a gestire voce, foto e video, l'approccio vecchio andò in crisi. Questi input sono disordinati: accenti, rumore di fondo, immagini sfocate, riprese mosse, slang e contesto che non è scritto da nessuna parte. Per renderli utili, servivano sistemi in grado di imparare pattern dai dati invece di regole scritte a mano.

Voce: trasformare il suono in intento

Con la ricerca vocale e la dettatura su Android, l'obiettivo non era solo “trascrivere parole”. Era capire cosa una persona intende — rapidamente, sul dispositivo o con connessioni instabili.

Il riconoscimento vocale spinse Google verso il machine learning su larga scala perché le prestazioni miglioravano di più quando i modelli erano addestrati su dataset audio grandi e diversi. Quella pressione di prodotto giustificò investimenti seri in compute (per l'addestramento), tooling specializzato (pipeline di dati, set di valutazione, sistemi di deployment) e persone in grado di iterare su modelli come prodotti vivi, non demo di ricerca.

Foto: significato, non metadata

Le foto non arrivano con parole chiave. Gli utenti si aspettano che Google Photos trovi “cani”, “spiaggia” o “il mio viaggio a Parigi”, anche se non hanno mai taggato niente.

Questa aspettativa spinse verso una comprensione immagine più forte: rilevamento oggetti, raggruppamento dei volti e ricerca per similarità. Anche qui, le regole non potevano coprire la varietà della vita reale, quindi i sistemi di apprendimento erano la strada pratica. Migliorare l'accuratezza significava più dati etichettati, migliore infrastruttura di addestramento e cicli di sperimentazione più rapidi.

Video e raccomandazioni: la scala mette a nudo i limiti

Il video aggiunge una sfida doppia: sono immagini nel tempo più audio. Aiutare gli utenti a navigare YouTube — ricerca, sottotitoli, “Up next” e filtri di sicurezza — richiese modelli che potessero generalizzare attraverso argomenti e lingue.

Le raccomandazioni rese ancora più chiaro il bisogno di ML. Quando miliardi di utenti cliccano, guardano, saltano e ritornano, il sistema deve adattarsi continuamente. Quel tipo di loop di feedback premiò naturalmente gli investimenti in addestramento scalabile, metriche e talenti per mantenere i modelli in miglioramento senza rompere la fiducia.

Il pivot AI-first: rendere l'IA il predefinito, non una funzione

Plan like a long game

Usa la modalità di pianificazione per mappare obiettivi, segnali di dati ed esperimenti prima di generare codice.

“AI-first” è più facile da capire come decisione di prodotto: invece di aggiungere l'IA come strumento speciale a lato, la tratti come parte del motore dentro tutto ciò che le persone già usano.

Google descrisse questa direzione pubblicamente intorno al 2016–2017, definendola come uno spostamento da “mobile-first” a “AI-first”. L'idea non era che ogni feature diventasse improvvisamente “smart”, ma che il modo predefinito in cui i prodotti migliorano sarebbe sempre più attraverso sistemi di apprendimento — ranking, raccomandazioni, riconoscimento vocale, traduzione e rilevamento dello spam — piuttosto che regole tarate a mano.

IA dentro il loop centrale

In termini pratici, un approccio AI-first si vede quando il “loop centrale” di un prodotto cambia silenziosamente:

- I risultati di ricerca migliorano perché il sistema impara pattern in query e clic, non perché un team codifica migliaia di regole if-then.

- Le foto sono organizzate per ciò che contengono, non solo per nomi di file e cartelle.

- Gmail intercetta più messaggi indesiderati imparando comportamenti in evoluzione, non solo abbinando parole chiave note.

L'utente potrebbe non vedere mai un pulsante con scritto “IA”. Noterà semplicemente meno risultati sbagliati, meno attrito e risposte più rapide.

Gli assistenti alzarono l'asticella per il linguaggio naturale

Assistenti vocali e interfacce conversazionali rimodellarono le aspettative. Quando le persone possono dire “Ricordami di chiamare mamma quando arrivo a casa”, cominciano a pretendere che il software capisca intento, contesto e linguaggio quotidiano disordinato.

Questo spinse i prodotti a considerare la comprensione del linguaggio naturale come capacità di base — su voce, digitazione e persino input fotografico (punti il telefono su qualcosa e chiedi cosa sia). Il pivot, quindi, riguardava tanto l'aderire alle nuove abitudini degli utenti quanto le ambizioni di ricerca.

Importante: “AI-first” va letto meglio come una direzione — supportata da dichiarazioni pubbliche ripetute e mosse di prodotto — piuttosto che come l'affermazione che l'IA abbia sostituito ogni altro approccio dall'oggi al domani.

Alphabet e il gioco a lungo termine: spazio per scommesse oltre la ricerca

La creazione di Alphabet nel 2015 fu meno un rebrand e più una decisione operativa: separare il core maturo e generatore di ricavi (Google) dagli sforzi più rischiosi e a orizzonte lungo (spesso chiamati “Other Bets”). Quella struttura conta se pensi alla visione IA di Larry Page come a un progetto pluri-decenale anziché a un singolo ciclo di prodotto.

Perché separare il “core” dalle “scommesse”

Google Search, Ads, YouTube e Android avevano bisogno di esecuzione incessante: affidabilità, controllo dei costi e iterazione costante. I moonshot — auto a guida autonoma, scienze della vita, progetti di connettività — avevano bisogno di altro: tolleranza per l'incertezza, spazio per esperimenti costosi e il permesso di sbagliare.

Sotto Alphabet, il core poteva essere gestito con aspettative di performance chiare, mentre le scommesse potevano essere valutate su milestone di apprendimento: “Abbiamo provato un'ipotesi tecnica chiave?” “Il modello è migliorato abbastanza con i dati reali?” “Il problema è risolvibile a livelli di sicurezza accettabili?”

La logica del moonshot: sperimentazione come strategia

Questa mentalità da “gioco a lungo termine” non presume che ogni progetto avrà successo. Presume che la sperimentazione sostenuta sia il modo per scoprire cosa conterà in seguito.

Una sorta di fabbrica di moonshot come X è un buon esempio: i team provano ipotesi audaci, strumentano i risultati e ammazzano idee velocemente quando le prove sono deboli. Questa disciplina è particolarmente rilevante per l'IA, dove il progresso spesso dipende dall'iterazione — dati migliori, setup di training migliori, valutazione migliore — non solo da una singola svolta.

Cosa portarsi a casa (senza promesse)

Alphabet non era una garanzia di vittorie future. Era un modo per proteggere due ritmi di lavoro diversi:

- Tenere il core concentrato e responsabile.

- Creare una casa esplicita per ricerca ad alta varianza e scommesse di prodotto.

Per i team, la lezione è strutturale: se vuoi risultati IA a lungo termine, progetta per questo. Separa consegne a breve termine da lavoro esplorativo, finanzia esperimenti come veicoli di apprendimento e misura i progressi in insight validati — non solo in titoli.

Le parti difficili: qualità, sicurezza e fiducia su scala

Turn research into product

Imposta un flusso di lavoro condiviso che il tuo team può rivedere, misurare e perfezionare nel tempo.

Quando sistemi di IA servono miliardi di query, piccoli tassi di errore diventano titoli quotidiani. Un modello “per lo più corretto” può comunque fuorviare milioni — soprattutto su salute, finanza, elezioni o notizie in evoluzione. Alla scala di Google, la qualità non è un optional; è una responsabilità che si compone.

I compromessi fondamentali

Bias e rappresentazione. I modelli imparano pattern dai dati, inclusi bias sociali e storici. Un ranking “neutrale” può comunque amplificare punti di vista dominanti o non servire adeguatamente lingue e regioni di minoranza.

Errori e sovra-confidenza. L'IA spesso fallisce in modi che suonano convincenti. Gli errori più dannosi non sono bug evidenti; sono risposte plausibili che gli utenti si fidano.

Sicurezza vs utilità. Filtri forti riducono i danni ma possono bloccare query legittime. Filtri deboli migliorano la copertura ma aumentano il rischio di abilitare truffe, autolesionismo o disinformazione.

Responsabilità. Mano a mano che i sistemi si automatizzano, diventa più difficile rispondere a domande di base: chi ha approvato questo comportamento? Come è stato testato? Come possono gli utenti appellarsi o correggerlo?

Perché la scala aumenta il bisogno di salvaguardie

Scalare migliora le capacità, ma anche:

- Espande i casi limite (lingue, culture, contesti sensibili)

- Aumenta gli incentivi per l'abuso (spam, prompt injection, SEO avversario)

- Rende i fallimenti più difficili da ritirare una volta integrati nei prodotti

Per questo le salvaguardie devono scalare anch'esse: suite di valutazione, red-teaming, applicazione di policy, provenienza delle fonti e interfacce utente chiare che segnalino incertezza.

Una check-list pratica per valutare le affermazioni IA

Usala per giudicare qualsiasi funzionalità “potenziata dall'IA” — che venga da Google o da altri:

- Qual è la modalità di fallimento? Mostrano dove si rompe, non solo demo?

- Come viene misurata? Cerca metriche reali (accuratezza, tassi di tossicità, tassi di allucinazione), non vaghe “migliorie”.

- Su quali dati è addestrato? Al minimo: categorie ampie, recency e politiche di esclusione.

- Quali sono le salvaguardie? Regole di sicurezza, percorsi di revisione umana e monitoraggio degli abusi.

- Gli utenti possono verificare? Citazioni, riferimenti o spiegazioni che permettono di controllare le affermazioni.

- Come vengono gestite le correzioni? Segnalazione chiara, aggiornamenti rapidi e auditabilità.

La fiducia si guadagna tramite processi ripetibili — non tramite un singolo modello di svolta.

Lezioni per i team: come pensare all'IA sul lungo periodo

Il pattern più trasferibile dietro l'arco lungo di Google è semplice: obiettivo chiaro → dati → infrastruttura → iterazione. Non ti serve la scala di Google per usare il loop — ti serve disciplina su cosa stai ottimizzando e un modo per imparare dall'uso reale senza ingannare te stesso.

Il pattern base che puoi copiare

Inizia con una promessa utente misurabile (velocità, meno errori, migliori corrispondenze). Strumentala in modo da poter osservare i risultati. Costruisci la minima “macchina” che ti permette di raccogliere, etichettare e rilasciare miglioramenti in sicurezza. Poi iterare in passi piccoli e frequenti — tratta ogni versione come un'opportunità di apprendimento.

Se il tuo collo di bottiglia è semplicemente passare dall'“idea” al “prodotto strumentato” abbastanza in fretta, i flussi di lavoro moderni possono aiutare. Per esempio, Koder.ai è una piattaforma vibe-coding dove i team possono creare app web, backend o mobile da un'interfaccia chat — utile per lanciare un MVP che includa loop di feedback (pollice su/giù, segnala un problema, sondaggi rapidi) senza aspettare settimane per una pipeline personalizzata completa. Funzionalità come la modalità di pianificazione e snapshot/rollback si mappano bene al principio “sperimenta in sicurezza, misura, itera”.

6 takeaway per i leader applicabili (senza essere Google)

- Scegli una stella polare visibile all'utente. “Migliorare l'esperienza di ricerca” è più chiaro di “adottare l'IA”. Definisci il successo in termini che la gente percepisce.

- Progetta il prodotto per generare dati di apprendimento. Aggiungi loop di feedback (pollice su/giù, correzioni, “ti è stato utile?”) che catturino intento, non solo clic.

- Investi presto nelle tubature, non solo nei modelli. Controlli sulla qualità dei dati, dashboard di valutazione e workflow di deployment battono prototipi una tantum.

- Tratta la valutazione come una feature di prodotto. Crea una scheda di valutazione ripetibile (qualità, latenza, costo, sicurezza) così l'iterazione non diventa congettura.

- Rilascia a fette. Parti con casi d'uso stretti, lancia a un pubblico limitato, misura e poi espandi. Il momentum batte i grandi lanci.

- Rendi le scommesse lunghe sostenibili. Proteggi una piccola quota di capacità per esperimenti, ma richiedi milestone di apprendimento chiare per mantenerli onesti.

Letture correlate

- /blog/ai-strategy-basics

- /blog/data-flywheels-for-product-teams

- /blog/evaluating-ml-models-without-a-phd

- /blog/ai-governance-lightweight