Perché l'idea del programma memorizzato conta

Al centro del calcolo moderno c'è una domanda semplice: cosa ha reso possibile che una macchina svolgesse molti compiti diversi senza essere ricostruita ogni volta? I primi computer elettronici potevano calcolare velocemente, ma “cambiare il lavoro” spesso significava modificare fisicamente la configurazione della macchina. L'idea del programma memorizzato è il punto di svolta che ha reso i computer davvero programmabili.

Il programma memorizzato, in parole semplici

Un computer a programma memorizzato conserva le istruzioni per un compito (il programma) nello stesso tipo di memoria interna dei dati su cui il programma opera. Invece di ricollegare l'hardware o riconfigurare manualmente pannelli, puoi caricare un nuovo insieme di istruzioni in memoria ed eseguire un lavoro diverso.

Ora può sembrare ovvio, ma fu un cambiamento profondo:

- Il computer diventa uno strumento a uso generale, non una macchina a scopo singolo.

- I programmi diventano informazione—qualcosa che puoi modificare, salvare, copiare e condividere.

- Lo sviluppo del software diventa un'attività pratica: scrivere, testare e migliorare istruzioni senza ricostruire il computer.

Cosa tratteremo in questo articolo (e perché è ancora importante)

Non è solo una curiosità storica. Il concetto del programma memorizzato spiega perché il “software” esiste come cosa separata dall’“hardware” e perché aggiornare un dispositivo oggi può sbloccare nuove funzionalità senza cambiare i chip all'interno.

Nelle sezioni successive vedremo il problema che affrontavano i primi computer, cosa ha cambiato l'approccio del programma memorizzato, le persone e i documenti che hanno chiarito l'idea (incluso il famoso rapporto EDVAC) e come il termine “architettura von Neumann” è diventato un'etichetta per un modello ampiamente usato.

Una breve nota sul riconoscimento dei meriti

Anche se il nome di John von Neumann è fortemente associato al programma memorizzato, il merito è condiviso tra un team e un'epoca più ampia. Molti ricercatori stavano convergendo su idee simili mentre costruivano i primi computer elettronici pratici. Questo articolo mantiene quel contesto, perché capire lo sforzo collettivo aiuta a spiegare come l'idea si sia diffusa così rapidamente e sia diventata il modello predefinito per la maggior parte dei computer successivi.

Prima dei programmi memorizzati: quando cambiare compito significava ricollegare

Prima dell'idea del programma memorizzato, molti primi computer non “eseguivano software” nel senso in cui lo intendiamo oggi. Potevano calcolare a velocità impressionante, ma dire loro cosa fare spesso voleva dire modificare fisicamente la macchina.

La “programmazione hardware” in pratica

Un approccio comune era usare pannelli a prese, cavi di collegamento e pannelli di interruttori. Gli operatori collegavano fili tra prese, impostavano file di interruttori e talvolta regolavano unità di temporizzazione perché i segnali arrivassero nell'ordine corretto. Il “programma” non era un file da caricare: era uno schema di collegamento temporaneo.

Questa configurazione funzionava, ma aveva un costo nascosto: ogni nuovo compito era un mini progetto di ingegneria. Se volevi cambiare la sequenza delle operazioni (somma, moltiplicazione, confronto, ciclo), poteva essere necessario spostare dozzine o centinaia di collegamenti. Un singolo cavo inserito male poteva creare errori sottili difficili da diagnosticare, perché la logica era distribuita attraverso connessioni hardware anziché scritta come passi leggibili.

Perché cambiare compito era costoso

Riconfigurare poteva richiedere ore o giorni, soprattutto se la macchina doveva essere spenta con cura, ricollegata e testata. Questo significava flessibilità limitata: quelle macchine spesso venivano programmate per un solo tipo di calcolo per lunghi periodi perché cambiare lavoro era così disruptive.

Un esempio semplice

Immagina una macchina configurata per calcolare tabelle balistiche—calcoli lunghi e ripetitivi con una formula fissa. Se i ricercatori volevano poi usare la stessa macchina per risolvere un problema diverso, come tabulare risultati statistici per un censimento, non era un rapido “modifica il programma e riesegui”. L'ordine delle operazioni, i passaggi di memorizzazione intermedi e i controlli condizionali potevano differire, richiedendo una progettazione completa del pannello a prese e una nuova serie di verifiche.

Questo è il mondo che il computer a programma memorizzato è stato progettato per superare.

Il computer a programma memorizzato, spiegato semplicemente

Un computer a programma memorizzato è una macchina in cui le istruzioni (il programma) risiedono nella stessa memoria di lavoro dei dati che il programma usa. In altre parole, il computer non tratta “cosa fare” come qualcosa di separato da “su cosa lavorare”: entrambi sono memorizzati come pattern di bit nella memoria.

Cosa significa qui “memoria”?

Quando i pionieri del computer parlavano di memoria, intendevano l'archiviazione interna veloce e direttamente utilizzabile del computer—quello che oggi associamo più da vicino alla RAM. È il luogo da cui il processore può leggere e scrivere rapidamente mentre esegue.

Questo è diverso dall'archiviazione a lungo termine come un disco rigido o un SSD. Un disco è ottimo per conservare file a macchina spenta, ma non è il blocco note immediato che il processore usa costantemente per prelevare l'istruzione successiva e aggiornare i risultati intermedi.

La conseguenza chiave: cambiare il compito senza cambiare la macchina

Una volta che le istruzioni sono memorizzate in memoria, passare da un compito all'altro diventa molto più semplice: puoi caricare un nuovo programma in memoria ed eseguirlo, senza ricostruire, ricollegare o riconfigurare fisicamente l'hardware. La stessa macchina a uso generale può fare l'elaborazione paghe al mattino e i calcoli balistici al pomeriggio—perché il “come” del compito è solo un altro insieme di bit che puoi sostituire.

Un'analogia quotidiana

Immagina una cucina in cui la ricetta e gli ingredienti sono conservati insieme nella stessa dispensa. Il cuoco (il processore) va ripetutamente alla dispensa (memoria) per leggere il prossimo passo della ricetta (istruzione) e prendere o aggiornare gli ingredienti (dati).

Vuoi fare un piatto diverso? Non rimodelli la cucina. Cambi ricetta—usando gli stessi piani di lavoro, forno e utensili.

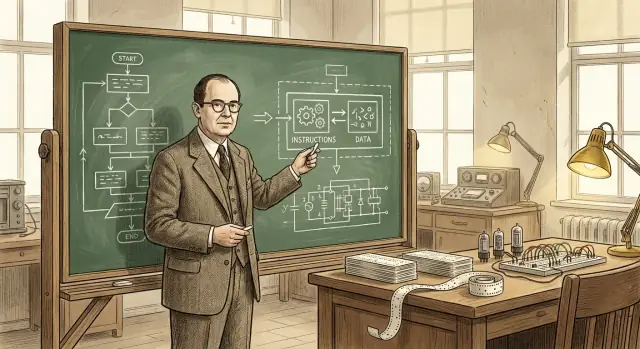

Il ruolo di John von Neumann (e perché il suo nome è rimasto)

John von Neumann non ha “inventato il computer” e non ha creato da solo l'idea del programma memorizzato. Ciò che fece—brillantemente—fu contribuire a trasformare un concetto promettente in un progetto chiaramente enunciato e ampiamente condiviso che altri ingegneri e laboratori potevano implementare.

Un contributore importante—e un comunicatore particolarmente efficace

Von Neumann fu profondamente coinvolto in progetti di calcolo durante e dopo la guerra, consigliando team e affinando la struttura logica dei primi progetti. Aveva il dono di spiegare scelte tecniche complesse in termini chiari e organizzati, e questo contava perché l'informatica elettronica stava avanzando rapidamente, con gruppi diversi che risolvevano problemi simili contemporaneamente.

Ancora più importante, scrisse e diffuse descrizioni influenti di come un computer potesse memorizzare istruzioni di programma nella stessa memoria usata per i dati. Quel quadro chiaro rese più facile per altri discutere, insegnare e replicare l'approccio.

Perché il suo nome si è attaccato all'architettura

I nomi spesso restano non tanto alla prima persona con un'idea, quanto a chi produce una descrizione di riferimento. I testi di von Neumann furono molto letti, copiati e citati—quindi i lettori successivi associarono naturalmente l'organizzazione “a programma memorizzato” a lui.

Questa etichetta semplificò anche la storia: è più facile dire “architettura von Neumann” che elencare tutti i contributori e i rapporti. Ma questa abbreviazione può offuscare quello che è realmente accaduto.

Uno sforzo collettivo, non una scoperta solitaria

I primi computer elettronici furono un impegno collaborativo e trans-istituzionale che coinvolse matematici, ingegneri e programmatori. Il concetto del programma memorizzato maturò attraverso discussioni, bozze, prototipi e revisioni tra i vari team. Il ruolo duraturo di von Neumann fu aiutare a cristallizzare e diffondere l'idea—accelerandone l'adozione—piuttosto che inventarla da solo.

Il rapporto EDVAC e una dichiarazione chiara del concetto

EDVAC (Electronic Discrete Variable Automatic Computer) fu uno dei primi progetti postbellici che miravano ad andare oltre le macchine “monouso”. Altresì importante rispetto allo sforzo hardware fu la decisione di mettere per iscritto le idee di progetto in una forma chiara e condivisibile. All'epoca la costruzione di computer era ancora vicina all'ingegneria sperimentale—la conoscenza viveva in quaderni di laboratorio, incontri e nelle teste di pochi specialisti. Un rapporto poteva trasformare quelle intuizioni disperse in qualcosa che altri gruppi potevano discutere, criticare e riusare.

Cosa diceva il rapporto EDVAC—senza la matematica

Il First Draft of a Report on the EDVAC (spesso abbreviato in “rapporto EDVAC”) espose, in termini concettuali accessibili, l'idea del programma memorizzato: un computer dovrebbe conservare le istruzioni del programma nello stesso tipo di memoria interna usata per i dati. Quella memoria non è solo un luogo per tenere numeri mentre un calcolo è in corso—contiene anche i passi che dicono alla macchina cosa fare dopo.

Questo modo di vedere fa percepire il computer meno come un dispositivo a scopo fisso e più come una macchina generale che può essere “riprogrammata” cambiando ciò che è in memoria. Non si ricollega il sistema per passare da un lavoro a un altro; si carica una diversa sequenza di istruzioni.

Perché fu importante per gli altri

Oltre al concetto in sé, il rapporto aiutò a standardizzare il modo in cui le persone parlavano dei computer: memoria, controllo, aritmetica e input/output come parti funzionali distinte che lavorano insieme. Avere un vocabolario condiviso e una descrizione ampiamente letta non solo spiegò EDVAC, ma diede all'intero campo un modello mentale comune per costruire, confrontare e migliorare i computer a programma memorizzato.

Meriti condivisi: il team dietro il pensiero iniziale sui programmi memorizzati

Guadagna crediti mentre insegni

Pubblica ciò che costruisci con Koder.ai e guadagna crediti attraverso il programma.

È allettante chiedersi “chi ha inventato il computer a programma memorizzato?” e aspettarsi un unico nome. Ma scienza e ingegneria raramente funzionano così. Le idee spesso si sviluppano in parallelo, si affinano tramite discussioni e diventano convincenti solo quando vengono dimostrate in hardware funzionante.

Collaboratori chiave e sforzi paralleli

John von Neumann è fortemente associato al concetto, ma i lavori iniziali coinvolsero molte persone e gruppi:

- J. Presper Eckert e John Mauchly (lavoro su ENIAC/EDVAC): centrali nella spinta ingegneristica verso computer elettronici pratici e progetti migliorati.

- Herman Goldstine: organizzatore cruciale e ponte tra matematici e ingegneri, figura chiave nella documentazione e diffusione delle idee.

- Arthur Burks: contribuì alla progettazione logica iniziale e a resoconti successivi su come queste architetture furono formalizzate.

- Alan Turing: scrisse riflessioni influenti, precedenti a EDVAC, sulla computazione a uso generale e sulle macchine controllate da programmi.

- Maurice Wilkes (EDSAC) e Frederic Williams & Tom Kilburn (Manchester): dimostrarono praticamente che i sistemi a programma memorizzato potevano funzionare, con prime dimostrazioni operative e progressi nella memoria.

Perché “chi l'ha inventato” è complicato

Un computer a programma memorizzato non è una singola intuizione. Combina (1) il salto concettuale che le istruzioni possano vivere in memoria come i dati, (2) l'ingegneria necessaria per costruire memorie e unità di controllo affidabili, e (3) le pratiche di programmazione che rendono il progetto utilizzabile. Persone diverse contribuirono a pezzi diversi.

Proporre vs. costruire

Un altro motivo per cui il merito è condiviso: proporre un'idea non è la stessa cosa che costruire una macchina che funziona giorno dopo giorno. I primi rapporti e le discussioni chiarirono il concetto; i primi prototipi e i sistemi di produzione provarono che era fattibile. Una storia attenta riconosce entrambi i tipi di contributo senza forzare un'improbabile sentenza di “primo inventore”.

Cosa significa solitamente “architettura von Neumann”

Quando si parla di “architettura von Neumann”, di solito ci si riferisce a un modello semplice e ampiamente insegnato di come è organizzato un computer a programma memorizzato. Non è un marchio né una singola macchina storica—è un'etichetta comoda per un piano di base che appare, in una forma o nell'altra, in molti computer.

A livello concettuale, l'immagine è la seguente:

- CPU (central processing unit): il “lavoratore” che esegue le operazioni.

- Memoria: il luogo dove il computer conserva sia le istruzioni del programma sia i dati che il programma usa.

- Input/Output (I/O): i modi per far entrare e uscire informazioni—tastiere, dischi, schermi, reti, sensori, e così via.

L'idea chiave è che la CPU non ha un luogo fisico separato per “il programma” rispetto ai “numeri”. Preleva tutto ciò che le serve dalla memoria.

Come scorrono le istruzioni: fetch, decode, execute

La CPU esegue un programma ripetendo un ciclo spesso descritto come fetch–decode–execute:

- Fetch: leggere la prossima istruzione dalla memoria.

- Decode: interpretare cosa chiede quell'istruzione (somma, confronto, carica, memorizza, salto…).

- Execute: eseguire l'azione, che può coinvolgere lettura/scrittura della memoria o interazione con l'I/O.

Questa descrizione è semplificata, ma cattura il nucleo: il programma è una sequenza di istruzioni memorizzate in memoria e la CPU le esegue passo dopo passo.

Perché è potente mettere istruzioni e dati nella stessa memoria

Mettere istruzioni e dati nella stessa memoria rende un computer a uso generale in modo molto pratico:

- Per cambiare ciò che la macchina fa, di solito cambi il programma in memoria, non il cablaggio.

- I programmi possono trattare le istruzioni come informazioni—copiarle, caricarle, modificarle (anche se i sistemi moderni spesso limitano questo per motivi di sicurezza).

- Diventa più semplice costruire strumenti come assembler, compilatori e sistemi operativi, perché “un programma” è solo un altro tipo di informazione memorizzata.

Un'etichetta comoda, non una rivendicazione di invenzione unica

Quindi “architettura von Neumann” è meglio intesa come un'abbreviazione per il modello a programma memorizzato con una CPU, una memoria condivisa che contiene istruzioni e dati, e I/O—un'idea fortemente associata alle chiare spiegazioni di von Neumann, anche se la storia iniziale coinvolse molti contributori.

Von Neumann vs. Harvard: due modi per organizzare istruzioni e dati

Trasforma i concetti in codice

Descrivi un'app in chat e lascia che Koder.ai generi un punto di partenza funzionante.

Si parla spesso di “von Neumann” e “Harvard” come se fossero filosofie in competizione. In realtà sono due modi pratici di disporre istruzioni del programma e dati in modo che il computer possa prelevare ciò che gli serve.

Stile von Neumann: una sola memoria, percorso condiviso

In un design in stile von Neumann, istruzioni e dati vivono nella stessa memoria e tipicamente viaggiano sullo stesso percorso principale verso la CPU.

È concettualmente semplice: un programma sono semplicemente byte in memoria, accanto ai numeri, al testo e alle immagini su cui lavora. Rende anche il calcolo a uso generale più diretto—il software può essere caricato, cambiato e memorizzato con gli stessi meccanismi usati per i dati.

Il compromesso: quando istruzioni e dati condividono la stessa “strada”, possono competere per la larghezza di banda. (A volte lo sente descrivere come un “collo di bottiglia”.)

Stile Harvard: archiviazione separata (e spesso percorsi separati)

Un approccio Harvard mantiene l'archiviazione delle istruzioni separata dall'archiviazione dei dati, spesso con percorsi distinti per il loro prelievo.

Questa separazione può rendere più facile prelevare la prossima istruzione mentre si leggono o scrivono dati—utile in sistemi piccoli e prevedibili. Un esempio semplice sono molti microcontrollori, dove il codice del programma può risiedere in memoria flash mentre le variabili vivono in RAM.

Perché molti sistemi reali fondono i due approcci

Le CPU moderne spesso appaiono “von Neumann” dal punto di vista del software (uno spazio di indirizzi, un modello unico), mentre internamente prendono idee dallo stile Harvard. Un esempio comune sono cache separate per istruzioni e dati (I-cache e D-cache). Al software sembra ancora un'unica memoria, ma l'hardware può prelevare codice e dati in modo più efficiente.

Da ricordare: non esiste un vincitore universale. Von Neumann enfatizza semplicità e flessibilità; Harvard enfatizza separazione e throughput. Molte macchine mescolano entrambi per bilanciare programmabilità, costo, consumo e velocità.

Come i programmi memorizzati hanno reso possibile la programmazione moderna

Un computer a programma memorizzato non si limita a eseguire calcoli—può caricare un insieme di istruzioni dalla memoria, eseguirle e poi caricarne uno diverso in seguito. Questo cambiamento rese il software riutilizzabile e condivisibile: un programma poteva essere scritto una volta, salvato, copiato, migliorato e distribuito senza toccare l'hardware.

Da “questa macchina” a “qualsiasi compito”

Quando il programma vive in memoria, la stessa macchina fisica può svolgere molti lavori diversi semplicemente sostituendo le istruzioni che legge. Questo è il vero significato di “a uso generale”: una macchina, molti programmi. Il computer non è più definito da un singolo flusso di lavoro; diventa una piattaforma.

Un esempio moderno è il tuo portatile che esegue posta, giochi e fogli di calcolo. Sotto, è sempre la stessa idea: l'hardware resta fermo mentre programmi diversi vengono caricati ed eseguiti mentre passi da un'app all'altra.

Perché questo ha permesso strumenti reali per programmare

Una volta che le istruzioni sono trattate come dati in memoria, diventa pratico costruire strati di software che aiutino a scrivere software:

- Assembler che permettono di scrivere mnemonici più umani invece di codici numerici grezzi.

- Compilatori che traducono linguaggi di livello superiore in istruzioni macchina, rendendo i programmi più facili da scrivere e manutenere.

- Sistemi operativi che gestiscono il caricamento dei programmi, la condivisione di memoria e dispositivi e la pianificazione del lavoro in modo che più programmi possano funzionare insieme.

Questi strumenti dipendono dall'assunto che i programmi possano essere memorizzati, spostati e manipolati come altre informazioni. Questo rese il software un ecosistema piuttosto che un artefatto unico legato a una specifica configurazione hardware.

Un modo utile per vedere l'arco storico: i programmi memorizzati permisero compilatori e sistemi operativi, che permisero strumenti di sviluppo moderni—e oggi vediamo un altro livello di astrazione dove puoi descrivere un'app in linguaggio naturale e avere strumenti che generano codice funzionante. Per esempio, Koder.ai è una piattaforma vibe-coding dove costruisci web, backend o app mobili tramite un'interfaccia chat, sfruttando LLM e un flusso di lavoro agent-based per accelerare il passaggio dall'intento (“cosa dovrebbe fare?”) alle istruzioni eseguibili (codice sorgente che puoi esportare, distribuire e ripristinare tramite snapshot).

Il risultato è lo stesso ciclo virtuoso: i programmi memorizzati hanno reso possibili strumenti migliori, e strumenti migliori hanno reso possibili programmi più ambiziosi—trasformando i computer in macchine flessibili e a uso generale.

Il famoso limite: il “collo di bottiglia di von Neumann”

L'idea del programma memorizzato rese i computer flessibili, ma mise anche in luce un vincolo pratico di cui gli ingegneri parlano ancora oggi: il “collo di bottiglia di von Neumann”. In termini quotidiani, è come un ingorgo sulla strada tra la CPU (il lavoratore) e la memoria (il magazzino).

Un ingorgo fra CPU e memoria

In un tipico design a programma memorizzato, sia le istruzioni sia i dati vivono in memoria. La CPU preleva un'istruzione, poi i dati necessari, poi scrive i risultati—spesso passando tutti per la stessa connessione. Se quella connessione non può muovere informazioni abbastanza velocemente, la CPU rimane in attesa anche se potrebbe calcolare molto più rapidamente.

Perché velocità e larghezza di banda contano

Due fattori correlati modellano questo collo di bottiglia:

- Latenza della memoria (velocità): quanto tempo ci vuole a ottenere il primo pezzo di informazione dopo la richiesta.

- Larghezza di banda della memoria: quanta informazione può essere trasferita al secondo una volta iniziato il trasferimento.

Una CPU può essere in grado di eseguire miliardi di operazioni al secondo, ma se la memoria non riesce a fornire un flusso costante di istruzioni e dati, le prestazioni sono limitate dal passo più lento: ottenere i byte dentro e fuori.

Mitigazioni comuni (non soluzioni magiche)

Questa è una considerazione ingegneristica molto discussa, e i computer moderni usano diverse tecniche per ridurne l'impatto:

- Cache: memoria piccola e veloce vicino alla CPU che conserva istruzioni/dati usati di recente.

- Prefetching: prevedere cosa sarà necessario e caricarlo in anticipo.

- Parallelismo: fare più cose contemporaneamente (core multipli, sovrapporre accesso alla memoria e calcolo).

Questi approcci non eliminano la “strada” sottostante, ma aiutano a mantenerla meno congestionata—così la CPU passa più tempo a lavorare e meno a aspettare.

Dove vedi l'idea nei computer che usi oggi

Rilascia con fiducia

Usa snapshot e rollback per testare le modifiche senza il timore di rompere il progetto.

Il concetto del programma memorizzato non è un pezzo da museo—è il modo in cui il calcolo quotidiano resta flessibile. I tuoi dispositivi non devono essere “ricablati” per fare qualcosa di nuovo; caricano semplicemente istruzioni diverse in memoria ed eseguirle.

Telefoni, laptop e server: lo stesso trucco di base

Su un telefono, toccare l'icona di un'app fa sì che il sistema operativo carichi il codice di quell'app (istruzioni) dall'archivio in memoria, poi la CPU lo esegue. Su un laptop succede lo stesso quando apri un browser, modifichi un documento o avvii un gioco. Nei server la cosa è ancora più evidente: la macchina può eseguire migliaia di carichi di lavoro variabili—richieste web, query di database, job in background—senza cambiare l'hardware.

Anche funzioni che percepiamo come “hardware-like” sono spesso definite da software. Instradamento di rete, decodifica video, miglioramento delle foto e politiche di gestione energetica sono frequentemente aggiornati tramite firmware e software di sistema—nuove istruzioni, stesso dispositivo.

Interpreti e macchine virtuali eseguono ancora istruzioni memorizzate

Linguaggi come Python e JavaScript tipicamente girano tramite un interprete o una macchina virtuale. Invece che la CPU esegua direttamente il tuo codice sorgente, il programma viene tradotto in una forma strutturata (bytecode o istruzioni interne) che viene memorizzata in memoria e eseguita passo dopo passo. JVM di Java, runtime .NET, WebAssembly e i motori JavaScript dei browser si basano tutti su questo: le istruzioni diventano strutture dati che la macchina può caricare, muovere ed eseguire.

Nota di sicurezza: quando i dati diventano istruzioni

Poiché le istruzioni sono “solo” informazioni, gli attacchi spesso cercano di introdurre codice malevolo nei dati—il classico code injection. Difese come protezione della memoria, firma del codice e regioni di memoria non eseguibili servono a impedire che dati non affidabili vengano trattati come istruzioni eseguibili.

Tutto questo ricade sulla promessa centrale dei programmi memorizzati: flessibilità tramite software—nuovi comportamenti sullo stesso hardware.

Punti chiave e letture suggerite

Punti chiave

- Un computer a programma memorizzato conserva le istruzioni del programma nello stesso tipo di memoria read/write dei dati, così puoi cambiare ciò che la macchina fa modificando la memoria—invece di ricollegare l'hardware.

- L'etichetta “architettura von Neumann” di solito indica una organizzazione pratica (CPU + memoria + input/output) dove istruzioni e dati condividono percorsi, non una rivendicazione che una persona abbia inventato tutto da sola.

- Il pensiero iniziale sui programmi memorizzati è stato un lavoro di squadra: le discussioni e il rapporto EDVAC hanno aiutato a chiarire l'idea, e diversi progetti mostrarono come costruirla e farla funzionare in modo affidabile.

- I programmi memorizzati hanno reso possibile la programmazione moderna perché supportano codice riutilizzabile, librerie, compilatori e sistemi operativi, tutti basati sull'assunto che il software sia dato che la macchina può caricare ed eseguire.

Domande rapide per riconoscere un'architettura

Quando guardi un computer (o leggi una specifica), queste domande ti aiutano a individuare il modello base:

- Dove sono memorizzate le istruzioni in fase di esecuzione: nella stessa memoria dei dati o in una memoria separata?

- Istruzioni e dati viaggiano sul medesimo bus/percorso, o ci sono percorsi separati (comune nei design in stile Harvard)?

- Il sistema può modificare o generare codice e poi eseguirlo (capacità classica dei programmi memorizzati), oppure l'archiviazione del codice è fissa/isolata?

- La “memoria del programma” è descritta come flash/ROM mentre la “memoria dei dati” è RAM (un indizio di separazione in molti microcontrollori)?

Letture suggerite

- Libri: The Computer from Pascal to von Neumann (Herman H. Goldstine); panoramiche storiche generali che coprono ENIAC/EDVAC/IAS.

- Musei: Computer History Museum; Science Museum (collezioni di informatica); Smithsonian (storia della tecnologia).

- Archivi e riviste: articoli storici IEEE e ACM (incluse interviste), oltre alle collezioni speciali delle biblioteche universitarie che ospitano documenti sui primi computer.

Se vuoi altri post a orientamento divulgativo come questo, sfoglia /blog.

Nota: Se sperimenti modi moderni di trasformare “istruzioni” in sistemi eseguibili—sia scrivendo codice direttamente sia usando piattaforme di build guidate dalla chat come Koder.ai—considera di documentare ciò che impari. Koder.ai offre anche un programma per guadagnare crediti pubblicando contenuti e referral, che può essere un modo pratico per finanziare altri esperimenti e tutorial.