17 aug 2025·8 min

Waarom AI-gestuurde workflows voortijdige abstractie verminderen

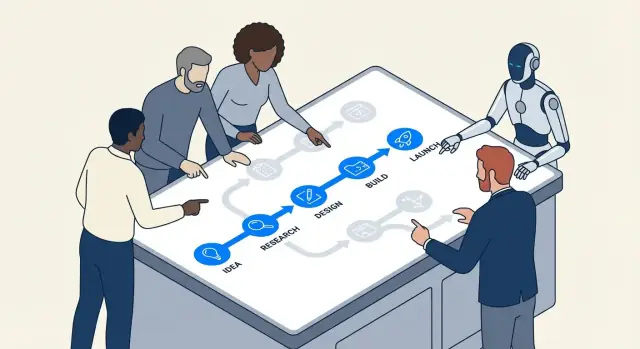

AI-gestuurde workflows stimuleren teams om concrete stappen, snelle feedback en meetbare uitkomsten te kiezen — waardoor de neiging tot te vroege abstractie en over-engineering afneemt.

Wat we bedoelen met voortijdige abstractie en over-engineering

Voortijdige abstractie is wanneer je een "algemene oplossing" bouwt voordat je genoeg echte gevallen hebt gezien om te weten wat gegeneraliseerd moet worden.

In plaats van de eenvoudigste code te schrijven die het probleem van vandaag oplost, verzin je een framework: extra interfaces, configuratiesystemen, plug-inpunten of herbruikbare modules — omdat je aanneemt dat je ze later nodig zult hebben.

Over-engineering is de bredere gewoonte erachter. Het is het toevoegen van complexiteit die op dit moment geen rendement oplevert: extra lagen, patronen, services of opties die niet duidelijk kosten of risico's verminderen.

Eenvoudige voorbeelden

Als je product één abonnementsvorm heeft en je bouwt "voor het geval" een multi-tenant prijsengine, is dat voortijdige abstractie.

Als een feature een enkele eenvoudige functie had kunnen zijn, maar je splitst het in zes klassen met factories en registries om het "uitbreidbaar" te maken, is dat over-engineering.

Waarom het vroeg in projecten opduikt

Deze gewoonten komen vaak voor aan het begin, omdat vroege projecten vol onzekerheid zitten:

- Angst voor herwerk: Teams vrezen dat als ze iets simpels bouwen, ze het later moeten herschrijven.

- Onduidelijke vereisten: Als niemand zeker weet wat het product zal worden, is het verleidelijk om een flexibel skelet te bouwen dat "alles aankan."

- Sociale druk: Engineers willen vaak vooruitkijken en het "goed doen", ook als "goed" nog niet vaststaat.

Het probleem is dat "flexibel" vaak betekent "moeilijker te veranderen." Extra lagen kunnen dagelijkse aanpassingen trager maken, debugging moeilijker en onboarding pijnlijker. Je betaalt de complexiteitskosten meteen, terwijl de voordelen mogelijk nooit komen.

Waar AI past (en waar niet)

AI-gestuurde workflows kunnen teams aansporen om werk concreet te houden — door prototyping te versnellen, snel voorbeelden te leveren en het makkelijker te maken om aannames te testen. Dat kan de angst verminderen die speculatief ontwerp voedt.

Maar AI vervangt geen engineeringoordeel. Het kan op verzoek slimme architecturen en abstracties genereren. Jouw taak blijft: Wat is het eenvoudigste dat vandaag werkt, en welk bewijs zou gerechtvaardigd zijn om morgen structuur toe te voegen?

Tools zoals Koder.ai zijn hier bijzonder nuttig omdat ze het makkelijk maken om van een chatprompt naar een uitvoerbaar stukje van een echte app (web, backend of mobiel) te gaan — zodat teams kunnen valideren wat nodig is voordat ze iets "future-proof" maken.

Hoe AI-workflows teams naar concreet werk duwen

AI-geassisteerde ontwikkeling begint meestal met iets tastbaars: een specifieke bug, een kleine feature, een datatransformatie, een UI-scherm. Die framing doet ertoe. Als de workflow start met "dit is precies wat we nodig hebben", zullen teams minder snel een gegeneraliseerde architectuur uitvinden voordat ze geleerd hebben wat het probleem echt is.

Concrete prompts creëren concrete code

De meeste AI-tools reageren het beste als je specifics geeft: inputs, outputs, beperkingen en een voorbeeld. Een prompt als "ontwerp een flexibel notificatiesysteem" is vaag, dus het model zal vaak de ontbrekende delen invullen met extra lagen — interfaces, factories, configuratie — omdat het de echte grenzen niet ziet.

Maar wanneer de prompt gegrond is, is de output dat ook:

- Input: "Gezien deze orderstatussen..."

- Output: "Geef het gebruikersgerichte bericht en CTA terug..."

- Beperkingen: "Moet snel zijn; geen database-aanroep; vereist i18n..."

- Voorbeelden: "Voor

PENDING_PAYMENTtoon ..."

Dit duwt teams natuurlijk naar het implementeren van een smalle slice die end-to-end werkt. Zodra je het kunt draaien, beoordelen en laten zien, opereer je in de realiteit in plaats van in speculatie.

"Laat het eerst werken" wordt de standaard

AI pair-programming maakt iteratie goedkoop. Als een eerste versie een beetje rommelig maar correct is, is de volgende stap meestal "refactor dit" in plaats van "ontwerp een systeem voor alle toekomstige gevallen." Die volgorde — eerst werkende code, daarna verfijnen — vermindert de neiging om abstracties te bouwen die hun complexiteit niet hebben verdiend.

In de praktijk ontstaat er een ritme:

- Vraag om een minimale implementatie.

- Test het met echte voorbeelden.

- Pas aan op basis van wat breekt of onhandig voelt.

- Trek alleen daarna een helper, module of patroon eruit.

Specificiteit onthult ontbrekende vereisten vroeg

Prompts dwingen je te zeggen wat je daadwerkelijk bedoelt. Als je de inputs/outputs niet duidelijk kunt definiëren, is dat een signaal dat je nog niet klaar bent om te abstraheren — je bent nog steeds bezig met het ontdekken van vereisten. AI-tools belonen helderheid, dus ze trainen teams subtiel om eerst te verduidelijken en later te generaliseren.

Korte feedbackloops verminderen speculatief ontwerp

Snel feedback verandert wat "goed engineering" betekent. Als je een idee binnen enkele minuten kunt proberen, begint speculatieve architectuur minder te voelen als een comfortabele deken en meer als een kostenpost die je kunt vermijden.

De lus: schets → draai → inspecteer → pas aan

AI-gestuurde workflows comprimeren de cyclus:

- Schets: vraag de assistent om een klein, werkend stukje (een script, een handler, een query)

- Draai: voer het meteen uit met echte inputs

- Inspecteer: kijk naar outputs, logs, randgevallen en hoe het faalt

- Pas aan: verfijn code en vereiste tegelijk

Deze lus beloont concreet vooruitgang. In plaats van te discussiëren over "we hebben een plug-in systeem nodig" of "dit moet 12 datasources ondersteunen", ziet het team wat het huidige probleem daadwerkelijk vraagt.

Waarom snelheid speculatieve architectuur reduceert

Voortijdige abstractie gebeurt vaak wanneer teams bang zijn voor verandering: als veranderingen duur zijn, probeer je de toekomst te voorspellen en daarvoor te ontwerpen. Met korte lussen is verandering goedkoop. Dat keert het incentive-model om:

- Je kunt generalizatie uitstellen totdat herhaald werk aantoont dat het nodig is.

- Je ontdekt echte beperkingen (prestaties, datavorm, gebruikersgedrag) vroeg.

- Je stopt met "voor het geval" bouwen, omdat je "just in time" kunt itereren.

Een eenvoudig voorbeeld: endpoint vóór framework

Stel dat je een interne "export naar CSV" feature toevoegt. Het over-engineerde pad begint met het ontwerpen van een generiek exportframework, meerdere formaten, jobqueues en configuratielagen.

Een snel-luspad is kleiner: genereer een enkele /exports/orders.csv endpoint (of een eenmalig script), voer het uit op stagingdata en inspecteer bestandsformaat, runtime en ontbrekende velden. Als je na twee of drie exports terugkerende patronen ziet — dezelfde paginatie-logica, gedeelde filtering, gemeenschappelijke headers — dan heeft een abstractie haar waarde want ze is gebaseerd op bewijs, niet op gissingen.

Incrementele veranderingen laten abstracties hun waarde bewijzen

Incrementele delivery verandert de economie van ontwerp. Als je in kleine stappen uitlevert, moet elke "nice-to-have" laag bewijzen dat ze nu helpt — niet in een ingebeelde toekomst. Daar ligt waar AI-gestuurde workflows voortijdige abstractie stilletjes verminderen: AI is goed in het voorstellen van structuren, maar die structuren zijn het makkelijkst te valideren als de scope klein is.

Kleine scope maakt AI-voorstellen testbaar

Als je de assistent vraagt om één module te refactoren of een nieuw endpoint toe te voegen, kun je snel controleren of de abstractie daadwerkelijk duidelijkheid verbetert, duplicatie reduceert of de volgende wijziging vergemakkelijkt. Met een kleine diff is de feedback onmiddellijk: tests slagen of falen, de code leest beter of slechter, en de feature gedraagt zich correct of niet.

Bij een grote scope kunnen AI-voorstellen plausibel aanvoelen zonder aantoonbaar nuttig te zijn. Je accepteert misschien een gegeneraliseerd framework omdat het "er netjes uitziet", om later te ontdekken dat het echte wereld randgevallen compliceert.

Kleine componenten onthullen wat je moet houden (en wat je kunt verwijderen)

Incrementeel werken moedigt aan om eerst kleine, wegwerpelementen te bouwen — helpers, adapters, eenvoudige datavormen. Na een paar iteraties wordt duidelijk welke onderdelen in meerdere features worden gebruikt (waard om te behouden) en welke alleen voor een eenmalig experiment waren (veilig om te verwijderen).

Abstracties worden dan een afspiegeling van daadwerkelijk hergebruik, niet van voorspeld hergebruik.

Incrementeel leveren verkleint het refactor-risico

Als wijzigingen continu worden uitgerold, is refactoren minder eng. Je hoeft het niet meteen perfect te doen omdat je het ontwerp kunt evolueren naarmate bewijs zich opstapelt. Als een patroon echt zijn waarde bewijst — door herhaald werk te verminderen over meerdere increments — is het promoten tot abstractie een laag-risico, goed onderbouwde stap.

Die mindset draait de standaard om: bouw eerst de eenvoudigste versie, abstraheer alleen wanneer de volgende incrementele stap er duidelijk baat bij heeft.

Gemakkelijk experimenteren bevoordeelt eenvoud boven "groot ontwerp"

Bewijs de app op mobiel

Valideer de flow in Flutter voordat je investeert in een herbruikbare architectuur.

AI-gestuurde workflows maken experimenteren zo goedkoop dat "één groot systeem bouwen" niet langer de standaard is. Als een team meerdere benaderingen in één middag kan genereren, bijstellen en opnieuw draaien, is het makkelijker om te leren wat echt werkt dan te voorspellen wat zou kunnen werken.

AI maakt kleine varianten bijna gratis

In plaats van dagen te investeren in het ontwerpen van een gegeneraliseerde architectuur, kunnen teams AI vragen om een paar smalle, concrete implementaties te maken:

- een eenvoudige versie die de happy path goed afhandelt

- een versie geoptimaliseerd voor leesbaarheid en onderhoudbaarheid

- een versie die precies één extra mogelijkheid toevoegt (bijv. een tweede invoerformaat)

Omdat het maken van deze varianten snel gaat, kan het team trade-offs verkennen zonder zich vast te leggen op een groot ontwerp. Het doel is niet om alle varianten te deployen — het doel is bewijs verzamelen.

Het vergelijken van varianten beloont eenvoud

Als je twee of drie werkende opties naast elkaar zet, wordt complexiteit zichtbaar. De eenvoudigere variant:

- voldoet vaak aan dezelfde reële vereisten

- heeft minder onderdelen om te debuggen

- maakt toekomstige wijzigingen makkelijker omdat er minder verborgen koppelingen zijn

Over-engineerde opties rechtvaardigen zichzelf daarentegen met hypothetische behoeften. Variantvergelijking is een tegengif: als de extra abstractie geen duidelijke, nabije voordelen oplevert, leest het als kosten.

Checklist: wat te meten bij het vergelijken van opties

Wanneer je lichte experimenten draait, maak dan afspraken over wat "beter" betekent. Een praktische checklist:

- Time-to-first-working-result: Hoe lang tot het de basisgevallen doorstaat?

- Implementatiecomplexiteit: Aantal bestanden/modules aangepast, aantal geïntroduceerde concepten en hoeveel "regels" een collega moet onthouden.

- Wijzigingskosten: Hoe moeilijk is het om één nieuwe vereiste toe te voegen (de volgende waarschijnlijke, niet een verre toekomstfantasie)?

- Faalmodi: Wat breekt, hoe erg en hoe makkelijk is het te detecteren (duidelijke fouten vs stil verkeerde output).

- Operationeel risico: Nieuwe afhankelijkheden, configuratie-oppervlak en plekken waar gedrag in productie kan afwijken.

- Testbaarheid: Hoe makkelijk kun je een kleine set tests schrijven die het gedrag uitleggen.

Als een abstractere variant niet op minstens één of twee van deze punten wint, is de eenvoudigste werkende aanpak meestal de juiste gok — voor nu.

AI helpt vereisten verduidelijken voordat je abstraheert

Voortijdige abstractie begint vaak met een zin als: "We hebben dit misschien later nodig." Dat is anders dan: "We hebben dit nu nodig." Het eerste is een gok over toekomstige variabiliteit; het tweede is een constraint die je vandaag kunt verifiëren.

AI-gestuurde workflows maken dat verschil moeilijker te negeren omdat ze ideaal zijn om vage gesprekken om te zetten in expliciete statements die je kunt inspecteren.

Maak vaagheid een geschreven contract (zonder overcommitment)

Als een featureverzoek vaag is, neigen teams naar "future-proofing" door een algemeen framework te bouwen. Gebruik in plaats daarvan AI om snel een eendelig vereissnapshot te maken die onderscheidt wat echt is van wat bedacht is:

- Wat we weten (huidige beperkingen): doelgebruikers, ondersteunde platforms, prestatieverwachtingen, vereiste integraties.

- Wat we aannemen: "Gebruikers hebben mogelijk meerdere accounts", "we ondersteunen 10 locales", "er komen prijsniveaus".

- Wat we nog niet weten: randgevallen, juridische beperkingen, schaal, migratiebehoeften.

Deze simpele opsplitsing verandert het engineeringgesprek. Je stopt met ontwerpen voor een onbekende toekomst en begint te bouwen voor een bekende heden — terwijl je een zichtbare lijst met onzekerheden bijhoudt om later opnieuw te bekijken.

Koder.ai’s Planning Mode past hier goed: je kunt een vaag verzoek omzetten in een concreet plan (stappen, datamodel, endpoints, UI-staten) voordat je implementatie genereert — zonder je vast te leggen op een omvangrijk architectuurontwerp.

Een lichte "toekomstvriendelijke" aanpak

Je kunt nog steeds ruimte laten om te evolueren zonder een diepe abstractielaag te bouwen. Geef de voorkeur aan mechanismen die makkelijk te veranderen of te verwijderen zijn:

- Feature flags om een smalle versie uit te rollen en van echt gebruik te leren.

- Configuratie voor waarden die variëren (timeouts, thresholds, tekst) in plaats van polymorfe systemen.

- Kleine extensiepunten (één interface, één hook, één event) alleen daar waar variatie al waarschijnlijk is.

Een goede regel: als je de volgende twee concrete variaties niet kunt benoemen, bouw het framework dan niet. Schrijf de vermoedelijke variaties op als "onbekenden", lever de eenvoudigste werkende route en laat echt bewijs later de abstractie rechtvaardigen.

Als je deze gewoonte wilt formaliseren, leg deze notities vast in je PR-template of een interne "assumpties"-documentatie gekoppeld aan het ticket (bijv. /blog/engineering-assumptions-checklist).

Tests en voorbeelden onthullen onnodige generalisatie

Een veelvoorkomende reden voor over-engineering is dat teams ontwerpen voor ingebeelde scenario's. Tests en concrete voorbeelden keren dat om: ze dwingen je echte inputs, echte outputs en echte faalmodi te beschrijven. Zodra die op papier staan, lijken "generieke" abstracties vaak minder nuttig — en duurder — dan een kleine, duidelijke implementatie.

Hoe AI randgevallen naar boven brengt (zonder architectuur te verzinnen)

Als je een AI-assistent vraagt om tests te helpen schrijven, duwt het je natuurlijk naar specificiteit. In plaats van "maak het flexibel" krijg je prompts als: Wat retourneert deze functie als de lijst leeg is? Wat is de maximaal toegestane waarde? Hoe representeren we een ongeldige staat?

Die vragen zijn waardevol omdat ze randgevallen vroeg blootleggen, terwijl je nog bezig bent met beslissen wat de feature echt nodig heeft. Als die randgevallen zeldzaam of buiten scope zijn, kun je ze documenteren en doorgaan — zonder een abstractie "voor het geval" te bouwen.

Tests eerst schrijven onthult of een abstractie nodig is

Abstracties verdienen hun plaats als meerdere tests dezelfde setup of gedragspatronen delen. Als je testsuite maar één of twee concrete scenario's bevat, is het creëren van een framework of plugin-systeem meestal een teken dat je optimaliseert voor hypothetisch toekomstwerk.

Een eenvoudige vuistregel: als je niet minstens drie verschillende gedragingen kunt formuleren die dezelfde gegeneraliseerde interface vereisen, is je abstractie waarschijnlijk voortijdig.

Mini-template voor praktische testcases

Gebruik deze lichte structuur voordat je naar "gegeneraliseerd" ontwerp grijpt:

- Happy path: Typische input → verwachte output.

- Grensgeval: Minimum/maximum waarden, lege collecties, limieten (bijv. 0, 1, 1000).

- Fout: Ongeldige input, ontbrekende afhankelijkheden, timeouts, permissiefouten → verwachte fout of fallback.

Zodra deze zijn geschreven, wil de code vaak eenvoudig zijn. Als herhaling over meerdere tests verschijnt, is dat je signaal om te refactoren — niet je uitgangspunt.

Zichtbare onderhoudskosten ontmoedigen over-engineering

Houd AI-uitvoer gegrond

Vraag eerst om een minimale implementatie en iterateer daarna met tests en echte voorbeelden.

Over-engineering zit vaak verborgen achter goede bedoelingen: "We hebben dit later nodig." Het probleem is dat abstracties terugkerende kosten hebben die niet zichtbaar zijn in het initiële ticket.

De echte rekening voor een abstractie

Elke nieuwe laag die je introduceert veroorzaakt meestal terugkerend werk:

- API-oppervlak: meer methoden, parameters en randgevallen om te ondersteunen (en backwards compatible te houden).

- Documentatie en voorbeelden: onboarding betekent het uitleggen van de abstractie, niet alleen de feature.

- Migraties: zodra andere code van een gegeneraliseerde interface afhankelijk is, vereisen wijzigingen adapters, deprecaties en release-opmerkingen.

- Testmatrix: "generieke" code vergroot scenario's — meerdere implementaties, meer mocks, meer integratiepunten.

AI-gestuurde workflows maken deze kosten lastiger te negeren omdat ze snel kunnen opsommen waarvoor je tekent.

Gebruik AI om complexiteit te schatten: tel de bewegende onderdelen

Een praktische prompt is: "Noem de bewegende onderdelen en afhankelijkheden die dit ontwerp introduceert." Een goede AI-assistent kan het plan opdelen in concrete items zoals:

- nieuwe modules/pakketten

- publieke interfaces en versieverwachtingen

- database-schemawijzigingen en migratiestappen

- cross-service calls en faalmodi

- nieuwe configuratievlaggen, permissies of queues

Dat overzicht naast een simpele, directe implementatie zetten maakt "clean architecture"-argumenten tot een heldere afweging: wil je acht nieuwe concepten onderhouden om een duplicatie te vermijden die misschien nooit optreedt?

Een "complexiteitsbudget" om werk eerlijk te houden

Een lichte policy: beperk het aantal nieuwe concepten per feature. Bijvoorbeeld, sta maximaal toe:

- 1 nieuwe publieke API

- 1 nieuwe gedeelde abstractie (interface/basisklasse)

- 1 nieuw datamodel/tabel

Als de feature het budget overschrijdt, eis dan een onderbouwing: welke toekomstige verandering maakt dit mogelijk, en welk bewijs heb je dat die nabij is? Teams die AI gebruiken om deze justificatie op te stellen (en om onderhoudstaken te voorspellen) kiezen vaak voor kleinere, omkeerbare stappen — omdat de terugkerende kosten zichtbaar zijn voordat de code wordt opgeleverd.

Wanneer AI je de verkeerde kant op kan duwen (en hoe dat te voorkomen)

AI-gestuurde workflows sturen teams vaak naar kleine, testbare stappen — maar ze kunnen ook het tegenovergestelde doen. Omdat AI snel "complete" oplossingen kan produceren, neigt het ertoe vertrouwde patronen toe te voegen, extra structuur te genereren of scaffolding te maken dat je niet vroeg omvroeg. Het resultaat kan meer code zijn dan nodig, eerder dan nodig.

Hoe AI per ongeluk over-engineering stimuleert

Een model wordt vaak beloond (door menselijke perceptie) voor grondigheid. Dat kan zich vertalen in extra lagen, meer bestanden en gegeneraliseerde ontwerpen die er professioneel uitzien maar geen actueel probleem oplossen.

Waarschuwingssignalen zijn onder meer:

- Nieuwe abstracties zonder concreet gebruiksgeval (bijv. "voor toekomstige flexibiliteit")

- Extra lagen: service → manager → adapter → factory, terwijl een functie volstaat

- Generieke interfaces met slechts één implementatie

- Plugin-systemen, eventbussen of dependency-injection setups die vroeg worden geïntroduceerd

- Een "framework binnen een framework" om iets te standaardiseren dat je nog niet herhaald hebt

Mitigaties om AI-uitvoer gegrond te houden

Behandel AI als een snelle paar handen, niet als een architectuurcommissie. Een paar beperkingen helpen enorm:

- Beperk prompts tot het heden. Vraag om de kleinst mogelijke wijziging die vandaag voldoet en verbied expliciet nieuwe patronen tenzij ze noodzakelijk zijn.

- Eis echte voorbeelden. Voordat je een abstractie accepteert, vraag 2–3 concrete call sites (of gebruikersflows) en controleer of de abstractie ze vereenvoudigt.

- Beperk architectuurverandering per iteratie. Sta slechts één structurele wijziging tegelijk toe (bijv. "introduceer één nieuw module" of "geen nieuwe lagen in deze PR").

- Controleer op verwijderbaarheid. Als het verwijderen van de nieuwe laag het gedrag nauwelijks verandert, heeft het waarschijnlijk zijn waarde niet bewezen.

Een simpele regel: laat AI niet generaliseren totdat je codebase herhaalde pijnpunten heeft.

Een praktische beslisframework: eerst bouwen, later abstraheren

Bouw eerst de eenvoudigste versie

Zet één concreet vereiste om in een uitvoerbare app voordat je frameworks ontwerpt.

AI maakt het goedkoop om code te genereren, te refactoren en alternatieven te proberen. Dat is een geschenk — als je het gebruikt om abstractie uit te stellen totdat ze verdiend is.

Stap 1: Begin concreet (optimaliseer voor leren)

Begin met de simpelste versie die het probleem van vandaag oplost voor één "happy path." Benoem dingen naar wat ze doen (niet naar wat ze later mogelijk doen) en houd API's smal. Als je twijfelt of een parameter, interface of plugin-systeem nodig is, lever het dan zonder.

Een nuttige regel: verkies duplicatie boven speculatie. Gedupliceerde code is zichtbaar en makkelijk te verwijderen; speculatieve generaliteit verbergt complexiteit in indirectie.

Stap 2: Extraheer later (optimaliseer voor stabiliteit)

Zodra de feature gebruikt wordt en verandert, refactor met bewijs. Met AI-ondersteuning kun je hier snel handelen: vraag het om een extractie voor te stellen, maar eis een minimale diff en leesbare namen.

Als je tooling het toelaat, gebruik veiligheidsnetten die refactors laag-risico maken. Bijvoorbeeld maken Koder.ai’s snapshots en rollback het makkelijker om met refactors te experimenteren, omdat je snel kunt terugdraaien als een "nettere" opzet in de praktijk slechter blijkt.

Wanneer abstractie gerechtvaardigd is (korte checklist)

Abstractie verdient haar plek als de meeste van deze waar zijn:

- Herhaalde logica: hetzelfde gedrag komt in 2–3 plekken voor en updates vereisten al meerdere aanpassingen.

- Bewezen variabiliteit: je hebt echte variaties gezien in productie of gevalideerde prototypes (niet "misschien X ooit").

- Duidelijk eigenaarschap: er is een persoon/team dat de abstractie, documentatie en toekomstige wijzigingen beheert.

- Stabiele grens: de input/output-vorm is consistent gebleven over minstens een paar iteraties.

- Netto vereenvoudiging: de extractie vermindert de totale code en cognitieve last, niet alleen herordening.

Een eenvoudig ritueel: de "één week later" review

Zet een herinnering een week na het uitrollen van een feature:

- Open de diff opnieuw en lijst wat er sinds release is veranderd.

- Identificeer kopieer-acties of terugkerende bugs.

- Beslis één van drie uitkomsten: houd concreet, extraheer een kleine helper, of introduceer een gedeeld module.

Dit houdt de standaardhouding: bouw eerst, generaliseer later als de realiteit erom vraagt.

Wat te meten om engineering slank te houden

Lean engineering is geen gevoel — het is observeerbaar. AI-gestuurde workflows maken het makkelijker om kleine wijzigingen snel uit te rollen, maar je hebt nog steeds signalen nodig om te zien wanneer het team terugglijdt naar speculatief ontwerp.

Een klein aantal metrics die over-engineering vroeg vangen

Houd een paar leading indicators bij die correleren met onnodige abstractie:

- Cycle time: tijd van "werk gestart" tot "merged en gedeployed." Als cycle time groeit zonder duidelijke scope-toename, duidt dat vaak op extra indirectie of future-proofing.

- Diffgrootte: gemiddelde aantal regels gewijzigd (of bestanden aangeraakt) per wijziging. Grote diffs zijn moeilijker te reviewen en nodigen gegeneraliseerde oplossingen uit.

- Aantal geïntroduceerde concepten: tel nieuwe modules/services/pakketten, nieuwe interfaces, nieuwe configuratieknoppen, nieuwe "framework-achtige" primitiven. Concepten zijn een belasting die je blijvend betaalt.

- Defectrate: productiebugs of supporttickets per release. Abstracties kunnen randgevallen verbergen; stijgende defects na "opschoningswerk" is een rood vlag.

- Time-to-onboard: hoe lang duurt het voor een nieuwe engineer om hun eerste kleine wijziging te releasen? Als onboarding vertraagt, wordt het systeem misschien geoptimaliseerd voor elegantie boven duidelijkheid.

Je hoeft niet perfect te zijn — trendlijnen volstaan. Bekijk deze wekelijks of per iteratie en vraag: "Hebben we meer concepten toegevoegd dan het product nodig had?"

Lichte documentatie die mysterieuze abstracties voorkomt

Eis een korte "waarom dit bestaat"-opmerking wanneer iemand een nieuwe abstractie introduceert (een nieuwe interface, helperlaag, interne library, enz.). Houd het bij een paar regels in de README of als commentaar nabij het entrypunt:

- Welk concreet probleem lost het vandaag op?

- Welke alternatieven zijn geprobeerd?

- Wat zou rechtvaardigen dat het verwijderd wordt?

Een actieplan om te starten

Voer een pilot uit met een klein AI-ondersteund workflow voor één team gedurende 2–4 weken: AI-ondersteund ticketopbreken, AI-geassisteerde code review checklists en AI-gegenereerde testcases.

Vergelijk aan het eind de bovenstaande metrics en houd een korte retro: behoud wat cyclus- en onboardingtijd verkort, rol terug wat het aantal geïntroduceerde concepten verhoogde zonder meetbaar productvoordeel.

Als je zoekt naar een praktische omgeving om dit experiment end-to-end te draaien, helpt een vibe-coding platform zoals Koder.ai je om die kleine, concrete slices snel in deployable apps om te zetten (met bronexport wanneer je volledige controle wilt), wat de gewoonte versterkt waar dit artikel voor pleit: lever iets echt, leer, en abstraheer pas daarna.