Wat “kosten, tijd en frictie” betekenen in softwarewerk

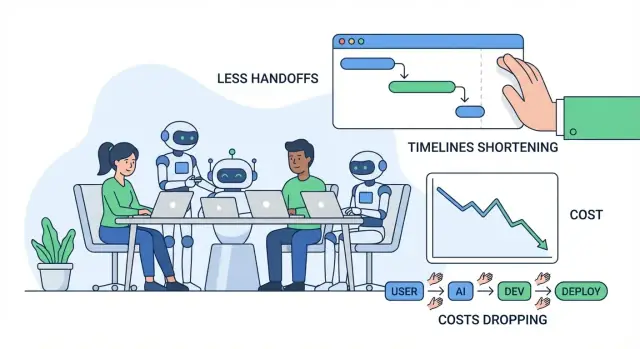

Als mensen het hebben over het verbeteren van softwarelevering, bedoelen ze meestal drie dingen: kosten, tijd en frictie. Deze hangen nauw samen, maar zijn niet hetzelfde — en het helpt om ze kort en duidelijk te definiëren voordat we het over AI hebben.

Kosten: wat je betaalt voor uitkomsten

Kosten zijn de totale uitgave om een feature op te leveren en te onderhouden: salarissen en ingehuurde uren, cloudkosten, tooling en de “verborgen” kosten van vergaderingen, coördinatie en het oplossen van fouten. Een feature die twee weken langer duurt kost niet alleen meer engineeringtijd — het kan ook omzet vertragen, de supportlast verhogen of je dwingen oudere systemen langer te onderhouden.

Tijd: hoe lang het duurt van idee tot waarde voor de klant

Tijd is de kalenderduur van “we moeten dit bouwen” tot “klanten kunnen het betrouwbaar gebruiken.” Het omvat ontwikkeling, maar ook beslissingen, goedkeuringen, wachten op reviews, wachten op omgevingen, wachten op QA‑resultaten en wachten op iemand met de juiste context om een vraag te beantwoorden.

Frictie: de moeite die verloren gaat aan traagheid, verwarring en onderbrekingen

Frictie is de dagelijkse wrijving die werk langzamer doet aanvoelen dan het zou moeten: onduidelijke vereisten, heen‑en‑weer verduidelijkingen, contextswitching, dubbel werk of lange overdrachten tussen rollen of teams.

De meeste verspilling in softwareprojecten verschijnt als overdrachten, rework en wachten. Een kleine misverstand vroeg kan later uitgroeien tot herontwerpen, bugjachten of herhaalde vergaderingen. Een trage reviewqueue of ontbrekende documentatie kan vooruitgang blokkeren, zelfs als iedereen “druk” lijkt.

In dit artikel omvat AI‑tools code‑copilots, chatassistenten voor onderzoek en uitleg, geautomatiseerde analyse voor vereisten en tickets, hulpmiddelen voor testgeneratie en workflowautomatisering in QA/DevOps.

AI kan inspanning verminderen en cycli versnellen — maar het haalt verantwoordelijkheid niet weg. Teams hebben nog steeds duidelijke eigenaarschap, goed oordeel, security‑controles en menselijke goedkeuring nodig voor wat er wordt opgeleverd.

Waar softwareprojecten meestal tijd en geld verliezen

De meeste overschrijdingen komen niet van “moeilijk programmeren”. Ze ontstaan door alledaagse knelpunten die zich opstapelen: onduidelijke vereisten, constante contextswitching, trage reviewlussen en handmatig testen dat te laat gebeurt.

De gebruikelijke knelpunten (en waarom ze duur zijn)

Onduidelijke vereisten veroorzaken de grootste downstream‑kosten. Een klein misverstand vroeg kan later een week herwerk betekenen — vooral wanneer verschillende mensen dezelfde feature anders interpreteren.

Contextswitching is de stille productivitykiller. Engineers springen tussen tickets, chatvragen, vergaderingen en productiestoringen. Elke switch heeft een herstartkost: de codebase herladen, de besluitgeschiedenis en het ‘waarom’ terugvinden.

Trage reviews vertragen niet alleen merges — ze vertragen leren. Als feedback dagen later komt, is de auteur vaak al verder en duurt het langer om het op te lossen.

Handmatig testen en late QA betekent vaak dat problemen worden gevonden wanneer ze het duurst zijn om te repareren: nadat meerdere features zijn gebouwd of vlak voor release.

De verborgen kosten waar mensen meestal niet voor budgetteren

De zichtbare kosten zijn salarissen en leveranciersrekeningen. De verborgen kosten doen vaak meer pijn:

- Herwerk: code herschrijven en flows herontwerpen omdat vereisten veranderden of verkeerd werden begrepen.

- Vertragingen: wachten op beslissingen, goedkeuringen, testomgevingen of één sleutelpersoon die moet reageren.

- Coördinatie‑overhead: synchroniseren tussen product, design, engineering, QA, security en stakeholders.

Een eenvoudige idee → release workflow (met pijnpunten)

Idee → vereisten → ontwerp → bouwen → review → testen → release → monitoren

Typische pijnpunten: vereisten (ambiguïteit), bouwen (onderbrekingen), review (wachttijd), testen (handwerk), release (overdrachten), monitoren (traag troubleshooten).

Snelle diagnose: friction mapping

Probeer een “friction map” in een sessie van 30 minuten: lijst elke stap en markeer (1) waar werk wacht, (2) waar beslissingen stagneren en (3) waar rework gebeurt. Die gemarkeerde gebieden zijn vaak waar AI‑tools de snelste besparingen opleveren — door misverstanden te verminderen, feedback te versnellen en repetitief handwerk te schrappen.

AI‑ondersteunde discovery en vereisten: minder misverstanden

Discovery is waar veel projecten stilletjes van koers raken: notities liggen verspreid, feedback is tegenstrijdig en beslissingen zitten in mensenhoofden. AI kan gesprekken met gebruikers niet vervangen, maar het kan het “vertalingsverlies” tussen gesprekken, documenten en wat engineers daadwerkelijk bouwen verminderen.

Teams verzamelen vaak een stapel onderzoeksnotities — interviewtranscripten, supporttickets, salesfragmenten, enquêteantwoorden — en worstelen daarna om snel patronen te halen. AI‑tools kunnen deze stap versnellen door:

- Lange onderzoeksnotities samen te vatten tot consistente conclusies (pijnpunten, doelen, bezwaren)

- Feedback te clusteren in thema’s (bijv. onboardingverwarring vs ontbrekende integraties)

- Eerste drafts van user stories en jobs‑to‑be‑done op te stellen vanuit ruwe inputs

Dit creëert geen waarheid automatisch, maar wel een duidelijk startpunt dat makkelijker te bekritiseren, verfijnen en op één lijn te brengen is.

Bepaal scope en acceptatiecriteria eerder

Misverstanden verschijnen meestal later als “dat is niet wat ik bedoelde”‑herwerk. AI helpt door snel eerste versies van het volgende te produceren:

- Scope‑grenzen (wat wel/niet in deze release zit)

- Randgevallen en “wat als…”‑scenario’s gebaseerd op vergelijkbare patronen

- Acceptatiecriteria die specifiek genoeg zijn om te testen

Bijvoorbeeld: als een vereiste zegt “gebruikers kunnen rapporten exporteren”, kan AI het team prompten om te verduidelijken: formaten (CSV/PDF), permissies, datumbereiken, tijdzonegedrag en of exports gemaild of gedownload worden. Deze antwoorden vroeg krijgen vermindert churn tijdens ontwikkeling en QA.

Consistente documentatie die daadwerkelijk gebruikt wordt

Wanneer vereisten verspreid leven in docs, chatthreads en tickets, betalen teams constant een “contextswitch‑belasting”. AI kan helpen een enkele, leesbare verhaallijn bij te houden door het opstellen en onderhouden van:

- Vergaderingssamenvattingen met beslissingen en openstaande vragen

- Vereisten‑docs en ticketbeschrijvingen in een consistent template

- Woordenlijsten voor domeintermen (zodat “account”, “workspace” en “org” niet door elkaar gebruikt worden)

Het rendement is minder onderbrekingen (“wat hebben we besloten?”) en soepelere overdrachten tussen product, design, engineering en QA.

Heklijnen: valideer aannames, besteed ze niet uit

AI‑outputs moeten als hypotheses behandeld worden, niet als vereisten. Gebruik eenvoudige heklijnen:

- Bekijk samenvattingen altijd tegen originele bronnen (vooral citaten en cijfers)

- Markeer onzekere items als vragen en bevestig ze met gebruikers en stakeholders

- Houd beslissings‑eigendom bij het team: AI stelt op, mensen keuren goed

Op deze manier vermindert AI‑geassisteerde discovery misverstanden zonder verantwoordelijkheid te verzwakken — en snijdt daarmee kosten, tijd en frictie voordat er ook maar één regel code is geschreven.

Sneller prototypen en ontwerpiteratie met AI

Prototyping is waar veel teams ofwel weken besparen — of ze verbranden ze. AI maakt het goedkoper om snel ideeën te verkennen, zodat je kunt valideren wat gebruikers echt willen voordat je engineeringtijd aan een volledige build besteedt.

Snelle “eerste drafts” voor schermen en flows

In plaats van vanaf een blanco pagina te beginnen, kun je AI gebruiken om te genereren:

- UI‑tekst voor knoppen, foutmeldingen, onboardingstappen en empty states (met toonopties zoals “vriendelijk” of “formeel”)

- Wireframe‑ideeën als eenvoudige schermbeschrijvingen (wat staat op de pagina, wat is primair vs secundair)

- Voorbeelden van gebruikersreizen: “nieuwe gebruiker meldt zich aan → importeert data → stelt een doel in → ontvangt een herinnering”

Deze drafts zijn geen finale ontwerpwerk maar geven je team iets concreets om op te reageren. Dat vermindert heen‑en‑weer zoals “ik dacht dat je X bedoelde” of “we zijn het nog steeds niet eens over de flow”.

Snelle demo‑apps en proof‑of‑concepts

Voor veel productbeslissingen heb je geen productiekwaliteitscode nodig om te leren. AI kan helpen bij het samenstellen van een basisdemo of proof‑of‑concept (POC) die laat zien:

- De kerninteractie (wat de gebruiker klikt, wat hij daarna ziet)

- Voorbeelddata en realistische randgevallen

- Een eenvoudige “happy path” die goed genoeg is voor interne review of gebruikersinterviews

Als je verder wilt gaan dan statische mockups, kunnen vibe‑coding platforms zoals Koder.ai nuttig zijn voor snelle iteraties: je beschrijft de feature in een chatinterface, genereert een werkend web‑ of mobiel app‑draft (op het web vaak React en op mobiel vaak Flutter), en verfijnt het daarna met stakeholders voordat je aan een volledige engineeringcyclus begint.

Waar de tijdwinst echt vandaan komt

De grootste besparingen zitten meestal niet in de “ontwerptijd”. Ze komen van het voorkomen van volledige builds van het verkeerde ding. Wanneer een prototype verwarring, ontbrekende stappen of onduidelijke waarde aan het licht brengt, kun je richting bijsturen terwijl veranderingen nog goedkoop zijn.

Een belangrijke waarschuwing: verzend geen prototypecode per ongeluk

AI‑gegenereerde prototypes slaan vaak belangrijke schoonmaak over: securitychecks, toegankelijkheid, performance, goede foutafhandeling en onderhoudbare structuur. Behandel prototypecode als wegwerpbaar tenzij je het bewust verhardt — anders loop je het risico van een snel experiment dat in langdurig rework verandert.

Als je prototypes omzet naar echte features, zoek dan naar workflows die die overgang expliciet maken (bijv. planningsmodus, snapshots en rollback). Dat helpt teams snel te bewegen zonder traceerbaarheid te verliezen.

Sneller coderen met AI‑assistenten (en waar ze het meest helpen)

Release met een vangnet

Itereer sneller met snapshots en rollback als een wijziging niet werkt.

AI‑codeassistenten zijn het meest waardevol in de onromantische delen van ontwikkeling: van “niets” naar een werkend startpunt komen en repetitief werk verwijderen dat teams vertraagt. Ze vervangen geen engineeringoordeel — maar ze kunnen de tijd tussen idee en reviewbare pull request sterk verkleinen.

Hoe ze de “lege pagina”‑tijd verminderen

Wanneer je een nieuwe endpoint, job of UI‑flow start, gaat het eerste uur vaak naar wiring, benoemen en patronen kopiëren uit eerdere code. Assistenten kunnen die initiële structuur snel opstellen: mappen, basisfuncties, foutafhandeling, logging en placeholder‑tests. Zo besteden engineers meer tijd aan productlogica en randgevallen en minder aan boilerplate.

Voor teams die verder willen dan “assistent in de editor”, verpakken platforms zoals Koder.ai dit in een volledige workflow: van een specificatie in chat naar een draaibare app met backend‑delen (vaak Go + PostgreSQL), plus opties zoals broncode‑export en deployment/hosting. Het praktische voordeel is dat de coördinatiekost van “tot iets komen dat je kunt reviewen” daalt.

Taken waar ze het beste bij passen

Ze presteren het beste bij afgebakend, patroonmatig werk, vooral wanneer je codebase al duidelijke conventies heeft:

- Scaffolding: nieuwe routes/controllers, CRUD‑schermen, CLI‑commando’s, background jobs, SDK‑wrappers.

- Refactors: hernoemen en reorganiseren van modules, functies extraheren, consistente foutafhandeling toepassen, verouderde API’s bijwerken.

- Vertalingen: kleine componenten porten tussen talen/frameworks (bijv. Python naar TypeScript) met tests om gedrag te bevestigen.

- Kleine features: goed afgebakende toevoegingen zoals een filter, export, webhook‑handler of validatieregel.

- Interne tools: adminpagina’s, scripts, datafixes, rapportgenerators — hoge waarde, lage UX‑polish.

Promptpatronen die bruikbare code opleveren

Goede prompts lijken minder op “schrijf feature X” en meer op een mini‑spec. Voeg toe:

- Context: wat de module doet, waar het leeft en omringende API’s.

- Beperkingen: libraries, stijlregels, performance‑eisen, security‑vereisten.

- Voorbeelden: bestaande soortgelijke bestanden of een input/output‑voorbeeld.

- Acceptatietests: randgevallen en “klaar‑betekent…” checks (ook in gewone taal).

Add a /v1/invoices/export endpoint.

Context: Node/Express, uses InvoiceService.list(), auth middleware already exists.

Constraints: stream CSV, max 50k rows, no PII fields, follow existing error format.

Example: match style of routes/v1/customers/export.ts.

Acceptance: returns 401 if unauthenticated; CSV has headers A,B,C; handles empty results.

Review is ononderhandelbaar

AI‑gegenereerde code heeft nog steeds dezelfde standaarden nodig: code review, security review en tests. Developers blijven verantwoordelijk voor correctheid, data‑handling en compliance — behandel de assistent als een snelle draft, niet als autoriteit.

Reviewcycli en rework verminderen met AI

Code review is een plek waar veel “verborgen kosten” zich ophopen: wachten op feedback, intentie steeds opnieuw uitleggen en dezelfde categorieën issues herhaaldelijk oplossen. AI kan reviewer‑oordeel niet vervangen, maar het kan de tijd voor mechanische checks en misverstanden verminderen.

Hoe AI helpt bij code review

Een goede AI‑workflow ondersteunt reviewers voordat ze de PR überhaupt openen:

- Wijzigingen samenvatten: genereer een platte‑Engelse samenvatting van wat de PR doet, welke bestanden veranderden en welk gedrag bedoeld is. Dat helpt reviewers sneller te focussen en vermindert opmerkingen als “wat kijk ik hier eigenlijk naar?”.

- Risicovolle patronen signaleren: markeer veelvoorkomende bronnen van bugs — ontbrekende nullchecks, onveilige stringparsing, flauwe tijdsafhankelijke logica, onbehandelde fouten of verdachte permissiewijzigingen.

- Tests voorstellen: doe concrete testvoorstellen op basis van de diff (“voeg test toe voor ongeldige input”, “controleer toegang voor rol X”, “cover het nieuwe randgeval in paginatie”).

Minder heen‑en‑weer loops

AI verbetert ook duidelijkheid en consistentie, wat vaak de drijvende kracht is achter review‑pingpong:

- Draft betere PR‑beschrijvingen (motivatie, aanpak, afwegingen).

- Handhaaf naamgevings‑ en formatteringsconsistentie om subjectieve discussies te vermijden.

- Stel kleine refactors voor die code leesbaarder maken, zodat reviewers later geen grote herwerkingen hoeven te vragen.

Praktische regels die het veilig houden

Gebruik AI om review te versnellen zonder standaarden te verlagen:

- Menselijke goedkeuring is verplicht voor elke PR.

- Stem AI‑suggesties af op je stijlguide en lintregels.

- Houd PR’s klein en gefocust zodat zowel mensen als AI ze kunnen doorgronden.

Waar AI nog moeite mee heeft

AI is zwakst bij domeinlogica en architectuur: businessregels, randgevallen gekoppeld aan echte gebruikers en systeembrede afwegingen vereisen nog steeds ervaren oordeel. Behandel AI als assistent van de reviewer — niet als de reviewer.

AI in testen en QA: issues eerder vangen met minder handwerk

Behoud eigenaarschap van de code

Exporteer de broncode zodat je team volledige controle houdt naarmate het project groeit.

Testen is waar kleine misverstanden uitgroeien tot dure verrassingen. AI kan geen garantie op kwaliteit bieden, maar het kan veel repetitief werk wegnemen — zodat mensen meer tijd besteden aan de lastige gevallen die producten echt breken.

Geautomatiseerde testgeneratie: begin bij echte codepaden

AI‑tools kunnen unittests voorstellen door bestaande code te lezen en veelvoorkomende uitvoeringspaden te identificeren (de “happy path”), plus takken die gemakkelijk vergeten worden (foutafhandeling, null/lege inputs, retries, timeouts). Wanneer je ook een korte spec of acceptatiecriteria meegeeft, kan AI randgevallen rechtstreeks uit de vereisten afleiden — bijvoorbeeld grenswaarden, ongeldige formaten, permissiechecks en “wat als de upstream service down is?”‑scenario’s.

De beste toepassing hier is versnelling: je krijgt snel een eerste testdraft, waarna engineers assertions aanpassen aan echte businessregels.

Snellere testdata, mocks en fixtures

Een onverwachte tijdvreter in QA is het maken van realistische testdata en het inregelen van mocks. AI kan helpen door:

- Representatieve voorbeeldrecords te genereren (inclusief “vreemde” gevallen) die aan validatieregels voldoen

- Mocks/stubs voor externe services te schrijven met voorspelbare responses

- Herbruikbare fixtures te creëren die tests korter en leesbaarder maken

Dit versnelt zowel door developers geschreven unittests als integratietests, vooral wanneer veel API’s betrokken zijn.

Betere bugreports: duidelijker, snellere fixes

Als issues naar QA of productie ontsnappen, kan AI bugreports verbeteren door rommelige notities om te zetten in gestructureerde reproductiestappen en door verwachting vs feitelijk gedrag duidelijk te scheiden. Gegeven logs of console‑output kan het patronen samenvatten (wat het eerst faalde, wat herhaalde, wat correleert met de failure) zodat engineers het eerste uur niet alleen aan begrijpen van het rapport hoeven te besteden.

Kwaliteitscontroles (niet onderhandelbaar)

AI‑gegenereerde tests moeten nog steeds:\n\n- Zinvol zijn: assertions gekoppeld aan echte vereisten, niet alleen “draait zonder crash”\n- Deterministisch zijn: geen flakiness door timing, random seeds of onstabiele externe afhankelijkheden\n- Onderhouden worden: behandel ze als productcode — review, goede namen en updates wanneer gedrag verandert

Op deze manier vermindert AI handmatig werk terwijl teams issues eerder vangen — wanneer fixes het goedkoopst zijn.

Release en operatie: minder wachten, sneller troubleshooten

Releasetaken zijn plekken waar “kleine vertragingen” zich opstapelen: een onbetrouwbare pipeline, een onduidelijke fout, een ontbrekende configwaarde of een trage overdracht tussen dev en ops. AI‑tools helpen door de tijd tussen “er is iets mis” en “we weten wat te doen” te verkorten.

AI voor CI/CD en DevOps

Moderne CI/CD‑systemen produceren veel signalen (buildlogs, testoutput, deployevents). AI kan die ruis samenvatten tot een korte, actiegerichte weergave: wat faalde, waar het voor het eerst verscheen en wat recent veranderde.

Het kan ook waarschijnlijke fixes in context suggereren — zoals een versieconflict in een Docker‑image, een foutieve stapvolgorde in een workflow of een ontbrekende omgevingsvariabele — zonder dat je handmatig honderden regels hoeft te scannen.

Als je een end‑to‑end platform gebruikt zoals Koder.ai voor bouwen en hosten, kunnen operationele features zoals snapshots en rollback ook releaserisk verminderen: teams kunnen experimenteren, deployen en snel terugdraaien als de realiteit afwijkt van het plan.

Incidentondersteuning: sneller hypothesen en checklists

Tijdens incidenten telt snelheid vooral in de eerste 15–30 minuten. AI kan:

- Root‑causehypothesen opstellen op basis van logs, alerts en recente deployments

- Een remediatiechecklist genereren (rollback, feature‑flag uit, schaal omhoog, queue legen, DB‑connecties valideren)

- Gerichte commando’s en queries voorstellen om elke hypothese te bevestigen of uit te sluiten

Dit verlaagt on‑call‑belasting door triage te versnellen — niet door de mensen die de service bezitten te vervangen. Eigenaarschap, oordeel en verantwoordelijkheid blijven bij het team.

Veiligheidsnotities (sla deze niet over)

AI helpt alleen wanneer het veilig gebruikt wordt:\n\n- Plak geen secrets (API‑sleutels, tokens, klantdata) in prompts — gebruik redactie en least‑privilege toegang\n- Behandel AI‑output als suggesties, niet als wijzigingen. Code review, goedkeuringen en change management blijven van kracht\n- Geef de voorkeur aan tooling die met gesaneerde logs kan werken en audittrails biedt voor compliance

Documentatie en kennisdeling: minder onderbrekingen en overdrachten

Maak snel een reviewbaar concept

Zet een korte specificatie om in een draaibaar app‑concept met Koder.ai in chat.

Goede documentatie is een van de goedkoopste manieren om engineeringfrictie te verminderen — maar het is vaak het eerste dat verslapt wanneer deadlines krap zijn. AI‑tools helpen door documentatie een lichtgewicht, herhaalbaar onderdeel van dagelijks werk te maken in plaats van iets wat “later” moet gebeuren.

Wat AI kan versnellen (zonder eigenaarschap te vervangen)

Teams zien meestal snelle winst in documentatie met duidelijke patronen:

- API‑docs: genereer endpointbeschrijvingen, request/response‑voorbeelden en errortabellen uit bestaande specs of code‑comments.

- Runbooks: stel stap‑voor‑stap incidentplaybooks op (“Als X alert gaat, controleer Y, doe dan Z”) uit eerdere tickets en postmortems.

- Changelogs en releasenotes: vat gemergde pull requests samen in klantgerichte en interne versies.

- Onboarding‑gidsen: maak “eerste week” checklists, serviceoverzichten en glossariumpagina’s uit repo‑structuur en bestaande docs.

De kern is dat AI een sterke eerste draft produceert; mensen bevestigen wat waar is, wat veilig te delen is en wat belangrijk is.

Minder onderbrekingen, minder knelpunten

Wanneer docs doorzoekbaar en actueel zijn, besteedt het team minder tijd aan het beantwoorden van herhaalde vragen zoals “Waar staat de config?” of “Hoe draai ik dit lokaal?” Dat vermindert contextswitching, beschermt focustijd en voorkomt dat kennis bij één ‘go‑to’ persoon blijft hangen.

Goed bijgehouden docs verkleinen ook overdrachten: nieuwe collega’s, QA, support en niet‑technische stakeholders kunnen zelf antwoorden vinden in plaats van op een engineer te wachten.

Een praktisch workflow die blijft plakken

Een simpel patroon werkt voor veel teams:

- Genereer docupdates vanuit PRs (samenvatting + wat veranderde + hoe te testen)

- Menselijke bewerking en verificatie (juistheid, security, doelgroepfit)

- Versioneer docs in de repo naast code, zodat wijzigingen reviewed en meegeleverd worden

Toegankelijkheid voor niet‑technische lezers

AI kan dichte notities herschrijven in duidelijker taal, consistente koppen toevoegen en structuur standaardiseren over pagina’s heen. Dat maakt documentatie bruikbaar buiten engineering — zonder engineers tot professionele schrijvers te hoeven maken.

ROI meten: hoe besparingen kwantificeren zonder giswerk

ROI wordt wazig als je alleen vraagt “Hebben we sneller opgeleverd?” Een handiger aanpak is de specifieke kostendrivers te prijzen die AI raakt en daarna een baseline met een “met‑AI” uitvoering te vergelijken.

Breng je echte kostendrivers in kaart

Begin met het opsommen van de bakken die voor jouw team echt bewegen:

- Engineeringuren: bouwen, reviewen, testen, fixen, rework.

- Cloudkosten: omgevingen die blijven draaien, trage pipelines, herhaalde testruns.

- Toolabonnementen: AI‑seats, testingtools, monitoring, designtools.

- Supportlast: incidentresponse, bugtriage, klanttickets.

- Vertragingskosten: vertraagde omzet, contractuele boetes, opportunity cost.

Kies één feature of sprint en verdeel tijd in fasen. Meet vervolgens twee waarden per fase: gemiddelde uren zonder AI versus met AI, plus eventuele nieuwe toolkosten.

Een eenvoudige formule:

\nSavings = (Hours_saved × Blended_hourly_rate) + Cloud_savings + Support_savings − Tool_cost\nROI % = Savings / Tool_cost × 100\n

Je hebt geen perfecte tracking nodig — gebruik tijdlogs, PR‑cyclustijd, aantal reviewrondes, testflakiness en lead time to deploy als proxies.

Negeer “risicokosten” niet

AI kan ook kosten introduceren als het ongereguleerd wordt gebruikt: security‑exposure, licentie/IP‑problemen, compliance‑gaten of lagere codekwaliteit. Prijs dit als verwachte kosten:\n\n- Risk cost = Probability × Impact (bijv. rework na een securityfinding, auditremediatietijd)

Begin klein, schaal daarna

Start met één workflow (bijv. testgeneratie of vereistenverduidelijking). Draai het 2–4 weken, registreer before/after metrics en breid pas dan uit naar meer teams. Zo wordt AI‑adoptie een meetbare verbetercyclus in plaats van een geloofskoop.

Risico’s en heklijnen: security, kwaliteit en compliance

AI kan veel repeterend werk wegnemen, maar het introduceert ook nieuwe faalwijzen. Behandel AI‑output als sterke autocomplete: handig voor snelheid, niet als bron van waarheid.

Belangrijke risico’s om voor te bereiden

Ten eerste onjuiste of onvolledige outputs. Modellen kunnen plausibel klinken terwijl ze randgevallen missen, API’s verzinnen of code produceren die de happy path passeert maar in productie faalt.

Ten tweede securitylekken. Secrets, klantdata, incidentlogs of proprietary code in ongeautoriseerde tools plakken kan per ongeluk blootstelling veroorzaken. Er is ook risico dat gegenereerde code onveilige patronen bevat (zwakke auth, onveilige deserialisatie, injection‑gevoelige queries).

Ten derde licentie/IP‑zorgen. Gegeneerde code kan overeenkomsten vertonen met beschermde snippets of afhankelijkheden introduceren met incompatibele licenties als developers klakkeloos kopiëren.

Ten vierde bias of inconsistente beslissingen. AI kan prioritering, woordkeus of evaluatie op een manier sturen die onbedoeld gebruikers uitsluit of interne beleidsregels schendt.

Praktische waarborgen die de snelheid hoog houden

Maak menselijke review de regel, niet de suggestie: vereis code review voor AI‑gegenereerde wijzigingen en vraag reviewers om security, foutafhandeling en tests te controleren — niet alleen stijl.

Voeg lichte beleid en toegang toe: alleen goedgekeurde tools, SSO, op rollen gebaseerde permissies en duidelijke regels over welke data gedeeld mag worden.

Houd audittrails bij: log prompts en outputs in goedgekeurde omgevingen waar mogelijk en noteer wanneer AI is gebruikt voor vereisten, code of testgeneratie.

Basisprincipes voor gegevensverwerking

Vermijd het sturen van gevoelige data (PII, credentials, productielogs, klantcontracten) naar algemene AI‑tools. Geef de voorkeur aan goedgekeurde omgevingen, redactie en synthetische voorbeelden.

De uiteindelijke conclusie

AI‑outputs zijn suggesties, geen garanties. Met heklijnen — review, beleid, toegangscontrole en traceerbaarheid — kun je snelheidswinst behalen zonder veiligheid, kwaliteit of compliance op te geven.

Een praktisch adoptieroadmap voor teams van elke omvang

AI‑tools adopteren werkt het beste als je het als elke andere procesverandering behandelt: begin klein, standaardiseer wat werkt en breid uit met duidelijke heklijnen. Het doel is niet “AI overal gebruiken” — maar het wegnemen van vermijdbaar heen‑en‑weer, rework en wachten.

Fase 1: Pilot (1–2 weken)

Kies één team en één workflow waar fouten laag risico hebben maar tijdbesparing zichtbaar is (bv. schrijven van user stories, genereren van testcases, refactoren van een klein module). Houd de scope smal en vergelijk met je normale baseline.

Fase 2: Standaarden (licht, geen bureaucratie)

Leg vast hoe “goed AI‑gebruik” eruitziet voor je team.

- Prompttemplates: korte, herbruikbare prompts voor veelvoorkomende taken (vereistenverduidelijking, code reviewnotities, testplandrafts).

- Reviewchecklist: wat mensen moeten verifiëren (correctheid, security, randgevallen, afstemming met vereisten).

- Do/Don’t lijst:\n - Do: geef context, beperkingen, acceptatiecriteria en voorbeelden.\n - Don’t: plak geen secrets, productiedata of proprietaire data die je niet mag delen.

Fase 3: Training (2–4 korte sessies)

Leer mensen betere vragen te stellen en outputs te valideren. Focus op praktische scenario’s: “zet een vage vereiste om in testbare acceptatiecriteria” of “genereer een migratieplan en check de risico’s”.

Fase 4: Automatisering (waar herhaling pijn doet)

Als het team het proces vertrouwt, automatiseer dan repetitieve onderdelen: PR‑beschrijvingen, testscaffolding, releasenotes en tickettriage. Houd een menselijke goedkeuringsstap voor alles wat shipped.

Als je platforms evalueert, kijk of ze veilige iteratiefuncties ondersteunen (bijv. planningsmodus, snapshots en rollback) en praktische adoptieopties (zoals broncode export). Dit is één gebied waar Koder.ai is ontworpen om in bestaande engineeringverwachtingen te passen: snel bewegen, maar controle behouden.

Fase 5: Continue verbetering

Evalueer maandelijk templates en regels. Zet prompts die niet helpen uit de roulatie en breid standaarden alleen uit als je terugkerende faalpatronen ziet.

Metrics om bij te houden (zodat ROI geen giswerk is)

Houd een paar indicatoren consequent bij:

- Cyclustijd (idee → gedeployed)

- Reviewtijd (PR open → gemerged)

- Defectrate (bugs ontsnapt + bugs gevonden in QA)

- Herwerk % (tickets heropend, churn, herhaalde wijzigingen)

- Teamsatisfactie (korte pulsenquête)

Gebruik deze checklist in je volgende project

Als je de bevindingen van je pilot publiceert, kan het ook de moeite waard zijn om het te formaliseren als interne richtlijn of een publiek stuk — veel teams merken dat het documenteren van before/after metrics AI‑adoptie verandert van experiment naar herhaalbare praktijk. (Sommige platforms, inclusief Koder.ai, draaien ook programma’s waarin teams credits kunnen verdienen voor het delen van praktische content of het doorverwijzen van andere gebruikers, wat toolkosten in de beginfase kan compenseren.)