24 apr 2025·8 min

Hoe je een webapp bouwt die handmatig werk bijhoudt om te automatiseren

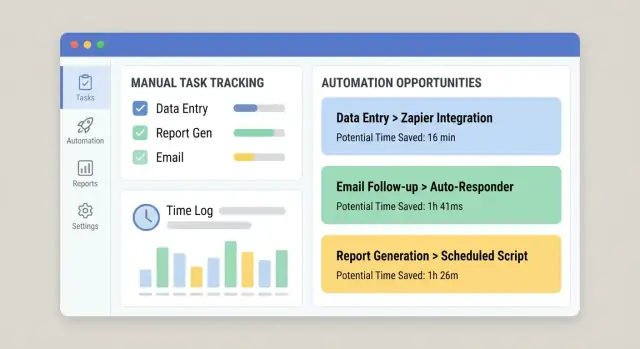

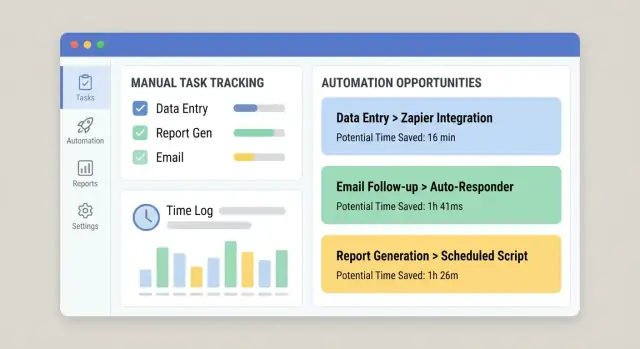

Leer hoe je een webapp plant en bouwt die handmatig werk vastlegt, bewijs en tijd registreert en herhaalde taken omzet in een automatiserings-kandidaatlijst.

Leer hoe je een webapp plant en bouwt die handmatig werk vastlegt, bewijs en tijd registreert en herhaalde taken omzet in een automatiserings-kandidaatlijst.

Voordat je schermen schetst of een database kiest, wees helder over wat je probeert te meten. Het doel is niet “alles wat medewerkers doen bijhouden.” Het doel is handmatig werk zo betrouwbaar vastleggen dat je kunt beslissen wat je als eerste automatiseert—op basis van bewijs, niet meningen.

Schrijf de terugkerende activiteiten op die nu handmatig gebeuren (copy/paste tussen systemen, gegevens opnieuw invoeren, documenten controleren, goedkeuringen najagen, spreadsheets reconciliëren). Beschrijf voor elke activiteit:

Als je het niet in twee zinnen kunt beschrijven, meng je waarschijnlijk meerdere workflows door elkaar.

Een tracking-app slaagt wanneer hij iedereen bedient die met het werk te maken heeft—niet alleen degene die het rapport wil.

Verwacht verschillende motivaties: operators willen minder administratief werk; managers willen voorspelbaarheid; IT wil stabiele requirements.

Tracking is alleen nuttig als het verbonden is met uitkomsten. Kies een kleine set die je consequent kunt berekenen:

Definieer grenzen vroeg om te voorkomen dat je per ongeluk een monster bouwt.

Deze app is meestal niet:

Hij kan deze systemen wel aanvullen—en soms een smalle slice vervangen—als dat expliciet je bedoeling is. Als je al tickets gebruikt, kan je tracking-app simpelweg gestructureerde “handmatige inspanning”-data aan bestaande items toevoegen (zie /blog/integrations).

Een tracking-app slaagt of faalt door focus. Als je probeert elke “drukke handeling” vast te leggen, verzamel je rumoerige data, frustreer je gebruikers en weet je nog steeds niet wat je als eerste moet automatiseren. Begin met een kleine, expliciete scope die je consistent kunt meten.

Kies workflows die veel voorkomen, repetitief zijn en al pijnlijk zijn. Een goede beginset bestrijkt vaak verschillende soorten handmatig werk, bijvoorbeeld:

Schrijf een eenvoudige definitie op die iedereen op dezelfde manier kan toepassen. Bijvoorbeeld: “Elke stap waarbij een persoon informatie verplaatst, controleert of transformeert zonder dat een systeem het automatisch doet.” Voeg voorbeelden en een paar uitsluitingen toe (bijv. klantgesprekken, creatief schrijven, relatiebeheer) zodat mensen niet alles gaan loggen.

Wees expliciet over waar de workflow begint en eindigt:

Bepaal hoe tijd wordt vastgelegd: per taak, per shift of per week. “Per taak” geeft het beste automatiseringssignaal, maar “per shift/week” kan een praktisch MVP zijn als taken te versnipperd zijn. Het belangrijkste is consistentie, niet precisie.

Voordat je velden, schermen of dashboards kiest, krijg een helder beeld van hoe het werk vandaag daadwerkelijk gebeurt. Een lichte kaart onthult wat je moet bijhouden en wat je kunt negeren.

Begin met één workflow en schrijf die in een rechte lijn:

Trigger → stappen → overdrachten → resultaat

Houd het concreet. “Request komt binnen in een gedeelde inbox” is beter dan “Intake vindt plaats.” Noteer voor elke stap wie het doet, welke tool ze gebruiken en wat “klaar” betekent. Als er overdrachten zijn (van Sales naar Ops, van Ops naar Finance), benoem die expliciet—overdrachten zijn plekken waar werk verdwijnt.

Je tracking-app moet wrijving benadrukken, niet alleen activiteit. Markeer tijdens het in kaart brengen:

Deze vertragingen worden later waardevolle velden (bijv. “blokkadereden”) en prioritaire automatiseringskandidaten.

Maak een lijst van systemen waarop mensen vertrouwen om het werk te voltooien: e-mailthreads, spreadsheets, ticketingtools, gedeelde schijven, legacy-apps, chatberichten. Als meerdere bronnen elkaar tegenspreken, noteer welke “wint.” Dit is essentieel voor latere integraties en om dubbele data-invoer te vermijden.

De meeste handmatige taken zijn rommelig. Noteer de veelvoorkomende redenen waarom taken afwijken: speciale klantvoorwaarden, ontbrekende documenten, regionale regels, eenmalige goedkeuringen. Je probeert niet elke edge-case te modelleren—noteer alleen de categorieën die verklaren waarom een taak langer duurde of extra stappen vereiste.

Een tracker voor handmatig werk slaagt of faalt op één ding: of mensen snel werk kunnen loggen terwijl ze toch data genereren waarop je kunt handelen. Het doel is niet “alles verzamelen.” Het is net genoeg structuur vastleggen om patronen te zien, impact te kwantificeren en herhaald pijnpunt om te zetten in automatiseringskandidaten.

Houd je kern datamodel eenvoudig en consistent over teams heen:

Deze structuur ondersteunt zowel dagelijkse logging als latere analyse zonder gebruikers te dwingen een lange vragenlijst in te vullen.

Tijd is essentieel om automatisering te prioriteren, maar het moet eenvoudig zijn:

Als tijd voelt als “controle”, neemt adoptie af. Positioneer het als een manier om drukwerk weg te nemen, niet om individuen te monitoren.

Voeg één verplicht veld toe dat uitlegt waarom het werk niet geautomatiseerd werd:

Gebruik een korte dropdown plus een optionele notitie. De dropdown maakt rapportage mogelijk; de notitie biedt context voor uitzonderingen.

Elke Task moet eindigen met een paar consistente uitkomsten:

Met deze velden kun je verspilling kwantificeren (herwerk), faalwijzen identificeren (error types) en een geloofwaardige automatiseringsbacklog opbouwen op basis van echt werk—niet meningen.

Als het loggen van een work item langzamer voelt dan het werk zelf, slaan mensen het over—of ze voeren vage data in die je later niet kunt gebruiken. Je UX-doel is simpel: leg de minimaal bruikbare details vast met zo weinig mogelijk frictie.

Begin met een kleine set schermen die de volledige cyclus dekken:

Ontwerp voor snelheid boven volledigheid. Gebruik toetsenbord-snelkoppelingen voor veelvoorkomende acties (item aanmaken, status veranderen, opslaan). Bied templates voor herhaald werk zodat gebruikers niet steeds dezelfde beschrijvingen en stappen opnieuw typen.

Gebruik waar mogelijk in-place bewerken en zinnige defaults (bijv. automatisch toewijzen aan de huidige gebruiker, zet “gestart op” wanneer iemand een item opent).

Free-text is nuttig, maar het aggregeert niet goed. Voeg begeleide velden toe die rapportage betrouwbaar maken:

Maak de app leesbaar en bruikbaar voor iedereen: hoog contrast, duidelijke labels (niet alleen placeholders), zichtbare focusstaten voor toetsenbordnavigatie en mobielvriendelijke lay-outs voor snel loggen onderweg.

Als je app bedoeld is om automatiseringsbeslissingen te sturen, moeten mensen de data vertrouwen. Dat vertrouwen breekt als iedereen alles kan bewerken, goedkeuringen onduidelijk zijn of er geen registratie is van wijzigingen. Een eenvoudig permissiemodel en een lichte audittrail lossen dit grotendeels op.

Begin met vier rollen die aansluiten bij hoe werk daadwerkelijk wordt gelogd:

Vermijd vroege, per-gebruiker customregels; rolgebaseerde toegang is makkelijker uit te leggen en te onderhouden.

Bepaal welke velden “feiten” zijn versus “notities”, en vergrendel feiten zodra ze zijn beoordeeld.

Een praktische aanpak:

Dit houdt rapportage stabiel en staat toch legitieme correcties toe.

Voeg een auditlog toe voor sleutelgebeurtenissen: statuswisselingen, tijdsaanpassingen, goedkeuringen/afwijzingen, bewijs toegevoegd/verwijderd en permissiewijzigingen. Bewaar minstens: actor, timestamp, oude waarde, nieuwe waarde en (optioneel) een korte opmerking.

Maak dit zichtbaar op elk record (bijv. een “Activiteit”-tab) zodat geschillen niet in Slack-archaeologie eindigen.

Stel retentieregels vroeg vast: hoe lang logs en gerelateerde bewijzen (afbeeldingen, bestanden, links) worden bewaard. Veel teams doen 12–24 maanden voor logs en korter voor grote bijlagen.

Als uploads zijn toegestaan, behandel ze als onderdeel van het auditverhaal: versioneer bestanden, registreer verwijderingen en beperk toegang op basis van rollen. Dit is belangrijk wanneer een entry de basis wordt voor een automatiseringsproject.

Een praktisch MVP moet makkelijk te bouwen en te veranderen zijn, en saai te beheren. Het doel is niet je toekomstige automatiseringsplatform voorspellen—het is handmatig werk betrouwbaar vastleggen met minimale frictie.

Begin met een duidelijke scheiding:

Deze scheiding houdt de UI snel om mee te itereren terwijl de API de bron van waarheid blijft.

Kies een stack waar je team snel mee kan leveren en die sterke community-ondersteuning heeft. Veelgebruikte combinaties:

Vermijd vroege exotische technologie—je grootste risico is productonzekerheid, niet performance.

Als je het MVP wilt versnellen zonder jezelf vast te zetten, kan een vibe-coding platform zoals Koder.ai helpen om van een geschreven specificatie naar een werkende React-webapp met een Go API en PostgreSQL te komen—via chat—terwijl je nog steeds de optie behoudt om de broncode te exporteren, te deployen/hosten en veilig terug te draaien met snapshots. Dat is vooral nuttig voor interne tools zoals trackers voor handmatig werk, waar requirements snel veranderen na de eerste pilot.

Ontwerp endpoints die weerspiegelen wat gebruikers daadwerkelijk doen, niet hoe je databasetabellen eruitzien. Typische ‘werkwoord-achtige’ mogelijkheden:

Dit maakt het makkelijker om in de toekomst clients te ondersteunen (mobiel, integraties) zonder je core te herschrijven.

POST /work-items

POST /work-items/{id}/time-logs

POST /work-items/{id}/attachments

POST /work-items/{id}/status

GET /work-items?assignee=me&status=in_progress

Zelfs vroege gebruikers vragen: “Kan ik uploaden wat ik al heb?” en “Kan ik mijn data eruit krijgen?” Voeg daarom toe:

Het vermindert opnieuw invoeren, versnelt onboarding en voorkomt dat je MVP als een doodlopend gereedschap voelt.

Als je app afhankelijk is van mensen die zich alles herinneren, zal adoptie wegdrijven. Een praktische aanpak is starten met handmatige invoer (zodat de workflow duidelijk is) en connectors toevoegen waar ze echt inspanning wegnemen—vooral bij hoogvolume, repetitief werk.

Zoek stappen waar mensen al een spoor achterlaten. Veelvoorkomende “laag-frictie” integraties:

Integraties worden snel rommelig als je items niet betrouwbaar kunt matchen tussen systemen. Maak een unieke identifier (bijv. MW-10482) en sla externe IDs erbij op (e-mail message ID, spreadsheet row key, ticket ID). Toon die identifier in notificaties en exports zodat mensen overal naar hetzelfde item kunnen verwijzen.

Het doel is niet direct mensen elimineren—het is typen verminderen en herwerk voorkomen.

Prefill velden vanuit integraties (requester, onderwerp, timestamps, bijlagen), maar behoud menselijke override zodat de log de werkelijkheid reflecteert. Bijvoorbeeld: een e-mail kan een categorie en geschatte inspanning voorstellen, terwijl de persoon de daadwerkelijke bestede tijd en uitkomst bevestigt.

Een goede regel: integraties maken standaard concepten, en mensen moeten “bevestigen en indienen” totdat je de mapping vertrouwt.

Het bijhouden van handmatig werk is alleen waardevol als het leidt tot beslissingen. Het doel van je app moet zijn ruwe logs om te zetten in een geprioriteerde lijst automatiseringskansen—jouw “automatiseringsbacklog”—die makkelijk te bekijken is in een wekelijkse ops- of verbeterbijeenkomst.

Begin met een simpele, uitlegbare score zodat stakeholders zien waarom iets bovenaan komt. Een praktische set criteria:

Houd de score zichtbaar naast de onderliggende cijfers zodat het geen black box voelt.

Voeg een speciale weergave toe die logs groepeert in herhaalbare “work items” (bijv. “Update klantadres in Systeem A en bevestig in Systeem B”). Rangschik items automatisch op score en toon:

Maak taggen lichtgewicht: één-klik tags zoals system, input type en exception type. Na verloop van tijd onthullen deze stabiele patronen (goed voor automatisering) versus rommelige edge-cases (beter voor training of procesaanpassingen).

Een simpele schatting volstaat:

ROI (tijd) = (bespaarde tijd × frequentie) − aanname voor onderhoud

Gebruik voor onderhoud een vaste maandelijkse urenaanname (bijv. 2–6 uur/maand) zodat teams kansen consistent vergelijken. Dit houdt je backlog gefocust op impact, niet op meningen.

Dashboards zijn alleen nuttig als ze snel echte vragen beantwoorden: “Waar besteden we tijd aan?” “Wat vertraagt ons?” en “Heeft onze laatste wijziging echt geholpen?” Ontwerp rapportage rond beslissingen, niet rond vanity charts.

De meeste leiders willen niet elk detail—ze willen duidelijke signalen. Een praktisch baseline-dashboard bevat:

Maak elk kaartje klikbaar zodat een leider van een kopcijfer naar “wat veroorzaakt dit” kan doorgaan.

Een enkele week kan misleiden. Voeg trendlijnen en eenvoudige datumfilters toe (laatste 7/30/90 dagen). Wanneer je een workflow wijzigt—zoals een integratie toevoegen of een formulier vereenvoudigen—maak het dan makkelijk om voor versus na te vergelijken.

Een lichte aanpak: sla een “change marker” op (datum en beschrijving) en toon een verticale lijn op grafieken. Dat helpt mensen verbeteringen aan echte interventies te koppelen in plaats van te gokken.

Handmatig werk tracking mixt vaak harde data (timestamps, aantallen) en zachtere inputs (geschatte tijd). Label metrics duidelijk:

Als tijd geschat is, geef dat duidelijk weer in de UI. Eerlijk zijn is beter dan er precies uitzien en fout zijn.

Elke grafiek moet “toon de records” ondersteunen. Drill-down bouwt vertrouwen en versnelt actie: gebruikers filteren op workflow, team en datum en openen dan onderliggende work items om notities, overdrachten en veelvoorkomende blokkades te zien.

Koppel dashboards aan je “automatiseringsbacklog”-weergave zodat de grootste tijdvreters direct omgezet kunnen worden in kandidaatverbeteringen terwijl de context vers is.

Als je app vastlegt hoe werk gebeurt, verzamelt hij snel gevoelige details: klantnamen, interne notities, bijlagen en “wie deed wat en wanneer.” Beveiliging en betrouwbaarheid zijn geen add-ons—zonder hen verlies je vertrouwen (en adoptie).

Begin met rolgebaseerde toegang die overeenkomt met echte verantwoordelijkheden. De meeste gebruikers mogen alleen hun eigen logs of die van hun team zien. Beperk admin-machtigingen tot een kleine groep en scheid “mag entries bewerken” van “mag data exporteren/goedkeuren.”

Voor bestandsuploads: behandel elke bijlage als onbetrouwbaar:

Je hebt geen enterprise-security nodig om een MVP te lanceren, maar wel de basics:

Leg systeemgebeurtenissen vast voor troubleshooting en auditen: aanmeldingen, permissiewijzigingen, goedkeuringen, importjobs en mislukte integraties. Houd logs gestructureerd en doorzoekbaar, maar sla geen geheimen op—schrijf nooit API-tokens, wachtwoorden of volledige bijlage-inhoud naar logs. Redacteer gevoelige velden standaard.

Als je PII verwerkt, beslis dan vroeg:

Deze keuzes beïnvloeden je schema, permissies en backups—makkelijker nu te plannen dan later te retrofitten.

Een tracking-app slaagt of faalt op adoptie. Behandel rollout als een productlancering: begin klein, meet gedrag en iterateer snel.

Piloteer met één team—bij voorkeur een groep die de pijn van handmatig werk al voelt en een duidelijke workflow heeft. Houd de scope smal (één of twee werktypes) zodat je gebruikers goed kunt ondersteunen en de app kunt aanpassen zonder de hele organisatie te verstoren.

Verzamel tijdens de pilot feedback direct: een één-klik “Dit was lastig”-prompt na het loggen, plus een wekelijkse check-in van 15 minuten. Zodra adoptie stabiel is, breid je uit naar het volgende team met vergelijkbare werkpatronen.

Stel eenvoudige, zichtbare doelen zodat iedereen weet wat “goed” is:

Volg deze in een intern dashboard en bespreek ze met teamleads.

Voeg in-app begeleiding toe waar mensen aarzelen:

Stel een reviewcadans in (maandelijks werkt goed) om te beslissen wat je als volgende automatiseert en waarom. Gebruik logdata om te prioriteren: hoge frequentie + hoge tijd eerst, met duidelijke eigenaren en verwachte impact.

Sluit de lus door uitkomsten te tonen: “Omdat je X hebt gelogd, hebben we Y geautomatiseerd.” Dat is de snelste manier om mensen te blijven laten loggen.

Als je snel over teams heen iterereert, overweeg tooling die snelle wijzigingen ondersteunt zonder de app te destabiliseren. Bijvoorbeeld, Koder.ai’s planning mode helpt je scope en flows uit te werken voordat je wijzigingen genereert, en snapshots/rollback maken het veiliger om workflows, velden en permissies aan te passen terwijl je leert van de pilot.

Begin met het opsommen van terugkerende handmatige activiteiten en beschrijf elke activiteit in duidelijke termen:

Als je het niet in twee zinnen kunt beschrijven, splits het dan op in meerdere workflows zodat je het consistent kunt meten.

Begin met 3–5 workflows die vaak voorkomen, herhaalbaar zijn en al lastig zijn (copy/paste, gegevensinvoer, goedkeuringen, reconciliaties, handmatige rapportage). Een beperkte scope verbetert adoptie en levert schonere data voor automatiseringsbeslissingen.

Gebruik een definitie die iedereen op dezelfde manier kan toepassen, bijvoorbeeld: “Elke stap waarbij iemand informatie verplaatst, controleert of transformeert zonder dat een systeem het automatisch doet.”

Documenteer ook uitsluitingen (bijv. relatiebeheer, creatief schrijven, klantgesprekken) zodat mensen niet alles gaan registreren en je dataset verwaterd raakt.

Breng elke workflow in kaart als:

Vastleg voor elke stap wie het doet, welke tool ze gebruiken en wat “klaar” betekent. Noteer expliciet overdrachten en rework-lussen—die worden later waardevolle trackingvelden (zoals blokkaderedenen en rework-aantallen).

Een praktisch, herbruikbaar kernmodel is:

Bied meerdere manieren om tijd vast te leggen zodat mensen de app niet vermijden:

De prioriteit is consistentie en lage frictie, niet perfecte nauwkeurigheid—positioneer het als het wegnemen van administratieve rompslomp, niet als toezicht.

Maak één verplicht veld dat uitlegt waarom het werk handmatig bleef, met een korte dropdown:

Voeg een optionele opmerking toe voor context. Dit levert rapportagevriendelijke data op en geeft tegelijk nuance voor automatiseringsontwerp.

Gebruik eenvoudige rolgebaseerde toegang:

Vergrendel “feiten” (tijd, status, bewijs) na goedkeuring en houd een auditlog bij van belangrijke wijzigingen (wie, wanneer, oud/nieuw waarde). Dit stabiliseert rapportage en bouwt vertrouwen.

Een ‘saai’, praktisch MVP-architectuur is meestal voldoende:

Dit maakt iteratie snel terwijl je een betrouwbare bron van waarheid behoudt.

Maak een herhaalbare manier om logs om te zetten in gerangschikte kansen met transparante criteria:

Genereer vervolgens een “automatiseringsbacklog”-weergave die totale bestede tijd, trends, topteams en veelvoorkomende blokkades toont zodat wekelijkse beslissingen op bewijs zijn gebaseerd, niet op meningen.

Houd het consistent tussen teams zodat rapportage en automatiseringsscoring later werken.