19 okt 2025·8 min

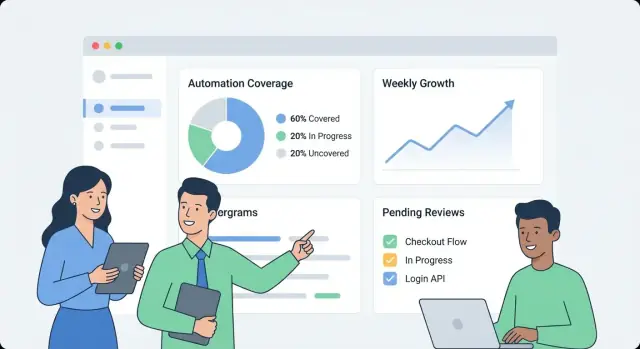

Hoe je een webapp bouwt om interne automatiseringsdekking te monitoren

Leer hoe je een webapp ontwerpt en bouwt die interne automatiseringsdekking bijhoudt: metriek, datamodel, integraties, dashboard-UX en waarschuwingen.

Leer hoe je een webapp ontwerpt en bouwt die interne automatiseringsdekking bijhoudt: metriek, datamodel, integraties, dashboard-UX en waarschuwingen.

Voordat je iets bouwt, schrijf op wat “automatiseringsdekking” binnen jouw organisatie betekent. Anders wordt het dashboard een verzameling van niet-gerelateerde cijfers die verschillende teams verschillend interpreteren.

Begin met het kiezen van de eenheden die je meet. Veelvoorkomende opties zijn:

Kies één primaire definitie voor v1 en noteer secundaire types die je later kunt toevoegen. Wees expliciet over randgevallen, zoals “semi-geautomatiseerde” stappen die nog goedkeuringen vereisen.

Verschillende doelgroepen stellen verschillende vragen:

Schrijf 5–10 “topvragen” en behandel ze als productvereisten.

Definieer de primaire uitkomsten: zichtbaarheid (wat bestaat), prioritering (wat te automatiseren), verantwoordelijkheid (wie is eigenaar) en trendtracking (gaat het vooruit?).

Stel duidelijke grenzen voor v1. Voorbeelden: “We scoren nog geen kwaliteit,” “We meten nog geen bespaarde tijd,” of “We nemen alleen CI-gebaseerde tests op, geen lokale scripts.”

Bepaal ten slotte wat succes is: consistente adoptie (wekelijkse actieve gebruikers), hoge datafrisheid (bijv. updates binnen 24 uur), minder blinde vlekken (dekking voor alle kritieke systemen) en meetbare opvolging (eigenaren toegewezen en gaten krimpen maand na maand).

Voordat je dekking kunt meten, moet je weten waar “bewijs van automatisering” daadwerkelijk staat. In de meeste organisaties verspreidt automatisering zich over tools die teams op verschillende momenten hebben gekozen.

Begin met een pragmatische inventaris die antwoord geeft op: Welke signalen bewijzen dat een activiteit geautomatiseerd is, en waar kunnen we ze ophalen?

Typische bronnen zijn CI-pijplijnen (build/test-jobs), testframeworks (unit/integratie/E2E-resultaten), workflowtools (goedkeuringen, deployments, tickettransities), runbooks (scripts en gedocumenteerde procedures) en RPA-platforms. Voor elke bron leg je vast welk identifier je later kunt joinen (repo, servicenaam, omgeving, team) en welk “bewijs” je opslaat (job run, testrapport, automatiseringsregel, scriptuitvoering).

Vervolgens lijst je je systemen van registratie die bepalen wat “zou moeten bestaan”: repo-hosting, issue-tracker en een CMDB/servicecatalogus. Deze bronnen geven doorgaans de gezaghebbende lijst van services, eigenaren en criticaliteit—essentieel om dekking te berekenen in plaats van alleen activiteit te tellen.

Koppel elke bron aan de minst fragiele ingestiemethode:

Leg rate limits, authenticatiemethoden (PAT, OAuth, service-accounts), retentiewindows en bekende datakwaliteitsproblemen vast (hernoemde services, inconsistente naamgeving, ontbrekende eigenaren).

Plan uiteindelijk een bronbetrouwbaarheidsscore per connector (en optioneel per metriek) zodat gebruikers kunnen zien of een cijfer “hoog vertrouwen” of “best effort” is. Dit voorkomt valse precisie en helpt bij het prioriteren van connectorverbeteringen later.

Een nuttig dekkingsdashboard begint met een datamodel dat scheidt wat je bedoelt te automatiseren van wat daadwerkelijk recent heeft gedraaid. Als je die mengt, lijken je cijfers goed terwijl de automatisering verouderd is.

Begin met deze bouwstenen:

Kies één primair rapportageniveau en houd je daaraan:

Je kunt later meerdere views ondersteunen, maar je eerste versie moet één “bron van waarheid”-niveau hebben.

Gebruik ID’s die refactors overleven:

Behandel weergavenamen als bewerkbaar, niet als identifiers.

Een praktisch patroon:

Hiermee kun je vragen beantwoorden als: “Wat zou gedekt moeten zijn?”, “Wat claimt dekking?” en “Wat draaide er echt?”

Leg vast:

last_seen_at (asset bestaat nog)last_run_at, last_failure_atlast_reviewed_at (iemand bevestigde dat de claim nog geldig is)Versheidsvelden maken het makkelijk om “gedekt maar verouderd” items te markeren zonder discussie.

Als je dekkingsmetriek vaag is, wordt elk diagram een discussiepunt. Kies eerst één primaire metriek voor executive samenvattingen, en voeg daarna ondersteunende uitsplitsingen voor teams toe.

De meeste organisaties kiezen een van deze:

Je kunt alle drie tonen, maar maak expliciet welke de “headline” is.

Schrijf expliciete regels zodat teams items consistent scoren:

Houd regels meetbaar. Als twee mensen hetzelfde item niet hetzelfde kunnen scoren, verfijn dan de definitie.

Gebruik kleine gehele schalen (1–5) voor inputs zoals risico, zakelijke impact, draai-frequentie en tijdswinst. Voorbeeld: weight = risk + impact + frequency.

Tel een item niet als “geautomatiseerd” tenzij er bewijs is, zoals:

Dit maakt van dekking geen zelf-gerapporteerde claim maar een observeerbaar signaal.

Plaats de scoringsregels en voorbeelden op één gedeelde pagina (link deze vanaf het dashboard). Consistente interpretatie is wat trends betrouwbaar maakt.

Een interne automatiseringsdekkings-app moet in de beste zin saai zijn: gemakkelijk te beheren, eenvoudig aan te passen en duidelijk over waar cijfers vandaan komen. Een eenvoudige “API + database + dashboard” structuur verslaat meestal een verdeeld systeem totdat je het echt nodig hebt.

Kies een stack die je team al ondersteunt. Een veelvoorkomend basisvoorbeeld:

Als je sneller wil bewegen voor de eerste interne versie, kan een vibe-coding-benadering goed werken: bijvoorbeeld Koder.ai kan helpen een React-dashboard plus een Go + PostgreSQL-backend te genereren vanaf een gestructureerde specificatie, en je team daarna via chat te laten itereren terwijl je volledige broncode-export en conventionele deployment behoudt.

Zelfs in een “simpel” systeem scheid je verantwoordelijkheden:

Gebruik relationele tabellen voor canonieke entiteiten (teams, services, automatiseringen, bewijs, eigenaren). Voor trends (runs in de tijd, dekking over weken) houd je óf:

Als meerdere teams de app delen, voeg vroege org_id/team_id-velden toe. Dit maakt permissies mogelijk en voorkomt lastige migraties later wanneer het management vraagt om “één dashboard, maar gesegmenteerd.”

Draai dev/staging/prod en definieer hoe data beweegt:

Voor meer over een makkelijk navigeerbare UI, zie /blog/design-dashboard-ux.

Een dekkingsdashboard wordt snel een bron van waarheid, dus toegangscontrole en dataverwerking zijn net zo belangrijk als de grafieken. Begin simpel, maar ontwerp zo dat security strenger kan worden zonder grote herschrijvingen.

Als je bedrijf al SSO heeft, integreer dat vanaf dag één (OIDC is vaak het makkelijkst; SAML is gebruikelijker in grotere organisaties). Heb je een snelle interne release nodig, dan kun je starten achter een interne auth-proxy die identity-headers injecteert en later wisselen naar native SSO.

Normaliseer identiteit naar een stabiele user-key (e-mail kan veranderen). Bewaar een minimaal gebruikersprofiel en haal groeps-/teamlidmaatschap op aanvraag op wanneer mogelijk.

Definieer een klein aantal rollen en houd autorisatie consistent over UI en API:

Geef de voorkeur aan scope-gebaseerde permissies (per team/service) boven “super users”. Dat vermindert risico en voorkomt bottlenecks.

Bewijs voor dekking bevat vaak links naar CI-logs, incidenttickets of interne docs. Beperk toegang tot die URL’s en ruwe logs. Sla alleen op wat nodig is voor verificatie (bijv. een build-ID, tijdstempel en korte status-samenvatting) in plaats van volledige logs in je database te kopiëren.

Elke handmatige wijziging aan coverage-claims of metadata moet een auditrecord creëren: wie wijzigde wat, wanneer en waarom (vrije-tekst reden). Stel ten slotte een retentiebeleid in voor runhistorie en bewijs—bepaal hoe lang je het bewaart en implementeer veilige purges zodat oude records verwijderd kunnen worden zonder huidige dekkingberekeningen te breken.

Een dekkingsdashboard slaagt als iemand drie vragen in minder dan een minuut kan beantwoorden: Hoe doen we het? Wat verandert er? Wat moeten we als volgende repareren? Ontwerp de UX rond die beslissingen, niet rond de datasources.

Maak het eerste scherm een eenvoudige overzichtspagina:

Houd labels in gewone taal (“Recent geautomatiseerd” is beter dan “Evidence recency”) en dwing lezers niet technische statussen te interpreteren.

Vanaf elk overzichtsmetric laat je gebruikers doorklikken naar een service-/procespagina die antwoord geeft op “wat” en “waarmee”:

Ontwerp elke rij/card zo dat de “waarom achter het nummer” zichtbaar is: bewijslink, eigenaar, laatste run-status en een duidelijk volgende actie (“Run job opnieuw”, “Wijs eigenaar toe”, “Voeg ontbrekend bewijs toe”).

Bied filters die overeenkomen met hoe de organisatie werkt:

Houd filterstatus zichtbaar en deelbaar (URL-parameters), zodat iemand een link kan sturen zoals “Prod + Tier-1 + laatste 14 dagen” naar een stakeholder.

Gebruik inline-definities, geen lange documentatie:

Integraties zijn waar je dekking-app echt wordt. Het doel is niet elk kenmerk van je CI- of testtools te spiegelen—maar een consistente set feiten te extraheren: wat draaide, wanneer het draaide, wat het dekte en wie het bezit.

Begin met systemen die al automatiseringssignalen produceren: CI (GitHub Actions, GitLab CI, Jenkins), testrunners (JUnit, pytest) en kwaliteitsinstrumenten (coverage-rapporten, linters, security-scans).

Een connector moet de minimale payload ophalen (of ontvangen via webhook):

Houd connectors idempotent: herhaalde pulls mogen geen duplicaten aanmaken.

Sommige dekkinggaten zijn intentioneel (legacy-systemen, derde-partijrestricties, gepauzeerde initiatieven). Voorzie in een lichte “exception”-record die vereist:

Dit voorkomt permanente blinde vlekken en houdt leiderschapsperspectieven eerlijk.

Verschillende bronnen zijn zelden het eens over identifiers: het ene systeem zegt “payments-service”, een andere “payments” en een derde gebruikt een repo-slug.

Maak normalisatieregels voor:

Doe dit vroeg; elke downstream-metriek hangt ervan af.

Voeg alias-tabellen toe (bijv. service_aliases, repo_aliases) die veel externe namen aan één canonieke entiteit koppelen. Wanneer nieuwe data binnenkomt, match eerst tegen canonieke IDs en daarna tegen aliassen.

Als een nieuwe naam niet matcht, genereer merge-suggesties (bijv. “payments-api” lijkt op “payments-service”) voor een admin om goed te keuren.

Plan een terugkerende job die de laatste run-tijdstempel per bron controleert en alles flagt dat verouderd is (bijv. geen CI-runs in 7 dagen). Toon dit in de UI zodat lage dekking niet verward wordt met ontbrekende data.

Een dashboard is nuttig, maar waarschuwingen en lichte workflows zijn wat interessante data in gestage verbetering veranderen. Het doel is eenvoudig: notify de juiste mensen op het juiste moment, met genoeg context om te handelen.

Begin met een kleine set hoog-signaal-waarschuwingen:

Elke waarschuwing moet direct linken naar de relevante drilldown-view (bijv. /services/payments?tab=coverage of /teams/platform?tab=owners) zodat mensen niet hoeven te zoeken.

Vermijd one-size-fits-all drempels. Laat teams regels instellen zoals:

Dit houdt signalen betekenisvol en vermindert alert-fatigue.

Stuur waarschuwingen naar bestaande kanalen (e-mail en Slack) en vermeld: wat veranderde, waarom het belangrijk is en wie de eigenaar is. Naast realtime waarschuwingen, voeg een wekelijkse samenvatting toe met:

Behandel waarschuwingen als taken: sta erkenning, toewijzing en status (open/triaged/opgelost) toe. Een korte commentaartoevoeging (“gefixet in PR #1234”) maakt rapportage geloofwaardig en voorkomt dat dezelfde issues stilletjes terugkomen.

Een monitoringdashboard voelt snel wanneer de API de vragen beantwoordt die de UI echt stelt—zonder de browser te dwingen tientallen calls samen te voegen. Begin met een minimale, dashboard-eerst API-surface en voeg achtergrondjobs toe om alles duurs vooraf te berekenen.

Houd de eerste versie gefocust op de kernschermen:

GET /api/services (filters zoals team, taal, tier)GET /api/services/{id}/coverage (algemene score + belangrijke uitsplitsingen)GET /api/services/{id}/evidence?status=passed&since=...PATCH /api/services/{id}Ontwerp responses zodat het dashboard direct kan renderen: include service-naam, owner, laatste bewijs-tijd en huidige score in één payload in plaats van extra lookups te vereisen.

Lijsten en drilldown-tabellen moeten altijd gepagineerd zijn (limit + cursor). Voor veelgebruikte endpoints voeg caching toe op API-laag (of een gedeelde cache) keyed op filters en de access-scope van de caller.

Voor alles wat veel bewijs moet scannen (bijv. “dekking per team”), precompute rollups in een nachtelijke job. Sla rollups op in een aparte tabel (of materialized view) zodat reads simpel en voorspelbaar zijn.

Trends zijn het makkelijkst als je dagelijkse snapshots opslaat:

GET /api/services/{id}/trend?days=90.Snapshots voorkomen dat historische metrics op elke pageload opnieuw berekend moeten worden en maken “versheid” (hoe recent bewijs draaide) makkelijk te plotten.

Bulk-onboarding verloopt soepeler met:

POST /api/import/services (CSV-upload)GET /api/export/services.csvVoer validatieregels af bij writes: verplichte owner, toegestane statuswaarden en zinnige tijdstempels (geen “toekomst” bewijs). Het vroeg af wijzen van slechte data voorkomt trage, verwarrende fixes later—vooral zodra rollups afhankelijk zijn van consistente inputs.

Een dekkingsdashboard is alleen nuttig als mensen het vertrouwen. Behandel deployment en operatie als onderdeel van het product: voorspelbare releases, duidelijke health-signalen en eenvoudige herstelstappen als iets misgaat.

Voor een interne app optimaliseer je voor lage overhead en snelle iteratie.

Als je een platform zoals Koder.ai gebruikt om ontwikkeling te versnellen, maak vroeg gebruik van source-code-export en deployment/workflowfuncties zodat je interne app nog steeds standaard promotie-, review- en rollbackpraktijken volgt.

Je hebt geen complexe stack nodig om betrouwbare signalen te krijgen.

Zet geautomatiseerde databasebackups en een retentiebeleid op dat bij je behoeften past.

Documenteer runbooks voor:

Een beetje operationele discipline voorkomt dat “dekking” in giswerk verandert.

Een monitoring-app helpt alleen als teams het vertrouwen en gebruiken. Behandel rollout als een productlancering: begin klein, definieer duidelijk eigenaarschap en bouw een voorspelbaar ritme voor updates in.

Houd onboarding licht en herhaalbaar:

Een goed doel is “eerste dashboardweergave binnen 30 minuten”, niet een weeklange configuratieklus.

Stel twee ritmes vast:

Dekkingsscores kunnen politiek worden als regels onverwacht veranderen. Definieer een kleine governancegroep (vaak Eng Productivity + Security/Quality) die kan:

Publiceer wijzigingen in een eenvoudige changelog-pagina zoals /docs/scoring-changelog.

Volg adoptie met een paar eenvoudige metrics: actieve gebruikers, services gevolgd en frisheidscompliance (hoeveel services up-to-date bewijs hebben). Gebruik deze om iteraties te sturen: betere weging, rijkere bewijstypes en extra connectors—altijd prioriterend wat handmatig werk voor teams vermindert.

Als je besluit je interne lessen publiek te delen, overweeg je je bouwnotities en sjablonen te standaardiseren: teams die Koder.ai gebruiken kunnen ook credits verdienen door content over hun ontwikkelworkflow te maken of collega’s te verwijzen, wat kan helpen de doorontwikkeling van interne tooling te financieren.

Automatiseringsdekking is wat je organisatie definieert als “werk dat automatisch wordt afgehandeld” versus handmatig. Om verwarring te voorkomen, kies een primaire eenheid voor v1 (bijvoorbeeld: processen, vereisten/controles, testsuites of runbooks) en leg duidelijke regels vast voor randgevallen zoals “gedeeltelijk geautomatiseerde” stappen die nog goedkeuringen nodig hebben.

Een goede definitie is er een waarbij twee mensen hetzelfde item op dezelfde manier zouden scoren.

Begin met het opschrijven van 5–10 “belangrijkste vragen” die je gebruikers beantwoord willen zien en behandel die als productvereisten. Veelvoorkomende voorbeelden:

Verschillende doelgroepen (QA, Ops, leiding) hebben verschillende doorsnedes nodig, dus bepaal voor wie v1 is geoptimaliseerd.

Maak een inventarisatie van waar “bewijs” van automatisering staat en van waar de gezaghebbende lijst van wat er zou moeten zijn vandaan komt.

Zonder een systeem van registratie kun je activiteit tellen, maar niet betrouwbaar dekking berekenen (omdat je de volledige set doelen niet kent).

Kies per bron de minst fragiele methode:

Documenteer ook connectorbeperkingen (rate limits, auth, retentiewindows) zodat gebruikers datafrisheid en vertrouwen begrijpen.

Scheid intentie, claims en bewijs zodat metrics niet “groen” lijken terwijl automatisering verouderd is.

Een praktisch model:

Gebruik versheidstimestamps en bewijsregels.

Veelgebruikte velden:

last_seen_at (asset bestaat nog)last_run_at, last_failure_atlast_reviewed_at (iemand bevestigde dat de claim nog geldt)Handhaaf vervolgens een regel zoals “wordt als geautomatiseerd gerekend alleen als er N succesvolle runs in de laatste 30 dagen zijn.” Dit onderscheidt “bestaat” van “werkt recent”.

Kies één headline-metric en maak de scoringsregels expliciet.

Typische headline-opties:

Houd gewichten eenvoudig (bijv. 1–5) en documenteer wat “geautomatiseerd / gedeeltelijk / handmatig” betekent met concrete voorbeelden.

Normaliseer identifiers vroeg en behandel hernoemingen expliciet.

Praktische stappen:

service_aliases, repo_aliases) om externe namen naar één canonieke ID te mappen.Dit voorkomt duplicaten en houdt historische trends intact wanneer teams reorganiseren of repos hernoemen.

Begin met SSO (OIDC/SAML) als dat beschikbaar is, of gebruik tijdelijk een intern auth-proxy die identity-headers injecteert. Definieer een kleine set rollen en houd autorisaties consistent over UI en API:

Bewaar minimale gevoelige bewijsgegevens: geef de voorkeur aan build-IDs, tijdstempels en korte samenvattingen in plaats van volledige logs. Audit handmatige aanpassingen (wie/wat/wanneer/waarom) en definieer retentie voor runhistorie.

Maak waarschuwingen actiegericht en vermijd globale ruis.

Hoog-signaal-waarschuwingstypes:

Laat drempels variëren per team/service (verschillende “stale windows” en pagingregels). Voeg diepe links toe naar drilldown-pagina’s (bijv. /services/payments?tab=coverage) en ondersteun erkenning/toewijzing/status zodat problemen netjes kunnen worden afgesloten.

Voeg eigenaarschap (team/persoon) en stabiele identifiers toe zodat hernoemingen de geschiedenis niet breken.