Waarom Shannon nog steeds relevant is voor alledaagse technologie

Je gebruikt Claude Shannon’s ideeën elke keer dat je een sms verstuurt, een video kijkt of verbinding maakt met Wi‑Fi. Niet omdat je telefoon “Shannon kent”, maar omdat moderne digitale systemen zijn gebouwd rond een eenvoudige belofte: we kunnen rommelige echte berichten omzetten in bits, die bits via imperfecte kanalen verplaatsen en toch de originele inhoud met hoge betrouwbaarheid terugkrijgen.

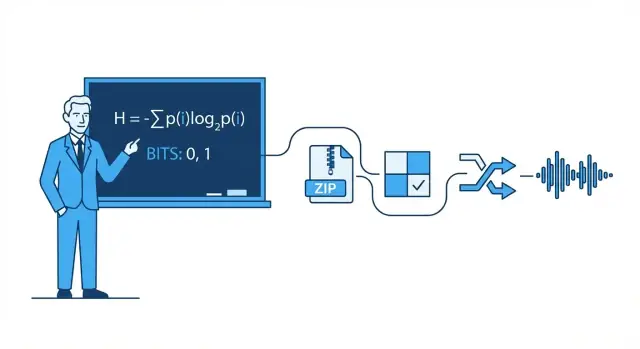

Informatietheorie is de wiskunde van berichten: hoeveel keuze (onzekerheid) een bericht bevat, hoe efficiënt het kan worden weergegeven en hoe betrouwbaar het kan worden verzonden als ruis, interferentie en congestie in de weg zitten.

Er zit wiskunde achter, maar je hoeft geen wiskundige te zijn om de praktische intuïtie te begrijpen. We gebruiken alledaagse voorbeelden—zoals waarom sommige foto’s beter comprimeren dan andere, of waarom je gesprek nog goed kan klinken bij een zwak signaal—om de ideeën uit te leggen zonder zware formules.

De vier pijlers die je overal ziet

Dit artikel draait om vier Shannon‑geïnspireerde pijlers die in moderne technologie terugkomen:

- Compressie: data (audio, video, bestanden) kleiner maken zonder te verliezen wat belangrijk is.

- Foutcorrectie: precies genoeg extra bits toevoegen zodat fouten kunnen worden gedetecteerd en hersteld.

- Netwerkbetrouwbaarheid: omgaan met verloren pakketten via retries, ordening en doorvoersafwegingen.

- End‑to‑end digitale communicatie: de hele keten zien van bron (jouw bericht) naar kanaal (Wi‑Fi, mobiel, glasvezel) en weer terug.

Waar je na het lezen over kunt nadenken

Aan het einde kun je helder nadenken over echte afwegingen: waarom hogere videokwaliteit meer bandbreedte vraagt, waarom meer balkjes niet altijd sneller internet betekenen, waarom sommige apps direct aanvoelen terwijl andere bufferen, en waarom elk systeem grenzen heeft—vooral de beroemde Shannon‑limiet voor hoeveel betrouwbare data een kanaal kan dragen.

Claude Shannon in één pagina: het grote idee

In 1948 publiceerde wiskundige en ingenieur Claude Shannon een artikel met een onopvallende titel—A Mathematical Theory of Communication—dat stilletjes onze manier van denken over gegevensversturing veranderde. In plaats van communicatie als kunst te zien, behandelde hij het als een ingenieursprobleem: een bron produceert berichten, een kanaal draagt ze, ruis corrumpeert ze en een ontvanger probeert te reconstrueren wat er werd verzonden.

Shannon’s kernstap was om informatie te definiëren op een manier die meetbaar en bruikbaar is voor machines. In zijn model gaat informatie niet over hoe belangrijk een bericht aanvoelt, wat het betekent of of het waar is. Het gaat over hoe verrassend het is—hoeveel onzekerheid verdwijnt als je de uitkomst leert.

Als je al weet wat er gaat gebeuren, draagt het bericht bijna geen informatie. Als je echt onzeker was, draagt de uitkomst meer.

De bit: de eenvoudigste eenheid die je kunt tellen

Om informatie te meten populariseerde Shannon de bit (afkorting van binary digit). Een bit is de hoeveelheid informatie die nodig is om een eenvoudige ja/nee‑onzekerheid op te lossen.

Voorbeeld: als ik vraag “Is het licht aan?” en je hebt van tevoren geen idee, dan levert het antwoord (ja of nee) 1 bit informatie op. Veel echte berichten kunnen worden opgebroken in lange reeksen van deze binaire keuzes, daarom kunnen tekst, foto’s en audio worden opgeslagen en verzonden als bits.

Wat dit bericht wél en niet doet

Dit artikel richt zich op de praktische intuïtie achter Shannon’s ideeën en waarom ze overal voorkomen: compressie (bestanden kleiner maken), foutcorrectie (corruptie herstellen), netwerkbetrouwbaarheid (retries en doorvoer) en kanaalcapaciteit (hoe snel je data over een ruisende verbinding kunt sturen).

Wat het niet doet, is door zware bewijzen lopen. Je hebt geen gevorderde wiskunde nodig om de kern te begrijpen: zodra je informatie kunt meten, kun je systemen ontwerpen die de best mogelijke efficiëntie benaderen—vaak verrassend dicht bij de theoretische limieten die Shannon beschreef.

Bits, symbolen en codes: een praktisch vocabulaire

Voordat we over entropie, compressie of foutcorrectie praten, helpt het om een paar alledaagse termen vast te leggen. Shannon’s ideeën zijn makkelijker als je de onderdelen kunt benoemen.

Symbolen, alfabet en berichten

Een symbool is één “token” uit een afgesproken set. Die set is het alfabet. In Engelse tekst kan het alfabet letters (plus spatie en interpunctie) zijn. In een bestand kan het alfabet bytewaarden 0–255 zijn.

Een bericht is een reeks symbolen uit dat alfabet: een woord, een zin, een fotobestand of een stroom van audio‑samples.

Om het concreet te houden, stel je een klein alfabet voor: {A, B, C}. Een bericht kan zijn:

A A B C A B A ...

Bits en codes

Een bit is een binair cijfer: 0 of 1. Computers slaan bits op en versturen ze omdat hardware betrouwbaar twee toestanden kan onderscheiden.

Een code is een regel om symbolen in bits (of andere symbolen) te representeren. Voor ons {A, B, C}‑alfabet is één mogelijke binaire code:

Nu kan elk bericht van A/B/C worden vertaald naar een stroom bits.

Codering versus compressie versus encryptie

Deze termen worden vaak door elkaar gehaald:

- Codering: data vertalen naar een gekozen formaat zodat het kan worden opgeslagen/verzonden/verwerkt (zoals A/B/C naar bits mappen, of tekst naar UTF‑8).

- Compressie: codering die gemiddeld minder bits gebruikt door patronen en ongelijke frequenties te benutten.

- Encryptie: data versleutelen met een sleutel zodat buitenstaanders het niet kunnen lezen; het gaat om geheimhouding, niet om grootte.

Een korte waarschijnlijkheidsintuïtie

Echte berichten zijn niet willekeurig: sommige symbolen komen vaker voor dan andere. Stel dat A 70% van de tijd voorkomt, B 20%, C 10%. Een goede compressiemethode geeft doorgaans kortere bitpatronen aan veelvoorkomende symbolen (A) en langere aan zeldzame (C). Die ongelijkheid is wat entropie later kwantificeert.

Entropie: verrassing meten (en waarom het compressibiliteit voorspelt)

Shannon’s beroemdste idee is entropie: een manier om te meten hoeveel “verrassing” er in een informatiebron zit. Niet verrassing als emotie—verrassing als onvoorspelbaarheid. Hoe onvoorspelbaarder het volgende symbool, hoe meer informatie het brengt als het arriveert.

Entropie als “gemiddelde verrassing”

Stel dat je naar muntworpen kijkt.

- Eerlijke munt (50/50 kop of munt): elke worp is lastig te voorspellen. Kop en munt zijn even waarschijnlijk, dus je wordt regelmatig “verrast”. Dat hoge onvoorspelbaarheid betekent hogere entropie.

- Geknopeerde munt (bijv. 95% kop, 5% munt): de meeste worpen zijn kop. Na een paar worpen ga je kop verwachten, dus kop levert weinig nieuwe informatie. Alleen de zeldzame munt is verrassend. Gemiddeld heeft de reeks lagere entropie.

Deze “gemiddelde verrassing”‑benadering sluit aan bij alledaagse patronen: een tekstbestand met herhaalde spaties en veelvoorkomende woorden is makkelijker te voorspellen dan een bestand met willekeurige tekens.

Waarom voorspelbaarheid compressibiliteit impliceert

Compressie werkt door kortere codes aan voorkomende symbolen te toewijzen en langere aan zeldzame. Als de bron voorspelbaar is (lage entropie), kun je vaak korte codes gebruiken en veel ruimte besparen. Is het vrijwel willekeurig (hoge entropie), dan valt er weinig te winnen omdat niets vaak genoeg voorkomt om uit te buiten.

Entropie en de beste mogelijke gemiddelde codelengte

Shannon toonde aan dat entropie een conceptuele ondergrens is: het is de beste mogelijke lagere grens voor het gemiddelde aantal bits per symbool dat je kunt bereiken bij het coderen van data uit die bron.

Belangrijk: entropie is geen compressiealgoritme. Het vertelt je niet precies hoe je een bestand moet comprimeren. Het vertelt je wat theoretisch mogelijk is—en wanneer je al dicht bij die grens zit.

Compressie: entropie omzetten in kleinere bestanden

Compressie is wat er gebeurt als je een bericht dat in minder bits beschreven kan worden, daadwerkelijk kleiner maakt. Shannon’s kerninzicht is dat data met lagere entropie (meer voorspelbaarheid) “ruimte” heeft om te krimpen, terwijl data met hoge entropie dat meestal niet heeft.

Waarom patronen en ongelijke frequenties goed comprimeren

Herhaalde patronen zijn de voor de hand liggende winst: als een bestand steeds dezelfde reeksen bevat, kun je die sequentie één keer opslaan en er veel naar verwijzen. Maar zelfs zonder duidelijke herhalingen helpt scheve symboolverdeling.

Als in tekst de “e” veel vaker voorkomt dan “z”, of een logbestand herhaaldelijk dezelfde timestamps en trefwoorden bevat, hoef je niet evenveel bits aan elk teken te geven. Hoe ongelijker de frequenties, hoe voorspelbaarder de bron—en hoe beter de compressie.

Variabele‑lengte codering (de kernintuïtie)

Een praktische manier om ongelijkmatige frequenties te benutten is variabele‑lengte codering:

- Frequente symbolen krijgen korte codes

- Zeldzame symbolen krijgen lange codes

Goed uitgevoerd verlaagt dit het gemiddelde aantal bits per symbool zonder informatie te verliezen.

Veel lossless‑compressoren combineren meerdere ideeën, maar je hoort vaak van deze families:

- Huffman‑codering: bouwt een efficiënte “kort‑voor‑veel” codeboek

- Aritmetische codering: pakt symbolen in een fractioneel bereik en komt vaak dichter bij de entropiegrens

- LZ (Lempel–Ziv): vindt herhaalde substrings en vervangt ze door referenties (gebruikt in veel ZIP‑achtige formaten)

Lossless versus lossy (ZIP versus JPEG/MP3)

Lossless compressie reproduceert het origineel perfect (bijv. ZIP, PNG). Het is essentieel voor software, documenten en alles waar één fout bit problemen geeft.

Lossy compressie gooit opzettelijk informatie weg die mensen meestal niet opmerken (bijv. JPEG voor foto’s, MP3/AAC voor audio). Het doel verschuift van “exact dezelfde bits terug” naar “dezelfde ervaring”, en levert vaak veel kleinere bestanden door perceptueel onbelangrijke details te verwijderen.

Fouten gebeuren: waarom redundantie nuttig is

Ontdek compressibiliteit

Maak een telemetry‑ of loggingflow en test wat in de praktijk goed comprimeert.

Elk digitaal systeem rust op een fragiele aanname: een 0 blijft een 0 en een 1 blijft een 1. In werkelijkheid kunnen bits flippen.

Waar fouten vandaan komen

Bij overdracht kan elektrische interferentie, zwakke Wi‑Fi of radiosignaal een signaal net genoeg verstoren zodat de ontvanger het verkeerd interpreteert. Bij opslag kunnen kleine fysieke effecten—slijtage in flashgeheugen, krassen op optische media, zelfs kosmische straling—een opgeslagen lading of magnetische staat veranderen.

Omdat fouten onvermijdelijk zijn, voegen ingenieurs opzettelijk redundantie toe: extra bits die geen “nieuwe” informatie dragen, maar helpen schade te detecteren of te herstellen.

Eenvoudige redundantie die je al gebruikt hebt

Pariteitsbit (snelle detectie). Voeg één extra bit toe zodat het totaal aantal enen even (even parity) of oneven (odd parity) is. Als één bit flippt, faalt de pariteitscontrole.

- Sterkte: goedkoop en snel.

- Beperking: vaak kan het niet zeggen welk bit fout is, en twee flips kunnen elkaar opheffen en toch “goed” lijken.

Checksum (betere detectie per blok). In plaats van één bit bereken je een klein samenvattend getal van een pakket of bestand (bijv. additive checksum, CRC). De ontvanger rekent opnieuw en vergelijkt.

- Sterkte: vangt veel multi‑bit fouten in een blok.

- Beperking: meestal alleen detectie; bij falen heb je meestal een retry of back‑up nodig.

Repetitiewijze (eenvoudige correctie). Verstuur elke bit drie keer: 0 wordt 000, 1 wordt 111. De ontvanger neemt een meerderheidsstem.

- Sterkte: kan één geflipte bit per groep van drie corrigeren.

- Beperking: extreem inefficiënt—drievoudigt de data.

Detectie versus correctie (en wanneer je elk gebruikt)

Foutdetectie beantwoordt: “Is er iets misgegaan?” Het is gebruikelijk wanneer opnieuw verzenden goedkoop is—zoals netwerkpakketten die opnieuw kunnen worden gestuurd.

Foutcorrectie beantwoordt: “Wat waren de originele bits?” Het wordt gebruikt wanneer hertransmissie duur of onmogelijk is—zoals streaming audio over een ruisige link, diepe‑ruimtecommunicatie of lezen uit opslag waar opnieuw lezen nog steeds fouten kan geven.

Redundantie lijkt vervelend, maar het is de reden dat moderne systemen snel en betrouwbaar kunnen zijn ondanks imperfecte hardware en ruisende kanalen.

Kanaalcapaciteit en de Shannon‑limiet (geen zware wiskunde)

Als je data over een echt kanaal verstuurt—Wi‑Fi, mobiel, USB, of een schijf—kunnen ruis en interferentie bits flippen of symbolen vervagen. Shannon’s grote belofte was verrassend: betrouwbare communicatie is mogelijk, zelfs over ruisende kanalen, zolang je niet te veel informatie probeert te persen.

Kanaalcapaciteit in gewone taal

Kanaalcapaciteit is de “snelheidslimiet” van een kanaal: de maximale snelheid (bits per seconde) die je kunt verzenden met fouten die naar nul gedreven kunnen worden, gegeven de ruis en beperkingen zoals bandbreedte en vermogen.

Het is niet hetzelfde als de ruwe symbolensnelheid (hoe snel je een signaal wisselt). Het gaat om hoeveel betekenisvolle informatie overblijft na ruis—als je slimme codering, redundantie en decodering toepast.

De Shannon‑limiet: een grens om naartoe te streven

De Shannon‑limiet is de praktische naam voor deze grens: eronder kun je (in theorie) communicatie zo betrouwbaar maken als je wilt; erboven kun je dat niet—fouten blijven bestaan, wat je ook doet.

Ingenieurs werken hard om dichter bij die grens te komen met betere modulatie en foutcorrelerende codes. Moderne systemen zoals LTE/5G en Wi‑Fi gebruiken geavanceerde codering zodat ze dichtbij die grens opereren in plaats van enorme hoeveelheden signaalvermogen of bandbreedte te verspillen.

De kernafweging (snelheid versus foutkans)

Denk aan het inpakken van spullen in een vrachtwagen op een hobbelige weg:

- Pak je te vol (snelheid boven capaciteit), dan breken spullen altijd wel een beetje (een niet‑nul foutkans).

- Pak je met ruimte en padding (snelheid onder capaciteit), dan kun je breuk zo zeldzaam maken als je wilt—ten koste van lagere doorvoer of meer redundantie.

Shannon gaf ons geen enkel “beste code”, maar bewees dat de grens bestaat—en dat het de moeite loont ernaar te streven.

Foutcorrigerende codes in echte systemen

Meet mobiele prestaties

Prototypeer een Flutter‑client om te zien hoe zwakke signalen UX en buffering beïnvloeden.

Shannon’s noisy‑channel‑theorema is vaak samengevat als een belofte: als je onder de kanaalcapaciteit zendt, bestaan er codes die fouten uiterst zeldzaam maken. Echte engineering draait om het omzetten van dat “existence proof” naar praktische schema’s die in chips, batterijen en deadlines passen.

De praktische gereedschapskist: blokken, interleaving en betere schattingen

De meeste systemen gebruiken blokcodes (bescherm een stuk bits tegelijk) of stream‑codes (bescherm een doorlopende stroom).

Met blokcodes voeg je zorgvuldig ontworpen redundantie toe aan elk blok zodat de ontvanger fouten kan detecteren en corrigeren. Met interleaving herschik je de volgorde van verzonden bits/symbolen zodat een ruisuitbarsting (veel fouten achter elkaar) verspreid wordt tot kleinere, corrigeerbare fouten over meerdere blokken—cruciaal voor draadloos en opslag.

Een andere belangrijke scheidslijn is hoe de ontvanger “besluit” wat hij gehoord heeft:

- Hard decisions: elk ontvangen signaal wordt meteen een 0 of 1.

- Soft decisions: de ontvanger houdt ook vertrouwen (bijv. “dit is waarschijnlijk een 1, maar niet zeker”).

Soft decisions geven de decoder meer informatie en kunnen de betrouwbaarheid flink verbeteren, vooral in Wi‑Fi en mobiele systemen.

Codes die je al gebruikt hebt

- Reed–Solomon: werkt op symbolen (niet op individuele bits) en is uitstekend tegen burst‑fouten. Gebruikt in QR‑codes, CD/DVD en sommige broadcast/opslag systemen.

- Convolutionele codes: klassieke keuze voor continue stromen; historisch veel gebruikt in satellietverbindingen.

- Turbo codes: een grote sprong in de jaren ’90, veel gebruikt in 3G/4G.

- LDPC (Low‑Density Parity‑Check): zeer efficiënte moderne blokcodes gebruikt in Wi‑Fi, 5G en veel high‑throughput systemen.

Waar ze ertoe doen

Van diepe‑ruimtecommunicatie (waar hertransmissie duur of onmogelijk is) tot satellieten, Wi‑Fi en 5G, foutcorrigerende codes zijn de praktische brug tussen Shannon’s theorie en de realiteit van ruisende kanalen—je ruilt extra bits en rekenwerk in voor minder weggevallen gesprekken, snellere downloads en betrouwbaardere verbindingen.

Netwerkbetrouwbaarheid: pakketten, retries en doorvoer

Het internet werkt ondanks imperfecte individuele verbindingen. Wi‑Fi vervaagt, mobiele signalen worden geblokkeerd en zelfs koper en glasvezel hebben af en toe ruis of fouten. Shannon’s kernboodschap—ruis is onvermijdelijk, maar betrouwbaarheid is haalbaar—verschijnt in netwerken als een mix van foutdetectie/-correctie en hertransmissie.

Pakketten: kleine weddenschappen in plaats van één grote

Data wordt opgesplitst in pakketten zodat het netwerk rond problemen kan routeren en verliezen kan herstellen zonder alles opnieuw te sturen. Elk pakket draagt extra bits (headers en checks) die de ontvanger helpen beslissen of wat aangekomen is betrouwbaar is.

Een veelgebruikt patroon is ARQ (Automatic Repeat reQuest):

- De ontvanger controleert een pakket (vaak met een checksum/CRC).

- Als het goed lijkt, stuurt hij een bevestiging (ACK).

- Als het ontbreekt of corrupt is, stuurt de zender het opnieuw na een timeout (of na een negatieve bevestiging).

Corrigeren versus opnieuw verzenden: de latentieafweging

Als een pakket fout is, heb je twee hoofdkeuzes:

- Corrigeer het nu met forward error correction (FEC): voeg genoeg redundantie toe zodat de ontvanger fouten zonder hertransmissie kan herstellen.

- Herstuur met ARQ: stuur minder redundantie upfront, maar betaal extra tijd als er iets misgaat.

FEC kan vertraging verminderen op verbindingen waar hertransmissies duur zijn (hoge latentie, intermitterend verlies). ARQ is efficiënt wanneer verliezen zeldzaam zijn, omdat je niet elke keer veel redundantie hoeft mee te sturen.

Doorvoer, congestie en waarom betrouwbaarheid niet gratis is

Betrouwbaarheidsmechanismen gebruiken capaciteit: extra bits, extra pakketten en extra wachten. Hertransmissies verhogen de belasting, wat congestie kan verergeren; congestie verhoogt op zijn beurt vertraging en verlies, wat weer meer retries triggert.

Goed netwerkontwerp zoekt een balans: genoeg betrouwbaarheid om correcte data te leveren, terwijl overhead laag genoeg blijft zodat het netwerk gezonde doorvoer houdt onder wisselende omstandigheden.

Digitale communicatie end‑to‑end: van bron naar kanaal

Een nuttige manier om moderne digitale systemen te begrijpen is als een pijplijn met twee taken: maak het bericht kleiner en zorg dat het de reis overleeft. Shannon’s belangrijke inzicht was dat je deze vaak als gescheiden lagen kunt bekijken—hoewel echte producten ze soms mengen.

Stap 1: source coding (compressie)

Je begint met een “bron”: tekst, audio, video, sensorgegevens. Source coding verwijdert voorspelbare structuur zodat je geen bits verspilt. Dat kan ZIP voor bestanden zijn, AAC/Opus voor audio of H.264/AV1 voor video.

Compressie is waar entropie in de praktijk verschijnt: hoe voorspelbaarder de inhoud, hoe minder bits je gemiddeld nodig hebt.

Stap 2: channel coding (foutcorrectie)

De gecomprimeerde bits moeten vervolgens een ruisend kanaal oversteken: Wi‑Fi, mobiel, glasvezel, USB. Channel coding voegt zorgvuldig ontworpen redundantie toe zodat de ontvanger fouten kan detecteren en corrigeren. Dit is het domein van CRC’s, Reed–Solomon, LDPC en andere forward error correction (FEC) methoden.

Shannon’s “scheiding”‑idee (een handig denkkader)

Shannon toonde aan dat je in theorie source coding kunt ontwerpen om de beste compressie te benaderen en channel coding om de beste betrouwbaarheid te benaderen tot aan de kanaalcapaciteit—ongeacht elkaar.

In de praktijk is die scheiding nog steeds een goed hulpmiddel om systemen te debuggen: als de prestaties slecht zijn, kun je nagaan of je efficiëntie verliest in compressie (source coding), betrouwbaarheid op de link (channel coding) of te veel latentie betaalt met retries en buffering.

Concreet voorbeeld: video streamen over Wi‑Fi

Bij streaming gebruikt de app een codec om frames te comprimeren. Over Wi‑Fi kunnen pakketten verloren of corrupt raken, dus het systeem voegt foutdetectie toe, soms FEC, en vervolgens retries (ARQ) wanneer nodig. Als de verbinding slechter wordt, kan de speler naar een lagere bitrate schakelen.

Echte systemen vervagen de scheiding omdat tijd ertoe doet: wachten op retries kan bufferen veroorzaken en draadloze condities veranderen snel. Daarom combineren streaming‑stacks compressiekeuzes, redundantie en adaptatie—niet perfect gescheiden, maar wel geleid door Shannon’s model.

Veelvoorkomende misverstanden en praktische afwegingen

Beheer de codebase

Exporteer de broncode wanneer je volledige controle over codecs, protocollen of infra wilt.

Informatietheorie wordt vaak aangehaald en sommige ideeën worden te simpel verteld. Hier een paar misverstanden—en de echte afwegingen die ingenieurs maken bij compressie, opslag en netwerken.

Misverstand 1: “Entropie betekent willekeur”

In alledaagse taal kan “willekeurig” “rommelig” of “onvoorspelbaar” betekenen. Shannon‑entropie is specifieker: het meet verrassing gegeven een waarschijnlijkheidsmodel.

- Een perfect voorspelbare stroom (zoals alle nullen) heeft lage entropie.

- Een stroom die moeilijk te voorspellen is gegeven wat je weet heeft hogere entropie.

Entropie is dus geen gevoel; het is een getal gekoppeld aan aannames over het gedrag van de bron.

Misverstand 2: “Meer compressie is altijd beter”

Compressie verwijdert redundantie. Foutcorrectie voegt vaak juist redundantie toe zodat de ontvanger kan herstellen.

Dat creëert een praktische spanning:

- Als je agressief comprimeert en dan over een ruisend kanaal stuurt, heb je mogelijk minder “spelruimte” om beschadiging te herstellen.

- Goed ontworpen systemen comprimeren eerst (verwijder voorspelbaarheid) en voegen daarna gestructureerde redundantie toe voor het kanaal.

Misverstand 3: “We kunnen perfect betrouwbaar zijn op elke snelheid”

Shannon’s kanaalcapaciteit zegt dat elk kanaal een maximale betrouwbare doorvoer heeft gegeven ruis. Onder die limiet kunnen foutkansen met de juiste codering extreem klein worden gemaakt; erboven zijn fouten onvermijdelijk.

Daarom is “perfect betrouwbaar bij elke snelheid” niet mogelijk: sneller sturen betekent meestal een hogere foutkans, hogere latentie (meer retransmissies) of meer overhead (sterkere codering).

Een eenvoudige checklist voor echte systemen

Bij het evalueren van een product of architectuur, vraag:

- Bronstatistieken: Is de data voorspelbaar (tekst, logs) of al bijna random (versleuteld, gecomprimeerd)?

- Ruis: Wat kan het corrumperen—draadloze interferentie, bitrot, pakketverlies?

- Latentiebudget: Kun je retries en buffering veroorloven, of moet het real‑time zijn?

- Overheadkeuze: Gebruik je bits voor compressiebesparing, foutcorrectie, retransmissies of een mix?

Deze vier goed krijgen is belangrijker dan formules uit je hoofd leren.

Belangrijkste conclusies en waar je verder kunt lezen

Shannon’s kernboodschap is dat informatie meetbaar, verplaatsbaar, beschermd en gecomprimeerd kan worden met een klein stel ideeën.

- Een bit is de gemeenschappelijke valuta die tekst, audio, video en sensordata gelijk behandelt zodra ze gecodeerd zijn.

- Entropie meet hoe onvoorspelbaar een bron is en voorspelt hoe goed data gecomprimeerd kan worden.

- Ruis en verlies zijn onvermijdelijk, dus betrouwbare systemen voegen redundantie toe via foutdetectie en foutcorrigerende codes.

- Kanaalcapaciteit zet een echte grens: boven een bepaalde snelheid kun je niet méér betrouwbaarheid afdwingen zonder van koers te veranderen.

Moderne netwerken en opslagsystemen draaien voortdurend om afwegingen tussen snelheid, betrouwbaarheid, latentie en rekenwerk.

Een praktisch advies voor makers

Als je echte producten bouwt—API’s, streamingfeatures, mobiele apps, telemetry‑pipelines—is Shannon’s raamwerk een nuttige ontwerplijst: comprimeer wat kan, bescherm wat moet en wees expliciet over latentie/doorvoerbudget. Dit zie je direct wanneer je snel end‑to‑end prototypeert en daarna iterereert: met een vibe‑coding platform zoals Koder.ai kunnen teams een React‑webapp, een Go‑backend met PostgreSQL en zelfs een Flutter‑mobile client opzetten vanuit een chatgestuurde specificatie, en vroeg echte afwegingen testen (payloadgrootte, retries, bufferinggedrag). Functies zoals planning mode, snapshots en rollback maken het makkelijker om te experimenteren met “sterkere betrouwbaarheid vs. lagere overhead” zonder momentum te verliezen.

Wie zou dieper moeten duiken

Diepere lectuur loont voor:

- Studenten die een helder mentaal model willen dat waarschijnlijkheid verbindt met compressie en codering

- Productmanagers die afwegingen maken tussen kwaliteit, latentie, bandbreedte en kosten

- Ingenieurs die werken aan netwerken, mediacodecs, opslag, telemetry of ML‑datapijplijnen

Om verder te gaan, verken gerelateerde explainers in /blog, bekijk /docs voor hoe ons product communicatie‑ en compressiegerelateerde instellingen en API’s blootlegt en vergelijk plannen of doorvoerlijsten op /pricing.