Waarom AI-gegenereerde code en automatisch gegenereerde tests bij elkaar horen

Door AI geschreven applicatielogica betekent dat de “werkende” delen van je codebase met hulp van een assistent worden opgesteld: nieuwe functies, kleine features, refactors, het afhandelen van randgevallen en zelfs herschrijvingen van bestaande modules. Jij bepaalt nog steeds wat er gebouwd wordt, maar de eerste versie van de implementatie komt vaak sneller—en soms met aannames die je pas later opmerkt.

Geautomatiseerde testgeneratie is de bijpassende capaciteit aan de verificatiekant. In plaats van elke test met de hand te schrijven, kunnen tools testcases en assertions voorstellen op basis van je code, een specificatie of patronen die uit eerdere bugs geleerd zijn. In de praktijk kan dat eruitzien als:

- “Gegeven deze functiesignatuur en takken, hier zijn tests die typische inputs, grenzen en foutpaden dekken.”

- “Hier zijn regressietests die de crash reproduceren die we in productie zagen.”

De belangrijkste verwachting: gegenereerde tests zijn niet automatisch “goed”

Een gegenereerde test kan misleidend zijn: hij kan het huidige gedrag asserten terwijl dat gedrag onjuist is, of hij kan productregels missen die in iemands hoofd of in tickets leven. Daarom blijft menselijke review belangrijk. Iemand moet bevestigen dat de testnaam, setup en assertions echte intentie weerspiegelen—niet alleen wat de code vandaag toevallig doet.

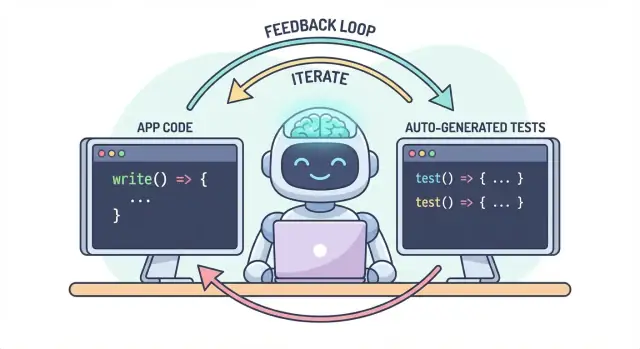

Eén workflow, twee outputs

Het kernidee is simpel: code en tests moeten samen evolueren als één workflow. Als AI je helpt logica snel te veranderen, helpt geautomatiseerde testgeneratie om het bedoelde gedrag net zo snel vast te leggen—zodat de volgende wijziging (mens of AI) een duidelijke, uitvoerbare definitie heeft van “blijft correct.”

In de praktijk is deze “gepaarde output”-aanpak makkelijker te onderhouden wanneer je ontwikkelproces al chatgestuurd is. Bijvoorbeeld bij Koder.ai (een vibe-coding platform om web-, backend- en mobiele apps via chat te bouwen) is het natuurlijk om “feature + tests” als één deliverable te behandelen: je beschrijft het gedrag, genereert de implementatie en genereert en beoordeelt vervolgens tests in dezelfde conversatielus voordat je uitrolt.

Het probleem: sneller coderen kan sneller bugs betekenen

Door AI geschreven code kan voelen als een superkracht: features verschijnen snel, boilerplate verdwijnt en refactors die vroeger uren kostten, gebeuren voordat je koffie is afgekoeld. Het risico verandert echter met de snelheid. Als code makkelijker te produceren is, is het ook makkelijker om fouten te versturen—soms subtiele.

Veelvoorkomende faalmodes van AI-geschreven logica

AI-assistenten zijn goed in het genereren van “redelijke” implementaties, maar redelijk is niet hetzelfde als correct voor jouw specifieke domein.

Randgevallen zijn vaak het eerste slachtoffer. AI-gegenereerde logica handelt meestal het happy path goed af, maar struikelt bij grenscondities: lege inputs, tijdzonekwesties, afronding, null-waarden, retrygedrag of “dit zou nooit moeten gebeuren”-toestanden die wel in productie voorkomen.

Verkeerde aannames zijn een andere frequente kwestie. Een assistent kan eisen infereren die niet zijn uitgesproken (“gebruikers zijn altijd geauthenticeerd”, “IDs zijn numeriek”, “dit veld is altijd aanwezig”), of hij implementeert een bekend patroon dat niet bij jouw systeemregels past.

Stille regressies zijn vaak het duurst. Je vraagt om een kleine wijziging, de assistent herschrijft een stuk logica en iets ongerelateerds faalt—zonder duidelijke fouten. De code compileert nog, de UI laadt nog, maar een prijsregel, permissiecheck of dataconversie is nu net iets anders.

Waarom handmatig testen niet meeschakelt met snellere code

Wanneer codewijzigingen versnellen, wordt handmatig testen een bottleneck en een gok. Je geeft meer tijd aan rondklikken (wat levering vertraagt) of je test minder (wat ontsnappingen vergroot). Zelfs gedisciplineerde QA-teams kunnen niet elke variant handmatig dekken wanneer wijzigingen frequent en ingrijpend zijn.

Erger nog: handmatige checks zijn moeilijk consistent te herhalen. Ze leven in iemands geheugen of checklist en zijn makkelijk over te slaan wanneer deadlines krap zijn—juist wanneer het risico het grootst is.

Tests als vangnet en communicatiemiddel

Geautomatiseerde tests creëren een duurzaam vangnet: ze maken verwachtingen uitvoerbaar. Een goede test zegt: “Gegeven deze inputs en deze context, is dit het resultaat waarop we vertrouwen.” Dat is niet alleen verificatie; het is communicatie voor de toekomstige jij, teamgenoten en zelfs de AI-assistent.

Als tests bestaan, worden wijzigingen minder eng omdat feedback direct is. In plaats van problemen te ontdekken tijdens code review, in staging of van klanten, vind je ze minuten na de wijziging.

Vroeger problemen ontdekken om rework te verminderen

Hoe eerder een bug wordt gevonden, hoe goedkoper het is om te repareren. Tests verkorten de feedbackloop: ze brengen mismatches in aannames en gemiste randgevallen naar voren terwijl de intentie nog vers is. Dat vermindert herwerk, voorkomt “fix-forward” patches en voorkomt dat AI-snelheid in AI-gedreven churn verandert.

Hoe tests een feedbackloop creëren voor AI-geschreven logica

AI-geschreven code is het snelst wanneer je het als een gesprek behandelt, niet als een eenmalige oplevering. Tests maken dat gesprek meetbaar.

De “spec → code → tests” lus (in gewone taal)

-

Spec: Je beschrijft wat er moet gebeuren (inputs, outputs, randgevallen).

-

Code: De AI schrijft de implementatie die beweert die beschrijving te volgen.

-

Tests: Jij (of de AI) genereert checks die bewijzen dat het gedrag daadwerkelijk klopt.

Herhaal deze lus en je produceert niet alleen meer code—je verscherpt continu de definitie van “klaar.”

Tests dwingen duidelijkere vereisten en interfaces af

Een vage eis als “handel ongeldige gebruikers gracieus af” is makkelijk te negeren in code. Een test kan niet vaag zijn. Hij dwingt specifics af:

- Wat telt als “ongeldig”? Ontbrekende ID, geblokkeerde status, foutief e-mailadres?

- Wat betekent “gracieus”? Foutmelding, statuscode, fallbackwaarde?

- Wat is de interface? Functiesignatuur, returnvorm, exceptions?

Zodra je dat in een test probeert uit te drukken, komen onduidelijkheden direct naar boven. Die helderheid verbetert de prompt die je aan de AI geeft en leidt vaak tot eenvoudigere, stabielere interfaces.

Gegeneerde tests valideren wat de code beweert

AI-code kan er correct uitzien terwijl het aannames verbergt. Gegeneerde tests zijn een praktische manier om de claims van de code te verifiëren:

- “Deze functie is puur” → test op geen externe bijwerkingen.

- “Handelt randgevallen af” → test nulls, lege lijsten, grenswaarden.

- “Is backwards compatible” → test oude inputs en verwachte outputs.

Het doel is niet om gegeneerde tests blind te vertrouwen—het is om ze te gebruiken als snelle, gestructureerde scepsis.

Falende tests worden de volgende prompt

Een falende test is praktische feedback: het wijst op een specifieke mismatch tussen het spec en de implementatie. In plaats van de AI te vragen “los het op”, kun je de fout plakken en zeggen: “Werk de code bij zodat deze test slaagt zonder de publieke API te veranderen.” Dat maakt debuggen tot een gerichte iteratie in plaats van giswerk.

Waar geautomatiseerde testgeneratie past in je testpiramide

Geautomatiseerde testgeneratie is het meest nuttig wanneer het je bestaande teststrategie ondersteunt—vooral de klassieke “testpiramide.” De piramide is geen regel omwille van de regel; het is een manier om feedback snel en betrouwbaar te houden en toch echte fouten te vangen.

AI kan helpen tests op elk niveau te maken, maar je krijgt de beste resultaten als je meer van de goedkope tests (onderaan de piramide) genereert en minder van de dure (bovenaan). Die balans houdt je CI-pijplijn snel en beschermt tegelijkertijd de gebruikerservaring.

Unit-tests: snel, gefocust en zeer genereerbaar

Unit-tests zijn kleine checks voor individuele functies, methoden of modules. Ze draaien snel, hebben geen externe systemen nodig en zijn ideaal voor door AI gegenereerde dekking van randgevallen.

Een goed gebruik van geautomatiseerde testgeneratie hier is om:

- Inputvalidatie en “rare” grenswaarden te testen

- Bedrijfsregels valideren (kortingen, permissies, statusovergangen)

- Bugfixes vastleggen met regressietests die moeilijk te vergeten zijn

Omdat unit-tests nauw gedefinieerd zijn, zijn ze makkelijker te reviewen en minder vatbaar voor flaky gedrag.

Integratietests: minder, maar van hoge waarde

Integratietests valideren hoe onderdelen samenwerken: je API met de database, een service die een andere service aanroept, queueverwerking, authenticatie, enz.

AI-gegenereerde integratietests kunnen waardevol zijn, maar vereisen meer discipline:

- Duidelijke setup/teardown zodat tests geen data lekken

- Stabiele testomgevingen (containers, testdatabases, mocks waar passend)

- Assertions die zich richten op uitkomsten, niet op interne implementatiedetails

Beschouw deze als “contractchecks” die bewijzen dat de naden tussen componenten nog steeds houden.

End-to-end tests: spaarzaam genereren

End-to-end (E2E) tests valideren belangrijke gebruikersflows. Ze zijn ook het duurst: trager om te draaien, breekbaarder en lastiger te debuggen.

Automatische testgeneratie kan helpen E2E-scenario's op te stellen, maar je moet ze kritisch cureren. Houd een kleine set kritieke paden (aanmelden, afrekenen, kernworkflow) en probeer niet voor elke feature E2E-tests te genereren.

Praktische aanbeveling: genereer een gebalanceerde mix

Streef er niet naar alles te genereren. In plaats daarvan:

- Genereer veel unit-tests om AI-geschreven logica op functieniveau eerlijk te houden

- Voeg gerichte integratietests toe om de risicovolle grenzen te beschermen (DB, auth, betalingen)

- Behoud een minimale E2E-suite voor de paar gebruikersreizen die je niet kunt laten breken

Deze aanpak houdt de piramide intact—en maakt geautomatiseerde testgeneratie een krachtvermenigvuldiger in plaats van een ruisbron.

Wat er gegenereerd kan worden: uit code, specs en echte bugs

Geautomatiseerde testgeneratie beperkt zich niet tot “schrijf unit-tests voor deze functie.” De meest nuttige generators putten uit drie bronnen: de code die je hebt, de intentie erachter en de fouten die je al hebt gezien.

1) Vanuit codestructuur: test gedrag, niet alleen regels

Given een functie of module kunnen tools testcases afleiden uit inputs/outputs, takken en exceptionpaden. Dat betekent typisch:

- “Happy path” inputs die een bekend resultaat moeten opleveren

- Grenswaarden (lege strings, nul, maximale lengtes)

- Branch coverage (if/else-paden)

- Foutafhandeling (ongeldige inputs, ontbrekende velden, timeouts)

Deze stijl is geweldig om snel AI-geschreven logica met checks te omringen die bevestigen wat het vandaag daadwerkelijk doet.

2) Vanuit vereisten: zet intentie om in uitvoerbare voorbeelden

Als je acceptatiecriteria, user stories of voorbeeldtabellen hebt, kunnen generators die omzetten in tests die als spec lezen. Dit is vaak waardevoller dan tests die van code zijn afgeleid omdat het vastlegt “wat zou moeten gebeuren”, niet “wat er nu gebeurt.”

Een praktische patroon: geef een paar concrete voorbeelden (inputs + verwachte uitkomsten) en vraag de generator randgevallen toe te voegen die consistent zijn met die regels.

3) Vanuit bugreports: reproduceer eerst, voorkom daarna

Bug-gebaseerde generatie is de snelste manier om een betekenisvolle regressiesuite op te bouwen. Voer de reproduceerstappen (of logs en een minimaal payload) in en genereer:

- een test die faalt op het huidige buggy gedrag, en dan

- dezelfde test die slaagt zodra het is gefixt—zodat het voorgoed beschermt tegen herintroductie.

Snapshot/golden tests: handig, met een waarschuwing

Snapshot (golden) tests kunnen efficiënt zijn voor stabiele outputs (gerenderde UI, geserialiseerde responses). Gebruik ze voorzichtig: grote snapshots kunnen subtiele fouten “goedkeuren”. Geef de voorkeur aan kleine, gerichte snapshots en combineer ze met assertions op sleutelvelden die correct moeten zijn.

Kiezen wat je eerst test (zonder de oceaan te koken)

Geautomatiseerde testgeneratie werkt het best wanneer je het duidelijke prioriteiten geeft. Als je het op de hele codebase richt en vraagt om “alle tests”, krijg je ruis: veel laag-waarde checks, dubbele dekking en fragiele tests die de levering vertragen.

Begin waar het bedrijf pijn zou voelen

Begin met flows die het duurst zouden zijn als ze breken—financieel, juridisch of reputatiegewijs. Een simpele risico-filter houdt de scope realistisch en verbetert snel de kwaliteit.

Richt je eerst op:

- Business-kritieke paden (aanmelden, afrekenen, kernworkflows) en gebieden die vaak veranderen (actieve features, refactors, nieuwe integraties).

- Hoge-risico domeinen: betalingen, authenticatie, dataintegriteit, permissies/rollen en alles dat bepaalt wat gebruikers kunnen zien of doen.

Voor elk gekozen pad genereer tests in lagen: een paar snelle unit-tests voor de lastige logica, plus één of twee integratietests die bevestigen dat het hele pad werkt.

“Happy path + top randgevallen” verslaat uitputtende combinaties

Vraag dekking die overeenkomt met echte fouten, niet theoretische permutaties. Een goede startset is:

- Eén happy path test die het verwachte gedrag bewijst.

- De top randgevallen waar je je werkelijk zorgen over maakt: ontbrekende/ongeldige input, verlopen tokens, onvoldoende permissies, gelijktijdigheidsconflicten en “lege staat” data.

Je kunt later altijd uitbreiden op basis van bugs, incidentrapporteringsdata of gebruikersfeedback.

Definieer “klaar” zodat het klaar blijft

Maak de regel expliciet: een feature is niet compleet totdat tests bestaan. Die definitie van klaar is nog belangrijker met AI-geschreven code, omdat het voorkomt dat “snel uitrollen” stilletjes “snel regressies uitrollen” wordt.

Als je wilt dat dit blijft hangen, koppel het aan je workflow (bijvoorbeeld: vereis relevante tests vóór merge in je CI) en vermeld de verwachting in je teamdocs (bijv. /engineering/definition-of-done).

Promptpatronen die betere tests opleveren

AI kan snel tests genereren, maar de kwaliteit hangt sterk af van hoe je het vraagt. Het doel is het model te sturen naar tests die gedrag beschermen—niet tests die alleen code uitvoeren.

Zet je codeerstandaard direct in de prompt

Begin met het vastleggen van de “vorm” van de tests zodat de output bij je repo past.

Voeg toe:

- Taal + testframework (bijv. TypeScript + Jest, Python + pytest)

- Naamgevingsregels (bijv.

should_<gedrag>_when_<conditie>)

- Bestandslocatie en structuur (bijv.

src/ en tests/, of __tests__/)

- Conventies (fixtures, factory-helpers, mocking-library)

Dit voorkomt dat het model patronen verzint die je team niet gebruikt.

Geef 1–2 echte testvoorbeelden om na te bootsen

Plak een bestaand testbestand (of een klein excerpt) en zeg expliciet: “Match deze stijl.” Dit richt beslissingen zoals testdata-opzet, naamgeving en voorkeur voor tabel-gedreven tests.

Als je project helpers heeft (bijv. buildUser() of makeRequest()), voeg die snippets ook toe zodat de gegenereerde tests ze hergebruiken in plaats van ze opnieuw te implementeren.

Vraag om zinvolle assertions (niet alleen “het draait”)

Wees expliciet over wat “goed” betekent:

- Assert op outputs en statuswijzigingen

- Verifieer bijwerkingen (bijv. database-writes, uitgezonden events)

- Assert op fouttypes/berichten waar relevant

Een nuttige promptregel: “Elke test moet minstens één assertion bevatten over bedrijfslogica (niet alleen ‘geen uitzondering’).”

Eis negatieve en grensgevallen

De meeste AI-gegenereerde suites neigen naar het happy path. Balanceer dat door te vragen om:

- Ongeldige inputs en verwachte failures

- Grenswaarden (lege strings, nul, maximale lengte)

- Permissie-/autorisatiefouten

- Ontbrekende afhankelijkheden (bijv. null-responses, timeouts)

Een praktische prompttemplate

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

Menselijke review: zorgen dat gegenereerde tests echt helpen

AI kan veel tests snel opstellen, maar het kan niet definitief oordelen of die tests jouw intentie representeren. Een menselijke review maakt van “tests die draaien” echte “tests die ons beschermen.” Het doel is niet om stijl te nitpicken—het is om te bevestigen dat de tests echte regressies vangen zonder onderhoudslast te worden.

Review op correctheid en relevantie

Begin met twee vragen:

- Assert de tests gedrag dat het product echt nodig heeft?

- Zou je blij zijn als deze test faalt bij een toekomstige wijziging—omdat hij een echt probleem aangeeft?

Gegenereerde tests leggen soms per ongeluk actueel gedrag vast (implementatiedetails) in plaats van de bedoelde regel. Als een test leest als een kopie van de code in plaats van een beschrijving van het verwachte resultaat, stuur hem naar hoger-niveau assertions.

Let op fragiliteit (de stille productiviteitdief)

Veelvoorkomende bronnen van flaky of fragiele tests zijn overmatig mocken, hard-gecodeerde timestamps en random waarden. Geef de voorkeur aan deterministische inputs en stabiele assertions (bijv. assert op een geparseerde datum of een bereik in plaats van een ruwe Date.now() string). Als een test buitensporig veel mocking vereist om te slagen, test je mogelijk bekabeling in plaats van gedrag.

Zorg dat failures om de juiste reden optreden

Een “passende” test kan nutteloos zijn als hij ook slaagt wanneer de feature gebroken is (false positive). Let op zwakke assertions zoals “geeft geen uitzondering” of alleen controleren dat een functie is aangeroepen. Versterk ze door te asserten op outputs, statuswijzigingen, teruggegeven fouten of persistente data.

Gebruik een lichte code-review checklist

Een eenvoudige checklist houdt reviews consistent:

- Leesbaarheid: duidelijke namen, minimale setup, duidelijke intentie

- Dekking van intentie: sleutelrandgevallen en foutpaden opgenomen

- Onderhoudbaarheid: vermijd overspecificatie van internals; minimaal mocken

- Signaalkwaliteit: zou falen bij een echte regressie, niet bij onschuldige refactors

Behandel gegenereerde tests als elke andere code: merge alleen wat je bereid bent over zes maanden te onderhouden.

Het laten beklijven: CI-checks die AI-code eerlijk houden

AI kan helpen code snel te schrijven, maar de echte winst is dat die code over tijd correct blijft. De eenvoudigste manier om kwaliteit te “vergrendelen” is tests en checks automatisch te laten draaien bij elke wijziging—zodat regressies worden tegengehouden vóór ze uitrollen.

Een praktische flow die werkt

Een lichte workflow die veel teams aannemen ziet er zo uit:

- Genereer of bewerk de featurecode (AI-ondersteund of niet).

- Genereer tests voor het nieuwe gedrag (en voor de bug die je net hebt opgelost).

- Draai alles lokaal om te bevestigen dat je groen bent.

- Commit code + tests samen.

Die laatste stap is belangrijk: AI-geschreven logica zonder bijbehorende tests heeft de neiging te vervagen. Met tests leg je het bedoelde gedrag vast op een manier waarop CI het kan afdwingen.

CI als onontkoombaar vangnet

Configureer je CI-pijplijn om bij elke pull request te draaien (en idealiter bij merges naar main). Op z’n minst zou het moeten:

- Dependencies installeren in een schone omgeving

- Unit-/integratietests draaien

- De build laten falen bij enige testfout

Dit voorkomt “werkt op mijn machine”-verrassingen en vangt accidentele breuken wanneer een collega (of een latere AI-prompt) code elders verandert.

Voeg een paar kwaliteitsgates toe (houd ze licht)

Tests zijn essentieel, maar ze vangen niet alles. Voeg kleine, snelle gates toe die testgeneratie complementeren:

- Linting (stijl + veelvoorkomende fouten)

- Typechecks (waar van toepassing)

- Format checks (zodat diffs leesbaar blijven)

Houd deze checks snel—als CI traag of luidruchtig aanvoelt, zoeken mensen naar manieren eromheen.

Kosten- en capaciteitsplanning

Als je CI-activiteiten uitbreidt omdat je meer tests genereert, zorg dan dat je budget de nieuwe cadans aankan. Als je CI-minuten bijhoudt, is het de moeite waard limieten en opties te herzien (zie /pricing).

Gebruik falende tests om de volgende AI-iteratie te sturen

Een verrassend effectieve manier om met AI-geschreven code te werken is falende tests als je “volgende prompt” te gebruiken. In plaats van het model breed te vragen “verbeter de feature”, geef je het een concrete failure en laat je die failure de wijziging begrenzen.

De workflow: failure → prompt → fix → herhaal

- Draai de suite (of CI) en pak één failure. Kopieer de naam van de falende test en de relevante assertion message/stacktrace.

- Vraag de AI alleen die failure aan te pakken. Geef minimale codecontext (de falende test en de functie/module onder test), plus eventuele bedrijfsregels die mogelijk worden geschonden.

- Eis eerst een regressietest. Als de failure uit een bugreport of productie-issue komt, vraag de AI een test te maken die de bug reproduceert vóór het aanpassen van de implementatie.

- Pas de kleinste wijziging toe die de test laat slagen. Draai tests direct opnieuw.

- Ga naar de volgende falende test. Eén failure tegelijk houdt de iteratie strak en begrijpelijk.

Promptpatroon: houd het klein en verifieerbaar

In plaats van:

- “Los de loginlogica op en update tests.”

Gebruik:

- “Deze test faalt:

shouldRejectExpiredToken. Hier is de foutoutput en relevante code. Werk de implementatie bij zodat deze test slaagt zonder ongewoon gedrag te veranderen. Voeg zo nodig een regressietest toe die de bug vastlegt.”

Waarom dit minder heen-en-weer maakt

Falende tests halen het giswerk weg. Ze definiëren wat “correct” betekent in uitvoerbare vorm, dus je onderhandel niet via chat over vereisten. Je vermijdt ook omvangrijke edits: elke prompt is begrensd tot één meetbaar resultaat, wat menselijke review versnelt en het makkelijker maakt te zien wanneer de AI alleen het symptoom repareert maar iets anders breekt.

Dit is ook waar een agent-achtige workflow kan lonen: één agent richt zich op de minimale codewijziging, een andere stelt de kleinste testaanpassing voor, en jij reviewt de diff. Platforms zoals Koder.ai zijn rond zo’n iteratief, chat-eerst ontwikkelproces gebouwd—waardoor “tests als volgende prompt” een standaard werkwijze wordt in plaats van een speciale techniek.

Succes meten zonder te jagen op schijnstatistieken

Geautomatiseerde testgeneratie kan je testsuite in één nacht groter maken—maar “groter” is niet hetzelfde als “beter.” Het doel is vertrouwen: regressies vroeg vangen, productie-gebreken verminderen en het team in beweging houden.

Metrics die echt iets zeggen over kwaliteit

Begin met signalen die mapped zijn aan uitkomsten die je belangrijk vindt:

- Build pass rate (op main): Als merges vaak breken, zijn gegenereerde tests mogelijk te fragiel of produceren je prompts onjuiste aannames.

- Flaky test rate: Houd bij hoe vaak tests falen en bij een rerun slagen. Een stijgend flaky-percentage is een belasting op developer-trust en zorgt dat teams falingen negeren.

- Time-to-detect regressions: Meet de tijd van het introduceren van een bug tot een falende CI-run. Gegeneerde tests zouden dit venster moeten verkorten door randgevallen en recente wijzigingen te dekken.

Zie coverage als hint, niet als score

Coverage kan een nuttig rookalarm zijn—vooral om ongeteste kritieke paden te vinden—maar het is makkelijk te manipuleren. Gegeneerde tests kunnen coverage opblazen terwijl ze weinig asserten (of de verkeerde dingen asserten). Geef de voorkeur aan indicatoren zoals:

- Assertions per test (sanity check, geen KPI)

- Mutatietestresultaten (als je dat gebruikt)

- Of tests falen wanneer je opzettelijk gedrag breekt

Focus op “defects gevangen vóór release”

Als je alleen testaantal of coverage volgt, optimaliseer je voor volume. Volg defects gevangen vóór release: bugs gevonden in CI, QA of staging die anders bij gebruikers zouden terechtkomen. Als geautomatiseerde testgeneratie werkt, stijgt dat aantal terwijl productie-incidenten dalen.

Plan onderhoud om winst blijvend te houden

Gegenereerde suites hebben onderhoud nodig. Zet een terugkerende taak in de agenda om:

- Redundante tests te verwijderen die geen unieke bescherming toevoegen

- Flaky tests te stabiliseren of te verwijderen

- Overlappende gevallen samen te voegen in duidelijkere, intentie-onthullende tests

Succes is een rustigere CI, snellere feedback en minder verrassingen—niet een dashboard dat indrukwekkend uitziet.

Veelvoorkomende valkuilen en een praktisch uitrolplan

Geautomatiseerde testgeneratie kan kwaliteit snel verhogen—maar alleen als je het als hulpmiddel gebruikt, niet als autoriteit. De grootste fouten lijken vaak op elkaar bij teams en zijn te vermijden.

Veelvoorkomende valkuilen om op te letten

Over-afhankelijkheid is de klassieke val: gegenereerde tests kunnen een illusie van veiligheid creëren terwijl ze de echte risico's missen. Als mensen ophouden kritisch na te denken (“de tool schreef tests, dus we zijn gedekt”), zul je bugs sneller uitrollen—alleen met meer groene vinkjes.

Een ander veelvoorkomend probleem is testen van implementatiedetails in plaats van gedrag. AI-tools klampen zich vaak vast aan huidige methoden, interne helpers of exacte foutmeldingen. Zulke tests worden fragiel: refactors breken ze zelfs als de feature nog werkt. Geef de voorkeur aan tests die wat moet gebeuren beschrijven, niet hoe het gebeurt.

Beveiliging en privacy: deel niet wat je niet zou moeten delen

Testgeneratie omvat vaak het kopiëren van code, stacktraces, logs of specs naar een prompt. Dat kan geheimen (API-sleutels), klantdata of propriëtaire logica blootstellen.

Houd prompts en testfixtures vrij van gevoelige informatie:

- Redacteer tokens, credentials en interne URL's.

- Vermijd het plakken van productielogs met persoonsgegevens.

- Gebruik synthetische voorbeelden (fake accounts, fake IDs) voor testdata.

- Als je echte gevallen moet delen, minimaliseer en anonimiseer.

Als je een gehost platform voor AI-ontwikkeling gebruikt, hanteer dezelfde discipline. Zelfs wanneer een platform moderne deployments en region-aware hosting ondersteunt, behandel je prompts en fixtures als onderdeel van je beveiligingshouding.

Een praktisch uitrolplan (dat teams daadwerkelijk volgen)

Begin klein en maak het routine:

- Kies één service of module die vaak verandert.

- Genereer unit-tests voor de hoogste risico-paden (geldverkeer, permissies, datatransformaties).

- Voeg een eenvoudige CI-regel toe: nieuwe AI-geschreven features moeten tests bevatten (zie /blog/ci-checks-for-ai-code).

- Vereis een korte human-review checklist: “Assert deze test gedrag? Zou hij falen om de juiste reden?”

- Meet regressies die voorkomen worden (niet alleen coverage), en breid uit naar integratietests zodra unit-tests stabiel aanvoelen.

Het doel is niet maximale tests—het is betrouwbare feedback die AI-geschreven logica eerlijk houdt.