Waarom deployment en SSR product werden

Nog niet zo lang geleden betekende het uitbrengen van een webapp meestal: bouw het, zoek een host, koppel het en houd het draaiend. Zelfs als je code eenvoudig was, vereiste live zetten vaak beslissingen over servers, caching, build-pijplijnen, TLS-certificaten en monitoring. Niets daarvan was glamoureus, maar het was onvermijdelijk—en het onttrok teams routinematig aan het product dat ze wilden opleveren.

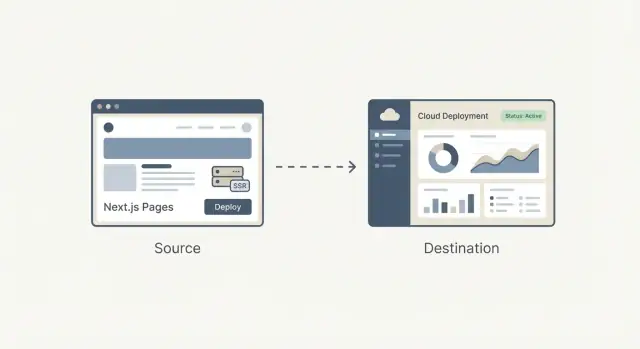

Van “hosting” naar een herhaalbare workflow

De grote verschuiving is dat deployment stopte met een eenmalig technisch project te zijn en een workflow werd die je elke dag herhaalt. Teams wilden preview-URL's voor elke pull request, rollbacks die geen detectivewerk vereisen en een betrouwbare route van lokale code naar productie.

Zodra die behoeften gemeengoed werden bij startups, agencies en enterprises, begon deployment minder op maatwerk-engineering te lijken en meer op iets dat je kon verpakken: een product met duidelijke defaults, een UI, zinvolle automatisering en voorspelbare uitkomsten.

Waarom deployment en SSR als gespecialiseerd voelden

Server-side rendering (SSR) voegde een extra laag complexiteit toe. Het is niet alleen "bestanden serveren"; het is "code op de server draaien om HTML te genereren, deze veilig cachen en bijwerken zonder gebruikers te breken." SSR goed doen betekende dat je moest begrijpen:

- Runtime-omgevingen (Node, serverless functies)

- Cachingregels en invalidatie

- Prestatieafwegingen en cold starts

- Routing, rewrites en headers

Dit was beheersbaar voor specialisten, maar makkelijk verkeerd te configureren—en moeilijk te onderhouden naarmate een project groeide.

De kernvraag die dit artikel beantwoordt

Wat betekent het om frontend-infrastructuur te productiseren?

Het betekent de rommelige, foutgevoelige onderdelen van het uitrollen van een frontend—builds, deploys, previews, SSR/SSG-afhandeling, caching en edge-levering—om te zetten in een standaard, grotendeels automatisch systeem dat op dezelfde manier over projecten heen werkt.

In de volgende secties is het doel praktisch: begrijp wat wordt vereenvoudigd, wat je wint en welke afwegingen je accepteert—zonder dat je een ops-expert hoeft te worden.

Guillermo Rauch’s rol in de moderne frontend-stack

Guillermo Rauch is tegenwoordig vooral bekend als CEO van Vercel en als een leidende stem achter Next.js. Zijn invloed draait minder om één uitvinding en meer om een constante obsessie: webontwikkeling voor productbouwers "logischer" maken.

Bouwer + open-source leider (de feitelijke kant)

Rauch heeft veel van zijn carrière besteed aan het openbaar uitbrengen van ontwikkelaarstools. Voor Vercel bouwde en onderhield hij populaire open-source projecten (met name Socket.IO) en hielp hij een cultuur te laten groeien waarin documentatie, voorbeelden en verstandige defaults als onderdeel van het product worden gezien—niet als bijzaak.

Later richtte hij ZEIT op (later hernoemd naar Vercel), een bedrijf dat zich richtte op het veranderen van deployment in een gestroomlijnde workflow. Next.js, oorspronkelijk binnen dat ecosysteem ontwikkeld, werd het vlaggenschip-framework dat een moderne frontend-ervaring koppelde aan productieklare features.

Developer experience als productkeuze

Een nuttige manier om Rauchs impact te begrijpen is via herhalende keuzes:

- Verminder het aantal "alleen-voor-experts" stappen tussen code en een live URL.

- Maak performance- en renderopties toegankelijk via conventies.

- Geef de voorkeur aan end-to-end workflows (framework + hosting) wanneer dat wrijving wegneemt.

Die focus vormde zowel het framework als het platform: Next.js moedigde teams aan SSR en statische generatie te gebruiken zonder een geheel nieuwe operationele handleiding te moeten leren, terwijl Vercel deployment naar een voorspelbare, herhaalbare default duwde.

Feit versus interpretatie (geen mythen bouwen)

Het is makkelijk om dit verhaal te romantiseren tot een persoonsgerichte mythe. Nauwkeuriger is dat Rauch hielp een bredere verschuiving te alignen die al plaatsvond: frontendteams wilden snellere iteratie, minder handoffs en infrastructuur die niet voor elke wijziging een dedicated ops-specialist nodig had.

Vercel en Next.js functioneren als een case study in productdenken omdat ze die wensen verpakte in defaults die mainstream teams echt konden gebruiken.

Next.js in eenvoudige termen: wat het oplost

Next.js is een React-framework dat je een "volledige webapp-starterkit" bovenop React geeft. Je bouwt componenten op dezelfde manier, maar Next.js voegt de ontbrekende stukken toe die de meeste teams toch zelf zouden samenstellen: pagina's, routing, manieren om data op te halen en productie-vriendelijke performance-defaults.

De problemen die het aanpakt

Routing en pagina's: In een gewone React-app voeg je meestal een routerbibliotheek toe, bedenk je URL-conventies en koppel je alles. Next.js maakt URL's en pagina's tot een eersteklas feature, zodat je app-structuur natuurlijk naar routes map.

Datalaadwerk: Echte apps hebben data nodig—productlijsten, gebruikersaccounts, CMS-content. Next.js biedt gangbare patronen om data op de server, tijdens de build of in de browser te laden, zonder dat elk team een eigen setup hoeft uit te vinden.

Performance-defaults: Next.js bakeert praktische optimalisaties in—code splitting, slimmer assetbeheer en renderkeuzes—zodat je goede snelheid krijgt zonder een lange checklist met plugins te moeten doorlopen.

Hoe het verschilt van een "gewone React-app"

Een gewone React-app is vaak "React + een stapel beslissingen": routingbibliotheek, buildconfig, SSR/SSG-tools (indien nodig) en conventies die alleen in jouw repo bestaan.

Next.js is opiniërender: het standaardiseert de veelvoorkomende beslissingen zodat nieuwe ontwikkelaars het project sneller begrijpen en teams minder tijd kwijt zijn aan het onderhouden van infrastructuur.

Wanneer Next.js overbodig kan zijn

Next.js kan overkill zijn als je een kleine, grotendeels statische site bouwt met een handvol pagina's, of een simpel intern hulpmiddel waar SEO en eerste-laadprestaties geen prioriteit zijn.

Als je geen meerdere renderopties, gestructureerde routing of server-side dataloading nodig hebt, kan een lichtgewicht React-setup (of zelfs geen React) de eenvoudigere en goedkopere keuze zijn.

SSR, SSG en client-rendering: de praktische verschillen

Moderne webapps kunnen mysterieus lijken omdat "waar de pagina wordt opgebouwd" verandert afhankelijk van de aanpak. Een eenvoudige manier om SSR, SSG en client-side rendering (CSR) te begrijpen is: wanneer en waar wordt de HTML gemaakt?

SSR (Server-Side Rendering)

Bij SSR genereert de server de HTML voor elk verzoek (of voor veel verzoeken als caching wordt gebruikt). Dat helpt bij SEO en kan de eerste weergave snel laten verschijnen—vooral op tragere apparaten—omdat de browser vroeg echte content ontvangt.

Een veelvoorkomend misverstand: SSR is niet automatisch sneller. Als elk verzoek trage databasecalls triggert, kan SSR traag aanvoelen. De echte snelheid komt vaak van caching (op de server, CDN of edge) zodat herhaalde bezoeken het werk niet opnieuw hoeven te doen.

SSG (Static Site Generation)

Bij SSG worden pagina's vooraf opgebouwd (tijdens een buildstap) en als statische bestanden geserveerd. Dit is geweldig voor betrouwbaarheid en kosten, en levert vaak uitstekende laadtijden omdat de pagina ‘‘klaar’’ is voordat de gebruiker arriveert.

SSG blinkt uit voor marketingpagina's, documentatie en content die niet elke seconde verandert. Het nadeel is versheid: content bijwerken kan een rebuild of een incrementele update-strategie vereisen.

CSR (Client-Side Rendering)

Bij CSR downloadt de browser JavaScript en bouwt de UI op het apparaat van de gebruiker. Dit is ideaal voor zeer interactieve, gepersonaliseerde delen van een app (dashboards, editors), maar het kan de eerste betekenisvolle weergave vertragen en SEO bemoeilijken als content niet als HTML beschikbaar is.

Waarom teams alle drie combineren

De meeste echte producten combineren modi: SSG voor landingspagina's (SEO en snelheid), SSR voor dynamische pagina's die toch indexeerbare content moeten hebben (productpagina's, lijsten) en CSR voor ingelogde ervaringen.

Goed kiezen hangt rechtstreeks samen met uitkomsten: SEO (vindbaarheid), snelheid (conversie) en betrouwbaarheid (minder incidenten, stabieler inkomsten).

Vóór productisatie: hoe webapps werden gedeployed

Voordat platforms deployment als een knop-klik lieten voelen, betekende het uitrollen van een webapp vaak je eigen mini "infrastructuurproject" samenstellen. Zelfs een simpele marketingsite met een dynamisch contactformulier kon uitgroeien tot een keten van servers, scripts en services die perfect synchroon moesten blijven.

De typische workflow

Een veelvoorkomende setup zag er zo uit: je provisiondeerde één of meer servers (of een VM), installeerde een webserver en zette een CI-pijplijn op die je app bouwde en artefacten via SSH kopieerde.

Daarbovenop configureerde je mogelijk een reverse proxy (zoals Nginx) om requests te routeren, TLS te termineren en compressie af te handelen. Dan kwam caching: misschien een HTTP-cache, CDN-configuratie en regels over welke pagina's veilig te cachen waren en hoe lang.

Als je SSR nodig had, draaide je nu een Node-proces dat gestart, gemonitord, herstart en geschaald moest worden.

Pijnpunten die teams vertraagden

De problemen waren niet theoretisch—ze kwamen bij elke release naar voren:

- Configuratiedrift: staging is "goed genoeg" totdat het dat niet is. Een klein verschil in OS-pakket kon builds of runtime-gedrag breken.

- Trage releases: elke deploy vereiste coördinatie tussen CI-scripts, serverstate, environment-variabelen en cache-invalidatie.

- Moeilijke rollbacks: terugdraaien betekende vaak een oude build opnieuw deployen en hopen dat serverstate (en dependencies) nog overeenkwamen.

Waarom “het werkt op mijn machine” zo vaak voorkwam

Lokale ontwikkeling verbergt de rommelige delen: je hebt een warme cache, een andere Node-versie, andere env-vars en geen echte verkeerspatronen.

Eenmaal gedeployed komen die verschillen onmiddellijk naar voren—vaak als subtiele SSR-mismatches, ontbrekende secrets of routingregels die zich anders gedragen achter een proxy.

De verborgen belasting op kleine teams

Geavanceerde setups (SSR, multi-region performance, veilige preview-omgevingen) waren mogelijk, maar vroegen operationele tijd. Voor veel kleine teams betekende dat kiezen voor eenvoudigere architectuur—niet omdat het beter was, maar omdat de deployment-overhead te hoog was.

Vercel’s kernidee: deployment als standaard workflow

Van idee naar live preview

Bouw een React-app via chat en publiceer een werkende preview zonder eerst infra in te richten.

Vercel automatiseerde deployment niet alleen—het verpakte het in een standaardworkflow die voelt als onderdeel van code schrijven. Het productidee is simpel: deployment hoort geen apart "ops-taken" te zijn; het moet het normale resultaat van dagelijkse ontwikkeling zijn.

"Git push to deploy" als product

"Git push to deploy" wordt vaak als een net script beschreven. Vercel ziet het meer als een belofte: als je code in Git staat, is het deployable—consistent, herhaalbaar en zonder een checklist van handmatige stappen.

Dat verschil doet ertoe omdat het verandert wie zich veilig voelt met uitrollen. Je hebt geen specialist nodig die elke keer serverinstellingen, cacheregels of buildstappen interpreteert. Het platform zet die beslissingen om in defaults en guardrails.

Preview-deploys veranderen samenwerking

Preview-deploys zijn een groot deel van waarom dit als een workflow voelt, niet als een tool. Elke pull request kan een deelbare URL genereren die productiegedrag nauw volgt.

Ontwerpers kunnen spacing en interacties in een echte omgeving beoordelen. QA kan testen op de exacte build die zou uitrollen. PM's kunnen door de feature klikken en concreet feedback geven—zonder te wachten op een "staging-push" of iemand te vragen de branch lokaal te draaien.

Rollbacks en omgevingpariteit als veiligheidsmaatregelen

Als deployen frequent wordt, wordt veiligheid een dagelijkse behoefte. Snelle rollbacks maken van een slechte release een ongemak in plaats van een incident.

Omgevingspariteit—preview, staging en productie zo gelijk mogelijk houden—vermindert het "het werkt op mijn machine"-probleem dat teams vertraagt.

Een simpele user story: marketing + app-update

Stel dat je een nieuwe pricing-pagina uitrolt plus een kleine wijziging in het signup-flow. Met preview-deploys controleert marketing de pagina, QA test de flow en het team merged met vertrouwen.

Als analytics na lancering een probleem toont, rol je in enkele minuten terug terwijl je het oplost—zonder al het andere werk te blokkeren.

Van CDN naar Edge: frontend-infrastructuur zonder ops-team

Een CDN (Content Delivery Network) is een set servers wereldwijd die kopieën van je sitebestanden bewaren en leveren—afbeeldingen, CSS, JavaScript en soms HTML—zodat gebruikers ze van een nabije locatie downloaden.

Caching is het regelboek voor hoe lang die kopieën hergebruikt mogen worden. Goede caching betekent snellere pagina's en minder hits op je origin-server. Slechte caching betekent gebruikers die verouderde content zien—of dat je team bang is om überhaupt te cachen.

De edge is de volgende stap: in plaats van alleen bestanden te serveren vanaf globale locaties, kun je kleine stukken code dicht bij de gebruiker uitvoeren, op het moment van request.

Hier wordt "frontend-infrastructuur zonder ops-team" echt: veel teams krijgen wereldwijde distributie en slimme request-afhandeling zonder zelf servers in meerdere regio's te beheren.

Waar edge-functies goed voor zijn

Edge-functies blinken uit wanneer je snelle beslissingen moet nemen voordat een pagina geserveerd wordt:

- Personalisatie: content kiezen op basis van locatie, apparaat of gebruikerssegment.

- Auth-checks: niet-ingelogde gebruikers omleiden, een sessie valideren of headers instellen.

- A/B-tests: gebruikers consistent in experimenten routeren (zonder extra rondes).

Wanneer edge overbodig is

Als je site voornamelijk statisch is, weinig verkeer heeft of je strikte eisen hebt over exact waar code mag draaien (om juridische of dataresidency-redenen), voegt edge complexiteit toe zonder duidelijke winst.

Afwegingen om te begrijpen

Code draaien over veel locaties kan observeerbaarheid en debuggen moeilijker maken: logs en traces zijn verspreid en reproduceren van "het faalt alleen in één regio" kost tijd.

Er is ook vendor-specifiek gedrag (API's, limieten, runtime-verschillen) dat draagbaarheid kan beïnvloeden.

Wanneer bedachtzaam gebruikt, geven edge-mogelijkheden teams "global by default" performance en controle—zonder een ops-team in te huren om alles aan elkaar te knopen.

Rol terug met vertrouwen

Experimenteer veilig met snapshots en rollbacks als een release niet goed blijkt.

Een framework en een hostingplatform "passen samen" wanneer het platform begrijpt wat het framework produceert tijdens buildtijd—en wat het nodig heeft tijdens requesttijd.

Dat betekent dat de host build-output kan interpreteren (statische bestanden vs. serverfuncties), de juiste routingregels kan toepassen (dynamische routes, rewrites) en verstandige cachinggedragingen kan instellen (wat op de edge kan worden gecachet, wat vers moet zijn).

Wat integratie vereenvoudigt

Wanneer het platform de conventies van het framework kent, verdwijnt veel werk:

- Afbeeldingsoptimalisatie kan automatisch zijn: het framework produceert een voorspelbare image-pipeline, en het platform kan die dicht bij gebruikers draaien, resultaten cachen en formaten afhandelen.

- Headers en redirects worden configuratie in plaats van aangepaste servercode. Je verklaart intentie (security-headers, caching, canonical redirects) en het platform voert het consequent uit.

- Preview-deploys en omgevingsinstellingen werken vaak "gewoon" omdat het platform branches, builds en runtime-instellingen kan mappen naar de verwachtingen van het framework.

Het nettoresultaat is minder bespoke scripts en minder "werkt op mijn machine"-deploy-verrassingen.

De nadelen van strakke koppeling

Het nadeel is lock-in door gemak. Als je app afhankelijk wordt van platform-specifieke features (edge-function API's, proprietaire cachingregels, build-plugins), kan verhuizen later betekenen dat je delen van routing, middleware of deployment-pijplijn moet herschrijven.

Om draagbaarheid in gedachten te houden: scheid zorgen; houd businesslogica framework-native, documenteer host-specifiek gedrag en geef de voorkeur aan standaarden waar mogelijk (HTTP-headers, redirects, environment-variabelen).

Hoe alternatieven te evalueren

Ga niet automatisch uit van één beste keuze. Vergelijk platforms op: deployment-flow, ondersteunde rendermodi, cache-control, edge-ondersteuning, observeerbaarheid, voorspelbaarheid van prijzen en hoe makkelijk het is om te vertrekken.

Een klein proof-of-concept—hetzelfde repo naar twee providers deployen—onthult vaak sneller de echte verschillen dan documentatie.

Performance gaat niet alleen om mooie scores op een snelheidscheck. Het is een productfeature: snellere pagina's verlagen bounce rates en verbeteren conversies, en snellere builds laten teams vaker uitrollen zonder te wachten.

Twee soorten "snel" die er toe doen

Voor gebruikers betekent "snel" dat de pagina snel bruikbaar wordt—vooral op gemiddelde telefoons en langzamere netwerken. Voor teams betekent "snel" dat deploys in minuten (of seconden) klaar zijn zodat veranderingen met vertrouwen live kunnen.

Vercel populariseerde het idee dat je beide tegelijk kunt optimaliseren door performance onderdeel van de standaardworkflow te maken in plaats van een apart project.

Incrementele builds en caching (in eenvoudige woorden)

Een traditionele build bouwt vaak alles opnieuw, ook al veranderde je maar één regel op één pagina. Incrementele builds streven ernaar alleen te herbouwen wat veranderde—alsof je één hoofdstuk in een boek bijwerkt in plaats van het hele boek opnieuw te drukken.

Caching helpt door eerder berekende resultaten te hergebruiken:

- Build-caching hergebruikt delen van eerdere builds zodat de volgende deploy sneller is.

- Rendering-caches houden vooraf berekende pagina's dicht bij gebruikers, zodat herhaalde bezoeken niet opnieuw werk triggeren.

In Next.js passen patronen zoals incremental static regeneration (ISR) in deze denkwijze: serveer een snelle vooraf gebouwde pagina en vernieuw die op de achtergrond wanneer content verandert.

Een performance-budget is een simpele limiet waar je het over eens bent—zoals "houd de homepage onder 200KB JavaScript" of "Largest Contentful Paint moet onder 2,5s blijven op typische mobiele apparaten." Het doel is niet perfectie; het doel is te voorkomen dat traagheid ongemerkt insluipt.

Eenvoudige checks voor je workflow

Houd het licht en consequent:

- Draai Lighthouse in CI voor sleutelpagina's en faal de build als je het budget breekt.

- Volg real-user metrics (RUM) zodat je de daadwerkelijke ervaring meet en niet alleen labresultaten.

- Bekijk bundle-size veranderingen in PR's om te voorkomen dat "nog een dependency" ongemerkt jouw pagina vertraagt.

Als snelheid als feature wordt behandeld, krijg je zowel betere gebruikerservaring als een sneller teamcadans—zonder dat elke release een performance-brand blijkt.

Mainstream maken: defaults, templates en leercurves

De meeste tools worden niet mainstream omdat ze het meest flexibel zijn—ze winnen omdat een nieuwe gebruiker snel succes kan boeken.

Hoe mainstream bouwers kiezen

Mainstream bouwers (kleine teams, agencies, productontwikkelaars zonder diepe infra-expertise) evalueren platforms vaak met simpele vragen:

- Kunnen we deze week een echte site uitbrengen?

- Is het standaard snel genoeg?

- Kunnen we later veilig wijzigingen doorvoeren?

Hier komen templates, duidelijke docs en "happy path" workflows om de hoek kijken. Een template die binnen enkele minuten deployed en routing, datavergaring en authenticatie demonstreert is vaak overtuigender dan een feature-matrix.

Documentatie die één aanbevolen aanpak toont (en uitlegt wanneer je ervan mag afwijken) verkort de tijd die aan gokken wordt besteed.

Waarom verstandige defaults winnen van eindeloze opties

Een lange lijst toggles kan krachtig lijken, maar dwingt elk team een expert te worden om basisbeslissingen te maken. Verstandige defaults verlagen de cognitieve belasting:

- Goede caching-gedrag uit de doos

- Een aanbevolen renderbenadering per paginatype

- Veilige omgang met environment-variabelen

- Standaard build/deploy-stappen die zelden aanpassing nodig hebben

Wanneer defaults kloppen, besteden teams hun tijd aan productwerk in plaats van configuratie.

Veelvoorkomende behoeftes die templates zouden moeten dekken

Reële builders beginnen vaak met bekende patronen:

- E-commerce: productpagina's, zoeken, checkout-integraties, SEO

- Contentsites: CMS-gedreven pagina's, previews, afbeeldingoptimalisatie

- Dashboards: auth, rolgebaseerde toegang, snelle navigatie, API-zware pagina's

De beste templates zien er niet alleen goed uit—ze coderen bewezen structuren.

Valkuilen voor nieuwkomers

Twee fouten komen vaak terug:

- Te vroeg over-engineeren: edge-logica, complexe caching of meerdere datalagen toevoegen voordat het verkeer het rechtvaardigt.

- Verwarrende renderkeuzes: SSR/SSG/CSR mixen zonder duidelijke reden, wat leidt tot trage pagina's of fragiele builds.

Een goede leercurve duwt teams naar één duidelijk startpunt en maakt gevorderde keuzes gevoel als bewuste upgrades, niet als verplichte huiswerk.

Productisatie voorbij deployment: apps bouwen vanuit intentie

Deployment-platforms productiseerden het pad van Git naar productie. Een parallelle trend ontstaat upstream: het productiseren van het pad van idee naar een werkende codebasis.

Koder.ai is een voorbeeld van deze "vibe-coding" richting: je beschrijft wat je wilt in een chatinterface en het platform gebruikt een agent-gebaseerde LLM-workflow om een echte applicatie te genereren en itereren. Het is ontworpen voor web, server en mobiel (React frontend, Go + PostgreSQL backend, Flutter voor mobiel), met praktische shipping-features zoals source-code export, deployment/hosting, custom domains, snapshots en rollback.

In de praktijk sluit dit natuurlijk aan op de workflow die in dit artikel wordt beschreven: verkort de lus van intentie → implementatie → preview-URL → productie, terwijl je een nooduitgang behoudt (exporteerbare code) wanneer je de defaults ontgroeit.

Kies SSR of SSG duidelijk

Gebruik Planning Mode om pagina's, renderingbehoeften en data te verduidelijken voordat code rommelig wordt.

Een frontend-platform kiezen is niet alleen "waar hosten we". Het is de standaardworkflow kiezen waarin je team leeft: hoe code een URL wordt, hoe wijzigingen worden beoordeeld en hoe outages worden afgehandeld.

1) Kostenmodel: waar je echt voor betaalt

De meeste platforms lijken op elkaar op de homepage, maar lopen uiteen in de facturatie-details. Vergelijk de eenheden die overeenkomen met jouw echt gebruik:

- Prijsmodel: vast vs. usage-based, en wat inbegrepen is per tier.

- Build-minuten: hoe CI/CD-tijd wordt geteld, of previews uit dezelfde pool komen en wat er gebeurt als je de limieten overschrijdt.

- Bandwidth en requests: hoe egress wordt geprijsd, of CDN-verkeer is inbegrepen en hoe pieken worden afgehandeld.

- Team seats: wie telt als betaalde gebruiker (ontwikkelaars, ontwerpers, contractors) en of read-only rollen bestaan.

Een praktisch advies: schat de kosten voor een normale maand en een "launch-week" maand. Als je beide niet kunt simuleren, word je op het slechtste moment verrast.

2) Betrouwbaarheid, regio's en scaling

Je hoeft geen infra-expert te zijn, maar stel een paar directe vragen:

- Waar kun je deployen (regio's/edge-locaties), en kun je dat controleren?

- Wat gebeurt er tijdens verkeerspieken—throttlet het platform, queue't het of faalt het?

- Hoe worden incidenten gecommuniceerd en is er een publieke statuspagina?

- Wat is het rollback-verhaal: één klik, automatisch of handmatig?

Als je klanten globaal zijn, kunnen regiodekking en cache-gedrag net zo belangrijk zijn als ruwe performance.

3) Security basics die ononderhandelbaar moeten zijn

Zoek naar alledaagse safeguards in plaats van vage beloften:

- Secrets management: hoe environment-variabelen worden opgeslagen, geroteerd en gespecificeerd (prod vs. preview).

- Toegangscontrole: rolgebaseerde permissies, SSO-ondersteuning en scheiding tussen projecten.

- Audit trails: zichtbaarheid in deploys, config-wijzigingen en wie wat deed.

4) Een lichte selectie-checklist

Gebruik dit als snelle filter voordat je dieper evalueert:

- Kunnen we preview-deploys voor elke PR maken met minimale setup?

- Ondersteunt het onze rendermodi (static, server rendering, edge-functies) zonder extra lijm?

- Zijn logs, metrics en error-tracing makkelijk te vinden als er iets misgaat?

- Kunnen we later exporteren/migreren zonder de app te herschrijven?

Kies het platform dat de "deployment-beslissingen" vermindert die je team wekelijks moet nemen—terwijl het je genoeg controle laat als het ertoe doet.

Conclusies: een eenvoudige playbook voor teams die het web uitrollen

Productisatie verandert "deployment- en renderingbeslissingen" van maatwerk-engineering naar herhaalbare defaults. Dat vermindert wrijving op twee plekken die teams meestal vertragen: verandering live krijgen en performance voorspelbaar houden.

Als het pad van commit → preview → productie gestandaardiseerd is, versnelt iteratie omdat minder releases afhankelijk zijn van een specialist (of een gelukkige middag debuggen).

Een praktisch migratiepad (klein beginnen, meten, uitbreiden)

Begin met het kleinste oppervlak dat je feedback geeft:

- Voeg eerst preview-deploys toe. Behandel elke pull request als iets dat je kunt klikken en beoordelen.

- Verplaats één pagina of route naar een framework-default (bijvoorbeeld een marketingpagina naar statische generatie of een ingelogde pagina naar server rendering) en vergelijk de uitkomsten.

- Meet wat telt: buildtijd, deploy-frequentie, rollback-tijd, Core Web Vitals en "tijd tot review" voor stakeholders.

Als dat werkt, breid dan langzaam uit:

- Consolideer omgevingen (preview/staging/prod) en definieer wie mag promoveren.

- Introduceer edge of serverless functies alleen waar latency of personalisatie het rechtvaardigt.

- Standaardiseer templates zodat nieuwe projecten starten met werkende auth, analytics en caching-patronen.

Houd leerroutes licht

Als je dieper wilt zonder te verdwalen, bekijk patronen en case studies op /blog en sanity-check kosten en limieten op /pricing.

Als je ook experimenteert met snellere manieren om van requirements naar een werkende basis te komen (vooral voor kleine teams), kan Koder.ai nuttig zijn als hulpmiddel: genereer een eerste versie via chat, iterer snel met stakeholders en houd daarna hetzelfde geproductiseerde pad naar previews, rollbacks en productie.

Gemak versus controle: hoe beslis je

Geïntegreerde platforms optimaliseren voor snelheid van uitrollen en minder operationele beslissingen. De afweging is minder low-level controle (custom infrastructuur, unieke compliance-eisen, bespoke networking).

Kies de "meest geproductiseerde" setup die binnen je beperkingen past—en houd een exit-plan (portable architectuur, duidelijke build-stappen) zodat je vanuit kracht kiest, niet vanuit lock-in.