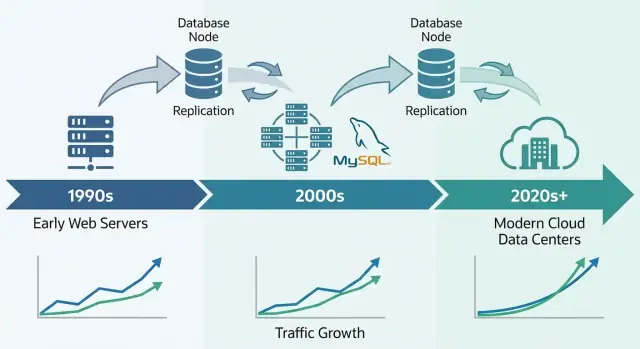

Waarom MySQL een fundament werd voor het vroege web

MySQL werd de voorkeursdatabase van het vroege web om een eenvoudige reden: het sloot aan bij wat websites toen nodig hadden — gestructureerde data snel opslaan en ophalen, draaien op bescheiden hardware en eenvoudig te beheren voor kleine teams.

Het was toegankelijk. Je kon het snel installeren, verbinden vanuit gangbare programmeertalen en een site werkend krijgen zonder een toegewijde databasebeheerder in te huren. Die mix van “goed genoeg prestaties” en lage operationele lasten maakte het de standaard voor startups, hobbyprojecten en groeiende bedrijven.

Wat “schaal” hier eigenlijk betekent

Als mensen zeggen dat MySQL “schaalde”, bedoelen ze meestal een mix van:

- Verkeersgroei: meer gelijktijdige gebruikers en meer queries per seconde.

- Datagroei: tabellen die van duizenden rijen naar miljoenen of miljarden groeien.

- Betrouwbaarheidseisen: online blijven tijdens crashes, deploys en hardware-fouten.

- Kostenbeperkingen: het bovenstaande bereiken zonder alleen-tegenwoordige enterprise budgetten.

Vroege webbedrijven hadden niet alleen snelheid nodig; ze wilden voorspelbare prestaties en uptime terwijl ze de infrastructuurkosten onder controle hielden.

De kernhefbomen die we opnieuw bekijken

Het schaalverhaal van MySQL is eigenlijk een verhaal van praktische afwegingen en herhaalbare patronen:

- Schema- en queryontwerp (wat je opslaat, hoe je join, wat je vermijdt)

- Indexen (het verschil tussen “werkt in dev” en “werkt in productie”)

- Caching (niet elke page view naar de database sturen)

- Replicatie en leesreplica's (leesverkeer spreiden)

- Sharding/partitionering (data splitsen als één database niet meer bijhoudt)

Omvang van dit artikel

Dit is een rondleiding door de patronen die teams gebruikten om MySQL onder echt webverkeer performant te houden — geen volledige MySQL-handleiding. Het doel is uit te leggen hoe de database paste bij de behoeften van het web en waarom diezelfde ideeën nog steeds terugkomen in grote productiesystemen.

Het LAMP-tijdperk: hoe eenvoud hielp MySQL zich te verspreiden

Het doorbraakmoment van MySQL hing nauw samen met de opkomst van shared hosting en kleine teams die snel webapps bouwden. Het was niet alleen dat MySQL “goed genoeg” was — het paste bij hoe het vroege web werd ingezet, beheerd en betaald.

Waarom LAMP aansloot bij vroeg hosten

LAMP (Linux, Apache, MySQL, PHP/Perl/Python) werkte omdat het aansloot bij de standaardserver die de meeste mensen zich konden veroorloven: één Linux-box met een webserver en een database naast elkaar.

Hostingproviders konden deze setup templaten, installaties automatiseren en goedkoop aanbieden. Ontwikkelaars konden vrijwel overal hetzelfde basisomgeving verwachten, waardoor verrassingen bij het verplaatsen van lokale ontwikkeling naar productie afnamen.

Eenvoud als distributiestrategie

MySQL was simpel te installeren, op te starten en te verbinden. Het sprak vertrouwde SQL, had een eenvoudige command-line client en integreerde goed met populaire talen en frameworks van die tijd.

Net zo belangrijk: het operationele model was benaderbaar: één primaire process, een handvol configuratiebestanden en duidelijke faalmodi. Dat maakte het realistisch voor generalistische sysadmins (en vaak ontwikkelaars) om een database te draaien zonder gespecialiseerde training.

Open-source zijn verwijderde licentiedrempels. Een studentenproject, een hobbyforum en een kleine bedrijfswebsite konden allemaal dezelfde database-engine gebruiken als grotere bedrijven.

Documentatie, mailinglijsten en later online tutorials creëerden momentum: meer gebruikers betekenden meer voorbeelden, meer tools en snellere troubleshooting.

De vroege workloads die MySQL goed bediende

De meeste vroege sites waren read-heavy en redelijk eenvoudig: forums, blogs, CMS-gedreven pagina's en kleine e-commercatalogi. Deze apps hadden typisch snelle opzoeken op ID, recente posts, gebruikersaccounts en basiszoek- of filterfunctionaliteit nodig — precies het soort workloads dat MySQL efficiënt kon afhandelen op bescheiden hardware.

Vroege schaaldruk: meer gebruikers, meer reads, meer writes

Vroege MySQL-deployments begonnen vaak als “één server, één database, één app.” Dat werkte prima voor een hobbyforum of een kleine bedrijfswebsite — totdat de app populair werd. Pageviews werden sessies, sessies werden constant verkeer en de database stopte een stille backstagecomponent te zijn.

Waarom reads meestal wonnen

De meeste webapps waren (en zijn nog steeds) read-heavy. Een homepage, productlijst of profielpagina kan duizenden keren bekeken worden voor elke update. Die ongelijkheid bepaalde vroege schaalbeslissingen: kun je reads sneller maken — of voorkomen dat je de database voor reads raakt — dan kun je veel meer gebruikers bedienen zonder alles te herschrijven.

De valkuil: zelfs read-heavy apps hebben cruciale writes. Aanmeldingen, aankopen, reacties en beheerdersupdates mogen niet falen. Naarmate het verkeer groeit, moet het systeem zowel een vloed aan reads als ‘moet-succes’-writes tegelijk verwerken.

De eerste pijnpunten die teams voelden

Bij hoger verkeer werden problemen simpel zichtbaar:

- Trage queries: een pagina die eerst direct laadde bleef “hangen” wanneer een rapportquery te veel rijen scande.

- Table locks: bij sommige vroege setups konden writes reads blokkeren (en andersom), wat verkeersopstoppingen veroorzaakte.

- Beperkt RAM: indexen en hot data pasten niet in geheugen, dus de server moest vaker naar schijf — veel langzamer dan geheugen.

Vroeg verantwoordelijkheden scheiden

Teams leerden verantwoordelijkheden te splitsen: de app behandelt businesslogica, een cache slokt herhaalde reads op en de database focust op accurate opslag en essentiële queries. Dat mentale model legde het fundament voor latere stappen zoals query-tuning, betere indexering en opschaling met replica's.

Storage engines: het grote keerpunt voor betrouwbaarheid

Een uniek kenmerk van MySQL is dat het niet één enkele database-engine is onder de motorkap. Het is een database-server die data kan opslaan en ophalen met verschillende storage engines.

Wat een storage engine eigenlijk doet

Een storage engine bepaalt hoe rijen naar schijf worden geschreven, hoe indexen worden onderhouden, hoe locks werken en wat er na een crash gebeurt. Je SQL kan identiek lijken, maar de engine bepaalt of de database zich gedraagt als een snel notitieboekje of als een bankboek.

MyISAM vs InnoDB (in gewone taal)

Lang was MyISAM in veel MySQL-omgevingen de keuze. Het was simpel en vaak snel voor read-heavy sites, maar het had nadelen:

- Locking: MyISAM gebruikt vaak table-level locks. Eén write kan andere reads/writes meer blokkeren dan je verwacht.

- Crashes: na een onjuiste afsluiting konden MyISAM-tabellen reparatie nodig hebben en recente wijzigingen verliezen.

- Transacties: MyISAM ondersteunt geen transacties, dus je kunt geen multi-step update betrouwbaar “alles of niets” laten zijn.

InnoDB keerde die aannames om:

- Locking: row-level locking vermindert blokkades wanneer veel gebruikers verschillende rijen updaten.

- Crash recovery: betere duurzaamheid en automatische recovery na fouten.

- Transacties: volledige transactiesupport, waardoor het toepassingsgedrag veel voorspelbaarder wordt.

Waarom InnoDB de standaard in productie werd

Naarmate webapps verschoof van vooral pagina's lezen naar het afhandelen van inlogs, winkelwagentjes, betalingen en berichten, werden correctheid en herstelvermogen net zo belangrijk als snelheid. InnoDB maakte het realistisch om te schalen zonder bang te zijn dat een herstart of verkeerspiek data zou corrupt maken of hele tabellen zou blokkeren.

De praktische les: de keuze van engine beïnvloedt zowel prestatie als veiligheid. Het is niet zomaar een vinkje — je lockingmodel, faalgedrag en app-garanties hangen ervan af.

Indexen en queryontwerp: de eerste schaalvergroter

Voordat je sharding, read replicas of ingewikkelde caching toepast, kwamen veel vroege MySQL-winstpunten uit één consistente verandering: queries voorspelbaar maken. Indexen en queryontwerp waren de eerste “vermenigvuldiger” omdat ze verminderden hoeveel data MySQL per verzoek hoefde te lezen.

B-tree-indexen: snelle opzoekingen versus full-table scans

De meeste MySQL-indexen zijn op B-tree gebaseerd. Zie ze als een geordende catalogus: MySQL kan naar de juiste plek springen en een klein, aaneengesloten stuk data lezen. Zonder de juiste index valt de server vaak terug op rijen één voor één scannen. Bij laag verkeer is dat alleen traag; op schaal wordt het een vermenigvuldiger van verkeer — meer CPU, meer schijf-I/O, meer locktijd en hogere latency voor alles.

Query-anti-patronen die pijn doen op schaal

Een paar patronen zorgden herhaaldelijk voor “werkt in staging”-falen:

SELECT *: haalt onnodige kolommen op, vergroot I/O en kan covering-index voordelen tenietdoen.- Leading wildcards:

WHERE name LIKE '%shoe' kan normaal B-tree-indexgebruik vermijden.

- Functies op geïndexeerde kolommen:

WHERE DATE(created_at) = '2025-01-01' voorkomt vaak indexgebruik; geef de voorkeur aan bereikfilters zoals created_at >= ... AND created_at < ....

Twee gewoonten schaadden minder dan elk slim trucje:

- Gebruik

EXPLAIN om te verifiëren dat je de bedoelde index gebruikt en niet scant.

- Houd de slow query log in de gaten om regressies te vangen zodra features live gaan, niet weken later.

Indexen moeten aansluiten op echte features

Ontwerp indexen rond hoe het product zich gedraagt:

- Zoeken: overweeg full-text of prefixstrategieën in plaats van wildcard-scans.

- Feeds: samengestelde indexen zoals

(user_id, created_at) maken “laatste items” snel.

- Checkoutflows: unieke indexen op order-/betaalidentificatoren voorkomen duplicaten en versnellen opzoekingen.

Goede indexering is niet “meer indexen.” Het zijn de juiste paar die passen bij kritieke lees-/schrijfpaden.

Verticale vs horizontale schaal: wat verandert en waarom

Exporteer de bron wanneer je wilt

Begin snel in chat en exporteer de code wanneer je volledige controle wilt.

Wanneer een MySQL-backed product begint te vertragen, is de eerste grote beslissing of je verticaal (scale up) of horizontaal (scale out) schaalt. Ze lossen verschillende problemen op en veranderen je operationele leven op heel verschillende manieren.

Verticale schaal: de “grotere box”-aanpak

Verticale schaal betekent MySQL meer resources geven op één machine: snellere CPU, meer RAM, betere opslag.

Dit werkt vaak verrassend goed omdat veel knelpunten lokaal zijn:

- CPU: complexe queries, sorteringen, joins en inefficiënte WHERE-clauses kunnen cores verzadigen.

- I/O: trage schijven en willekeurige reads/writes domineren als data niet in geheugen past.

- Buffer pool / geheugen: met InnoDB kan meer RAM hot data en indexen in cache houden, waardoor schijfhits verminderen.

- Connectielimieten: te veel gelijktijdige verbindingen kunnen threads, geheugen en context switching overweldigen.

Verticale schaal is meestal de snelste winst: minder bewegende delen, eenvoudigere faalmodi en minder applicatiewijzigingen. Het nadeel is dat er altijd een plafond is (en upgrades downtime of risicovolle migraties kunnen vereisen).

Horizontale schaal: “meer boxes”, meer coördinatie

Horizontale schaal voegt machines toe. Voor MySQL betekent dat typisch:

- Reads verspreiden over replica's

- Writes splitsen door data te verdelen (sharding) of workflows te herstructureren

Het is moeilijker omdat je coördinatieproblemen introduceert: replicatievertraging, failover-gedrag, consistentieafwegingen en meer operationele tooling. Je applicatie moet ook weten met welke server te praten (of je hebt een proxylaag nodig).

Verwachtingen stellen: spring niet direct naar sharding

De meeste teams hebben sharding niet als eerste stap nodig. Begin met vaststellen waar de tijd naartoe gaat (CPU vs I/O vs lock-contentie), repareer trage queries en indexen en pas geheugen en opslag aan. Horizontale schaal betaalt zich uit wanneer één machine je schrijfsnelheid, opslaggrootte of beschikbaarheidseisen niet meer aankan — zelfs na goede tuning.

Replicatie en leesreplica's: praktisch reads schalen

Replicatie is een van de meest praktische manieren waarop MySQL-systemen met groei omgingen: in plaats van één database alles te laten doen, kopieer je de data naar andere servers en spreid je het werk.

Replicatie in gewone taal: een primaire en replica's

Zie een primaire (soms “master” genoemd) als de database die wijzigingen accepteert — INSERTs, UPDATEs, DELETEs. Eén of meer replica's trekken continu die wijzigingen en passen ze toe, waardoor ze een bijna real-time kopie bijhouden.

Je applicatie kan dan:

- Writes naar de primaire sturen

- Veel reads naar replica's sturen

Dit patroon werd gebruikelijk omdat webverkeer vaak sneller “read-heavy” groeit dan “write-heavy”.

Waar men read replica's voor gebruikte

Read replica's waren niet alleen om paginaweergaven sneller te serveren. Ze hielpen ook werk te isoleren dat anders de hoofd-database zou vertragen:

- Lees-schaal: productpagina's, feeds, zoekresultaten en andere read-heavy endpoints

- Analytics en reporting: langere queries op een replica draaien in plaats van de primaire te blokkeren

- Back-ups: logische dumps of backup-tools tegen een replica draaien om productieverkeer te ontzien

De afwegingen die je moet accepteren

Replicatie is geen gratis lunch. Het meest voorkomende probleem is replicatievertraging — replica's kunnen bij pieken seconden (of meer) achterlopen.

Dat leidt tot een belangrijke app-vraag: read-your-writes consistentie. Als een gebruiker zijn profiel bijwerkt en je direct van een replica leest, ziet hij mogelijk oude data. Veel teams lossen dit op door direct na een write van de primaire te lezen of een korte “lees van primaire na write”-venster te gebruiken.

Replicatie is niet hetzelfde als failover

Replicatie kopieert data; het houdt je niet automatisch online tijdens failures. Failover — een replica promoten, verkeer omleiden en ervoor zorgen dat de app veilig reconnect — is een aparte capaciteit die tooling, testing en duidelijke operationele procedures vereist.

Basisprincipes van hoge beschikbaarheid: online blijven tijdens fouten

Test schaal-scenario's vroeg

Vraag Koder.ai om verkeer, consistentiebehoeften en foutgedrag te modelleren vóór lancering.

High availability (HA) zijn praktijken die je app draaiende houden wanneer een databaseserver crasht, een netwerkverbinding wegvalt of je onderhoud moet uitvoeren. De doelen zijn simpel: downtime verminderen, onderhoud veilig maken en herstel voorspelbaar in plaats van geïmproviseerd.

De meest voorkomende HA-patronen

Vroege MySQL-deployments begonnen vaak met één primaire database. HA voegde typisch een tweede machine toe zodat een uitval niet resulteerde in lange downtime.

- Primary–standby (active–passive): één server handelt verkeer af; een standby staat klaar om over te nemen.

- Multi-node clusters: meerdere databaseknopen werken samen om de dienst beschikbaar te houden, meestal met strengere regels over writes.

- Geautomatiseerde failover: monitoring detecteert primaire uitval en promoveert een standby, waarbij de app's connection target wordt bijgewerkt.

Automatisering helpt, maar verhoogt ook de lat: je team moet de detectielogica vertrouwen en split-brain (twee servers die denken dat ze primair zijn) voorkomen.

RPO en RTO, in gewone taal

Twee meetwaarden maken HA-beslissingen minder emotioneel en meer meetbaar:

- RPO (Recovery Point Objective): hoeveel data je je kunt veroorloven te verliezen. Als een replica 10 seconden achterloopt, is je RPO maximaal ~10 seconden.

- RTO (Recovery Time Objective): hoe lang je het je kunt veroorloven om down te zijn. Dit omvat detectie, promotie en het opnieuw verbinden van de app.

Operationele basics die HA echt maken

HA is niet alleen topologie — het is oefening.

Back-ups moeten routine zijn, maar de sleutel is herstelsessies: kun je daadwerkelijk herstellen naar een nieuwe server, snel en onder druk?

Schemawijzigingen zijn ook belangrijk. Grote tabelwijzigingen kunnen writes blokkeren of queries vertragen. Veiliger aanpakken kan door wijzigingen tijdens rustige uren uit te voeren, online schema-change tools te gebruiken en altijd een rollback-plan te hebben.

Goed uitgevoerd verandert HA storingen van noodsituaties in geplande, ingestudeerde gebeurtenissen.

Caching-strategieën die MySQL snel hielden onder webverkeer

Caching was een van de eenvoudigste manieren waarop vroege webteams MySQL responsief hielden naarmate verkeer steeg. Het idee is simpel: bedien herhaalde verzoeken vanuit iets snellers dan de database en raak MySQL alleen wanneer het echt nodig is. Goed gedaan reduceert caching de leesbelasting drastisch en laat plotselinge pieken voelen als een zachte stijging in plaats van een stormloop.

De veelvoorkomende caching-lagen

Applicatie-/objectcache slaat “stukjes” data op die je code vaak opvraagt — gebruikersprofielen, productdetails, permissiechecks. In plaats van dezelfde SELECT honderden keren per minuut te draaien, leest de app een voorgecomputeerd object op sleutel.

Pagina- of fragmentcache slaat gerenderde HTML op (volledige pagina's of onderdelen zoals een sidebar). Dit is vooral effectief voor content-rijke sites waar veel bezoekers dezelfde pagina's bekijken.

Queryresultaat-caching bewaart het resultaat van een specifieke query (of een genormaliseerde versie daarvan). Zelfs als je niet op SQL-niveau cachet, kun je “het resultaat van deze endpoint” cachen met een sleutel die het verzoek representeert.

Teams gebruiken in-memory key/value stores, HTTP-caches of ingebouwde caching in frameworks. Het exacte hulpmiddel is minder belangrijk dan consistente sleutels, TTL's en duidelijke ownership.

Het lastige: cache-invalidatie

Caching ruilt versheid voor snelheid. Sommige data mogen iets verouderd zijn (nieuwspagina's, view counts). Andere data niet (checkout-totals, permissies). Je kiest meestal tussen:

- Tijdgebaseerde expiratie (eenvoudig, staat korte veroudering toe)

- Event-based invalidatie (nauwkeuriger, maar makkelijker foutgevoelig)

Als invalidatie faalt, zien gebruikers verouderde content. Is het te agressief, dan verlies je het cachevoordeel en wordt MySQL weer overbelast.

Waarom het pieken gladstrijkt

Bij verkeerspieken absorberen caches herhaalde reads terwijl MySQL zich op “echt werk” concentreert (writes, cache misses, complexe queries). Dit vermindert wachtrijen, voorkomt dat vertragingen zich opstapelen en koopt tijd om veilig op te schalen.

Sharding en partitionering: wanneer één database niet genoeg is

Er komt een punt waarop “grotere hardware” en zelfs zorgvuldige querytuning je geen ruimte meer geven. Als één MySQL-server de write-volume, datasetgrootte of onderhoudsvensters niet meer kan bijbenen, ga je data splitsen.

Partitionering vs sharding (en waarom ze verschillen)

Partitionering splitst één tabel in kleinere delen binnen dezelfde MySQL-instance (bijv. op datum). Het kan deletes, archivering en sommige queries versnellen, maar je overschrijdt daarmee niet de CPU-, RAM- en I/O-limieten van die ene server.

Sharding verdeelt data over meerdere MySQL-servers. Elke shard bevat een subset van rijen en je applicatie (of een routeringslaag) beslist waar elk verzoek naartoe gaat.

Wanneer sharding noodzakelijk wordt

Sharding komt meestal om de hoek kijken wanneer:

- Writes een primaire satureren, zelfs na indexen, queryfixes en caching

- Opslaggroei backups, restores en schemachanges te langzaam maakt

- “Noisy neighbor”-workloads onvoorspelbare latency voor iedereen veroorzaken

Veelvoorkomende shard keys

Een goede shard key spreidt verkeer gelijkmatig en houdt de meeste verzoeken op één shard:

- user_id: veel gebruikt voor consumentenapps; houdt iemands data bij elkaar

- tenant_id: ideaal voor SaaS; sterke isolatie tussen klanten

- geografie: nuttig voor latency en dataresidency, maar kan hotspots creëren

De echte kosten

Sharding ruilt eenvoud voor schaal:

- Cross-shard queries worden complexer (vaak opgelost met fan-out + aggregatie)

- Cross-shard transacties zijn beperkt; veel teams stappen over op eventual-consistency patronen

- Migraties en rebalancen zijn operationeel zwaar (bereiken verplaatsen, routering bijwerken)

Een gefaseerde aanpak (voordat je commit)

Begin met caching en read replicas om druk van de primaire te halen. Isoleer vervolgens de zwaarste tabellen of workloads (soms per feature of service). Schaal pas naar sharding—bij voorkeur zo dat je shards geleidelijk kunt toevoegen in plaats van alles in één keer te herontwerpen.

Operaties op schaal: monitoring, onderhoud en incidenten

Genereer een rapportagevriendelijke API

Maak endpoints die zware queries van je primaire database houden en later eenvoudig aan te passen zijn.

MySQL draaien voor een druk product gaat minder over slimme features en meer over gedisciplineerde operatie. De meeste uitval begint niet met een dramatische fout, maar met kleine signalen die niemand op tijd koppelde.

Wat teams daadwerkelijk monitoren

Op schaal voorspellen vaak vier signalen problemen het vroegst:

- Query-latency (p50/p95/p99): stijgende tail-latency is belangrijker dan gemiddelden.

- Locks en lock waits: pieken kunnen wijzen op hot rows, ontbrekende indexen of lange transacties.

- Replicatievertraging: lag verandert “lees-schaal” in verouderde reads en kan failovers breken.

- Schijfgroei en IO-druk: schijf raakt vol, maar IO-saturatie schaadt vaak eerst.

Goede dashboards geven context: verkeer, foutpercentages, connection counts, buffer pool hit rate en top queries. Het doel is verandering te spotten — niet “normaal” uit het hoofd leren.

Waarom trage queries alleen onder echte load zichtbaar worden

Veel queries lijken prima in staging en zelfs in productie tijdens rustige uren. Onder load gedraagt de database zich anders: caches helpen minder, gelijktijdige verzoeken versterken lock-contentie en een licht inefficiënte query kan meer reads veroorzaken, meer tijdelijke tabellen of groter sorteerwerk.

Daarom vertrouwen teams op de slow query log, query-digests en productiehistrogrammen in plaats van losse benchmarks.

Onderhoud zonder verrassingen

Veilige change-praktijken zijn opzettelijk saai: voer migraties in kleine batches uit, voeg indexen toe met minimale locking wanneer mogelijk, verifieer met explain plans en houd rollbacks realistisch (soms is de rollback “stop de rollout en fail over”). Veranderingen moeten meetbaar zijn: voor/na latency, lock waits en replicatievertraging.

Incidentbasis: diagnose, mitigatie, preventie

Tijdens een incident: bevestig impact, identificeer de grootste boosdoener (een query, host, tabel), en mitigeren — throttlen van verkeer, runaway queries killen, een tijdelijke index toevoegen of reads/writes verschuiven.

Daarna: noteer wat er gebeurde, voeg alerts toe voor vroege signalen en maak de oplossing herhaalbaar zodat dezelfde fout niet volgende week terugkeert.

Waarom MySQL nog steeds grote systemen aandrijft

MySQL blijft een standaardkeuze voor veel moderne productiesystemen omdat het goed past bij alledaagse applicatiegegevens: veel kleine reads en writes, duidelijke transactionele grenzen en voorspelbare queries. Daarom past het nog steeds bij OLTP-centrische producten zoals SaaS-apps, e-commerce, marktplaatsen en multi-tenant platforms—vooral wanneer je data modelleert rond echte bedrijfsentiteiten en transacties gefocust houdt.

Een moderne MySQL ziet er heel anders uit dan “oude MySQL”

Het hedendaagse MySQL-ecosysteem profiteert van jaren lessen die in veiligere defaults en operationele gewoonten zijn verwerkt. In de praktijk vertrouwen teams op:

- InnoDB als de standaard storage engine, met sterk crash recovery en transactionele garanties

- Verbeterde prestatiefeatures (betere optimizers, snellere replicatie-opties, meer voorspelbaar concurrerend gedrag)

- Observability die makkelijker is in te schakelen: slow query logs, performance schema, metrics-exporters en dashboards die echte bottlenecks laten zien

- Automatisering rond schemachanges, backups en failover—zodat opschalen niet van heroïsch handwerk afhankelijk is

Managed MySQL verlaagt de operationele last

Veel bedrijven draaien MySQL nu via managed services, waarbij de provider routinetaken afhandelt zoals patching, geautomatiseerde backups, encryptie, point-in-time recovery en gangbare schaalstappen (grotere instances, leesreplica's, opslaggroei). Je blijft eigenaar van je schema, queries en datapatroon—maar je besteedt minder tijd aan onderhoudsvensters en hersteltests.

Deze patronen in moderne app-delivery brengen

Een reden waarom het “MySQL-schaalboek” nog steeds relevant is, is dat het zelden alleen een databaseprobleem is—het is een applicatie-architectuurprobleem. Keuzes zoals read/write-scheiding, cache keys en invalidatie, veilige migraties en rollback-plannen werken het beste wanneer ze samen met het product ontworpen worden, niet eromheen geplakt tijdens incidenten.

Als je nieuwe services bouwt en deze beslissingen vroeg wilt vastleggen, kan een vibe-coding-werkstroom helpen. Bijvoorbeeld, Koder.ai kan een plain-language specificatie (entiteiten, verwachte traffic, consistentiebehoeften) nemen en helpen een app-scaffold te genereren—typisch React voor web en Go voor services—terwijl je controle houdt over het datalaagontwerp. De Planning Mode, snapshots en rollback zijn vooral handig bij itereren op schema's en deploywijzigingen zonder elke migratie een hoog risico te laten worden.

Als je Koder.ai-tarieven wilt bekijken (Free, Pro, Business, Enterprise), zie /pricing.

MySQL kiezen vandaag (checklist vanuit requirements)

Kies MySQL wanneer je nodig hebt: sterke transacties, een relationeel model, volwassen tooling, voorspelbare prestaties en een grote sollicitantenpool.

Overweeg alternatieven wanneer je nodig hebt: enorme write-fan-out met flexibele schema's (sommige NoSQL-systemen), wereldwijd consistente multi-region writes (gespecialiseerde gedistribueerde databases) of analytics-gedreven workloads (columnar warehouses).

De praktische conclusie: begin bij de vereisten (latency, consistentie, datamodel, groeisnelheid, teamskills) en kies het eenvoudigste systeem dat daaraan voldoet—en vaak is dat nog steeds MySQL.