02 dec 2025·8 min

Larry Page’s oorspronkelijke AI-visie achter Googles langetermijnspel

Ontdek hoe Larry Page’s vroege ideeën over AI en kennis Googles langetermijnstrategie vormgaven — van zoekkwaliteit tot moonshots en AI-eerst-investeringen.

Wat dit bericht bedoelt met “Larry Page’s AI-visie"

Dit is geen opgeklopt verhaal over één doorbraakmoment. Het gaat over langetermijndenken: hoe een bedrijf vroeg een richting kiest, blijft investeren door meerdere technologische verschuivingen heen, en langzaam een groot idee omzet in alledaagse producten.

Als dit bericht “Larry Page’s AI-visie” zegt, bedoelt het niet “Google voorzag de chatbots van vandaag.” Het betekent iets eenvoudigers — en duurzamers: systemen bouwen die leren van ervaring.

Een simpele omschrijving

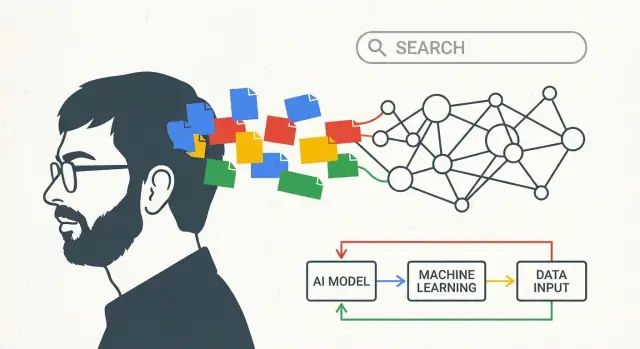

In dit bericht verwijst “AI-visie” naar een paar verbonden overtuigingen:

- Computers moeten hun prestaties verbeteren door te leren van data, niet alleen door handgeschreven regels te volgen.

- De beste systemen worden over tijd beter omdat gebruik in de echte wereld feedback creëert (waar mensen op klikken, wat ze negeren, hoe ze dingen anders formuleren).

- Om leren praktisch te maken heb je infrastructuur nodig: snelle rekenkracht, betrouwbare opslag en een manier om experimenten veilig op enorme schaal uit te voeren.

Met andere woorden: de “visie” gaat minder over één model en meer over een motor: verzamel signalen, leer patronen, lever verbeteringen, herhaal.

De lijn die we volgen

Om dat idee concreet te maken, volgt de rest van het bericht een eenvoudige progressie:

- Zoeken: begin met een duidelijk probleem — mensen helpen goede antwoorden te vinden.

- Data + infrastructuur: gebruik echt gebruik om te leren wat “goed” is, en bouw de machine om het te verwerken.

- AI-eerst producten: behandel leersystemen als de standaardaanpak, zodat spraak, beelden en nieuwe interfaces goed kunnen werken zonder alles opnieuw te hoeven schrijven.

Aan het einde zou “Larry Page’s AI-visie” minder als een slogan en meer als een strategie moeten voelen: vroeg investeren in leersystemen, de pijpen bouwen die ze voeden, en geduld hebben terwijl vooruitgang over jaren componeert.

Het vroege probleem dat Google probeerde op te lossen: goede antwoorden vinden

Het vroege web had een eenvoudig probleem met ingrijpende gevolgen: er kwam ineens veel meer informatie dan een mens kon doorzoeken, en de meeste zoektools raadden min of meer wat belangrijk was.

Als je een zoekopdracht intypte, vertrouwden veel engines op voor de hand liggende signalen — hoe vaak een woord op een pagina voorkwam, of het in de titel stond, of hoe vaak de site-eigenaar het in ‘onzichtbare’ tekst kon proppen. Dat maakte resultaten makkelijk te manipuleren en moeilijk om te vertrouwen. Het web groeide sneller dan de gereedschappen die het moesten organiseren.

PageRank, uitgelegd zoals je een aanbeveling uitlegt

De kerninzichten van Larry Page en Sergey Brin waren dat het web al een ingebouwd stemsysteem bevatte: links.

Een link van de ene pagina naar de andere is een beetje als een citaat in een paper of een aanbeveling van een vriend. Niet alle aanbevelingen zijn evenveel waard. Een link van een pagina die veel anderen waardevol vinden, zou meer moeten tellen dan een link van een onbekende pagina. PageRank zette dat idee om in wiskunde: in plaats van pagina’s alleen te rangschikken op wat ze zelf over zichzelf zeiden, rangschikte Google pagina’s op basis van wat de rest van het web er via links “over zei”.

Dit deed twee belangrijke dingen tegelijk:

- Het hielp gezaghebbende pagina’s naar boven te halen, zelfs als ze de exacte zoekwoorden niet herhaalden.

- Het maakte rangschikken moeilijker te manipuleren, omdat geloofwaardigheid verdiend moest worden over het netwerk van sites.

Waarom meten en itereren vanaf dag één belangrijk waren

Alleen een slim rangschikkingsidee hebben was niet genoeg. Zoekkwaliteit is een bewegend doel: er verschijnen nieuwe pagina’s, spam past zich aan, en wat mensen met een zoekopdracht bedoelen kan veranderen.

Dus het systeem moest meetbaar en bijwerkbaar zijn. Google leunde op constant testen — veranderingen uitproberen, meten of resultaten verbeterden, en herhalen. Die gewoonte van iteratie vormde de lange-termijnbenadering van het bedrijf voor “leersystemen”: behandel zoeken als iets dat je continu kunt evalueren, niet als éénmalig engineeringwerk.

Data als vliegwiel: leren van echt gebruik

Geweldig zoeken gaat niet alleen over slimme algoritmen — het gaat over de kwaliteit en hoeveelheid signalen waaruit die algoritmen kunnen leren.

Vroeg had Google een ingebouwd voordeel: het web zelf zit vol “stemmen” over wat belangrijk is. Links tussen pagina’s (de basis van PageRank) werken als citaties, en ankertekst (“klik hier” versus “beste wandelschoenen”) voegt betekenis toe. Daarbovenop helpen taalkundige patronen over pagina’s een systeem synoniemen, spelfouten en de vele manieren waarop mensen dezelfde vraag stellen te begrijpen.

De feedbackloop die compenseert

Als mensen op schaal een zoekmachine gaan gebruiken, creëert gebruik extra signalen:

- Klikken laten zien welke resultaten voor echte gebruikers relevant lijken voor een bepaalde zoekopdracht.

- “Lange klikken” versus snel teruggaan kan wijzen op tevredenheid.

- Herschrijvingen van zoekopdrachten (opnieuw zoeken met andere woorden) kunnen mismatches tussen intentie en resultaat onthullen.

Dit is het vliegwiel: betere resultaten trekken meer gebruik aan; meer gebruik creëert rijkere signalen; rijkere signalen verbeteren rangschikking en begrip; en die verbetering trekt weer meer gebruikers aan. In de loop van de tijd lijkt zoeken minder op een vaste set regels en meer op een leersysteem dat zich aanpast aan wat mensen echt nuttig vinden.

Waarom datavariëteit belangrijk is

Verschillende soorten data versterken elkaar. Linkstructuur kan autoriteit aan het licht brengen, terwijl klikgedrag huidige voorkeuren weerspiegelt, en taaldata helpt ambigue zoekopdrachten te interpreteren (“jaguar” het dier versus de auto). Samen maken ze het mogelijk om niet alleen te antwoorden op “welke pagina’s bevatten deze woorden”, maar op “wat is het beste antwoord voor deze intentie”.

Een woord over privacy

Dit vliegwiel roept vanzelfsprekend privacyvragen op. Openbare, goed gedocumenteerde berichtgeving heeft lang laten zien dat grote consumentproducten enorme interactiedata genereren, en dat bedrijven geaggregeerde signalen gebruiken om kwaliteit te verbeteren. Het is ook breed gedocumenteerd dat Google in de loop van de tijd in privacy- en beveiligingscontroles heeft geïnvesteerd, hoewel de details en effectiviteit onderwerp van discussie blijven.

De les is simpel: leren van echt gebruik is krachtig — en vertrouwen hangt af van hoe verantwoordelijk dat leren wordt behandeld.

De machine bouwen: infrastructuur die AI praktisch maakte

Google investeerde vroeg in gedistribueerd rekenen niet omdat het hip was — het was de enige manier om het rommelige schaalprobleem van het web bij te benen. Als je miljarden pagina’s wilt crawlen, ranglijsten vaak wilt bijwerken en queries binnen fracties van een seconde wilt beantwoorden, kun je niet op één supercomputer vertrouwen. Je hebt duizenden goedkopere machines nodig die samenwerken, met software die falen als normaal beschouwt.

Waarom gedistribueerd rekenen zo vroeg belangrijk was

Zoeken dwong Google systemen te bouwen die enorme hoeveelheden data betrouwbaar konden opslaan en verwerken. Dezelfde “veel computers, één systeem”-benadering werd de basis voor alles wat volgde: indexering, analyse, experimentatie en uiteindelijk machine learning.

De sleutelinzichten is dat infrastructuur niet losstaat van AI — het bepaalt wat voor modellen mogelijk zijn.

Hoe infrastructuur AI van demo naar product verandert

Een bruikbaar model trainen betekent het tonen van veel echte voorbeelden. Dat model bedienen betekent het draaien voor miljoenen mensen, direct, zonder storingen. Beide zijn “schaalproblemen”:

- Training heeft enorme rekenkracht nodig om data herhaaldelijk te verwerken.

- Serving heeft lage-latentie systemen nodig om voorspellingen snel te doen (vaak in milliseconden), zelfs tijdens piekverkeer.

Zodra je pipelines hebt gebouwd voor dataopslag, distributie van berekeningen, prestatiemonitoring en veilige uitrol van updates, kunnen leersystemen continu verbeteren in plaats van zeldzame, risicovolle herschrijvingen te zijn.

Simpele, alledaagse voorbeelden van “AI aangedreven door leidingen”

Een paar herkenbare features laten zien waarom de machine er toe deed:

- Spellingscorrectie: patronen opmerken zoals “restarant” → “restaurant” vereist leren van veel zoekopdrachten en klikken, en vervolgens direct correcties toepassen bij de zoekopdracht.

- Autocomplete: voorspellen wat je gaat typen hangt af van geaggregeerd gedrag en snelle inferentie — anders voelen suggesties traag en fout.

- Vertaling: betere vertaalkwaliteit komt van trainen op grote datasets en modellen die snel genoeg draaien voor gebruikers wereldwijd.

Googles langetermijnvoordeel was dus niet alleen slimme algoritmen — het was het bouwen van de operationele motor die algoritmen liet leren, uitrollen en verbeteren op internetschaal.

Van regels naar leren: hoe zoeken stilletjes “AI-achtiger” werd

Make infrastructure practical

Start een React-, Go- en PostgreSQL-app die echte metrics en iteraties kan ondersteunen.

Vroeg zag Google er al “slim” uit, maar veel van die intelligentie was geïngineerd: linkanalyse (PageRank), handmatig afgestemde signals en veel heuristieken tegen spam. In de loop van de tijd schoof het zwaartepunt van expliciet geschreven regels naar systemen die patronen uit data leerden — vooral over wat mensen bedoelen, niet alleen wat ze typen.

Hoe ML de ervaring van zoeken veranderde

Machine learning verbeterde geleidelijk drie dingen die alledaagse gebruikers merken:

- Rangschikkingskwaliteit: in plaats van signalen met vaste formules te wegen, leerden modellen welke combinaties signalen gebruikers tevreden stelden (gemeten via geanonimiseerd geaggregeerd gedrag en feedback van menselijke kwaliteitsbeoordelaars).

- Intentiebegrip: zoekopdrachten zoals “jaguar snelheid” of “apple support” dwongen modellen betekenis, context en ambiguïteit te infereren. Leerbased systemen werden beter in het koppelen van formuleringen aan concepten en waarschijnlijke doelen.

- Spam en betrouwbaarheid: naarmate contentfarms en manipulatieve SEO opschaalden, hielp ML onnatuurlijke linkpatronen, dunne content en andere tactieken te detecteren — ter ondersteuning van de bredere push naar hogere kwaliteit resultaten.

Een lezer-vriendelijke mijlpaaltijdlijn

- 1998: PageRank en het originele Google-paper leggen de basis voor relevantie via links.

- Begin jaren 2000: statistische spellingscorrectie en querysuggesties verbeteren “bedoelde je” en hervormuleringen.

- 2011: Panda richt zich op lagekwaliteit content; kwaliteitssignalen worden systematischer.

- 2012: Penguin straft linkmanipulatie af en duwt anti-spam voorbij handmatige regels.

- 2015: RankBrain (leercomponent voor rangschikking) helpt bij onbekende of ambigue zoekopdrachten.

- 2018–2019: neural matching en BERT brengen sterker taalbegrip, vooral voor langere queries en voorzetsels.

- 2021+: MUM-era multi-task modellen en “helpful content”-inspanningen duwen naar dieper intentie- en bruikbaarheidssignalen.

Bronnen die het waard zijn om te noemen

Voor geloofwaardigheid kun je een mix van primaire onderzoeken en publieke productuitleg citeren:

- Onderzoeksartikelen: Brin & Page (PageRank, 1998), BERT (Devlin et al., 2018).

- Officiële zoek-aankondigingen: Google Search blogposts over RankBrain, BERT, MUM, Panda/Penguin-updates.

- Sprekers/interviews/evenementen: Amit Singhal-interviews over rangschikkingsontwikkeling; Sundar Pichai-keynotes (Google I/O); “Search On”-evenementen voor moderne mijlpalen.

Onderzoekscultuur: van lange shots naar bruikbare systemen brengen

Googles lange termijnspel ging niet alleen over grote ideeën — het hing af van een onderzoekscultuur die academisch ogende papers in dingen kon veranderen die miljoenen mensen daadwerkelijk gebruikten. Dat betekende nieuwsgierigheid belonen, maar ook paden bouwen van prototype naar betrouwbaar product.

Van “publiceren” naar “uitrollen”

Veel bedrijven behandelen onderzoek als een apart eiland. Google pushte voor een strakkere lus: onderzoekers konden ambitieuze richtingen verkennen, resultaten publiceren en toch samenwerken met productteams die zich druk maakten om latency, betrouwbaarheid en gebruikervertrouwen. Wanneer die lus werkt, is een paper geen eindpunt — het is het begin van een sneller, beter systeem.

Een praktische manier om dit te zien is hoe modelideeën terugkomen in “kleine” features: betere spellingscorrectie, slimmer rangschikken, verbeterde aanbevelingen of vertalingen die minder letterlijk klinken. Elke stap kan incrementieel lijken, maar samen veranderen ze het gevoel van “zoeken”.

Landmark-projecten die het tempo bepaalden

Verschillende initiatieven werden symbolen van die papier-naar-product pijplijn. Google Brain hielp deep learning binnen het bedrijf te brengen door te laten zien dat het oudere benaderingen kon overtreffen als je genoeg data en rekenkracht had. Later maakte TensorFlow het makkelijker voor teams om modellen consistent te trainen en uit te rollen — een onopvallende maar cruciale bouwsteen voor het schalen van machine learning in veel producten.

Onderzoek aan neurale machinevertaling, spraakherkenning en visiesystemen verplaatste zich op vergelijkbare wijze van labresultaten naar dagelijkse ervaringen, vaak na meerdere iteraties die kwaliteit verbeterden en kosten verlaagden.

Waarom geduld telt

De opbrengstcurve is zelden onmiddellijk. Vroege versies kunnen duur, onnauwkeurig of moeilijk te integreren zijn. Het voordeel komt van het lang genoeg volhouden om infrastructuur te bouwen, feedback te verzamelen en het model te verfijnen totdat het betrouwbaar is.

Dat geduld — lange shots financieren, omwegen accepteren en jaren itereren — hielp ambitieuze AI-concepten omzetten in bruikbare systemen die mensen op Googles schaal konden vertrouwen.

Nieuwe inputs: spraak, beelden en video dwongen slimmere modellen af

Tekstzoekopdrachten beloonden slimme rangschikkingstrucs. Maar zodra Google spraak, foto’s en video ging verwerken, stuitte de oude aanpak op grenzen. Deze inputs zijn rommelig: accenten, achtergrondgeluid, onscherpe beelden, schokkerige filmpjes, straattaal en context die nergens is opgeschreven. Om ze bruikbaar te maken, had Google systemen nodig die patronen uit data konden leren in plaats van op handgeschreven regels te vertrouwen.

Spraak: geluid naar intentie omzetten

Bij spraakzoekopdrachten en Android-dictaat ging het doel niet alleen om woorden te transcriberen. Het was begrijpen wat iemand bedoelde — snel, op het apparaat of over haperende verbindingen.

Spraakherkenning duwde Google naar grootschalige machine learning omdat prestaties het meest verbeterden als modellen op enorme, diverse audiodatabases werden getraind. Die productdruk rechtvaardigde serieuze investeringen in compute (voor training), gespecialiseerde tooling (datapijplijnen, evaluatiesets, deployment-systemen) en mensen die modellen als levende producten konden itereren — niet als eenmalige onderzoeksdemo’s.

Foto’s: betekenis, niet metadata

Foto’s komen niet met trefwoorden. Gebruikers verwachten dat Google Photos “honden”, “strand” of “mijn reis naar Parijs” kan vinden, ook als ze nooit iets hebben getagd.

Die verwachting dwong sterker beeldbegrip af: objectdetectie, gezichtsclustering en similarity search. Wederom konden regels de variatie van het echte leven niet dekken, dus leersystemen werden de praktische weg. Verbeteren van nauwkeurigheid betekende meer gelabelde data, betere trainingsinfrastructuur en snellere experimentatiecycli.

Video en aanbevelingen: schaal legt zwaktes bloot

Video voegde een dubbele uitdaging toe: beelden over tijd plus audio. Gebruikers helpen op YouTube — zoek, ondertiteling, “Volgende”, en veiligheidsfilters — eiste modellen die konden generaliseren over onderwerpen en talen.

Aanbevelingen maakten de nood aan ML nog duidelijker. Wanneer miljarden gebruikers klikken, kijken, overslaan en terugkeren, moet het systeem continu aanpassen. Zulke feedbackloops beloonden investeringen in schaalbare training, metrics en talent om modellen te blijven verbeteren zonder vertrouwen te breken.

De AI-eerst pivot: AI als standaard, niet als feature

Turn research into product

Zet een gedeelde buildflow op die je team kan hergebruiken, meten en verfijnen in de tijd.

“AI-eerst” is het makkelijkst te begrijpen als een productbeslissing: in plaats van AI als een speciaal hulpmiddel erbij te zetten, behandel je het als onderdeel van de motor binnen alles wat mensen al gebruiken.

Google beschreef deze richting publiekelijk rond 2016–2017, als verschuiving van “mobile-first” naar “AI-first.” Het idee was niet dat elke feature plotseling “slim” werd, maar dat de standaardmanier waarop producten verbeteren steeds vaker via leersystemen zou lopen — rangschikking, aanbevelingen, spraakherkenning, vertaling en spamdetectie — in plaats van handmatig afgestelde regels.

AI in de kernlus

Concreet toont een AI-eerst aanpak zich wanneer de “kernlus” van een product stilletjes verandert:

- Zoekresultaten worden beter omdat het systeem patronen in queries en klikken leert, niet omdat een team duizenden if-then-regels handmatig toevoegt.

- Foto’s worden georganiseerd op basis van wat erop staat, niet alleen bestandsnamen en mappen.

- Gmail pakt meer ongewenste berichten door evoluerend gedrag te leren, niet alleen door bekende trefwoorden te matchen.

De gebruiker ziet misschien nooit een knop met “AI”. Ze merken gewoon minder foutieve resultaten, minder frictie en snellere antwoorden.

Assistenten verhoogden de lat voor natuurlijke taal

Spraakassistenten en conversatie-interfaces veranderden verwachtingen. Als mensen kunnen zeggen: “Herinner me eraan mama te bellen als ik thuis ben”, gaan ze verwachten dat software intentie, context en rommelige alledaagse taal begrijpt.

Dat duwde producten naar natuurlijke taalbegrip als basiscapaciteit — via spraak, typen en zelfs cameragebruik (je telefoon op iets richten en vragen wat het is). De pivot ging dus evenzeer over het tegemoetkomen aan nieuwe gebruikersgewoonten als over onderzoeksambities.

Belangrijk: “AI-eerst” is het beste te lezen als een richting — ondersteund door herhaalde publieke uitspraken en productstappen — in plaats van een bewering dat AI elke andere aanpak meteen verving.

Alphabet en het lange spel: ruimte voor weddenschappen buiten zoeken

De oprichting van Alphabet in 2015 was minder een rebranding en meer een operationele keuze: het mature, inkomsten genererende kernbedrijf (Google) scheiden van de riskantere, langere horizon-initiatieven (vaak “Other Bets” genoemd). Die structuur doet ertoe als je naar Larry Page’s AI-visie kijkt als een meerjarenproject in plaats van een enkele productcyclus.

Waarom “kern” en “weddenschappen” scheiden

Google Search, Ads, YouTube en Android vroegen om onophoudelijke uitvoering: betrouwbaarheid, kostenbeheer en consistente iteratie. Moonshots — zelfrijdende auto's, life sciences, connectiviteitsprojecten — hadden iets anders nodig: tolerantie voor onzekerheid, ruimte voor dure experimenten en de toestemming om fouten te maken.

Onder Alphabet kon de kern worden beheerd met heldere prestatieverwachtingen, terwijl weddenschappen konden worden beoordeeld op leerdoelen: “Hebben we een cruciale technische veronderstelling bewezen?” “Is het model genoeg verbeterd met echte data?” “Is het probleem überhaupt oplosbaar op acceptabele veiligheidsniveaus?”

De moonshot-logica: experimenteren als strategie

Deze lange-termijnmentaliteit gaat er niet van uit dat elk project slaagt. Het gaat ervan uit dat aanhoudend experimenteren is hoe je ontdekt wat later belangrijk zal zijn.

Een moonshot-fabriek zoals X is een goed voorbeeld: teams proberen gedurfde hypotheses, instrumenteren de resultaten en stoppen ideeën snel als het bewijs zwak is. Die discipline is bijzonder relevant voor AI, waar vooruitgang vaak afhangt van iteratie — betere data, betere trainingsopstellingen, betere evaluatie — niet slechts één doorbraak.

Wat je er zonder beloften uit kunt meenemen

Alphabet was geen garantie voor toekomstige successen. Het was een manier om twee verschillende werkritmes te beschermen:

- Houd de kernbusiness gefocust en verantwoordlijk.

- Creëer een expliciete thuisbasis voor hoog-variantie onderzoek en productweddenschappen.

Voor teams is de les structureel: wil je langetermijn AI-uitkomsten, ontwerp er dan voor. Scheid kortetermijnlevering van verkennend werk, financier experimenten als leermiddelen en meet vooruitgang in gevalideerde inzichten — niet alleen in koppen.

De moeilijke kanten: kwaliteit, veiligheid en vertrouwen op schaal

Get to production faster

Ga van chat naar deployment en hosting zodat je team eerder van echt gebruik kan leren.

Als AI-systemen miljarden queries bedienen, worden kleine foutpercentages dagelijkse koppen. Een model dat “meestal gelijk” heeft, kan nog steeds miljoenen misleiden — vooral op gezondheid, financiën, verkiezingen of breaking news. Op Google-schaal is kwaliteit geen luxe; het is een cumulatieve verantwoordelijkheid.

De kernafwegingen

Bias en representatie. Modellen leren patronen uit data, inclusief sociale en historische vooroordelen. “Neutrale” ranglijsten kunnen dominante standpunten versterken of minderheden en regio’s onderbedienen.

Fouten en overmoed. AI faalt vaak op manieren die klinken overtuigend. De meest schadelijke fouten zijn niet evidente bugs; het zijn plausibel klinkende antwoorden die gebruikers vertrouwen.

Veiligheid vs. bruikbaarheid. Strikte filters verminderen schade maar kunnen ook legitieme queries blokkeren. Zwakke filters verbeteren dekking maar verhogen het risico op oplichting, zelfbeschadiging of desinformatie.

Verantwoordingsplicht. Naarmate systemen meer geautomatiseerd worden, wordt het lastiger om basisvragen te beantwoorden: wie keurde dit gedrag goed? Hoe is het getest? Hoe kunnen gebruikers het betwisten of corrigeren?

Waarom opschalen de behoefte aan waarborgen vergroot

Opschalen vergroot mogelijkheden, maar ook:

- Het aantal edgecases (talen, culturen, gevoelige contexten)

- Incentives voor misbruik (spam, prompt-injectie, adversarial SEO)

- Moeilijkheden om fouten terug te draaien zodra ze in meerdere producten zitten

Daarom moeten waarborgen ook schaalbaar zijn: evaluatiesuites, red-teaming, beleidshandhaving, herkomst van bronnen en duidelijke gebruikersinterfaces die onzekerheid aangeven.

Een praktische checklist om AI-claims te beoordelen

Gebruik dit om elke “AI-aangedreven” feature te beoordelen — of die nu van Google is of van anderen:

- Wat is het faalpatroon? Tonen ze waar het breekt, niet alleen demo’s?

- Hoe wordt het gemeten? Zoek naar echte metrics (nauwkeurigheid, toxiciteitspercentages, hallucinatieratio’s), niet vage “verbeteringen”.

- Waarop is het getraind? Minimaal: brede categorieën, actualiteit en uitsluitingsbeleid.

- Welke waarborgen zijn er? Veiligheidsregels, menselijke reviewpaden en misbruikmonitoring.

- Kunnen gebruikers verifiëren? Citaten, bronnen of uitleg die je laten controleren.

- Hoe worden correcties afgehandeld? Duidelijke rapportage, snelle updates en auditmogelijkheden.

Vertrouwen wordt verdiend via herhaalbare processen — niet door één enkele doorbraakinspanning.

Lessen voor teams: hoe je langetermijn over AI denkt

Het meest overdraagbare patroon achter Googles lange boog is eenvoudig: duidelijke doelstelling → data → infrastructuur → iteratie. Je hebt niet Googles schaal nodig om de lus te gebruiken — je hebt discipline nodig over waar je op optimaliseert en een manier om van echt gebruik te leren zonder jezelf voor de gek te houden.

Het kernpatroon dat je kunt kopiëren

Begin met één meetbare gebruikersbelofte (snelheid, minder fouten, betere matches). Instrumenteer het zodat je uitkomsten kunt observeren. Bouw de minimale “machine” die je in staat stelt data te verzamelen, labelen en veilig verbeteringen uit te rollen. Itereer vervolgens in kleine, frequente stappen — behandel elke release als een leermogelijkheid.

Als je bottleneck simpelweg is om snel van “idee” naar “geïnstrumenteerd product” te komen, kunnen moderne bouwworkflows helpen. Bijvoorbeeld, Koder.ai is een vibe-coding platform waar teams web-, backend- of mobiele apps kunnen creëren vanuit een chatinterface — handig om snel een MVP op te zetten dat feedbackloops (duim omhoog/omlaag, meld een probleem, korte enquêtes) bevat zonder weken te wachten op een volledig maatwerktraject. Functies zoals planningmodus plus snapshots/rollback passen ook netjes bij het principe “experimenteer veilig, meet, iterate”.

6 inzichten voor leiders die toepasbaar zijn (zonder Google te zijn)

- Kies een heldere noordster die richting geeft. “Verbeter de zoekervaring” is duidelijker dan “adopteer AI.” Definieer succes in termen die mensen voelen.

- Ontwerp je product om leerdata te genereren. Voeg feedbackloops toe (duim omhoog/omlaag, correcties, “heeft dit geholpen?”) die intentie vastleggen, niet alleen klikken.

- Investeer vroeg in leidingen, niet alleen in modellen. Datakwaliteitschecks, evaluatiedashboards en deployment-workflows verslaan eenmalige prototypes.

- Behandel evaluatie als een productfeature. Maak een herhaalbare scorecard (kwaliteit, latentie, kosten, veiligheid) zodat iteratie geen giswerk wordt.

- Lever in plakken. Begin met smalle use cases, rol uit naar een klein publiek, meet en breid uit. Momentum verslaat big-bang-lanceringen.

- Maak lange weddenschappen overleefbaar. Reserveer een klein deel van de capaciteit voor experimenten, maar eis duidelijke leerdoelen om ze eerlijk te houden.

Gerelateerde lectuur

Als je praktische vervolgstappen wilt, zet deze titels op de leeslijst van je team:

- Basisprincipes van AI-strategie

- Data-flywheels voor productteams

- ML-modellen evalueren zonder PhD

- Lichte AI-governance