03 nov 2025·8 min

Leslie Lamport en gedistribueerde systemen: tijd, volgorde, correctheid

Leer Lamports kernideeën voor gedistribueerde systemen — logische klokken, ordening, consensus en correctheid — en waarom ze nog steeds moderne infrastructuur sturen.

Waarom Lamport nog steeds belangrijk is voor moderne gedistribueerde systemen

Leslie Lamport is een van die zeldzame onderzoekers wiens “theoretische” werk elke keer terugkomt zodra je een echt systeem uitrolt. Als je ooit een databasecluster, een message queue, een workflow-engine of iets hebt beheerd dat verzoeken opnieuw probeert en fouten overleeft, dan werk je met problemen waar Lamport bij heeft geholpen die te benoemen en op te lossen.

Wat zijn ideeën duurzaam maakt, is dat ze niet gebonden zijn aan een specifieke technologie. Ze beschrijven de ongemakkelijke waarheden die verschijnen wanneer meerdere machines proberen te doen alsof ze één systeem zijn: klokken wijken af, netwerken vertragen en laten berichten vallen, en fouten zijn normaal — niet uitzonderlijk.

Drie thema’s die we doorlopend gebruiken

Tijd: In een gedistribueerd systeem is “hoe laat is het?” geen eenvoudige vraag. Fysieke klokken lopen uiteen en de volgorde waarin je gebeurtenissen ziet kan verschillen tussen machines.

Ordening: Zodra je een enkele klok niet meer vertrouwt, heb je andere manieren nodig om te praten over welke gebeurtenissen eerst gebeurden — en wanneer je iedereen moet dwingen dezelfde volgorde te volgen.

Correctheid: “Het werkt meestal” is geen ontwerp. Lamport duwde het veld richting heldere definities (safety versus liveness) en specificaties waar je over kunt redeneren, niet alleen testen.

Wat je kunt verwachten (geen zware wiskunde)

We concentreren ons op concepten en intuïtie: de problemen, de minimale hulpmiddelen om helder te denken, en hoe die hulpmiddelen praktische ontwerpen vormen.

Hier is de kaart:

- Waarom geen gedeelde klok geen enkel, globaal verhaal van gebeurtenissen mogelijk maakt

- Hoe causaliteit ("happened-before") leidt tot logische klokken en Lamport-tijdstempels

- Wanneer een partiële ordening niet genoeg is en je één tijdlijn nodig hebt

- Hoe consensus en Paxos samenhangen met overeenstemming over een volgorde

- Waarom state machine-replicatie werkt als ordening gedeeld is

- Hoe je over correctheid praat in specificaties — en hoe modelleertools zoals TLA+ helpen

Het kernprobleem: geen gedeelde klok, geen enkele realiteit

Een systeem is “gedistribueerd” wanneer het uit meerdere machines bestaat die via een netwerk samenwerken om één taak te doen. Dat klinkt simpel totdat je twee feiten accepteert: machines kunnen onafhankelijk falen (partiële fouten), en het netwerk kan berichten vertragen, laten vallen, dupliceren of herschikken.

In één programma op één computer kun je meestal aanwijzen “wat er eerst gebeurde.” In een gedistribueerd systeem kunnen verschillende machines verschillende volgorden van gebeurtenissen waarnemen — en beide kunnen correct zijn vanuit hun lokale gezichtspunt.

Waarom je een globale klok niet kunt vertrouwen

Het is verleidelijk coördinatie op te lossen door alles te timen. Maar er is geen enkele klok waarop je kunt vertrouwen over machines heen:

- De hardwareklok van elke server drijft op zijn eigen tempo.

- Kloksynchronisatie (zoals NTP) is best-effort, geen garantie.

- Virtualisatie, CPU-belasting of pauzes kunnen tijd laten springen of stagneren.

Dus “gebeurtenis A gebeurde om 10:01:05.123” op de ene host vergelijkt niet betrouwbaar met “10:01:05.120” op een andere.

Hoe vertragingen de werkelijkheid verwarren

Netwerkvertragingen kunnen doen kantelen wat je dacht te zien. Een write kan eerst verzonden worden maar later aankomen. Een retry kan ná het origineel binnenkomen. Twee datacenters kunnen dezelfde aanvraag in tegengestelde order verwerken.

Dat maakt debuggen bijzonder verwarrend: logs van verschillende machines kunnen van mening verschillen, en "gesorteerd op timestamp" kan een verhaal creëren dat nooit echt gebeurde.

Reële gevolgen

Als je uitgaat van een enkele tijdlijn die niet bestaat, krijg je concrete falen:

- Dubbele verwerking (een betaling twee keer in rekening gebracht na retries)

- Inconsistenties (twee gebruikers claimen allebei “succesvol” het laatste item)

- Schijnbaar dataverlies (een later binnenkomende update overschrijft een nieuwere)

Lamports belangrijkste inzicht begint hier: als je tijd niet kunt delen, moet je op een andere manier over volgorde redeneren.

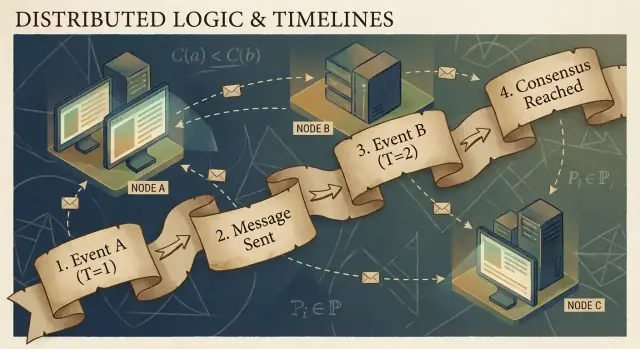

Causaliteit en de happened-before-relatie

Gedistribueerde programma’s bestaan uit gebeurtenissen: iets dat op een specifiek knooppunt plaatsvindt (een proces, server of thread). Voorbeelden zijn “ontving een verzoek”, “schreef een rij”, of “stuurde een bericht”. Een bericht is de verbinding tussen knooppunten: één gebeurtenis is het verzenden, een andere gebeurtenis is het ontvangen.

Lamport’s kerninzich is dat in een systeem zonder betrouwbare gedeelde klok, het meest betrouwbare dat je kunt bijhouden causaliteit is — welke gebeurtenissen andere gebeurtenissen hadden kunnen beïnvloeden.

De happened-before-relatie (→)

Lamport definieerde een eenvoudige regel genaamd happened-before, geschreven als A → B (gebeurtenis A gebeurde vóór gebeurtenis B):

- Volgorde op hetzelfde proces: Als A en B op hetzelfde proces/machine plaatsvinden, en A in dat proces vóór B plaatsvond, dan A → B.

- Berichtvolgorde: Als A “stuurde bericht m” is en B “ontving bericht m”, dan A → B.

- Transitiviteit: Als A → B en B → C, dan A → C.

Deze relatie geeft je een partiële ordening: het vertelt je dat sommige paren geordend zijn, maar niet alle.

Een concreet verhaal: gebruiker → verzoek → DB → cache

Een gebruiker klikt op “Koop”. Die klik triggert een verzoek naar een API-server (gebeurtenis A). De server schrijft een order-rij naar de database (gebeurtenis B). Nadat de write voltooid is, publiceert de server een “order created”-bericht (gebeurtenis C), en een cache-service ontvangt het en werkt een cache-entry bij (gebeurtenis D).

Hier geldt A → B → C → D. Zelfs als klokken niet overeenkomen, creëren het bericht- en programmastructuur echte causale verbanden.

Wat “concurrent” echt betekent

Twee gebeurtenissen zijn concurrent wanneer geen van beide de ander veroorzaakt: niet (A → B) en niet (B → A). Concurrency betekent niet “tegelijkertijd” — het betekent “er is geen causale pad tussen hen”. Daarom kunnen twee services allebei beweren dat ze “eerder” handelden, en beide kunnen gelijk hebben tenzij je een ordeningsregel toevoegt.

Logische klokken: Lamport-tijdstempels in gewone taal

Als je ooit hebt geprobeerd te reconstrueren “wat er eerst gebeurde” over meerdere machines, ben je het basale probleem tegengekomen: computers delen geen perfect gesynchroniseerde klok. Lamport’s workaround is om te stoppen met het najagen van perfecte tijd en in plaats daarvan volgorde bij te houden.

Het idee: een teller gekoppeld aan elke gebeurtenis

Een Lamport-tijdstempel is gewoon een nummer dat je aan elke relevante gebeurtenis in een proces hangt (een service-instantie, een node, een thread — wat je ook kiest). Zie het als een “gebeurtenistenteller” die je een consistente manier geeft om te zeggen: “deze gebeurtenis gebeurde vóór die”, zelfs als de wandklok onbetrouwbaar is.

De twee regels (en ze zijn echt zo simpel)

-

Lokaal verhogen: verhoog je lokale teller voordat je een gebeurtenis registreert (bijv. “schreef naar DB”, “verzond verzoek”, “append aan log”).

-

Bij ontvangst: neem max + 1: wanneer je een bericht ontvangt waar de timestamp van de zender in zit, zet je je teller op:

max(local_counter, received_counter) + 1

Stempel vervolgens de ontvangstevenement met die waarde.

Deze regels zorgen ervoor dat tijdstempels causaliteit respecteren: als gebeurtenis A B had kunnen beïnvloeden (omdat informatie via berichten stroomde), dan zal A’s tijdstempel kleiner zijn dan B’s.

Wat Lamport-tijdstempels wél en niet kunnen vertellen

Ze kunnen je iets vertellen over causale ordening:

- Als

TS(A) < TS(B), kan A mogelijk voor B hebben plaatsgevonden. - Als A B veroorzaakte (direct of indirect), dan is noodzakelijkerwijs

TS(A) < TS(B).

Ze kunnen je niet vertellen over echte tijd:

- Een lagere timestamp betekent niet “eerder in seconden”.

- Twee gebeurtenissen kunnen concurrent zijn (geen causale relatie) en toch verschillende tijdstempels hebben door berichtpatronen.

Dus Lamport-tijdstempels zijn geweldig voor ordening, niet voor het meten van latency of het beantwoorden van “hoe laat was het?”

Praktisch voorbeeld: logentries ordenen over services heen

Stel je voor dat Service A Service B aanroept en beide auditlogs schrijven. Je wilt één verenigd logoverzicht dat oorzaak-en-gevolg behoudt.

- Service A verhoogt zijn teller, logt “starting payment”, stuurt een verzoek naar B met timestamp 42.

- Service B ontvangt het verzoek met 42, zet zijn teller op

max(local, 42) + 1, zeg 43, en logt “validated card”. - B antwoordt met 44; A ontvangt, werkt bij naar 45, en logt “payment completed”.

Nu, wanneer je logs van beide services samenvoegt, geeft sorteren op (lamport_timestamp, service_id) je een stabiele, verklaarbare tijdlijn die overeenkomt met de daadwerkelijke keten van beïnvloeding — zelfs als wandklokken afwijken of het netwerk vertraagt.

Van partiële ordening naar totale ordening: wanneer je één tijdlijn nodig hebt

Causaliteit geeft je een partiële ordening: sommige gebeurtenissen zijn duidelijk “voor” andere (omdat een bericht of afhankelijkheid hen verbindt), maar veel gebeurtenissen zijn gewoon concurrent. Dat is geen bug — dat is de natuurlijke vorm van gedistribueerde realiteit.

Partiële ordening: genoeg voor veel vragen

Als je debugt “wat had dit kunnen beïnvloeden?”, of regels afdwingt zoals “een antwoord moet na het verzoek komen”, dan is partiële ordening precies wat je wilt. Je hoeft alleen de happened-before-edges te respecteren; alles daarbuiten kun je als onafhankelijk behandelen.

Totale ordening: vereist wanneer het systeem één verhaal moet kiezen

Sommige systemen kunnen niet leven met “beide orders zijn oké.” Ze hebben een enkele sequentie van operaties nodig, vooral voor:

- Schrijfs naar een gedeeld object (“stel balans in”, “update profiel”, “append aan log”)

- Commando’s die identiek op elke plek toegepast moeten worden (state machine-replicatie)

- Conflictresolutie waarbij “last write wins” voor elke node hetzelfde moet betekenen

Zonder totale ordening kunnen twee replicas beide lokaal “correct” zijn maar mondiaal uit elkaar lopen: de één past A dan B toe, de ander B dan A, en je krijgt verschillende uitkomsten.

Hoe krijg je één tijdlijn?

Je introduceert een mechanisme dat ordening creëert:

- Een sequencer/leader die aan elk commando een monoton toenemende positie toewijst.

- Of consensus (bijv. Paxos-achtige methodes) zodat het cluster het eens wordt over de volgende logentry, zelfs bij vertragingen en fouten.

De onvermijdelijke afwegingen

Een totale ordening is krachtig, maar je betaalt ervoor:

- Latentie: je wacht op coördinatie voordat je commit.

- Throughput: een enkele geordende log kan een bottleneck worden.

- Beschikbaarheid bij fouten: als je niet genoeg nodes kunt bereiken om het eens te worden, kan de voortgang pauzeren om correctheid te beschermen.

De ontwerpkeuze is eenvoudig te noemen: wanneer correctheid één gedeeld verhaal vereist, betaal je coördinatiekosten om dat verhaal te krijgen.

Consensus: overeenkomen ondanks vertraging en fouten

Behoud volledige eigendom

Stuur de gegenereerde broncode naar je repository zodra het ontwerp goed voelt.

Consensus is het probleem van meerdere machines op één lijn krijgen over één beslissing — één waarde om te committen, één leider om te volgen, één configuratie te activeren — ook al ziet elke machine alleen zijn eigen lokale gebeurtenissen en de berichten die toevallig binnenkomen.

Dat klinkt simpel totdat je je herinnert wat een gedistribueerd systeem mag doen: berichten kunnen vertraagd, gedupliceerd, herschikt of verloren gaan; machines kunnen crashen en herstarten; en je krijgt zelden een duidelijk signaal dat “deze node is definitief dood.” Consensus gaat over het veilig maken van overeenstemming onder die omstandigheden.

Waarom overeenstemming lastig is

Als twee nodes tijdelijk niet kunnen praten (een netwerkpartition), kan elke kant op eigen houtje “vooruitgaan”. Als beide zijden verschillende waarden besluiten, kun je split-brain krijgen: twee leiders, twee verschillende configuraties, of twee concurrerende geschiedenissen.

Zelfs zonder partitions veroorzaakt alleen vertraging problemen. Tegen de tijd dat een node over een voorstel hoort, kunnen andere nodes al verder zijn gegaan. Zonder gedeelde klok kun je niet betrouwbaar zeggen “voorstel A gebeurde vóór voorstel B” alleen omdat A een eerdere timestamp heeft — fysieke tijd is hier niet gezaghebbend.

Waar je consensus in echte systemen tegenkomt

Je noemt het misschien niet dagelijks “consensus”, maar het verschijnt in veel infrastructuurtaken:

- Leader election (wie heeft nu de leiding?)

- Gerepliceerde logs (wat is de volgende entry in de gedeelde geschiedenis?)

- Configuratiewijzigingen (welke set nodes mag stemmen/committen?)

In elk geval heeft het systeem één uitkomst nodig waarop iedereen kan convergeren, of ten minste een regel die voorkomt dat tegenstrijdige uitkomsten allebei als geldig worden beschouwd.

Paxos als Lamports antwoord

Lamport’s Paxos is een fundamentele oplossing voor dit “veilige overeenstemming”-probleem. Het belangrijkste idee is geen magische timeout of een perfecte leider — het zijn regels die ervoor zorgen dat slechts één waarde gekozen kan worden, zelfs wanneer berichten laat zijn en nodes falen.

Paxos scheidt safety (“nooit twee verschillende waarden kiezen”) van progress (“uiteindelijk iets kiezen”), waardoor het een praktisch blauwdruk is: je kunt tunen voor prestaties in de echte wereld terwijl je de kerngarantie intact houdt.

Paxos, zonder hoofdpijn: de kernintuïtie voor safety

Paxos heeft de reputatie onleesbaar te zijn, maar veel daarvan komt doordat “Paxos” geen enkel eenduidig algoritme is. Het is een familie van nauw verwante patronen om een groep het eens te laten worden, zelfs wanneer berichten vertraagd, gedupliceerd of machines tijdelijk uitvallen.

De rollen: proposers, acceptors en quorums

Een handig mentaal model scheidt wie voorstelt van wie valideert.

- Proposers proberen een waarde gekozen te krijgen (bijvoorbeeld: “de volgende logentry is X”).

- Acceptors stemmen over voorstellen.

- Een quorum is “genoeg acceptors” om vooruitgang te boeken — typisch een meerderheid.

De structurele gedachte om te onthouden: elke twee meerderheden overlapen. In die overlap woont safety.

Het safety-doel: nooit twee verschillende waarden beslissen

Paxos-safety is eenvoudig te formuleren: zodra het systeem een waarde beslist, moet het nooit een andere waarde besluiten — geen split-brain-beslissingen.

De kernintuïtie is dat voorstellen nummers (denk: stemrondes) dragen. Acceptors beloven oudere genummerde voorstellen te negeren zodra ze een nieuwer voorstel hebben gezien. En wanneer een proposer met een nieuw nummer probeert, vraagt hij eerst een quorum wat ze al hebben geaccepteerd.

Omdat quorums overlappen, zal een nieuwe proposer onvermijdelijk van minstens één acceptor horen die “zich de meest recent geaccepteerde waarde herinnert”. De regel is: als iemand in het quorum iets accepteerde, moet je dat waarde voorstellen (of de meest recente daarvan). Die beperking voorkomt dat twee verschillende waarden gekozen worden.

Liveness, in grote lijnen

Liveness betekent dat het systeem uiteindelijk iets beslist onder redelijke omstandigheden (bijv. een stabiele leider verschijnt en het netwerk levert uiteindelijk berichten). Paxos belooft geen snelheid in chaos; het belooft correctheid en voortgang zodra de situatie stabiliseert.

State machine-replicatie: correctheid door gedeelde ordening

Draai het als productie

Implementeer je prototype en houd het deelbaar terwijl je partitities en timeouts test.

State machine-replicatie (SMR) is het werkpaardpatroon achter veel "high availability"-systemen: in plaats van één server die beslissingen neemt, draai je meerdere replicas die allemaal dezelfde sequentie van commando’s verwerken.

Het idee van het gerepliceerde log

Centraal staat een gerepliceerd log: een geordende lijst commando’s zoals “put key=K value=V” of “transfer $10 van A naar B.” Clients sturen commando’s naar de groep, en het systeem wordt het eens over één volgorde voor die commando’s; daarna past elke replica ze lokaal toe.

Waarom ordening je correctheid geeft

Als elke replica vanuit dezelfde initiële staat begint en dezelfde commando’s in dezelfde volgorde uitvoert, eindigen ze in dezelfde staat. Dat is de kernintuïtie voor safety: je probeert meerdere machines niet te synchroniseren door tijd; je maakt ze identiek door determinisme en gedeelde ordening.

Dit is waarom consensus (zoals Paxos-/Raft-stijl protocollen) vaak met SMR gepaard gaat: consensus beslist de volgende logentry, en SMR zet die beslissing om in consistente staat over replicas.

Waar je het ziet in echte systemen

- Coördinatieservices (bijv. voor configuratie en leader election)

- Databases met gerepliceerde write-ahead logs

- Messagesystemen die strikte partitiewijziging vereisen

Praktische zaken die engineers niet mogen negeren

Het log groeit eindeloos tenzij je het beheert:

- Snapshots: leg periodiek de huidige staat vast zodat nieuwe nodes kunnen bijspringen zonder de hele geschiedenis af te spelen.

- Log compaction: gooi oude logentries veilig weg zodra ze in een snapshot zijn opgenomen en niet meer nodig.

- Lidmaatschapswijzigingen: het toevoegen/verwijderen van replicas moet ook geordend zijn, anders kunnen nodes van mening verschillen over wie “in de groep” zit, wat tot split-brain leidt.

SMR is geen magie; het is een gedisciplineerde manier om “overeenstemming over volgorde” te veranderen in “overeenstemming over staat”.

Correctheid: safety, liveness en het schrijven van een heldere spec

Gedistribueerde systemen falen op vreemde manieren: berichten komen laat aan, nodes herstarten, klokken wijken af, en netwerken splijten. “Correctheid” is geen gevoel — het zijn beloften die je precies kunt formuleren en vervolgens tegen elke situatie kunt controleren, inclusief fouten.

Safety versus liveness (met concrete voorbeelden)

Safety betekent “niets slechts gebeurt.” Voorbeeld: in een gerepliceerde key-value store mogen er nooit twee verschillende waarden voor dezelfde logindex gecommit worden. Een ander voorbeeld: een lock-service mag nooit hetzelfde slot gelijktijdig aan twee clients vergeven.

Liveness betekent “er gebeurt uiteindelijk iets goeds.” Voorbeeld: als een meerderheid van replicas up is en het netwerk uiteindelijk berichten levert, dan voltooit een write-request uiteindelijk. Een lock-aanvraag krijgt uiteindelijk ja of nee (geen oneindig wachten).

Safety gaat over het voorkomen van tegenstrijdigheden; liveness over het vermijden van permanente stilstand.

Invarianten: je non-negotiables

Een invariant is een conditie die altijd waar moet zijn, in elke bereikbare toestand. Bijvoorbeeld:

- “Elke logindex heeft hoogstens één committed waarde.”

- “Het termnummer van een leider neemt nooit af.”

Als een invariant geschonden kan worden tijdens een crash, timeout, retry of partition, dan was die invariant niet echt afgedwongen.

Wat een “bewijs” hier betekent

Een bewijs is een argument dat alle mogelijke uitvoeringen dekt, niet alleen het “normale pad.” Je redeneert over elk geval: berichtverlies, duplicatie, herschikking; nodecrashes en restarts; concurrerende leiders; clients die retryen.

Specs voorkomen verrassend gedrag

Een heldere specificatie definieert staat, toegestane acties en vereiste eigenschappen. Dat voorkomt dubbelzinnige verwachtingen zoals “het systeem moet consistent zijn” die kunnen leiden tot conflicterende aannames. Specs dwingen je te zeggen wat er gebeurt tijdens partitions, wat “commit” betekent en waarop clients kunnen rekenen — voordat productie je het moeilijke leert.

Van theorie naar praktijk: modelleren met TLA+

Een van Lamport’s meest praktische lessen is dat je een gedistribueerd protocol op een hoger niveau dan code kunt ontwerpen. Voordat je je druk maakt over threads, RPC’s en retry-lussen, kun je de regels van het systeem opschrijven: welke acties zijn toegestaan, welke staat kan veranderen en wat nooit mag gebeuren.

Waar TLA+ voor is

TLA+ is een specificatietaal en model-checking toolkit voor het beschrijven van concurrerende en gedistribueerde systemen. Je schrijft een eenvoudige, wiskunde-achtige model van je systeem — toestanden en transities — plus de eigenschappen die je belangrijk vindt (bijvoorbeeld “maximaal één leider” of “een committed entry verdwijnt nooit”).

Vervolgens verkent de modelchecker mogelijke interleavings, berichtvertragingen en fouten om een tegenvoorbeeld te vinden: een concrete reeks stappen die je eigenschap breekt. In plaats van ruis in vergaderingen krijg je een uitvoerbaar argument.

Een bug die een model kan vangen

Denk aan een “commit”-stap in een gerepliceerd log. In code is het makkelijk per ongeluk twee verschillende nodes toe te laten twee verschillende entries op dezelfde index te committen onder zeldzame timing.

Een TLA+-model kan een trace tonen zoals:

- Node A commit entry X op index 10 nadat hij van een quorum had gehoord.

- Node B (met verouderde data) vormt ook een quorum en commit entry Y op index 10.

Dat is een dubbele commit — een safety-violation die misschien maar eens per maand in productie optreedt, maar snel zichtbaar wordt onder exhaustief zoeken. Vergelijkbare modellen vangen vaak verloren updates, dubbele applies of “ack maar niet duurzaam” situaties.

Wanneer het de moeite waard is om te modelleren

TLA+ is het meest waardevol voor kritische coördinatielogica: leader election, lidmaatschapswijzigingen, consensus-achtige flows en elk protocol waar ordening en foutafhandeling interacteren. Als een bug data zou corrumperen of handmatige recovery vereist, is een klein model meestal goedkoper dan het later debuggen.

Als je intern tooling rond deze ideeën bouwt, is een praktische workflow om eerst een lichte spec te schrijven (zelfs informeel), dan het systeem te implementeren en tests uit de invarianten van het spec te genereren. Platforms zoals Koder.ai kunnen hier helpen door de build-test-loop te versnellen: je kunt bedoeld ordering/consensus-gedrag in gewone taal beschrijven, itereren op service-scaffolding (React-frontends, Go-backends met PostgreSQL of Flutter-clients) en “wat nooit mag gebeuren” zichtbaar houden tijdens het uitrollen.

Praktische conclusies voor bouwen en opereren van betrouwbare systemen

Voeg een control panel toe

Maak een Flutter-adminclient om logs, traces en replica-state overal te inspecteren.

Lamport’s grootste gift aan praktijkmensen is een mindset: behandel tijd en ordening als data die je modeleert, niet als aannames die je van de wandklok erft. Die mindset vertaalt zich in gewoontes die je direct kunt toepassen.

Theorie omzetten in dagelijkse engineeringpraktijken

Als berichten vertraagd, gedupliceerd of uit volgorde kunnen aankomen, ontwerp elke interactie om onder die condities veilig te zijn.

- Idempotentie als default: zorg dat “doe het nogmaals” onschadelijk is. Gebruik idempotency-keys voor betalingen, provisioning of elke write die je mogelijk opnieuw probeert.

- Retries met deduplicatie: retries zijn nodig, maar zonder dedup creëer je double-writes. Houd request-IDs bij en sla een “al verwerkt”-marker op.

- At-least-once delivery + exactly-once effecten: accepteer dat het netwerk mogelijk twee keer levert; zorg dat je toestandveranderingen dat niet doen.

Wees voorzichtig met timeouts en klokken

Timeouts zijn geen waarheid; het zijn beleid. Een timeout vertelt je alleen “ik hoorde niet op tijd terug”, niet “de andere kant heeft niet gehandeld.” Twee concrete implicaties:

- Behandel een timeout niet als een definitief falen. Ontwerp compensatie- en reconciliatiepaden.

- Vermijd het gebruiken van lokale kloktijd om gebeurtenissen over nodes heen te ordenen. Gebruik sequentienummers, monotone tellers of expliciete causale metadata (bijv. “deze update vervangt versie X”).

Observability die causaliteit respecteert

Goede debuggingtools coderen ordening, niet alleen timestamps.

- Trace-IDs overal: draag een correlatie-/trace-ID door elke hop en logregel.

- Causale aanwijzingen in logs: log bericht-ID’s, ouder-request-ID’s en “wat ik dacht de laatste versie te zijn” bij het nemen van beslissingen.

- Deterministische replays: neem inputs (commando’s) op zodat je gedrag kunt herhalen en bevestigen of een bug timing-afhankelijk of logica-afhankelijk is.

Ontwerpvragen om te stellen vóór je uitrolt

Voordat je een gedistribueerde feature toevoegt, dwing duidelijkheid af met een paar vragen:

- Wat gebeurt er als hetzelfde verzoek twee keer verwerkt wordt?

- Welke ordening hebben we nodig (indien aanwezig), en waar wordt die afgedwongen?

- Welke fouten zijn “veilig” (geen slechte staat) vs. “luid” (zichtbaar voor gebruiker) vs. “stil” (verborgen corruptie)?

- Wat is het herstelpad na een partiële storing of netwerk-splitsing?

- Wat loggen we om het happened-before-verhaal in productie te reconstrueren?

Deze vragen hebben geen doctoraat nodig — alleen de discipline om ordening en correctheid als eersteklas productvereisten te behandelen.

Conclusie en voorgestelde vervolgstappen

Lamport’s blijvende gift is een manier om helder te denken wanneer systemen geen klok delen en niet automatisch overeenkomen over “wat er gebeurde”. In plaats van perfecte tijd na te jagen, volg je causaliteit (wat wat had kunnen beïnvloeden), representeren dat met logische tijd (Lamport-tijdstempels) en — wanneer het product één geschiedenis vereist — bouw je overeenstemming (consensus) zodat elke replica dezelfde reeks beslissingen toepast.

Die draad leidt tot een praktische engineeringmindset:

Eerst specificeren, dan bouwen

Schrijf de regels op die je nodig hebt: wat nooit mag gebeuren (safety) en wat uiteindelijk moet gebeuren (liveness). Implementeer vervolgens volgens dat spec en test het systeem onder vertraging, partitions, retries, dubbele berichten en node-restarts. Veel “mystery outages” zijn eigenlijk ontbrekende uitspraken zoals “een verzoek kan twee keer verwerkt worden” of “leiders kunnen op elk moment wisselen.”

Leer verder, met gerichte stappen

Als je dieper wilt gaan zonder te verdrinken in formalisme:

- Lees Lamport’s “Time, Clocks, and the Ordering of Events in a Distributed System” om happened-before te internaliseren.

- Scan “Paxos Made Simple” voor de safety-intuïtie: zodra een waarde gekozen is, kan voortgang die waarde niet tegenwerken.

- Bekijk een TLA+-introductie en modelleer daarna een klein protocol (een lock-service of een register met twee replicas) en check het.

Probeer één hands-on oefening

Kies een component dat je beheert en schrijf een eendelige “failure contract”: wat je aanneemt over netwerk en opslag, welke operaties idempotent zijn en welke ordeningsgaranties je biedt.

Wil je dit concreter maken, bouw dan een kleine “ordering demo”-service: een request-API die commando’s naar een log append, een achtergrondworker die ze toepast, plus een admin-view die causale metadata en retries toont. Dit doen op Koder.ai kan een snelle manier zijn om te itereren — vooral als je snelle scaffolding, hosting, snapshots/rollback voor experimenten en source-code-export wilt zodra je tevreden bent.

Goed gedaan toegepast, verminderen deze ideeën storingen omdat minder gedrag impliciet is. Ze maken ook redeneren eenvoudiger: je stopt met ruzie over tijd en begint te bewijzen wat ordening, overeenstemming en correctheid daadwerkelijk betekenen voor jouw systeem.