Hoe “schonere architectuur” eruitziet bij AI‑ondersteund werk

“Schonere architectuur” in dit artikel betekent niet een specifiek framework of een perfect diagram. Het betekent dat je het systeem eenvoudig kunt uitleggen, dat je het kunt wijzigen zonder ongerelateerde delen te breken, en dat je gedrag kunt verifiëren zonder heroïsche testinspanningen.

Een praktische definitie: duidelijkheid, modulariteit, testbaarheid

Duidelijkheid betekent dat het doel en de vorm van het systeem duidelijk zijn uit een korte omschrijving: wat het doet, wie het gebruikt, welke data het verwerkt en wat het nooit mag doen. Bij AI‑ondersteund werk betekent duidelijkheid ook dat het model requirements op een manier kan herformuleren die jij zou goedkeuren.

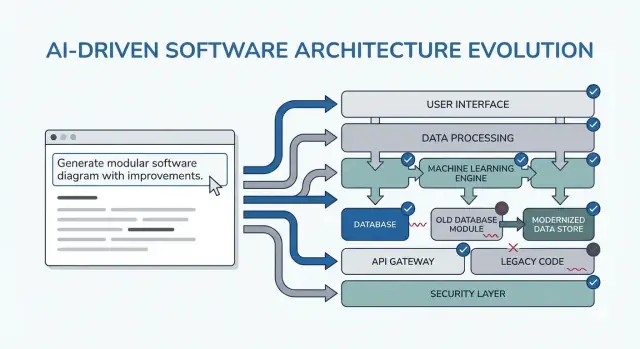

Modulariteit betekent dat verantwoordelijkheden duidelijke grenzen hebben. Elke module heeft een taak, inputs/outputs en minimale kennis van interne details van andere modules. Wanneer AI code genereert, voorkomt modulariteit dat businessregels over controllers, UI en data‑toegang worden verspreid.

Testbaarheid betekent dat de architectuur het “aantonen dat het werkt” goedkoop maakt. Businessregels kunnen getest worden zonder een volledig draaiend systeem en integratietests richten zich op een paar contracten in plaats van elk code‑pad.

Waarom herschrijvingen gebeuren (en waarom AI ze kan versterken)

Herschrijvingen worden meestal niet veroorzaakt door “slechte code” maar door ontbrekende constraints, vage scope en verborgen aannames. Voorbeelden:

- Een feature wordt gebouwd voor één type gebruiker, en later ontdek je dat er drie rollen zijn met verschillende permissies.

- Performance, audit‑logging of dataretentievereisten duiken pas laat op.

- Een externe API gedraagt zich anders dan verwacht, waardoor wijzigingen overal nodig zijn.

AI kan dit faalpatroon versnellen doordat het snel overtuigende output levert, waardoor je makkelijk bouwt op wankele fundamenten.

Wat je van de patronen in deze gids mag verwachten

De patronen hieronder zijn templates om aan te passen, geen magische prompts. Hun echte doel is om vroeg de juiste gesprekken af te dwingen: constraints verduidelijken, opties vergelijken, aannames documenteren en contracten definiëren. Als je dat denkwerk overslaat, vult het model de lege plekken en betaal je daar later voor.

Waar deze patronen in je workflow passen

Je gebruikt ze tijdens de hele leveringscyclus:

- Planning: verscherp requirements en succescriteria

- Ontwerp: kies grenzen, datastromen en contracten

- Coderen: houd verantwoordelijkheden gescheiden terwijl de implementatie groeit

- Review: vang risico's en mismatches voordat ze herschrijvingen veroorzaken

Als je een vibe‑coding workflow gebruikt (waar het systeem via chat wordt gegenereerd en geïtereerd), zijn deze checkpoints nog belangrijker. Bijvoorbeeld, in Koder.ai kun je een "planning mode" loop draaien om requirements en contracten vast te leggen voordat je React/Go/PostgreSQL code genereert, en vervolgens snapshots/rollback gebruiken om veilig te itereren wanneer aannames veranderen—zonder dat elke wijziging in een herschrijving uitmondt.

Hoe je prompting‑patronen gebruikt zonder meer werk te creëren

Prompting‑patronen zijn het meest waardevol wanneer ze de besluitvorming verminderen. Het geheim is ze als korte, herhaalbare checkpoints te gebruiken—voordat je code schrijft, tijdens ontwerp en tijdens review—zodat de AI artefacten produceert die je opnieuw kunt gebruiken, niet extra tekst waar je doorheen moet ploegen.

Wanneer je patronen gebruikt

Voor het coderen: draai één "alignment"‑loop om doelen, gebruikers, constraints en succescriteria te bevestigen.

Tijdens ontwerp: gebruik patronen die expliciete afwegingen afdwingen (bijv. alternatieven, risico's, databoundaries) voordat je begint met implementeren.

Tijdens review: gebruik een checklist‑achtige prompt om hiaten te vinden (randgevallen, monitoring, security, performance) terwijl veranderingen nog goedkoop zijn.

Je krijgt beter output met een klein, consistent input‑pakket:

- Doelen: wat “klaar” betekent (latency targets, UX‑uitkomsten, kostenlimieten)

- Gebruikers: rollen, kernworkflows en belangrijkste pijnpunten

- Constraints: techstack, deadlines, compliance/security vereisten

- Data & integraties: bronnen, eigenaarschap, APIs, derde partijen

Als je iets niet weet, zeg het expliciet en vraag de AI om aannames te benoemen.

In plaats van “leg het ontwerp uit,” vraag artefacten die je in docs of tickets kunt plakken:

- Een decision log (opties → voor/tegen → gekozen → waarom)

- Een tabel van componenten met verantwoordelijkheden en grenzen

- Een checklist voor betrouwbaarheid en testen

- Een eenvoudige diagramomschrijving (bijv. Mermaid‑tekst) die je later kunt renderen

Iterate in korte loops met acceptatiecriteria

Doe 10–15 minuten loops: prompt → skim → aanscherpen. Neem altijd acceptatiecriteria op (wat waar moet zijn om het ontwerp acceptabel te maken) en vraag de AI om zichzelf daartegen te controleren. Dat voorkomt eindeloze redesign en maakt de patronen in de volgende secties snel toepasbaar.

Patroon 1: Verduidelijk de requirements vóór enig ontwerp

De meeste “architectuurherschrijvingen” worden niet veroorzaakt door slechte diagrammen maar door het bouwen van het juiste ding voor het verkeerde (of onvolledige) probleem. Als je vroeg een LLM gebruikt, vraag dan niet meteen om architectuur. Laat het ambiguïteit blootleggen.

De prompting‑zet: verander onzekerheid in een checklist

Gebruik het model als requirements‑interviewer. Je doel is een korte, geprioriteerde spec die je kunt bevestigen voordat iemand componenten ontwerpt, databases kiest of APIs vastlegt.

Hier is een copy‑paste template die je hergebruiken kunt:

You are my requirements analyst. Before proposing any architecture, do this:

1) Ask 10–15 clarifying questions about missing requirements and assumptions.

- Group questions by: users, workflows, data, integrations, security/compliance, scale, operations.

2) Produce a prioritized scope list:

- Must-have

- Nice-to-have

- Explicitly out-of-scope

3) List constraints I must confirm:

- Performance (latency/throughput targets)

- Cost limits

- Security/privacy

- Compliance (e.g., SOC2, HIPAA, GDPR)

- Timeline and team size

4) End with: “Restate the final spec in exactly 10 bullets for confirmation.”

Context:

- Product idea:

- Target users:

- Success metrics:

- Existing systems (if any):

Waar je op moet letten in de output

Je wilt vragen die beslissingen afdwingen (geen generieke “vertel meer”), plus een must‑have lijst die binnen je tijdlijn afgevinkt kan worden.

Behandel de “10 bullets” herformulering als een contract: plak het in je ticket/PRD, vraag stakeholders om een snelle ja/nee en ga pas daarna door naar architectuur. Deze ene stap voorkomt de meest voorkomende oorzaak van late refactors: bouwen aan features die nooit echt vereist waren.

Patroon 2: Eerst user journeys, dan technische keuzes

Als je begint met tools (“Moeten we event sourcing gebruiken?”) ontwerp je vaak voor de architectuur in plaats van voor de gebruiker. Een snellere weg naar schone structuur is de AI eerst user journeys in eenvoudige taal te laten beschrijven en pas daarna die journeys te vertalen naar componenten, data en APIs.

Een eenvoudig journey‑first prompt template

Gebruik dit als copy‑paste startpunt:

- Rollen: user / admin / system

- Kernactions: wat elke rol probeert te bereiken

- Randgevallen: wat er fout kan gaan (ongeldige input, ontbrekende permissies, gedeeltelijke afhandeling)

Vraag dan:

-

“Beschrijf de stap‑voor‑stap flow voor elke actie in eenvoudige taal.”

-

“Geef een eenvoudige statusdiagram‑beschrijving of statuslijst (bijv. Draft → Submitted → Approved → Archived).”

-

“Noem non‑happy‑path scenario's: timeouts, retries, dubbele requests, annuleringen en ongeldige inputs.”

Journeys naar beslissingen (zonder voorbarig te zijn)

Als de flows duidelijk zijn, kun je de AI vragen ze te mappen naar technische keuzes:

- Waar hebben we validatie nodig vs businessregels?

- Welke stappen vereisen idempotentie (veilige retries)?

- Welke data moet opgeslagen worden, wat kan afgeleid worden en wat heeft een audittrail nodig?

Pas daarna vraag je om een architectuurschets (services/modules, grenzen en verantwoordelijkheden) die direct gekoppeld is aan de flowstappen.

Zet flows om in testbare acceptatiecriteria

Laat de AI elke journey omzetten in acceptatiecriteria die je echt kunt testen:

- “Given/When/Then voor elke stap en faalgeval.”

- “Wat moet het systeem teruggeven of tonen?”

- “Wat moet gelogd worden, en wat moet een retry triggeren versus een gebruikersfout?”

Dit patroon vermindert herschrijvingen omdat de architectuur uit gebruikersgedrag groeit—niet uit aannames over technologie.

Patroon 3: Assumptielog om verrassende herschrijvingen te voorkomen

De meeste architectuurherschrijvingen worden niet veroorzaakt door “slecht ontwerp” maar door verborgen aannames die onjuist blijken. Als je een LLM om architectuur vraagt, vult het vaak gaten met plausibele gissingen. Een assumptielog maakt die gissingen vroeg zichtbaar, wanneer veranderingen goedkoop zijn.

Wat je het model moet vragen

Je doel is een duidelijke scheiding tussen feiten die je gaf en aannames die het maakte.

Gebruik dit promptpatroon:

Template prompt

“Before proposing any solution: list your assumptions. Mark each as validated (explicitly stated by me) or unknown (you inferred it). For each unknown assumption, propose a fast way to validate it (question to ask, metric to check, or quick experiment). Then design based only on validated assumptions, and call out where unknowns could change the design.”

Houd het kort zodat mensen het echt gebruiken:

- Assumption: …

- Status: validated / unknown

- Why it matters: welke beslissing het beïnvloedt

- How to validate: vraag, check of spike

- If wrong, likely change: wat je zou herontwerpen

“Wat zou je antwoord veranderen?” triggers

Voeg één regel toe die het model dwingt zijn kantelpunten te noemen:

- “List 5 triggers: what would change your answer? (bijv. gebruikersvolume, latency‑targets, compliance‑behoeften, dataretentieregels).”

Dit patroon verandert architectuur in een set conditionele beslissingen. Je krijgt niet alleen een diagram—je krijgt een kaart van wat bevestigd moet worden voordat je je commit.

Patroon 4: Vergelijk meerdere architecturen vóór je kiest

Maak een full‑stack app

Genereer een React-webapp met een Go-backend en PostgreSQL vanuit één chatflow.

AI‑tools zijn goed in het produceren van één “beste” ontwerp—maar dat is vaak slechts de eerste plausibele optie. Schonere architectuur verschijnt vaak als je vroeg een vergelijking afdwingt, terwijl veranderingen nog goedkoop zijn.

De kernprompt template

Gebruik een prompt die meerdere architecturen vereist en een gestructureerde tradeoff‑tabel:

Propose 2–3 viable architectures for this project.

Compare them in a table with criteria: complexity, reliability, time-to-ship, scalability, cost.

Then recommend one option for our constraints and explain why it wins.

Finally, list “what we are NOT building” in this iteration to keep scope stable.

Context:

- Users and key journeys:

- Constraints (team size, deadlines, budget, compliance):

- Expected load and growth:

- Current systems we must integrate with:

Waarom dit herschrijvingen vermindert

Een vergelijking dwingt het model (en jou) om verborgen aannames naar boven te halen: waar state leeft, hoe services communiceren, wat synchroon moet zijn en wat kan worden vertraagd.

De criteriatabel is belangrijk omdat die discussies als “microservices vs monolith” ontwijkt en de beslissing ankert aan wat jullie echt belangrijk vinden—snel leveren, minder operationele overhead of betere betrouwbaarheid.

Vereis een aanbeveling en een grens

Accepteer geen “het hangt ervan af.” Vraag om een duidelijke aanbeveling en specifieke constraints waarop die optimaliseert.

Eis ook “wat we in deze iteratie NIET bouwen.” Voorbeelden: “Geen multi‑region failover”, “Geen plugin‑systeem”, “Geen realtime notificaties.” Dit voorkomt dat de architectuur stiekem uitbreidt om features te ondersteunen waar je nog niet voor hebt gekozen—en voorkomt verrassende herschrijvingen als de scope later verandert.

Patroon 5: Modular boundaries en verantwoordelijkheden

De meeste herschrijvingen gebeuren omdat grenzen vaag zijn: alles raakt alles, en een kleine wijziging verspreidt zich door de codebase. Dit patroon gebruikt prompts die vóór elke framework‑ of class‑discussie heldere module‑eigenaarship afdwingen.

Het kernidee

Vraag de AI modules en verantwoordelijkheden te definiëren, plus wat uitdrukkelijk niet in elke module hoort. Vraag vervolgens interfaces (inputs/outputs) en dependency‑regels, geen bouwplan of implementatiedetails.

Copy‑paste prompt template

Gebruik dit wanneer je een nieuwe feature schetst of een rommelig gebied refactort:

- Context: <één alinea over het product/feature>

- Doel: Stel een modulair ontwerp voor met 4–8 modules.

-

Noem modules met:

- Doel (1 zin)

- Verantwoordelijkheden (3–5 bullets)

- Non‑verantwoordelijkheden (“HANDLEt NIET…”) (2–3 bullets)

-

Definieer voor elke module alleen interfaces:

- Inputs (events/requests/data)

- Outputs (responses/events/side effects)

- Publieke API‑surface (functie‑ of endpointnamen ok; geen interne classes)

-

Dependency‑regels:

- Toegestane afhankelijkheden (A → B)

- Verboden afhankelijkheden (A ↛ C) met motivatie

- Waar gedeelde types leven (en wat NOOIT gedeeld mag worden)

-

Future change test: Gegeven deze waarschijnlijke wijzigingen: <lijst 3>, laat zien welke enkele module elke wijziging moet opvangen en waarom.

Hoe goede output eruitziet

Doel is modules die je in onder een minuut aan een collega kunt uitleggen. Als het model een “Utils”‑module voorstelt of businessregels in controllers schuift, duw terug: “Verplaats beslissingen naar een domeinmodule en houd adapters dun.”

Als je klaar bent, heb je grenzen die toekomstige vereisten overleven—omdat wijzigingen een duidelijke plek hebben en dependency‑regels accidentele koppeling voorkomen.

Patroon 6: Data & API‑contract eerst (vermijd integratie‑herwerk)

Integratie‑herwerk wordt vaak niet veroorzaakt door “slechte code” maar door onduidelijke contracten. Als datamodel en API‑shapes laat worden besloten, vult elk team (of elke module) de lege plekken op zijn eigen manier en besteed je de volgende sprint aan het reconciliëren van mismatchende aannames.

Begin door contracten te vragen voordat je praat over frameworks, databases of microservices. Een duidelijk contract wordt de gedeelde referentie die UI, backend en datapunten op één lijn houdt.

Het contract‑first prompt

Gebruik deze vroege prompt met je AI‑assistent:

- Template: “Beschrijf het datamodel, eigenaarschap en lifecycle voor elke entiteit”

Volg dat direct met:

- Vraag API‑contracten met voorbeelden (requests, responses, error‑shapes)

- Voeg versionering en backwards‑compatibility verwachtingen toe

- Vraag validatieregels en edge cases per veld

Wat goede output is

Je wilt concrete artefacten, geen prose. Bijvoorbeeld:

- Entiteit:

Subscription

- Owner: Billing service

- Lifecycle: created on checkout → active → past_due → canceled (soft-delete after 90 days)

- Source of truth: billing DB; andere services cachen read‑only kopieën

En een API‑schets:

POST /v1/subscriptions

{

"customer_id": "cus_123",

"plan_id": "pro_monthly",

"start_date": "2026-01-01"

}

201 Created

{

"id": "sub_456",

"status": "active",

"current_period_end": "2026-02-01"

}

422 Unprocessable Entity

{

"error": {

"code": "VALIDATION_ERROR",

"message": "start_date must be today or later",

"fields": {"start_date": "in_past"}

}

}

Versionering en compatibiliteitsregels

Laat de AI regels noemen zoals: “Additieve velden zijn toegestaan zonder versie‑bump; hernoemingen vereisen /v2; clients moeten onbekende velden negeren.” Deze ene stap voorkomt stille breaking changes—en de herschrijvingen die daarop volgen.

Patroon 7: Faalmodi en betrouwbaarheid‑checklist

Krijg meer build‑credits

Maak content over Koder.ai of verwijs collega's en verdien credits terwijl je bouwt.

Architecturen worden herschreven wanneer “happy path” ontwerpen echte traffic, flauwe afhankelijkheden en onverwacht gebruikersgedrag ontmoeten. Dit patroon maakt betrouwbaarheid een expliciet ontwerpresultaat, niet iets voor na de lancering.

Copy/paste prompt template

Gebruik dit met je gekozen architectuurbeschrijving:

List failure modes; propose mitigations; define observability signals.

For each failure mode:

- What triggers it?

- User impact (what the user experiences)

- Mitigation (design + operational)

- Retries, idempotency, rate limits, timeouts considerations

- Observability: logs/metrics/traces + alert thresholds

Wat je het model moet laten behandelen (niet onderhandelbaar)

Noem interfaces die kunnen falen: externe APIs, database, queues, auth provider en achtergrondjobs. Vereis concrete beslissingen:

- Retries: wanneer herhalen, hoeveel keren, backoff‑strategie en welke fouten retryable zijn.

- Idempotentie: idempotency keys, dedupe‑windows en welke state veilig te replayen is.

- Rate limits: per gebruiker/IP/service limieten, client‑melding en server‑bescherming.

- Timeouts: per dependency, totaal request‑budget en propagatie van annulering.

Betrouwbaarheidschecklist output

Eindig de prompt met: “Return a simple checklist we can review in 2 minutes.” Een goede checklist bevat items zoals: dependency timeouts ingesteld, retries begrensd, idempotentie geïmplementeerd voor create/charge acties, backpressure/rate limiting aanwezig, graceful degradation pad gedefinieerd.

Observability gekoppeld aan gebruikersacties

Vraag events rond gebruikersmomenten (niet alleen systeemintern): “user_signed_up”, “checkout_submitted”, “payment_confirmed”, “report_generated”. Voor elk, vraag om:

- Logvelden (user_id, request_id, idempotency_key)

- Metrics (succespercentage, latency p95/p99, retry‑aantal)

- Traces (spans per dependency call)

Dit maakt betrouwbaarheid tot een ontwerpartefact dat je kunt valideren voordat er code bestaat.

Patroon 8: MVP‑slice planning om overbuilding te verminderen

Een veelvoorkomende manier waarop AI‑ondersteund ontwerp herschrijvingen creëert, is door te vroeg een “complete” architectuur te stimuleren. De oplossing is eenvoudig: forceer dat het plan begint met de kleinste bruikbare slice—één die waarde levert, het ontwerp test en toekomstige opties openhoudt.

De prompt template

Gebruik dit wanneer het oplossingidee sneller uitbreidt dan de requirements:

Template: “Propose the smallest usable slice; define success metrics; list follow‑ups.”

Vraag het model te antwoorden met:

- MVP slice: wat er bij zit om iets echt te kunnen uitrollen

- Succesmetrics: hoe je weet of het werkte (gebruikersgericht + technisch)

- Follow‑ups: wat kan wachten zonder het leren te blokkeren

Eisen een gefaseerde roadmap (MVP → v1 → v2)

Voeg een tweede instructie toe: “Give a phased roadmap: MVP → v1 → v2, and explain what risk each phase reduces.” Dit houdt latere ideeën zichtbaar zonder ze in de eerste release te dwingen.

Voorbeelden van gewenste uitkomsten:

- MVP valideert de kernworkflow en een dunne end‑to‑end pad.

- v1 verhardt betrouwbaarheid, voegt missende “must‑have” bruikbaarheid toe.

- v2 breidt de breedte uit (meer integraties, geavanceerde rollen, optimalisaties).

Vereis expliciete uitsluitingen om scope creep te voorkomen

De krachtigste regel in dit patroon is: “List what is explicitly out of scope for MVP.” Uitsluitingen beschermen architectuurbeslissingen tegen voortijdige complexiteit.

Goede uitsluitingen zien eruit als:

- “Geen multi‑region failover in MVP (log incidenten; plan voor v2).”

- “Geen plugin‑systeem nog (houd grenzen schoon, maar lever vaste modules).”

- “Slechts één paymentprovider; abstracteer later als dat nodig blijkt.”

Zet het plan om in tickets met afhankelijkheden

Tot slot: “Convert the MVP into tickets, each with acceptance criteria and dependencies.” Dit dwingt duidelijkheid af en onthult verborgen koppelingen.

Een degelijke ticketopdeling bevat doorgaans:

- Een dunne end‑to‑end “happy path”\n2) Minimaal datamodel + API‑contract\n3) Basisfoutafhandeling en logging\n4) Eén integratiepunt (indien nodig) met een gestubde fallback

Als je wilt, laat het model outputten in het format van je team (bijv. Jira‑velden) en bewaar latere fases als aparte backlog.

Patroon 9: Test‑first prompts die betere ontwerpen vormen

Ship mobiel vanuit chat

Zet je journeys om in een Flutter mobiele app zonder van nul te beginnen.

Een eenvoudige manier om te voorkomen dat architectuur wegzakt, is duidelijkheid forceren via tests voordat je om een ontwerp vraagt. Als je een LLM vraagt te beginnen met acceptatietests, moet het gedrag, inputs, outputs en randgevallen benoemen. Dat legt ontbrekende requirements bloot en stuurt implementatie naar schone modulegrenzen.

Copy‑paste prompt template

Gebruik dit als een “poort”‑prompt telkens wanneer je een component gaat ontwerpen:

- Template: “Write acceptance tests first; then propose implementation. You must: (1) list assumptions, (2) name unit vs integration tests, (3) define test data and mocks vs real dependencies, (4) include a definition of done.”

Vraag testgrenzen die bij modules passen

Volg aan met: “Group the tests by module responsibility (API layer, domain logic, persistence, external integrations). For each group, specify what is mocked and what is real.”

Dit duwt het LLM weg van verwarde ontwerpen waarin alles alles raakt. Als het niet kan uitleggen waar integratietests beginnen, is de architectuur waarschijnlijk nog niet duidelijk.

Testdata‑strategie: vermijd broze suites

Vraag: “Propose a test data plan: fixtures vs factories, how to generate edge cases, and how to keep tests deterministic. List which dependencies can use in‑memory fakes and which require a real service in CI.”

Je ontdekt vaak dat een “simpele” feature eigenlijk een contract, een seed‑dataset of stabiele IDs nodig heeft—beter om dat nu te vinden dan tijdens een herschrijving.

Definition of done (zodat het ontwerp uitrolt)

Sluit af met een lichte checklist:

- Tests slagen (unit + integratie) en zinvolle dekking van faalgevallen

- Minimale docs: gebruik, config en een korte troubleshooting‑notitie

- Monitoring/alerts voor sleutel‑foutmodi

- Rollout‑plan (featureflag, migratiestappen, rollback)

Patroon 10: Design review prompts om problemen vroeg te vinden

Design reviews mogen niet alleen plaatsvinden nadat code al bestaat. Met AI kun je een “pre‑mortem review” op je architectuurschets uitvoeren (zelfs als het maar enkele alinea's en een diagram‑in‑woorden is) en een concrete lijst met zwaktes krijgen voordat ze herschrijvingen worden.

De kern review template

Begin met een strenge reviewer‑houding en forceer specificiteit:

Prompt: “Act as a reviewer; list risks, inconsistencies, and missing details in this design. Be concrete. If you can’t evaluate something, say what information is missing.”

Plak je design‑samenvatting, constraints (budget, tijdlijn, teamvaardigheden) en non‑functionele vereisten (latency, beschikbaarheid, compliance).

Zet feedback om in een uitvoerbare punchlist

Reviews falen wanneer feedback vaag is. Vraag om een gerangschikte set fixes:

Prompt: “Give me a prioritized punch list. For each item: severity (Blocker/High/Medium/Low), why it matters, suggested fix, and the smallest validation step.”

Dit levert beslisklare taken op in plaats van een debat.

Kwantificeer rewrite‑risico

Een nuttige dwingende maat is een eenvoudige score:

Prompt: “Assign a rewrite risk score from 1–10. Explain the top 3 drivers. What would reduce the score by 2 points with minimal effort?”

Je jaagt geen precisie na; je brengt vooral de meest rewrite‑gevoelige aannames naar boven.

Sluit af met een “diff plan”

Voorkom dat de review scope opgeblazen wordt:

Prompt: “Provide a diff plan: minimal changes needed to reach the target design. List what stays the same, what changes, and any breaking impacts.”

Als je dit patroon bij elke iteratie herhaalt, evolueert je architectuur via kleine, omkeerbare stappen—terwijl grote problemen vroeg worden opgevangen.

Een copy‑paste promptpakket en een eenvoudige workflow

Gebruik dit pakket als een lichtgewicht workflow die je bij elke feature herhaalt. Het idee is om prompts te koppelen zodat elke stap een artefact produceert dat de volgende stap kan hergebruiken—waardoor “verloren context” en verrassende herschrijvingen afnemen.

De 6‑stappen workflow (koppel deze patronen)

- Requirements (verduidelijken + constraints)

- Architectuurop ties (vergelijk 2–3 aanpakken)

- Grenzen (modules + verantwoordelijkheden)

- Contracten (data + APIs)

- Tests (test‑first acceptatie + cruciale unit tests)

- Review (faalmodi + design review checklist)

In de praktijk implementeren teams deze keten vaak als een herhaalbaar “feature‑recept”. Als je met Koder.ai bouwt, map je dezelfde structuur makkelijk naar een chat‑gedreven bouwproces: bewaar de artefacten op één plek, genereer de eerste werkende slice en iterateer met snapshots zodat experimenten omkeerbaar blijven. Als de MVP klaar is, kun je broncode exporteren of deployen/hosten met een custom domain—handig als je de snelheid van AI‑ondersteunde levering wilt zonder jezelf aan één omgeving vast te binden.

Copy‑paste prompt pack (met guardrails)

SYSTEM (optional)

You are a software architecture assistant. Be practical and concise.

Guardrail: When you make a recommendation, cite the specific lines from *my input* you relied on by quoting them verbatim under “Input citations”. Do not cite external sources or general industry claims.

If something is unknown, ask targeted questions.

1) REQUIREMENTS CLARIFIER

Context: <product/system overview>

Feature: <feature name>

My notes: <paste bullets, tickets, constraints>

Task:

- Produce: (a) clarified requirements, (b) non-goals, (c) constraints, (d) open questions.

- Include “Input citations” quoting the exact parts of my notes you used.

2) ARCHITECTURE OPTIONS

Using the clarified requirements above, propose 3 architecture options.

For each: tradeoffs, complexity, risks, and when to choose it.

End with a recommendation + “Input citations”.

3) MODULAR BOUNDARIES

Chosen option: <option name>

Define modules/components and their responsibilities.

- What each module owns (and does NOT own)

- Key interfaces between modules

- “Input citations”

4) DATA & API CONTRACTS

For each interface, define a contract:

- Request/response schema (or events)

- Validation rules

- Versioning strategy

- Error shapes

- “Input citations”

5) TEST-FIRST ACCEPTANCE

Write:

- Acceptance criteria (Given/When/Then)

- 5–10 critical tests (unit/integration)

- What to mock vs not mock

- “Input citations”

6) RELIABILITY + DESIGN REVIEW

Create:

- Failure modes list (timeouts, partial failure, bad data, retries)

- Observability plan (logs/metrics/traces)

- Review checklist tailored to this feature

- “Input citations”

Als je een diepere companion wilt, zie /blog/prompting-for-code-reviews. Als je tooling of team‑rollout evalueert, is /pricing een praktisch volgende stap.